Charger des données de Microsoft 365 (Office 365) à l’aide d’Azure Data Factory

S’APPLIQUE À : Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Conseil

Essayez Data Factory dans Microsoft Fabric, une solution d’analyse tout-en-un pour les entreprises. Microsoft Fabric couvre tous les aspects, du déplacement des données à la science des données, en passant par l’analyse en temps réel, l’aide à la décision et la création de rapports. Découvrez comment démarrer un nouvel essai gratuitement !

Cet article vous montre comment charger des données de Microsoft 365 (Office 365) dans le stockage d’objets blob Azure à l’aide de Data Factory. Vous pouvez suivre une procédure similaire pour copier des données vers Azure Data Lake Gen1 ou Gen2. Reportez-vous à l’article sur le connecteur Microsoft 365 (Office 365) relatif à la copie de données à partir de Microsoft 365 (Office 365) en général.

Créer une fabrique de données

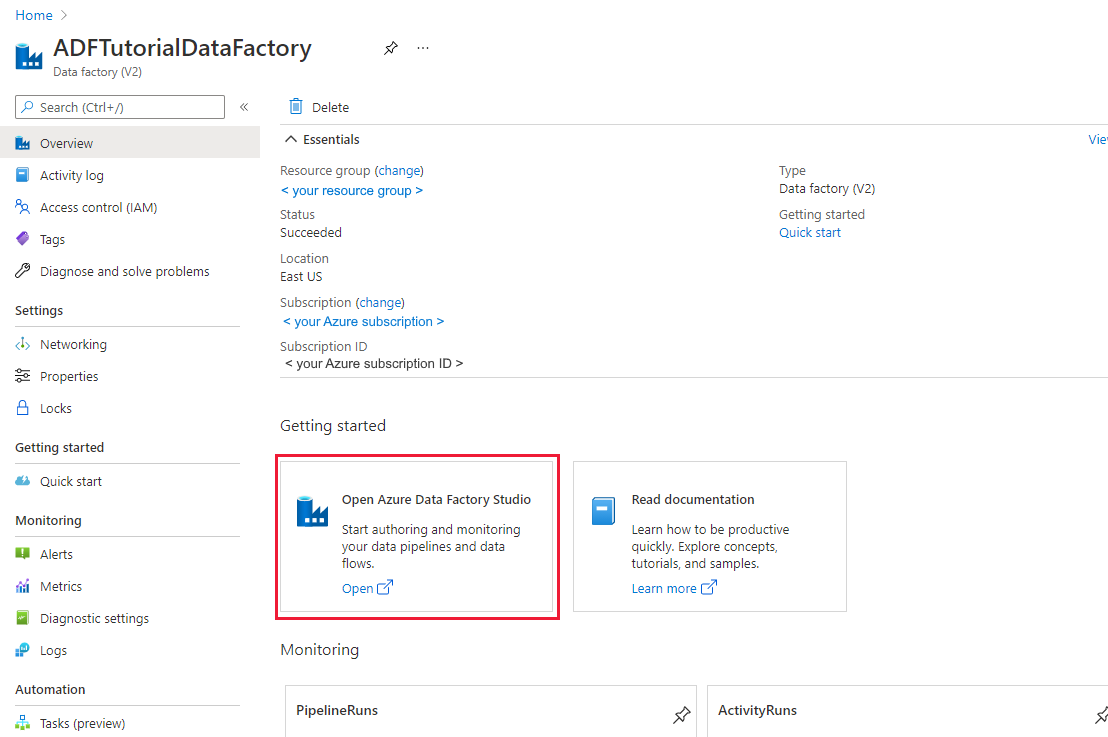

Si vous n’avez pas encore créé votre fabrique de données, suivez les étapes de démarrage rapide : Créer une fabrique de données à l’aide du Portail Azure et Azure Data Factory Studio pour en créer une. Après la création, accédez à la fabrique de données dans le Portail Azure.

Sélectionnez Ouvrir dans la mosaïque Ouvrir Azure Data Factory Studio pour lancer l’application d’intégration de données dans un onglet distinct.

Créer un pipeline

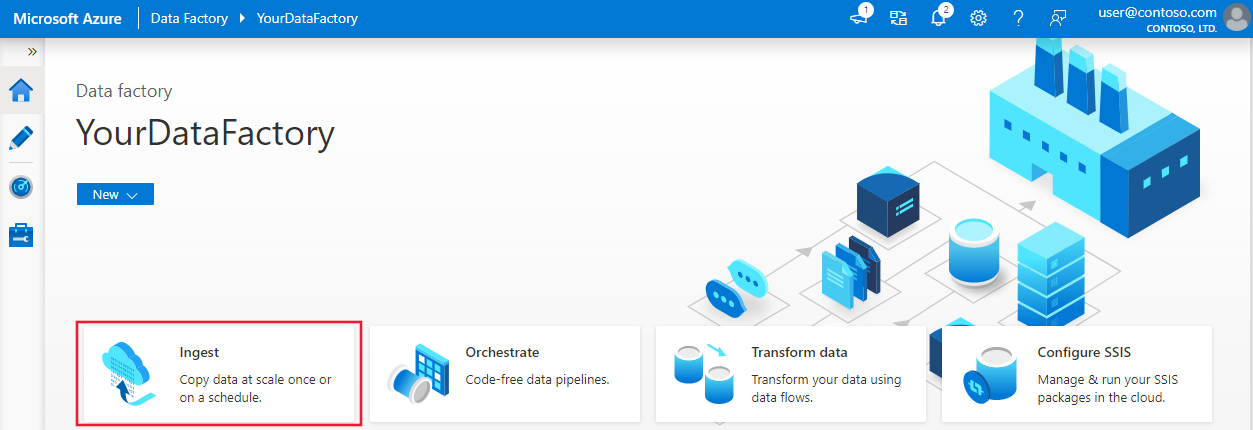

Dans la page d’accueil, sélectionnez Orchestrer.

Dans l’onglet Général du pipeline, entrez « CopyPipeline » pour le nom du pipeline.

Dans la zone > d’outils Activités, déplacez et > déplacez la activité Copy de la zone d’outils vers l’aire du concepteur de pipelines. Spécifiez « CopyFromOffice365ToBlob » comme nom d’activité.

Notes

Veuillez utiliser le runtime d’intégration Azure dans les services liés source et récepteur. Le runtime d’intégration auto-hébergé et le runtime d’intégration de réseau virtuel managé ne sont pas pris en charge.

Configurer la source

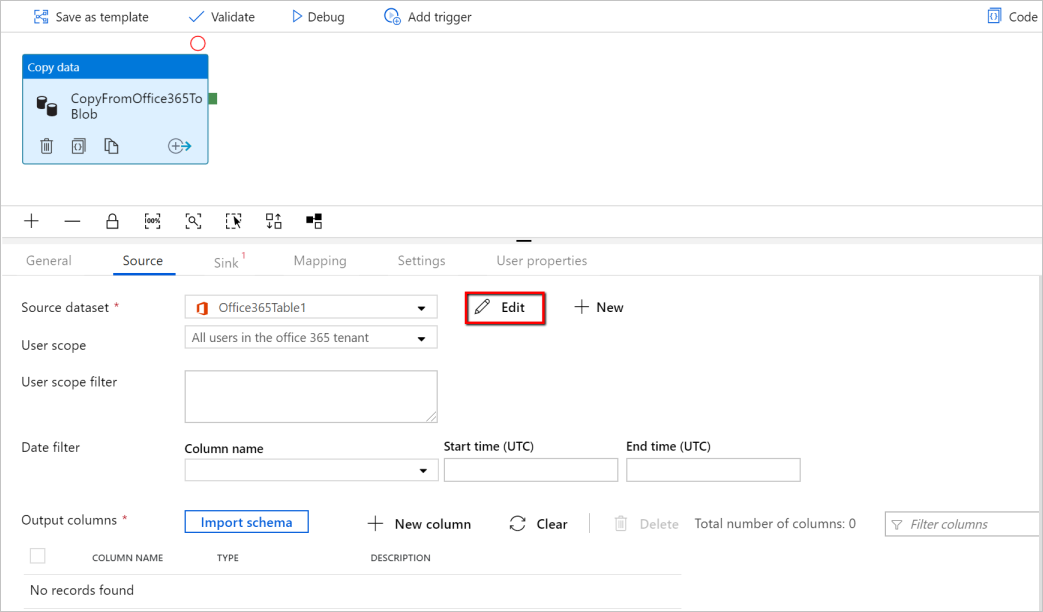

Accédez au pipeline >onglet Source, puis sélectionnez + Nouveau pour créer un jeu de données source.

Dans la fenêtre Nouveau jeu de données, sélectionnez Microsoft 365 (Office 365), puis sélectionnez Continuer.

Vous êtes maintenant dans l’onglet Configuration de l’activité de copie. Sélectionnez le bouton Modifier en regard du jeu de données Microsoft 365 (Office 365) pour continuer la configuration des données.

Vous voyez un nouvel onglet ouvert pour le jeu de données Microsoft 365 (Office 365). Dans l’onglet Général en bas de la fenêtre Propriétés, entrez « SourceOffice365Dataset » pour le nom.

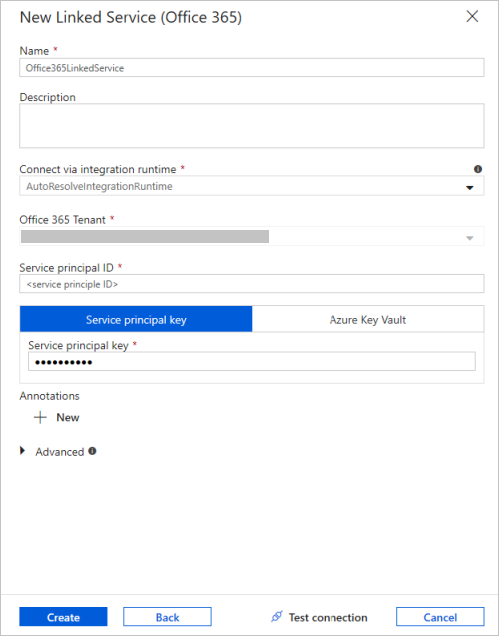

Accédez à l’onglet Connexion dans la fenêtre Propriétés. En regard de la zone de texte Service lié, sélectionnez + Nouveau.

Dans la fenêtre Nouveau service lié, entrez « Office365LinkedService » comme nom, saisissez l’ID et la clé du principal de service et la clé du principal de service, puis testez la connexion et sélectionnez Créer pour déployer le service lié.

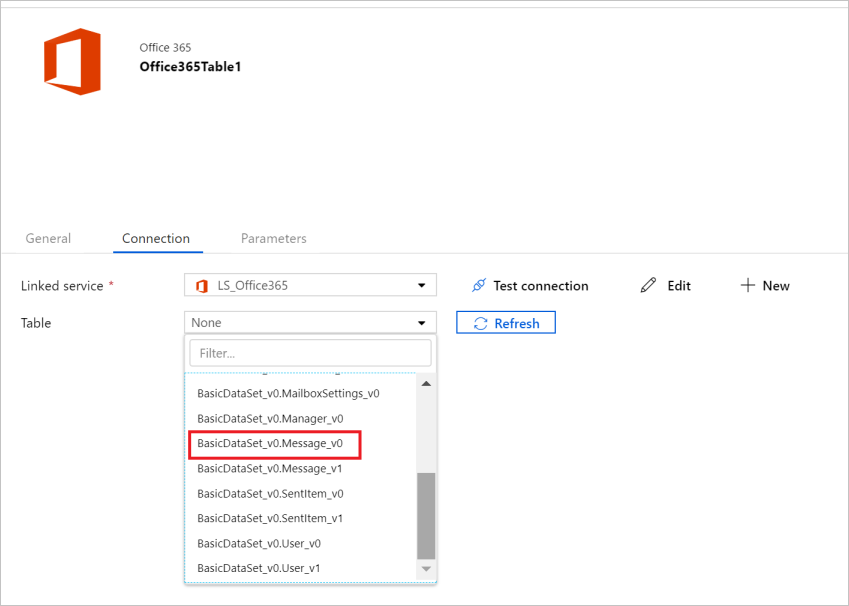

Une fois le service lié créé, vous revenez dans les paramètres du jeu de données. En regard de Table, cliquez sur la flèche vers le bas pour développer la liste des jeux de données Microsoft 365 (Office 365) disponibles, puis choisissez « BasicDataSet_v0.Message_v0 » dans la liste déroulante :

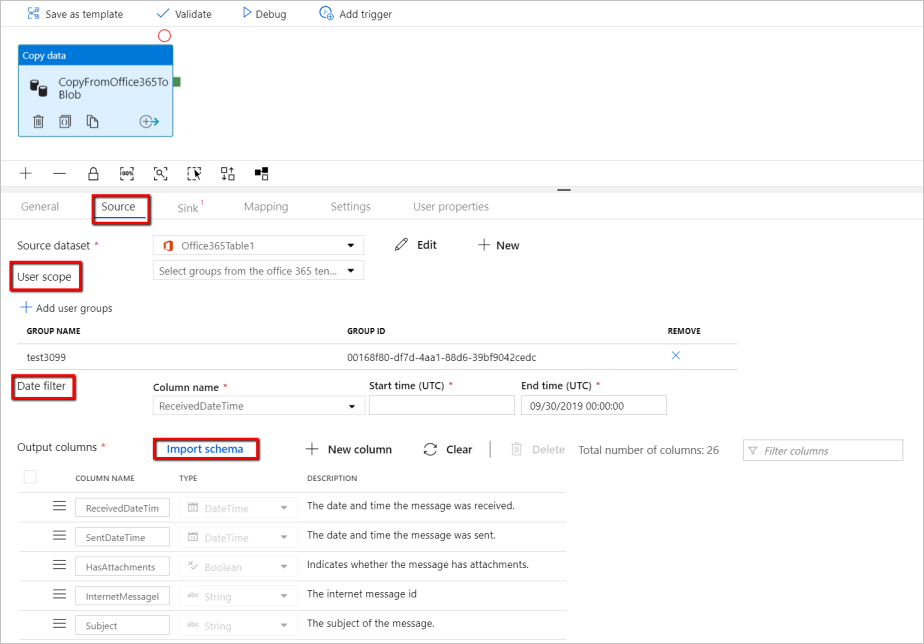

Revenez maintenant au pipeline>onglet Source pour continuer à configurer des propriétés supplémentaires pour l’extraction de données Microsoft 365 (Office 365). L’étendue de l’utilisateur et le filtre d’étendue utilisateur sont des prédicats facultatifs que vous pouvez définir pour limiter les données que vous souhaitez extraire de Microsoft 365 (Office 365). Pour plus d’informations sur la configuration de ces paramètres, consultez les propriétés du jeu de données Microsoft 365 (Office 365).

Vous devez choisir l’un des filtres de date et fournir les valeurs heure de début et heure de fin.

Sélectionnez l’onglet Importer le schéma pour importer le schéma du jeu de données de messages.

Configurer le récepteur

Accédez au pipeline > onglet >Récepteur, puis sélectionnez + Nouveau pour créer un jeu de données récepteur.

Dans la fenêtre Nouveau jeu de données, notez que seule les destinations prises en charge sont sélectionnées lors de la copie à partir de Microsoft 365 (Office 365). Sélectionnez Stockage Blob Azure, sélectionnez le format binaire, puis sélectionnez Continuer. Dans ce tutoriel, vous copiez des données Microsoft 365 (Office 365) dans un Stockage Blob Azure.

Sélectionnez le bouton Modifier en regard du jeu de données Stockage Blob Azure pour continuer la configuration des données.

Dans l’onglet Général de la fenêtre Propriétés, sous Nom, entrez « OutputBlobDataset ».

Accédez à l’onglet Connexion dans la fenêtre Propriétés. En regard de la zone de texte Service lié, sélectionnez + Nouveau.

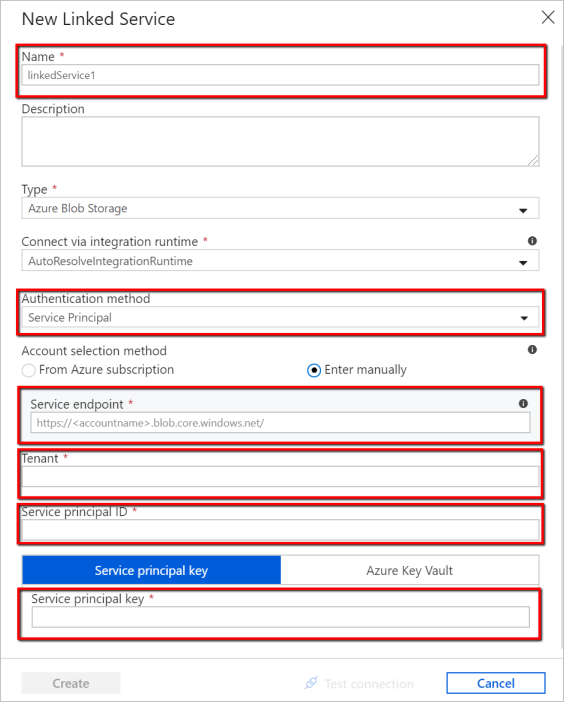

Dans la fenêtre Nouveau service lié, entrez « AzureStorageLinkedService » comme nom, sélectionnez « Principal de service » dans la liste déroulante des méthodes d’authentification, renseignez le point de terminaison de service, l’abonné, l’ID du principal de service et la clé du principal de service, puis sélectionnez Enregistrer pour déployer le service lié. Cliquez ici pour savoir comment configurer l’authentification du principal de service pour le stockage Blob Azure.

Valider le pipeline

Sélectionnez Valider dans la barre d’outils pour valider les paramètres du pipeline.

Vous pouvez également obtenir le code JSON associé au pipeline en cliquant sur Code dans le coin supérieur droit.

Publier le pipeline

Dans la barre d’outils supérieure, sélectionnez Publier tout. Cette action publie les entités (jeux de données et pipelines) que vous avez créées dans Data Factory.

Déclencher le pipeline manuellement

Sélectionnez Ajouter déclencheur dans la barre d’outils, puis Déclencher maintenant. Sur la page Exécution du pipeline, sélectionnez Terminer.

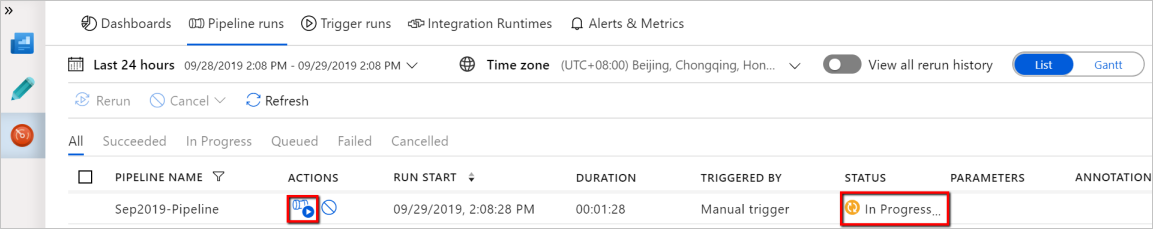

Surveiller le pipeline

Accédez à l’onglet Surveiller sur la gauche. Vous voyez un pipeline qui est déclenché par un déclencheur manuel. Vous pouvez utiliser les liens dans la colonne Actions pour afficher les détails de l’activité et réexécuter le pipeline.

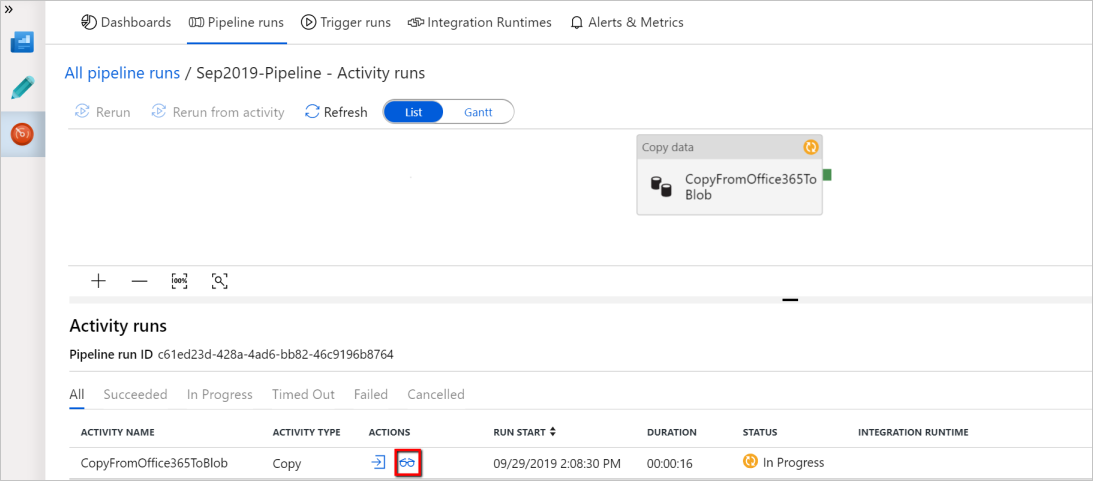

Pour afficher les exécutions d’activités associées à l’exécution du pipeline, sélectionnez le lien Afficher les exécutions d’activités dans la colonne Actions. Dans cet exemple, il n’y a qu’une seule activité, vous ne voyez donc qu’une seule entrée dans la liste. Pour plus de détails sur l’opération de copie, sélectionnez le lien Détails (icône en forme de lunettes) dans la colonne Actions.

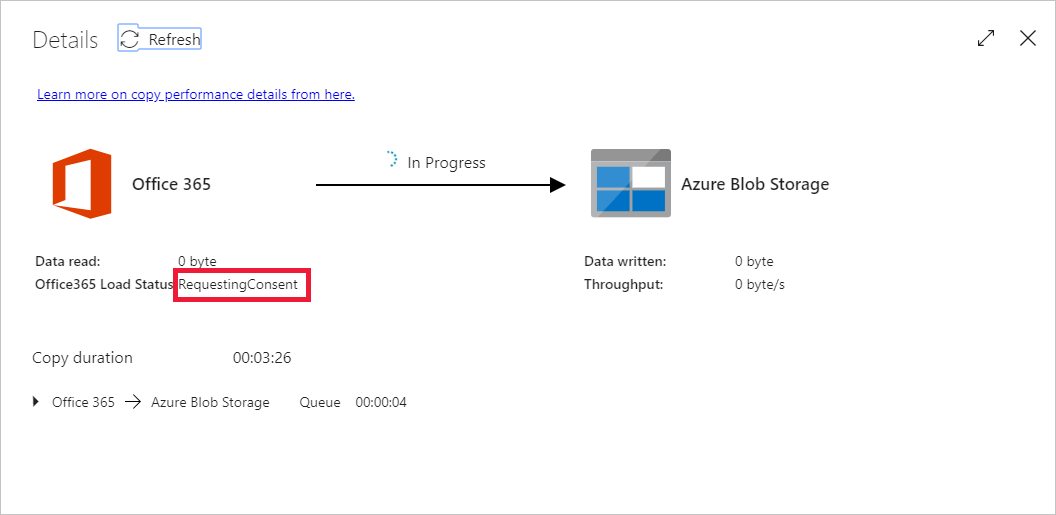

Si c’est la première fois que vous demandez des données pour ce contexte (une combinaison de la table de données consultée, du compte de destination dans lequel les données sont chargées et de l’identité de l’utilisateur à l’origine de la demande d’accès aux données), l’état de l’activité de copie sera En cours d’exécution et en sélectionnant uniquement le lien « Détails » sous Actions, l’état qui s’affiche est RequesetingConsent. Un membre du groupe d’approbateurs pour l’accès aux données doit approuver la requête dans Privileged Access Management pour permettre l’extraction de données.

État lors de la demande de consentement :

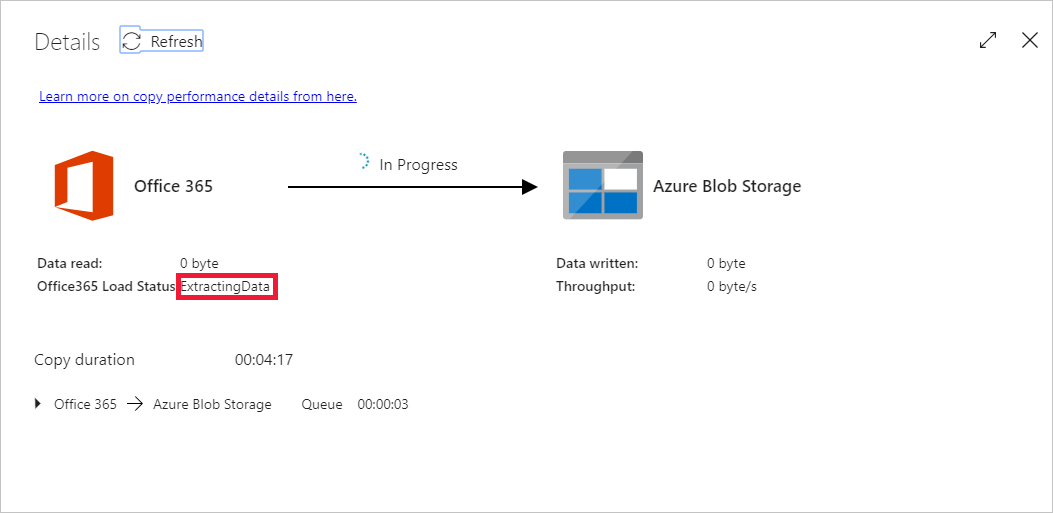

État lors de l’extraction des données :

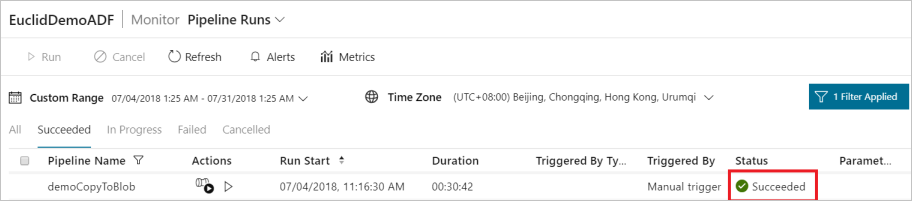

Une fois le consentement fourni, l’extraction de données peut continuer et, après un certain temps, l’exécution du pipeline apparaît comme réussie.

Maintenant, accédez au Stockage Blob Azure de destination et vérifiez que les données Microsoft 365 (Office 365) ont été extraites au format binaire.

Contenu connexe

Lisez l’article suivant pour en savoir plus sur la prise en charge d’Azure Synapse Analytics :