Comment utiliser un connecteur Flink/Delta

Important

Cette fonctionnalité est disponible actuellement en mode Aperçu. Les Conditions d’utilisation supplémentaires pour les préversions de Microsoft Azure contiennent davantage de conditions légales qui s’appliquent aux fonctionnalités Azure en version bêta, en préversion ou ne se trouvant pas encore en disponibilité générale. Pour plus d’informations sur cette préversion spécifique, consultez les Informations sur la préversion d’Azure HDInsight sur AKS. Pour toute question ou pour des suggestions à propos des fonctionnalités, veuillez envoyer vos requêtes et leurs détails sur AskHDInsight, et suivez-nous sur la Communauté Azure HDInsight pour plus de mises à jour.

En utilisant Apache Flink et Delta Lake ensemble, vous pouvez créer une architecture de data lakehouse fiable et évolutive. Le connecteur Flink/Delta vous permet d’écrire des données dans des tables Delta avec des transactions ACID et de façon exacte pendant le traitement. Cela signifie que vos flux de données sont cohérents et sans erreur, même si vous redémarrez votre pipeline Flink à partir d’un point de contrôle. Le connecteur Flink/Delta garantit que vos données ne sont pas perdues ou dupliquées, et qu’elles correspondent à la sémantique Flink.

Dans cet article, vous allez apprendre à utiliser le connecteur Flink-Delta.

- Lisez les données de la table delta.

- Écrivez les données dans une table delta.

- Interrogez-le dans Power BI.

Présentation du connecteur Flink/Delta

Le connecteur Flink/Delta est une bibliothèque JVM pour lire et écrire des données à partir d’applications Apache Flink vers des tables Delta en utilisant la bibliothèque autonome JVM Delta. Le connecteur fournit une garantie de livraison en une seule fois.

Le connecteur Flink/Delta comprend :

DeltaSink pour écrire des données d’Apache Flink vers une table Delta. DeltaSource pour lire des tables Delta à l’aide d’Apache Flink.

Le connecteur Apache Flink-Delta comprend :

Selon la version du connecteur, vous pouvez l’utiliser avec les versions Apache Flink suivantes :

Connector's version Flink's version

0.4.x (Sink Only) 1.12.0 <= X <= 1.14.5

0.5.0 1.13.0 <= X <= 1.13.6

0.6.0 X >= 1.15.3

0.7.0 X >= 1.16.1 --- We use this in Flink 1.17.0

Pour plus d’informations, consultez Connecteur Flink/Delta.

Prérequis

- Cluster HDInsight Flink 1.17.0 sur AKS

- Connecteur Flink-Delta 0.7.0

- Utiliser MSI pour accéder à ADLS Gen2

- IntelliJ pour le développement

Lire des données à partir d’une table delta

Delta Source peut fonctionner dans l’un des deux modes décrits comme suit.

Mode limité adapté aux travaux par lots, où nous voulons lire le contenu de la table Delta uniquement pour une version spécifique de la table. Créez une source de ce mode à l’aide de l’API DeltaSource.forBoundedRowData.

Mode continu adapté aux travaux de diffusion en continu, où nous voulons vérifier en permanence la table Delta à la recherche de nouvelles modifications et versions. Créez une source de ce mode à l’aide de l’API DeltaSource.forContinuousRowData.

Exemple : création de source pour la table Delta, pour lire toutes les colonnes en mode limité. Convient pour les travaux de traitement par lots. Cet exemple charge la dernière version de la table.

import org.apache.flink.api.common.eventtime.WatermarkStrategy;

import org.apache.flink.core.fs.Path;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.table.data.RowData;

import org.apache.hadoop.conf.Configuration;

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// Define the source Delta table path

String deltaTablePath_source = "abfss://container@account_name.dfs.core.windows.net/data/testdelta";

// Create a bounded Delta source for all columns

DataStream<RowData> deltaStream = createBoundedDeltaSourceAllColumns(env, deltaTablePath_source);

public static DataStream<RowData> createBoundedDeltaSourceAllColumns(

StreamExecutionEnvironment env,

String deltaTablePath) {

DeltaSource<RowData> deltaSource = DeltaSource

.forBoundedRowData(

new Path(deltaTablePath),

new Configuration())

.build();

return env.fromSource(deltaSource, WatermarkStrategy.noWatermarks(), "delta-source");

}

Pour obtenir d’autres exemples de modèle continu, consultez Modes de source de données.

Écriture dans le récepteur Delta

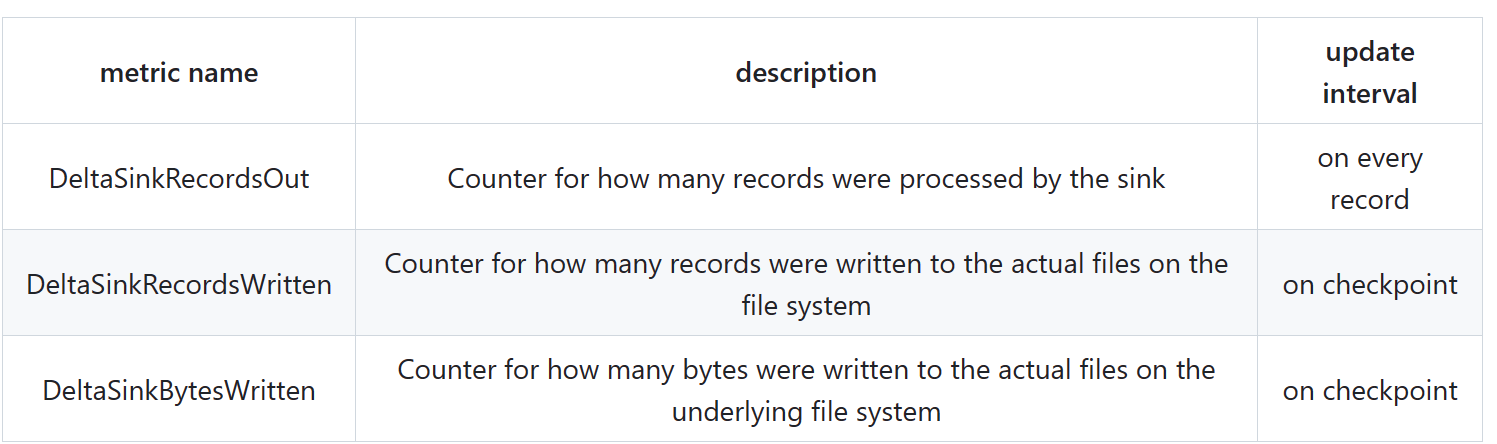

Delta Sink expose actuellement les métriques Flink suivantes :

Création d’un récepteur pour les tables non partitionnées

Dans cet exemple, nous montrons comment créer un DeltaSink et le brancher à un org.apache.flink.streaming.api.datastream.DataStream existant.

import io.delta.flink.sink.DeltaSink;

import org.apache.flink.core.fs.Path;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.table.data.RowData;

import org.apache.flink.table.types.logical.RowType;

import org.apache.hadoop.conf.Configuration;

// Define the sink Delta table path

String deltaTablePath_sink = "abfss://container@account_name.dfs.core.windows.net/data/testdelta_output";

// Define the source Delta table path

RowType rowType = RowType.of(

DataTypes.STRING().getLogicalType(), // Date

DataTypes.STRING().getLogicalType(), // Time

DataTypes.STRING().getLogicalType(), // TargetTemp

DataTypes.STRING().getLogicalType(), // ActualTemp

DataTypes.STRING().getLogicalType(), // System

DataTypes.STRING().getLogicalType(), // SystemAge

DataTypes.STRING().getLogicalType() // BuildingID

);

createDeltaSink(deltaStream, deltaTablePath_sink, rowType);

public static DataStream<RowData> createDeltaSink(

DataStream<RowData> stream,

String deltaTablePath,

RowType rowType) {

DeltaSink<RowData> deltaSink = DeltaSink

.forRowData(

new Path(deltaTablePath),

new Configuration(),

rowType)

.build();

stream.sinkTo(deltaSink);

return stream;

}

Pour obtenir d’autres exemples de création de récepteur, consultez Métriques du récepteur de données.

Code complet

Lit les données d’une table delta et du récepteur vers une autre table delta.

package contoso.example;

import io.delta.flink.sink.DeltaSink;

import io.delta.flink.source.DeltaSource;

import org.apache.flink.api.common.eventtime.WatermarkStrategy;

import org.apache.flink.core.fs.Path;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.table.api.DataTypes;

import org.apache.flink.table.data.RowData;

import org.apache.flink.table.types.logical.RowType;

import org.apache.hadoop.conf.Configuration;

public class DeltaSourceExample {

public static void main(String[] args) throws Exception {

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// Define the sink Delta table path

String deltaTablePath_sink = "abfss://container@account_name.dfs.core.windows.net/data/testdelta_output";

// Define the source Delta table path

String deltaTablePath_source = "abfss://container@account_name.dfs.core.windows.net/data/testdelta";

// Define the source Delta table path

RowType rowType = RowType.of(

DataTypes.STRING().getLogicalType(), // Date

DataTypes.STRING().getLogicalType(), // Time

DataTypes.STRING().getLogicalType(), // TargetTemp

DataTypes.STRING().getLogicalType(), // ActualTemp

DataTypes.STRING().getLogicalType(), // System

DataTypes.STRING().getLogicalType(), // SystemAge

DataTypes.STRING().getLogicalType() // BuildingID

);

// Create a bounded Delta source for all columns

DataStream<RowData> deltaStream = createBoundedDeltaSourceAllColumns(env, deltaTablePath_source);

createDeltaSink(deltaStream, deltaTablePath_sink, rowType);

// Execute the Flink job

env.execute("Delta datasource and sink Example");

}

public static DataStream<RowData> createBoundedDeltaSourceAllColumns(

StreamExecutionEnvironment env,

String deltaTablePath) {

DeltaSource<RowData> deltaSource = DeltaSource

.forBoundedRowData(

new Path(deltaTablePath),

new Configuration())

.build();

return env.fromSource(deltaSource, WatermarkStrategy.noWatermarks(), "delta-source");

}

public static DataStream<RowData> createDeltaSink(

DataStream<RowData> stream,

String deltaTablePath,

RowType rowType) {

DeltaSink<RowData> deltaSink = DeltaSink

.forRowData(

new Path(deltaTablePath),

new Configuration(),

rowType)

.build();

stream.sinkTo(deltaSink);

return stream;

}

}

Maven Pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>contoso.example</groupId>

<artifactId>FlinkDeltaDemo</artifactId>

<version>1.0-SNAPSHOT</version>

<properties>

<maven.compiler.source>1.8</maven.compiler.source>

<maven.compiler.target>1.8</maven.compiler.target>

<flink.version>1.17.0</flink.version>

<java.version>1.8</java.version>

<scala.binary.version>2.12</scala.binary.version>

<hadoop-version>3.3.4</hadoop-version>

</properties>

<dependencies>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-java</artifactId>

<version>${flink.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-streaming-java -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java</artifactId>

<version>${flink.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-clients -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-clients</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>io.delta</groupId>

<artifactId>delta-standalone_2.12</artifactId>

<version>3.0.0</version>

</dependency>

<dependency>

<groupId>io.delta</groupId>

<artifactId>delta-flink</artifactId>

<version>3.0.0</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-parquet</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-clients</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>${hadoop-version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table-runtime</artifactId>

<version>${flink.version}</version>

<scope>provided</scope>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-assembly-plugin</artifactId>

<version>3.0.0</version>

<configuration>

<appendAssemblyId>false</appendAssemblyId>

<descriptorRefs>

<descriptorRef>jar-with-dependencies</descriptorRef>

</descriptorRefs>

</configuration>

<executions>

<execution>

<id>make-assembly</id>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

</plugins>

</build>

</project>

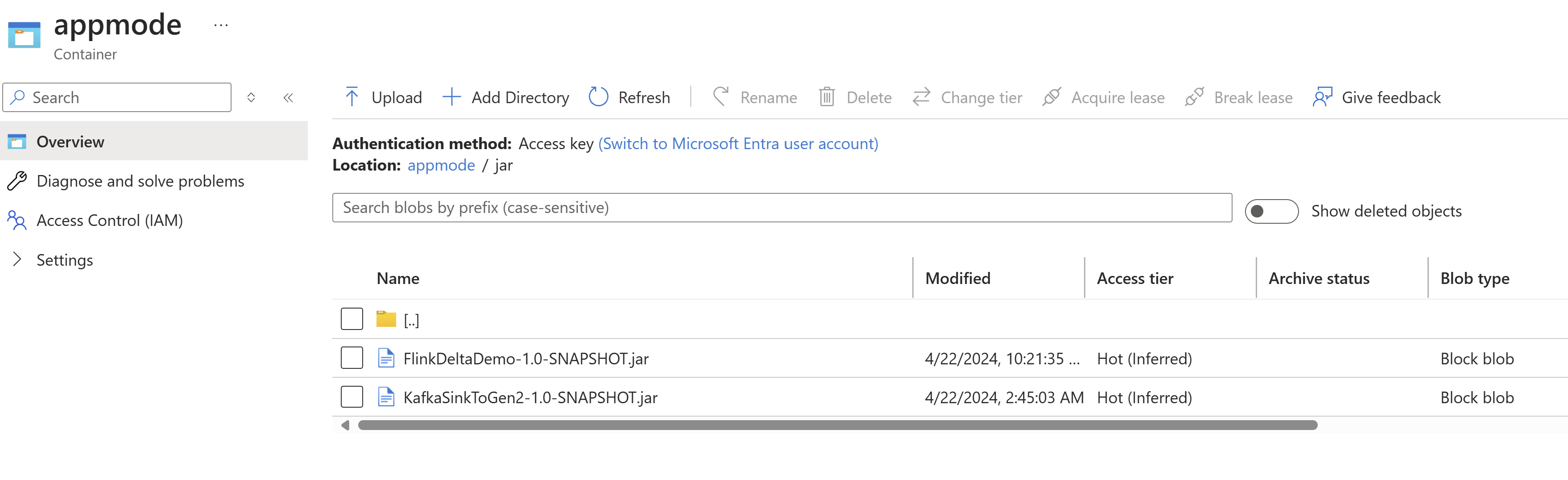

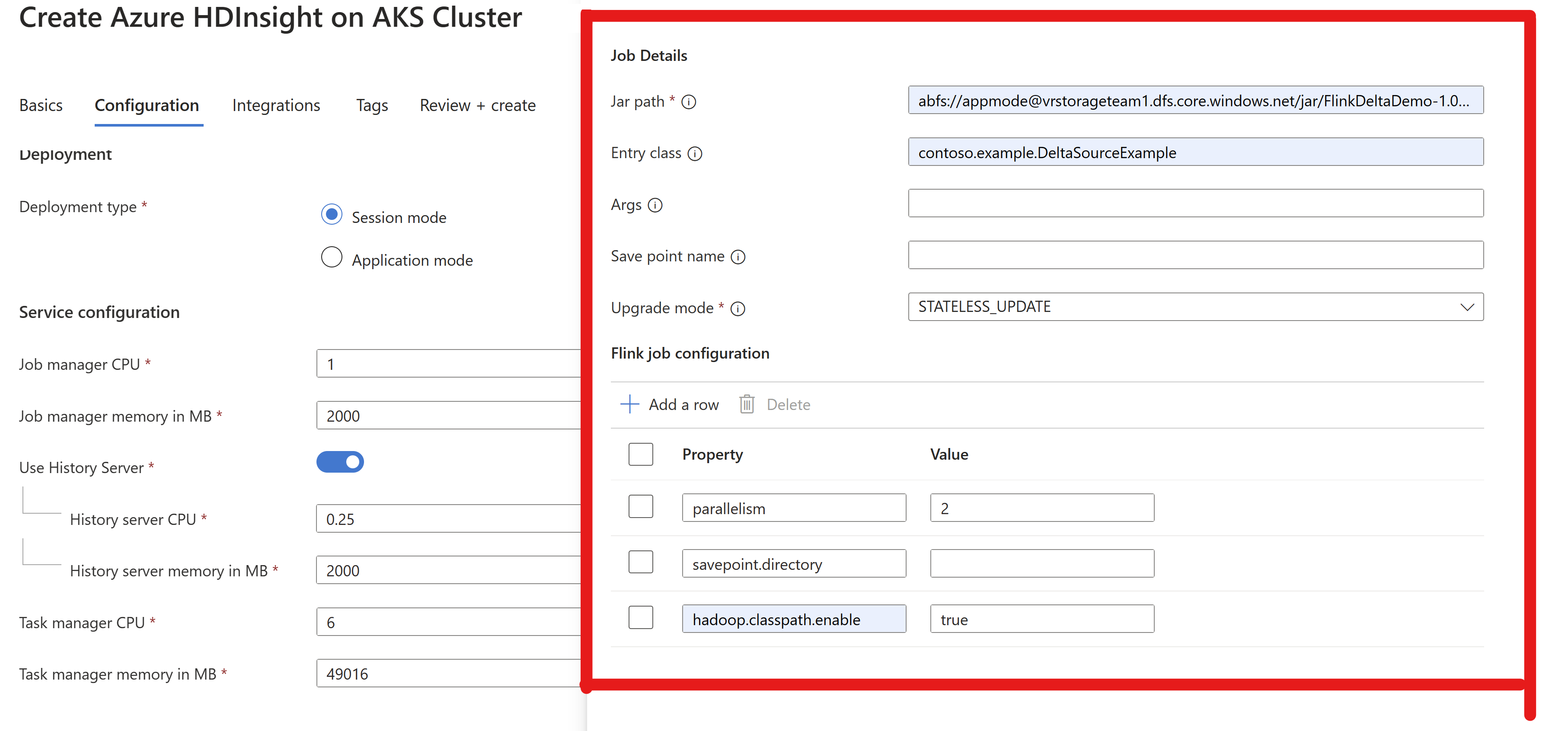

Empaqueter le fichier jar et le soumettre au cluster Flink à exécuter

Transmettez les informations jar du travail dans le cluster AppMode.

Remarque

Activez toujours

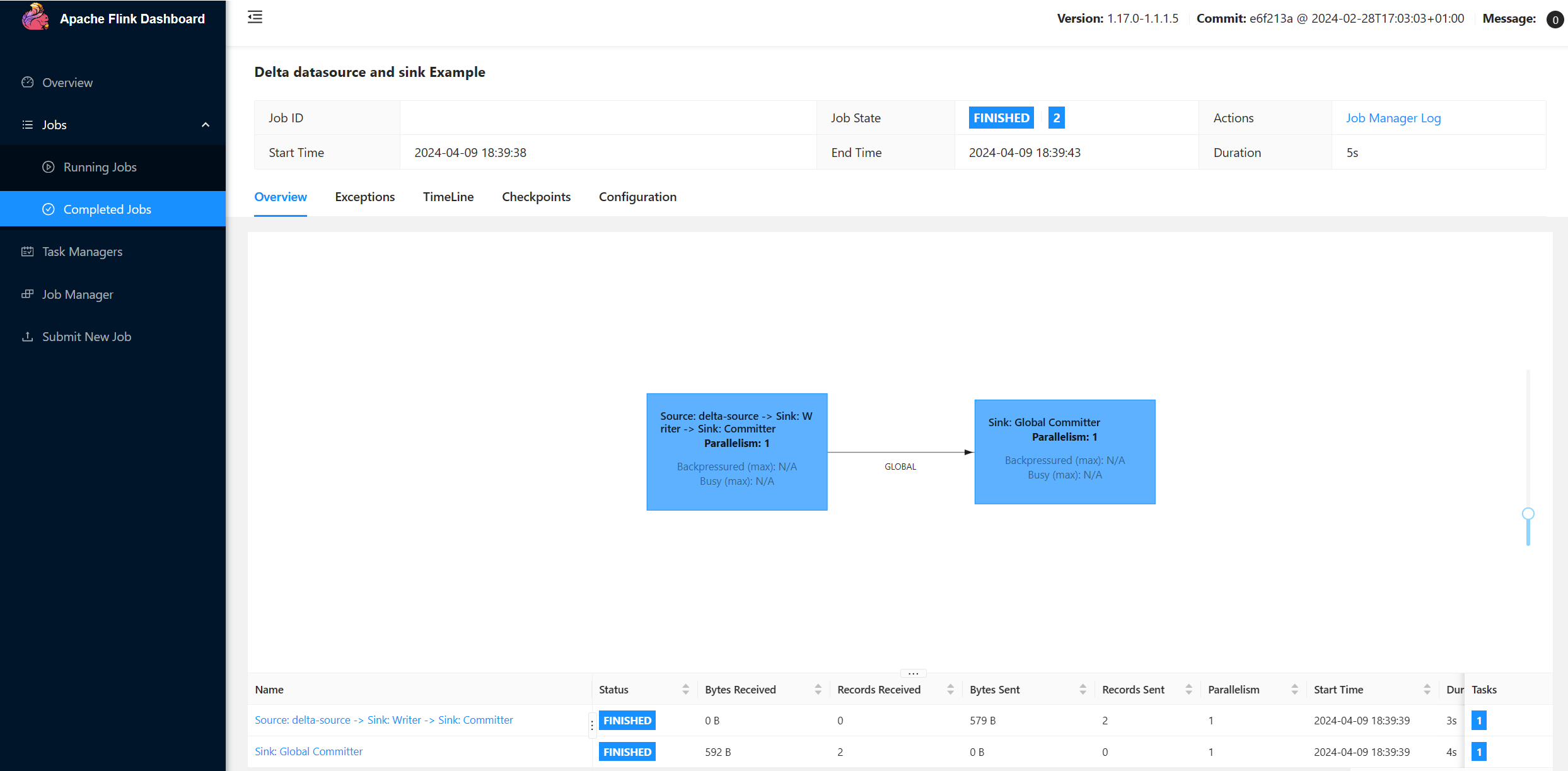

hadoop.classpath.enablelors de la lecture/écriture dans ADLS.Envoyez le cluster, vous devriez être en mesure de voir le travail dans l’interface utilisateur Flink.

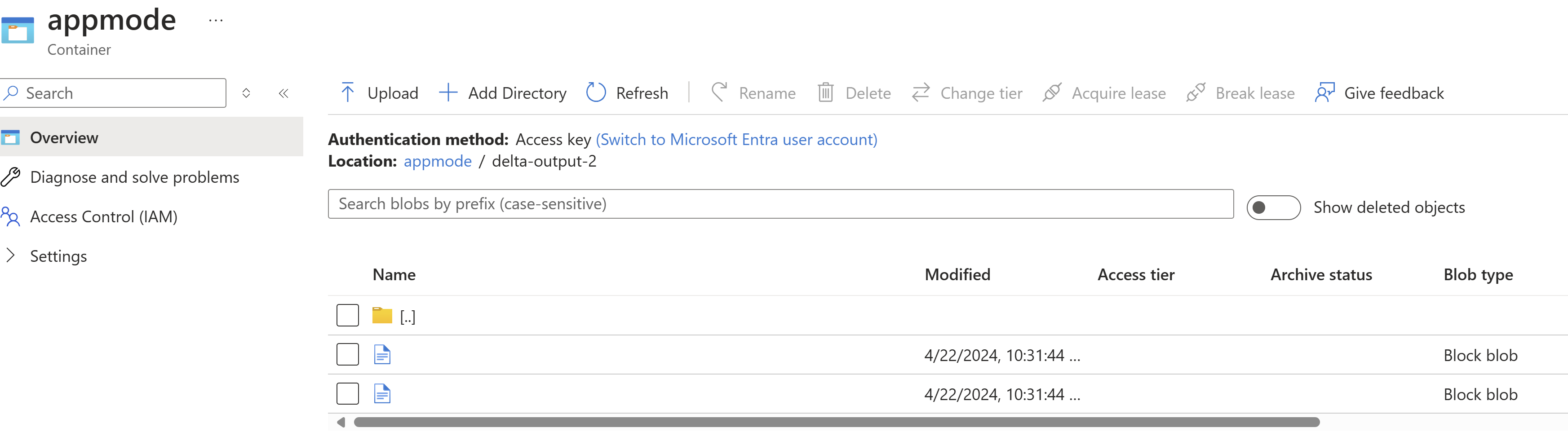

Recherchez les résultats dans ADLS.

Intégration Power BI

Une fois que les données se trouvent dans le récepteur delta, vous pouvez exécuter la requête dans Power BI Desktop et créer un rapport.

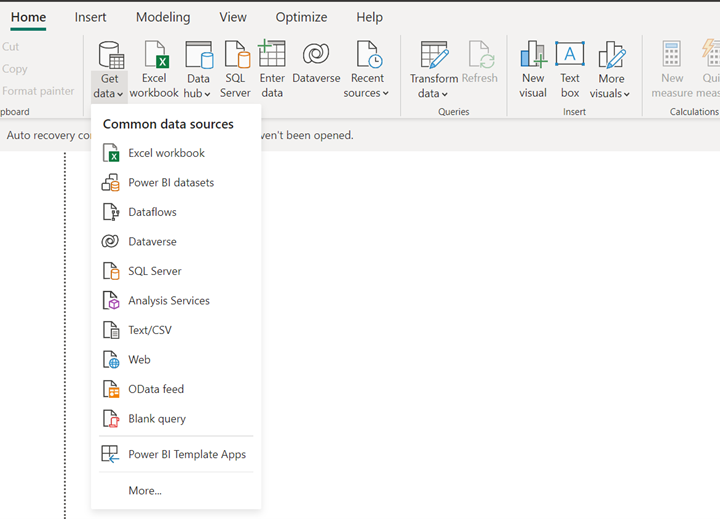

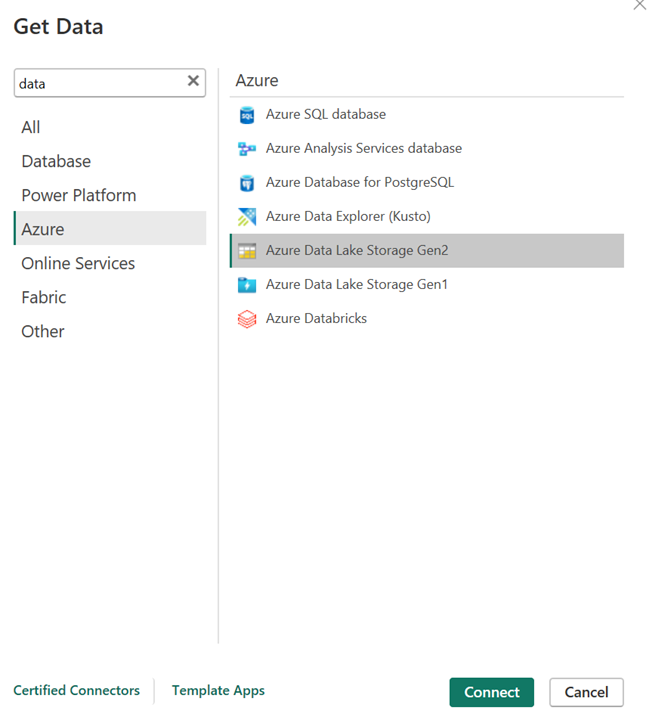

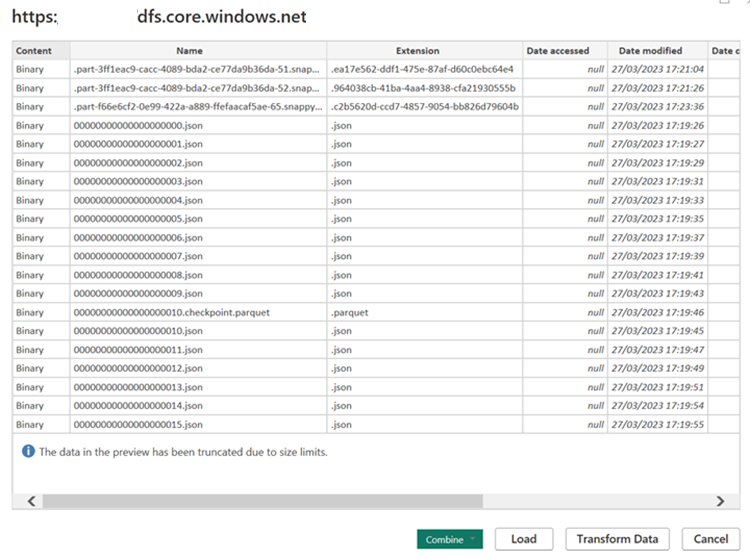

Ouvrez votre bureau Power BI et obtenez les données à l’aide du connecteur ADLS Gen2.

URL du compte de stockage.

Créez une requête M pour la source et appelez la fonction, qui interroge les données à partir du compte de stockage. Reportez-vous aux connecteurs Delta Power BI.

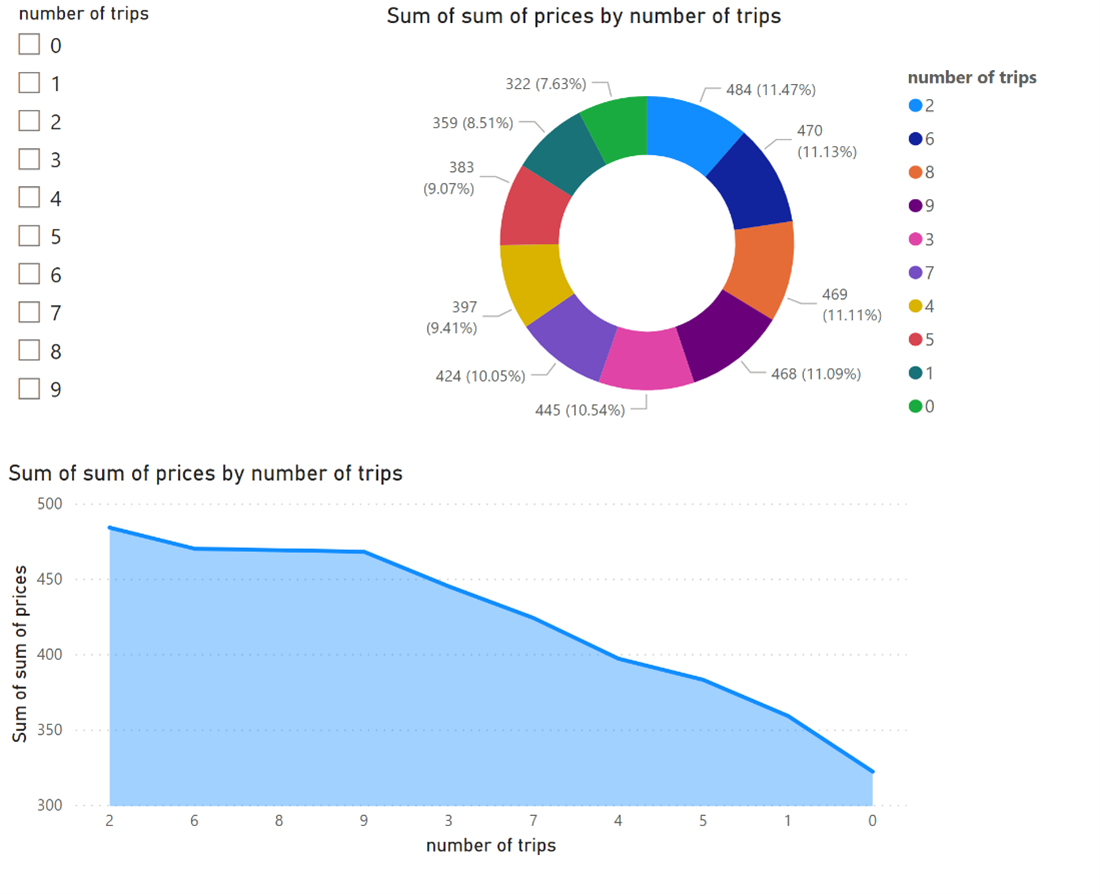

Dès que les données sont disponibles, vous pouvez créer des rapports.

Références

- Connecteurs Delta.

- Connecteurs Delta Power BI.

- Apache, Apache Flink, Flink et les noms de projet open source associés sont des marques de commerce d’Apache Software Foundation (ASF).