Számítási konfigurációs referencia

Ez a cikk a Számítási felhasználói felületen elérhető összes konfigurációs beállítást ismerteti. A felhasználók többsége a hozzárendelt szabályzatok használatával hoz létre számítást, ami korlátozza a konfigurálható beállításokat. Ha nem lát egy adott beállítást a felhasználói felületen, az azért van, mert a kiválasztott szabályzat nem teszi lehetővé a beállítás konfigurálását.

A cikkben ismertetett konfigurációk és felügyeleti eszközök mind a teljes körű, mind a feladatalapú számításra érvényesek. A feladatszámítás konfigurálásával kapcsolatos további szempontokért tekintse meg az Azure Databricks számítási feladataival való használatát.

Politikák

A szabályzatok olyan szabályok, amelyek a felhasználók számára a számítás létrehozásakor elérhető konfigurációs beállítások korlátozására szolgálnak. Ha egy felhasználó nem rendelkezik a korlátlan fürtlétrehozás jogosultságával, akkor csak a megadott szabályzatok használatával hozhat létre számítást.

Ha szabályzat szerint szeretne számítást létrehozni, válasszon ki egy szabályzatot a Szabályzat legördülő menüből.

Alapértelmezés szerint minden felhasználó rendelkezik hozzáféréssel a személyes számítási szabályzathoz, amely lehetővé teszi számukra az egygépes számítási erőforrások létrehozását. Ha hozzá kell férnie a Személyes számításhoz vagy bármilyen további szabályzathoz, forduljon a munkaterület rendszergazdájához.

Egycsomópontos vagy többcsomópontos számítás

A szabályzattól függően választhat egy csomópontos vagy többcsomópontos számítás létrehozása között.

Az egycsomópontos számítás olyan feladatokhoz készült, amelyek kis mennyiségű adatot vagy nem elosztott számítási feladatot, például egycsomópontos gépi tanulási kódtárakat használnak. A többcsomópontos számítást elosztott számítási feladatokkal rendelkező nagyobb feladatokhoz kell használni.

Egycsomópont tulajdonságai

Egyetlen csomópont számítása a következő tulajdonságokkal rendelkezik:

- Helyileg futtatja a Sparkot.

- Az illesztőprogram főként és feldolgozóként is működik, munkavégző csomópontok nélkül.

- Logikai magonként egy végrehajtószálat hoz ki a számításban, mínusz 1 magot az illesztőprogram számára.

- Menti az illesztőprogram-napló összes

stderrkimenetétstdoutéslog4jnaplókimenetét. - Nem konvertálható többcsomópontos számítássá.

Egy vagy több csomópont kijelölése

Fontolja meg a használati esetet, amikor egyetlen vagy többcsomópontos számítás között dönt:

A nagy léptékű adatfeldolgozás kimeríti az erőforrásokat egyetlen csomóponton. Ezekhez a számítási feladatokhoz a Databricks többcsomópontos számítás használatát javasolja.

Az egycsomópontos számítás nem osztható meg. Az erőforrásütközések elkerülése érdekében a Databricks többcsomópontos számítás használatát javasolja, amikor meg kell osztani a számítást.

A többcsomópontos számítás nem skálázható 0 feldolgozóra. Ehelyett használjon egy csomópontos számítást.

Az egycsomópontos számítás nem kompatibilis a folyamatelkülönítéssel.

A GPU-ütemezés nincs engedélyezve egyetlen csomópontos számításban.

Egycsomópontos számításkor a Spark nem tudja olvasni az UDT oszlopot tartalmazó Parquet-fájlokat. A következő hibaüzenet eredménye:

The Spark driver has stopped unexpectedly and is restarting. Your notebook will be automatically reattached.A probléma megoldásához tiltsa le a natív Parquet-olvasót:

spark.conf.set("spark.databricks.io.parquet.nativeReader.enabled", False)

Hozzáférési módok

A hozzáférési mód egy biztonsági funkció, amely meghatározza, hogy ki használhatja a számítást, és hogy milyen adatokhoz férhetnek hozzá a számításon keresztül. Az Azure Databricks minden számítása rendelkezik hozzáférési móddal.

A Databricks azt javasolja, hogy minden számítási feladathoz használjon megosztott hozzáférési módot. Csak akkor használja az egyfelhasználós hozzáférési módot, ha a megosztott hozzáférési mód nem támogatja a szükséges funkciókat.

| Hozzáférési mód | Látható a felhasználó számára | UC-támogatás | Támogatott nyelvek | Jegyzetek |

|---|---|---|---|---|

| Egyetlen felhasználó | Mindig | Igen | Python, SQL, Scala, R | Egyetlen felhasználóhoz rendelhető hozzá és használhatja azt. Egyes munkaterületeken hozzárendelt hozzáférési módnak nevezzük. |

| Megosztott | Always (Prémium csomag szükséges) | Igen | Python (Databricks Runtime 11.3 LTS-en és újabb verziókon), SQL, Scala (Unity Catalog-kompatibilis számítás a Databricks Runtime 13.3 LTS és újabb használatával) | Több felhasználó is használhatja a felhasználók közötti adatelkülönítéssel. |

| Nincs megosztott elkülönítés | A Rendszergazda a felhasználói elkülönítés kényszerítésével elrejthetik ezt a hozzáférési módot a rendszergazdai beállítások lapon. | Nem | Python, SQL, Scala, R | A nem elkülönített megosztott számításhoz kapcsolódó fiókszintű beállítás érhető el. |

| Egyéni | Rejtett (minden új számításhoz) | Nem | Python, SQL, Scala, R | Ez a beállítás csak akkor jelenik meg, ha a meglévő számításhoz nincs megadott hozzáférési mód. |

Egy meglévő számítást úgy frissíthet, hogy megfeleljen a Unity-katalógus követelményeinek, ha a hozzáférési módot egyetlen felhasználóra vagy megosztottra állítja.

Feljegyzés

A Databricks Runtime 13.3 LTS és újabb verziókban az init szkriptek és kódtárak minden hozzáférési mód esetén támogatottak. A követelmények és a támogatás eltérő. Lásd: Hol telepíthetők init-szkriptek? és fürt hatókörű kódtárak.

Databricks Runtime-verziók

A Databricks Runtime a számításon futó alapvető összetevők halmaza. Válassza ki a futtatókörnyezetet a Databricks Futtatókörnyezet verziója legördülő menüben. A Databricks Runtime egyes verzióival kapcsolatos részletekért lásd a Databricks Runtime kibocsátási megjegyzéseinek verzióit és kompatibilitását. Minden verzió tartalmazza az Apache Sparkot. A Databricks a következőket javasolja:

- A teljes körű számításhoz használja a legújabb verziót, hogy biztosítsa a legújabb optimalizálást és a kód és az előre betöltött csomagok közötti legújabb kompatibilitást.

- Az operatív számítási feladatokat futtató feladatokhoz érdemes lehet a Databricks Futtatókörnyezet hosszú távú támogatási (LTS) verzióját használni. Az LTS-verzió használata biztosítja, hogy ne fusson kompatibilitási problémákba, és a frissítés előtt alaposan tesztelje a számítási feladatokat.

- Adatelemzési és gépi tanulási használati esetek esetén fontolja meg a Databricks Runtime ML-verziót.

Photon-gyorsítás használata

A Photon alapértelmezés szerint engedélyezve van a Databricks Runtime 9.1 LTS-t vagy újabb verziót futtató számításnál.

A fotongyorsítás engedélyezéséhez vagy letiltásához jelölje be a Foton-gyorsítás használata jelölőnégyzetet. A Photonről további információt a Mi a Photon? című témakörben talál.

Feldolgozó és illesztőprogram csomóponttípusai

A számítás egy illesztőcsomópontból és nulla vagy több feldolgozó csomópontból áll. Az illesztőprogram- és feldolgozócsomópontokhoz külön felhőszolgáltatói példánytípusokat választhat, de alapértelmezés szerint az illesztőprogram-csomópont ugyanazt a példánytípust használja, mint a feldolgozó csomópont. A példánytípusok különböző családjai különböző használati eseteket, például memóriaigényes vagy számítási igényű számítási feladatokat illesztenek be.

Kiválaszthatja azt a készletet is, amelyet feldolgozóként vagy illesztőprogram-csomópontként szeretne használni. Lásd: Mik azok az Azure Databricks-készletek?.

Dolgozó típusa

A többcsomópontos számításban a feldolgozó csomópontok futtatják a Spark-végrehajtókat és a megfelelő működéshez szükséges egyéb szolgáltatásokat. Amikor a számítási feladatot a Sparkkal osztja el, az összes elosztott feldolgozás a feldolgozó csomópontokon történik. Az Azure Databricks egy végrehajtót futtat munkavégző csomópontonként. Ezért a végrehajtó és a feldolgozó kifejezések felcserélhetők a Databricks-architektúra kontextusában.

Tipp.

Spark-feladat futtatásához legalább egy munkavégző csomópontra van szükség. Ha a számításnak nincs feldolgozója, futtathat nem Spark-parancsokat az illesztőcsomóponton, de a Spark-parancsok sikertelenek lesznek.

Feldolgozó csomópont IP-címei

Az Azure Databricks két privát IP-címmel indít el feldolgozó csomópontokat. A csomópont elsődleges privát IP-címe az Azure Databricks belső forgalmát üzemelteti. A másodlagos privát IP-címet a Spark-tároló használja a fürtön belüli kommunikációhoz. Ez a modell lehetővé teszi az Azure Databricks számára, hogy elkülönítést biztosítson több számítás között ugyanazon a munkaterületen.

Illesztőprogram típusa

Az illesztőprogram-csomópont megőrzi a számításhoz csatolt összes jegyzetfüzet állapotadatait. Az illesztőprogram-csomópont emellett fenntartja a SparkContextet, értelmezi a számítási jegyzetfüzetből vagy tárból futtatott összes parancsot, és futtatja a Spark-végrehajtókkal koordináló Apache Spark-főkiszolgálót.

Az illesztőcsomópont típusának alapértelmezett értéke megegyezik a munkavégző csomópont típusáéval. Nagyobb, több memóriával rendelkező illesztőprogram-csomóponttípust is választhat, ha a Spark-feldolgozóktól származó adatok nagy részét tervezi elemezni collect() a jegyzetfüzetben.

Tipp.

Mivel az illesztőprogram-csomópont megőrzi a csatolt jegyzetfüzetek összes állapotinformációját, mindenképpen válassza le a nem használt jegyzetfüzeteket az illesztőprogram-csomópontról.

GPU-példánytípusok

A nagy teljesítményt igénylő számítási feladatokhoz, például a mély tanuláshoz kapcsolódó feladatok esetében az Azure Databricks támogatja a grafikus feldolgozási egységek (GPU-k) használatával felgyorsított számításokat. További információ: GPU-kompatibilis számítás.

Azure-beli bizalmas számítási virtuális gépek

Az Azure bizalmas számítási virtuálisgép-típusai megakadályozzák az adatokhoz való jogosulatlan hozzáférést használat közben, beleértve a felhőszolgáltatót is. Ez a virtuálisgép-típus előnyös a szigorúan szabályozott iparágak és régiók, valamint a felhőben bizalmas adatokkal rendelkező vállalkozások számára. Az Azure bizalmas számítástechnikáról további információt az Azure bizalmas számítástechnikája című témakörben talál.

Ha azure-beli bizalmas számítási virtuális gépek használatával szeretné futtatni a számítási feladatokat, válassza ki a DC vagy EC sorozatú virtuálisgép-típusok közül a feldolgozó és az illesztőprogram csomópontjának legördülő listájában. Tekintse meg az Azure Confidential virtuálisgép-beállításokat.

Kihasználatlan példányok

A költségmegtakarítás érdekében a Kihasználatlan példányok jelölőnégyzet bejelölésével dönthet úgy, hogy kihasználatlan példányokat( más néven Azure Spot virtuális gépeket) használ.

Az első példány mindig igény szerinti lesz (az illesztőprogram-csomópont mindig igény szerint működik), a későbbi példányok pedig kihasználatlan példányok lesznek.

Ha a példányok nem érhetők el, az Azure Databricks megkísérli új kihasználatlan példányok beszerzését a kiürített példányok lecseréléséhez. Ha a kihasználatlan példányok nem szerezhetők be, a rendszer igény szerinti példányokat helyez üzembe a kiürített példányok helyére. Emellett, ha új csomópontokat ad hozzá a meglévő számításhoz, az Azure Databricks megpróbálja beszerezni az adott csomópontok kihasználatlan példányait.

Automatikus skálázás engedélyezése

Ha az automatikus skálázás engedélyezése be van jelölve, megadhat egy minimális és maximális számú feldolgozót a számításhoz. A Databricks ezután kiválasztja a feladat futtatásához szükséges feldolgozók számát.

Ha meg szeretné adni a számítás által automatikusan skálázandó feldolgozók minimális és maximális számát, használja a Munkavégző típus legördülő lista melletti Minimális feldolgozók és Feldolgozók maximális száma mezőt.

Ha nem engedélyezi az automatikus skálázást, rögzített számú feldolgozót fog megadni a Feldolgozó típus legördülő lista Melletti Feldolgozók mezőben.

Feljegyzés

Amikor a számítás fut, a számítási részletek oldalon megjelenik a lefoglalt feldolgozók száma. Összehasonlíthatja a kiosztott feldolgozók számát a feldolgozó konfigurációjával, és szükség szerint módosíthatja azokat.

Az automatikus skálázás előnyei

Az automatikus skálázással az Azure Databricks dinamikusan újratelepíti a dolgozókat, hogy figyelembe vegyék a feladat jellemzőit. Előfordulhat, hogy a folyamat bizonyos részei számításilag nagyobb terhelést igényelnek, mint mások, és a Databricks automatikusan további feldolgozókat ad hozzá a feladat ezen fázisai során (és eltávolítja őket, ha már nincs rájuk szükség).

Az automatikus skálázás megkönnyíti a magas kihasználtság elérését, mivel nem kell kiépítenie a számítási feladatot a számítási feladatnak megfelelően. Ez különösen azokra a számítási feladatokra vonatkozik, amelyek követelményei idővel változnak (például egy adathalmaz felfedezése egy nap során), de olyan egyszeri, rövidebb számítási feladatokra is alkalmazható, amelyek kiépítési követelményei ismeretlenek. Az automatikus skálázás így két előnyt kínál:

- A számítási feladatok gyorsabban futhatnak az állandó méretű, nem kiosztott számítási feladatokhoz képest.

- Az automatikus skálázás csökkentheti az általános költségeket egy statikus méretű számításhoz képest.

A számítás és a számítási feladat állandó méretétől függően az automatikus skálázás egyszerre nyújt egy vagy mindkét előnyt. A számítási méret alacsonyabb lehet a felhőszolgáltató példányainak leállásakor kiválasztott minimális számú feldolgozónál. Ebben az esetben az Azure Databricks folyamatosan újrapróbálkozza a példányok újbóli kiépítését a minimális feldolgozószám fenntartása érdekében.

Feljegyzés

Az automatikus skálázás nem érhető el feladatokhoz spark-submit .

Feljegyzés

A számítási automatikus skálázás korlátozásokkal rendelkezik a strukturált streamelési számítási feladatok fürtméretének leskálázásával. A Databricks a Delta Live Tables with Enhanced Autoscaling használatát ajánlja a streaming munkaterhelésekhez. Lásd: A Delta Live Tables-folyamatok fürtkihasználtságának optimalizálása továbbfejlesztett automatikus skálázással.

Az automatikus skálázás viselkedése

A Prémium és Nagyvállalati tarifacsomagok munkaterülete optimalizált automatikus skálázást használ. A standard tarifacsomag munkaterületei szabványos automatikus skálázást használnak.

Az optimalizált automatikus skálázás a következő jellemzőkkel rendelkezik:

- 2 lépésben felskálázható a minimálistól a maximumig.

- Leskálázható, még akkor is, ha a számítás nem tétlen, az shuffle fájl állapotát vizsgálva.

- Az aktuális csomópontok százalékos aránya alapján lefelé skálázható.

- A feladat számítása során leskálázható, ha a számítás kihasználatlan az elmúlt 40 másodpercben.

- Minden célú számítás esetén leskálázható, ha a számítás kihasználatlan az elmúlt 150 másodpercben.

- A

spark.databricks.aggressiveWindowDownSSpark konfigurációs tulajdonság másodpercek alatt megadja, hogy a számítás milyen gyakran hoz leskálázási döntéseket. Az érték növelésével a számítás lassabban skálázható le. A maximális érték 600.

Standard automatikus skálázást használnak a standard csomag-munkaterületeken. A standard automatikus skálázás a következő jellemzőkkel rendelkezik:

- 8 csomópont hozzáadásával kezdődik. Ezután exponenciálisan felskáláz, és a maximális érték eléréséhez annyi lépést tesz meg, amennyi szükséges.

- Leskálázható, ha a csomópontok 90%-a nem foglalt 10 percig, és a számítás legalább 30 másodpercig tétlen volt.

- Exponenciálisan lefelé skáláz, 1 csomóponttal kezdve.

Automatikus skálázás készletekkel

Ha készlethez csatolja a számítást, vegye figyelembe a következőket:

- Győződjön meg arról, hogy a kért számítási méret kisebb vagy egyenlő a készletben lévő üresjárati példányok minimális számával. Ha nagyobb, a számítási indítási idő egyenértékű lesz a készletet nem használó számítással.

- Győződjön meg arról, hogy a maximális számítási méret kisebb vagy egyenlő a készlet maximális kapacitásával . Ha nagyobb, a számítás létrehozása sikertelen lesz.

Automatikus skálázási példa

Ha újrakonfigurál egy statikus számítást automatikus skálázásra, az Azure Databricks azonnal átméretezi a számítást a minimális és maximális korláton belül, majd megkezdi az automatikus skálázást. Az alábbi táblázat például azt mutatja be, hogy mi történik egy bizonyos kezdeti mérettel rendelkező számítással, ha újrakonfigurálja a számítást 5 és 10 csomópont közötti automatikus skálázásra.

| Kezdeti méret | Újrakonfigurálás utáni méret |

|---|---|

| 6 | 6 |

| 12 | 10 |

| 3 | 5 |

Helyi tároló automatikus skálázásának engedélyezése

Gyakran nehéz megbecsülni, hogy egy adott feladat mennyi lemezterületet fog igénybe venni. Az Azure Databricks automatikusan engedélyezi a helyi tároló automatikus skálázását az összes Azure Databricks-számításon, hogy ne kelljen megbecsülnie, hogy hány gigabájtnyi felügyelt lemezt csatoljon a számításhoz a létrehozáskor.

A helyi tároló automatikus skálázásával az Azure Databricks figyeli a számítási Spark-feldolgozókon rendelkezésre álló szabad lemezterület mennyiségét. Ha egy feldolgozó túl alacsonyan kezd futni a lemezen, a Databricks automatikusan csatol egy új felügyelt lemezt a feldolgozóhoz, mielőtt elfogyna a lemezterület. A lemezek legfeljebb 5 TB lemezterületet csatolnak virtuális gépenként (beleértve a virtuális gép kezdeti helyi tárolóját is).

A virtuális géphez csatlakoztatott felügyelt lemezek csak akkor lesznek leválasztva, ha a virtuális gép visszakerül az Azure-ba. Ez azt jelzi, hogy a felügyelt lemezek soha nem lesznek leválasztva a virtuális gépekről, amíg egy futó számítás részét képezik. A felügyelt lemezek használatának leskálázásához az Azure Databricks azt javasolja, hogy használja ezt a funkciót az automatikus számítási vagy automatikus leállítással konfigurált számításban.

Helyi lemeztitkosítás

Fontos

Ez a funkció a nyilvános előzetes verzióban érhető el.

A számítás futtatásához használt példánytípusok némelyike helyileg csatlakoztatott lemezekkel rendelkezhet. Az Azure Databricks ezeket a helyileg csatlakoztatott lemezeken tárolhatja a shuffle adatokat vagy rövid élettartamú adatokat. Annak érdekében, hogy minden inaktív adat titkosítva legyen minden tárolási típushoz, beleértve az ideiglenesen a számítás helyi lemezén tárolt shuffle-adatokat is, engedélyezheti a helyi lemeztitkosítást.

Fontos

A számítási feladatok lassabban futhatnak, mert a titkosított adatok olvasása és írása a helyi kötetekbe és onnan.

Ha engedélyezve van a helyi lemeztitkosítás, az Azure Databricks helyileg létrehoz egy, az egyes számítási csomópontokra egyedi titkosítási kulcsot, amely a helyi lemezeken tárolt összes adat titkosítására szolgál. A kulcs hatóköre minden számítási csomóponton helyi, és a számítási csomóponttal együtt megsemmisül. A kulcs az élettartama során a memóriában található a titkosításhoz és a visszafejtéshez, és titkosítva tárolja a lemezen.

A helyi lemeztitkosítás engedélyezéséhez a Clusters API-t kell használnia. A számítás létrehozása vagy szerkesztése során állítsa a következőre enable_local_disk_encryptiontrue: .

Automatikus leállítás

A számításhoz beállíthatja az automatikus leállítást. A számítás létrehozása során adjon meg percek alatt egy inaktivitási időszakot, amely után le szeretné állítani a számítást.

Ha a számításon az aktuális idő és az utolsó parancsfuttatás közötti különbség nagyobb, mint a megadott inaktivitási időszak, az Azure Databricks automatikusan leállítja a számítást. A számítási leállításról további információt a számítás leállítása című témakörben talál.

Címkék

A címkék lehetővé teszik a szervezet különböző csoportjai által használt felhőerőforrások költségeinek egyszerű monitorozását. Adja meg a címkéket kulcs-érték párként a számítás létrehozásakor, és az Azure Databricks ezeket a címkéket a felhőbeli erőforrásokra, például virtuális gépekre és lemezkötetekre, valamint DBU-használati jelentésekre alkalmazza.

Készletekből indított számítás esetén az egyéni címkék csak a DBU használati jelentéseire lesznek alkalmazva, és nem propagálódnak a felhőbeli erőforrásokra.

A készlet- és számításicímkék típusainak együttes működéséről további információt a használat figyelése címkékkel című témakörben talál .

Címkék hozzáadása a számításhoz:

- A Címkék szakaszban adjon hozzá egy kulcs-érték párot az egyes egyéni címkékhez.

- Kattintson a Hozzáadás gombra.

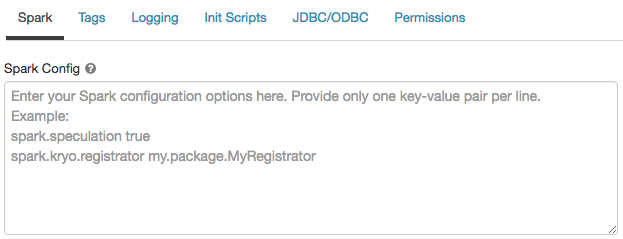

Spark-konfiguráció

A Spark-feladatok finomhangolásához egyéni Spark-konfigurációs tulajdonságokat is megadhat.

A számítási konfigurációs lapon kattintson a Speciális beállítások váltógombra.

Kattintson a Spark fülre.

A Spark-konfigurációban soronként egy kulcs-érték párként adja meg a konfigurációs tulajdonságokat.

Amikor a Fürtök API-val konfigurálja a számítást, állítsa be a Spark-tulajdonságokat a spark_conf fürt API létrehozása vagy a fürt api frissítése mezőben.

A Spark-konfigurációk számítási kényszerítéséhez a munkaterület rendszergazdái számítási szabályzatokat használhatnak.

Spark-konfigurációs tulajdonság lekérése titkos kódból

A Databricks azt javasolja, hogy az egyszerű szöveg helyett titkos kódban tárolja a bizalmas információkat, például a jelszavakat. Ha egy titkos kódra szeretne hivatkozni a Spark-konfigurációban, használja a következő szintaxist:

spark.<property-name> {{secrets/<scope-name>/<secret-name>}}

Ha például egy Spark-konfigurációs tulajdonságot szeretne beállítani, amely a következőben secrets/acme_app/passwordtárolt titkos kód értékére van meghívvapassword:

spark.password {{secrets/acme-app/password}}

További információt a Spark konfigurációs tulajdonságában vagy környezeti változójában található titkos kódokra vonatkozó szintaxisban talál.

SSH-hozzáférés a számításhoz

Biztonsági okokból az Azure Databricksben az SSH-port alapértelmezés szerint bezárul. Ha engedélyezni szeretné az SSH-hozzáférést a Spark-fürtökhöz, tekintse meg az SSH-t az illesztőprogram-csomóponthoz.

Feljegyzés

Az SSH csak akkor engedélyezhető, ha a munkaterület a saját Azure-beli virtuális hálózatában van üzembe helyezve.

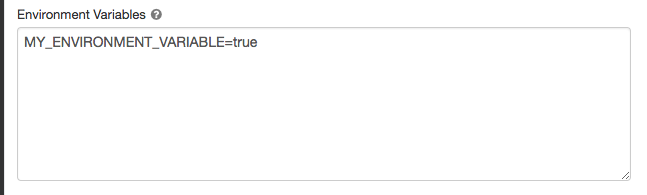

Környezeti változók

Konfiguráljon egyéni környezeti változókat, amelyek a számításon futó init szkriptekből érhetők el. A Databricks előre definiált környezeti változókat is biztosít, amelyeket init-szkriptekben használhat. Ezeket az előre definiált környezeti változókat nem lehet felülbírálni.

A számítási konfigurációs lapon kattintson a Speciális beállítások váltógombra.

Kattintson a Spark fülre.

Állítsa be a környezeti változókat a Környezeti változók mezőben.

A környezeti változókat a Fürt létrehozása API vagy a spark_env_varsFürt frissítése API mező használatával is beállíthatja.

Számítási naplók kézbesítése

Számítás létrehozásakor megadhatja a Spark-illesztő csomópont, a feldolgozó csomópontok és események naplóinak kézbesítési helyét. A naplókat öt percenként kézbesítjük, és óránként archiváljuk a kiválasztott célhelyen. A számítás leállásakor az Azure Databricks garantálja, hogy a számítási feladat befejezéséig generált összes naplót kézbesíti.

A naplók célja a számítástól cluster_idfügg. Ha a megadott cél az dbfs:/cluster-log-delivery, akkor a rendszer a számítási naplókat a következő helyre 0630-191345-leap375 kézbesíti dbfs:/cluster-log-delivery/0630-191345-leap375: .

A naplók kézbesítési helyének konfigurálása:

- A számítási lapon kattintson a Speciális beállítások váltógombra.

- Kattintson a Naplózás fülre.

- Válasszon egy céltípust.

- Adja meg a számítási napló elérési útját.

Feljegyzés

Ez a funkció a REST API-ban is elérhető. Tekintse meg a Clusters API-t.

Visszajelzés

Hamarosan elérhető: 2024-ben fokozatosan kivezetjük a GitHub-problémákat a tartalom visszajelzési mechanizmusaként, és lecseréljük egy új visszajelzési rendszerre. További információ: https://aka.ms/ContentUserFeedback.

Visszajelzés küldése és megtekintése a következőhöz: