Az Azure Data Factory összetevőinek ismertetése

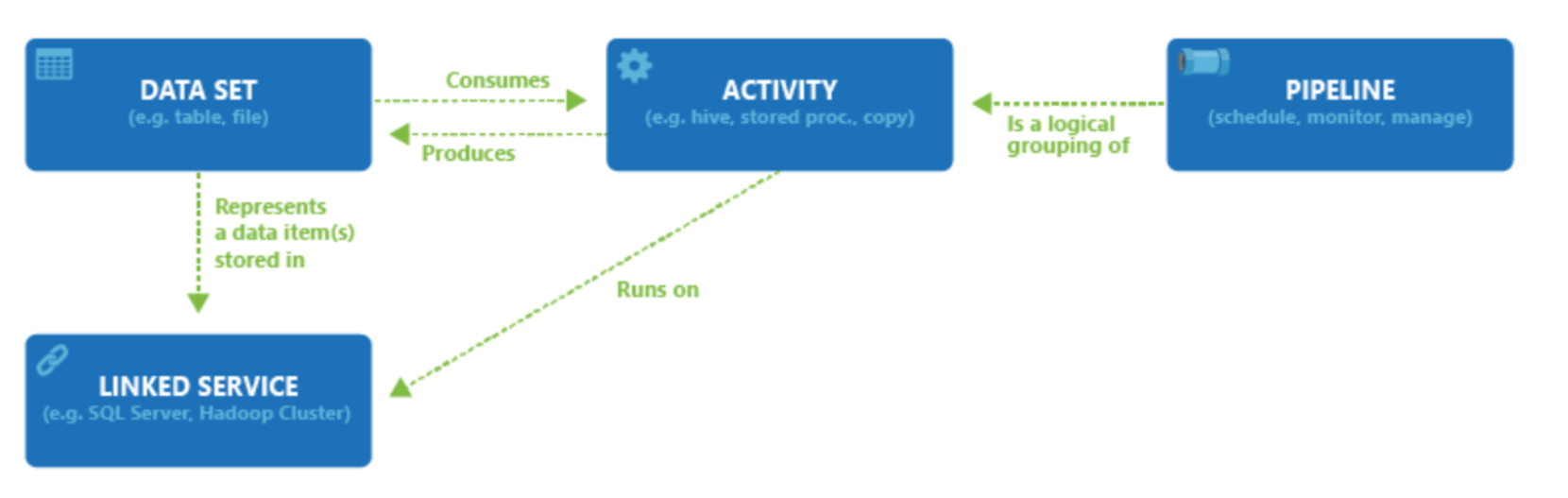

Egy Azure-előfizetés egy vagy több Azure Data Factory-példányt tartalmazhat. Az Azure Data Factory négy alapvető összetevőből áll. Ezek együtt alkotják azt a platformot, amelyen létrehozhatók olyan adatvezérelt munkafolyamatok, amelyeknek a lépései áthelyezik és átalakítják az adatokat.

A Data Factory számos különböző adatforrást támogat, amelyekhez egy társított szolgáltatásként ismert objektum létrehozásával csatlakozhat, amely lehetővé teszi, hogy az adatokat egy adatforrásból betöltse, készen arra, hogy előkészítse az adatokat az átalakításra és/vagy elemzésre. Emellett a társított szolgáltatások igény szerint ki is kapcsolhatják a számítási szolgáltatásokat. Előfordulhat például, hogy szükség van egy igény szerinti HDInsight-fürt elindítására az adatok Hive-lekérdezésen keresztüli feldolgozásának céljából. A Társított szolgáltatások lehetővé teszik az adatok betöltéséhez és előkészítéséhez szükséges adatforrások vagy számítási erőforrások definiálását.

A társított szolgáltatás definiálásával az Azure Data Factory tisztában van azokkal az adatkészletekkel, amelyeket egy Adathalmaz-objektum létrehozása során használnia kell. Az adathalmazok az adattár azon adatstruktúráit jelölik, amelyekre a társított szolgáltatás objektum hivatkozik. Az adathalmazokat egy tevékenységként ismert ADF-objektum is használhatja.

A tevékenységek általában tartalmazzák az Azure Data Factory munkájának átalakítási logikáját vagy elemzési parancsait. A tevékenységek közé tartozik a másolási tevékenység, amely különböző adatforrásokból származó adatok betöltésére használható. A kód nélküli adatátalakításokhoz a leképezési Adatfolyam is belefoglalhatja. Ez magában foglalhatja egy tárolt eljárás, a Hive Query vagy a Pig szkript végrehajtását is az adatok átalakításához. Az elemzés elvégzéséhez adatokat küldhet egy gépi Tanulás-modellbe. Nem ritka, hogy több olyan tevékenység is végbe megy, amely magában foglalhatja az adatok SQL-alapú tárolt eljárásokkal való átalakítását, majd a Databricksszel végzett elemzést. Ebben az esetben több tevékenység logikailag csoportosítható egy folyamatnak nevezett objektummal, és ezek ütemezhetőkvégrehajtásra, vagy meghatározható egy eseményindító, amely meghatározza, hogy mikor kell elindítani a folyamat végrehajtását. A különböző típusú eseményekhez eltérő típusú eseményindítók tartoznak.

A vezérlési folyamat folyamattevékenységek vezénylése, amely magában foglalja a láncolási tevékenységeket egy sorrendben, elágaztatást, paramétereket definiál a folyamat szintjén, és argumentumokat ad át a folyamat igény szerinti vagy eseményindítóból történő meghívása közben. Ez magában foglalja az egyéni állapot átadását és hurkolását tárolók, valamint az egyes iterátorok számára.

A paraméterek csak olvasható konfiguráció kulcs-érték párjai. A paraméterek meghatározása a folyamatban történik. Az e paraméterekhez tartozó argumentumok továbbítása a végrehajtás során történik a futtatási környezetből, amelyet egy eseményindító vagy egy manuálisan végrehajtott folyamat hoz létre. A folyamatok tevékenységei a paraméterértékeket dolgozzák fel.

Az Azure Data Factory integrációs modullal rendelkezik, amely lehetővé teszi, hogy hidat képezhessen a tevékenység és a társított szolgáltatások objektumai között. A társított szolgáltatás hivatkozik rájuk, és megadja a számítási környezetet, ahol a tevékenység fut, vagy ahonnan a tevékenységet küldik. Így a tevékenység a lehető legközelebb eső régióban végezhető el. Az integrációs modulnak három típusa létezik, köztük az Azure, a saját üzemeltetésű és az Azure-SSIS.

Ha minden munka befejeződött, a Data Factory használatával közzéteheti a végső adathalmazt egy másik társított szolgáltatásban, amelyet aztán olyan technológiák használhatnak fel, mint a Power BI vagy a Machine Tanulás.