Menggunakan Azure Data Lake Storage Gen1 untuk persyaratan big data

Catatan

Azure Data Lake Storage Gen1 sekarang dihentikan. Lihat pengumuman penghentian di sini. Data Lake Storage Gen1 sumber daya tidak lagi dapat diakses. Jika Anda memerlukan bantuan khusus, silakan hubungi kami.

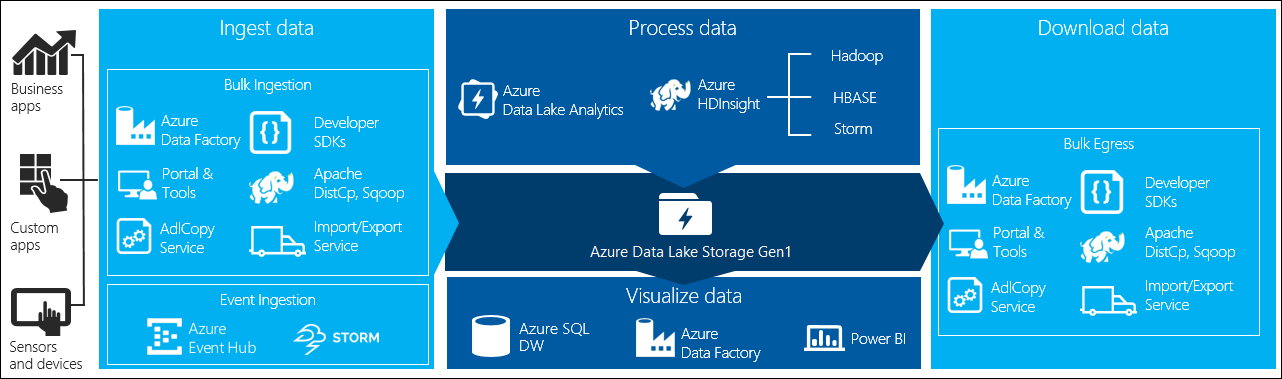

Ada empat tahap utama dalam pemrosesan big data:

- Menyerap data dalam jumlah besar ke dalam penyimpanan data, secara real-time atau dalam batch

- Memproses data

- Mengunduh data

- Memvisualisasikan data

Dalam artikel ini, kami melihat tahapan ini sehubungan dengan Azure Data Lake Storage Gen1 untuk memahami opsi dan alat yang tersedia untuk memenuhi kebutuhan data besar Anda.

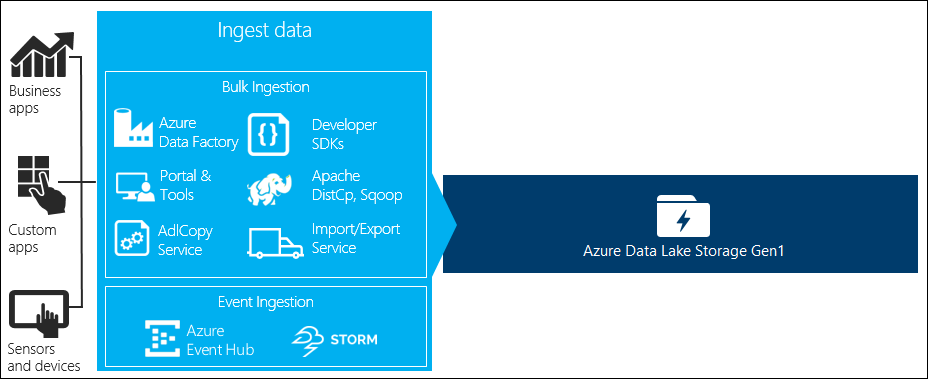

Menyerap data ke dalam Data Lake Storage Gen1

Bagian ini menyoroti berbagai sumber data dan berbagai cara di mana data tersebut dapat diserap ke dalam akun Data Lake Storage Gen1.

Data ad hoc

Ini menunjukkan kumpulan data yang lebih kecil yang digunakan untuk membuat prototipe aplikasi big data. Ada berbagai cara untuk menyerap data ad hoc tergantung pada sumber data.

| Sumber Data | Serap menggunakan |

|---|---|

| Komputer lokal | |

| Azure Storage Blob |

Data yang dialirkan

Ini mewakili data yang dapat dihasilkan oleh berbagai sumber seperti aplikasi, perangkat, sensor, dll. Data ini dapat diserap ke dalam Data Lake Storage Gen1 dengan berbagai alat. Alat-alat ini biasanya akan menangkap dan memproses data berdasarkan kejadian per kejadian secara real-time, dan kemudian menulis kejadian dalam batch ke Dalam Data Lake Storage Gen1 sehingga mereka dapat diproses lebih lanjut.

Berikut ini adalah alat yang bisa Anda gunakan:

- Azure Stream Analytics - Kejadian yang diserap ke dalam Event Hubs dapat ditulis ke Azure Data Lake Storage Gen1 menggunakan output Azure Data Lake Storage Gen1.

- EventProcessorHost – Anda dapat menerima acara dari Azure Event Hubs dan kemudian menulisnya ke Data Lake Storage Gen1 menggunakan .NET SDK Data Lake Storage Gen1.

Database relasional

Anda juga bisa mengambil sumber data dari database relasional. Selama periode waktu tertentu, database relasional mengumpulkan sejumlah besar data yang dapat memberikan wawasan utama jika diproses melalui saluran big data. Anda dapat menggunakan alat berikut untuk memindahkan data tersebut ke Data Lake Storage Gen1.

Data log server web (unggah menggunakan aplikasi kustom)

Jenis dataset ini secara khusus dipanggil karena analisis data log server web adalah kasus penggunaan umum untuk aplikasi big data dan memerlukan volume file log yang besar untuk diunggah ke Data Lake Storage Gen1. Anda dapat menggunakan salah satu alat berikut untuk menulis skrip atau aplikasi Anda sendiri untuk mengunggah data tersebut.

Untuk mengunggah data log server web, dan juga untuk mengunggah jenis data lain (misalnya data sentimen sosial), ini adalah pendekatan yang baik untuk menulis skrip / aplikasi kustom Anda sendiri karena memberi Anda fleksibilitas untuk menyertakan komponen pengunggahan data Anda sebagai bagian dari aplikasi big data Anda yang lebih besar. Dalam beberapa kasus, kode ini dapat berupa skrip atau utilitas baris perintah sederhana. Dalam kasus lain, kode dapat digunakan untuk mengintegrasikan pemrosesan big data ke dalam aplikasi atau solusi bisnis.

Data yang terkait dengan kluster Azure HDInsight

Sebagian besar jenis kluster HDInsight (Hadoop, HBase, Storm) mendukung Data Lake Storage Gen1 sebagai repositori penyimpanan data. Kluster HDInsight mengakses data dari Azure Storage Blob (WASB). Untuk kinerja yang lebih baik, Anda dapat menyalin data dari WASB ke akun Data Lake Storage Gen1 yang terkait dengan kluster. Anda bisa menggunakan alat berikut untuk menyalin data.

Data yang disimpan di kluster di tempat atau IaaS Hadoop

Data dalam jumlah besar dapat disimpan di kluster Hadoop yang ada, secara lokal pada mesin menggunakan HDFS. Kluster Hadoop mungkin berada dalam penyebaran lokal atau mungkin berada dalam kluster IaaS di Azure. Mungkin ada persyaratan untuk menyalin data tersebut ke Azure Data Lake Storage Gen1 untuk pendekatan satu kali atau dengan cara berulang. Ada berbagai opsi yang dapat Anda gunakan untuk mencapai hal ini. Berikut ini adalah daftar alternatif dan trade-off terkait.

| Pendekatan | Detail | Kelebihan | Pertimbangan |

|---|---|---|---|

| Gunakan Azure Data Factory (ADF) untuk menyalin data langsung dari kluster Hadoop ke Azure Data Lake Storage Gen1 | ADF mendukung HDFS sebagai sumber data | ADF menyediakan dukungan out-of-the-box untuk HDFS dan manajemen dan pemantauan end-to-end kelas satu | Memerlukan Gateway Manajemen Data untuk digunakan di tempat atau di klaster IaaS |

| Ekspor data dari Hadoop sebagai file. Lalu salin file ke Azure Data Lake Storage Gen1 menggunakan mekanisme yang sesuai. | Anda dapat menyalin file ke Azure Data Lake Storage Gen1 menggunakan:

|

Memulai cepat. Dapat melakukan unggahan yang disesuaikan | Proses multi-langkah yang melibatkan beberapa teknologi. Manajemen dan pemantauan akan tumbuh menjadi tantangan dari waktu ke waktu mengingat sifat alat yang disesuaikan |

| Gunakan Distcp untuk menyalin data dari Hadoop ke Azure Storage. Kemudian salin data dari Azure Storage ke Data Lake Storage Gen1 menggunakan mekanisme yang sesuai. | Anda dapat menyalin data dari Azure Storage ke Data Lake Storage Gen1 menggunakan: | Anda dapat menggunakan alat sumber terbuka. | Proses multi-langkah yang melibatkan beberapa teknologi |

Himpunan data yang sangat besar

Untuk mengunggah himpunan data yang berkisar di beberapa terabyte, menggunakan metode yang dijelaskan di atas terkadang bisa lambat dan mahal. Dalam kasus seperti itu, Anda dapat menggunakan opsi di bawah.

Menggunakan Azure ExpressRoute. Azure ExpressRoute memungkinkan Anda membuat sambungan privat antara pusat data Azure dan infrastruktur lokal Anda. Ini menyediakan opsi yang dapat diandalkan untuk mentransfer data dalam jumlah besar. Untuk informasi selengkapnya, lihat dokumentasi Azure ExpressRoute.

Unggahan data "Offline" . Jika menggunakan Azure ExpressRoute tidak memungkinkan karena alasan apa pun, Anda dapat menggunakan layanan Import/Export Azure untuk mengirimkan hard disk drive dengan data Anda ke pusat data Azure. Pertama-tama, data Anda diunggah ke penyimpanan Azure Storage Blobs. Anda lalu dapat menggunakan Azure Data Factory atau alat AdlCopy untuk menyalin data dari Azure Storage Blobs ke Data Lake Storage Gen1.

Catatan

Saat menggunakan layanan Import/Export, ukuran file pada disk yang Anda kirim ke pusat data Azure tidak boleh lebih besar dari 195 GB.

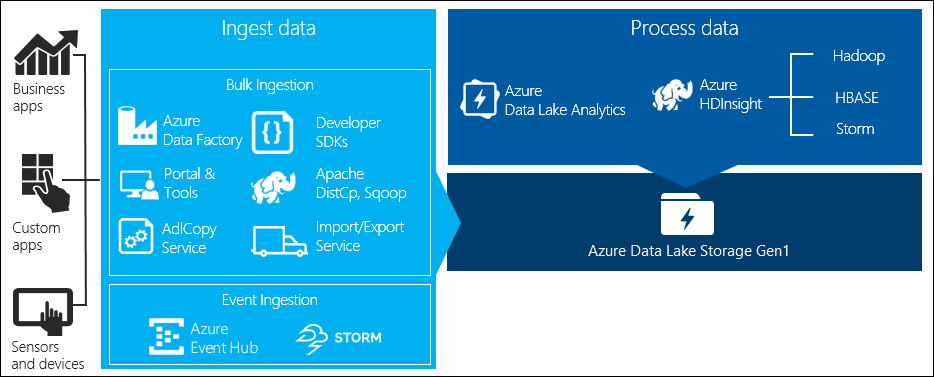

Memproses data yang disimpan dalam Data Lake Storage Gen1

Setelah data tersedia di Data Lake Storage Gen1 Anda dapat menjalankan analisis pada data tersebut menggunakan aplikasi big data yang didukung. Saat ini, Anda dapat menggunakan Azure HDInsight dan Azure Data Lake Analytics untuk menjalankan tugas analisis data pada data yang disimpan di Data Lake Storage Gen1.

Anda dapat melihat contoh-contoh berikut.

- Buat kluster HDInsight dengan Data Lake Storage Gen1 sebagai penyimpanan

- Gunakan Azure Data Lake Analytics dengan Data Lake Storage Gen1

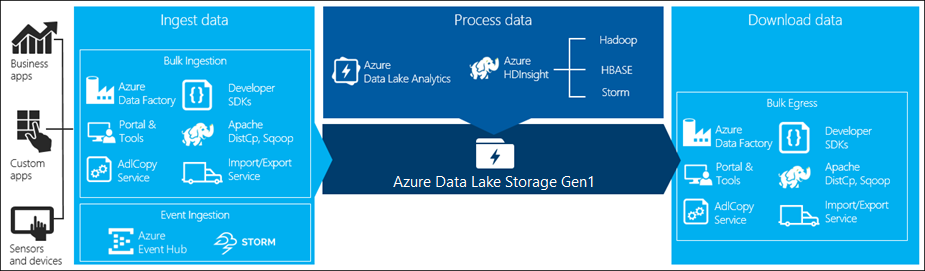

Unduh data dari Data Lake Storage Gen1

Anda mungkin juga ingin mengunduh atau memindahkan data dari Azure Data Lake Storage Gen1 untuk skenario seperti:

- Pindahkan data ke repositori lain untuk berinteraksi dengan saluran pemrosesan data yang ada. Misalnya, Anda mungkin ingin memindahkan data dari Data Lake Storage Gen1 ke Azure SQL Database atau SQL Server.

- Unduh data ke komputer lokal Anda untuk diproses di lingkungan IDE saat membuat prototipe aplikasi.

Dalam kasus seperti itu, Anda dapat menggunakan salah satu opsi berikut:

Anda juga dapat menggunakan metode berikut untuk menulis skrip/aplikasi Anda sendiri untuk mengunduh data dari Data Lake Storage Gen1.

Visualisasikan data di Data Lake Storage Gen1

Anda dapat menggunakan campuran layanan untuk membuat representasi visual dari data yang disimpan di Data Lake Storage Gen1.

- Anda dapat memulai dengan menggunakan Azure Data Factory untuk memindahkan data dari Data Lake Storage Gen1 ke Azure Synapse Analytics

- Setelah itu, Anda dapat mengintegrasikan Power BI dengan Azure Synapse Analytics untuk membuat representasi visual dari data.