Melacak dan mencatat kejadian untuk pesanan ekspor Azure Data Box dan Azure Data Box Heavy

Pesanan ekspor Data Box atau Data Box Heavy melewati langkah-langkah berikut: Pemesanan, penyiapan, penyalinan data, pengembalian, dan penghapusan data. Sesuai dengan setiap langkah dalam pesanan Data Box Anda, Anda dapat mengambil beberapa tindakan untuk mengontrol akses ke pesanan, mengaudit peristiwa, melacak pesanan, dan menginterpretasikan berbagai log yang dihasilkan.

Artikel ini menjelaskan secara rinci berbagai mekanisme atau alat yang tersedia untuk melacak dan mengaudit pesanan ekspor Data Box atau Data Box Heavy. Informasi dalam artikel ini berlaku untuk Data Box dan Data Box Heavy. Di bagian berikutnya, setiap referensi ke Data Box juga berlaku untuk Data Box Heavy.

Tabel berikut ini memperlihatkan ringkasan langkah-langkah pesanan ekspor Data Box dan alat yang tersedia untuk melacak dan mengaudit pesanan untuk setiap langkah.

| Tahap pesanan ekspor Data Box | Alat untuk melacak dan mengaudit |

|---|---|

| Membuat pesanan | Siapkan kontrol akses pada pesanan melalui Azure RBAC Mengaktifkan log verbose dalam pesanan |

| Pesanan diproses | Lacak pesanan melalui

|

| Menyiapkan perangkat | Akses info masuk perangkat yang dicatat dalam log Aktivitas |

| Menyalin data dari perangkat | Meninjau log penyalinan Meninjau log verbosesebelum menyalin data |

| Penghapusan data dari perangkat | Lihat rantai log kustodian termasuk log audit dan riwayat pesanan |

Menyiapkan kontrol akses pada pesanan

Anda dapat mengontrol siapa yang dapat mengakses pesanan Anda saat pesanan pertama kali dibuat. Siapkan peran Azure di berbagai cakupan untuk mengontrol akses ke pesanan Data Box. Peran Azure menentukan jenis akses; baca-tulis, baca-saja, baca-tulis ke subset operasi.

Dua peran yang dapat ditentukan untuk layanan Azure Data Box adalah:

- Pembaca Data Box - memiliki akses baca-saja ke pesanan seperti yang ditentukan oleh cakupan. Mereka hanya dapat melihat detail pesanan. Mereka tidak dapat mengakses detail lain terkait dengan akun penyimpanan atau mengedit detail pesanan seperti alamat dan sebagainya.

- Kontributor Data Box - hanya dapat membuat pesanan untuk mentransfer data ke akun penyimpanan tertentu jika mereka sudah memiliki akses tulis ke akun penyimpanan. Jika mereka tidak memiliki akses ke akun penyimpanan, mereka bahkan tidak dapat membuat pesanan Data Box untuk menyalin data ke akun. Peran ini tidak menentukan izin terkait akun Storage atau memberikan akses ke akun penyimpanan.

Untuk membatasi akses ke pesanan, Anda dapat:

- Menetapkan peran pada tingkat pesanan. Pengguna hanya memiliki izin tersebut sebagaimana didefinisikan oleh peran untuk berinteraksi dengan pesanan Data Box tertentu saja dan tidak dengan yang lain.

- Menetapkan peran di tingkat grup sumber daya, pengguna memiliki akses ke semua pesanan Data Box dalam satu grup sumber daya.

Untuk informasi selengkapnya tentang penggunaan Azure RBAC yang disarankan, lihat Praktik terbaik untuk Azure RBAC.

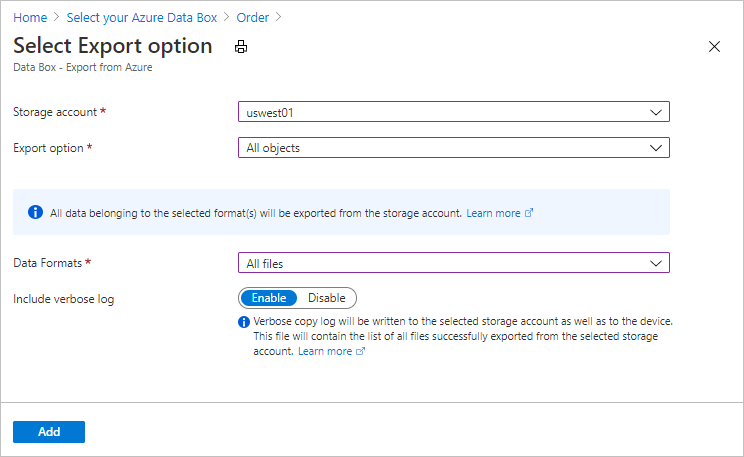

Mengaktifkan log verbose dalam pesanan

Saat membuat urutan ekspor untuk Data Box, Anda memiliki opsi untuk mengaktifkan pengumpulan log verbose. Berikut adalah layar pesanan di mana Anda dapat mengaktifkan log verbose:

Saat Anda memilih opsi Sertakan log verbose, file log verbose dibuat saat menyalin data dari akun Azure Storage Anda. Log ini memuat daftar semua file yang berhasil diekspor.

Untuk informasi selengkapnya tentang pesanan ekspor, lihat Membuat pesanan ekspor untuk Data Box

Melacak pesanan

Anda dapat melacak pesanan Anda melalui portal Microsoft Azure dan melalui situs web operator pengiriman. Mekanisme berikut ini tersedia untuk melacak pesanan Data Box kapan saja:

Untuk melacak urutan saat perangkat berada di pusat data Azure atau lokal Anda, buka Gambaran Umum pesanan > Data Box Anda di portal Azure.

Untuk melacak pesanan saat perangkat sedang dalam transit, buka situs web operator regional, misalnya, situs web UPS di AS. Berikan nomor pelacakan pesanan Anda.

Data Box juga mengirimkan pemberitahuan surel setiap kali status pesanan berubah berdasarkan alamat surel yang diberikan saat pesanan dibuat. Untuk daftar seluruh status pesanan Data Box, lihat Tampilkan status pesanan. Untuk mengubah pengaturan pemberitahuan yang berkaitan dengan pesanan, lihat Mengedit detail pemberitahuan.

Mengkueri log aktivitas saat persiapan

Data Box tiba di tempat Anda dalam keadaan terkunci. Anda dapat menggunakan info masuk perangkat yang tersedia di portal Microsoft Azure untuk pesanan Anda.

Saat Data Box disiapkan, Anda mungkin perlu mengetahui siapa saja yang mengakses info masuk perangkat. Untuk mencari tahu siapa yang mengakses bilah Info masuk perangkat, Anda dapat mengkueri log Aktivitas. Setiap tindakan yang melibatkan akses bilah Kredensial detail > Perangkat dicatat ke log aktivitas sebagai

ListCredentialstindakan.

Setiap masuk ke Data Box dicatat secara real time. Namun, informasi ini hanya tersedia dalam Rantai log audit kustodian setelah pesanan berhasil diselesaikan.

Melihat log saat penyalinan data

Sebelum menyalin data dari Data Box, Anda dapat mengunduh dan meninjau log penyalinan dan log verbose untuk data yang disalin ke Data Box. Log ini dibuat saat data disalin dari akun Storage Anda di Azure ke Data Box Anda.

Menyalin log

Sebelum Anda menyalin data dari Data Box Anda, unduh log penyalinan dari halaman Sambungkan dan salin.

Berikut adalah sampel output log penyalinan ketika tidak ada kesalahan dan semua file disalin saat penyalinan data dari Azure ke perangkat Data Box.

<CopyLog Summary="Summary">

<Status>Succeeded</Status>

<TotalFiles_Blobs>5521</TotalFiles_Blobs>

<FilesErrored>0</FilesErrored>

</CopyLog>

Berikut adalah sampel output ketika log penyalinan memiliki kesalahan dan beberapa file gagal disalin dari Azure.

<ErroredEntity CloudFormat="AppendBlob" Path="export-ut-appendblob/wastorage.v140.3.0.2.nupkg">

<Category>UploadErrorCloudHttp</Category>

<ErrorCode>400</ErrorCode>

<ErrorMessage>UnsupportBlobType</ErrorMessage>

<Type>File</Type>

</ErroredEntity><ErroredEntity CloudFormat="AppendBlob" Path="export-ut-appendblob/xunit.console.Primary_2020-05-07_03-54-42-PM_27444.hcsml">

<Category>UploadErrorCloudHttp</Category>

<ErrorCode>400</ErrorCode>

<ErrorMessage>UnsupportBlobType</ErrorMessage>

<Type>File</Type>

</ErroredEntity><ErroredEntity CloudFormat="AppendBlob" Path="export-ut-appendblob/xunit.console.Primary_2020-05-07_03-54-42-PM_27444 (1).hcsml">

<Category>UploadErrorCloudHttp</Category>

<ErrorCode>400</ErrorCode>

<ErrorMessage>UnsupportBlobType</ErrorMessage>

<Type>File</Type>

</ErroredEntity><CopyLog Summary="Summary">

<Status>Failed</Status>

<TotalFiles_Blobs>4</TotalFiles_Blobs>

<FilesErrored>3</FilesErrored>

</CopyLog>

Anda memiliki opsi berikut untuk mengekspor file tersebut:

- Anda bisa mentransfer file yang tidak dapat disalin melalui jaringan.

- Jika ukuran data Anda lebih besar dari kapasitas perangkat yang dapat digunakan, maka penyalinan parsial terjadi dan semua file yang tidak disalin tercantum dalam log ini. Anda dapat menggunakan log ini sebagai XML input untuk membuat pesanan Data Box baru lalu menyalin file-file ini.

Log verbose

Log verbose berisi daftar semua file yang berhasil diekspor dari akun Azure Storage. Log juga berisi ukuran file dan komputasi checksum.

Log verbose memiliki informasi dalam format berikut:

<file size = "file-size-in-bytes" crc64="cyclic-redundancy-check-string">\folder-path-on-data-box\name-of-file-copied.md</file>

Berikut adalah sampel output dari log verbose.

<File CloudFormat="BlockBlob" Path="validblobdata/test1.2.3.4" Size="1024" crc64="7573843669953104266">

</File><File CloudFormat="BlockBlob" Path="validblobdata/helloEndWithDot..txt" Size="11" crc64="7320094093915972193">

</File><File CloudFormat="BlockBlob" Path="validblobdata/test..txt" Size="12" crc64="17906086011702236012">

</File><File CloudFormat="BlockBlob" Path="validblobdata/test1" Size="1024" crc64="7573843669953104266">

</File><File CloudFormat="BlockBlob" Path="validblobdata/test1.2.3" Size="1024" crc64="7573843669953104266">

</File><File CloudFormat="BlockBlob" Path="validblobdata/.......txt" Size="11" crc64="7320094093915972193">

</File><File CloudFormat="BlockBlob" Path="validblobdata/copylogb08fa3095564421bb550d775fff143ed====..txt" Size="53638" crc64="1147139997367113454">

</File><File CloudFormat="BlockBlob" Path="validblobdata/testmaxChars-123456790-123456790-123456790-123456790-123456790-123456790-123456790-123456790-123456790-123456790-123456790-123456790-123456790-123456790-123456790-123456790-123456790-123456790-123456790-123456790-12345679" Size="1024" crc64="7573843669953104266">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/file0" Size="0" crc64="0">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/file1" Size="0" crc64="0">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/file4096_000001" Size="4096" crc64="16969371397892565512">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/file4096_000000" Size="4096" crc64="16969371397892565512">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/64KB-Seed10.dat" Size="65536" crc64="10746682179555216785">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/LiveSiteReport_Oct.xlsx" Size="7028" crc64="6103506546789189963">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/NE_Oct_GeoReport.xlsx" Size="103197" crc64="13305485882546035852">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/64KB-Seed1.dat" Size="65536" crc64="3140622834011462581">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/1mbfiles-0-0" Size="1048576" crc64="16086591317856295272">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/file524288_000001" Size="524288" crc64="8908547729214703832">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/4mbfiles-0-0" Size="4194304" crc64="1339017920798612765">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/file524288_000000" Size="524288" crc64="8908547729214703832">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/8mbfiles-0-1" Size="8388608" crc64="3963298606737216548">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/1mbfiles-0-1" Size="1048576" crc64="11061759121415905887">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/XLS-10MB.xls" Size="1199104" crc64="2218419493992437463">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/8mbfiles-0-0" Size="8388608" crc64="1072783424245035917">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/4mbfiles-0-1" Size="4194304" crc64="9991307204216370812">

</File><File CloudFormat="BlockBlob" Path="export-ut-container/VL_Piracy_Negtive10_TPNameAndGCS.xlsx" Size="12398699" crc64="13526033021067702820">

</File>

Log verbose juga disalin ke akun penyimpanan Azure. Secara default, log ditulis ke kontainer bernama copylog. Log disimpan dengan konvensi penamaan berikut:

storage-account-name/databoxcopylog/ordername_device-serial-number_CopyLog_guid.xml.

Jalur log salin juga ditampilkan pada bilah Ringkasan untuk portal.

Anda dapat menggunakan log ini untuk memverifikasi bahwa file yang disalin dari Azure cocok dengan data yang disalin ke server lokal Anda.

Gunakan file log verbose Anda:

- Untuk memverifikasi nama aktual dan jumlah file yang disalin dari Data Box.

- Untuk memverifikasi ukuran aktual file.

- Untuk memverifikasi bahwa crc64 sesuai dengan string bukan nol. Komputasi Cyclic Redundancy Check (CRC) dilakukan saat ekspor dari Azure. CRC dari ekspor dan setelah data disalin dari Data Box ke server lokal dapat dibandingkan. Ketidakcocokan CRC menunjukkan bahwa file terkait gagal diunggah.

Mendapatkan rantai log kustodian setelah penghapusan data

Setelah data dihapus dari disk Data Box sesuai pedoman NIST SP 800-88 Revisi 1, rantai log kustodian akan tersedia. Log ini termasuk rantai log audit kustodian dan riwayat pesanan. File BOM atau file manifes juga ikut disalin dengan log audit.

Rantai log audit kustodian

Rantai log audit kustodian berisi informasi tentang memulai dan mengakses berbagi pada Data Box atau Data Box Heavy ketika berada di luar pusat data Azure. Log ini terletak di: storage-account/azuredatabox-chainofcustodylogs

Berikut adalah contoh log audit dari Data Box:

9/10/2018 8:23:01 PM : The operating system started at system time 2018-09-10T20:23:01.497758400Z.

9/10/2018 8:23:42 PM : An account was successfully logged on.

Subject:

Security ID: S-1-5-18

Account Name: WIN-DATABOXADMIN

Account Domain: Workgroup

Logon ID: 0x3E7

Logon Information:

Logon Type: 3

Restricted Admin Mode: -

Virtual Account: No

Elevated Token: No

Impersonation Level: Impersonation

New Logon:

Security ID: S-1-5-7

Account Name: ANONYMOUS LOGON

Account Domain: NT AUTHORITY

Logon ID: 0x775D5

Linked Logon ID: 0x0

Network Account Name: -

Network Account Domain: -

Logon GUID: {00000000-0000-0000-0000-000000000000}

Process Information:

Process ID: 0x4

Process Name:

Network Information:

Workstation Name: -

Source Network Address: -

Source Port: -

Detailed Authentication Information:

Logon Process: NfsSvr

Authentication Package:MICROSOFT_AUTHENTICATION_PACKAGE_V1_0

Transited Services: -

Package Name (NTLM only): -

Key Length: 0

This event is generated when a logon session is created. It is generated on the computer that was accessed.

The subject fields indicate the account on the local system which requested the logon. This is most commonly a service such as the Server service, or a local process such as Winlogon.exe or Services.exe.

The logon type field indicates the kind of logon that occurred. The most common types are 2 (interactive) and 3 (network).

The New Logon fields indicate the account for whom the new logon was created, i.e. the account that was logged on.

The network fields indicate where a remote logon request originated. Workstation name is not always available and may be left blank in some cases.

The impersonation level field indicates the extent to which a process in the logon session can impersonate.

The authentication information fields provide detailed information about this specific logon request.

- Logon GUID is a unique identifier that can be used to correlate this event with a KDC event.

- Transited services indicate which intermediate services have participated in this logon request.

- Package name indicates which sub-protocol was used among the NTLM protocols.

- Key length indicates the length of the generated session key. This will be 0 if no session key was requested.

9/10/2018 8:25:58 PM : An account was successfully logged on.

Mengunduh riwayat pesanan

Riwayat pesanan tersedia di portal Microsoft Azure. Jika pesanan selesai dan pembersihan perangkat (penghapusan data dari disk) telah selesai, buka pesanan perangkat Anda dan navigasi ke Detail pesanan. Opsi Unduh riwayat pesanan tersedia. Untuk informasi selengkapnya, lihat Mengunduh riwayat pesanan.

Jika Anda menggulir riwayat pesanan, Anda akan melihat:

- Informasi pelacakan operator untuk perangkat Anda.

- Peristiwa dengan aktivitas SecureErase. Peristiwa ini sesuai dengan penghapusan data pada disk.

- Link log Data Box. Jalur untuk log audit, log salin, dan file tanda urutan byte disajikan.

Berikut adalah sampel log riwayat pesanan dari portal Microsoft Azure:

-------------------------------

Microsoft Data Box Order Report

-------------------------------

Name : gus-poland

StartTime(UTC) : 9/19/2018 8:49:23 AM +00:00

DeviceType : DataBox

-------------------

Data Box Activities

-------------------

Time(UTC) | Activity | Status | Description

9/19/2018 8:49:26 AM | OrderCreated | Completed |

10/2/2018 7:32:53 AM | DevicePrepared | Completed |

10/3/2018 1:36:43 PM | ShippingToCustomer | InProgress | Shipment picked up. Local Time : 10/3/2018 1:36:43 PM at AMSTERDAM-NLD

10/4/2018 8:23:30 PM | ShippingToCustomer | InProgress | Processed at AMSTERDAM-NLD. Local Time : 10/4/2018 8:23:30 PM at AMSTERDAM-NLD

10/4/2018 11:43:34 PM | ShippingToCustomer | InProgress | Departed Facility in AMSTERDAM-NLD. Local Time : 10/4/2018 11:43:34 PM at AMSTERDAM-NLD

10/5/2018 8:13:49 AM | ShippingToCustomer | InProgress | Arrived at Delivery Facility in BRIGHTON-GBR. Local Time : 10/5/2018 8:13:49 AM at LAMBETH-GBR

10/5/2018 9:13:24 AM | ShippingToCustomer | InProgress | With delivery courier. Local Time : 10/5/2018 9:13:24 AM at BRIGHTON-GBR

10/5/2018 12:03:04 PM | ShippingToCustomer | Completed | Delivered - Signed for by. Local Time : 10/5/2018 12:03:04 PM at BRIGHTON-GBR

1/25/2019 3:19:25 PM | ShippingToDataCenter | InProgress | Shipment picked up. Local Time : 1/25/2019 3:19:25 PM at BRIGHTON-GBR

1/25/2019 8:03:55 PM | ShippingToDataCenter | InProgress | Processed at BRIGHTON-GBR. Local Time : 1/25/2019 8:03:55 PM at LAMBETH-GBR

1/25/2019 8:04:58 PM | ShippingToDataCenter | InProgress | Departed Facility in BRIGHTON-GBR. Local Time : 1/25/2019 8:04:58 PM at BRIGHTON-GBR

1/25/2019 9:06:09 PM | ShippingToDataCenter | InProgress | Arrived at Sort Facility LONDON-HEATHROW-GBR. Local Time : 1/25/2019 9:06:09 PM at LONDON-HEATHROW-GBR

1/25/2019 9:48:54 PM | ShippingToDataCenter | InProgress | Processed at LONDON-HEATHROW-GBR. Local Time : 1/25/2019 9:48:54 PM at LONDON-HEATHROW-GBR

1/25/2019 10:30:20 PM | ShippingToDataCenter | InProgress | Departed Facility in LONDON-HEATHROW-GBR. Local Time : 1/25/2019 10:30:20 PM at LONDON-HEATHROW-GBR

1/28/2019 7:11:35 AM | ShippingToDataCenter | InProgress | Arrived at Delivery Facility in AMSTERDAM-NLD. Local Time : 1/28/2019 7:11:35 AM at AMSTERDAM-NLD

1/28/2019 9:07:57 AM | ShippingToDataCenter | InProgress | With delivery courier. Local Time : 1/28/2019 9:07:57 AM at AMSTERDAM-NLD

1/28/2019 1:35:56 PM | ShippingToDataCenter | InProgress | Scheduled for delivery. Local Time : 1/28/2019 1:35:56 PM at AMSTERDAM-NLD

1/28/2019 2:57:48 PM | ShippingToDataCenter | Completed | Delivered - Signed for by. Local Time : 1/28/2019 2:57:48 PM at AMSTERDAM-NLD

1/29/2019 2:18:43 PM | PhysicalVerification | Completed |

1/29/2019 3:49:50 PM | DeviceBoot | Completed | Appliance booted up successfully.

1/29/2019 3:49:51 PM | AnomalyDetection | Completed | No anomaly detected.

2/12/2019 10:37:03 PM | DataCopy | Resumed |

2/13/2019 12:05:15 AM | DataCopy | Resumed |

2/15/2019 7:07:34 PM | DataCopy | Completed | Copy Completed.

2/15/2019 7:47:32 PM | SecureErase | Started |

2/15/2019 8:01:10 PM | SecureErase | Completed | Azure Data Box:<Device-serial-no> has been sanitized according to NIST 800-88 Rev 1.

------------------

Data Box Log Links

------------------

Account Name : gusacct

Copy Logs Path : databoxcopylog/gus-poland_<Device-serial-no>_CopyLog_<GUID>.xml

Audit Logs Path : azuredatabox-chainofcustodylogs\<GUID>\<Device-serial-no>

BOM Files Path : azuredatabox-chainofcustodylogs\<GUID>\<Device-serial-no>

Langkah berikutnya

- Pelajari cara Memecahkan masalah pada Data Box dan Data Box Heavy Anda.