Come inserire dati usando Azure Data Factory in Azure Cosmos DB per PostgreSQL

SI APPLICA A: Azure Cosmos DB per PostgreSQL (basato sull'estensione del database Citus in PostgreSQL)

Azure Data Factory è un servizio di integrazione dei dati etl basato sul cloud. Consente di creare flussi di lavoro basati sui dati per spostare e trasformare i dati su larga scala.

Usando Data Factory, è possibile creare e pianificare flussi di lavoro basati sui dati (denominati pipeline) che inseriscono dati da archivi dati diversi. Le pipeline possono essere eseguite in locale, in Azure o in altri provider di servizi cloud per l'analisi e la creazione di report.

Data Factory ha un sink di dati per Azure Cosmos DB per PostgreSQL. Il sink di dati consente di trasferire i dati (relazionali, NoSQL, file data lake) nelle tabelle di Azure Cosmos DB per PostgreSQL per l'archiviazione, l'elaborazione e la creazione di report.

Importante

Data Factory non supporta gli endpoint privati per Azure Cosmos DB per PostgreSQL al momento.

Data Factory per l'inserimento in tempo reale

Ecco i motivi principali per scegliere Azure Data Factory per l'inserimento di dati in Azure Cosmos DB per PostgreSQL:

- Facile da usare : offre un ambiente visivo senza codice per orchestrare e automatizzare lo spostamento dei dati.

- Potente : usa la capacità completa della larghezza di banda di rete sottostante, fino a 5 GiB/s velocità effettiva.

- Connettori predefiniti: integra tutte le origini dati, con più di 90 connettori predefiniti.

- Conveniente : supporta un servizio cloud serverless completamente gestito con pagamento in base al consumo che viene ridimensionato su richiesta.

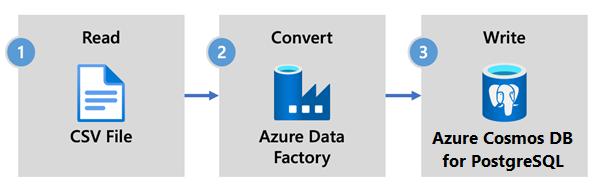

Passaggi per l'uso di Data Factory

In questo articolo viene creata una pipeline di dati usando l'interfaccia utente di Data Factory. La pipeline in questa data factory copia i dati dall'archivio BLOB di Azure a un database. Per un elenco degli archivi dati supportati come origini e sink, vedere la tabella degli archivi dati supportati.

In Data Factory è possibile usare l'attività Copia per copiare dati tra gli archivi dati che si trovano in locale e nel cloud in Azure Cosmos DB per PostgreSQL. Se non si ha familiarità con Data Factory, ecco una guida rapida su come iniziare:

Dopo il provisioning di Data Factory, passare alla data factory e avviare Azure Data Factory Studio. Verrà visualizzata la home page Data factory, come mostrato nell'immagine seguente:

Nella home page di Azure Data Factory Studio selezionare Orchestrate (Orchestra).

In Proprietà immettere un nome per la pipeline.

Nella casella degli strumenti Attività espandere la categoria Sposta e trasforma e trascinare e rilasciare l'attività Copia dati nell'area di progettazione della pipeline. Nella parte inferiore del riquadro della finestra di progettazione immettere un nome per l'attività di copia nella scheda Generale .

Configurare l'origine.

Nella pagina Attività selezionare la scheda Origine . Selezionare Nuovo per creare un set di dati di origine.

Nella finestra di dialogo Nuovo set di dati selezionare Archiviazione BLOB di Azure e quindi Continua.

Scegliere il tipo di formato dei dati e quindi selezionare Continua.

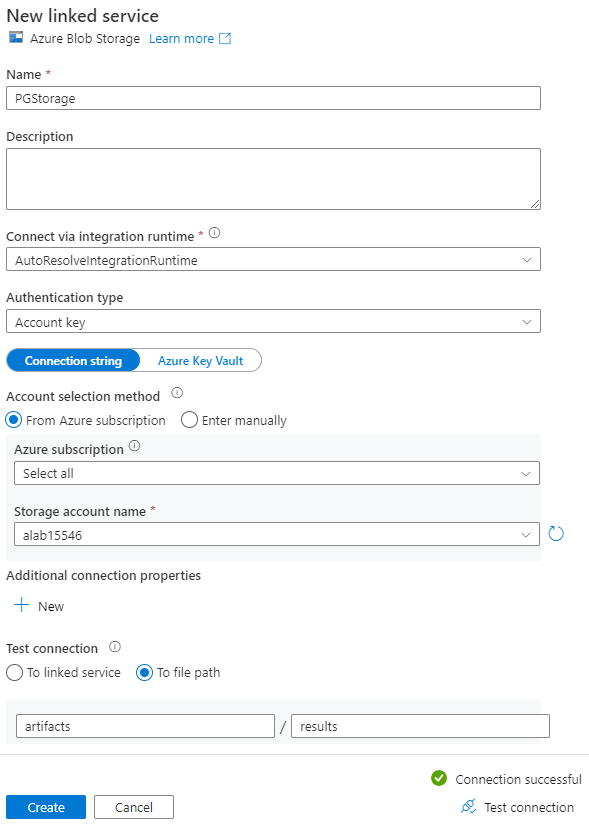

Nella pagina Imposta proprietà, in Servizio collegato, selezionare Nuovo.

Nella pagina Nuovo servizio collegato immettere un nome per il servizio collegato e selezionare l'account di archiviazione dall'elenco Archiviazione nome account.

In Test connessione selezionare Percorso file, immettere il contenitore e la directory a cui connettersi e quindi selezionare Test connessione.

Selezionare Crea per salvare la configurazione.

Nella schermata Imposta proprietà selezionare OK.

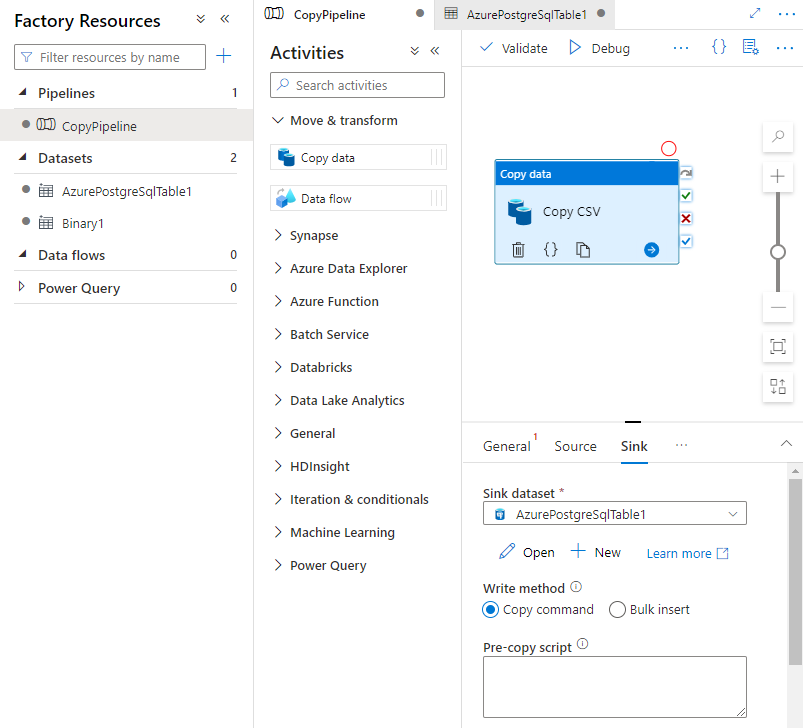

Configurare sink.

Nella pagina Attività selezionare la scheda Sink . Selezionare Nuovo per creare un set di dati sink.

Nella finestra di dialogo Nuovo set di dati selezionare Database di Azure per PostgreSQL e quindi selezionare Continua.

Nella pagina Imposta proprietà, in Servizio collegato, selezionare Nuovo.

Nella pagina Nuovo servizio collegato immettere un nome per il servizio collegato e selezionare Invio manualmentenel metodo di selezione account.

Immettere il nome coordinatore del cluster nel campo Nome di dominio completo. È possibile copiare il nome del coordinatore dalla pagina Panoramica del cluster Azure Cosmos DB per PostgreSQL.

Lasciare la porta predefinita 5432 nel campo Porta per la connessione diretta al coordinatore o sostituirla con la porta 6432 per connettersi alla porta PgBouncer gestita.

Immettere il nome del database nel cluster e specificare le credenziali per la connessione.

Selezionare SSL nell'elenco a discesa Metodo di crittografia .

Selezionare Test connessione nella parte inferiore del pannello per convalidare la configurazione del sink.

Selezionare Crea per salvare la configurazione.

Nella schermata Imposta proprietà selezionare OK.

Nella scheda Sink della pagina Attività selezionare Apri accanto all'elenco a discesa Sink dataset (Set di dati sink) e selezionare il nome della tabella nel cluster di destinazione in cui si desidera inserire i dati.

In Write method (Metodo di scrittura) selezionare Copy command (Copia comando).

Sulla barra degli strumenti sopra l'area di disegno selezionare Convalida per convalidare le impostazioni della pipeline. Correggere eventuali errori, riconvalidare e verificare che la pipeline sia stata convalidata correttamente.

Selezionare Debug sulla barra degli strumenti per eseguire la pipeline.

Quando è possibile eseguire correttamente la pipeline, nella barra degli strumenti superiore selezionare Pubblica tutto. Questa azione pubblica le entità create (set di dati e pipeline) in Data Factory.

Chiamare una stored procedure in Data Factory

In alcuni scenari specifici, è possibile chiamare una stored procedure o una funzione per eseguire il push dei dati aggregati dalla tabella di staging alla tabella di riepilogo. Data Factory non offre un'attività stored procedure per Azure Cosmos DB per PostgreSQL, ma come soluzione alternativa è possibile usare l'attività Lookup con una query per chiamare una stored procedure, come illustrato di seguito:

Passaggi successivi

- Informazioni su come creare un dashboard in tempo reale con Azure Cosmos DB per PostgreSQL.

- Informazioni su come spostare il carico di lavoro in Azure Cosmos DB per PostgreSQL