Panoramica e architettura delle funzionalità di SAP CDC

SI APPLICA A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Suggerimento

Provare Data Factory in Microsoft Fabric, una soluzione di analisi completa per le aziende. Microsoft Fabric copre tutti gli elementi, dallo spostamento dei dati all'analisi scientifica dei dati, all'analisi in tempo reale, alla business intelligence e alla creazione di report. Scopri come avviare gratuitamente una nuova versione di valutazione .

Informazioni sulle funzionalità di SAP Change Data Capture (CDC) in Azure Data Factory e sull'architettura.

Azure Data Factory è una piattaforma di integrazione dati ETL e ELT distribuita come servizio (PaaS). Per l'integrazione dei dati SAP, Data Factory offre attualmente sei connettori di disponibilità generale:

Esigenze di estrazione dei dati

I connettori SAP in Data Factory estraggono i dati di origine SAP solo in batch. Ogni batch elabora i dati nuovi e esistenti allo stesso modo. Nell'estrazione dei dati in modalità batch, le modifiche tra set di dati esistenti e nuovi non vengono identificate. Questo tipo di modalità di estrazione non è ottimale quando si dispone di set di dati di grandi dimensioni, ad esempio tabelle con milioni o miliardi di record che cambiano spesso.

È possibile mantenere aggiornata e aggiornata la copia dei dati SAP tramite l'estrazione frequente del set di dati completo, ma questo approccio è costoso e inefficiente. È anche possibile usare una soluzione alternativa manuale e limitata per estrarre record principalmente nuovi o aggiornati. In un processo denominato filigrana, l'estrazione richiede l'uso di una colonna timestamp, l'aumento monotonico dei valori e il rilevamento continuo del valore più alto dall'ultima estrazione. Alcune tabelle, tuttavia, non dispongono di una colonna che è possibile usare per la filigrana. Questo processo non identifica anche un record eliminato come modifica nel set di dati.

Funzionalità di SAP CDC

I clienti Microsoft indicano che hanno bisogno di un connettore in grado di estrarre solo il delta tra due set di dati. Nei dati, un delta è qualsiasi modifica in un set di dati che è il risultato di un aggiornamento, un inserimento o un'eliminazione nel set di dati. Un connettore di estrazione differenziale usa la funzionalità CDC (SAP Change Data Capture) presente nella maggior parte dei sistemi SAP per determinare il delta in un set di dati. Le funzionalità di SAP CDC in Data Factory usano il framework ODP (Operational Data Provisioning) sap per replicare il delta in un set di dati di origine SAP.

Questo articolo fornisce un'architettura di alto livello delle funzionalità di SAP CDC in Azure Data Factory. Altre informazioni sulle funzionalità di SAP CDC:

- Prerequisiti e configurazione

- Configurare un runtime di integrazione self-hosted

- Configurare un servizio collegato e un set di dati di origine

- Gestire la soluzione

Come usare le funzionalità di SAP CDC

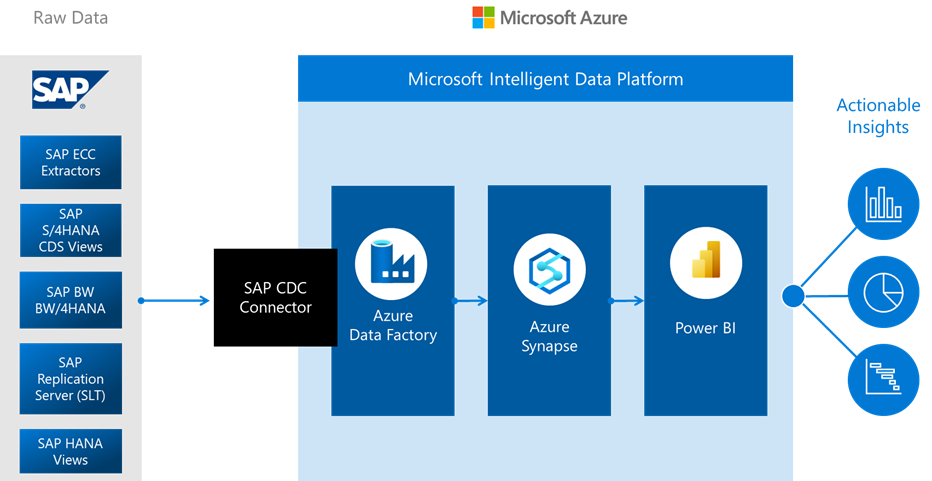

Il connettore SAP CDC è il nucleo delle funzionalità di SAP CDC. Può connettersi a tutti i sistemi SAP che supportano ODP, che include SAP ECC, SAP S/4HANA, SAP BW e SAP BW/4HANA. La soluzione funziona direttamente a livello di applicazione o indirettamente tramite un server SLT (Landscape Transformation Replication Server) SAP come proxy. Non si basa sulla filigrana per estrarre i dati SAP in modo completo o incrementale. I dati estratti dal connettore SAP CDC includono non solo tabelle fisiche, ma anche oggetti logici creati usando le tabelle. Un esempio di oggetto basato su tabelle è una vista SAP Advanced Business Application Programming (ABAP) Core Data Services (CDS).

Usare il connettore SAP CDC con funzionalità di Data Factory come le attività del flusso di dati di mapping e i trigger di finestra a cascata per una soluzione di replica SAP CDC a bassa latenza in una pipeline autogestito.

Architettura di SAP CDC

La soluzione SAP CDC in Azure Data Factory è un connettore tra SAP e Azure. Il lato SAP include il connettore SAP ODP che richiama l'API ODP su moduli RFC (Remote Function Call) standard per estrarre dati SAP completi e differenziali non elaborati.

Il lato Azure include il flusso di dati di mapping in grado di trasformare e caricare i dati SAP in qualsiasi sink di dati supportato dai flussi di dati di mapping. Alcune di queste opzioni sono destinazioni di archiviazione come Azure Data Lake Archiviazione Gen2 o database come database SQL di Azure o Azure Synapse Analytics. L'attività flusso di dati di mapping può anche caricare i risultati in Data Lake Archiviazione Gen2 in formato differenziale. È possibile usare la funzionalità Delta Lake Time Travel per produrre snapshot di dati SAP per un periodo specifico. È possibile eseguire spesso i flussi di dati della pipeline e del mapping usando un trigger di finestra a cascata di Data Factory per replicare i dati SAP in Azure con bassa latenza e senza usare la filigrana.

Per iniziare, creare un servizio collegato SAP CDC, un set di dati di origine SAP CDC e una pipeline con un'attività del flusso di dati di mapping in cui si usa il set di dati di origine SAP CDC. Per estrarre i dati da SAP, è necessario installare un runtime di integrazione self-hosted in un computer locale o in una macchina virtuale (VM) con una linea di vista per i sistemi di origine SAP o il server SLT. L'attività del flusso di dati di mapping viene eseguita in un cluster Azure Databricks o Apache Spark serverless o in un runtime di integrazione di Azure. È necessario configurare un'archiviazione di staging nell'attività del flusso di dati di mapping per rendere il runtime di integrazione self-hosted perfettamente funzionante con il runtime di integrazione del flusso di dati di mapping.

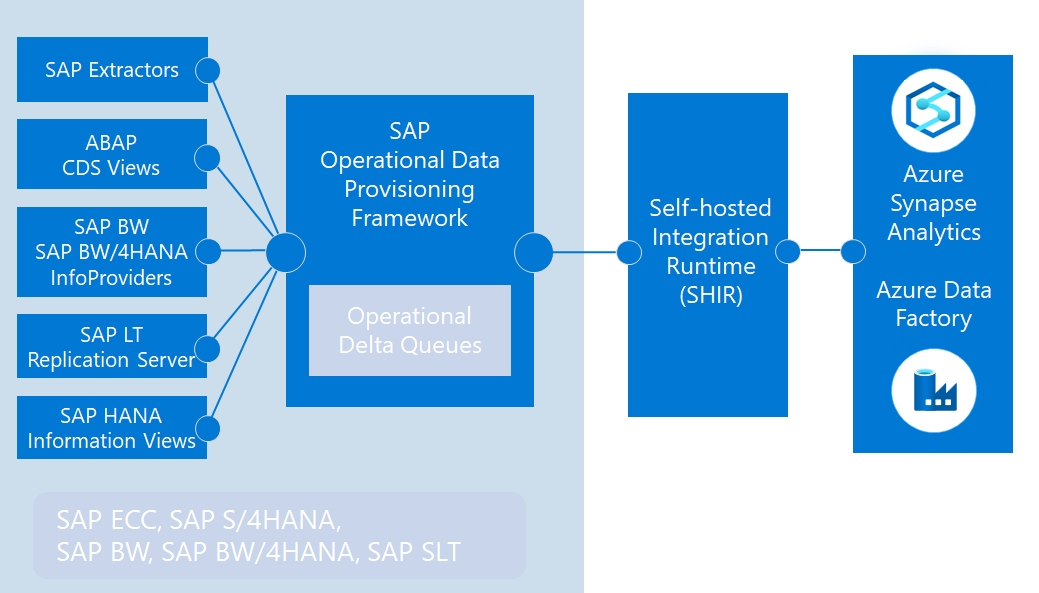

Il connettore SAP CDC usa il framework SAP ODP per estrarre vari tipi di origine dati, tra cui:

- Estrattori SAP, originariamente compilati per estrarre dati da SAP ECC e caricarli in SAP BW

- Viste ABAP CDS, il nuovo standard di estrazione dei dati per SAP S/4HANA

- Set di dati InfoProvider e InfoObjects in SAP BW e SAP BW/4HANA

- Tabelle delle applicazioni SAP, quando si usa un server di replica SAP LT (SLT) come proxy

In questo processo, le origini dati SAP sono provider. I provider vengono eseguiti nei sistemi SAP per produrre dati completi o incrementali in una coda differenziale operativa (ODQ). L'origine del flusso di dati di mapping è un sottoscrittore di ODQ.

Poiché ODP separa completamente i provider dai sottoscrittori, qualsiasi documentazione SAP che offre configurazioni del provider è applicabile a Data Factory come sottoscrittore. Per altre informazioni su ODP, vedere Introduzione al provisioning dei dati operativi.