Che cos'è l'intelligenza artificiale responsabile?

SI APPLICA A: Estensione ml dell'interfaccia della riga di comando di Azure v2 (corrente)

Estensione ml dell'interfaccia della riga di comando di Azure v2 (corrente) Python SDK azure-ai-ml v2 (corrente)

Python SDK azure-ai-ml v2 (corrente)

L'intelligenza artificiale responsabile (IA responsabile) è un approccio allo sviluppo, alla valutazione e alla distribuzione di sistemi di intelligenza artificiale in modo sicuro, affidabile ed etico. I sistemi di intelligenza artificiale sono il prodotto di molte decisioni prese da coloro che li sviluppano e li distribuiscono. Dallo scopo del sistema al modo in cui le persone interagiscono con i sistemi di intelligenza artificiale, l'intelligenza artificiale responsabile può aiutare a guidare in modo proattivo queste decisioni verso risultati più vantaggiosi ed equi. Ciò significa mantenere le persone e i loro obiettivi al centro delle decisioni di progettazione del sistema e rispettare valori durevoli come equità, affidabilità e trasparenza.

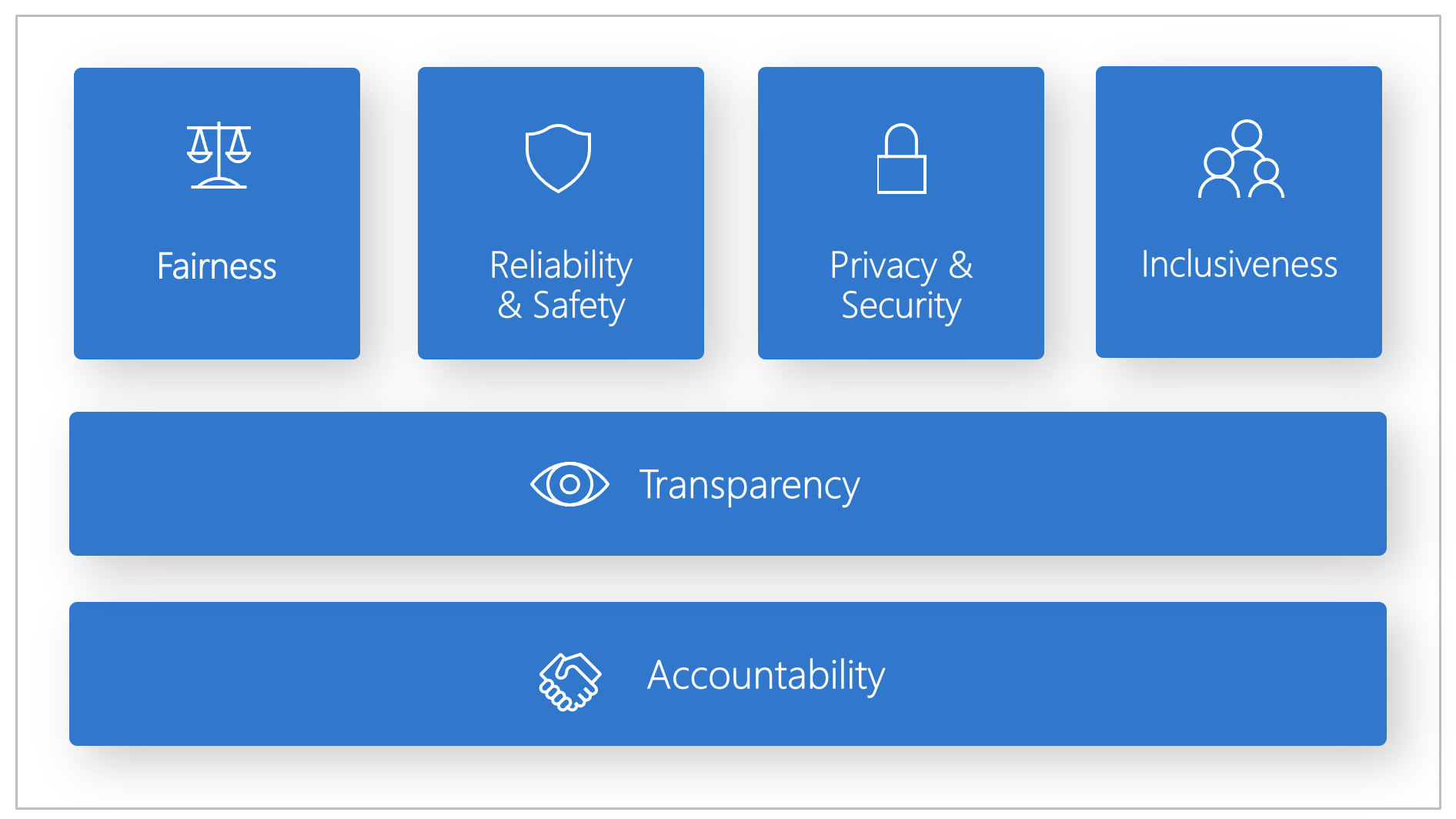

Microsoft ha sviluppato uno standard di intelligenza artificiale responsabile. Si tratta di un framework per la creazione di sistemi di intelligenza artificiale in base a sei principi: equità, affidabilità e sicurezza, privacy e sicurezza, inclusività, trasparenza e responsabilità. Per Microsoft, questi principi sono la pietra miliare di un approccio responsabile e affidabile all'intelligenza artificiale, soprattutto perché la tecnologia intelligente diventa sempre più diffusa nei prodotti e nei servizi che le persone usano ogni giorno.

Questo articolo illustra in che modo Azure Machine Learning supporta gli strumenti per consentire a sviluppatori e scienziati dei dati di implementare e rendere operativi i sei principi.

Equità e inclusività

I sistemi di IA devono trattare tutti equamente ed evitare di influire in modo diverso su gruppi di persone con collocazione analoga. Ad esempio, quando i sistemi di intelligenza artificiale forniscono indicazioni su cure mediche, richieste di prestiti o impieghi, devono fornire le stesse raccomandazioni a tutti coloro che presentano sintomi, circostanze finanziarie o qualifiche professionali simili.

Equità e inclusività in Azure Machine Learning: il componente valutazione dell'equità del dashboard di intelligenza artificiale responsabile consente a scienziati dei dati e sviluppatori di valutare l'equità dei modelli tra gruppi sensibili definiti in termini di sesso, etnia, età e altre caratteristiche.

Affidabilità e sicurezza

Per creare fiducia, è fondamentale che i sistemi di intelligenza artificiale funzionino in modo affidabile, sicuro e coerente. Questi sistemi devono essere in grado di funzionare in base alla progettazione originale, di rispondere in modo sicuro a condizioni impreviste e di resistere a manipolazioni dannose. Il comportamento e la varietà di condizioni che possono gestire riflettono la gamma di situazioni e circostanze previste dagli sviluppatori durante la progettazione e il test.

Affidabilità e sicurezza in Azure Machine Learning: il componente analisi degli errori del dashboard di intelligenza artificiale responsabile consente a scienziati dei dati e sviluppatori di:

- Ottenere una conoscenza approfondita del modo in cui viene distribuito l'errore per un modello.

- Identificare le coorti (subset) di dati con una frequenza di errore superiore rispetto al benchmark generale.

Queste discrepanze possono verificarsi quando il sistema o il modello non funziona per gruppi demografici specifici o per condizioni di input osservate raramente nei dati di training.

Trasparenza

Quando i sistemi di intelligenza artificiale aiutano a prendere decisioni che hanno un impatto enorme sulla vita delle persone, è fondamentale che le persone comprendano come sono state prese queste decisioni. Ad esempio, una banca potrebbe usare un sistema di intelligenza artificiale per decidere se una persona è solvibile. Un'azienda potrebbe usare un sistema di intelligenza artificiale per determinare i candidati più qualificati da assumere.

Una parte fondamentale della trasparenza è l'interpretabilità: la spiegazione utile del comportamento dei sistemi di intelligenza artificiale e dei relativi componenti. Per migliorare l'interpretabilità è necessario che le parti interessate comprendano come e perché i sistemi di intelligenza artificiale funzionano in un determinato modo. Le parti interessate possono quindi identificare potenziali problemi di prestazioni, problemi di equità, procedure di esclusione o risultati imprevisti.

Trasparenza in Azure Machine Learning: i componenti interpretabilità del modello e simulazione controfattuale del dashboard di intelligenza artificiale responsabile consentono a scienziati dei dati e sviluppatori di generare descrizioni comprensibili delle previsioni di un modello.

Il componente interpretabilità del modello fornisce più punti vista sul comportamento di un modello:

- Spiegazioni globali. Ad esempio, quali caratteristiche influenzano il comportamento generale di un modello di assegnazione del prestito?

- Spiegazioni locali. Ad esempio, perché la richiesta di prestito di un cliente è stata approvata o rifiutata?

- Spiegazioni del modello per una coorte selezionata di punti dati. Ad esempio, quali caratteristiche influenzano il comportamento generale di un modello di assegnazione del prestito per i richiedenti a basso reddito?

Il componente simulazione controfattuale consente di comprendere ed eseguire il debug di un modello di apprendimento automatico in termini di come reagisce i cambiamenti e alle perturbazioni delle caratteristiche.

Azure Machine Learning supporta anche una scorecard di intelligenza artificiale responsabile. La scorecard è un report PDF personalizzabile che gli sviluppatori possono facilmente configurare, generare, scaricare e condividere con le parti interessate tecniche e non tecniche per informarle sull'integrità dei set di dati e dei modelli, ottenere la conformità e creare fiducia. Questa scorecard può essere usata anche nelle verifiche di controllo per individuare le caratteristiche dei modelli di apprendimento automatico.

Privacy e sicurezza

Con la crescente diffusione dell'intelligenza artificiale, la protezione della privacy e delle informazioni personali e aziendali sta diventando sempre più importante e complessa. Con l'intelligenza artificiale, la privacy e la sicurezza dei dati richiedono una particolare attenzione perché l'accesso ai dati è essenziale per i sistemi di intelligenza artificiale per eseguire previsioni e decisioni accurate e informate sulle persone. I sistemi di intelligenza artificiale devono rispettare le leggi sulla privacy che:

- Richiedono trasparenza sulla raccolta, l'uso e l'archiviazione dei dati.

- Impongono che i consumer abbiano controlli appropriati per scegliere la modalità di utilizzo dei dati.

Privacy e sicurezza in Azure Machine Learning: Azure Machine Learning consente agli amministratori e agli sviluppatori di creare una configurazione sicura conforme ai criteri delle aziende. Con Azure Machine Learning e la piattaforma Azure, gli utenti possono:

- Limitare l'accesso alle risorse e alle operazioni per account utente o gruppo.

- Limitare le comunicazioni di rete in ingresso e in uscita.

- Crittografare i dati in transito e inattivi.

- Cercare le vulnerabilità.

- Applicare e controllare i criteri di configurazione.

Microsoft ha anche creato due pacchetti open source che possono abilitare un'ulteriore implementazione dei principi di privacy e sicurezza:

SmartNoise: la privacy differenziale è un set di sistemi e procedure che consentono di preservare la sicurezza e la riservatezza dei dati personali. Nelle soluzioni di apprendimento automatico la privacy differenziale potrebbe essere necessaria per la conformità alle normative. SmartNoise è un progetto open source (co-sviluppato da Microsoft) che contiene componenti per la creazione di sistemi privati globali in modo differenziale.

Counterfit: Counterfit è un progetto open source che comprende uno strumento da riga di comando e un livello di automazione generico per consentire agli sviluppatori di simulare attacchi informatici contro i sistemi di intelligenza artificiale. Chiunque può scaricare lo strumento e distribuirlo tramite Azure Cloud Shell per l'esecuzione in un browser o distribuirlo in locale in un ambiente Anaconda Python. Può valutare i modelli di intelligenza artificiale ospitati in diversi ambienti cloud, locali o perimetrali. Lo strumento è indipendente dai modelli di intelligenza artificiale e supporta vari tipi di dati, tra cui testo, immagini o input generici.

Responsabilità

Le persone che progettano e distribuiscono sistemi di IA devono rendere conto del funzionamento dei loro sistemi. Le organizzazioni devono fare riferimento agli standard del settore per elaborare norme di responsabilità. Queste norme possono garantire che i sistemi di intelligenza artificiale non siano l'autorità finale su qualsiasi decisione che influisca sulla vita delle persone. Possono anche garantire che gli esseri umani mantengano un controllo significativo sui sistemi di intelligenza artificiale altrimenti altamente autonomi.

Responsabilità in Azure Machine Learning: Le operazioni per l'apprendimento automatico (MLOps) sono basate su principi e procedure DevOps che aumentano l'efficienza dei flussi di lavoro di intelligenza artificiale. Azure Machine Learning offre le funzionalità MLOps seguenti per una migliore responsabilità dei sistemi di intelligenza artificiale:

- Registrare i modelli, inserirli in pacchetti e distribuirli da qualsiasi posizione. È possibile anche tenere traccia dei metadati associati necessari per usare il modello.

- Acquisire i dati di governance per il ciclo di vita dell'apprendimento automatico end-to-end. Le informazioni sulla derivazione dei dati registrate possono includere chi pubblica i modelli, perché sono state apportate modifiche e quando i modelli sono stati distribuiti o usati nell'ambiente di produzione.

- Inviare notifiche e avvisi riguardo agli eventi nel ciclo di vita dell'apprendimento automatico. Gli esempi includono il completamento dell'esperimento, la registrazione del modello, la distribuzione del modello e il rilevamento della deriva dei dati.

- Monitorare le applicazioni per problemi operativi e problemi relativi all'apprendimento automatico. Confrontare gli input del modello tra training e inferenza, esplorare le metriche specifiche del modello e offrire monitoraggio e avvisi nell'infrastruttura di apprendimento automatico.

Oltre alle funzionalità MLOps, la scorecard di intelligenza artificiale responsabile in Azure Machine Learning crea responsabilità consentendo le comunicazioni tra le parti interessate. La scorecard crea anche responsabilità consentendo agli sviluppatori di configurare, scaricare e condividere le informazioni dettagliate sull'integrità del modello con le parti interessate tecniche e non tecniche relative ai dati di intelligenza artificiale e all'integrità del modello. La condivisione di queste informazioni dettagliate può aiutare a creare fiducia.

La piattaforma di Machine Learning consente anche di prendere decisioni informando le decisioni aziendali tramite:

- Informazioni dettagliate basate sui dati, per aiutare le parti interessate a comprendere gli effetti causali del trattamento su un risultato, usando solo i dati cronologici. Ad esempio, "In che modo una medicina influisce sulla pressione sanguigna di un paziente?" Queste informazioni dettagliate vengono fornite tramite il componente inferenza causale del dashboard di intelligenza artificiale responsabile.

- Informazioni dettagliate basate su modello, per rispondere alle domande degli utenti, ad esempio "Cosa posso fare per ottenere un risultato diverso dall'intelligenza artificiale la prossima volta?", in modo da poter intervenire. Tali informazioni dettagliate vengono fornite agli scienziati dei dati tramite il componente simulazione controfattuale del dashboard di intelligenza artificiale responsabile.

Passaggi successivi

- Per altre informazioni su come implementare l'intelligenza artificiale responsabile in Azure Machine Learning, vedere Dashboard di intelligenza artificiale responsabile.

- Informazioni su come generare il dashboard di intelligenza artificiale responsabile tramite l'interfaccia della riga di comando e l'SDK o l'interfaccia utente dello studio di Azure Machine Learning.

- Informazioni su come generare una scorecard di intelligenza artificiale responsabile in base alle informazioni dettagliate osservate nel dashboard di intelligenza artificiale responsabile.

- Informazioni sullo Standard di intelligenza artificiale responsabile per la creazione di sistemi di intelligenza artificiale secondo sei principi chiave.