Configurare il training AutoML senza codice per i dati tabulari con l'interfaccia utente di Studio

In questo articolo, troverai informazioni su come configurare processi di training AutoML senza una singola riga di codice con Machine Learning automatizzato di studio di Azure Machine Learning.

Machine Learning automatizzato, AutoML, è un processo in cui viene selezionato il migliore algoritmo di Machine Learning da usare per i dati specifici. Questo processo consente di generare rapidamente modelli di Machine Learning. Altre informazioni su come Azure Machine Learning implementa Machine Learning automatizzato.

Per un esempio end-to-end, provare l'Esercitazione: AutoML- eseguire il training di modelli di classificazione senza codice.

Per un'esperienza basata su codice Python, configurare gli esperimenti di Machine Learning automatizzato con l'SDK di Azure Machine Learning.

Prerequisiti

Una sottoscrizione di Azure. Se non si ha una sottoscrizione di Azure, creare un account gratuito prima di iniziare. Provare la versione gratuita o a pagamento di Azure Machine Learning.

Un'area di lavoro di Azure Machine Learning. Consultare Creare le risorse dell'area di lavoro.

Operazioni preliminari

Accedere ad Azure Machine Learning Studio.

Selezionare la sottoscrizione e l’area di lavoro.

Passare al riquadro sinistro. Selezionare ML automatizzato nella sezione Creazione.

Poiché si tratta del primo esperimento, verranno visualizzati un elenco vuoto e collegamenti alla documentazione.

Altrimenti, verrà visualizzato un elenco degli esperimenti recenti di Machine Learning automatizzato, inclusi quelli creati con l'SDK.

Creare ed eseguire l'esperimento

Selezionare + Nuovo processo di ML automatizzato e popolare il modulo.

Selezionare un asset di dati dal contenitore di archiviazione o creare un nuovo asset di dati. Gli asset di dati possono essere creati da file locali, URL Web, archivi dati o set di dati aperti di Azure. Altre informazioni sulla creazione di asset di dati.

Importante

Requisiti per i dati di training:

- I dati devono essere in formato tabulare.

- Il valore che si desidera prevedere (colonna di destinazione) deve essere presente nei dati.

Per creare un nuovo set di dati da un file nel computer locale, selezionare + Crea set di dati, quindi selezionare Da file locale.

Selezionare Avanti per aprire il modulo di selezione file e archivio dati. è possibile selezionare la posizione in cui caricare il set di dati, il contenitore di archiviazione predefinito creato automaticamente con l'area di lavoro o scegliere un contenitore di archiviazione da usare per l'esperimento.

- Se i dati si trovano dietro una rete virtuale, è necessario abilitare la funzionalità ignorare la convalida per assicurarsi che l'area di lavoro possa accedere ai dati. Per altre informazioni, vedere Usare studio di Azure Machine Learning in una rete virtuale di Azure.

Selezionare Sfoglia per caricare il file di dati per il set di dati.

Esaminare il modulo Impostazioni e anteprima per verificarne l'accuratezza. Il modulo viene popolato in modo intelligente in base al tipo di file.

Campo Descrizione File format Definisce il layout e il tipo di dati archiviati in un file. Delimitatore Uno o più caratteri per specificare il limite tra aree distinte indipendenti in testo normale o altri flussi di dati. Codifica Identifica la tabella dello schema bit-carattere da usare per leggere il set di dati. Intestazioni di colonna Indica come verranno considerate le intestazioni del set di dati, se presenti. Ignora righe Indica quante righe vengono eventualmente ignorate nel set di dati. Selezionare Avanti.

Il modulo Schema viene popolato in modo intelligente in base alle selezioni nel modulo Impostazioni e anteprima. Qui è possibile configurare il tipo di dati per ogni colonna, esaminare i nomi delle colonne e selezionare le colonne da non includere per l'esperimento.

Selezionare Avanti.

Il modulo Conferma dettagli è un riepilogo delle informazioni con cui sono stati precedentemente popolati i moduli Info di base e Impostazioni e anteprima. È inoltre possibile creare un profilo dati per il set di dati usando un ambiente di calcolo abilitato per la profilatura.

Selezionare Avanti.

Selezionare il set di dati appena creato quando viene visualizzato. È anche possibile visualizzare un'anteprima del set di dati e delle statistiche di esempio.

Nel modulo Configura il processo selezionare Crea nuovo e immettere Tutorial-automl-deploy per il nome dell'esperimento.

Selezionare una colonna di destinazione. Si tratta della colonna su cui si desidera eseguire le previsioni.

Selezionare un tipo di ambiente di calcolo per il processo di training e profilatura dei dati. È possibile selezionare un cluster di elaborazione o l’istanza dell’ambiente di calcolo.

Selezionare un calcolo dall'elenco a discesa dei calcoli esistenti. Per creare un nuovo ambiente di calcolo, seguire le istruzioni riportate nel passaggio 8.

Selezionare Crea un nuovo ambiente di calcolo per configurare il contesto di calcolo per questo esperimento.

Campo Descrizione Nome del calcolo Immettere un nome univoco che identifichi il contesto di calcolo. Virtual machine priority Le macchine virtuali con priorità bassa sono più economiche, ma non garantiscono i nodi di calcolo. Tipo di macchina virtuale Selezionare CPU o GPU per il tipo di macchina virtuale. Dimensioni della macchina virtuale Selezionare le dimensioni della macchina virtuale per il contesto di calcolo. Nodi min/max Per profilare i dati, è necessario specificare almeno un nodo. Immettere il numero massimo di nodi per l’ambiente di calcolo. Il valore predefinito è sei nodi per un ambiente di calcolo di Azure Machine Learning. Impostazioni avanzate Queste impostazioni consentono di configurare un account utente e una rete virtuale esistente per l'esperimento. Seleziona Crea. La creazione di un nuovo ambiente di calcolo può richiedere alcuni minuti.

Selezionare Avanti.

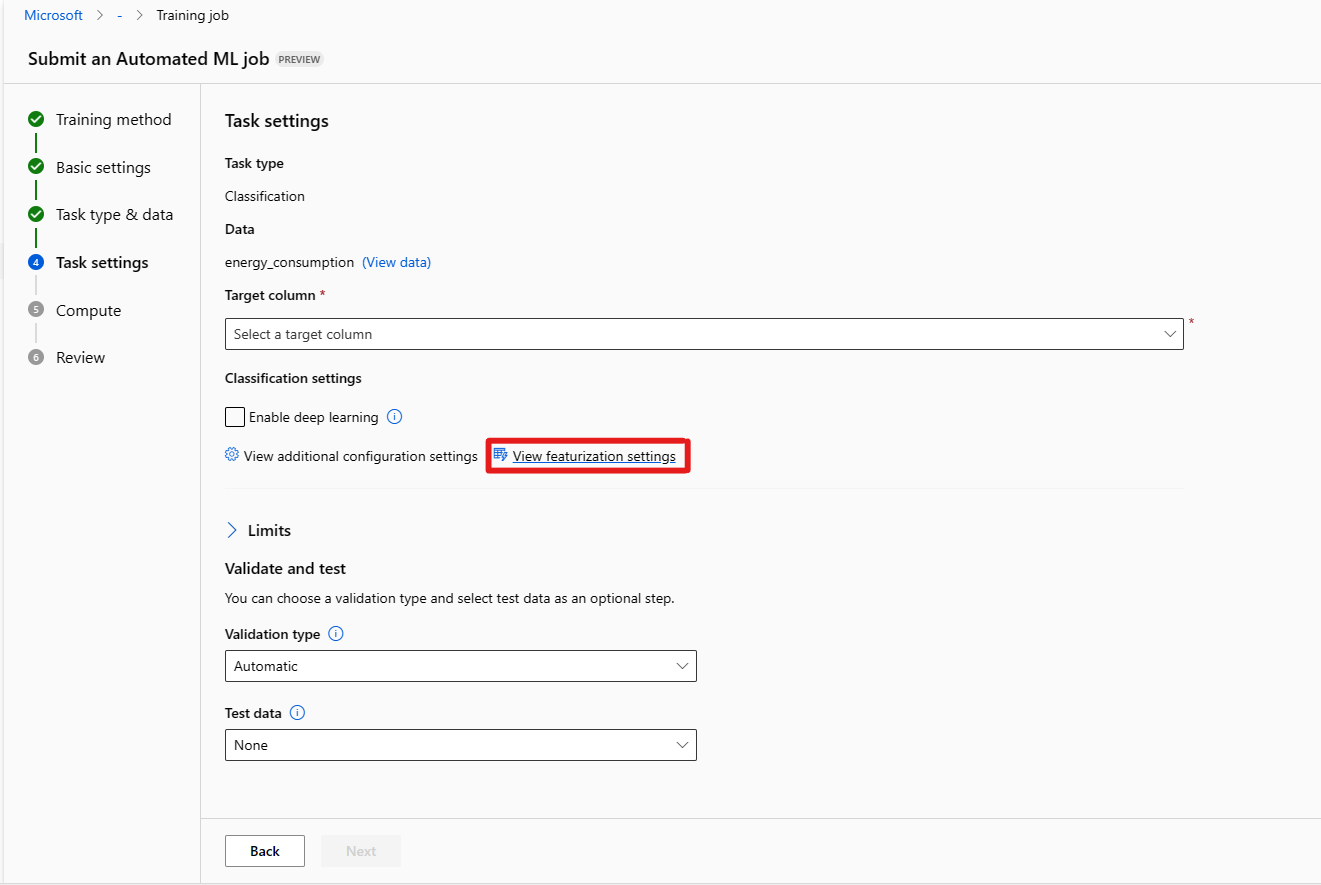

Nel modulo Tipo di attività e impostazioni selezionare il tipo di attività: classificazione, regressione o previsione. Per altre informazioni, vedere tipi di attività supportati.

Per classificazione, è anche possibile abilitare il Deep Learning.

Per previsione è possibile

Abilita Deep Learning.

Selezionare colonna ora: questa colonna contiene i dati relativi all'ora da usare.

Selezionare orizzonte di previsione: indicare il numero di unità di tempo (minuti/ore/giorni/settimane/mesi/anni) che il modello sarà in grado di prevedere in futuro. Maggiore è il tempo per il quale il modello deve effettuare previsioni nel futuro, minore sarà il livello di precisione. Altre informazioni sulla previsione e sull'orizzonte di previsione.

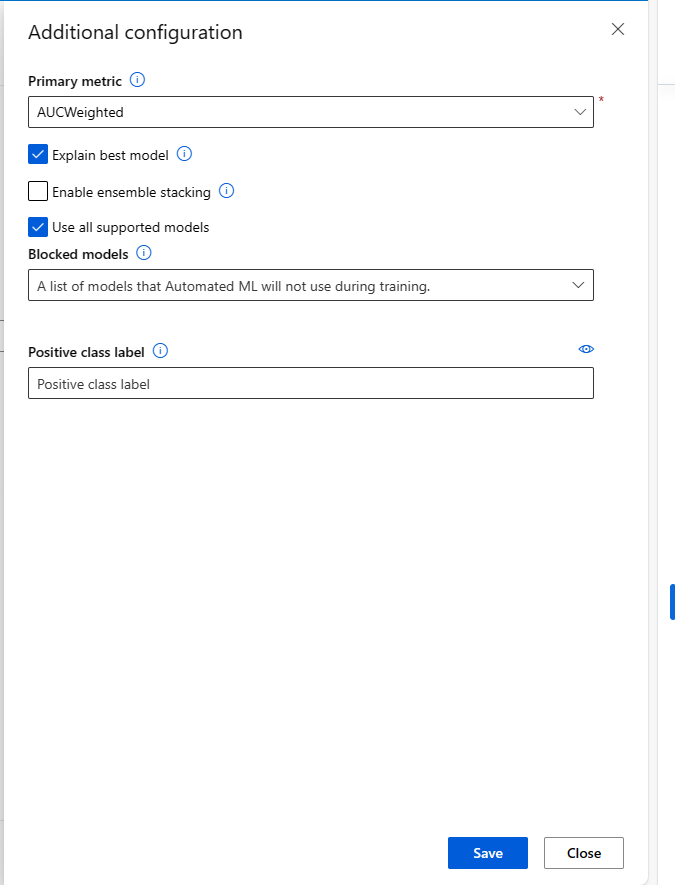

(Facoltativo) Visualizzare le impostazioni di configurazione aggiuntive: altre impostazioni che è possibile usare per controllare meglio il processo di training. Altrimenti, vengono applicate le impostazioni predefinite in base alla selezione dell'esperimento e ai dati.

Configurazioni aggiuntive Descrizione Primary metric (Metrica principale) Metrica principale usata per assegnare un punteggio al modello. Altre informazioni sulle metriche dei modelli. Abilitare la distribuzione con spaziatura dell'insieme L'apprendimento dell'insieme migliora i risultati di Machine Learning e le prestazioni predittive combinando più modelli rispetto all'uso di modelli singoli. Altre informazioni sui modelli di insieme. Modelli bloccati Selezionare i modelli da escludere dal processo di training.

L'autorizzazione dei modelli è disponibile solo per gli esperimenti SDK.

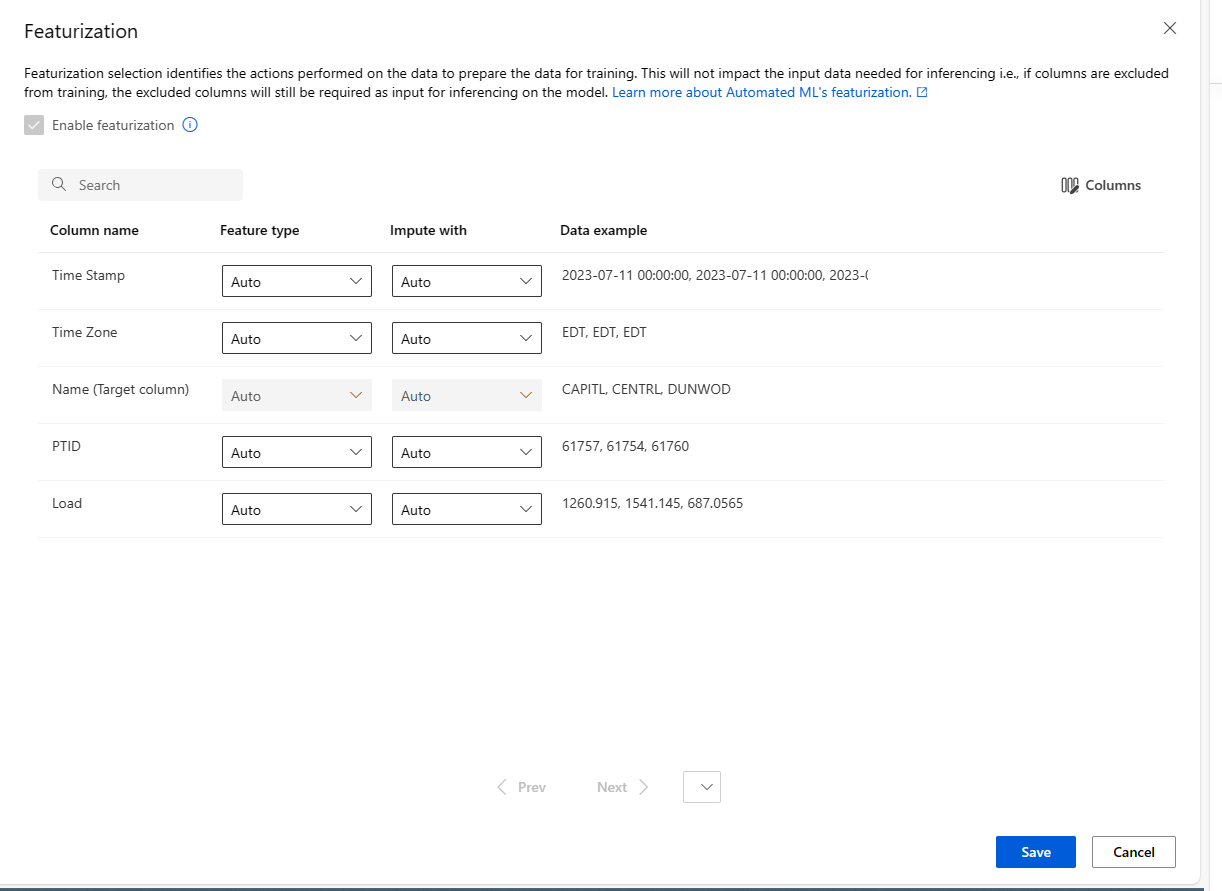

Vedere gli algoritmi supportati per ogni tipo di attività.Modello esplicativo migliore Mostra automaticamente il modello esplicativo migliore creato da ML automatizzato. Etichetta di classe positiva L’etichetta che Machine Learning automatizzato userà per calcolare le metriche binarie. (Facoltativo) Visualizzare le impostazioni di definizione delle funzionalità: se si sceglie di abilitare definizione delle funzionalità automatica nel modulo Impostazioni di configurazione aggiuntive, vengono applicate tecniche di definizione delle funzionalità predefinite. In Visualizzare le impostazioni di definizione delle funzionalità è possibile modificare queste impostazioni predefinite e personalizzare di conseguenza. Informazioni su come personalizzare la definizione delle funzionalità.

Il modulo [Facoltativo] Limiti consente di eseguire le operazioni seguenti.

Opzione Descrizione Max prova Numero massimo di prove, ognuna con una combinazione diversa di algoritmi e iperparametri da provare durante il processo AutoML. Deve essere un numero intero compreso tra 1 e 1000. Numero massimo di versioni di valutazione simultanee Numero massimo di processi di prova che possono essere eseguiti in parallelo. Deve essere un numero intero compreso tra 1 e 1000. Numero massimo di nodi Numero massimo di nodi che questo processo può usare dalla destinazione di calcolo selezionata. Soglia di punteggio metrica Quando questo valore soglia verrà raggiunto per una metrica di iterazione, il processo di training terminerà. Tenere presente che i modelli significativi hanno correlazione > 0, in caso contrario, la soglia media delle metriche deve essere compresa tra limiti [0, 10]. Timeout dell'esperimento (minuti) Tempo massimo in minuti per l'esecuzione dell'intero esperimento. Una volta raggiunto questo limite, il sistema annulla il processo AutoML, incluse tutte le relative prove (processi figli). Timeout della sessione (minuti) Tempo massimo in minuti consentito per l'esecuzione di ogni processo di prova. Una volta raggiunto questo limite, il sistema annulla la valutazione. Abilitare la terminazione anticipata Selezionare questa opzione per terminare il processo se il punteggio non migliora a breve termine. Il modulo [Facoltativo] Valida e testa consente di eseguire le operazioni seguenti.

a. Specificare il tipo di convalida da usare per il processo di training. Se non viene specificato in modo esplicito un parametro validation_data o n_cross_validations, ML automatizzato applica tecniche predefinite in base al numero di righe fornite nel singolo set di dati training_data.

| Dimensioni dei dati di training | Tecnica di convalida |

|---|---|

| Più di 20.000 righe | Viene applicata la suddivisione dei dati di training/convalida. Per impostazione predefinita, come set di convalida viene considerato il 10% del set di dati di training iniziale. A sua volta, il set di convalida viene usato per il calcolo delle metriche. |

| Meno di 20.000 righe | Viene applicato l'approccio di convalida incrociata. Il numero predefinito di riduzioni dipende dal numero di righe. Se il set di dati contiene meno di 1.000 righe, vengono usate 10 riduzioni. Se le righe sono comprese tra 1.000 e 20.000, vengono usate tre riduzioni. |

b. Fornire un set di dati di test (anteprima) per valutare il modello consigliato generato automaticamente da ML automatizzato alla fine dell'esperimento. Quando si forniscono dati di test, un processo di test viene attivato automaticamente alla fine dell'esperimento. Questo processo di test è solo sul modello migliore consigliato dal ML automatizzato. Informazioni su come ottenere i risultati del processo di test remoto.

Importante

Fornire un set di dati di test per valutare i modelli generati è una funzionalità di anteprima. Questa funzionalità è una funzionalità sperimentale di anteprima e può cambiare in qualsiasi momento.

* I dati di test sono considerati separati dal training e dalla convalida, in modo da non distorcere i risultati del processo di test del modello consigliato. Altre informazioni sulla distorsione durante la convalida del modello.

* È possibile fornire un set di dati di test personalizzato o scegliere di usare una percentuale del set di dati di training. I dati di test devono essere specificati nel formato TabularDataset di Azure Machine Learning.

* Lo schema del set di dati di test deve corrispondere al set di dati di training. La colonna di destinazione è facoltativa, ma se questa non viene indicata non viene calcolata alcuna metrica di test.

* Il set di dati di test non deve corrispondere al set di dati di training o al set di dati di convalida.

* I processi di previsione non supportano la divisione di training/test.

Personalizzare la definizione delle funzionalità

Nel modulo Definizione delle funzionalità è possibile abilitare/disabilitare la definizione automatica delle funzionalità e personalizzare le impostazioni di definizione delle funzionalità automatiche per l'esperimento. Per aprire questo modulo, vedere il passaggio 10 nella sezione Creare ed eseguire l'esperimento.

La tabella seguente riepiloga le personalizzazioni attualmente disponibili tramite lo studio.

| Istogramma | Personalizzazione |

|---|---|

| Tipo di funzionalità | Modifica il tipo di valore per la colonna selezionata. |

| Attribuisci con | Selezionare il valore con cui imputare i valori mancanti nei dati. |

Eseguire l'esperimento e visualizzare i risultati

Selezionare Fine per eseguire l'esperimento. L'esperimento di preparazione del processo può richiedere fino a 10 minuti. Per completare l'esecuzione di ogni pipeline, i processi di training possono richiedere altri 2-3 minuti. Se è stato specificato di generare il dashboard RAI per il modello consigliato, potrebbero essere necessari fino a 40 minuti.

Nota

Gli algoritmi automatizzati di Machine Learning hanno una casualità intrinseca che può causare lievi variazioni nel punteggio finale delle metriche del modello consigliato, ad esempio l'accuratezza. Machine Learning automatizzato esegue anche operazioni sui dati, ad esempio la divisione dei test di training, la divisione della convalida del training o la convalida incrociata, quando necessario. Pertanto, se si esegue più volte un esperimento con le stesse impostazioni di configurazione e la stessa metrica primaria, è probabile che si vedano variazioni nel punteggio finale di ogni esperimento a causa di questi fattori.

Visualizzare i dettagli sull'esperimento

Viene visualizzata la schermata Dettagli processo nella scheda Dettagli. Questa schermata mostra un riepilogo del processo dell'esperimento, inclusa una barra di stato in alto accanto al numero di processo.

La scheda Modelli contiene un elenco dei modelli creati, ordinati in base al punteggio della metrica. Per impostazione predefinita, il modello che riceve il punteggio più alto in base alla metrica scelta si trova all'inizio dell'elenco. Man mano che il processo di training prova altri modelli, questi vengono aggiunti all'elenco. Usare questa procedura per ottenere un rapido confronto delle metriche per i modelli prodotti finora.

Visualizza i dettagli del processo di training

Eseguire il drill-down su uno dei modelli completati per visualizzare i dettagli del processo di training.

È possibile visualizzare grafici delle metriche delle prestazioni specifici del modello nella scheda Metriche. Altre informazioni sui grafici.

È anche possibile trovare informazioni dettagliate su tutte le proprietà del modello insieme a codice, processi figlio e immagini associati.

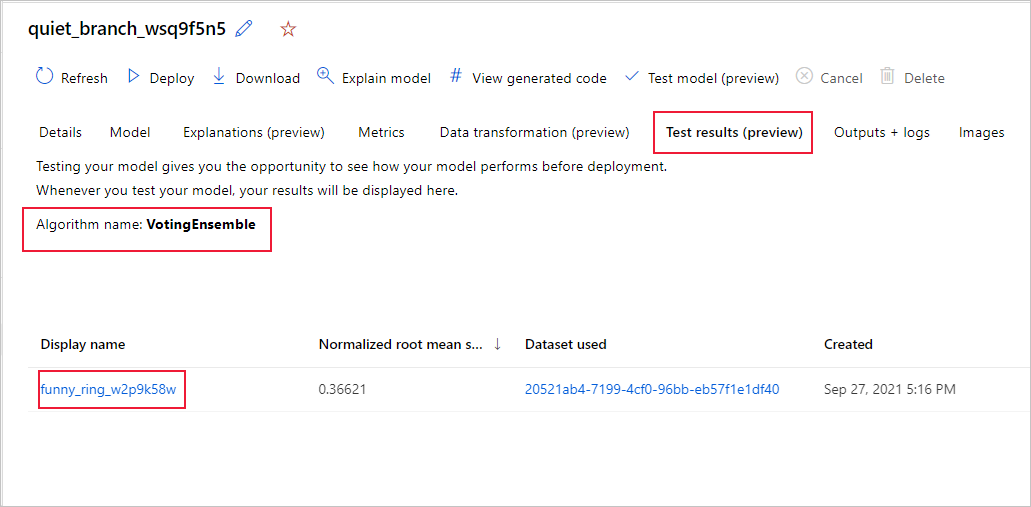

Visualizzare i risultati del processo di test remoto (anteprima)

Se è stato specificato un set di dati di test o si è scelto di eseguire una suddivisione di training/test durante l'installazione dell'esperimento nel modulo Convalida e test, il ML automatizzato testa automaticamente il modello consigliato per impostazione predefinita. Di conseguenza, ML automatizzato calcola le metriche di test per determinare la qualità del modello consigliato e le relative stime.

Importante

Il test dei modelli con un set di dati di test per valutare i modelli generati è una funzionalità di anteprima. Questa funzionalità è una funzionalità sperimentale di anteprima e può cambiare in qualsiasi momento.

Avviso

Questa funzionalità non è disponibile per gli scenari di Machine Learning automatizzati seguenti

Per visualizzare le metriche del processo di test del modello consigliato,

- Passare alla pagina Modelli, selezionare il modello migliore.

- Selezionare la scheda Risultati del test (anteprima).

- Selezionare il processo desiderato e visualizzare la scheda Metriche.

Per visualizzare le stime dei test usate per calcolare le metriche di test,

- Passare alla parte inferiore della pagina e selezionare il collegamento in Set di dati output per aprire il set di dati.

- Nella pagina Set di dati selezionare la scheda Esplora per visualizzare le stime del processo di test.

- In alternativa, è anche possibile visualizzare o scaricare il file di stima dalla scheda Output e log, espandere la cartella Stime per individuare il file di

predicted.csv.

- In alternativa, è anche possibile visualizzare o scaricare il file di stima dalla scheda Output e log, espandere la cartella Stime per individuare il file di

In alternativa, il file di stime può anche essere visualizzato/scaricato dalla scheda Output e log, espandere la cartella Stime per individuare il file predictions.csv.

Il processo di test del modello genera il file predictions.csv archiviato nell'archivio dati predefinito creato con l'area di lavoro. Questo archivio dati è visibile a tutti gli utenti con la stessa sottoscrizione. I processi di test non sono consigliati per gli scenari se una delle informazioni usate per o create dal processo di test deve rimanere privata.

Testare un modello di Machine Learning automatizzato esistente (anteprima)

Importante

Il test dei modelli con un set di dati di test per valutare i modelli generati è una funzionalità di anteprima. Questa funzionalità è una funzionalità sperimentale di anteprima e può cambiare in qualsiasi momento.

Avviso

Questa funzionalità non è disponibile per gli scenari di Machine Learning automatizzati seguenti

Al termine dell'esperimento, è possibile testare i modelli generati da Machine Learning automatizzato. Se si vuole testare un modello diverso generato da ML automatizzato, non il modello consigliato, è possibile eseguire l’operazione seguendo questa procedura.

Selezionare un processo di esperimento automatizzato esistente.

Passare alla scheda Modelli del processo e selezionare il modello completato da testare.

Nella pagina Dettagli del modello selezionare il pulsante Modello di test (anteprima) per aprire il riquadro Modello di test.

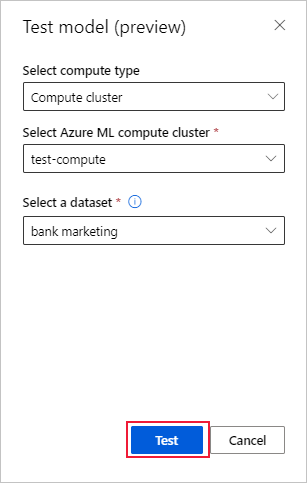

Nel riquadro Modello di test selezionare il cluster di elaborazione e un set di dati di test da usare per il processo di test.

Selezionare il pulsante Test. Lo schema del set di dati di test deve corrispondere al set di dati di training, ma la colonna di destinazione è facoltativa.

Al termine della creazione del processo di test del modello, nella pagina Dettagli viene visualizzato un messaggio di operazione riuscita. Selezionare la scheda Risultati di test per visualizzare lo stato di avanzamento del processo.

Per visualizzare i risultati del processo di test, aprire la pagina Dettagli e seguire la procedura della sezione Visualizzare i risultati del processo di test remoto.

Dashboard di intelligenza artificiale responsabile (anteprima)

Per comprendere meglio il modello, è possibile visualizzare varie informazioni dettagliate sul modello usando il dashboard di intelligenza artificiale responsabile. Consente di valutare ed eseguire il debug del modello di Machine Learning automatizzato migliore. Il dashboard di intelligenza artificiale responsabile valuterà gli errori del modello e i problemi di equità, diagnosticherà il motivo per cui si verificano tali errori valutando i dati di training e/o test e osservando le spiegazioni del modello. Queste informazioni dettagliate consentono di creare un trust con il modello e di passare i processi di controllo. I dashboard di intelligenza artificiale responsabile non possono essere generati per un modello di Machine Learning automatizzato esistente. Viene creato solo per il modello consigliato quando viene creato un nuovo processo AutoML. Gli utenti devono continuare a usare solo Spiegazioni del modello (anteprima) fino a quando non viene fornito il supporto per i modelli esistenti.

Per generare un dashboard di intelligenza artificiale responsabile per un modello specifico,

Durante l'invio di un processo di Machine Learning automatizzato, passare alla sezione Impostazioni attività sulla barra di spostamento a sinistra e selezionare l’opzioneVisualizza impostazioni di configurazione aggiuntive.

Nella nuova maschera visualizzata dopo la selezione, selezionare la casella di controllo Spiegare il modello migliore.

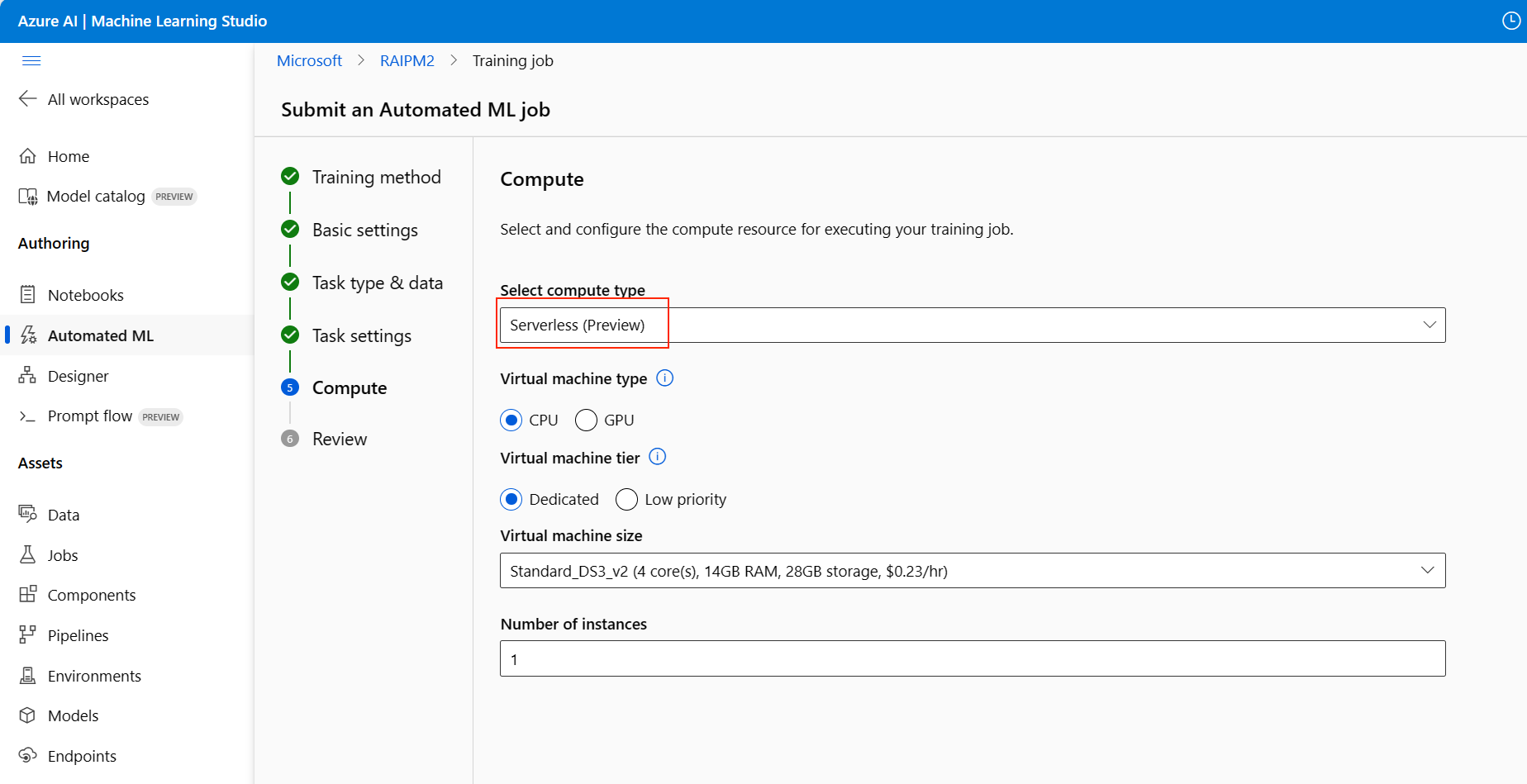

Passare alla pagina Calcolo del modulo di installazione e scegliere l'opzione Serverless per il calcolo.

Al termine, passare alla pagina Modelli del processo di Machine Learning automatizzato, che contiene un elenco dei modelli sottoposti a training. Selezionare il collegamento Visualizza dashboard di intelligenza artificiale responsabile:

Il dashboard di intelligenza artificiale responsabile viene visualizzato per il modello, come illustrato in questa immagine:

Nel dashboard sono disponibili quattro componenti attivati per il modello migliore di Machine Learning automatizzato:

| Componente | Cosa mostra il componente? | Come leggere questo grafico? |

|---|---|---|

| Analisi degli errori | Usare l'analisi degli errori quando è necessario: Acquisire una conoscenza approfondita circa il modo in cui gli errori del modello vengono distribuiti in un set di dati e in diverse dimensioni di input e funzionalità. Suddividere le metriche delle prestazioni aggregate per individuare automaticamente coorti errate per informare i passaggi di mitigazione mirati. |

Grafici di analisi degli errori |

| Panoramica del modello ed equità | Usare questo componente per: Acquisire una conoscenza approfondita delle prestazioni del modello tra coorti di dati diversi. Comprendere i problemi di equità del modello esaminando le metriche di disparità. Queste metriche possono valutare e confrontare il comportamento del modello tra sottogruppi identificati in termini di funzionalità sensibili (o senza distinzione). |

Panoramica del modello e grafici di equità |

| Spiegazioni del modello | Usare il componente di spiegazione del modello per generare descrizioni comprensibili delle stime di un modello di Machine Learning esaminando: Spiegazioni globali: ad esempio, quali funzionalità influiscono sul comportamento complessivo di un modello di allocazione prestiti? Spiegazioni locali: ad esempio, perché la richiesta di un prestito di un cliente è stata approvata o rifiutata? |

Grafici di spiegazione dei modelli |

| Analisi dei dati | Usare l'analisi dei dati quando è necessario: Esplorare le statistiche del set di dati selezionando filtri diversi per suddividere i dati in dimensioni diverse (note anche come coorti). Comprendere la distribuzione del set di dati tra coorti e gruppi di funzionalità diversi. Determinare se i risultati correlati all'equità, all'analisi degli errori e alla causalità (derivati da altri componenti del dashboard) sono il risultato della distribuzione del set di dati. Decidere in quali aree raccogliere più dati per mitigare gli errori provenienti da problemi di rappresentazione, disturbo delle etichette, disturbo delle funzionalità, distorsione delle etichette e fattori simili. |

Grafici di Esplora dati |

- Inoltre, è possibile creare coorti (sottogruppi di punti dati che condividono le caratteristiche specificate) per concentrarsi sull'analisi di ogni componente su coorti diverse. Il nome della coorte attualmente applicato al dashboard viene sempre visualizzato in alto a sinistra del dashboard. La vista predefinita nel dashboard è l'intero set di dati, denominato “Tutti i dati” (per impostazione predefinita). Altre informazioni sul controllo globale del dashboard sono disponibili qui.

Modifica e invia processi (anteprima)

Importante

La possibilità di copiare, modificare e inviare un nuovo esperimento basato su un esperimento esistente è una funzionalità di anteprima. Questa funzionalità è una funzionalità sperimentale di anteprima e può cambiare in qualsiasi momento.

Negli scenari in cui si vuole creare un nuovo esperimento in base alle impostazioni di un esperimento esistente, ML automatizzato offre la possibilità di farlo con il pulsante Modifica e invio nell'interfaccia utente di Studio.

Questa funzionalità è limitata agli esperimenti avviati dall'interfaccia utente di Studio e richiede lo schema dei dati per il nuovo esperimento in modo che corrisponda a quello dell'esperimento originale.

Il pulsante Modifica e invio apre la procedura guidata Crea un nuovo processo di Machine Learning automatizzato con i dati, le impostazioni di calcolo e l’esperimento prepopolati. È possibile scorrere ogni modulo e modificare le selezioni in base alle esigenze per il nuovo esperimento.

Distribuire il modello

Una volta ottenuto il modello migliore, è necessario distribuirlo come servizio Web per eseguire previsioni sui nuovi dati.

Suggerimento

Se si vuole distribuire un modello generato tramite il pacchetto automl con Python SDK, è necessario registrare il modello) all'area di lavoro.

Dopo aver registrato il modello, lo si trova nello studio selezionando Modelli nel riquadro sinistro. Dopo aver aperto il modello, è possibile selezionare il pulsante Distribuire nella parte superiore della schermata e quindi seguire le istruzioni descritte nel passaggio 2 della sezione Distribuire il modello.

ML automatizzato semplifica la distribuzione del modello senza scrivere codice:

Per la distribuzione sono disponibili due opzioni.

Opzione 1: Distribuire il modello migliore in base ai criteri della metrica definiti.

- Una volta completato l'esperimento, passare alla pagina del processo padre selezionando Processo 1 nella parte superiore della schermata.

- Selezionare il modello elencato nella sezione Riepilogo modello migliore.

- Selezionare Distribuisci nella parte superiore sinistra della finestra.

Opzione 2: Per distribuire un'iterazione del modello specifica da questo esperimento.

- Selezionare il modello desiderato dalla scheda Modelli

- Selezionare Distribuisci nella parte superiore sinistra della finestra.

Inserire i dati nel riquadro Distribuisci modello.

Campo Valore Nome Specificare un nome univoco per la distribuzione. Descrizione Immettere una descrizione per identificare meglio le finalità della distribuzione. Tipo di calcolo Selezionare il tipo di endpoint da distribuire: Servizio Azure Kubernetes o Istanza di Azure Container. Nome del calcolo Si applica solo al servizio Azure Kubernetes: Selezionare il nome del cluster del servizio Azure Kubernetes in cui si vuole eseguire la distribuzione. Abilita autenticazione Selezionare questa impostazione per consentire l'autenticazione basata su token o basata su chiave. Usa asset di distribuzione personalizzati Abilitare questa funzionalità se si desidera caricare lo script di punteggio e il file di ambiente. In caso contrario, il ML automatizzato fornisce automaticamente questi asset per impostazione predefinita. Altre informazioni sugli script di punteggio. Importante

I nomi file devono essere inferiori a 32 caratteri e iniziare e terminare con caratteri alfanumerici. Possono includere trattini, caratteri di sottolineatura, punti e caratteri alfanumerici. Gli spazi non sono consentiti.

Il menu Avanzata offre funzionalità di distribuzione predefinite, quali la raccolta dati e le impostazioni di utilizzo delle risorse. Se si desidera eseguire l'override di queste impostazioni predefinite, effettuare questa operazione in questo menu.

Seleziona Distribuisci. Il completamento della distribuzione può richiedere circa 20 minuti. Una volta avviata la distribuzione, viene visualizzata la scheda Riepilogo modello. Vedere lo stato di avanzamento della distribuzione nella sezione Stato distribuzione.

A questo punto, è disponibile un servizio Web operativo per generare previsioni. Per eseguire il test delle previsioni, è possibile eseguire una query sul servizio dal supporto Azure Machine Learning incorporato di Power BI.

Passaggi successivi

- Informazioni sui risultati di Machine Learning automatizzato.

- Altre informazioni su Machine Learning automatizzato e Azure Machine Learning.