Guida introduttiva: Trasformare i dati usando flussi di dati di mapping

In questa guida introduttiva si userà Azure Synapse Analytics per creare una pipeline che trasforma i dati da un'origine Azure Data Lake Storage Gen2 (ADLS Gen2) a un sink DILS Gen2 usando il flusso di dati di mapping. Il modello di configurazione di questa guida introduttiva può essere espanso quando si trasformano i dati usando il flusso di dati di mapping

In questa guida introduttiva si eseguono i passaggi seguenti:

- Creare una pipeline con un'attività di Flusso di dati in Azure Synapse Analytics.

- Creare un flusso di dati di mapping con quattro trasformazioni.

- Eseguire test della pipeline.

- Monitorare un'attività di Flusso di dati

Prerequisiti

Sottoscrizione di Azure: se non si ha una sottoscrizione di Azure, creare un account Azure gratuito prima di iniziare.

Azure Synapse'area di lavoro: creare un'area di lavoro synapse usando il portale di Azure seguendo le istruzioni riportate in Avvio rapido: Creare un'area di lavoro Synapse.

Account di archiviazione di Azure: si usa l'archiviazione ADLS come archivi dati di origine e sink . Se non si ha un account di archiviazione, vedere Creare un account di archiviazione di Azure per informazioni su come crearne uno.

Il file trasformato in questa esercitazione è MoviesDB.csv, disponibile qui. Per recuperare il file da GitHub, copiare il contenuto in un editor di testo di propria scelta per salvare localmente come file di .csv. Per caricare il file nell'account di archiviazione, vedere Caricare BLOB con il portale di Azure. Gli esempi faranno riferimento a un contenitore denominato "sample-data".

Passare a Synapse Studio

Dopo aver creato l'area di lavoro di Azure Synapse, è possibile aprire Synapse Studio in due modi:

- Aprire l'area di lavoro di Synapse nel portale di Azure. Selezionare Apri nella scheda Apri Synapse Studio in Introduzione.

- Aprire Azure Synapse Analytics e accedere all'area di lavoro.

In questo argomento di avvio rapido viene usata come esempio l'area di lavoro denominata "adftest2020". Si verrà indirizzati automaticamente alla home page di Synapse Studio.

Creare una pipeline con un'attività di Flusso di dati

Una pipeline contiene il flusso logico per un'esecuzione di un set di attività. In questa sezione si creerà una pipeline contenente un'attività Flusso di dati.

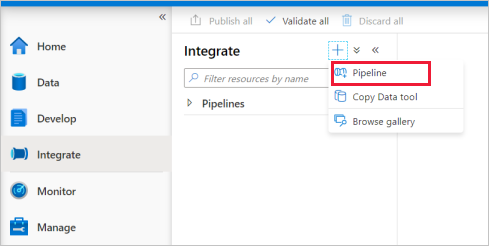

Passare alla scheda Integrazione. Selezionare l'icona con il segno più accanto all'intestazione della pipeline e quindi selezionare Pipeline.

Nella pagina Impostazioni proprietà della pipeline immettere TransformMovies per Nome.

In Sposta e trasforma nel riquadro Attività trascinare Flusso di dati nell'area di disegno della pipeline.

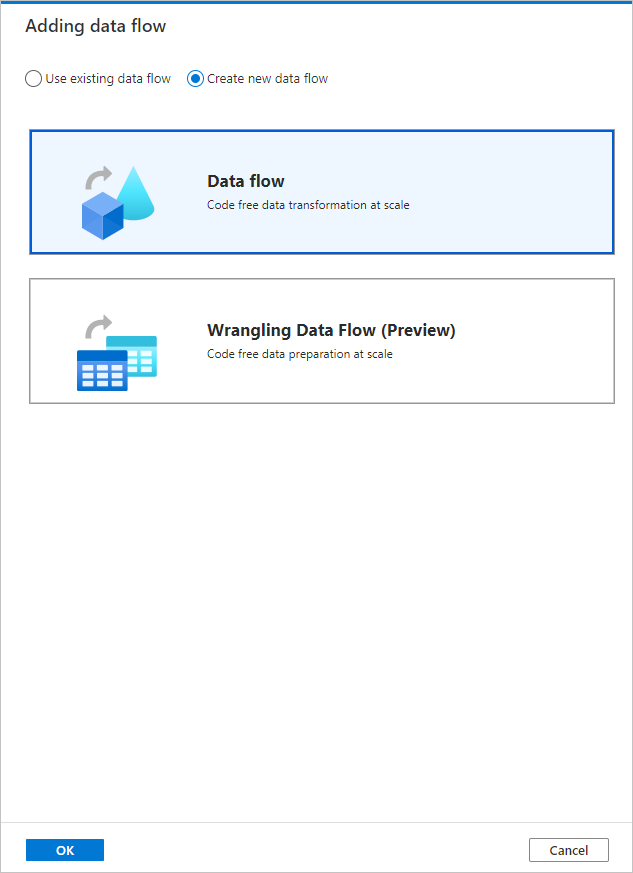

Nella pagina popup Aggiunta flusso di dati selezionare Crea nuovo flusso di dati ->Flusso di dati. Fare clic su OK al termine dell'operazione.

Assegnare al flusso di dati il nome TransformMovies nella pagina Proprietà .

Creare la logica di trasformazione nell'area di disegno del flusso di dati

Dopo aver creato il Flusso di dati, si verrà inviati automaticamente all'area di disegno del flusso di dati. In questo passaggio si creerà un flusso di dati che accetta il MoviesDB.csv nell'archiviazione ADLS e aggrega la valutazione media delle comedies dal 1910 al 2000. Si scriverà quindi di nuovo questo file nell'archiviazione ADLS.

Sopra l'area di disegno del flusso di dati scorrere il dispositivo di scorrimento Debug flusso di dati. La modalità di debug consente il test interattivo della logica di trasformazione in un cluster Spark attivo. Flusso di dati i cluster richiedono 5-7 minuti e si consiglia agli utenti di attivare prima il debug se si prevede di eseguire lo sviluppo Flusso di dati. Per altre informazioni, vedere Modalità di debug.

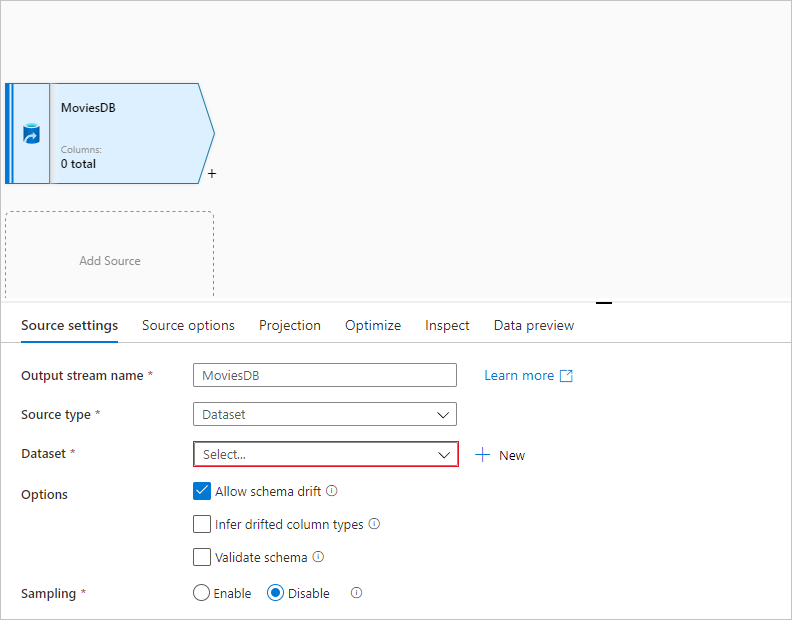

Nell'area di disegno del flusso di dati aggiungere un'origine facendo clic sulla casella Aggiungi origine .

Assegnare all'origine il nome MoviesDB. Fare clic su Nuovo per creare un nuovo set di dati di origine.

Scegliere Azure Data Lake Storage Gen2. Fare clic su Continue.

Scegliere DelimitedText. Fare clic su Continue.

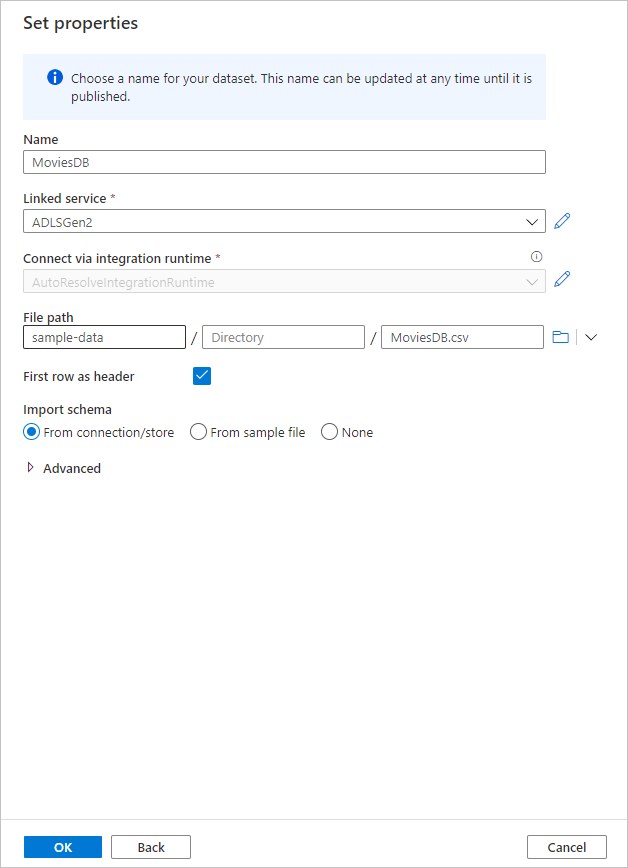

Assegnare al set di dati il nome MoviesDB. Nell'elenco a discesa servizio collegato scegliere Nuovo.

Nella schermata di creazione del servizio collegato assegnare un nome adLS Gen2 al servizio collegato ADLSGen2 e specificare il metodo di autenticazione. Immettere quindi le credenziali di connessione. In questa guida introduttiva si usa la chiave dell'account per connettersi all'account di archiviazione. È possibile fare clic su Test connessione per verificare che le credenziali siano state immesse correttamente. Al termine, fare clic su Crea.

Quando si torna alla schermata di creazione del set di dati, nel campo Percorso file immettere dove si trova il file. In questa guida introduttiva il file "MoviesDB.csv" si trova nel contenitore "sample-data". Poiché il file contiene intestazioni, selezionare First row as header (Prima riga come intestazione). Selezionare Da connessione/archivio per importare lo schema dell'intestazione direttamente dal file nella risorsa di archiviazione. Fare clic su OK al termine dell'operazione.

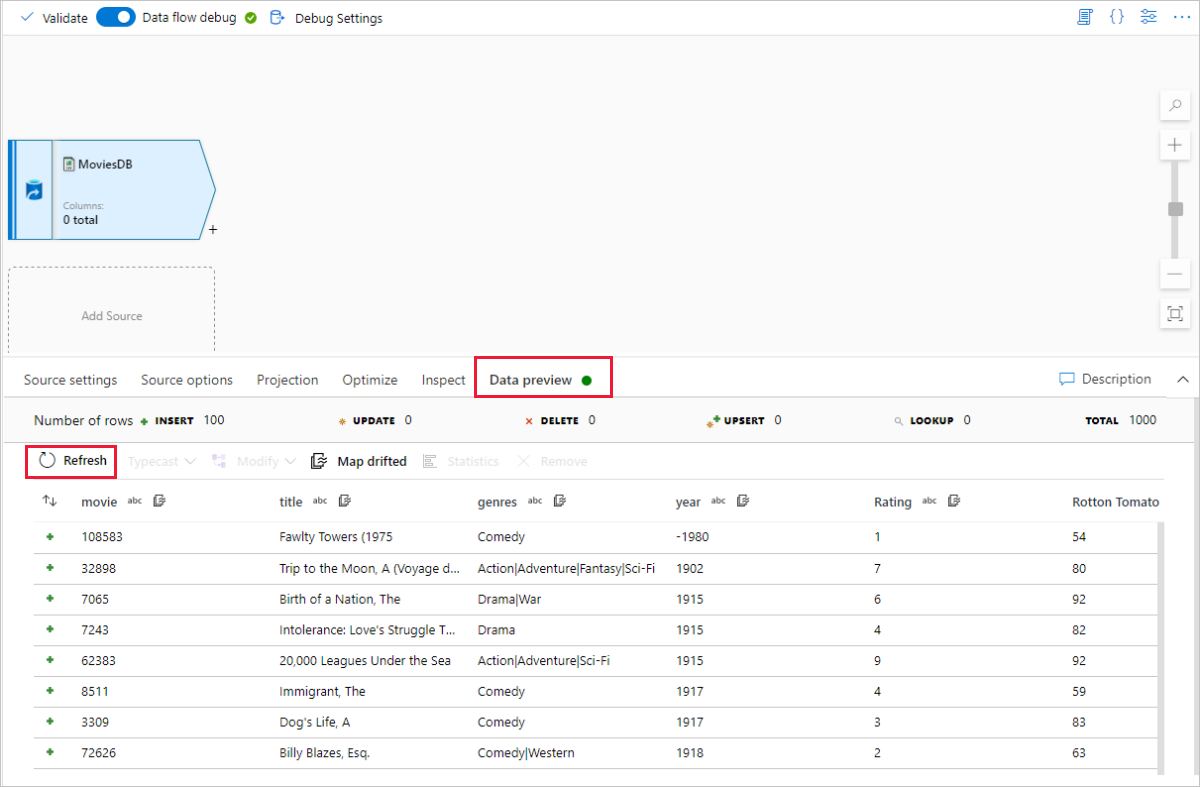

Se il cluster di debug è stato avviato, passare alla scheda Anteprima dati della trasformazione origine e fare clic su Aggiorna per ottenere uno snapshot dei dati. È possibile usare l'anteprima dei dati per verificare che la trasformazione sia configurata correttamente.

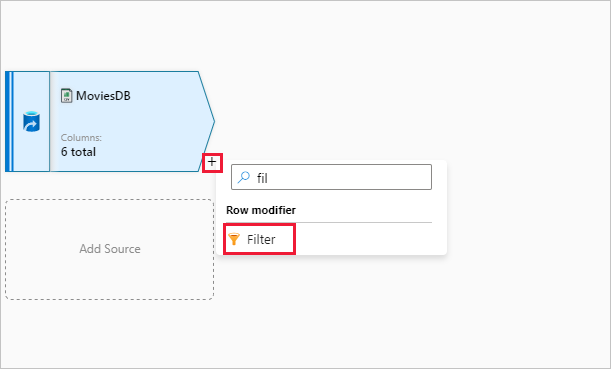

Accanto al nodo di origine nell'area di disegno del flusso di dati fare clic sull'icona con il segno più per aggiungere una nuova trasformazione. La prima trasformazione che si sta aggiungendo è un filtro.

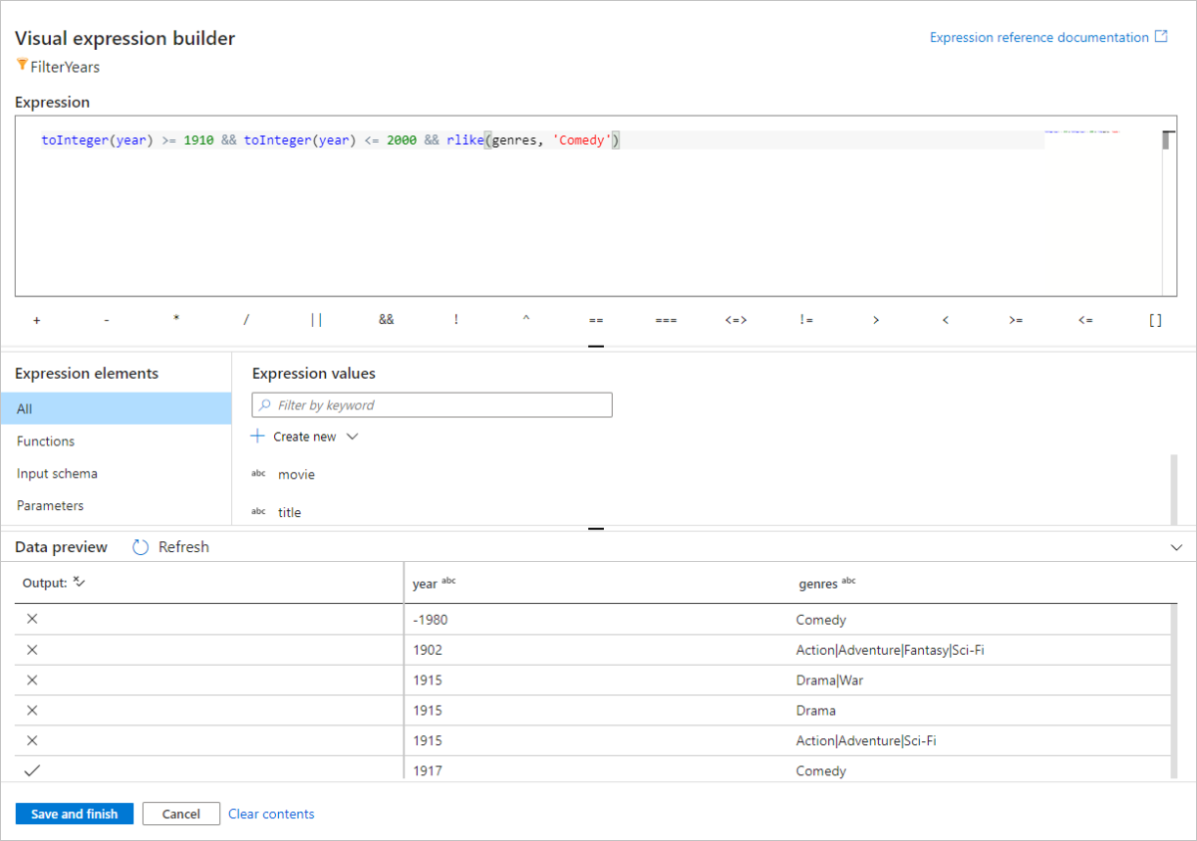

Assegnare alla trasformazione filtro il nome FilterYears. Fare clic sulla casella dell'espressione accanto a Filtra per aprire il generatore di espressioni. Qui verrà specificata la condizione di filtro.

Il generatore di espressioni del flusso di dati consente di compilare in modo interattivo espressioni da usare in varie trasformazioni. Le espressioni possono includere funzioni predefinite, colonne dello schema di input e parametri definiti dall'utente. Per altre informazioni su come compilare espressioni, vedere Flusso di dati generatore di espressioni.

In questo argomento di avvio rapido si vogliono filtrare i film della commedia di genere che sono usciti tra gli anni 1910 e 2000. Poiché l'anno è attualmente una stringa, è necessario convertirlo in un numero intero usando la

toInteger()funzione . Usare gli operatori maggiori o uguali a (>=) e minori o uguali a (<=) per confrontare i valori letterali anno 1910 e 200-. Unire queste espressioni con l'operatore&&(e). L'espressione viene restituita come segue:toInteger(year) >= 1910 && toInteger(year) <= 2000Per trovare quali film sono commedie, è possibile usare la funzione per trovare il

rlike()modello 'Comedy' nei generi della colonna. Unire l'espressionerlikecon il confronto dell'anno per ottenere:toInteger(year) >= 1910 && toInteger(year) <= 2000 && rlike(genres, 'Comedy')

Se è attivo un cluster di debug, è possibile verificare la logica facendo clic su Aggiorna per visualizzare l'output delle espressioni rispetto agli input usati. C'è più di una risposta giusta su come è possibile eseguire questa logica usando il linguaggio di espressione del flusso di dati.

Dopo aver completato l'espressione, fare clic su Salva e fine .

Recuperare un'anteprima dati per verificare che il filtro funzioni correttamente.

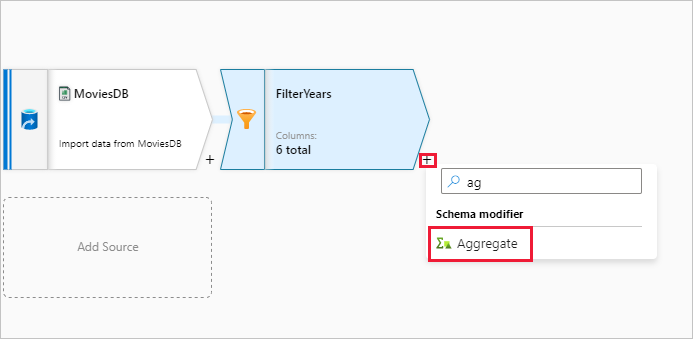

La trasformazione successiva che verrà aggiunta è una trasformazione Aggregazione in Modificatore dello schema.

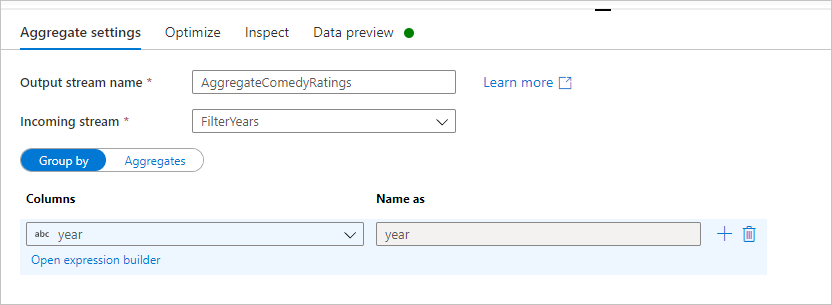

Denominare la trasformazione di aggregazione AggregateComedyRatings. Nella scheda Raggruppa per selezionare anno dall'elenco a discesa per raggruppare le aggregazioni in base all'anno in cui è uscito il film.

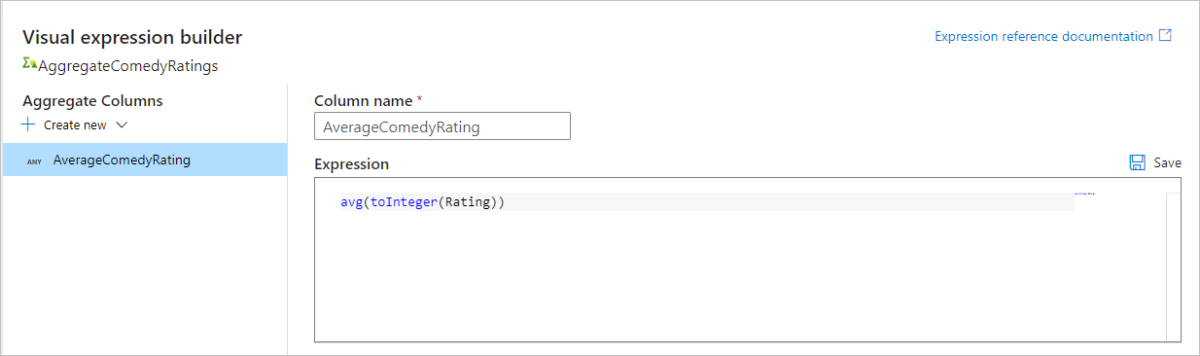

Passare alla scheda Aggregazioni . Nella casella di testo a sinistra denominare la colonna di aggregazione AverageComedyRating. Fare clic sulla casella dell'espressione destra per immettere l'espressione di aggregazione tramite il generatore di espressioni.

Per ottenere la media della colonna Rating, usare la

avg()funzione di aggregazione. Poiché Rating è una stringa eavg()accetta un input numerico, è necessario convertire il valore in un numero tramite latoInteger()funzione . Questa espressione ha un aspetto simile al seguente:avg(toInteger(Rating))Al termine, fare clic su Salva e fine .

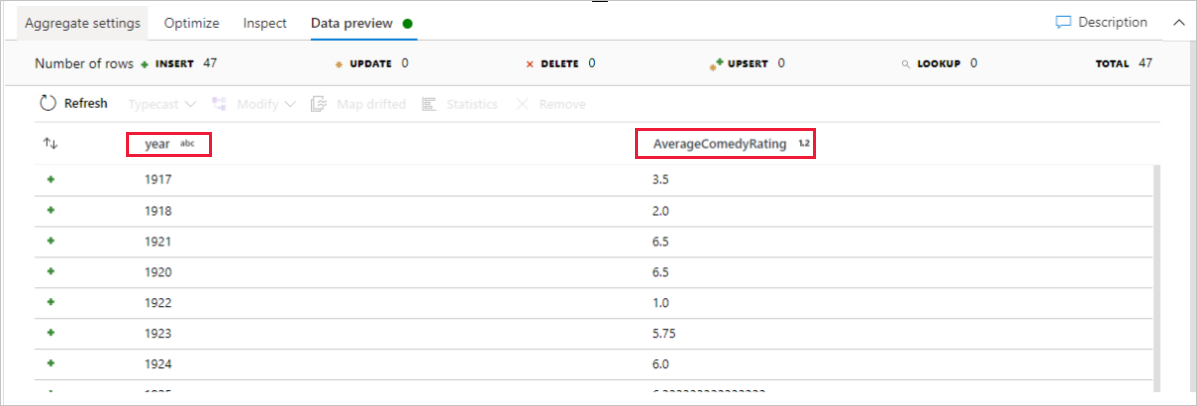

Passare alla scheda Anteprima dati per visualizzare l'output della trasformazione. Si noti che sono presenti solo due colonne, year e AverageComedyRating.

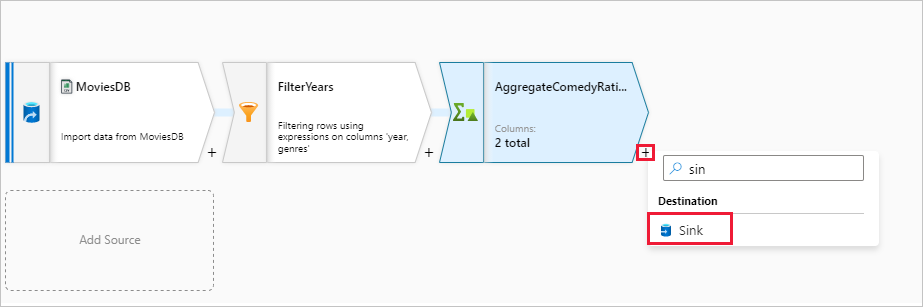

Successivamente, si vuole aggiungere una trasformazione Sink in Destinazione.

Assegnare al sink il nome Sink. Fare clic su Nuovo per creare il set di dati sink.

Scegliere Azure Data Lake Storage Gen2. Fare clic su Continue.

Scegliere DelimitedText. Fare clic su Continue.

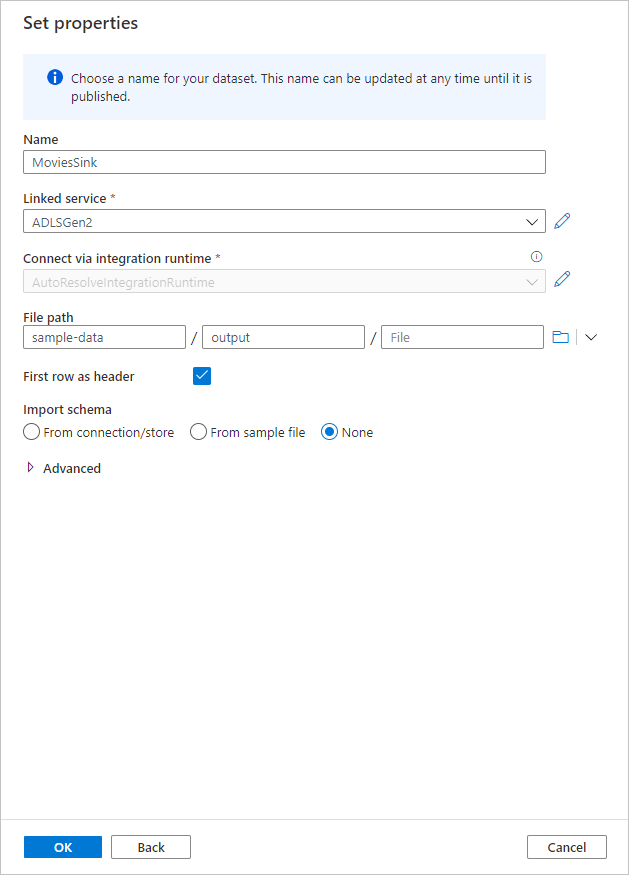

Assegnare al set di dati sink il nome MoviesSink. Per il servizio collegato, scegliere il servizio collegato ADLS Gen2 creato nel passaggio 7. Immettere una cartella di output in cui scrivere i dati. In questa guida introduttiva si scrive nella cartella 'output' nel contenitore 'sample-data'. La cartella non deve esistere in anticipo e può essere creata dinamicamente. Impostare Prima riga come intestazione su true e selezionare Nessuno per Importa schema. Fare clic su OK al termine dell'operazione.

A questo punto è stata completata la compilazione del flusso di dati. È possibile eseguirlo nella pipeline.

Esecuzione e monitoraggio del Flusso di dati

È possibile eseguire il debug di una pipeline prima di pubblicarla. In questo passaggio si attiverà un'esecuzione di debug della pipeline del flusso di dati. Mentre l'anteprima dei dati non scrive i dati, un'esecuzione di debug scriverà i dati nella destinazione sink.

Passare all'area di disegno della pipeline. Fare clic su Debug per attivare un'esecuzione di debug.

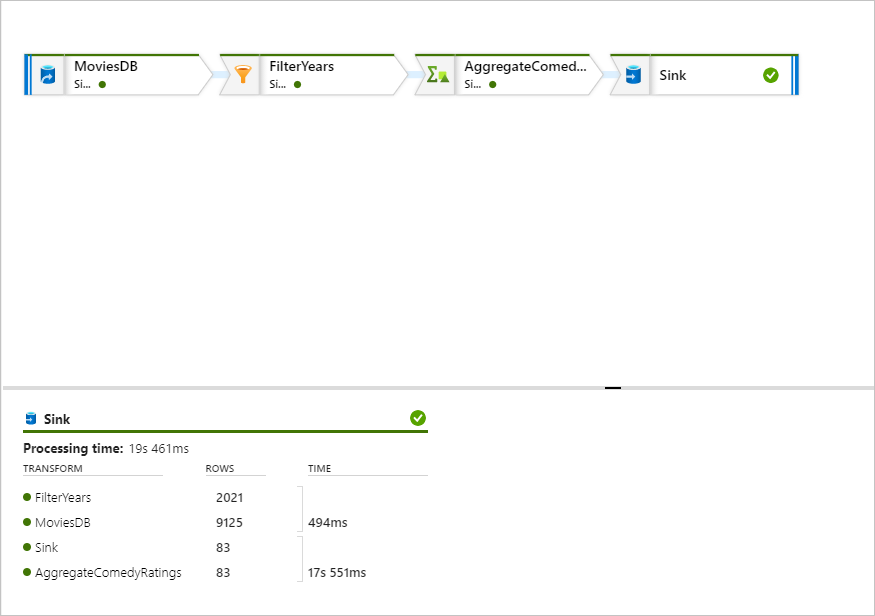

Il debug della pipeline di Flusso di dati attività usa il cluster di debug attivo, ma l'inizializzazione richiede almeno un minuto. È possibile tenere traccia dello stato di avanzamento tramite la scheda Output . Al termine dell'esecuzione, fare clic sull'icona degli occhiali per aprire il riquadro di monitoraggio.

Nel riquadro di monitoraggio è possibile visualizzare il numero di righe e il tempo impiegato in ogni passaggio di trasformazione.

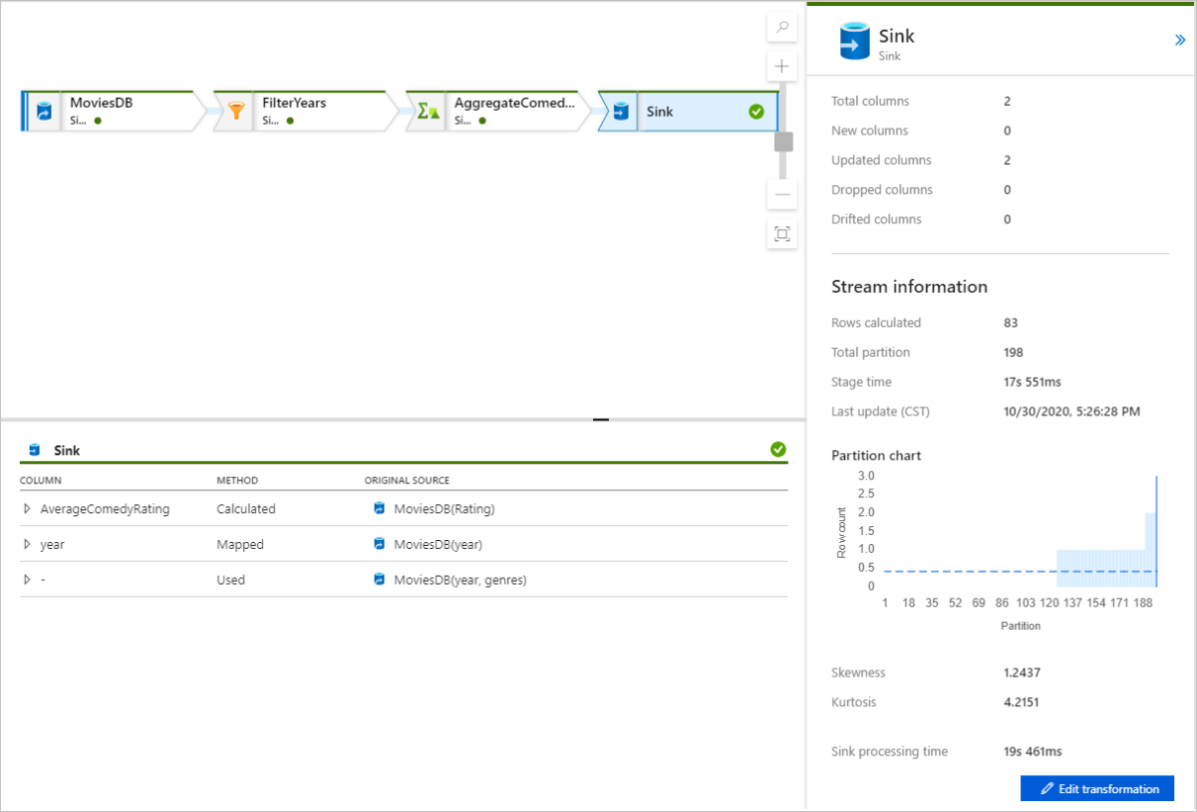

Fare clic su una trasformazione per ottenere informazioni dettagliate sulle colonne e sul partizionamento dei dati.

Se è stata seguita correttamente questa guida introduttiva, nella cartella sink devono essere scritte 83 righe e 2 colonne. È possibile verificare i dati controllando l'archiviazione BLOB.

Passaggi successivi

Passare agli articoli seguenti per informazioni sul supporto di Azure Synapse Analytics: