Monitorare i pool di Spark in Azure Synapse Analytics

Per monitorare il pool di Apache Spark, è consigliabile usare la scheda Monitoraggio in Azure Synapse Studio.

L'hub Monitoraggio consente di visualizzare svariate attività di Azure Synapse Analytics, tra cui le esecuzioni di pipeline e trigger e lo stato dei diversi runtime di integrazione in esecuzione. È anche possibile visualizzare processi di Apache Spark, richieste SQL e attività di debug dei flussi di dati.

L'hub Monitoraggio è la prima risorsa da considerare per eseguire il debug dei problemi e per ottenere informazioni dettagliate sull'utilizzo delle risorse del pool di Apache Spark. È possibile visualizzare la cronologia di tutte le attività verificatesi nell'area di lavoro e quelle attualmente in corso.

Potrebbero essere presenti attività del pool di Apache Spark che fanno parte delle attività della pipeline di Azure Synapse. Se è stata creata ed eseguita una pipeline, qui è possibile visualizzare tutte le attività di esecuzione della pipeline. È anche possibile visualizzare i dettagli delle esecuzioni dove si possono vedere gli input e gli output delle attività della pipeline ed eventuali messaggi di errore. Se si è automatizzata un'esecuzione della pipeline configurando trigger automatizzati, è possibile trovare qui anche le esecuzioni.

Per quanto riguarda le applicazioni Apache Spark, è possibile visualizzare tutte le applicazioni Apache Spark attualmente in esecuzione o già eseguite nell'area di lavoro. Si supponga di aver eseguito alcune attività Apache Spark. Come si deve procedere per monitorarle?

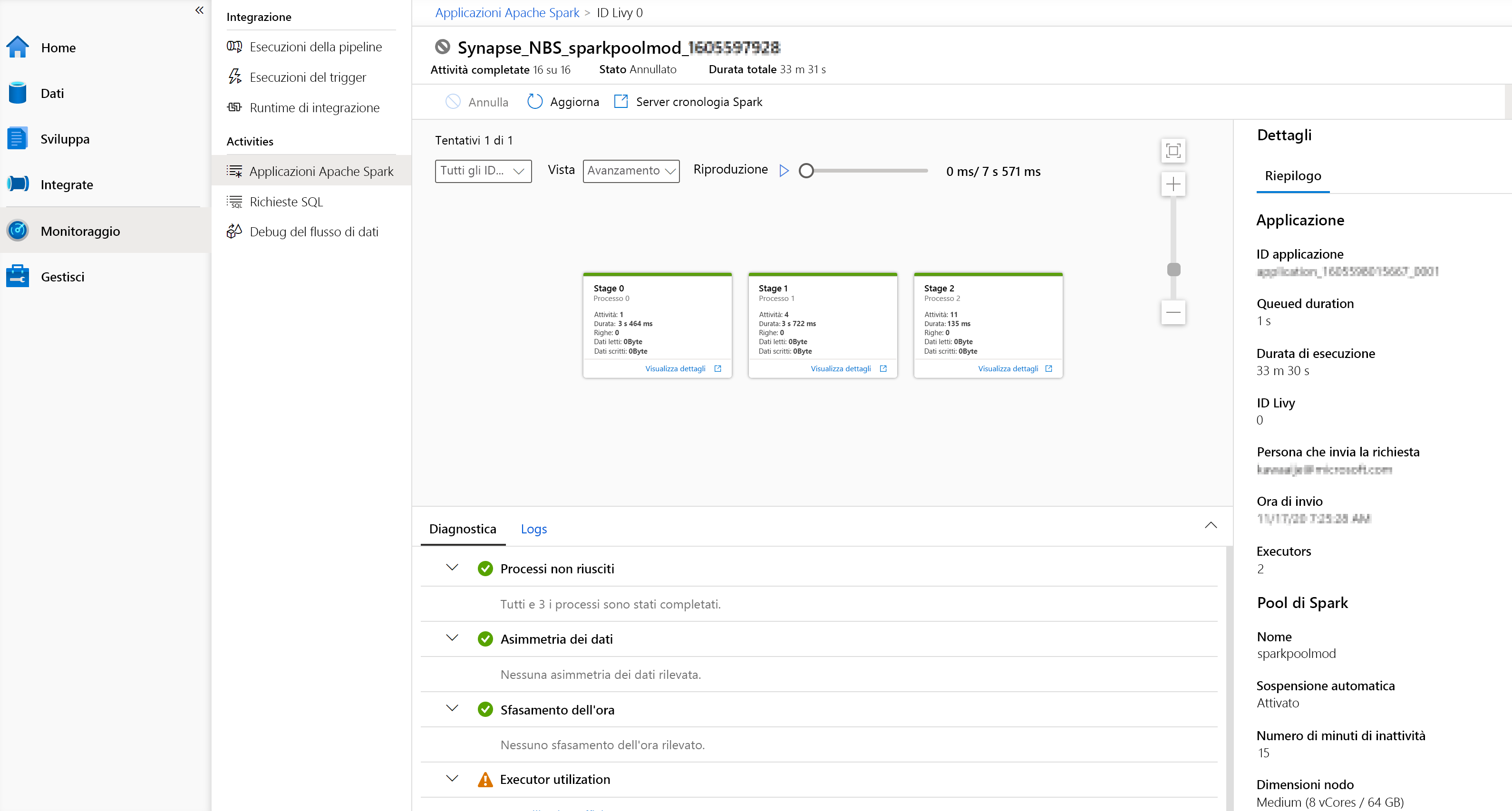

Prima di tutto, in Azure Synapse Studio passare all'hub Monitoraggio, quindi selezionare Attività e Apache Spark applications (Applicazioni Apache Spark). Qui è possibile vedere tutte le applicazioni Apache Spark che sono in esecuzione o sono state eseguite nell'area di lavoro.

Per trovare altre informazioni su un'applicazione Apache Spark non più in esecuzione, è necessario selezionare il nome dell'applicazione nell'hub Monitoraggio e selezionare il nome dell'applicazione Apache Spark. Qui saranno disponibili tutti i dettagli dell'applicazione Apache Spark.

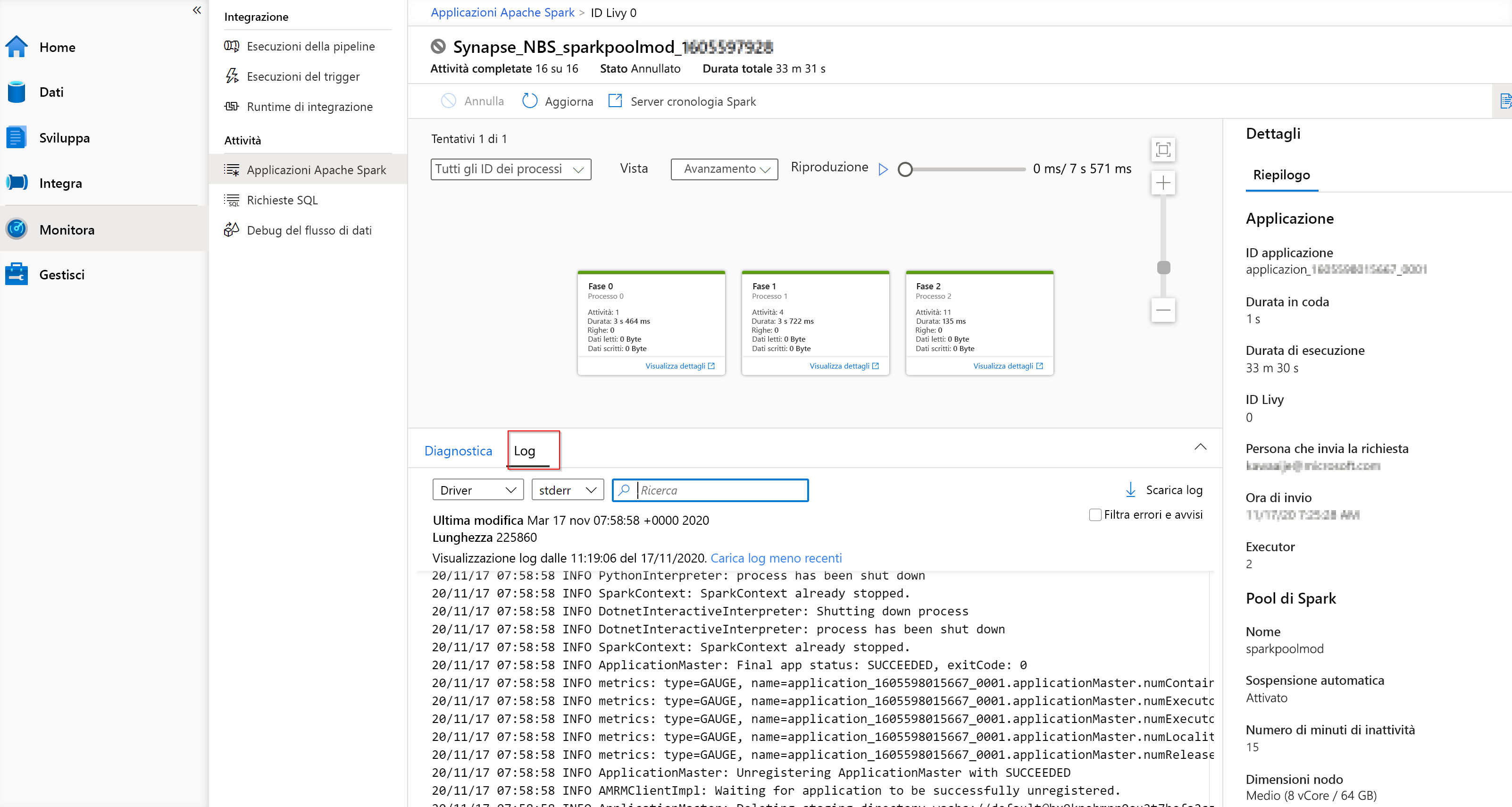

Se si ha familiarità con Apache Spark, è possibile accedere all'interfaccia utente standard del server cronologia Spark facendo clic su Server cronologia Apache Spark. Non solo è possibile controllare la diagnostica dell'applicazione Apache Spark che era in esecuzione, ad esempio un notebook collegato a un pool di Apache Spark, ma è anche possibile controllare i log passando alla scheda Log:

Sul lato destro sono disponibili i dettagli dell'applicazione del pool di Apache Spark, la durata dell'esecuzione, il numero di executor, i dettagli del pool di Apache Spark e molto altro. Inoltre, per visualizzare i dettagli per ogni fase, è possibile passare alla scheda Visualizza i dettagli di una delle fasi, il cui aspetto è simile al seguente:

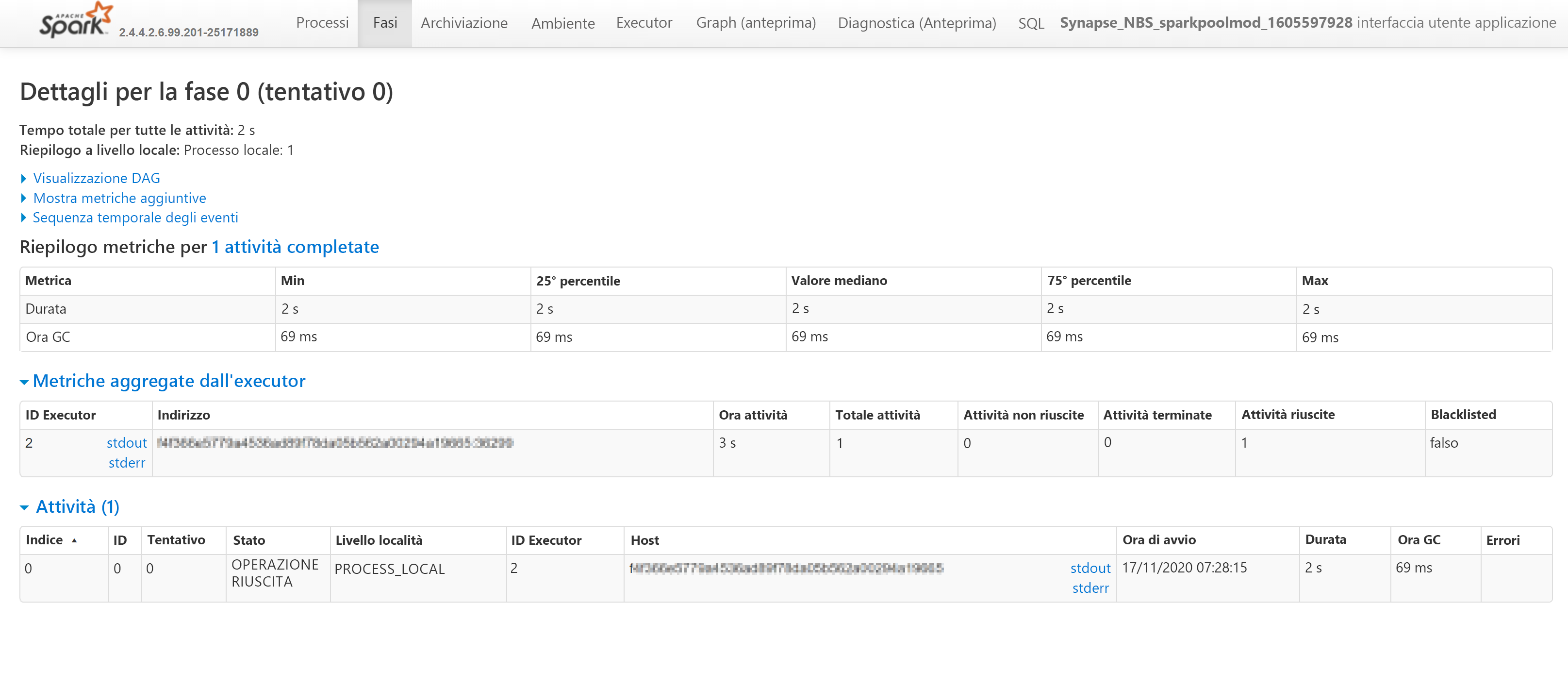

Si verrà reindirizzati all'interfaccia utente di Apache Spark dove è possibile trovare altri dettagli sulle fasi del pool di Apache Spark. È anche possibile controllare i dettagli di tutte le fasi selezionando Spark UI (Interfaccia utente Spark).