Panoramica degli esempi di rilevamento oculare - MRTK2

Questo argomento descrive come iniziare rapidamente il rilevamento oculare in MRTK creando esempi di rilevamento oculare MRTK (Asset/MRTK/Esempi/Demos/EyeTracking). Questi esempi consentono di sperimentare una delle nuove funzionalità di input magiche: Rilevamento degli occhi! La demo include vari casi d'uso, tra cui attivazioni implicite basate su occhi e come combinare facilmente le informazioni su ciò che si sta guardando con l'input vocale e della mano . Ciò consente agli utenti di selezionare e spostare rapidamente e facilmente il contenuto olografico nella visualizzazione semplicemente esaminando una destinazione e dicendo "Seleziona" o eseguendo un movimento di mano. Le demo includono anche un esempio per lo scorrimento diretto dagli occhi, la panoramica e lo zoom di testo e immagini su uno slate. Infine, viene fornito un esempio per registrare e visualizzare l'attenzione visiva dell'utente su uno slate 2D. Nella sezione seguente sono disponibili altri dettagli sui diversi esempi inclusi nel pacchetto di esempio di rilevamento oculare MRTK (Assets/MRTK/Examples/Demos/EyeTracking):

![]()

La sezione seguente è una rapida panoramica delle singole scene demo di rilevamento oculare. Le scene demo di rilevamento oculare MRTK vengono caricate in modo aggiuntivo, che verrà illustrato di seguito come configurare.

Panoramica degli esempi demo di rilevamento oculare

Selezione di destinazione supportata dall'occhio

Questa esercitazione illustra la facilità di accesso ai dati dello sguardo oculare per selezionare le destinazioni. Include un esempio per un feedback sottile e potente per fornire all'utente la fiducia che una destinazione è focalizzata senza essere travolgente. Inoltre, esiste un semplice esempio di notifiche intelligenti che scompaiono automaticamente dopo la lettura.

Riepilogo: selezioni di destinazione veloci e senza sforzo usando una combinazione di occhi, voce e input della mano.

Navigazione supportata dall'occhio

Si supponga di leggere alcune informazioni su una visualizzazione distante o sul lettore di e-reader e quando si raggiunge la fine del testo visualizzato, il testo scorre automaticamente fino a rivelare più contenuto. O come si fa a ingrandire in modo magico direttamente verso dove si stava guardando? Questi sono alcuni degli esempi illustrati in questa esercitazione relativa alla navigazione supportata dall'occhio. Inoltre, esiste un esempio per la rotazione pratica di ologrammi 3D facendoli ruotare automaticamente in base allo stato attivo corrente.

Riepilogo: scorrimento, panoramica, zoom, rotazione 3D usando una combinazione di occhi, voce e input della mano.

Posizionamento oculare supportato

Questa esercitazione illustra uno scenario di input denominato Put-That-There che risale alla ricerca dal MIT Media Lab nei primi anni 1980 con l'input visivo, la mano e la voce. L'idea è semplice: trarre vantaggio dagli occhi per la selezione e la posizione rapida di destinazione. Guarda semplicemente un ologramma e dice "mettilo", guarda dove vuoi posizionarlo e dici "lì!". Per posizionare in modo più preciso l'ologramma, è possibile usare un input aggiuntivo dalle mani, dalla voce o dai controller.

Riepilogo: posizionamento di ologrammi usando gli occhi, la voce e l'input della mano (trascinamento). Dispositivi di scorrimento supportati dagli occhi usando gli occhi e le mani.

Visualizzazione dell'attenzione visiva

I dati basati sulla posizione in cui gli utenti cercano rendono uno strumento estremamente potente per valutare l'usabilità di una progettazione e identificare i problemi nei flussi di lavoro efficienti. Questa esercitazione illustra le diverse visualizzazioni di rilevamento degli occhi e il modo in cui soddisfano esigenze diverse. Vengono forniti esempi di base per la registrazione e il caricamento dei dati di rilevamento oculare e degli esempi per visualizzarli.

Riepilogo: mappa dell'attenzione bidimensionale (mappa termica) su slates. Registrazione & rependere i dati di rilevamento degli occhi.

Configurazione degli esempi di rilevamento oculare MRTK

Prerequisiti

Si noti che l'uso degli esempi di rilevamento oculare nel dispositivo richiede un HoloLens 2 e un pacchetto di app di esempio creato con la funzionalità "Input sguardo" nell'AppXManifest del pacchetto.

Per usare questi esempi di rilevamento oculare nel dispositivo, assicurarsi di seguire questi passaggi prima di creare l'app in Visual Studio.

1. Load EyeTrackingDemo-00-RootScene.unity

EyeTrackingDemo-00-RootScene è la scena base (radice) che include tutti i componenti MRTK principali inclusi. Questa è la scena che devi caricare prima e da cui eseguirai le demo di rilevamento degli occhi. Offre un menu della scena grafica che consente di passare facilmente tra i diversi esempi di rilevamento oculare che verranno caricati in modo aggiuntivo.

![]()

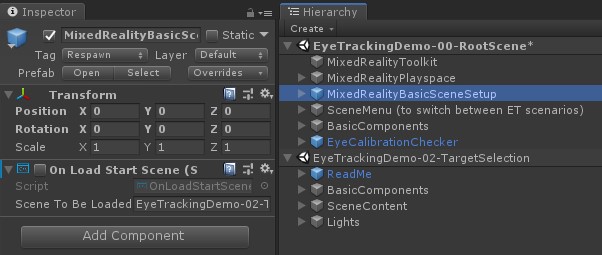

La scena radice include alcuni componenti principali che verranno mantenuti nelle scene caricate in modo aggiuntivo, ad esempio i profili e la fotocamera della scena configurati da MRTK. MixedRealityBasicSceneSetup (vedere screenshot seguente) include uno script che caricherà automaticamente la scena a cui si fa riferimento all'avvio. Per impostazione predefinita, si tratta di EyeTrackingDemo-02-TargetSelection.

![]()

2. Aggiunta di scene al menu di compilazione

Per caricare scene aggiuntive durante il runtime, è necessario aggiungere queste scene alle impostazioni di compilazione -> Scene nel menu Compilazione prima. È importante che la scena radice venga visualizzata come prima scena nell'elenco:

![]()

3. Riprodurre gli esempi di rilevamento oculare nell'editor di Unity

Dopo aver aggiunto le scene di rilevamento oculare alle impostazioni di compilazione e caricando EyeTrackingDemo-00-RootScene, è possibile verificare un'ultima cosa: lo script "OnLoadStartScene" associato al GameObject MixedRealityBasicSceneSetup è abilitato? Si tratta di consentire alla scena radice di sapere quale scena demo caricare prima.

![]()

Andiamo a rotolare! Hit "Play"! Verranno visualizzate diverse gemme e il menu scena nella parte superiore.

![]()

Si dovrebbe anche notare un piccolo cerchio semitrasparente al centro della visualizzazione del gioco. Questo funge da indicatore (cursore) dello sguardo simulato: premere semplicemente il pulsante destro del mouse e spostare il mouse per modificare la posizione. Quando il cursore passa sopra le gemme, si noterà che lo snap al centro del gioiello attualmente visualizzato. Questo è un ottimo modo per testare se gli eventi vengono attivati come previsto quando si guarda una destinazione. Tenere presente che lo sguardo visivo simulato tramite il controllo del mouse è un integratore piuttosto povero per i nostri movimenti oculari rapidi e non intenzionali. Tuttavia, è ideale per testare la funzionalità di base prima di eseguire l'iterazione sulla progettazione distribuendola nel dispositivo HoloLens 2. Tornare alla scena dell'esempio di rilevamento oculare: la gemma ruota fino a quando si guarda e può essere distrutta da "guardando" e ...

- Premere INVIO (che simula la parola "select")

- Dicendo "select" nel microfono

- Quando si preme Spazio per visualizzare l'input della mano simulata, fare clic sul pulsante sinistro del mouse per eseguire un pizzicamento simulato

Viene descritto in dettaglio come ottenere queste interazioni nell'esercitazione Selezione destinazione supportata dall'occhio.

Quando si sposta il cursore fino alla barra dei menu superiore nella scena, si noterà che l'elemento attualmente spostato evidenzia in modo secondario. È possibile selezionare l'elemento attualmente evidenziato usando uno dei metodi di commit descritti sopra (ad esempio, premendo INVIO). In questo modo è possibile passare tra le diverse scene di esempio di rilevamento degli occhi.

4. Come testare scene secondarie specifiche

Quando si lavora in uno scenario specifico, potrebbe non essere necessario passare attraverso il menu scena ogni volta. È invece possibile iniziare direttamente dalla scena in cui si sta lavorando quando si preme il pulsante Play . non è un problema. Ecco cosa è possibile fare:

Caricare la scena radice

Nella scena radice disabilitare lo script "OnLoadStartScene"

Trascinare e rilasciare una delle scene di test di rilevamento oculare descritte di seguito (o qualsiasi altra scena) nella visualizzazione Gerarchia , come illustrato nello screenshot seguente.

Premere Play

Si noti che il caricamento della scena secondaria come questa non è persistente: ciò significa che se si distribuisce l'app nel dispositivo HoloLens 2, verrà caricata solo la scena radice (presupponendo che venga visualizzata nella parte superiore delle impostazioni di compilazione). Inoltre, quando si condivide il progetto con altri utenti, le scene secondarie non vengono caricate automaticamente.

Ora che si sa come ottenere le scene di esempio di rilevamento degli occhi MRTK per funzionare, si continua con immersioni più approfondite su come selezionare ologrammi con gli occhi: selezione di destinazione supportata dall'occhio.