Red Hat Enterprise Linux for SAP NetWeaver における Azure VM での GlusterFS

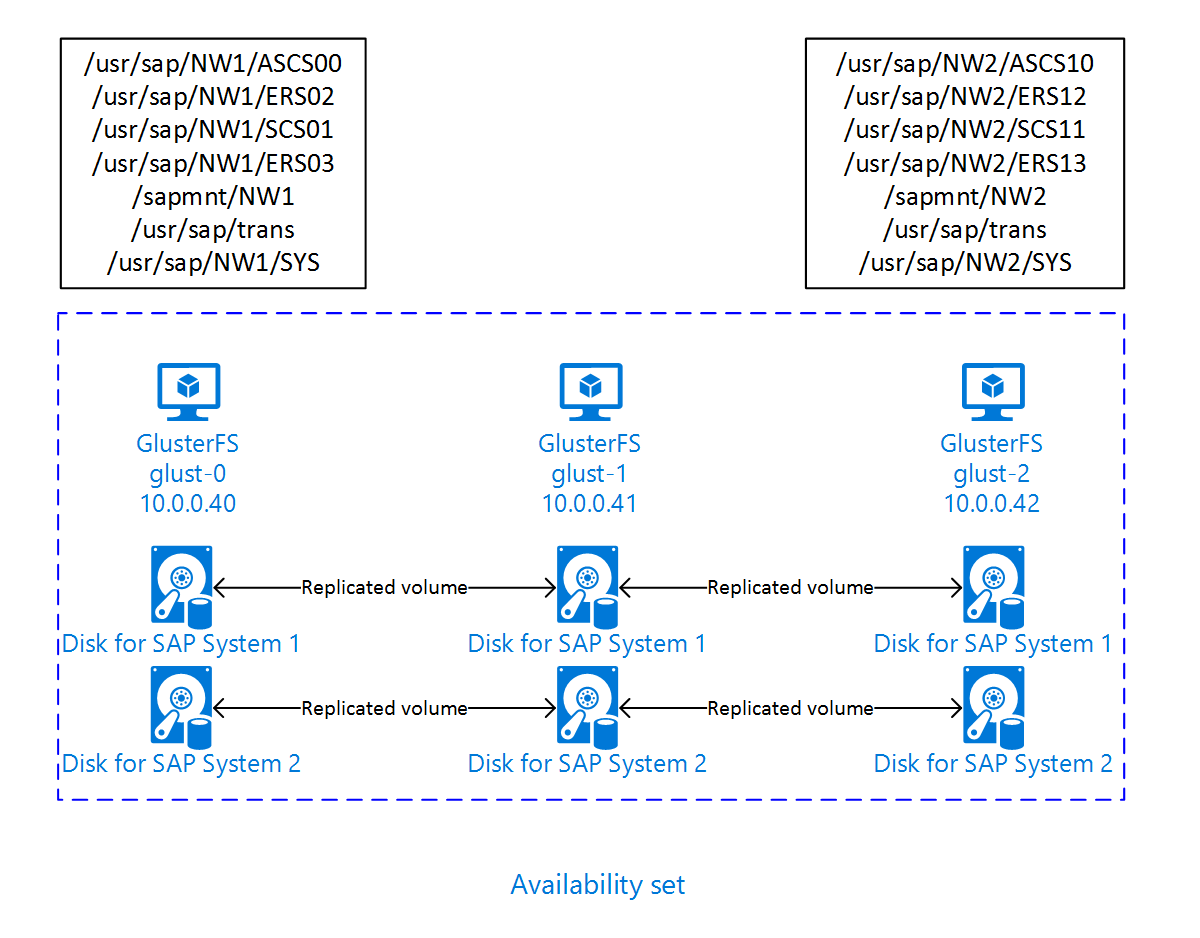

この記事では、仮想マシンをデプロイする方法、仮想マシンを構成する方法、および可用性の高い SAP システムの共有データを格納するために使用できる GlusterFS クラスターをインストールする方法について説明します。 このガイドでは、NW1 と NW2 の 2 つの SAP システムで使用される GlusterFS を設定する方法について説明します。 この例のリソース (仮想マシン、仮想ネットワークなど) の名前は、リソース プレフィックスが glust の SAP ファイル サーバー テンプレートを使用していることを想定しています。

Red Hat Gluster Storage Life Cycle に記載されているように、Red Hat Gluster Storage の有効期限が、2024 年末に切れることに注意してください。 構成は、有効期限の終了段階に達するまで、SAP on Azure でサポートされます。 新しいデプロイに GlusterFS を使用しないでください。 Azure Files 上の NFS を使用する RHEL 上の HA for SAP NW または Azure NetApp Files を使用する RHEL 上の HA for SAP NW に関するページに記載されているように、SAP 共有ディレクトリを、Azure Files または Azure NetApp Files ボリューム上の NFS にデプロイすることをお勧めします。

はじめに、次の SAP Note およびガイドを確認してください

SAP Note 1928533: 次の情報が含まれています。

- SAP ソフトウェアのデプロイでサポートされる Azure VM サイズの一覧

- Azure VM サイズの容量に関する重要な情報

- サポートされる SAP ソフトウェア、およびオペレーティング システム (OS) とデータベースの組み合わせ

- Microsoft Azure 上の Windows と Linux に必要な SAP カーネル バージョン

SAP Note 2015553: SAP でサポートされる Azure 上の SAP ソフトウェア デプロイの前提条件が記載されています。

SAP Note 2002167 では、Red Hat Enterprise Linux 用の OS 設定が推奨されています

SAP Note 2009879 には、Red Hat Enterprise Linux 用の SAP HANA ガイドラインが記載されています

SAP Note 2178632: Azure 上の SAP について報告されるすべての監視メトリックに関する詳細情報が記載されています。

SAP Note 2191498: Azure 上の Linux に必要な SAP Host Agent のバージョンが記載されています。

SAP Note 2243692: Azure 上の Linux で動作する SAP のライセンスに関する情報が記載されています。

SAP Note 1999351: Azure Enhanced Monitoring Extension for SAP に関するその他のトラブルシューティング情報が記載されています。

SAP Community WIKI: Linux に必要なすべての SAP Note を参照できます。

一般的な RHEL ドキュメント

Azure 固有の RHEL ドキュメント:

概要

高可用性を実現するため、SAP NetWeaver には共有ストレージが必要です。 GlusterFS は別のクラスターで構成されており、複数の SAP システムでそれを使用できます。

GlusterFS の設定

この例では、リソースは Azure portal を使用して手動でデプロイされています。

Azure Portal を使用した手動による Linux のデプロイ

このドキュメントは、リソース グループ、Azure Virtual Network、サブネットが既にデプロイ済みであることを前提としています。

GlusterFS 用の仮想マシンをデプロイします。 Gluster ストレージでサポートされている適切な RHEL イメージを選択します。 VM を、スケール セット、可用性ゾーン、可用性セットのいずれかの可用性オプションでデプロイできます。

GlusterFS を構成する

次の各手順の先頭には、[A] - 全ノードが該当、[1] - ノード 1 のみ該当、[2] - ノード 2 のみ該当、[3] - ノード 3 のみ該当、のいずれかが付いています。

[A] ホスト名解決を設定します

DNS サーバーを使用するか、すべてのノードの /etc/hosts を変更します。 この例では、/etc/hosts ファイルを使用する方法を示しています。 次のコマンドの IP アドレスとホスト名を置き換えます

sudo vi /etc/hosts次の行を /etc/hosts に挿入します。 お使いの環境に合わせて IP アドレスとホスト名を変更します

# IP addresses of the Gluster nodes 10.0.0.40 glust-0 10.0.0.41 glust-1 10.0.0.42 glust-2[A] 登録します

使用する仮想マシンを登録し、それを、RHEL 7 および GlusterFS 用のリポジトリを含むプールに追加します

sudo subscription-manager register sudo subscription-manager attach --pool=<pool id>[A] GlusterFS リポジトリを有効にします

必要なパッケージをインストールするには、次のリポジトリを有効にします。

sudo subscription-manager repos --disable "*" sudo subscription-manager repos --enable=rhel-7-server-rpms sudo subscription-manager repos --enable=rh-gluster-3-for-rhel-7-server-rpms[A] GlusterFS パッケージをインストールします

これらのパッケージをすべての GlusterFS ノードにインストールします

sudo yum -y install redhat-storage-serverインストール後にノードを再起動します。

[A] ファイアウォール ルールを変更します

GlusterFS ノードへのクライアント トラフィックを許可するためのファイアウォール規則を追加します。

# list the available zones firewall-cmd --get-active-zones sudo firewall-cmd --zone=public --add-service=glusterfs --permanent sudo firewall-cmd --zone=public --add-service=glusterfs[A] GlusterFS サービスを有効にして開始します

すべてのノード上の GlusterFS サービスを開始します。

sudo systemctl start glusterd sudo systemctl enable glusterd[1] GluserFS を作成します

以下のコマンドを実行して、GlusterFS クラスターを作成します

sudo gluster peer probe glust-1 sudo gluster peer probe glust-2 # Check gluster peer status sudo gluster peer status # Number of Peers: 2 # # Hostname: glust-1 # Uuid: 10d43840-fee4-4120-bf5a-de9c393964cd # State: Accepted peer request (Connected) # # Hostname: glust-2 # Uuid: 9e340385-12fe-495e-ab0f-4f851b588cba # State: Accepted peer request (Connected)[2] ピアの状態をテストします

2 番目のノード上でピアの状態をテストします

sudo gluster peer status # Number of Peers: 2 # # Hostname: glust-0 # Uuid: 6bc6927b-7ee2-461b-ad04-da123124d6bd # State: Peer in Cluster (Connected) # # Hostname: glust-2 # Uuid: 9e340385-12fe-495e-ab0f-4f851b588cba # State: Peer in Cluster (Connected)[3] ピアの状態をテストします

3 番目のノード上でピアの状態をテストします

sudo gluster peer status # Number of Peers: 2 # # Hostname: glust-0 # Uuid: 6bc6927b-7ee2-461b-ad04-da123124d6bd # State: Peer in Cluster (Connected) # # Hostname: glust-1 # Uuid: 10d43840-fee4-4120-bf5a-de9c393964cd # State: Peer in Cluster (Connected)[A] LVM を作成します

この例では、NW1 と NW2 の 2 つの SAP システムで GlusterFS を使用します。 次のコマンドを使用して、これらの SAP システム用の LVM 構成を作成します。

NW1 には以下のコマンドを使用します

sudo pvcreate --dataalignment 1024K /dev/disk/azure/scsi1/lun0 sudo pvscan sudo vgcreate --physicalextentsize 256K rhgs-NW1 /dev/disk/azure/scsi1/lun0 sudo vgscan sudo lvcreate -l 50%FREE -n rhgs-NW1/sapmnt sudo lvcreate -l 20%FREE -n rhgs-NW1/trans sudo lvcreate -l 10%FREE -n rhgs-NW1/sys sudo lvcreate -l 50%FREE -n rhgs-NW1/ascs sudo lvcreate -l 100%FREE -n rhgs-NW1/aers sudo lvscan sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/sapmnt sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/trans sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/sys sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/ascs sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/aers sudo mkdir -p /rhs/NW1/sapmnt sudo mkdir -p /rhs/NW1/trans sudo mkdir -p /rhs/NW1/sys sudo mkdir -p /rhs/NW1/ascs sudo mkdir -p /rhs/NW1/aers sudo chattr +i /rhs/NW1/sapmnt sudo chattr +i /rhs/NW1/trans sudo chattr +i /rhs/NW1/sys sudo chattr +i /rhs/NW1/ascs sudo chattr +i /rhs/NW1/aers echo -e "/dev/rhgs-NW1/sapmnt\t/rhs/NW1/sapmnt\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/trans\t/rhs/NW1/trans\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/sys\t/rhs/NW1/sys\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/ascs\t/rhs/NW1/ascs\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/aers\t/rhs/NW1/aers\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab sudo mount -aNW2 には以下のコマンドを使用します

sudo pvcreate --dataalignment 1024K /dev/disk/azure/scsi1/lun1 sudo pvscan sudo vgcreate --physicalextentsize 256K rhgs-NW2 /dev/disk/azure/scsi1/lun1 sudo vgscan sudo lvcreate -l 50%FREE -n rhgs-NW2/sapmnt sudo lvcreate -l 20%FREE -n rhgs-NW2/trans sudo lvcreate -l 10%FREE -n rhgs-NW2/sys sudo lvcreate -l 50%FREE -n rhgs-NW2/ascs sudo lvcreate -l 100%FREE -n rhgs-NW2/aers sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/sapmnt sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/trans sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/sys sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/ascs sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/aers sudo mkdir -p /rhs/NW2/sapmnt sudo mkdir -p /rhs/NW2/trans sudo mkdir -p /rhs/NW2/sys sudo mkdir -p /rhs/NW2/ascs sudo mkdir -p /rhs/NW2/aers sudo chattr +i /rhs/NW2/sapmnt sudo chattr +i /rhs/NW2/trans sudo chattr +i /rhs/NW2/sys sudo chattr +i /rhs/NW2/ascs sudo chattr +i /rhs/NW2/aers sudo lvscan echo -e "/dev/rhgs-NW2/sapmnt\t/rhs/NW2/sapmnt\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/trans\t/rhs/NW2/trans\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/sys\t/rhs/NW2/sys\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/ascs\t/rhs/NW2/ascs\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/aers\t/rhs/NW2/aers\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab sudo mount -a[1]分散ボリュームを作成します

次のコマンドを使用して NW1 用の GlusterFS ボリュームを作成してそれを開始します。

sudo gluster vol create NW1-sapmnt replica 3 glust-0:/rhs/NW1/sapmnt glust-1:/rhs/NW1/sapmnt glust-2:/rhs/NW1/sapmnt force sudo gluster vol create NW1-trans replica 3 glust-0:/rhs/NW1/trans glust-1:/rhs/NW1/trans glust-2:/rhs/NW1/trans force sudo gluster vol create NW1-sys replica 3 glust-0:/rhs/NW1/sys glust-1:/rhs/NW1/sys glust-2:/rhs/NW1/sys force sudo gluster vol create NW1-ascs replica 3 glust-0:/rhs/NW1/ascs glust-1:/rhs/NW1/ascs glust-2:/rhs/NW1/ascs force sudo gluster vol create NW1-aers replica 3 glust-0:/rhs/NW1/aers glust-1:/rhs/NW1/aers glust-2:/rhs/NW1/aers force sudo gluster volume start NW1-sapmnt sudo gluster volume start NW1-trans sudo gluster volume start NW1-sys sudo gluster volume start NW1-ascs sudo gluster volume start NW1-aers次のコマンドを使用して NW2 用の GlusterFS ボリュームを作成してそれを開始します。

sudo gluster vol create NW2-sapmnt replica 3 glust-0:/rhs/NW2/sapmnt glust-1:/rhs/NW2/sapmnt glust-2:/rhs/NW2/sapmnt force sudo gluster vol create NW2-trans replica 3 glust-0:/rhs/NW2/trans glust-1:/rhs/NW2/trans glust-2:/rhs/NW2/trans force sudo gluster vol create NW2-sys replica 3 glust-0:/rhs/NW2/sys glust-1:/rhs/NW2/sys glust-2:/rhs/NW2/sys force sudo gluster vol create NW2-ascs replica 3 glust-0:/rhs/NW2/ascs glust-1:/rhs/NW2/ascs glust-2:/rhs/NW2/ascs force sudo gluster vol create NW2-aers replica 3 glust-0:/rhs/NW2/aers glust-1:/rhs/NW2/aers glust-2:/rhs/NW2/aers force sudo gluster volume start NW2-sapmnt sudo gluster volume start NW2-trans sudo gluster volume start NW2-sys sudo gluster volume start NW2-ascs sudo gluster volume start NW2-aers

次の手順

- SAP ASCS とデータベースのインストール

- SAP のための Azure Virtual Machines の計画と実装

- SAP のための Azure Virtual Machines のデプロイ

- SAP のための Azure Virtual Machines DBMS のデプロイ

- SAP HANA on Azure (L インスタンス) の高可用性を確保し、ディザスター リカバリーを計画する方法を確認するには、「Azure での SAP HANA (L インスタンス) の高可用性とディザスター リカバリー」を参照してください。

- Azure VM 上の SAP HANA の高可用性を確保し、ディザスター リカバリーを計画する方法を確認するには、「Azure Virtual Machines (VM) 上の SAP HANA の高可用性」を参照してください。