이 문서에서는 Azure 아키텍처 센터에 설명된 Azure 데이터베이스 솔루션에 대한 개요를 제공합니다.

Apache®, Apache Cassandra® 및 Hadoop 로고는 미국 및/또는 기타 국가에서 Apache Software Foundation의 등록 상표 또는 상표입니다. 이러한 표시의 사용은 Apache Software Foundation에 의한 보증을 암시하지 않습니다.

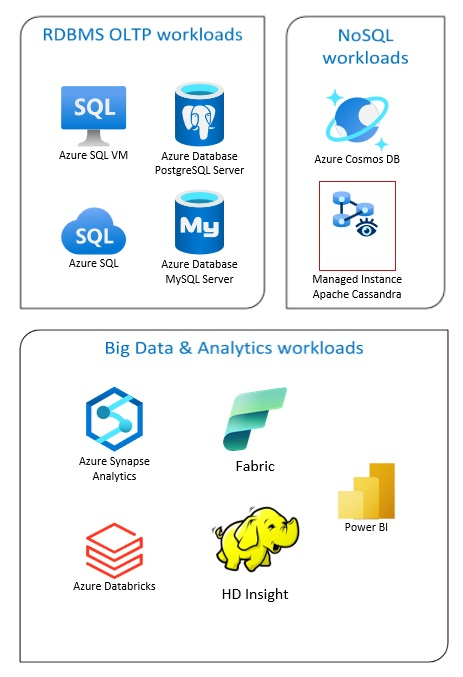

Azure Database 솔루션에는 기존의 관계형 데이터베이스 관리 시스템(RDBMS 및 OLTP), 빅 데이터 및 분석 워크로드(OLAP 포함) 및 NoSQL 워크로드가 포함됩니다.

이러한 워크로드에는 OLTP(온라인 트랜잭션 처리) 및 OLAP(온라인 분석 처리)가 포함됩니다. 조직의 여러 원본의 데이터를 데이터 웨어하우스로 통합할 수 있습니다. ETL(추출, 변환 및 로드) 또는 ELT(추출, 로드 및 변환) 프로세스를 사용하여 원본 데이터를 이동하고 변환할 수 있습니다. RDBMS 데이터베이스에 대한 자세한 내용은 Azure에서 관계형 데이터베이스 탐색을 참조하세요.

빅 데이터 아키텍처는 기존의 데이터베이스 시스템에 비해 너무 크거나 복잡한 데이터의 수집, 처리 및 분석을 수행하도록 디자인되었습니다. 빅 데이터 솔루션에는 일반적으로 많은 양의 관계형 및 비관계형 데이터가 포함되며, 기존의 RDBMS 시스템은 저장하기에 적합하지 않습니다. 일반적으로 Data Lakes, Delta Lakes 및 Lakehouses와 같은 솔루션이 포함됩니다. 분석 아키텍처 디자인에 대한 자세한 내용을 참조하세요.

NoSQL 데이터베이스를 비관계형, NoSQL DB 또는 비 SQL이라고 하여 빠르게 변화하는 구조화되지 않은 대량의 데이터를 처리할 수 있다는 사실을 강조합니다. (SQL) 데이터베이스와 같은 테이블, 행 및 열에는 데이터를 저장하지 않습니다. SQL DB 데이터베이스 없음에 대한 자세한 내용은 NoSQL 데이터 및 NoSQL 데이터베이스란?을 참조하세요.

이 문서에서는 Azure 데이터베이스에 대해 알아볼 수 있는 리소스를 제공합니다. 솔루션을 디자인할 때 염두에 두어야 할 요구 사항 및 모범 사례를 충족하는 아키텍처를 구현하는 경로를 간략하게 설명합니다.

데이터베이스 요구 사항을 해결하기 위해 그릴 수 있는 많은 아키텍처가 있습니다. 또한 필요한 모든 구성 요소에 대한 링크를 포함하는 빌드할 수 있는 솔루션 아이디어를 제공합니다.

Azure의 데이터베이스에 대해 알아보기

솔루션에 사용할 수 있는 아키텍처에 대해 생각하기 시작하면 올바른 데이터 저장소를 선택하는 것이 중요합니다. Azure의 데이터베이스를 새로 사용하는 경우 가장 좋은 시작 위치는 Microsoft Learn입니다. 이 무료 온라인 플랫폼은 실습 학습을 위한 비디오 및 자습서를 제공합니다. Microsoft Learn은 개발자 또는 데이터 분석가와 같은 작업 역할을 기반으로 하는 학습 경로를 제공합니다.

Azure의 다양한 데이터베이스 및 해당 용도에 대한 일반적인 설명으로 시작할 수 있습니다. Azure 데이터 모듈을 찾아보고 Azure에서 데이터 스토리지 접근 방식을 선택할 수도 있습니다. 이러한 문서는 Azure 데이터 솔루션에서 선택한 항목을 이해하고 특정 시나리오에서 일부 솔루션이 권장되는 이유를 알아보는 데 도움이 됩니다.

유용한 몇 가지 Learn 모듈은 다음과 같습니다.

- Azure로의 마이그레이션 설계

- Azure SQL Database 배포

- Azure Database 및 분석 서비스 살펴보기

- Azure SQL Database 보안

- Azure Cosmos DB

- Azure Database for PostgreSQL

- Azure Database for MySQL

- Azure VM의 SQL Server

프로덕션 경로

관계형 데이터를 처리하는 데 유용한 옵션을 찾으려면 다음 리소스를 고려하세요.

- 여러 원본에서 데이터를 수집하기 위한 리소스와 데이터 파이프라인 내에서 데이터 변환을 적용하고 적용하는 방법에 대해 알아보려면 Azure의 분석을 참조하세요.

- 대규모 비즈니스 데이터베이스를 구성하고 복잡한 분석을 지원하는 OLAP에 대해 알아보려면 온라인 분석 처리를 참조하세요.

- OLTP 시스템이 발생하는 비즈니스 상호 작용을 기록하는 방법에 대해 알아보려면 온라인 트랜잭션 처리를 참조하세요.

비관계형 데이터베이스는 행과 열의 테이블 형식 스키마를 사용하지 않습니다. 자세한 내용은 비관계형 데이터 및 NoSQL을 참조 하세요.

대량의 데이터를 원시 형식으로 보유하는 데이터 레이크에 대해 알아보려면 데이터 레이크를 참조하세요.

빅 데이터 아키텍처는 기존의 데이터베이스 시스템에 비해 너무 크거나 복잡한 데이터의 수집, 처리 및 분석을 수행할 수 있습니다. 자세한 내용은 빅 데이터 아키텍처 및분석을 참조하세요.

하이브리드 클라우드는 퍼블릭 클라우드와 온-프레미스 데이터 센터를 결합하는 IT 환경입니다. 자세한 내용은 온-프레미스 데이터 솔루션을 클라우드로 확장하거나 Azure 데이터베이스와 결합된 Azure Arc를 고려하세요.

Azure Cosmos DB는 최신 앱 개발을 위한 완전 관리형 NoSQL 데이터베이스 서비스입니다. 자세한 내용은 Azure Cosmos DB 리소스 모델을 참조하세요.

Azure와 데이터를 전송하는 옵션에 대한 자세한 내용은 Azure로 데이터 전송을 참조하세요.

모범 사례

솔루션을 설계할 때 이러한 모범 사례를 검토하세요.

| 모범 사례 | 설명 |

|---|---|

| 데이터 관리 패턴 | 데이터 관리는 클라우드 애플리케이션의 핵심 요소입니다. 대부분의 품질 특성에 영향을 줍니다. |

| Azure Cosmos DB를 사용한 트랜잭션 Outbox 패턴 | 안정적인 메시징 및 보장된 이벤트 배달을 위해 트랜잭션 Outbox 패턴을 사용하는 방법을 알아보세요. |

| Azure Cosmos DB를 사용하여 전역적으로 데이터 배포 | 짧은 대기 시간 및 고가용성을 이루려면 일부 애플리케이션을 해당 사용자에서 가까운 데이터 센터에 배포해야 합니다. |

| Azure Cosmos DB의 보안 | 보안 모범 사례를 통해 데이터베이스 위반을 방지, 감지 및 대응할 수 있습니다. |

| Azure Cosmos DB의 특정 시점 복원을 사용한 지속적인 백업 | Azure Cosmos DB 특정 시점 복원에 대해 알아보세요. |

| Azure Cosmos DB의 고가용성 달성 | Azure Cosmos DB는 고가용성을 달성하기 위해 여러 기능 및 구성 옵션을 제공합니다. |

| Azure SQL Database 및 SQL Managed Instance에 대한 고가용성 | 데이터베이스는 아키텍처에서 단일 실패 지점이 되지 않아야 합니다. |

기술 선택

Azure Databases에서 사용할 기술에는 여러 가지 옵션이 있습니다. 이러한 문서는 요구 사항에 가장 적합한 기술을 선택하는 데 도움이 됩니다.

- 데이터 저장소 선택

- Azure에서 분석 데이터 저장소 선택

- Azure에서 데이터 분석 기술 선택

- Azure에서 일괄 처리 기술 선택

- Azure에서 빅 데이터 스토리지 기술 선택

- Azure에서 데이터 파이프라인 오케스트레이션 기술 선택

- Azure에서 검색 데이터 저장소 선택

- Azure에서 스트림 처리 기술 선택

데이터베이스를 최신 상태로 유지

Azure Databases 기술을 최신 상태로 유지하려면 Azure 업데이트를 참조하세요.

관련 참고 자료

- Azure에서 데이터 관리 및 분석을 위한 Adatum Corporation 시나리오

- Azure의 데이터 관리 및 분석을 위한 Lamna Healthcare 시나리오

- SQL Server 인스턴스 관리 최적화

- Azure의 데이터 관리 및 분석을 위한 Relecloud 시나리오

예제 솔루션

이러한 솔루션 아이디어는 요구 사항에 맞게 조정할 수 있는 몇 가지 예제 접근 방식입니다.

비슷한 데이터베이스 제품

AWS(Amazon Web Services) 또는 Google Cloud에 익숙한 경우 다음 비교를 참조하세요.