Azure CLI를 사용하여 Azure Data Lake Analytics 관리

중요

Azure Data Lake Analytics 2024년 2월 29일에 사용 중지되었습니다. 이 공지 사항을 통해 자세히 알아봅니다.

데이터 분석의 경우 organization Azure Synapse Analytics 또는 Microsoft Fabric을 사용할 수 있습니다.

Azure CLI를 사용하여 Azure Data Lake Analytics 계정, 데이터 원본, 사용자 및 작업을 관리하는 방법에 대해 알아봅니다. 다른 도구를 사용하여 관리 항목을 보려면 위의 탭 선택을 선택합니다.

필수 구성 요소

이 자습서를 시작하기 전에 다음 리소스가 있어야 합니다.

Azure 구독 Azure 평가판을 참조하세요.

Azure CLI. Azure CLI 설치 및 구성을 참조하세요.

- 이 데모를 완료하려면 시험판Azure CLI 도구 를 다운로드하여 설치합니다.

az login명령을 사용하여 인증하고, 사용하려는 구독을 선택합니다. 회사 또는 학교 계정을 사용하여 인증하는 방법에 대한 자세한 내용은 Azure CLI에서 Azure 구독에 연결을 참조하세요.az login az account set --subscription <subscription id>이제 Data Lake Analytics 및 Data Lake Store 명령에 액세스할 수 있습니다. 다음 명령을 사용하여 Data Lake Store 및 Data Lake Analytics 명령을 나열합니다.

az dls -h az dla -h

계정 관리

데이터 레이크 분석 작업을 실행하려면 데이터 레이크 분석 계정이 있어야 합니다. Azure HDInsight와 달리 작업을 실행하지 않는 경우 분석 계정에 대해 비용을 지불하지 않습니다. 작업이 실행되는 시간에 대해서만 비용을 지불합니다. 자세한 내용은 Azure 데이터 레이크 분석 개요를 참조하세요.

계정 만들기

다음 명령을 실행하여 Data Lake 계정을 만듭니다.

az dla account create --account "<Data Lake Analytics account name>" --location "<Location Name>" --resource-group "<Resource Group Name>" --default-data-lake-store "<Data Lake Store account name>"

계정 업데이트

다음 명령은 기존 데이터 레이크 분석 계정의 속성을 업데이트합니다.

az dla account update --account "<Data Lake Analytics Account Name>" --firewall-state "Enabled" --query-store-retention 7

계정 나열

특정 리소스 그룹 내의 데이터 레이크 분석 계정 나열

az dla account list "<Resource group name>"

계정에 대한 세부 정보 가져오기

az dla account show --account "<Data Lake Analytics account name>" --resource-group "<Resource group name>"

계정 삭제

az dla account delete --account "<Data Lake Analytics account name>" --resource-group "<Resource group name>"

데이터 원본 관리

Data Lake Analytics는 현재 다음 두 데이터 원본을 지원합니다.

분석 계정을 만들 때 Azure 데이터 레이크 Storage 계정이 기본 Storage 계정이 되도록 지정해야 합니다. 기본 Data Lake 스토리지 계정은 작업 메타데이터 및 작업 감사 로그를 저장하는 데 사용됩니다. 분석 계정을 만든 후 Data Lake Storage 계정 및/또는 Azure Storage 계정을 더 추가할 수 있습니다.

기본 데이터 레이크 저장소 계정 찾기

az dla account show 명령을 실행하여 사용되는 기본 Data Lake Store 계정을 볼 수 있습니다. 기본 계정 이름은 defaultDataLakeStoreAccount 속성에 나열됩니다.

az dla account show --account "<Data Lake Analytics account name>"

다른 Blob 스토리지 계정 추가

az dla account blob-storage add --access-key "<Azure Storage Account Key>" --account "<Data Lake Analytics account name>" --storage-account-name "<Storage account name>"

참고

File Storage FAQ FQDN(예: “myblob.blob.core.windows.net”)을 사용하지 마십시오.

다른 Data Lake Store 계정 추가

다음 명령은 지정된 Data Lake Analytics 계정을 다른 Data Lake Store 계정으로 업데이트합니다.

az dla account data-lake-store add --account "<Data Lake Analytics account name>" --data-lake-store-account-name "<Data Lake Store account name>"

기존 데이터 원본 업데이트

Java에서 File Storage를 사용하는 방법

az dla account blob-storage update --access-key "<New Blob Storage Account Key>" --account "<Data Lake Analytics account name>" --storage-account-name "<Data Lake Store account name>"

데이터 원본 나열

Data Lake Store 계정 나열:

az dla account data-lake-store list --account "<Data Lake Analytics account name>"

Blob Storage 계정 나열:

az dla account blob-storage list --account "<Data Lake Analytics account name>"

데이터 원본 삭제

데이터 레이크 저장소 계정을 삭제하려면:

az dla account data-lake-store delete --account "<Data Lake Analytics account name>" --data-lake-store-account-name "<Azure Data Lake Store account name>"

.NET용 File Storage 시작

az dla account blob-storage delete --account "<Data Lake Analytics account name>" --storage-account-name "<Data Lake Store account name>"

작업 관리

작업을 만들려면 데이터 레이크 분석 계정이 있어야 합니다. 자세한 내용은 데이터 레이크 분석 계정 관리를 참조하세요.

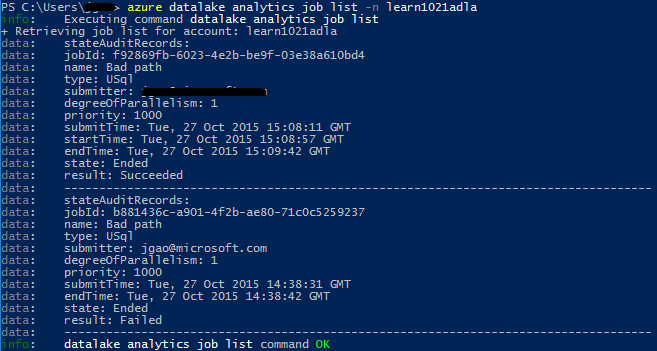

작업 나열

az dla job list --account "<Data Lake Analytics account name>"

작업 세부 정보 가져오기

az dla job show --account "<Data Lake Analytics account name>" --job-identity "<Job Id>"

작업 제출

참고

작업의 기본 우선 순위는 1000이고 작업에 대한 기본 병렬 처리 수준은 1입니다.

az dla job submit --account "<Data Lake Analytics account name>" --job-name "<Name of your job>" --script "<Script to submit>"

작업 취소

list 명령을 사용하여 작업 ID를 찾은 후 cancel을 사용하여 작업을 취소합니다.

az dla job cancel --account "<Data Lake Analytics account name>" --job-identity "<Job Id>"

파이프라인 및 되풀이

파이프라인 및 되풀이에 대한 정보 가져오기

az dla job pipeline 명령을 사용하여 이전에 제출한 작업의 파이프라인 정보를 확인합니다.

az dla job pipeline list --account "<Data Lake Analytics Account Name>"

az dla job pipeline show --account "<Data Lake Analytics Account Name>" --pipeline-identity "<Pipeline ID>"

az dla job recurrence 명령을 사용하여 이전에 제출한 작업의 되풀이 정보를 확인합니다.

az dla job recurrence list --account "<Data Lake Analytics Account Name>"

az dla job recurrence show --account "<Data Lake Analytics Account Name>" --recurrence-identity "<Recurrence ID>"