직접 하드웨어 요구 사항 저장소 공간

적용 대상: Azure Stack Hub, Azure Stack HCI 버전 21H2, Azure Stack HCI 버전 20H2, Windows Server 2022, Windows Server 2019, Windows Server 2016

이 문서에서는 저장소 공간 Direct에 대한 최소 하드웨어 요구 사항을 설명합니다. 클라우드에 대한 연결이 있는 하이퍼 컨버지드 배포용으로 설계된 운영 체제인 Azure Stack HCI의 하드웨어 요구 사항은 Azure Stack HCI를 배포하기 전에: 하드웨어 요구 사항 결정을 참조 하세요.

프로덕션의 경우 Microsoft는 배포 도구 및 절차를 포함하는 파트너로부터 검증된 하드웨어/소프트웨어 솔루션을 구매하는 것이 좋습니다. 이러한 솔루션은 호환성과 안정성을 보장하기 위해 참조 아키텍처에 대해 설계, 어셈블 및 유효성 검사를 수행하므로 빠르게 시작하고 실행할 수 있습니다. 하드웨어 솔루션은 Azure Stack HCI 솔루션 웹 사이트를 방문하세요.

팁

저장소 공간 Direct를 평가하려고 하지만 하드웨어가 없나요? 게스트 가상 머신 클러스터에서 저장소 공간 Direct 사용에 설명된 대로 Hyper-V 또는 Azure 가상 머신을 사용합니다.

기본 요구 사항

Important

클러스터 노드가 구현되는 시나리오에서 NIC 어댑터, 드라이버 및 펌웨어는 SET 팀이 제대로 작동하려면 정확히 일치해야 합니다.

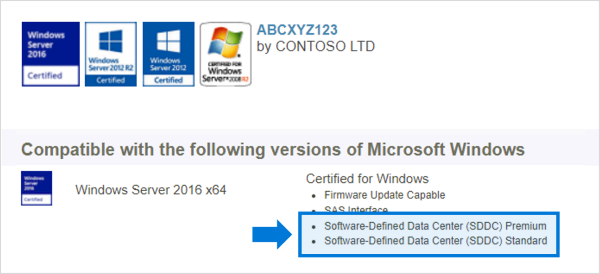

시스템, 구성 요소, 디바이스 및 드라이버는 Windows Server 카탈로그에서 사용 중인 운영 체제에 대해 인증을 받아야 합니다. 또한 서버 및 네트워크 어댑터에는 아래 그림과 같이 SDDC(소프트웨어 정의 데이터 센터) 표준 및/또는 SDDC(소프트웨어 정의 데이터 센터) 프리미엄 추가 자격(AQ)이 있는 것이 좋습니다. SDDC AQ를 사용하는 구성 요소는 1,000개가 넘습니다.

완전히 구성된 클러스터(서버, 네트워킹 및 스토리지)는 장애 조치(failover) 클러스터 관리자 또는 PowerShell의 cmdlet을 사용하여 Test-Cluster마법사당 모든 클러스터 유효성 검사 테스트를 통과해야 합니다.

또한 다음 요구 사항이 적용됩니다.

서버

- 최소 2개 서버, 최대 16개 서버

- 모든 서버가 동일한 제조업체 및 모델을 사용하는 것이 좋습니다.

CPU

- Intel Nehalem 이상 호환 프로세서 또는

- AMD EPYC 이상 호환 프로세서

메모리

- Windows Server, VM 및 기타 앱 또는 워크로드용 메모리 플러스

- 저장소 공간 Direct 메타데이터의 경우 각 서버의 캐시 드라이브 용량 테라바이트당 4GB RAM

Boot

- 이제 SATADOM을 포함하는 Windows Server에서 지원하는 모든 부팅 디바이스

- RAID 1 미러 필요하지 않지만 부팅에 지원됩니다.

- 권장: 최소 크기 200GB

네트워킹

저장소 공간 Direct에는 각 노드 간에 안정적인 높은 대역폭, 짧은 대기 시간 네트워크 연결이 필요합니다.

소규모 2-3 노드에 대한 최소 상호 연결

- 10Gbps NIC(네트워크 인터페이스 카드) 이상

- 중복성 및 성능에 권장되는 각 노드의 두 개 이상의 네트워크 연결

고성능, 대규모 또는 4+ 배포에 권장되는 상호 연결

- RDMA(원격 직접 메모리 액세스) 지원, iWARP(권장) 또는 RoCE인 NIC

- 중복성 및 성능에 권장되는 각 노드의 두 개 이상의 네트워크 연결

- 25Gbps NIC 이상

전환되거나 전환되지 않는 노드 상호 연결

- 전환됨: 대역폭 및 네트워킹 유형을 처리하도록 네트워크 스위치를 올바르게 구성해야 합니다. RoCE 프로토콜을 구현하는 RDMA를 사용하는 경우 네트워크 디바이스 및 스위치 구성이 훨씬 더 중요합니다.

- 스위치리스: 스위치를 사용하지 않고 직접 연결을 사용하여 노드를 상호 연결할 수 있습니다. 모든 노드는 클러스터의 다른 모든 노드와 직접 연결해야 합니다.

드라이브

저장소 공간 Direct는 각각 하나의 서버에 물리적으로 연결된 직접 연결된 SATA, SAS, NVMe 또는 PMem(영구 메모리) 드라이브에서 작동합니다. 드라이브를 선택하는 데 도움이 필요하면 드라이브 선택 및 영구 메모리 문서 이해 및 배포를 참조하세요.

- SATA, SAS, 영구 메모리 및 NVMe(M.2, U.2 및 추가 기능 카드) 드라이브가 모두 지원됩니다.

- 512n, 512e 및 4K 네이티브 드라이브가 모두 지원됩니다.

- 반도체 드라이브는 전원 손실 방지 기능을 제공해야 합니다.

- 모든 서버에서 동일한 수 및 유형의 드라이브 - 드라이브 대칭 고려 사항 참조

- 캐시 디바이스는 32GB 이상이어야 합니다.

- 영구 메모리 디바이스는 블록 스토리지 모드에서 사용됩니다.

- 영구 메모리 디바이스를 캐시 디바이스로 사용하는 경우 NVMe 또는 SSD 용량 디바이스를 사용해야 합니다(HDD를 사용할 수 없습니다).

- HDD를 사용하여 스토리지 용량을 제공하는 경우 스토리지 버스 캐싱을 사용해야 합니다. 모든 플래시 배포를 사용하는 경우 스토리지 버스 캐싱이 필요하지 않습니다.

- NVMe 드라이버는 Windows(stornvme.sys)에 포함된 Microsoft 제공 드라이버입니다.

- 권장: 용량 드라이브 수는 캐시 드라이브 수의 전체 배수입니다.

- 권장: 캐시 드라이브는 쓰기 내구성이 높아야 합니다. DWPD(하루 3개 이상의 드라이브-쓰기 수) 또는 하루에 최소 4TBW(TBW)가 기록됨 - DWPD(일일 드라이브 쓰기 이해), TBW(테라바이트 쓰기) 및 저장소 공간 Direct에 권장되는 최소값 참조

참고 항목

스토리지 용량에 모든 플래시 드라이브를 사용하는 경우 스토리지 풀 캐싱의 이점은 제한됩니다. 스토리지 풀 캐시에 대해 자세히 알아봅니다.

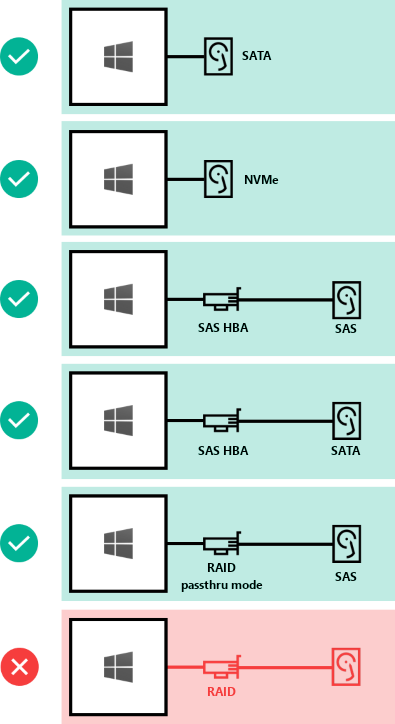

저장소 공간 Direct에 드라이브를 연결할 수 있는 방법은 다음과 같습니다.

- 직접 연결된 SATA 드라이브

- 직접 연결된 NVMe 드라이브

- SAS 드라이브가 있는 SAS HBA(호스트 버스 어댑터)

- SATA 드라이브가 있는 SAS HBA(호스트 버스 어댑터)

- RAID 컨트롤러 카드 SAS 물리적 스토리지 디바이스만 직접 전달

- 지원되지 않음: SAS 물리적 스토리지 디바이스 또는 SAN(파이버 채널, iSCSI, FCoE) 스토리지의 직접 통과를 지원하지 않는 RAID 컨트롤러 카드. HBA(호스트 버스 어댑터) 카드 저장소 공간 Direct에 사용되는 모든 스토리지 디바이스에 대해 간단한 통과 모드를 구현해야 합니다.

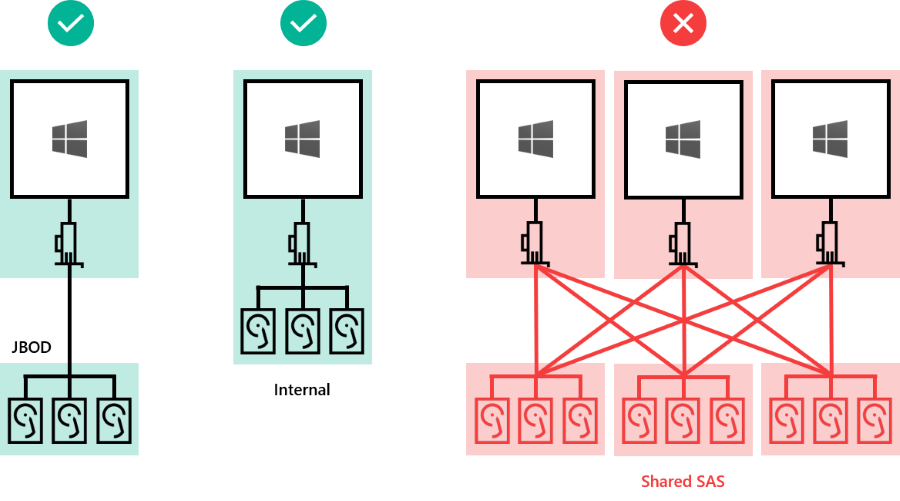

드라이브는 서버 내부 또는 하나의 서버에만 연결된 외부 엔클로저에 있을 수 있습니다. 슬롯 매핑 및 식별에는 SES(SCSI 엔클로저 서비스)가 필요합니다. 각 외부 엔클로저는 고유 식별자(고유 ID)를 제공해야 합니다.

- 서버 내부 드라이브

- 한 서버에 연결된 외부 엔클로저("JBOD")의 드라이브

- 지원되지 않음: 여러 서버에 연결된 공유 SAS 엔클로저 또는 여러 경로로 드라이브에 액세스할 수 있는 MPIO(다중 경로 IO) 형식입니다.

최소 드라이브 수(부팅 드라이브 제외)

필요한 최소 용량 드라이브 수는 배포 시나리오에 따라 다릅니다. 스토리지 풀 캐시를 사용하려는 경우 서버당 2개 이상의 캐시 디바이스가 있어야 합니다.

물리적 서버 클러스터 또는 VM(가상 머신) 게스트 클러스터에 저장소 공간 Direct를 배포할 수 있습니다. 물리적 또는 가상 스토리지 디바이스의 선택에 따라 성능, 용량 또는 균형 잡힌 시나리오에 대한 저장소 공간 직접 디자인을 구성할 수 있습니다. 가상화된 배포는 프라이빗 또는 퍼블릭 클라우드의 기본 스토리지 성능 및 복원력을 활용합니다. VM 게스트 클러스터에 배포된 저장소 공간 직접을 사용하면 가상 환경 내에서 고가용성 솔루션을 사용할 수 있습니다.

다음 섹션에서는 물리적 및 가상 배포에 대한 최소 드라이브 요구 사항을 설명합니다.

물리적 배포

이 표에서는 Azure Stack HCI 버전 21H2 이상 및 Windows Server와 같은 하드웨어 배포에 대한 유형별 최소 용량 드라이브 수를 보여 줍니다.

| 드라이브 유형이 있음(용량에만 해당) | 필요한 최소 드라이브(Windows Server) | 필요한 최소 드라이브(Azure Stack HCI) |

|---|---|---|

| 모든 영구 메모리(동일한 모델) | 4 영구 메모리 | 영구 메모리 2개 |

| 모든 NVMe(동일한 모델) | 4 NVMe | 2 NVMe |

| 모든 SSD(동일한 모델) | 4 SSD | 2 SSD |

스토리지 풀 캐시를 사용하는 경우 캐시에 대해 구성된 드라이브가 2개 이상 있어야 합니다. 이 표에서는 2개 이상의 노드를 사용하는 Windows Server 및 Azure Stack HCI 배포에 필요한 최소 드라이브 수를 보여 줍니다.

| 드라이브 유형이 있음 | 필요한 최소 드라이브 |

|---|---|

| 영구 메모리 + NVMe 또는 SSD | 영구 메모리 2개 + NVMe 또는 SSD 4개 |

| NVMe + SSD | NVMe 2개 + SSD 4개 |

| NVMe + HDD | 2 NVMe + 4 HDD |

| SSD + HDD | SSD 2개 + HDD 4개 |

Important

스토리지 풀 캐시는 단일 노드 배포에서 Azure Stack HCI와 함께 사용할 수 없습니다.

가상 배포

이 표에서는 Windows Server 게스트 VM 또는 Windows Server Azure Edition과 같은 가상 배포에 대한 유형별 최소 드라이브 수를 보여 줍니다.

| 드라이브 유형이 있음(용량에만 해당) | 필요한 최소 드라이브 |

|---|---|

| 가상 하드 디스크 | 2 |

팁

Azure Stack HCI 또는 Windows Server에서 실행할 때 게스트 VM의 성능을 향상시키려면 CSV 메모리 내 읽기 캐시를 사용하여 버퍼되지 않은 읽기 작업을 캐시하는 것이 좋습니다.

가상 환경에서 저장소 공간 Direct를 사용하는 경우 다음을 고려해야 합니다.

- 가상 디스크는 실제 드라이브와 같은 오류에 취약하지 않지만 퍼블릭 또는 프라이빗 클라우드의 성능 및 안정성에 종속됩니다.

- 짧은 대기 시간/고성능 스토리지의 단일 계층을 사용하는 것이 좋습니다.

- 가상 디스크는 용량에만 사용해야 합니다.

가상 머신 및 가상화된 스토리지를 사용하여 저장소 공간 Direct를 배포하는 방법에 대해 자세히 알아봅니다.

최대 생산 능력

| 최대값 | Windows Server 2019 이상 | Windows Server 2016 |

|---|---|---|

| 서버당 원시 용량 | 400TB | 100TB |

| 풀 용량 | 4PB(4,000TB) | 1PB |