Importar dados de treinamento para o Estúdio do Machine Learning (clássico) de diferentes fontes de dados.

APLICA-SE A: Machine Learning Studio (clássico)

Machine Learning Studio (clássico)  Azure Machine Learning

Azure Machine Learning

Importante

O suporte para o Machine Learning Studio (clássico) terminará em 31 de agosto de 2024. É recomendável fazer a transição para o Azure Machine Learning até essa data.

A partir de 1º de dezembro de 2021, você não poderá criar recursos do Machine Learning Studio (clássico). Até 31 de agosto de 2024, você pode continuar usando os recursos existentes do Machine Learning Studio (clássico).

- Confira informações sobre como mover projetos de machine learning do ML Studio (clássico) para o Azure Machine Learning.

- Saiba mais sobre o Azure Machine Learning

A documentação do ML Studio (clássico) está sendo desativada e pode não ser atualizada no futuro.

Para usar seus próprios dados no Machine Learning Studio (clássico) para desenvolver e treinar uma solução de análise preditiva, você pode usar dados de:

- Arquivo local – carregue dados locais antecipadamente do disco rígido para criar um módulo de conjunto de dados em seu workspace

- Fontes de dados on-line: use o módulo Importar dados para acessar dados de uma das várias fontes on-line enquanto sua experiência está em exibição

- Experimento do Machine Learning Studio (clássico) – use os dados que foram salvos como um conjunto de dados no Machine Learning Studio (clássico)

- Banco de dados do Microsoft SQL Server – use os dados de um banco de dados do Microsoft SQL Server sem ter que copiar dados manualmente

Observação

Há diversos conjuntos de dados de exemplo disponíveis no Machine Learning Studio (clássico) que você pode usar para treinamento de dados. Para obter informações sobre eles, veja Usar os conjuntos de dados de exemplo no Estúdio do Machine Learning (clássico).

Preparar dados

O Machine Learning Studio (clássico) foi criado para trabalhar com dados tabulares ou retangulares, como dados de texto delimitados ou dados estruturados de um banco de dados, embora em algumas circunstâncias seja possível usar dados não retangulares.

Será melhor se os dados estiverem relativamente limpos antes de serem importados para o Studio (clássico). Por exemplo, você desejará resolver problemas como cadeias de caracteres sem aspas.

No entanto, há módulos disponíveis no Studio (clássico) que permitem fazer alguma manipulação de dados no experimento após a importação dos dados. Dependendo dos algoritmos de aprendizado de máquina que for usar, talvez seja necessário decidir como você lidará com problemas estruturais dos dados, como valores ausentes e dados esparsos, e há módulos que podem ajudar com isso. Veja a seção Transformação de Dados da paleta de módulos para ver os módulos que executam essas funções.

A qualquer altura do experimento, você poderá exibir ou baixar os dados produzidos por um módulo clicando na porta de saída. Dependendo do módulo, poderá haver opções de download diferentes disponíveis ou a possibilidade de visualizar os dados no navegador da Web no Studio (clássico).

Formatos e tipos de dados compatíveis

Você pode importar vários tipos de dados para seu experimento, dependendo de qual mecanismo usar para importar os dados e de onde eles estão vindo:

- Texto sem formatação (.txt)

- Valores separados por vírgulas (CSV) com cabeçalho (.csv) ou sem (.nh.csv)

- Valores separados por tabulação (TSV) com cabeçalho (.tsv) ou sem (.nh.tsv)

- Arquivo do Excel

- Tabela do Azure

- Tabela do Hive

- Tabela de Banco de Dados SQL

- Valores de OData

- Dados SVMLight (.svmlight) (consulte a definição de SVMLight para obter informações sobre o formato)

- Attribute Relation File Format (ARFF) (.arff) (consulte a definição de ARFF para obter informações sobre o formato)

- Arquivo zip (.zip)

- Arquivo de workspace ou objeto R (.RData)

Se você importar os dados em um formato como ARFF, que inclui metadados, o Studio (clássico) usará esses metadados para definir o cabeçalho e o tipo de dados de cada coluna.

Se você importar os dados em um formato como TSV ou CSV, que não incluem esses metadados, o Studio (clássico) inferirá o tipo de dados de cada coluna por amostragem dos dados. Se os dados também não tiverem títulos de coluna, o Studio (clássico) fornecerá nomes padrão.

Você pode especificar explicitamente ou alterar os cabeçalhos e tipos de dados das colunas usando o módulo Editar Metadados.

Os seguintes tipos de dados são reconhecidos pelo Studio (clássico):

- String

- Integer

- Double

- Booliano

- DateTime

- TimeSpan

O Studio usa um tipo de dados interno chamado tabela de dados para transmitir dados entre módulos. Você pode converter explicitamente os dados no formato de tabela de dados usando o módulo Converter em conjunto de dados.

Qualquer módulo que aceite formatos que não sejam a tabela de dados converterá os dados para a tabela de dados silenciosamente antes de passá-los para o próximo módulo.

Se necessário, você poderá converter o formato de tabela de dados novamente no formato CSV, TSV, ARFF ou SVMLight usando outros módulos de conversão. Veja a seção Conversões de Formato de Dados da paleta de módulos para ver os módulos que executam essas funções.

Capacidades de dados

Os módulos do Machine Learning Studio (clássico) dão suporte a conjuntos de dados com até 10 GB de dados numéricos densos para casos de uso comuns. Se um módulo receber mais de uma entrada, o valor de 10 GB será o total dos tamanhos das entradas. Você pode conjuntos de dados de exemplo maiores usando consultas do Hive ou de Banco de Dados SQL do Azure ou pode usar o Learning por meio contagens de pré-processamento antes de importar os dados.

Os seguintes tipos de dados podem ser expandidos para conjuntos de dados maiores durante a normalização de recursos e são limitados a menos de 10 GB:

- Esparsos

- Categóricos

- Cadeias de caracteres

- Dados binários

Os seguintes módulos são limitados a conjuntos de dados com menos de 10 GB:

- Módulos de recomendação

- Módulo SMOTE (Técnica de Sobreamostragem Minoritária Sintética)

- Módulos de script: R, Python, SQL

- Módulos em que o tamanho dos dados de saída pode ser maior que o tamanho dos dados de entrada, como Join ou Feature Hashing

- Validação cruzada, Hiperparâmetros de Modelo de Ajuste, Regressão Ordinal e Classes Múltiplas, um versos todos, quando o número de iterações é muito grande

Para conjuntos de dados com mais do que alguns GB, carregue os dados no Armazenamento do Azure ou no Banco de Dados SQL do Azure ou use o Azure HDInsight, em vez de carregar diretamente de um arquivo local.

Você pode encontrar informações sobre dados de imagem na referência de módulo Importar imagens.

Importação de um arquivo local

Carregue um arquivo de dados do disco rígido para usá-lo como dados de treinamento no Studio (clássico). Ao importar um arquivo de dados, você cria um módulo de conjunto de dados pronto para uso nos experimentos em seu workspace.

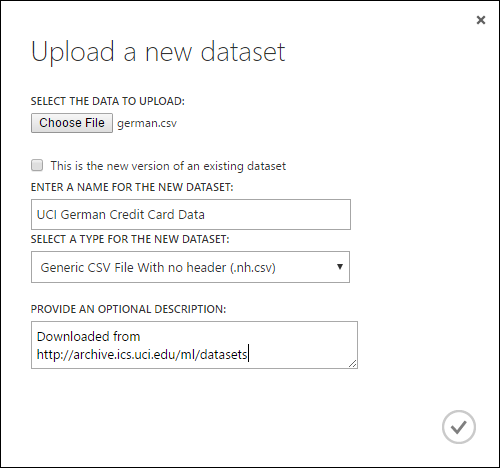

Para importar dados de um disco rígido local, faça o seguinte:

- No Studio (clássico), clique em +NOVO na parte inferior da janela.

- Selecione CONJUNTO DE DADOS e DO ARQUIVO LOCAL.

- Na caixa de diálogo Carregar um novo conjunto de dados, procure o arquivo que deseja carregar.

- Digite um nome, identifique o tipo de dados e, opcionalmente, insira uma descrição. Uma descrição é recomendada – ela permite registrar características sobre os dados que você deseja lembrar ao usar os dados no futuro.

- A caixa de seleção Esta é a nova versão de um conjunto de dados existente permite que você atualize um conjunto de dados existente com novos dados. Para fazer isso, clique nessa caixa de seleção e insira o nome de um conjunto de dados existente.

O tempo de upload depende do tamanho dos dados e da velocidade da conexão com o serviço. Se você souber que o arquivo levará muito tempo para ser carregado, você poderá realizar outras tarefas no Studio (clássico) enquanto aguarda. No entanto, o fechamento do navegador antes da conclusão do upload de dados causará uma falha no upload.

Uma vez carregados, seus dados são armazenados em um módulo de conjunto de dados e ficam disponíveis para qualquer experimento em seu workspace.

Quando estiver editando um experimento, você poderá encontrar os conjuntos de dados carregados na lista Meus Conjuntos de Dados da lista Conjuntos de Dados Salvos na paleta de módulos. É possível arrastar e soltar o conjunto de dados na tela de teste quando você desejar usá-lo para outras análises e aprendizado de máquina.

Importação de fontes de dados online

Usando o módulo Importar Dados módulo, o experimento poderá importar dados de várias fontes de dados online durante a execução.

Observação

Este artigo fornece informações gerais sobre o módulo Importar Dados. Para obter informações mais detalhadas sobre os tipos de dados que você pode acessar, formatos, parâmetros e respostas a perguntas comuns, consulte o tópico de referência do módulo Importar Dados.

Usando o módulo Importar Dados, você poderá acessar dados de uma das várias fontes de dados online durante a execução do experimento:

- Uma URL da Web usando HTTP

- Hadoop usando HiveQL

- Armazenamento do blob do Azure

- Tabela do Azure

- Banco de Dados SQL do Azure. Instância Gerenciada de SQL ou SQL Server

- Um provedor de feed de dados, atualmente OData

- Azure Cosmos DB

Como esses dados de treinamento são acessados durante a execução do experimento, eles só ficam disponíveis nesse experimento. Por comparação, os dados que foram armazenados em um módulo do conjunto de dados ficam disponíveis para todos os experimentos em seu workspace.

Para acessar fontes de dados online no experimento do Studio (clássico), adicione o módulo Importar dados ao experimento. Em seguida, selecione Iniciar Assistente para Importação de Dados em Propriedades para obter instruções guiadas passo a passo para selecionar e configurar a fonte de dados. Como alternativa, você pode selecionar Fonte de dados manualmente em Propriedades e fornecer os parâmetros necessários para acessar os dados.

As fontes de dados online com suporte são detalhadas na tabela a seguir. Esta tabela também resume os formatos de arquivo e os parâmetros com suporte usados para acessar os dados.

Importante

Atualmente, os módulos Importar Dados e Exportar Dados podem ler e gravar dados somente no armazenamento do Azure criado usando o modelo de implantação Clássico. Em outras palavras, o novo tipo de conta de Armazenamento de Blobs do Azure que oferece uma camada de acesso de armazenamento dinâmica ou uma camada de acesso de armazenamento estática ainda não é compatível.

De modo geral, as contas de armazenamento do Azure que você possa ter criado antes de essa opção se tornar disponível não deverão ser afetadas. Se precisar criar uma nova conta, escolha Clássico para o modelo de Implantação, ou use o Gerenciador de Recursos e selecione Objetivo Geral, em vez de Armazenamento de Blobs, para Tipo de conta.

Para saber mais, confira Armazenamento de Blobs do Azure: camadas de armazenamento dinâmica e estática.

Fontes de dados online com suporte

O módulo Importar Dados do Estúdio do Machine Learning (clássico) é compatível com as seguintes fontes de dados:

| fonte de dados | Descrição | Parâmetros |

|---|---|---|

| URL da Web via HTTP | Lê dados nos formatos de valores separados por vírgula (CSV), de valores separados por tabulação (TSV), de arquivo de relação de atributo (ARFF) e de Máquinas de Vetores de Suporte (SVM-light), de qualquer URL da Web que use HTTP | URL: especifica o nome completo do arquivo, incluindo a URL do site e o nome do arquivo com qualquer extensão. Formato de dados: especifica um dos formatos de dados com suporte: CSV, TSV, ARFF ou SVM-light. Se os dados tiverem uma linha de cabeçalho, serão usados para atribuir nomes de coluna. |

| Hadoop/HDFS | Lê dados do armazenamento distribuído no Hadoop. Você especifica os dados desejados usando o HiveQL, uma linguagem de consulta do tipo SQL. O HiveQL também pode ser usado para agregar dados e executar a filtragem deles antes de serem adicionados ao Studio (clássico). | Consulta de banco de dados do Hive: especifica a consulta de Hive usada para gerar os dados. URI do servidor HCatalog : especifica o nome do cluster usando o formato <nome do cluster>.azurehdinsight.net. Nome de conta de usuário do Hadoop: especifica o nome de conta de usuário do Hadoop usada para provisionar o cluster. Senha de conta de usuário do Hadoop : especifica as credenciais usadas para provisionar o cluster. Para obter mais informações, veja Criar clusters Hadoop no HDInsight. Local dos dados de saída: especifica se os dados são armazenados em HDFS (sistema de arquivos distribuído do Hadoop) ou no Azure.

Se você armazenar os dados de saída no Azure, deverá especificar o nome da conta de armazenamento do Azure, a chave de acesso de Armazenamento e o nome do contêiner do Armazenamento. |

| Banco de dados SQL | Lê os dados armazenados no Banco de Dados SQL do Azure, na Instância Gerenciada de SQL ou em um banco de dados do SQL Server em execução em uma máquina virtual do Azure. | Nome do servidor de banco de dados: especifica o nome do servidor no qual o banco de dados está em execução.

No caso de um SQL Server hospedado em uma máquina virtual do Azure, digite tcp:<Nome DNS da Máquina Virtual>, 1433 Nome do banco de dados : especifica o nome do banco de dados no servidor. Nome de conta de usuário do servidor: especifica um nome de usuário de uma conta com permissões de acesso para o banco de dados. Senha de conta de usuário do servidor: especifica a senha da conta de usuário. Consulta de banco de dados: insira uma instrução SQL que descreve os dados que você deseja ler. |

| Banco de dados SQL local | Lê dados armazenados em um banco de dados SQL. | Gateway de dados: especifica o nome do Gateway de Gerenciamento de Dados instalado em um computador em que ele pode acessar o banco de dados do SQL Server. Para saber mais sobre como configurar o gateway, veja Executar análises avançadas com o Estúdio do Machine Learning (clássico) usando os dados de um SQL Server. Nome do servidor de banco de dados: especifica o nome do servidor no qual o banco de dados está em execução. Nome do banco de dados : especifica o nome do banco de dados no servidor. Nome de conta de usuário do servidor: especifica um nome de usuário de uma conta com permissões de acesso para o banco de dados. Nome de usuário e senha: clique em Inserir valores para inserir suas credenciais de banco de dados. Você pode usar a Autenticação Integrada do Windows ou a Autenticação do SQL Server dependendo de como o SQL Server estiver configurado. Consulta de banco de dados: insira uma instrução SQL que descreve os dados que você deseja ler. |

| tabela do Azure | Lê os dados do serviço Tabela no Armazenamento do Azure. Caso você leia grandes quantidades de dados com pouca frequência, use o serviço Tabela do Azure. Ele fornece uma solução de armazenamento flexível, não relacional (NoSQL), massivamente escalonável, barata e de alta disponibilidade. |

As opções em Importar Dados variam de acordo com o que você está acessando: informações públicas ou uma conta de armazenamento privada que exija credenciais de logon. Isso é determinado pelo Tipo de Autenticação, que pode ter um valor "PublicOrSAS" ou "Account", cada um deles com seu próprio conjunto de parâmetros. URI pública ou de SAS (Assinatura de Acesso Compartilhado): os parâmetros são:

Especifica as linhas onde procurar os nomes de propriedade: os valores são TopN para verificar o número especificado de linhas ou ScanAll para obter todas as linhas na tabela. Se os dados forem homogêneos e previsíveis, é recomendável que você selecione TopN e insira um número para N. No caso de tabelas grandes, isso pode resultar em tempos de leitura mais rápidos. Se os dados são estruturados com conjuntos de propriedades que variam de acordo com a profundidade e a posição da tabela, escolha a opção ScanAll para examinar todas as linhas. Isso garante a integridade da propriedade resultante e da conversão dos metadados.

Chave de conta: especifica a chave de armazenamento associada à conta. Nome da tabela : especifica o nome da tabela que contém os dados a serem lidos. Linhas onde procurar os nomes de propriedade: os valores são TopN para verificar o número especificado de linhas ou ScanAll para obter todas as linhas na tabela. Se os dados forem homogêneos e previsíveis, recomendamos que você selecione TopN e insira um número para N. No caso de tabelas grandes, isso pode resultar em tempos de leitura mais rápidos. Se os dados são estruturados com conjuntos de propriedades que variam de acordo com a profundidade e a posição da tabela, escolha a opção ScanAll para examinar todas as linhas. Isso garante a integridade da propriedade resultante e da conversão dos metadados. |

| Armazenamento do Blobs do Azure | Lê os dados armazenados no serviço Blob no Armazenamento do Azure, incluindo imagens, texto não estruturado ou dados binários. Você pode usar o serviço Blob para expor dados publicamente ou para armazenar dados de aplicativo de forma privada. Você pode acessar seus dados de qualquer lugar usando as conexões HTTP ou HTTPS. |

As opções no módulo Import Data (Importar Dados) variam de acordo com o que você está acessando: informações públicas ou uma conta de armazenamento privada que exija credenciais de logon. Isso é determinado pelo Tipo de Autenticação, que pode ter um valor "PublicOrSAS" ou "Conta". URI pública ou de SAS (Assinatura de Acesso Compartilhado): os parâmetros são:

Formato de arquivo: especifica o formato dos dados no serviço Blob. Os formatos com suporte são CSV, TSV e ARFF.

Chave de conta: especifica a chave de armazenamento associada à conta. Caminho para o contêiner, diretório ou blob : especifica o nome do blob que contém os dados a serem lidos. Formato de arquivo de blob: especifica o formato dos dados no serviço Blob. Os formatos de dados com suporte são CSV, TSV, ARFF, CSV com uma codificação especificada e o Excel.

Você pode usar a opção do Excel para ler dados de pastas de trabalho do Excel. Na opção formato de dados do Excel, indique se os dados estão em um intervalo da planilha do Excel ou em uma tabela do Excel. Na opção planilha do Excel ou tabela inserida, especifique o nome da planilha ou da tabela que você deseja ler. |

| Provedor de feed de dados | Lê dados de um provedor de feeds com suporte. Atualmente, somente o formato OData (Open Data Protocol) tem suporte. | Tipo de conteúdo de dados: especifica o formato OData. URL de origem: especifica a URL completa para o feed de dados. Por exemplo, a URL a seguir lê a partir do banco de dados de exemplo Northwind: https://services.odata.org/northwind/northwind.svc/ |

Importação de outro experimento

Haverá momentos em que você desejará usar o resultado intermediário de um teste como parte de outro teste. Para fazer isso, salve o módulo como um conjunto de dados:

- Clique na saída do módulo que você deseja salvar como um conjunto de dados.

- Clique em Salvar como Conjunto de Dados.

- Quando solicitado, insira um nome e uma descrição que permitiriam identificar o conjunto de dados facilmente.

- Clique na marca de seleção OK .

Quando o salvamento for concluído, o conjunto de dados ficará disponível para uso em qualquer experimento do seu workspace. Você pode encontrá-lo na lista Conjuntos de Dados Salvos na paleta de módulos.