Transforme dados de uma fonte SAP ODP usando o conector SAP CDC no Azure Data Factory ou no Azure Synapse Analytics

APLICA-SE A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Gorjeta

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange tudo, desde a movimentação de dados até ciência de dados, análises em tempo real, business intelligence e relatórios. Saiba como iniciar uma nova avaliação gratuitamente!

Este artigo descreve como usar o fluxo de dados de mapeamento para transformar dados de uma fonte SAP ODP usando o conector SAP CDC. Para saber mais, leia o artigo introdutório do Azure Data Factory ou do Azure Synapse Analytics. Para obter uma introdução à transformação de dados com o Azure Data Factory e a análise do Azure Synapse, leia o fluxo de dados de mapeamento ou o tutorial sobre o mapeamento de fluxo de dados.

Gorjeta

Para saber o suporte geral no cenário de integração de dados SAP, consulte o whitepaper Integração de dados SAP usando o Azure Data Factory com introdução detalhada sobre cada conector, comparação e orientação SAP.

Capacidades suportadas

Este conector SAP CDC é suportado para os seguintes recursos:

| Capacidades suportadas | IR |

|---|---|

| Mapeando o fluxo de dados (fonte/-) | ①, ② |

(1) Tempo de execução de integração do Azure (2) Tempo de execução de integração auto-hospedado

Este conector SAP CDC usa a estrutura SAP ODP para extrair dados de sistemas de origem SAP. Para obter uma introdução à arquitetura da solução, leia Introdução e arquitetura para SAP change data capture (CDC) em nosso centro de conhecimento SAP.

A estrutura SAP ODP está contida em todos os sistemas baseados no SAP NetWeaver atualizados, incluindo SAP ECC, SAP S/4HANA, SAP BW, SAP BW/4HANA, SAP LT Replication Server (SLT). Para obter os pré-requisitos e as versões mínimas necessárias, consulte Pré-requisitos e configuração.

O conector SAP CDC suporta autenticação básica ou Secure Network Communications (SNC), se o SNC estiver configurado.

Limitações atuais

Aqui estão as limitações atuais do conector SAP CDC no Data Factory:

- Não é possível redefinir ou excluir assinaturas ODQ no Data Factory (use a transação ODQMON no sistema SAP conectado para essa finalidade).

- Não é possível usar hierarquias SAP com a solução.

Pré-requisitos

Para usar esse conector SAP CDC, consulte Pré-requisitos e configuração para o conector SAP CDC.

Começar

Para executar a atividade Copiar com um pipeline, você pode usar uma das seguintes ferramentas ou SDKs:

- A ferramenta Copiar dados

- O portal do Azure

- O SDK do .NET

- O SDK do Python

- Azure PowerShell

- A API REST

- O modelo do Azure Resource Manager

Criar um serviço vinculado para o conector SAP CDC usando a interface do usuário

Siga as etapas descritas em Preparar o serviço vinculado SAP CDC para criar um serviço vinculado para o conector SAP CDC na interface do usuário do portal do Azure.

Propriedades do conjunto de dados

Para preparar um conjunto de dados SAP CDC, siga Preparar o conjunto de dados de origem do SAP CDC.

Transforme dados com o conector SAP CDC

O feed de alteração bruto do SAP ODP é difícil de interpretar e atualizá-lo corretamente para um coletor pode ser um desafio. Por exemplo, os atributos técnicos associados a cada linha (como ODQ_CHANGEMODE) devem ser entendidos para aplicar as alterações ao coletor corretamente. Além disso, uma extração de dados de alteração do ODP pode conter várias alterações na mesma chave (por exemplo, a mesma ordem de venda). Portanto, é importante respeitar a ordem das mudanças e, ao mesmo tempo, otimizar o desempenho processando as alterações em paralelo. Além disso, gerenciar um feed de captura de dados de alteração também requer manter o controle do estado, por exemplo, para fornecer mecanismos internos para recuperação de erros. Os fluxos de dados de mapeamento do Azure data factory cuidam de todos esses aspetos. Portanto, a conectividade SAP CDC faz parte da experiência de fluxo de dados de mapeamento. Assim, os usuários podem se concentrar na lógica de transformação necessária sem ter que se preocupar com os detalhes técnicos da extração de dados.

Para começar, crie um pipeline com um fluxo de dados de mapeamento.

Em seguida, especifique um serviço vinculado de preparo e uma pasta de preparo no Azure Data Lake Gen2, que serve como um armazenamento intermediário para dados extraídos do SAP.

Nota

- O serviço vinculado de preparo não pode usar um tempo de execução de integração auto-hospedado.

- A pasta de preparo deve ser considerada um armazenamento interno do conector SAP CDC. Para otimizações adicionais do tempo de execução do SAP CDC, os detalhes da implementação, como o formato de arquivo usado para os dados de preparação, podem mudar. Portanto, recomendamos não usar a pasta de preparo para outros fins, por exemplo, como fonte para outras atividades de cópia ou mapeamento de fluxos de dados.

A chave de ponto de verificação é usada pelo tempo de execução do SAP CDC para armazenar informações de status sobre o processo de captura de dados de alteração. Isso, por exemplo, permite que os fluxos de dados de mapeamento do SAP CDC se recuperem automaticamente de situações de erro ou saibam se um processo de captura de dados de alteração para um determinado fluxo de dados já foi estabelecido. Portanto, é importante usar uma chave de ponto de verificação exclusiva para cada fonte. Caso contrário, as informações de status de uma fonte serão substituídas por outra fonte.

Nota

- Para evitar conflitos, uma id exclusiva é gerada como Chave de Ponto de Verificação por padrão.

- Ao usar parâmetros para aproveitar o mesmo fluxo de dados para várias fontes, certifique-se de parametrizar a chave de ponto de verificação com valores exclusivos por fonte.

- A propriedade Checkpoint Key não será mostrada se o modo Run na origem do SAP CDC estiver definido como Full em cada execução (consulte a próxima seção), porque neste caso nenhum processo de captura de dados de alteração é estabelecido.

Mapeando propriedades de fluxo de dados

Para criar um fluxo de dados de mapeamento usando o conector SAP CDC como origem, conclua as seguintes etapas:

No ADF Studio, vá para a seção Fluxos de dados do hub Autor, selecione o botão ... para abrir o menu Ações de fluxo de dados e selecione o item Novo fluxo de dados. Ative o modo de depuração usando o botão de depuração de fluxo de dados na barra superior da tela de fluxo de dados.

No editor de fluxo de dados de mapeamento, selecione Adicionar fonte.

Na guia Configurações de origem, selecione um conjunto de dados SAP CDC preparado ou selecione o botão Novo para criar um novo. Como alternativa, você também pode selecionar Inline na propriedade Source type e continuar sem definir um conjunto de dados explícito.

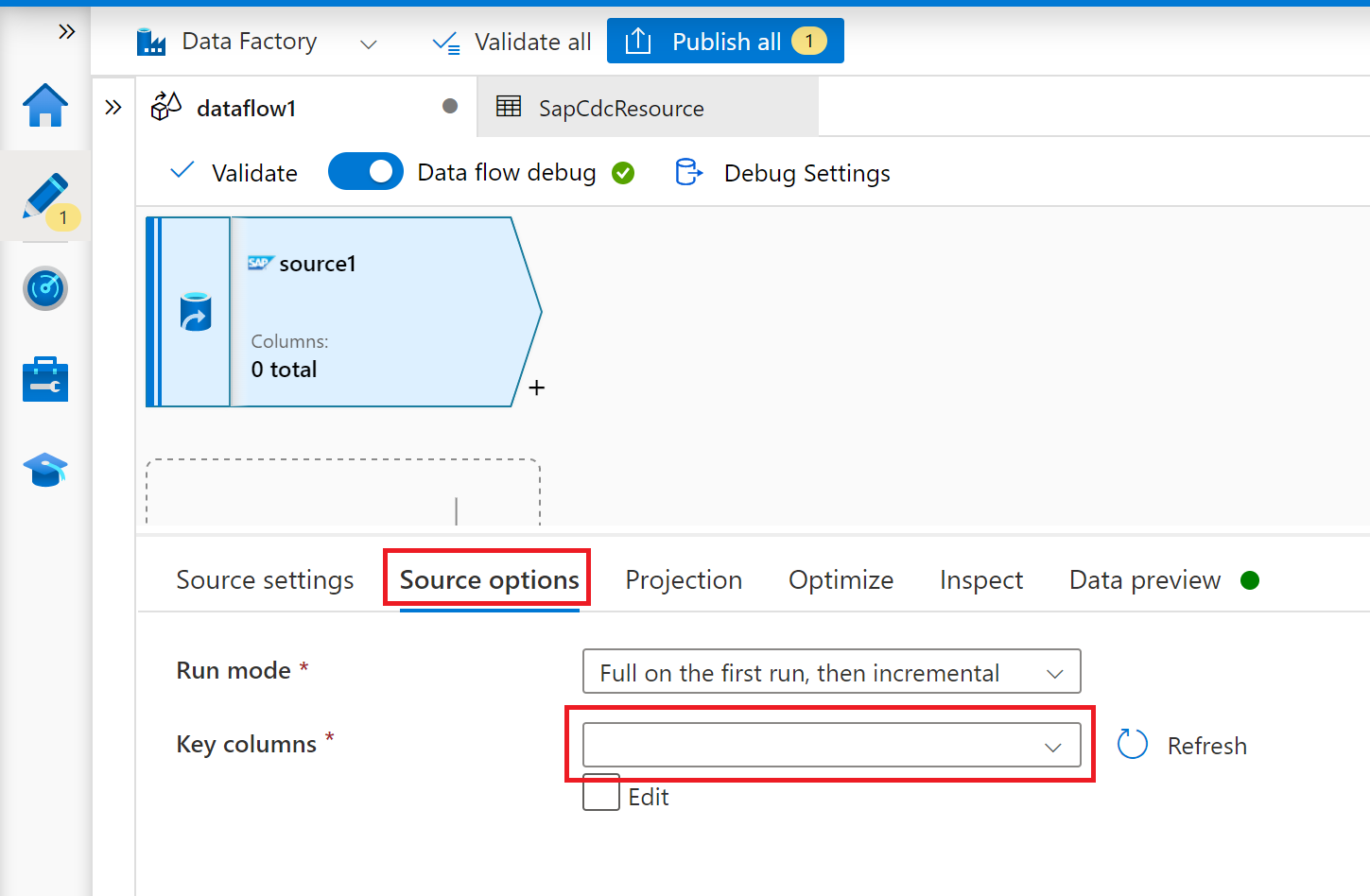

Na guia Opções de origem, selecione a opção Completo em cada execução se quiser carregar instantâneos completos em cada execução do fluxo de dados de mapeamento. Selecione Completo na primeira execução e, em seguida, incremental se quiser assinar um feed de alterações do sistema de origem SAP, incluindo um instantâneo de dados completo inicial. Nesse caso, a primeira execução do pipeline executa uma inicialização delta, o que significa que cria uma assinatura delta ODP no sistema de origem e retorna um instantâneo de dados completo atual. As execuções de pipeline subsequentes retornam apenas alterações incrementais desde a execução anterior. A opção alterações incrementais cria apenas uma assinatura delta ODP sem retornar um instantâneo de dados completo inicial na primeira execução. Novamente, as execuções subsequentes retornam alterações incrementais apenas desde a execução anterior. Ambas as opções de carregamento incremental exigem especificar as chaves do objeto de origem ODP na propriedade Key columns .

Para as guias Projeção, Otimizar e Inspecionar, siga o fluxo de dados de mapeamento.

Otimizando o desempenho de cargas completas ou iniciais com particionamento de origem

Se o modo Executar estiver definido como Completo em cada execução ou Completo na primeira execução, então incremental, a guia Otimizar oferecerá um tipo de seleção e particionamento chamado Origem. Essa opção permite especificar várias condições de partição (ou seja, filtro) para dividir um grande conjunto de dados de origem em várias partes menores. Para cada partição, o conector SAP CDC aciona um processo de extração separado no sistema de origem SAP.

Se as partições forem de tamanho igual, o particionamento de origem pode aumentar linearmente a taxa de transferência da extração de dados. Para obter essas melhorias de desempenho, são necessários recursos suficientes no sistema de origem SAP, na máquina virtual que hospeda o tempo de execução de integração auto-hospedado e no tempo de execução de integração do Azure.