Эта эталонная архитектура реализует шаблон центральной сети с компонентами инфраструктуры, управляемыми клиентом. Сведения о решении инфраструктуры, управляемом корпорацией Майкрософт, см. в статье "Топология центральной сети" с помощью Azure Виртуальная глобальная сеть.

Архитектура

Скачайте файл Visio для этой архитектуры.

Рабочий процесс

В этой конфигурации сети концентратора используются следующие архитектурные элементы:

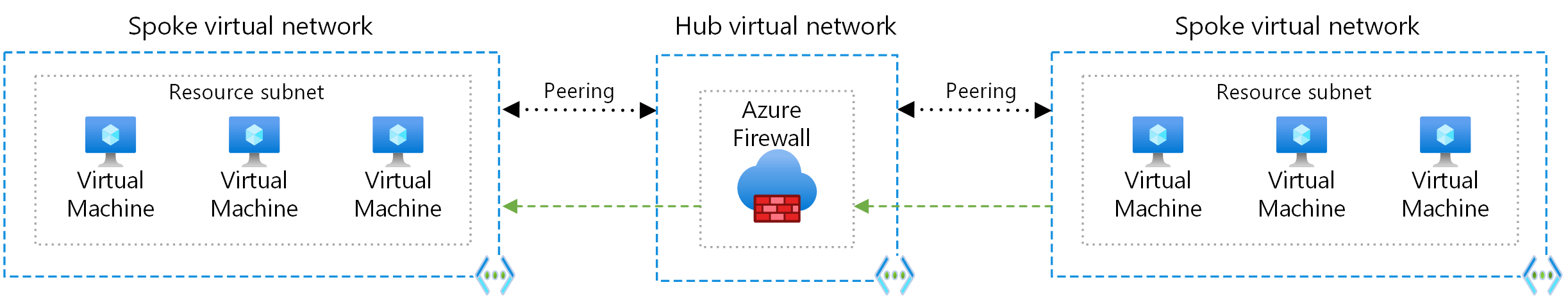

Виртуальная сеть концентратора. Виртуальная сеть концентратора размещает общие службы Azure. Рабочие нагрузки, размещенные в периферийных виртуальных сетях, могут использовать эти службы. Виртуальная сеть концентратора — это центральная точка подключения для локальных сетей.

Периферийные виртуальные сети. Периферийные виртуальные сети изолированы и управляют рабочими нагрузками отдельно в каждой периферийной сети. Каждая рабочая нагрузка может включать несколько уровней с несколькими подсетями, подключенными через подсистемы балансировки нагрузки Azure. Периферийные компоненты могут существовать в разных подписках и представлять различные среды, такие как рабочая и непроизводственная среда.

Подключение к виртуальной сети. Эта архитектура подключает виртуальные сети с помощью пиринговых подключений или подключенных групп. Пиринговые подключения и подключенные группы являются не транзитивными, низкой задержкой между виртуальными сетями. Пиринговые или подключенные виртуальные сети могут обмениваться трафиком через магистраль Azure без необходимости маршрутизатора. Диспетчер виртуальная сеть Azure создает и управляет группами сети и их подключениями.

Узел Бастиона Azure. Бастион Azure обеспечивает безопасное подключение от портал Azure к виртуальным машинам с помощью браузера. Узел Бастиона Azure, развернутый в виртуальной сети Azure, может получить доступ к виртуальным машинам в этой виртуальной сети или в подключенных виртуальных сетях.

Брандмауэр Azure. Экземпляр управляемого брандмауэра Брандмауэр Azure существует в собственной подсети.

Шлюз Azure VPN-шлюз или Azure ExpressRoute. Шлюз виртуальной сети позволяет виртуальной сети подключаться к устройству виртуальной частной сети (VPN) или каналу Azure ExpressRoute. Шлюз обеспечивает подключение к локальной сети. Дополнительные сведения см. в статье Подключение локальную сеть в виртуальную сеть Microsoft Azure и расширение локальной сети с помощью VPN.

VPN-устройство. VPN-устройство или служба обеспечивают внешнее подключение к локальной сети. VPN-устройство может быть аппаратным устройством или программным решением, таким как служба маршрутизации и удаленного доступа (RRAS) в Windows Server. Дополнительные сведения см. в руководствах по настройке vpn-устройств и проверенных VPN-устройств.

Компоненты

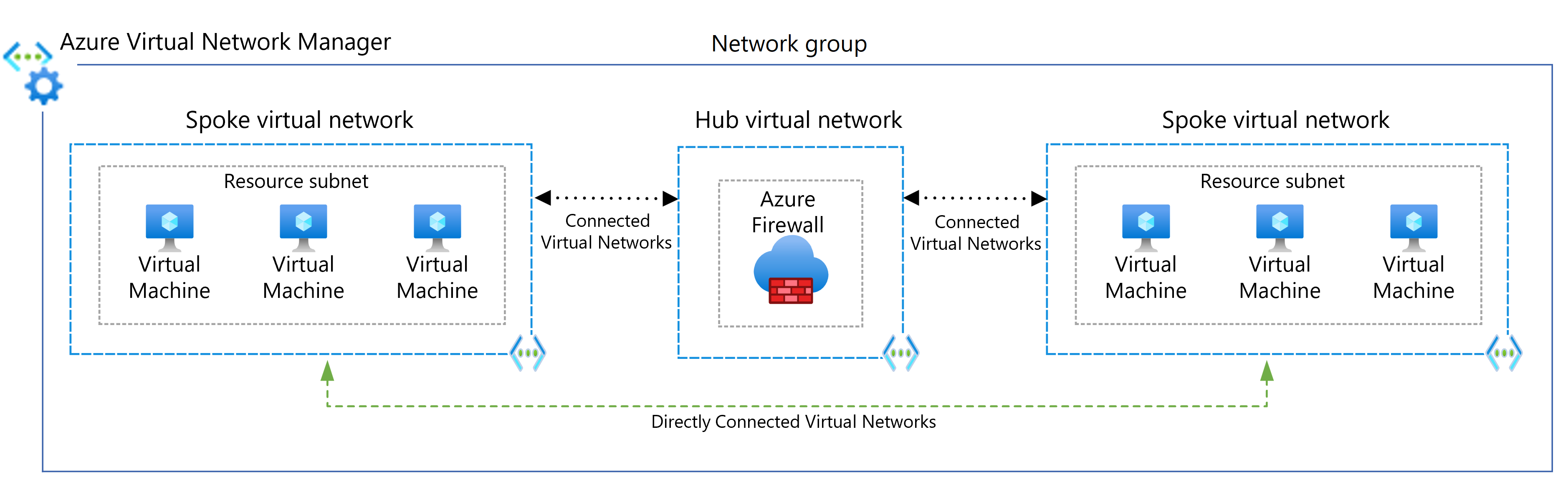

виртуальная сеть Manager — это служба управления, которая помогает группировать, настраивать, развертывать и управлять виртуальными сетями в масштабе между подписками, регионами и клиентами Azure. С помощью диспетчера виртуальная сеть можно определить группы виртуальных сетей для идентификации и логического сегментирования виртуальных сетей. Вы можете определить и применить конфигурации подключения и безопасности во всех виртуальных сетях в группе сети одновременно.

Виртуальная сеть Azure — это фундаментальный стандартный блок для частных сетей в Azure. виртуальная сеть позволяет многим ресурсам Azure, таким как виртуальные машины Azure, безопасно взаимодействовать друг с другом, между локальными сетями и Интернетом.

Бастион Azure — это полностью управляемая служба, которая обеспечивает более безопасный и простой протокол удаленного рабочего стола (RDP) и протокол SSH для виртуальных машин без предоставления общедоступных IP-адресов.

Брандмауэр Azure — это управляемая облачная служба безопасности сети, которая защищает виртуальная сеть ресурсы. Эта служба брандмауэра с отслеживанием состояния имеет встроенную высокий уровень доступности и неограниченное масштабируемость облака, чтобы помочь вам создавать, применять и применять приложения журнала и политики сетевого подключения между подписками и виртуальными сетями.

VPN-шлюз — это определенный тип шлюза виртуальной сети, который отправляет зашифрованный трафик между виртуальной сетью и локальным расположением через общедоступный Интернет. Его также можно использовать для обмена зашифрованным трафиком между виртуальными сетями Azure через сеть Майкрософт.

Azure Monitor может собирать, анализировать и действовать с данными телеметрии из локальных сред, включая Azure и локальную среду. Azure Monitor помогает повысить производительность и доступность приложений и заранее определить проблемы в секундах.

Подробности сценария

Эта эталонная архитектура реализует шаблон сети концентратора, где виртуальная сеть концентратора выступает в качестве центральной точки подключения ко многим периферийным виртуальным сетям. Периферийные виртуальные сети подключаются к концентратору и могут использоваться для изоляции рабочих нагрузок. Вы также можете включить междомовые сценарии с помощью концентратора для подключения к локальным сетям.

Эта архитектура описывает шаблон сети с компонентами инфраструктуры, управляемыми клиентом. Сведения о решении инфраструктуры, управляемом корпорацией Майкрософт, см. в статье "Топология центральной сети" с помощью Azure Виртуальная глобальная сеть.

Преимущества использования центральной и периферийной конфигурации включают:

- Экономия денежных средств

- Преодоление ограничений подписки

- Изоляция рабочих нагрузок

Дополнительные сведения см. в статье "Топология сети с концентраторами и периферийными устройствами".

Потенциальные варианты использования

Типичные варианты использования для центральной и периферийной архитектуры включают рабочие нагрузки, которые:

- Существует несколько сред, требующих общих служб. Например, рабочая нагрузка может иметь среды разработки, тестирования и рабочей среды. Общие службы могут включать DNS-идентификаторы, протокол сетевого времени (NTP) или службы домен Active Directory (AD DS). Общие службы размещаются в центральной виртуальной сети, и каждая среда развертывается на разных периферийных устройствах для обеспечения изоляции.

- Не требуется подключение друг к другу, но требуется доступ к общим службам.

- Требует централизованного контроля над безопасностью, например брандмауэра периметра (также известного как DMZ) в концентраторе с разделением управления рабочими нагрузками в каждом периферийном режиме.

- Требуется централизованное управление подключением, например выборочное подключение или изоляция между периферийными узлами определенных сред или рабочих нагрузок.

Рекомендации

Следующие рекомендации применяются к большинству сценариев. Следуйте этим рекомендациям, если у вас нет конкретных требований, которые переопределяют их.

Группы ресурсов, подписки и регионы

В этом примере решения используется одна группа ресурсов Azure. Вы также можете реализовать концентратор и каждый из них в разных группах ресурсов и подписках.

При одноранговых виртуальных сетях в разных подписках можно связать подписки с теми же или разными клиентами Microsoft Entra. Эта гибкость обеспечивает децентрализованное управление каждой рабочей нагрузкой при сохранении общих служб в центре. См. статью "Создание пиринга между виртуальными сетями" — Resource Manager, различными подписками и клиентами Microsoft Entra.

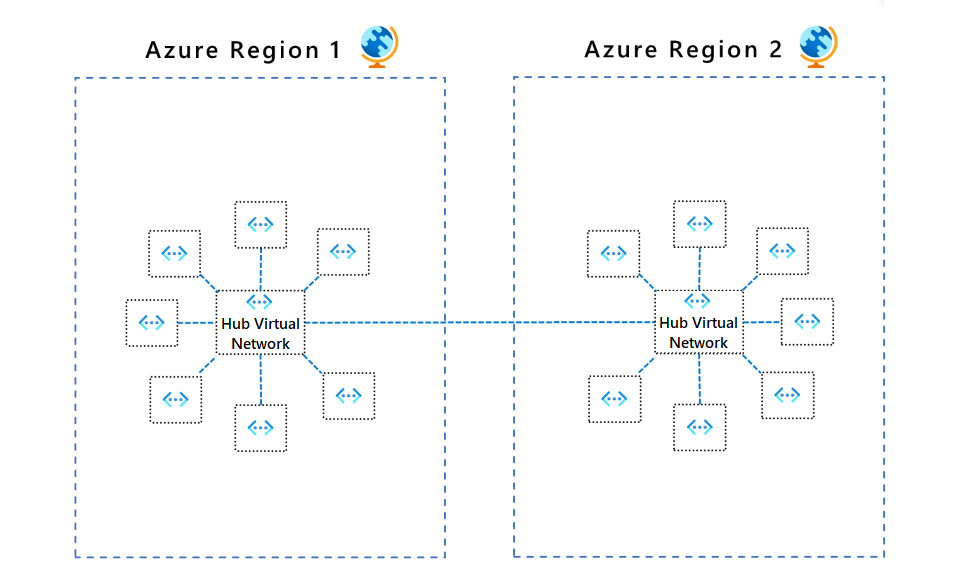

Как правило, лучше всего иметь по крайней мере один концентратор в каждом регионе. Эта конфигурация помогает избежать единой точки сбоя, например, чтобы избежать влияния ресурсов региона A на сетевом уровне сбоем в регионе B.

Подсети виртуальной сети

Ниже приведены рекомендации по настройке подсетей в виртуальной сети.

Подсеть шлюза

Для шлюза виртуальной сети требуется эта подсеть. Кроме того, можно использовать топологию концентратора без шлюза, если не требуется подключение к локальной сети.

Создайте подсеть с именем GatewaySubnet с диапазоном адресов по крайней мере /27. Диапазон /27 адресов предоставляет подсети достаточно параметров конфигурации масштабируемости, чтобы предотвратить достижение ограничений размера шлюза в будущем. Дополнительные сведения о настройке шлюза см. в следующих статьях с данными об эталонных архитектурах в зависимости от типа подключения:

- Connect an on-premises network to Azure using ExpressRoute (Подключение локальной сети к Azure с помощью ExpressRoute).

- Connect an on-premises network to Azure using a VPN gateway (Подключение локальной сети к Azure с помощью VPN-шлюза).

Для обеспечения высокой доступности вы можете использовать ExpressRoute вместе с VPN для отработки отказа. Ознакомьтесь со статьей Connect an on-premises network to Azure using ExpressRoute with VPN failover (Подключение локальной сети к Azure с помощью ExpressRoute с отработкой отказа VPN).

AzureFirewallSubnet

Создайте подсеть с именем AzureFirewallSubnet с диапазоном адресов по крайней мере /26. Независимо от масштаба /26 диапазон адресов рекомендуется использовать и охватывает все ограничения будущих размеров. Эта подсеть не поддерживает группы безопасности сети (группы безопасности сети).

Брандмауэр Azure требуется эта подсеть. Если вы используете виртуальную (модуль) сети партнеров (NVA), следуйте его требованиям к сети.

Подключение к сети с периферийной связью

Пиринг между виртуальными сетями или подключенные группы — это не транзитивные связи между виртуальными сетями. Если вам нужны периферийные виртуальные сети для подключения друг к другу, добавьте пиринговое подключение между этими периферийными узлами или поместите их в одну и ту же группу сети.

Периферийные подключения через Брандмауэр Azure или NVA

Количество пирингов виртуальных сетей для каждой виртуальной сети ограничено. Если у вас есть много периферийных устройств, которые должны подключаться друг к другу, вы можете выйти из пиринговых подключений. Подключение группы также имеют ограничения. Дополнительные сведения см. в разделе "Ограничения сети" и ограничения Подключение групп.

В этом сценарии рекомендуется использовать определяемые пользователем маршруты (UDR) для принудительного отправки трафика в Брандмауэр Azure или другомУ NVA, который выступает в качестве маршрутизатора в центре. Это изменение позволяет периферийным устройствам подключаться друг к другу. Для поддержки этой конфигурации необходимо реализовать Брандмауэр Azure с включенной принудительной конфигурацией туннеля. Дополнительные сведения см. в статье Azure Firewall forced tunneling (Принудительное туннелирование в Брандмауэре Azure).

Топология в этом архитектурном дизайне упрощает потоки исходящего трафика. Хотя Брандмауэр Azure в основном предназначено для обеспечения безопасности исходящего трафика, это также может быть точка входящего трафика. Дополнительные сведения о маршрутизации входящего трафика концентратора NVA см. в разделе "Брандмауэр" и Шлюз приложений для виртуальных сетей.

Периферийные подключения к удаленным сетям через шлюз концентратора

Чтобы настроить периферийные серверы для взаимодействия с удаленными сетями через шлюз концентратора, можно использовать пиринги виртуальных сетей или подключенные сетевые группы.

Чтобы использовать пиринги виртуальных сетей, в настройке пиринга виртуальной сети:

- Настройте пиринговое подключение в концентраторе, чтобы разрешить транзит шлюза.

- Настройте пиринговое подключение в каждой периферийной сети для использования шлюза удаленной виртуальной сети.

- Настройте все подключения пиринга для разрешения перенаправленного трафика.

Дополнительные сведения см. в разделе "Создание пиринга виртуальной сети".

Чтобы использовать подключенные сетевые группы, выполните приведенные действия.

- В диспетчере виртуальная сеть создайте сетевую группу и добавьте виртуальные сети-члены.

- Создайте конфигурацию подключения концентратора и периферийной связи.

- Для групп сетей "Периферийные" выберите "Концентратор" в качестве шлюза.

Дополнительные сведения см. в статье "Создание концентратора и периферийной топологии с помощью Диспетчера виртуальная сеть Azure".

Периферийные сетевые коммуникации

Существует два основных способа разрешить обмен данными между периферийными виртуальными сетями:

- Обмен данными через NVA, например брандмауэр и маршрутизатор. Этот метод вызывает прыжок между двумя периферийными узлами.

- Обмен данными с помощью пиринга виртуальной сети или прямого подключения диспетчера виртуальная сеть между периферийными узлами. Этот подход не вызывает прыжка между двумя периферийными узлами и рекомендуется для минимизации задержки.

Обмен данными через NVA

Если требуется подключение между периферийными устройствами, рассмотрите возможность развертывания Брандмауэр Azure или другого NVA в концентраторе. Затем создайте маршруты для перенаправления трафика с периферийной связи на брандмауэр или NVA, который затем может перенаправляется на второй периферийный сервер. В этом случае необходимо настроить пиринговые соединения, чтобы разрешить перенаправленный трафик.

Вы также можете использовать VPN-шлюз для маршрутизации трафика между периферийными устройствами, хотя этот выбор влияет на задержку и пропускную способность. Дополнительные сведения о конфигурации см. в разделе "Настройка транзита VPN-шлюза для пиринга виртуальной сети".

Оцените службы, которые вы разделяете в концентраторе, чтобы обеспечить масштабирование концентратора для большего количества периферийных компонентов. Например, если центр предоставляет службы брандмауэра, рассмотрите ограничения пропускной способности решения брандмауэра при добавлении нескольких периферийных устройств. Некоторые из этих общих служб можно переместить на второй уровень центров.

Прямой обмен данными между периферийными сетями

Чтобы подключиться непосредственно между периферийными виртуальными сетями без обхода виртуальной сети концентратора, можно создать пиринговые подключения между периферийными узлами или включить прямое подключение для группы сети. Рекомендуется ограничить пиринг или прямое подключение к периферийным виртуальным сетям, которые являются частью одной среды и рабочей нагрузки.

При использовании диспетчера виртуальная сеть можно добавлять периферийные виртуальные сети в группы сети вручную или автоматически добавлять сети на основе заданных условий. Дополнительные сведения см. в разделе "Периферийные к периферийным" сетям.

На следующей схеме показано использование диспетчера виртуальная сеть для прямого подключения между периферийными узлами.

Рекомендации по управлению

Чтобы централизованно управлять подключением и средствами управления безопасностью, используйте диспетчер виртуальная сеть для создания новых топологий виртуальной сети и периферийных топологий виртуальной сети или подключения существующих топологий. Использование диспетчера виртуальная сеть гарантирует, что топологии центральной и периферийной сети подготовлены к крупномасштабному росту в нескольких подписках, группах управления и регионах.

Примеры сценариев использования диспетчера виртуальная сеть:

- Демократизация управления периферийными виртуальными сетями для групп, таких как бизнес-подразделения или группы приложений. Демократизация может привести к большому количеству требований к подключению виртуальной сети к виртуальной сети и правилам безопасности сети.

- Стандартизация нескольких архитектур реплика в нескольких регионах Azure для обеспечения глобального присутствия приложений.

Чтобы обеспечить единообразное подключение и правила безопасности сети, можно использовать группы сети для группировки виртуальных сетей в любой подписке, группе управления или регионе в одном клиенте Microsoft Entra. Вы можете автоматически или вручную подключить виртуальные сети к группам сети с помощью динамических или статических назначений членства.

Определяется возможность обнаружения виртуальных сетей, которыми управляет диспетчер виртуальная сеть с помощью областей. Эта функция обеспечивает гибкость для требуемого количества экземпляров диспетчера сети, что обеспечивает дальнейшую демократизацию управления для групп виртуальной сети.

Чтобы подключить периферийные виртуальные сети в одной группе сети друг к другу, используйте диспетчер виртуальная сеть для реализации пиринга виртуальной сети или прямого подключения. Используйте глобальный параметр сетки для расширения прямого подключения сетки к периферийным сетям в разных регионах. На следующей схеме показаны глобальные подключения к сетке между регионами.

Виртуальные сети можно связать в группе сети с базовым набором правил администратора безопасности. Правила администратора безопасности группы сети запрещают владельцам периферийных виртуальных сетей перезаписывать базовые правила безопасности, позволяя им независимо добавлять собственные наборы правил безопасности и группы безопасности сети. Пример использования правил администратора безопасности в концентраторах и периферийных топологиях см. в руководстве по созданию защищенного концентратора и периферийной сети.

Для упрощения управляемого развертывания сетевых групп, подключений и правил безопасности развертывания конфигурации виртуальная сеть Manager помогают безопасно освободить потенциально критические изменения конфигурации в центральных и периферийных средах. Дополнительные сведения см. в статье о развертывании конфигурации в Azure виртуальная сеть Manager.

Сведения о начале работы с диспетчером виртуальная сеть см. в статье "Создание концентратора и периферийной топологии с помощью диспетчера виртуальная сеть Azure".

Рекомендации

Эти рекомендации реализуют основные принципы платформы Azure Well-Architected Framework, которая является набором руководящих принципов, которые можно использовать для улучшения качества рабочей нагрузки. Дополнительные сведения см. в статье Microsoft Azure Well-Architected Framework.

Безопасность

Безопасность обеспечивает гарантии от преднамеренного нападения и злоупотребления ценными данными и системами. Дополнительные сведения см. в разделе "Общие сведения о компоненте безопасности".

Чтобы обеспечить базовый набор правил безопасности, обязательно свяжите правила администратора безопасности с виртуальными сетями в группах сети. Правила администратора безопасности имеют приоритет и оцениваются перед правилами NSG. Как и правила NSG, правила администратора безопасности поддерживают приоритетность, теги службы и протоколы L3-L4. Дополнительные сведения см. в разделе "Правила администратора безопасности" в диспетчере виртуальная сеть.

Используйте развертывания диспетчера виртуальная сеть для упрощения управляемого развертывания потенциально критических изменений в правилах безопасности группы сети.

Защита от атак DDoS Azure в сочетании с рекомендациями по проектированию приложений предоставляет расширенные функции защиты от атак DDoS. Необходимо включить защиту от атак DDOS Azure в любой виртуальной сети периметра.

Оптимизация затрат

Оптимизация затрат — это способы сокращения ненужных расходов и повышения эффективности работы. Дополнительные сведения см. в разделе Обзор критерия "Оптимизация затрат".

При развертывании и управлении сетями концентратора и периферийных сетей следует учитывать следующие факторы, связанные с затратами. Дополнительные сведения см. в разделе о ценах на виртуальную сеть.

затраты на Брандмауэр Azure

Эта архитектура развертывает экземпляр Брандмауэр Azure в центральной сети. Использование Брандмауэр Azure развертывания в качестве общего решения, используемого несколькими рабочими нагрузками, может значительно сэкономить облачные затраты по сравнению с другими NVA. Дополнительные сведения см. в Брандмауэр Azure виртуальных (модуль) сети.

Чтобы эффективно использовать все развернутые ресурсы, выберите нужный размер Брандмауэр Azure. Определите, какие функции вам нужны и какой уровень лучше всего подходит для текущего набора рабочих нагрузок. Дополнительные сведения о доступных номерах SKU Брандмауэр Azure см. в статье "Что такое Брандмауэр Azure?"

Затраты на частный IP-адрес

Частные IP-адреса можно использовать для маршрутизации трафика между одноранговых виртуальных сетей или между сетями в подключенных группах. Применяются следующие рекомендации по затратам:

- Трафик входящего трафика и исходящего трафика взимается в обоих концах одноранговых или подключенных сетей. Например, передача данных из виртуальной сети в зоне 1 в другую виртуальную сеть в зоне 2 вызывает скорость исходящей передачи для зоны 1 и скорость входящего трафика для зоны 2.

- Разные зоны имеют разные тарифы передачи.

Запланируйте IP-адресацию на основе требований пиринга и убедитесь, что адресное пространство не перекрывается между локальными расположениями и расположениями Azure.

Эффективность работы

Оперативное превосходство охватывает процессы операций, которые развертывают приложение и продолжают работать в рабочей среде. Дополнительные сведения см. в разделе "Общие сведения о принципах эффективности работы".

Используйте Azure Наблюдатель за сетями для мониторинга и устранения неполадок сетевых компонентов с помощью следующих средств:

- Аналитика трафика показывает системы в виртуальных сетях, которые создают большую часть трафика. Вы можете визуально определить узкие места перед тем, как они становятся проблемами.

- Сетевые Монитор производительности отслеживают сведения о каналах ExpressRoute.

- VPN-диагностика помогает устранять неполадки с VPN-подключениями типа "сеть — сеть", которые подключают приложения к локальным пользователям.

Кроме того, рекомендуется включить Брандмауэр Azure ведение журнала диагностики, чтобы получить более подробные сведения о запросах DNS и результатах разрешения или запрета в журналах.

Развертывание этого сценария

Это развертывание включает в себя одну виртуальную сеть концентратора и два подключенных периферийных устройства, а также развертывает экземпляр Брандмауэр Azure и узел Бастиона Azure. При необходимости развертывание может включать виртуальные машины в первую периферийную сеть и VPN-шлюз.

Вы можете выбрать между пирингом виртуальной сети или виртуальная сеть Диспетчер подключенных групп, чтобы создать сетевые подключения. Каждый метод имеет несколько вариантов развертывания.

Использование пиринга между виртуальными сетями

Выполните следующую команду, чтобы создать группу ресурсов с именем

hub-spokeв регионеeastusдля развертывания. Выберите " Попробовать использовать встроенную оболочку".az group create --name hub-spoke --location eastusВыполните следующую команду, чтобы скачать шаблон Bicep.

curl https://raw.githubusercontent.com/mspnp/samples/main/solutions/azure-hub-spoke/bicep/main.bicep > main.bicepВыполните следующую команду, чтобы развернуть конфигурацию концентратора и периферийной сети, пиринги виртуальной сети между концентратором и периферийными узлами и узлом Бастиона Azure. При появлении запроса введите имя пользователя и пароль. Это имя пользователя и пароль можно использовать для доступа к виртуальным машинам в периферийных сетях.

az deployment group create --resource-group hub-spoke --template-file main.bicep

Подробные сведения и дополнительные варианты развертывания см. в шаблонах Hub и Spoke ARM и Bicep, которые развертывают это решение.

Использование подключенных групп диспетчера виртуальная сеть

Выполните следующую команду, чтобы создать группу ресурсов для развертывания. Выберите " Попробовать использовать встроенную оболочку".

az group create --name hub-spoke --location eastusВыполните следующую команду, чтобы скачать шаблон Bicep.

curl https://raw.githubusercontent.com/mspnp/samples/main/solutions/azure-hub-spoke-connected-group/bicep/main.bicep > main.bicepВыполните следующие команды, чтобы скачать все необходимые модули в новый каталог.

mkdir modules curl https://raw.githubusercontent.com/mspnp/samples/main/solutions/azure-hub-spoke-connected-group/bicep/modules/avnm.bicep > modules/avnm.bicep curl https://raw.githubusercontent.com/mspnp/samples/main/solutions/azure-hub-spoke-connected-group/bicep/modules/avnmDeploymentScript.bicep > modules/avnmDeploymentScript.bicep curl https://raw.githubusercontent.com/mspnp/samples/main/solutions/azure-hub-spoke-connected-group/bicep/modules/hub.bicep > modules/hub.bicep curl https://raw.githubusercontent.com/mspnp/samples/main/solutions/azure-hub-spoke-connected-group/bicep/modules/spoke.bicep > modules/spoke.bicepВыполните следующую команду, чтобы развернуть сетевую конфигурацию концентратора и периферийной сети, подключения виртуальной сети между концентратором и периферийными узлами и узлом Бастиона. При появлении запроса введите имя пользователя и пароль. Это имя пользователя и пароль можно использовать для доступа к виртуальным машинам в периферийных сетях.

az deployment group create --resource-group hub-spoke --template-file main.bicep

Подробные сведения и дополнительные варианты развертывания см. в шаблонах Hub и Spoke ARM и Bicep, которые развертывают это решение.

Соавторы

Эта статья поддерживается корпорацией Майкрософт. Первоначально он был написан следующими участник.

Автор субъекта:

Аледжандра Паласиос | Старший инженер клиента

Другие участник:

- Мэтью Брэтчун | Инженер клиента

- Джей Ли | Старший менеджер по продуктам

- Telmo Sampaio | Диспетчер инженеров-служб

Чтобы просмотреть недоступные профили LinkedIn, войдите в LinkedIn.

Следующие шаги

Дополнительные сведения о защищенных виртуальных центрах и связанных политиках безопасности и маршрутизации, настроенных Брандмауэр Azure Manager, см. в статье "Что такое защищенный виртуальный концентратор?"

Концентратор в топологии сети с поддержкой концентратора является основным компонентом подписки на подключение в целевой зоне Azure. Дополнительные сведения о создании крупномасштабных сетей в Azure с маршрутизацией и безопасностью, управляемой клиентом или корпорацией Майкрософт, см. в статье "Определение топологии сети Azure".

Связанные ресурсы

Изучите следующие связанные архитектуры:

- Руководство по архитектуре брандмауэра Azure

- Брандмауэр и Шлюз приложений для виртуальных сетей

- Устранение неполадок гибридного VPN-подключения

- Сеть с периферийным подключением

- Гибридное подключение

- Подключение автономные серверы с помощью сетевого адаптера Azure

- Защита рабочих нагрузок и управление ими с помощью сегментации уровня сети

- Базовая архитектура для кластера Служба Azure Kubernetes (AKS)