Prestandamått för Azure NetApp Files för Linux

I den här artikeln beskrivs prestandamått som Azure NetApp Files levererar för Linux.

Utskalning av Linux

I det här avsnittet beskrivs prestandamått för Linux-arbetsbelastningens dataflöde och IOPS för arbetsbelastningar.

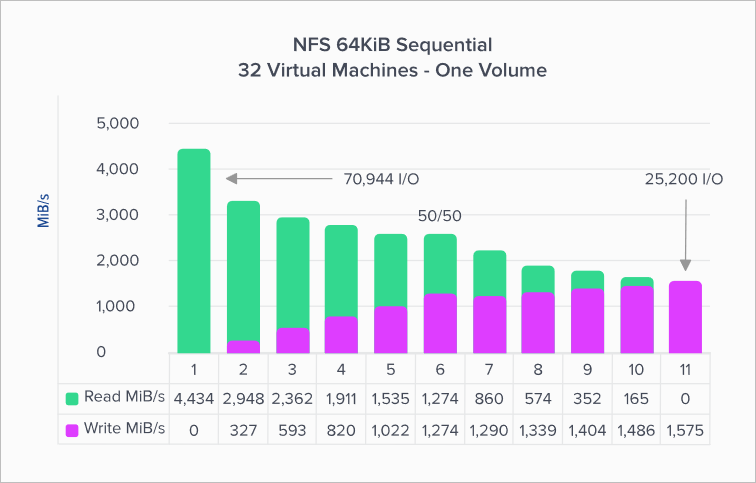

Dataflöde för Linux-arbetsbelastning

Diagrammet nedan representerar en sekventiell arbetsbelastning på 64 kibibyte (KiB) och en 1 TiB-arbetsuppsättning. Den visar att en enda Azure NetApp Files-volym kan hantera mellan ~1 600 MiB/s rena sekventiella skrivningar och ~4 500 MiB/s rena sekventiella läsningar.

Diagrammet visar minskningar i 10 % åt gången, från ren läsning till ren skrivning. Den visar vad du kan förvänta dig när du använder varierande läs-/skrivförhållanden (100%:0%, 90%:10%, 80%:20%och så vidare).

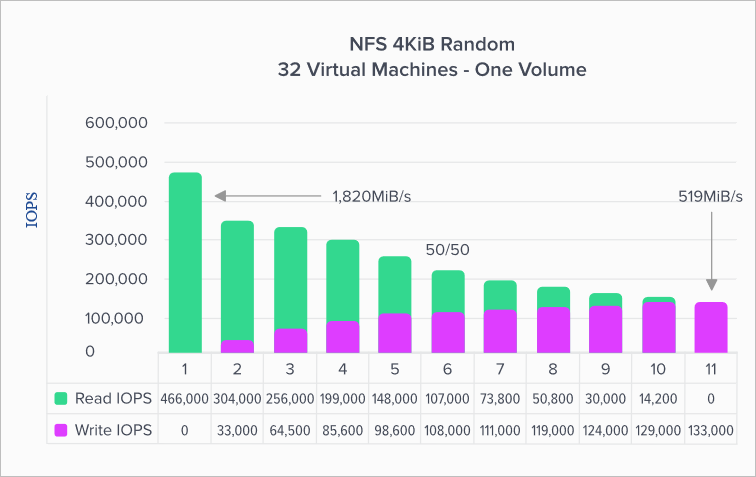

IOPS för Linux-arbetsbelastning

Följande diagram representerar en slumpmässig arbetsbelastning på 4 kibibyte (KiB) och en 1 TiB-arbetsuppsättning. Diagrammet visar att en Azure NetApp Files-volym kan hantera mellan ~130 000 rena slumpmässiga skrivningar och ~460 000 rena slumpmässiga läsningar.

Det här diagrammet visar minskningar i 10 % åt gången, från ren läsning till ren skrivning. Den visar vad du kan förvänta dig när du använder varierande läs-/skrivförhållanden (100%:0%, 90%:10%, 80%:20%och så vidare).

Linux-uppskalning

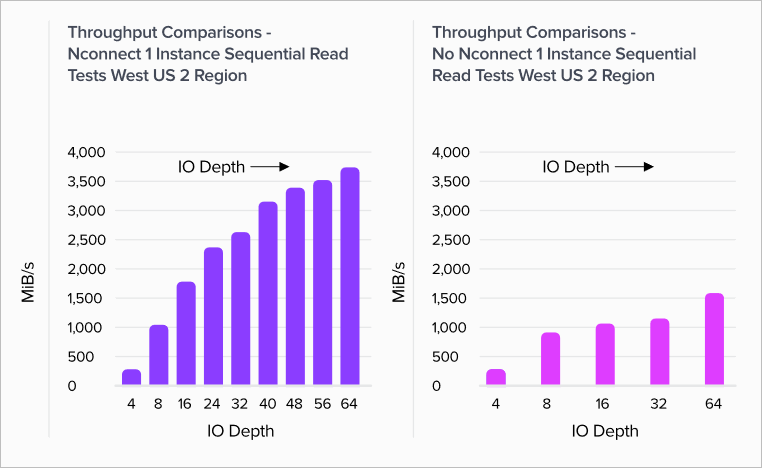

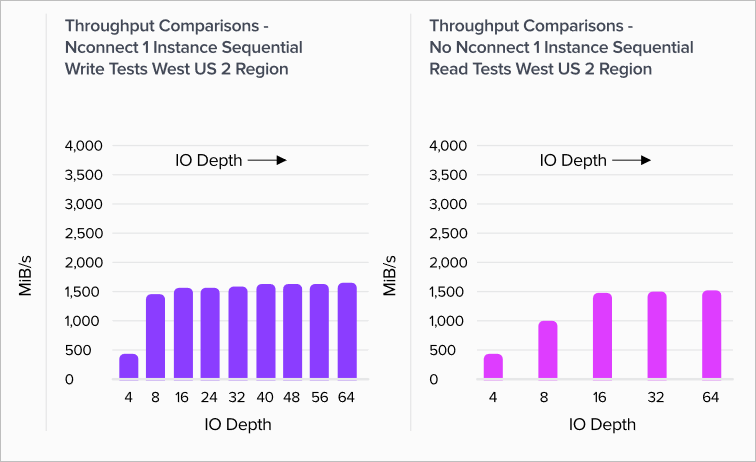

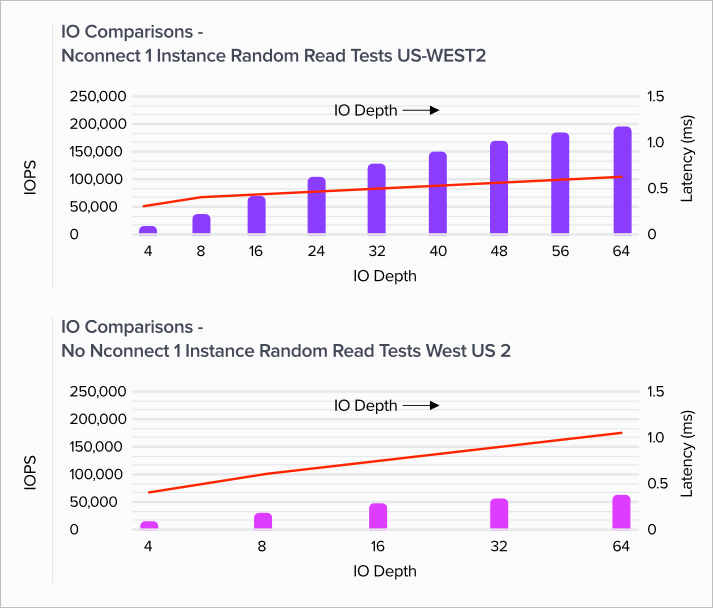

Graferna i det här avsnittet visar valideringstestresultaten för monteringsalternativet på klientsidan med NFSv3. Mer information finns i nconnect avsnittet om Linux-monteringsalternativ.

Graferna jämför fördelarna med nconnect en icke-monteradconnected volym. I graferna genererade FIO arbetsbelastningen från en enda D32s_v4 instans i Azure-regionen us-west2 med en sekventiell arbetsbelastning på 64 KiB – den största I/O-storleken som stöds av Azure NetApp Files vid tidpunkten för testningen som visas här. Azure NetApp Files har nu stöd för större I/O-storlekar. Mer information finns i rsize och wsize avsnittet om Linux-monteringsalternativ.

Linux-läsdataflöde

Följande diagram visar sekventiella 64-KiB-läsningar på ~3 500 MiB/s med nconnect, ungefär 2,3 X icke-nconnect.

Linux-skrivdataflöde

Följande diagram visar sekventiella skrivningar. De anger att nconnect det inte finns någon märkbar fördel med sekventiella skrivningar. 1 500 MiB/s är ungefär både den sekventiella skrivvolymens övre gräns och gränsen för D32s_v4 instansens utgående gräns.

Linux-läs-IOPS

Följande diagram visar slumpmässiga läsningar av 4 KiB på ~200 000 lästa IOPS med nconnect, ungefär 3 X icke-nconnect.

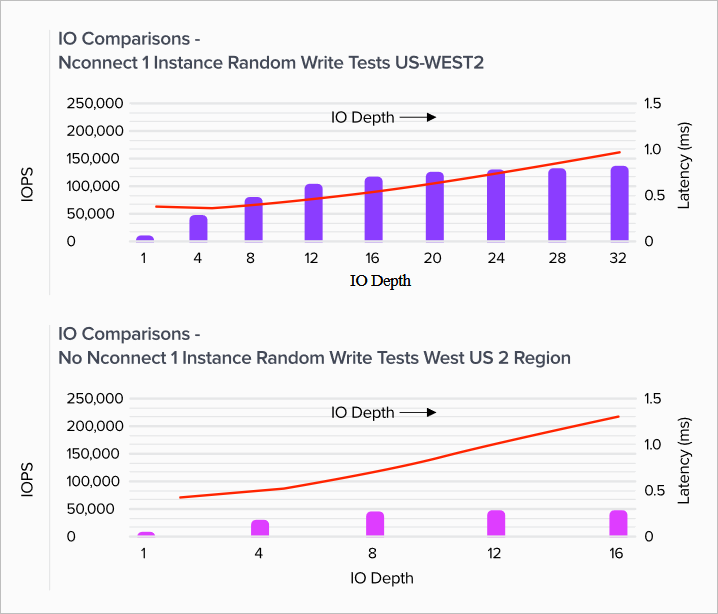

Linux-skriv-IOPS

Följande diagram visar 4-KiB slumpmässiga skrivningar av ~135 000 skriv-IOPS med nconnect, ungefär 3X icke-nconnect.