Snabbstart: Flytta och transformera data med dataflöden och datapipelines

I den här självstudien får du lära dig hur dataflödet och datapipelines kan skapa en kraftfull och omfattande Data Factory-lösning.

Förutsättningar

För att komma igång måste du ha följande förutsättningar:

- Ett klientkonto med en aktiv prenumeration. Skapa ett kostnadsfritt konto.

- Kontrollera att du har en Microsoft Fabric-aktiverad arbetsyta: Skapa en arbetsyta som inte är standardvärdet Min arbetsyta.

- En Azure SQL-databas med tabelldata.

- Ett Blob Storage-konto.

Dataflöden jämfört med pipelines

Med Dataflows Gen2 kan du använda ett gränssnitt med låg kod och över 300 data och AI-baserade transformeringar för att enkelt rensa, förbereda och transformera data med större flexibilitet än något annat verktyg. Med datapipelines kan du använda avancerade funktioner för dataorkestrering för att skapa flexibla dataarbetsflöden som uppfyller företagets behov. I en pipeline kan du skapa logiska grupper av aktiviteter som utför en uppgift, vilket kan vara att anropa ett dataflöde för att rensa och förbereda dina data. Även om det finns en viss överlappning mellan de två, beror valet av vilka som ska användas för ett visst scenario på om du behöver fullständig rikedom av pipelines eller kan använda de enklare men mer begränsade funktionerna i dataflöden. Mer information finns i beslutsguiden för infrastrukturresurser

Transformera data med dataflöden

Följ de här stegen för att konfigurera ditt dataflöde.

Steg 1: Skapa ett dataflöde

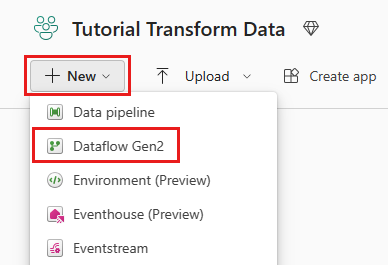

Välj din Infrastrukturaktiverade arbetsyta och välj sedan Ny. Välj sedan Dataflöde Gen2.

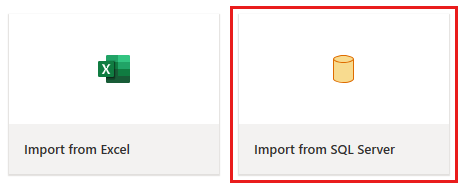

Fönstret dataflödesredigerare visas. Välj kortet Importera från SQL Server .

Steg 2: Hämta data

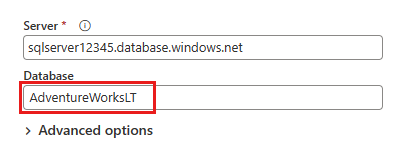

I dialogrutan Anslut till datakälla som visas härnäst anger du informationen för att ansluta till din Azure SQL-databas och väljer sedan Nästa. I det här exemplet använder du exempeldatabasen AdventureWorksLT som konfigurerades när du konfigurerade Azure SQL-databasen i förutsättningarna.

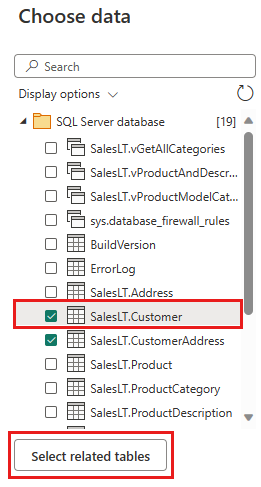

Välj de data som du vill transformera och välj sedan Skapa. För den här snabbstarten väljer du SalesLT.Customer från AdventureWorksLT-exempeldata som tillhandahålls för Azure SQL DB och sedan knappen Välj relaterade tabeller för att automatiskt inkludera två andra relaterade tabeller.

Steg 3: Transformera dina data

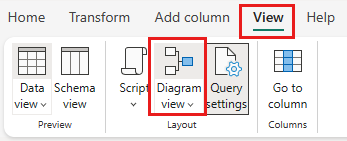

Om den inte är markerad väljer du knappen Diagramvy längs statusfältet längst ned på sidan eller väljer Diagramvy under menyn Visa överst i Power Query-redigeraren. Något av dessa alternativ kan växla diagramvyn.

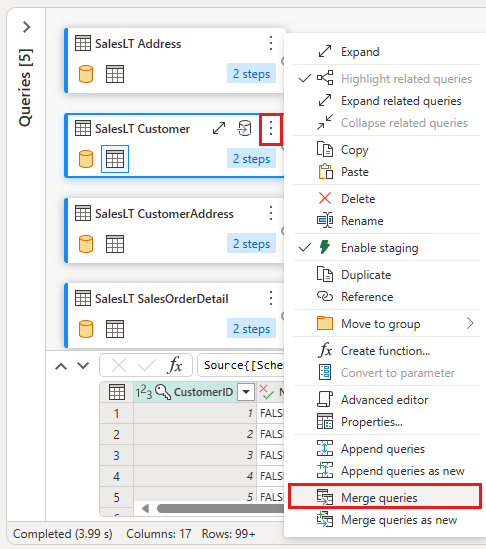

Högerklicka på salesLT-kundfråganeller välj den lodräta ellipsen till höger om frågan och välj sedan Slå samman frågor.

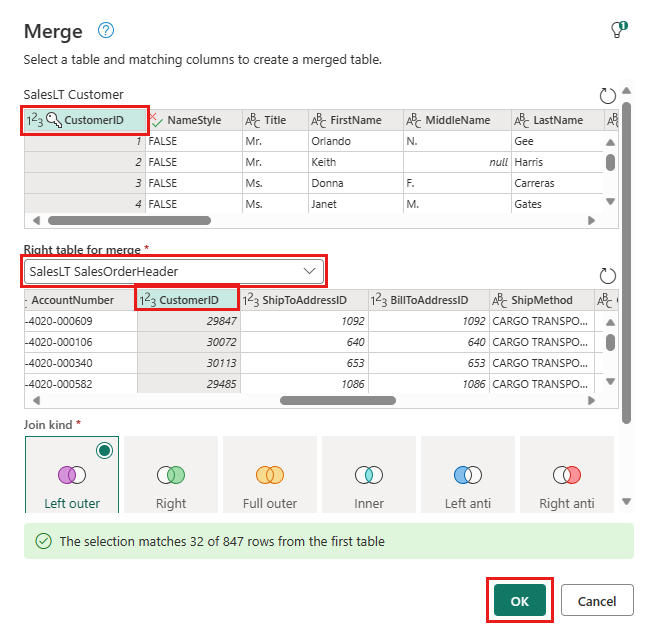

Konfigurera sammanfogningen genom att välja tabellen SalesLTOrderHeader som den högra tabellen för sammanfogningen, Kolumnen CustomerID från varje tabell som kopplingskolumn och Vänster yttre som kopplingstyp. Välj sedan OK för att lägga till kopplingsfrågan.

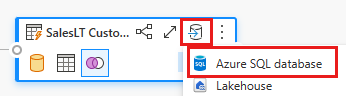

Välj knappen Lägg till datamål, som ser ut som en databassymbol med en pil ovanför, från den nya kopplingsfrågan som du nyss skapade. Välj sedan Azure SQL Database som måltyp.

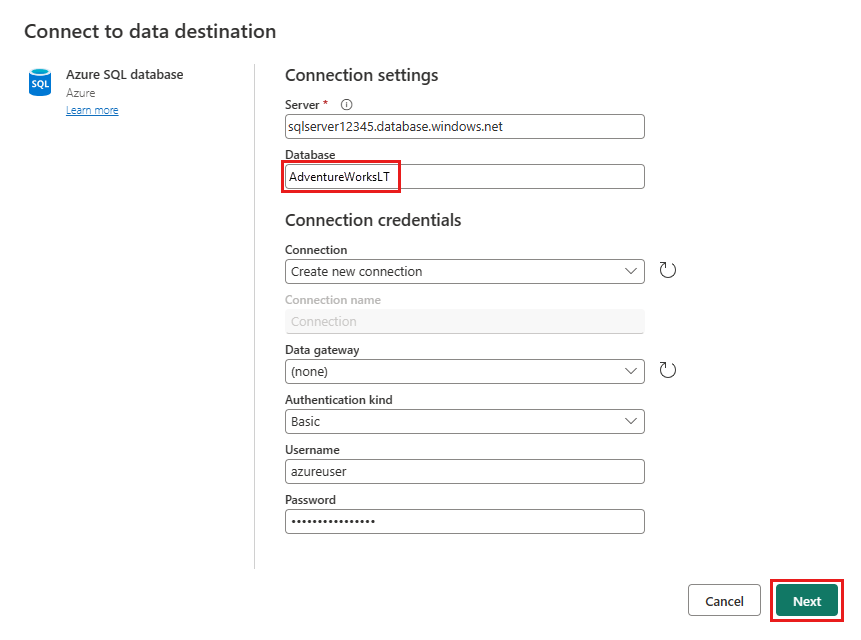

Ange information för din Azure SQL-databasanslutning där sammanslagningsfrågan ska publiceras. I det här exemplet kan du använda AdventureWorksLT-databasen som vi använde som datakälla för målet också.

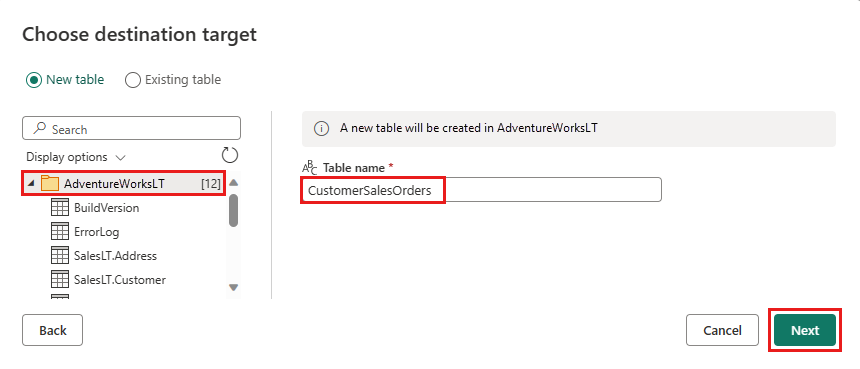

Välj en databas för att lagra data och ange ett tabellnamn och välj sedan Nästa.

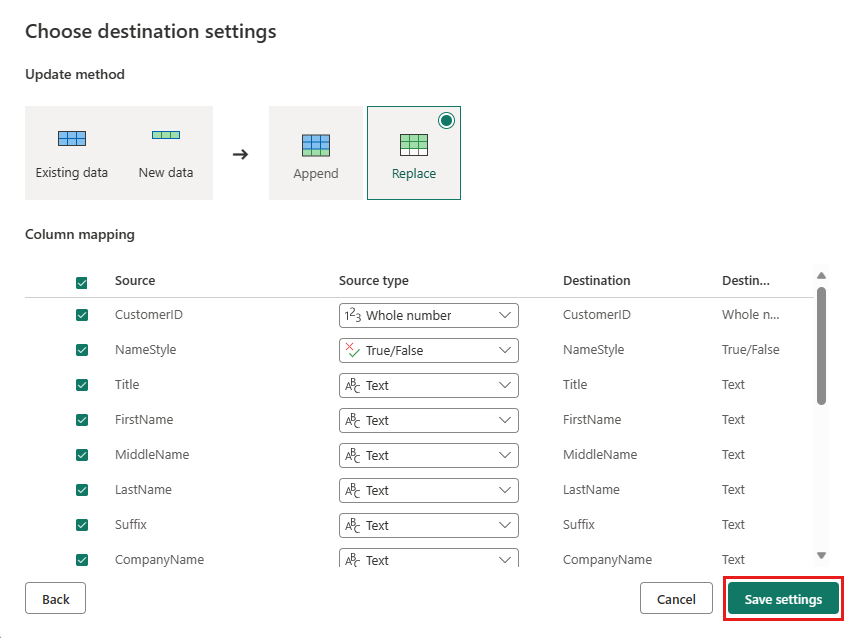

Du kan lämna standardinställningarna i dialogrutan Välj målinställningar och bara välja Spara inställningar utan att göra några ändringar här.

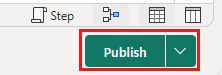

Välj Publicera igen på dataflödesredigerarens sida för att publicera dataflödet.

Flytta data med datapipelines

Nu när du har skapat ett Dataflöde Gen2 kan du använda det i en pipeline. I det här exemplet kopierar du data som genererats från dataflödet till textformat i ett Azure Blob Storage-konto.

Steg 1: Skapa en ny datapipeline

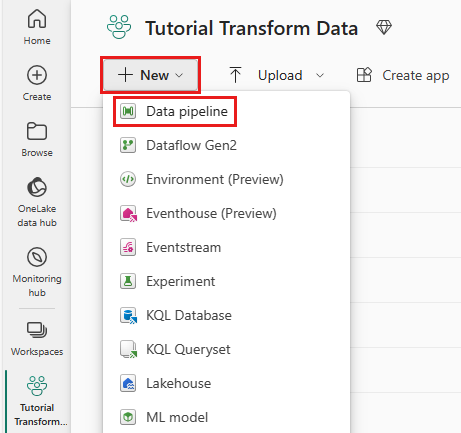

Välj Ny på arbetsytan och välj sedan Datapipeline.

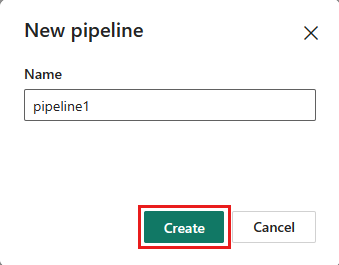

Namnge pipelinen och välj sedan Skapa.

Steg 2: Konfigurera ditt dataflöde

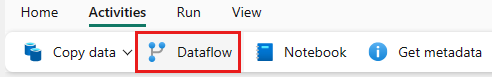

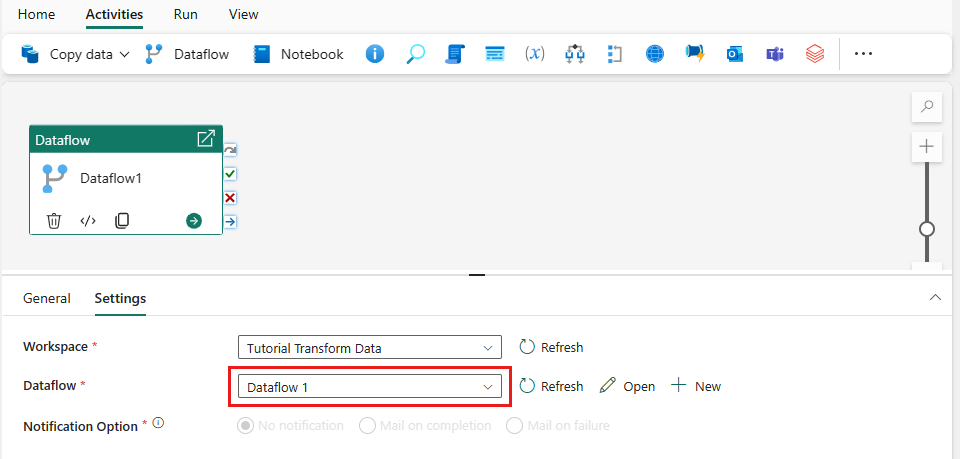

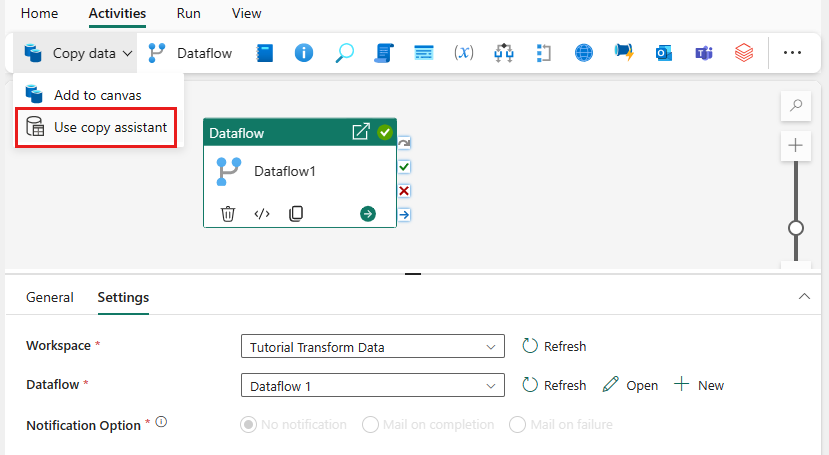

Lägg till en ny dataflödesaktivitet i datapipelinen genom att välja Dataflöde på fliken Aktiviteter .

Välj dataflödet på pipelinearbetsytan och sedan fliken Inställningar. Välj det dataflöde som du skapade tidigare i listrutan.

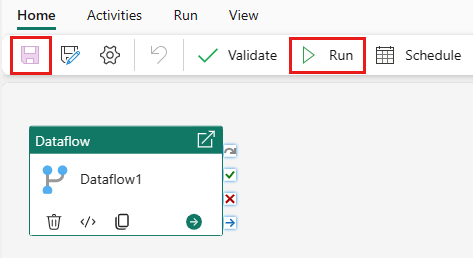

Välj Spara och kör sedan dataflödet för att först fylla i den sammanfogade frågetabell som du skapade i föregående steg.

Steg 3: Använd kopieringsassistenten för att lägga till en kopieringsaktivitet

Välj Kopiera data på arbetsytan för att öppna verktyget Kopieringsassistenten för att komma igång. Eller välj Använd kopieringsassistenten i listrutan Kopiera data under fliken Aktiviteter i menyfliksområdet.

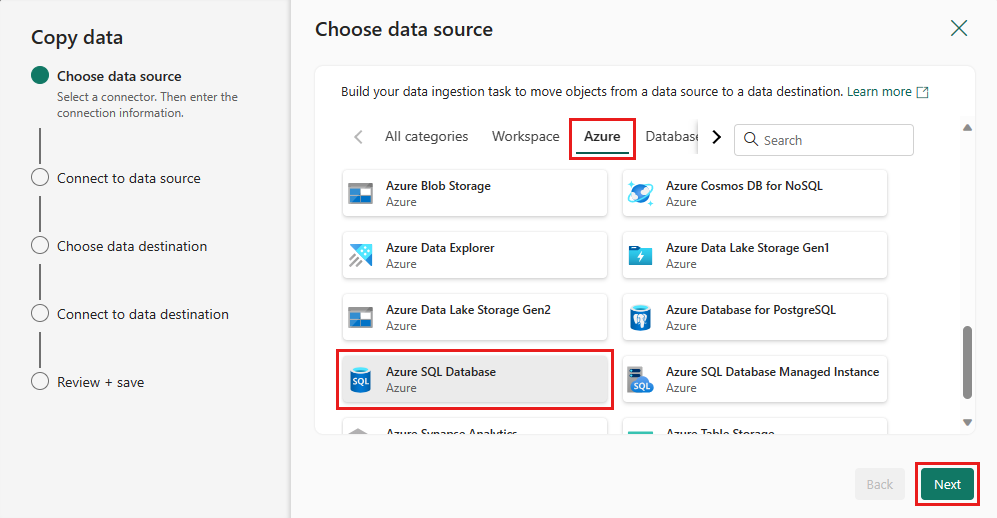

Välj din datakälla genom att välja en typ av datakälla. I den här självstudien använder du Azure SQL Database som användes tidigare när du skapade dataflödet för att generera en ny sammanslagningsfråga. Rulla nedåt under exempeldataerbjudandena och välj fliken Azure och sedan Azure SQL Database. Välj sedan Nästa för att fortsätta.

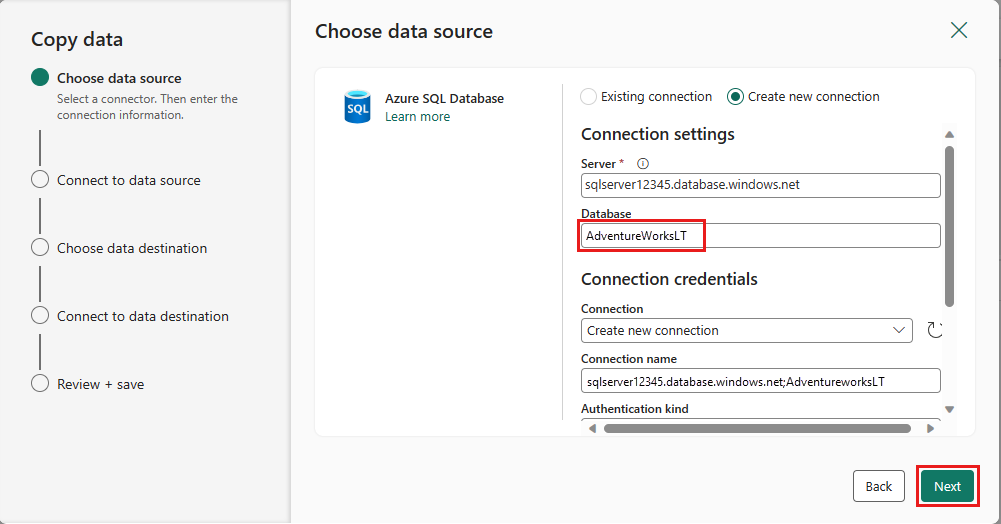

Skapa en anslutning till datakällan genom att välja Skapa ny anslutning. Fyll i nödvändig anslutningsinformation på panelen och ange AdventureWorksLT för databasen, där vi genererade sammanslagningsfrågan i dataflödet. Välj sedan Nästa.

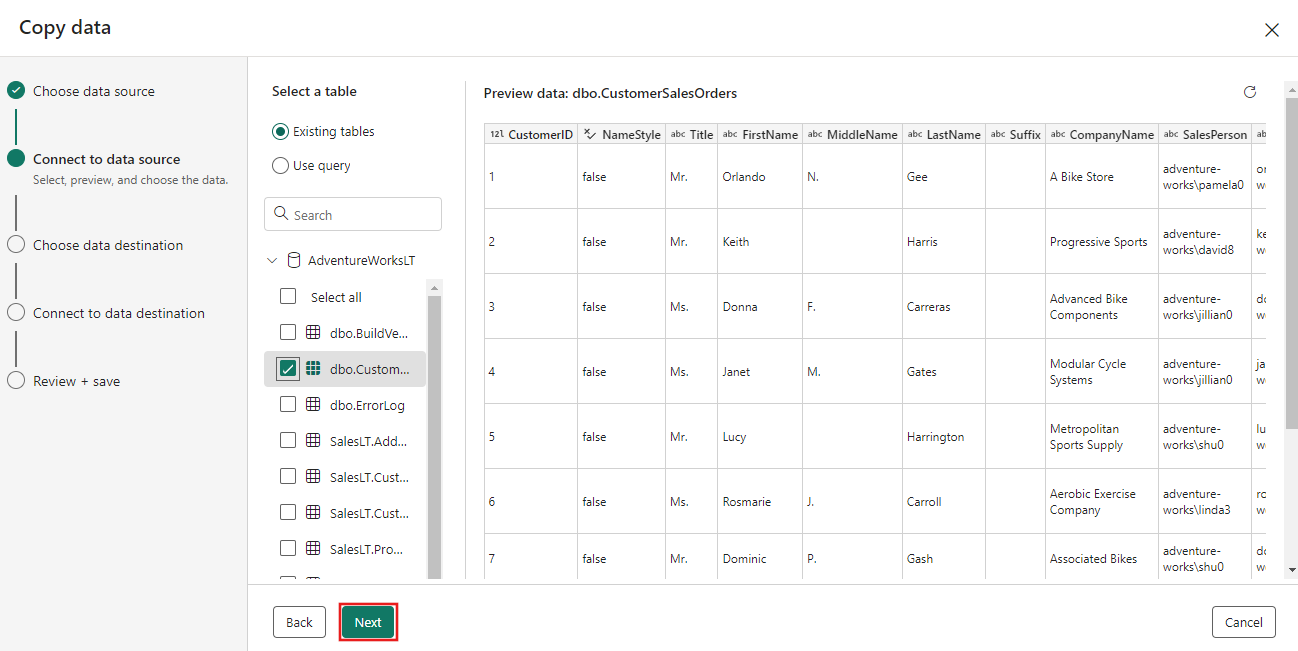

Välj den tabell som du genererade i dataflödessteget tidigare och välj sedan Nästa.

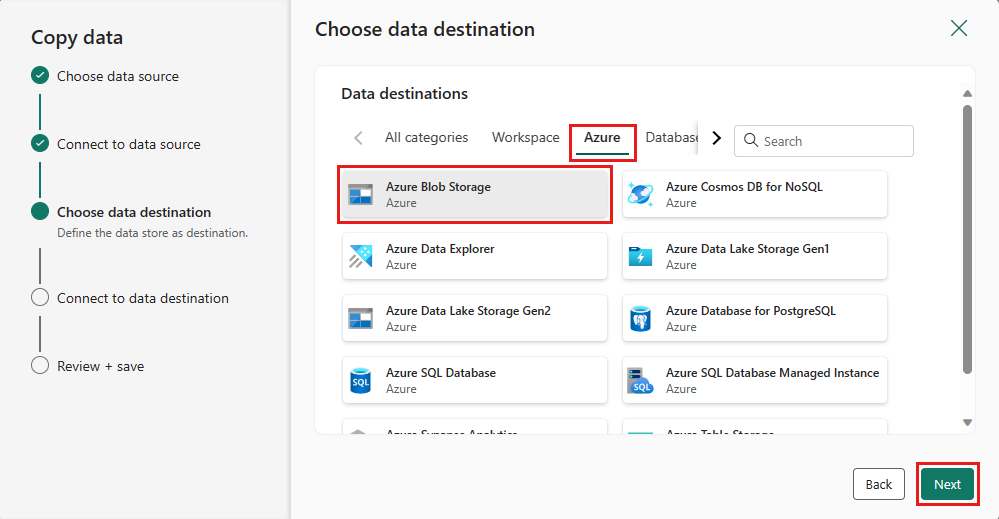

Välj Azure Blob Storage som mål och välj sedan Nästa.

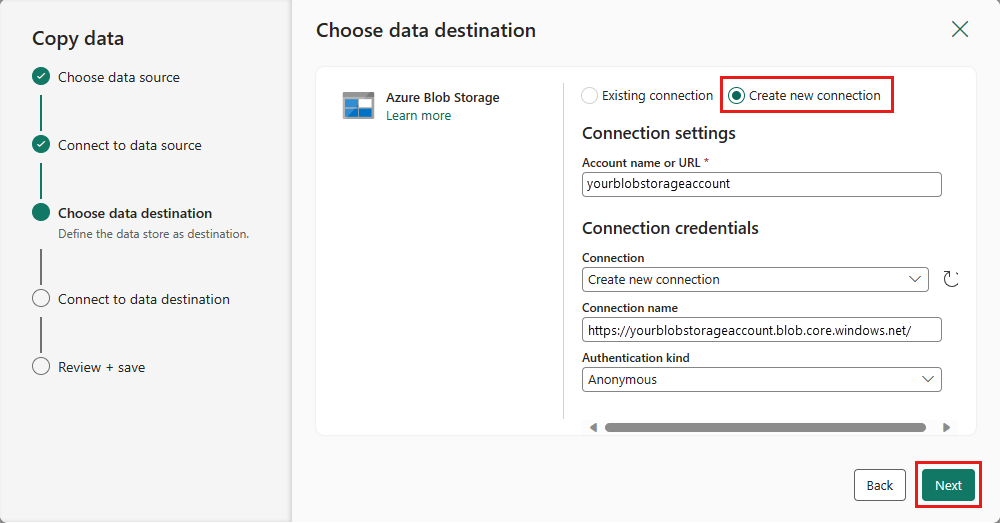

Skapa en anslutning till målet genom att välja Skapa ny anslutning. Ange information för anslutningen och välj sedan Nästa.

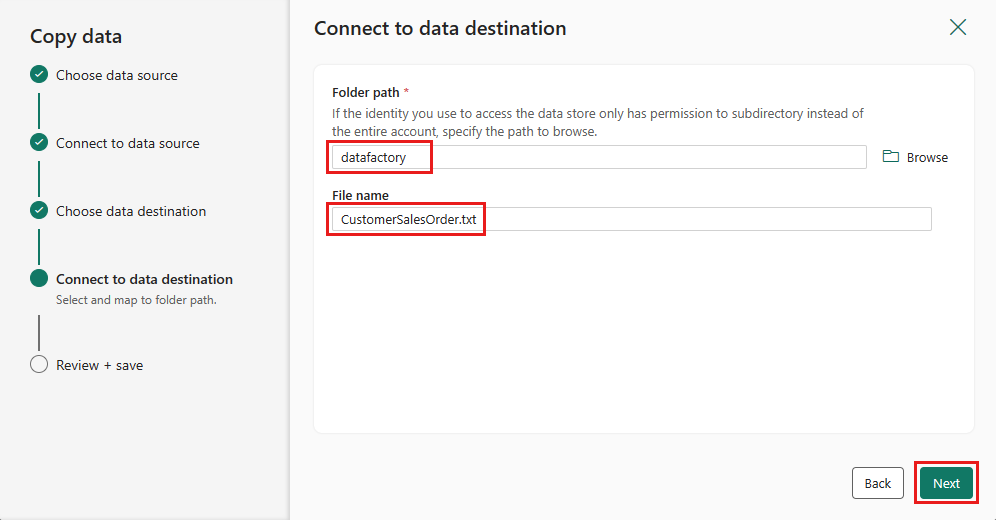

Välj mappsökvägen och ange ett filnamn och välj sedan Nästa.

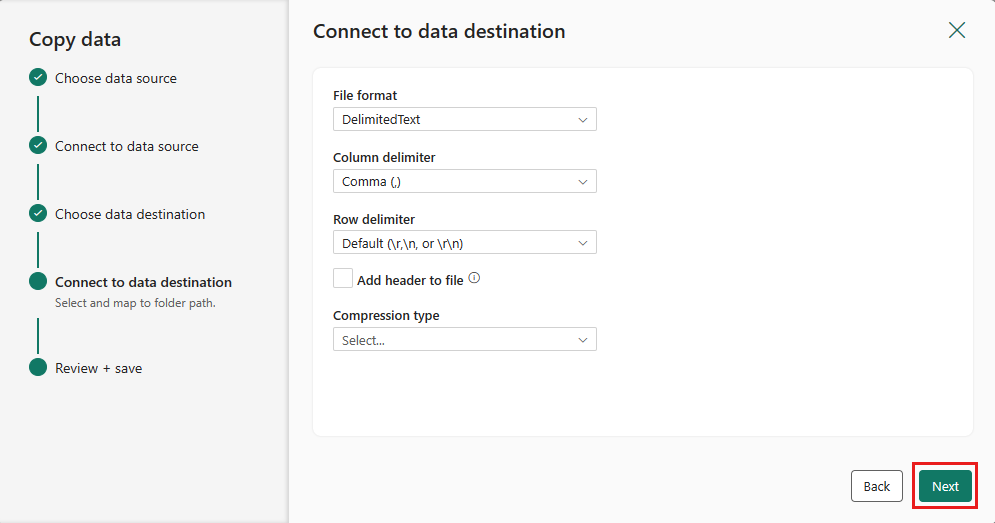

Välj Nästa igen för att acceptera standardfilformatet, kolumn avgränsare, rad avgränsare och komprimeringstyp, om du vill inkludera ett huvud.

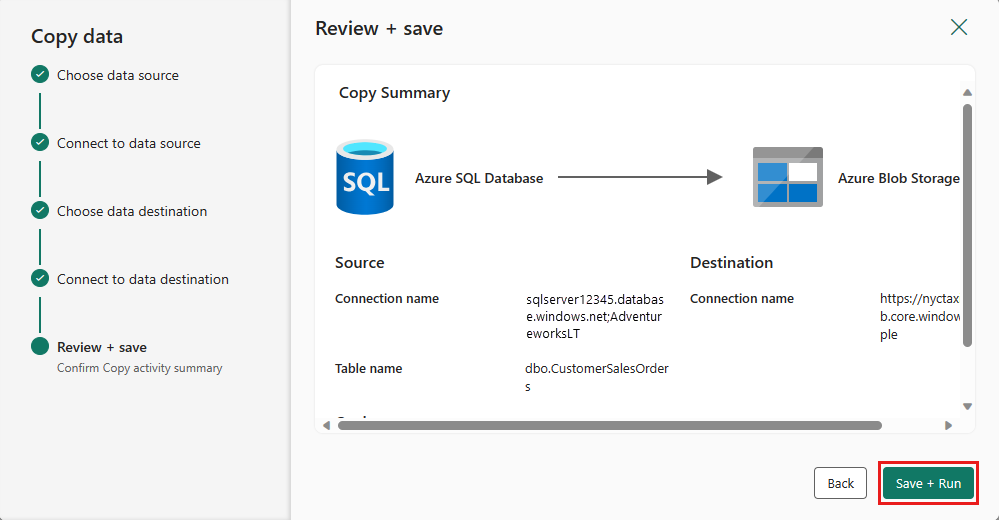

Slutför inställningarna. Granska sedan och välj Spara + Kör för att slutföra processen.

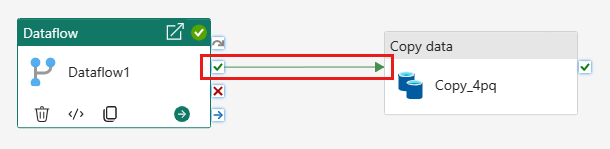

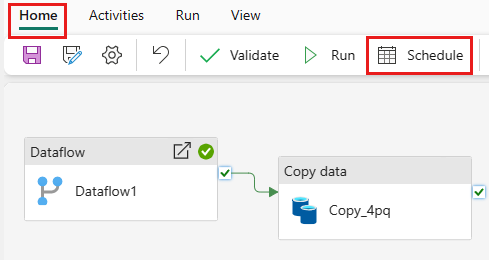

Steg 5: Utforma din datapipeline och spara för att köra och läsa in data

Om du vill köra kopieringsaktiviteten efter dataflödesaktiviteten drar du från Lyckades på dataflödesaktiviteten till kopieringsaktiviteten. Kopieringsaktiviteten körs bara efter att dataflödesaktiviteten har slutförts.

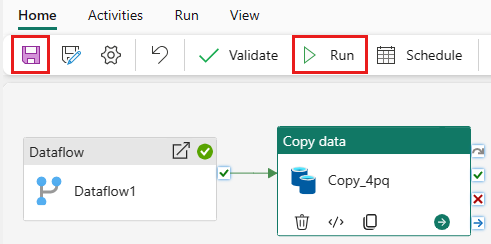

Välj Spara för att spara datapipelinen. Välj sedan Kör för att köra datapipelinen och läsa in dina data.

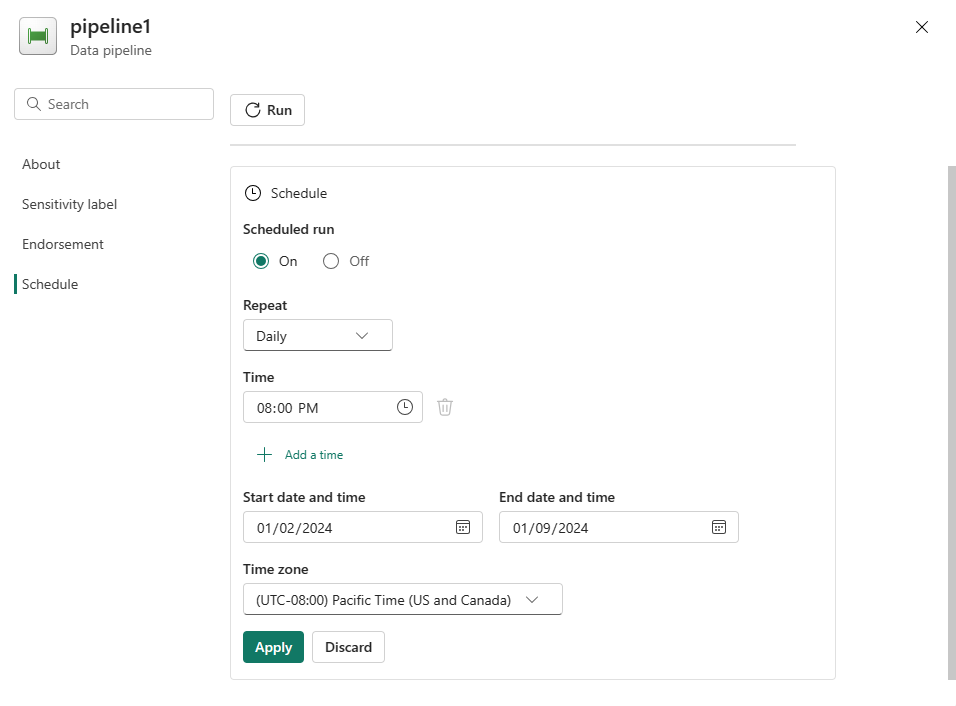

Schemalägg pipelinekörning

När du har utvecklat och testat din pipeline kan du schemalägga den så att den körs automatiskt.

På fliken Start i fönstret pipelineredigerare väljer du Schema.

Konfigurera schemat efter behov. Exemplet här schemalägger pipelinen så att den körs dagligen kl. 20:00 till slutet av året.

Relaterat innehåll

Det här exemplet visar hur du skapar och konfigurerar ett Dataflöde Gen2 för att skapa en sammanslagningsfråga och lagra den i en Azure SQL-databas och sedan kopierar data från databasen till en textfil i Azure Blob Storage. Du har lärt dig att:

- Skapa ett dataflöde.

- Transformera data med dataflödet.

- Skapa en datapipeline med hjälp av dataflödet.

- Beställ körningen av stegen i pipelinen.

- Kopiera data med kopieringsassistenten.

- Kör och schemalägg din datapipeline.

Gå sedan vidare för att lära dig mer om att övervaka dina pipelinekörningar.

Feedback

Kommer snart: Under hela 2024 kommer vi att fasa ut GitHub-problem som feedbackmekanism för innehåll och ersätta det med ett nytt feedbacksystem. Mer information finns i: https://aka.ms/ContentUserFeedback.

Skicka och visa feedback för