快速入门:使用数据流和数据管道移动和转换数据

在本教程中,你将了解数据流和数据管道体验如何创建功能强大且全面的数据工厂解决方案。

先决条件

若要开始,必须具备以下先决条件:

- 具有有效订阅的租户帐户。 创建免费帐户。

- 确保具有已启用 Microsoft Fabric 的工作区创建工作区,该工作区不是默认的“我的工作区”。

- 包含表数据的 Azure SQL 数据库。

- Blob 存储帐户。

数据流与管道的比较

Dataflows Gen2 使你能够利用低代码接口以及 300 多种基于数据和 AI 的转换,比任何其他工具更加轻松、灵活地清理、准备和转换数据。 数据管道使你能够利用丰富的现成数据编排功能来生成灵活的数据工作流,以满足你的业务需求。 在管道中,你可以创建执行任务的逻辑活动分组,其中包括调用数据流来清理和准备数据。 虽然两者在功能上有一些重叠,但在特定应用场景中选择使用哪一种取决于你是需要管道的丰富功能,还是数据流更简单但有限的功能。 有关更多详细信息,请参阅 Fabric 决策指南

使用数据流转换数据

若要设置数据流,请按照以下步骤操作。

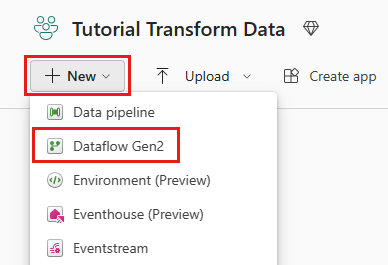

步骤 1:创建数据流

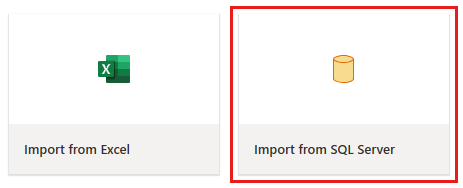

步骤 2:获取数据

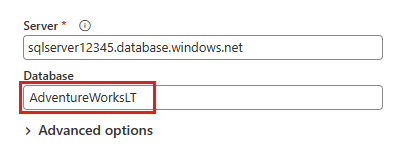

在接下来显示的“连接到数据源”对话框中,输入连接到 Azure SQL 数据库的详细信息,然后选择“下一步”。 对于此示例,将使用在先决条件中设置 Azure SQL 数据库时配置的 AdventureWorksLT 示例数据库。

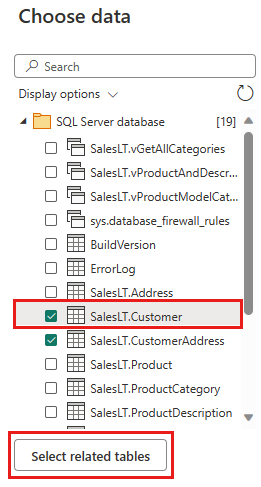

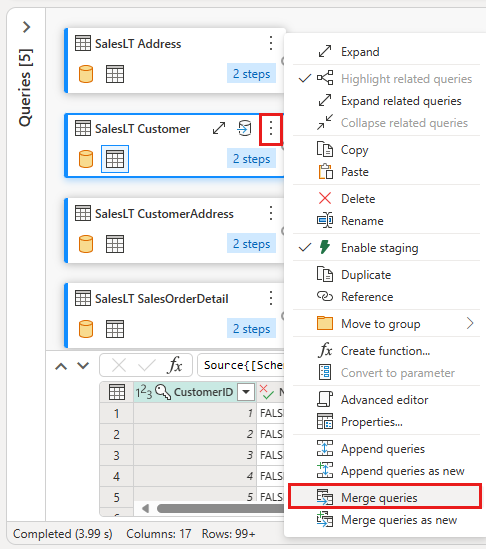

选择要转换的数据,然后选择“创建”。 对于本快速入门,请从为 Azure SQL DB 提供的 AdventureWorksLT 示例数据中选择“SalesLT.Customer”,然后选择“选择相关表”按钮以自动包含其他两个相关表。

步骤 3 – 转换数据

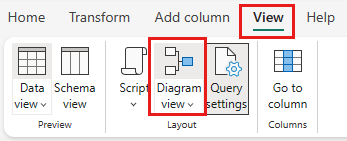

如果未选中,请选择页面底部状态栏旁的“关系图视图”按钮,或选择 Power Query 编辑器顶部的“视图”菜单下的“关系图视图”。 这些选项之一都可以切换关系图视图。

右键单击 SalesLT Customer 查询,或选择查询右侧的垂直省略号,然后选择“合并查询”。

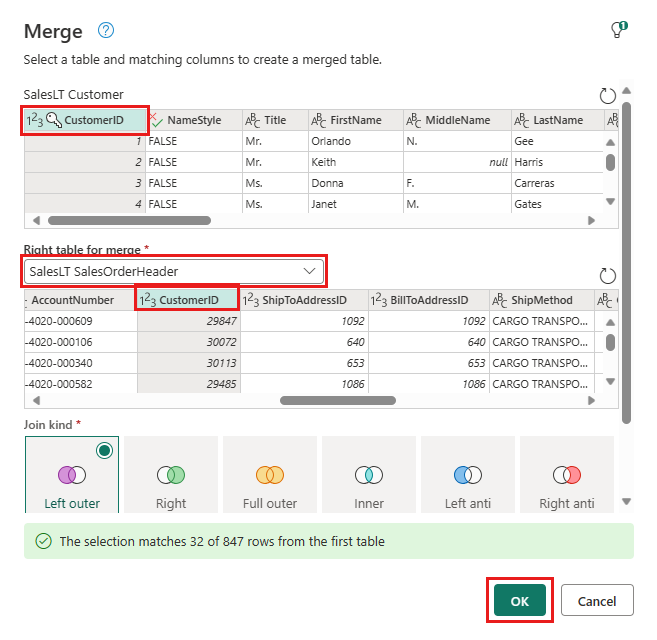

通过选择“SalesOrderHeader”表作为合并的右表、每个表中的“CustomerID”列作为联接列和“左外”作为联接类型来配置合并。 然后选择“确定”以添加合并查询。

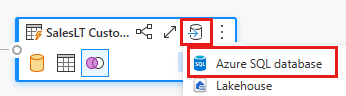

从刚刚创建的新合并查询中选择“添加数据目标”按钮,该按钮看起来像数据库符号上方有一个箭头。 选择 Azure SQL 数据库作为目标类型。

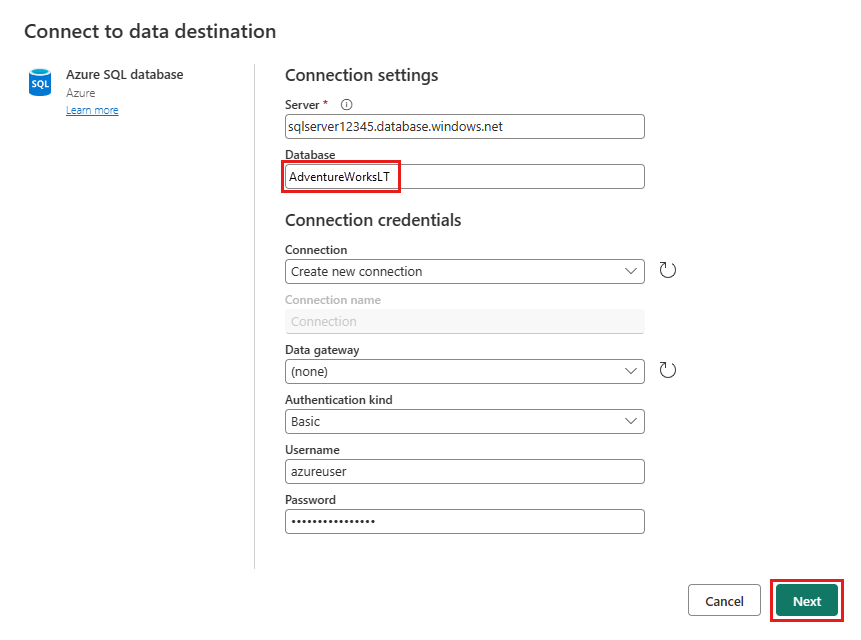

提供将在其中发布合并查询的 Azure SQL 数据库连接的详细信息。 在此示例中,也可以使用我们已用作目标的数据源的 AdventureWorksLT 数据库。

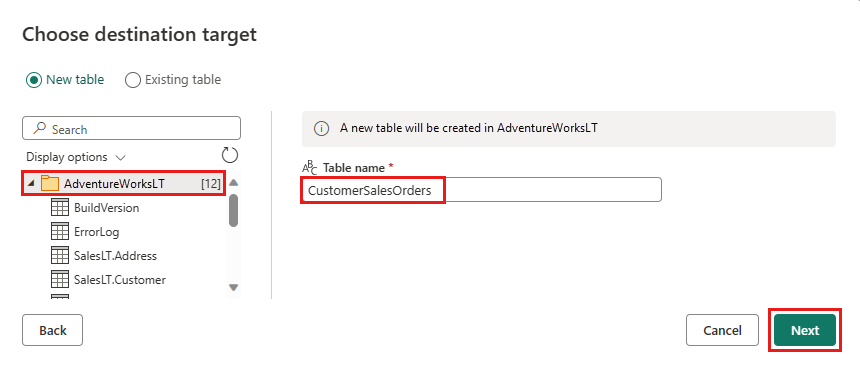

选择要存储数据的数据库,并提供表名,然后选择“下一步”。

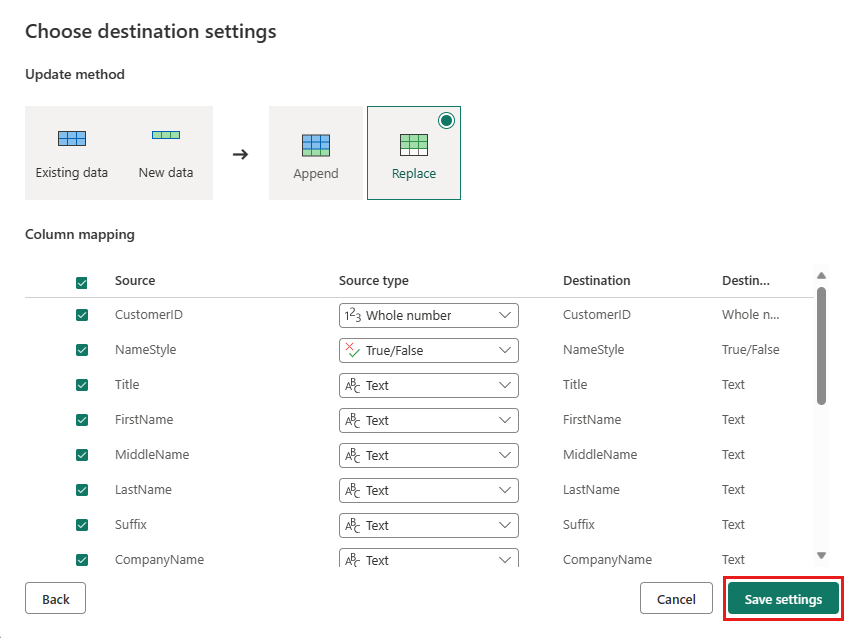

可以在“选择目标设置”对话框中保留默认设置,只需选择“保存设置”,而无需在此处进行任何更改。

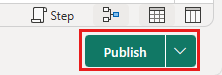

在数据流编辑器页上选择“发布”,以发布数据流。

使用数据管道移动数据

现在,你已创建 Dataflow Gen2,可以在管道中对其进行操作。 在此示例中,你将从数据流生成的数据复制到Azure Blob 存储帐户中的文本格式。

步骤 1:创建新的数据管道

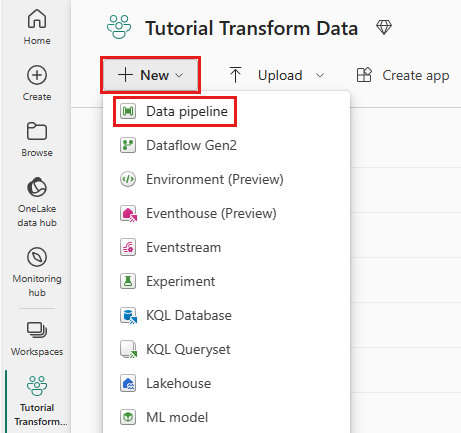

在工作区中,选择“新建”,然后选择“数据管道”。

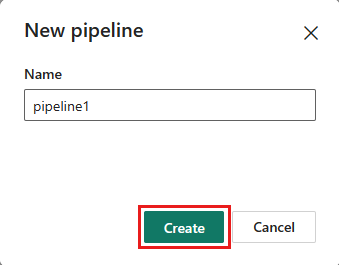

命名管道,然后选择“创建”。

步骤 2:配置数据流

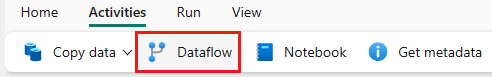

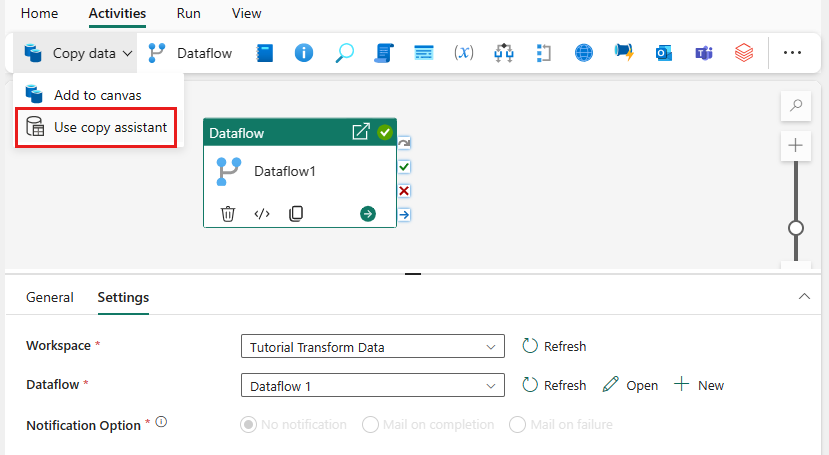

通过在“活动”选项卡中选择“数据流”,向数据管道添加新的数据流活动。

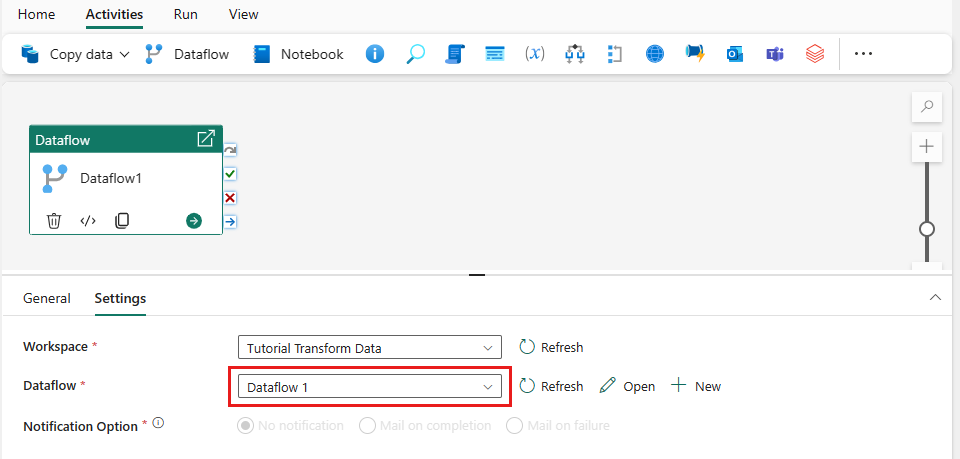

选择管道画布上的数据流,然后选择“设置”选项卡。从下拉列表中选择之前创建的数据流。

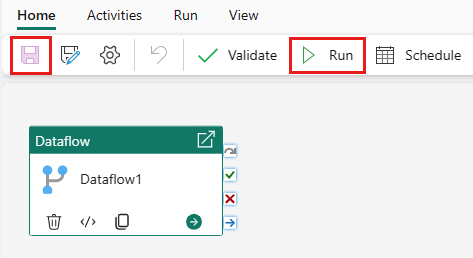

选择“保存”,然后选择“运行”以运行数据流,以最初填充在上一步中设计的合并查询表。

步骤 3:使用复制助手添加复制活动

选择画布上的“复制数据”,打开“复制助手”工具以开始使用。 或者从功能区上“活动”选项卡下的“复制数据”下拉列表中选择“使用复制助手”。

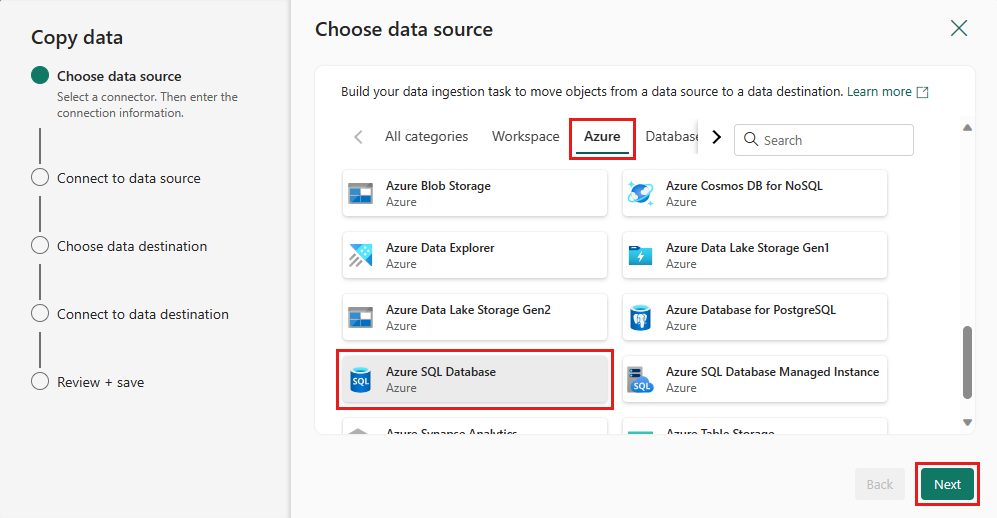

通过选择数据源类型来选择数据源。 在本教程中,你将使用先前创建数据流时使用的 Azure SQL 数据库来生成新的合并查询。 向下滚动示例数据产品/服务下方,选择“Azure”选项卡,然后选择“Azure SQL数据库”。 然后,选择下一步以继续。

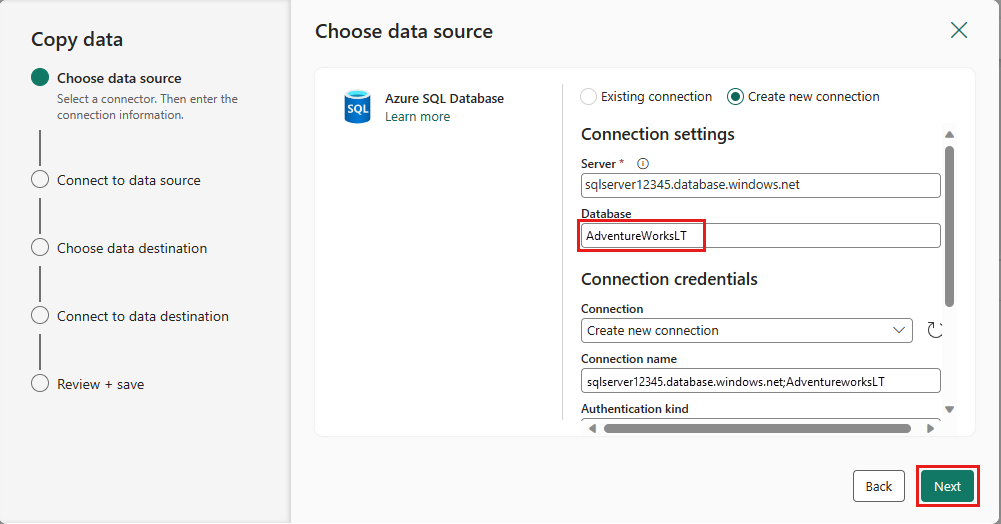

通过选择“创建新连接”,创建与数据源的连接。 在面板上填写所需的连接信息,然后输入数据库的 AdventureWorksLT,我们在这里的数据流中生成了合并查询。 然后,选择“下一步”。

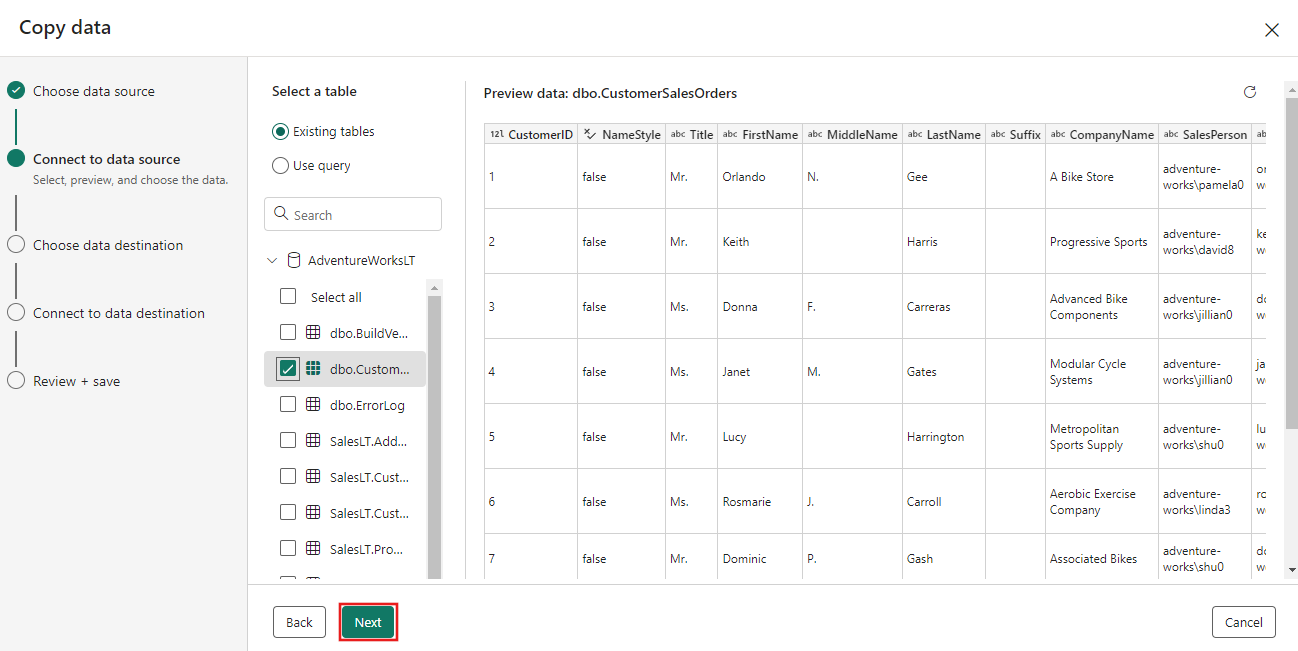

选择前面在数据流步骤中生成的表,然后选择“下一步”。

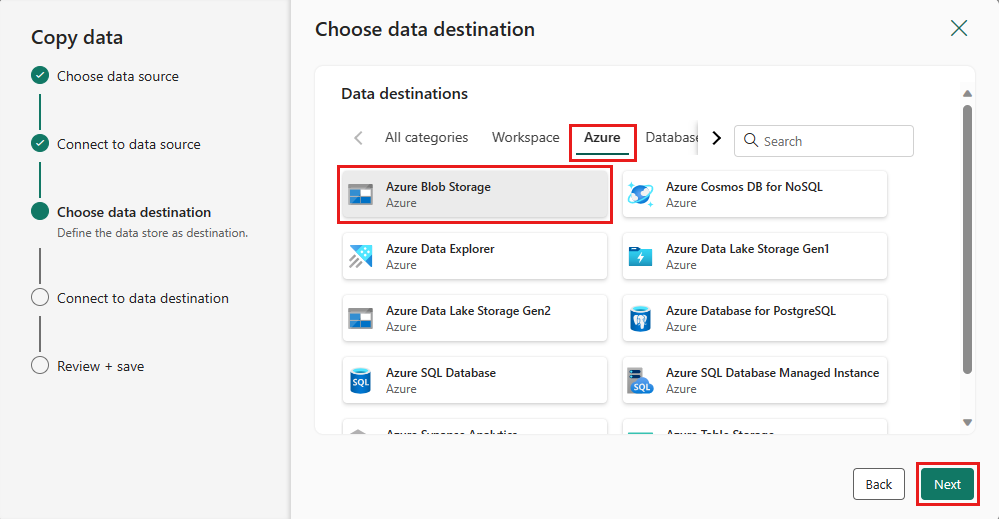

对于目标,选择“Azure Blob 存储”,然后选择“下一步”。

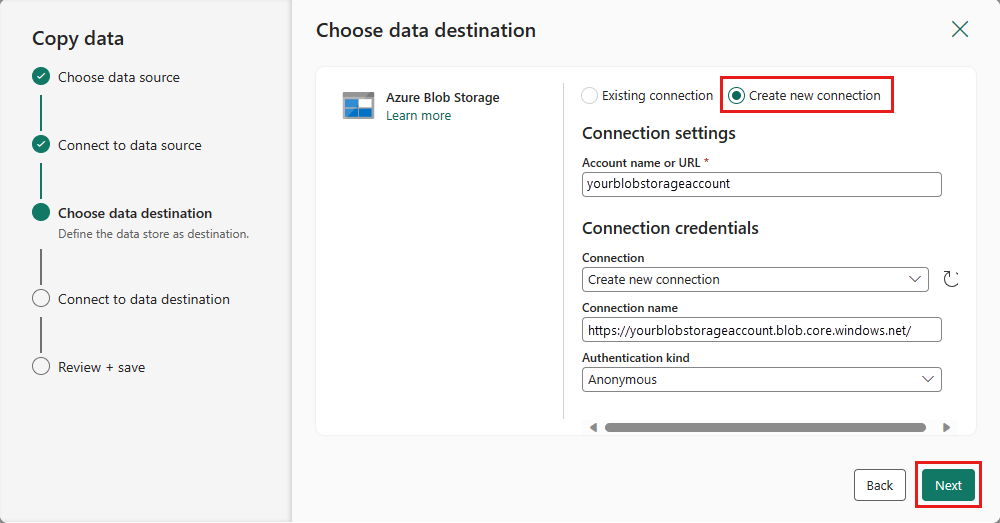

通过选择“创建新连接”,创建与模板的连接。 为连接提供所需的详细信息,然后选择“下一步”。

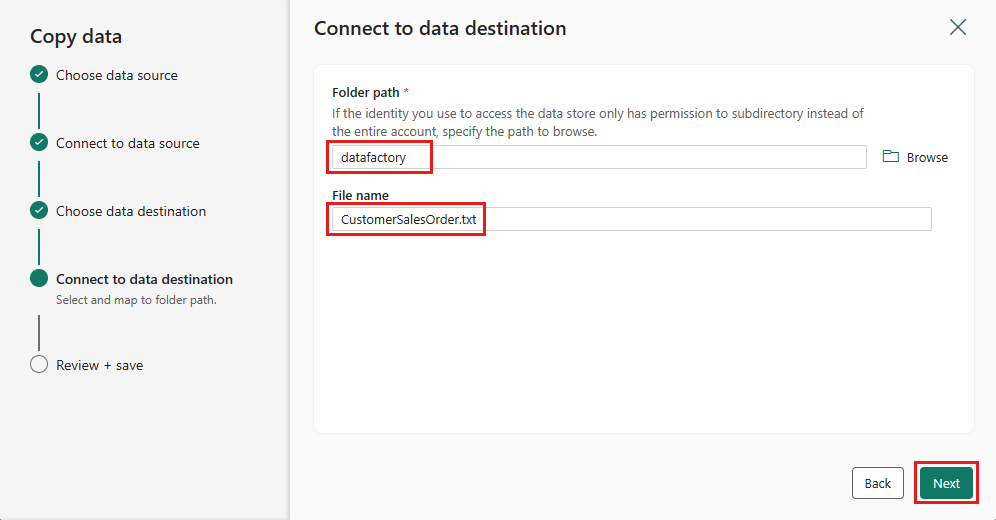

选择“文件夹路径”,并提供文件名,然后选择“下一步”。

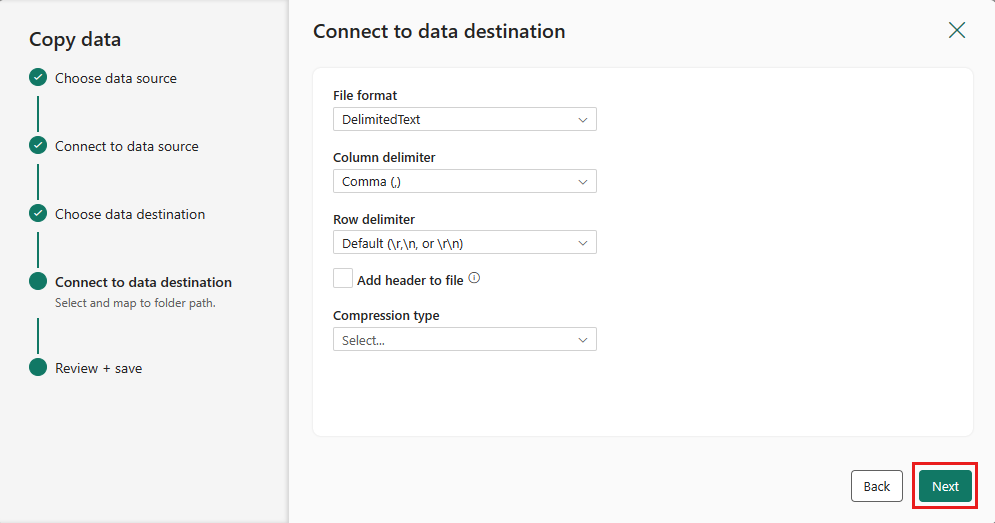

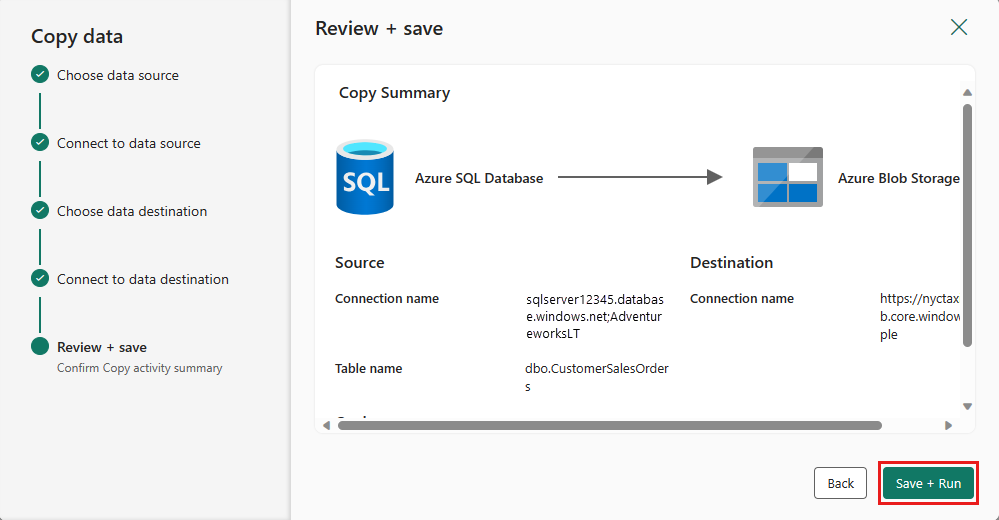

再次选择“下一步”以接受默认文件格式、列分隔符、行分隔符和压缩类型(可选包括标头)。

完成设置。 然后,检查并选择“保存并运行”以完成该过程。

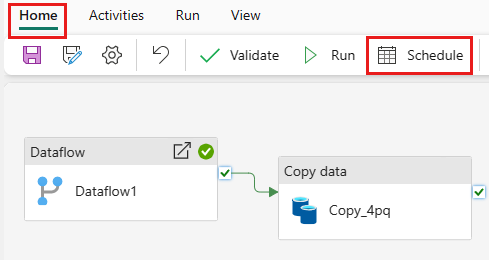

步骤 5:设计数据管道并保存以运行和加载数据

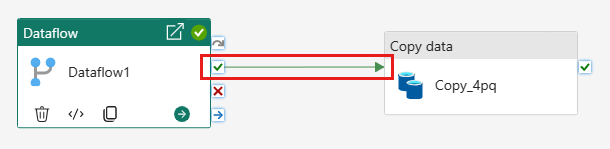

若要在“数据流”活动之后运行“复制”活动,请从“数据流”活动中的“成功拖到“复制”活动。 复制活动仅在数据流活动成功后运行。

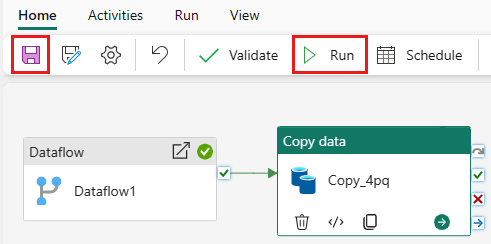

选择“保存”以保存数据管道。 然后选择“运行”以运行数据管道并加载数据。

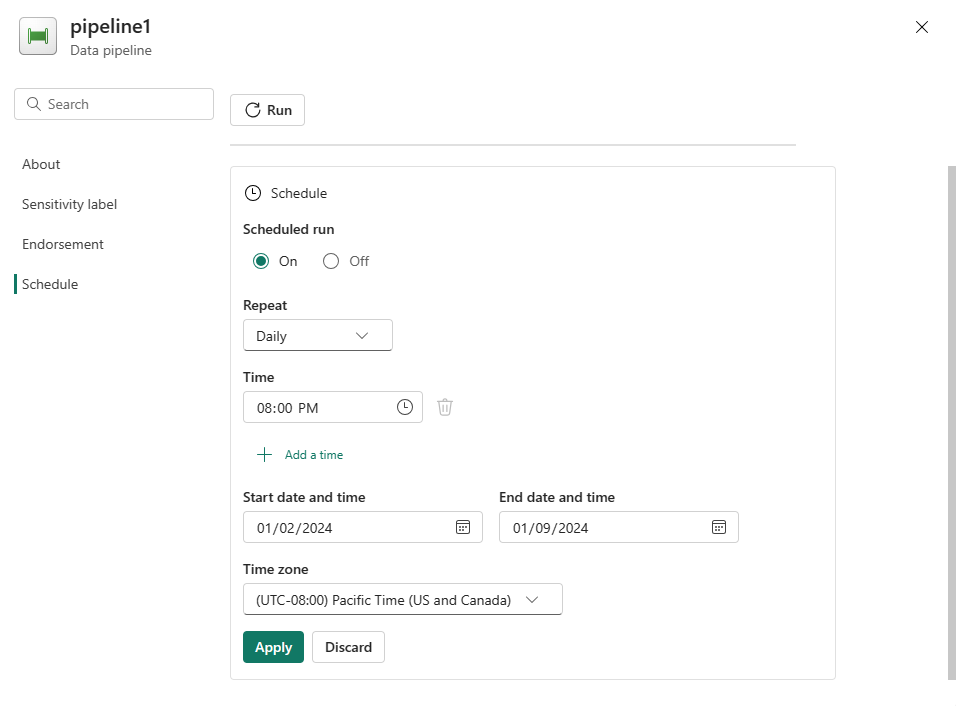

计划管道执行

完成管道的开发和测试后,可以计划它自动执行。

在管道编辑器窗口的“主页”选项卡上,选择“日程安排”。

根据需要配置计划。 此处的示例计划管道在每天晚上 8:00 执行,直到年底。

相关内容

此示例演示如何创建和配置 Dataflow Gen2 以创建合并查询,并将其存储在 Azure SQL 数据库中,然后将数据库中的数据复制到 Azure Blob 存储的文本文件中。 你已了解如何执行以下操作:

- 创建数据流。

- 使用数据流转换数据。

- 使用数据流创建数据管道。

- 对管道中的步骤执行进行排序。

- 使用复制助手复制数据。

- 运行和计划数据管道。

接下来,请继续了解有关监视管道运行的详细信息。

反馈

即将发布:在整个 2024 年,我们将逐步淘汰作为内容反馈机制的“GitHub 问题”,并将其取代为新的反馈系统。 有关详细信息,请参阅:https://aka.ms/ContentUserFeedback。

提交和查看相关反馈