OneLake,用于数据的 OneDrive

OneLake 是面向整个组织的统一逻辑数据湖。 与 OneDrive 一样,OneLake 也是每个 Microsoft Fabric 租户自动随附的,并且旨在成为所有分析数据的统一位置。 OneLake 为客户带来:

- 适用于整个组织的统一数据湖

- 与多个分析引擎配合使用的统一数据副本

适用于整个组织的统一数据湖

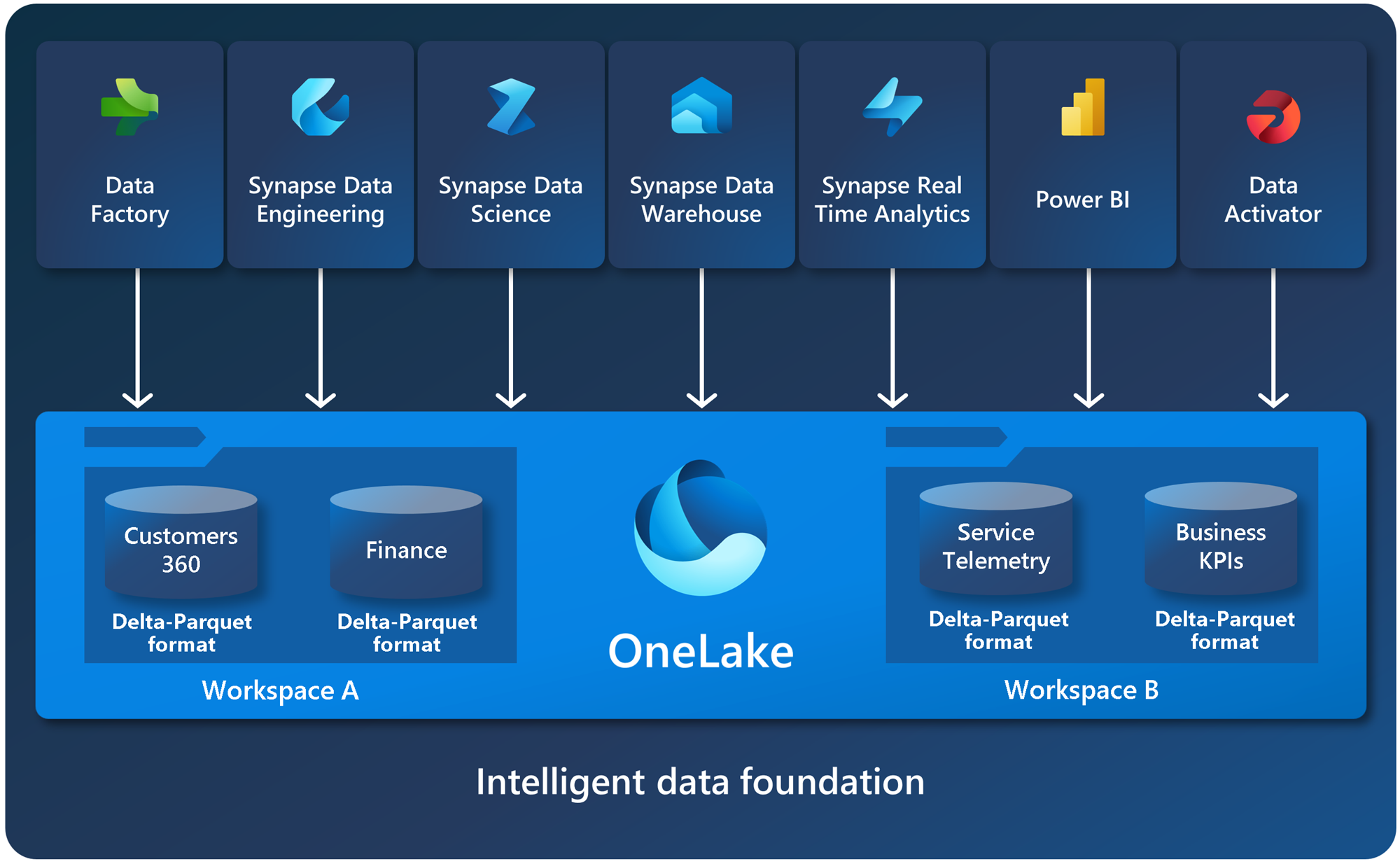

在 OneLake 推出之前,客户更容易为不同的业务组创建多个湖,而不是在单个湖上进行协作,即使管理多个资源会产生额外的开销。 OneLake 专注于通过改进协作来消除这些挑战。 每个客户租户只有一个 OneLake。 绝不会有多个数据湖,如果有 Fabric,则绝不会有零个。 每个 Fabric 租户都会自动预配 OneLake,无需额外的资源进行设置或管理。

默认使用分布式协作所有权进行管理

租户的概念是 SaaS 服务的独特优势。 了解客户组织的起点和终点有助于提供自然的治理和合规性边界,这由租户管理员进行控制。默认情况下,任何落入 OneLake 的数据都将受到治理。 虽然所有数据都在租户管理员设置的边界内,但重要的是,此管理员不会成为阻止组织其他部分参与 OneLake 的中央守护程序。

在租户中,可以创建任意数量的工作区。 工作区使组织的不同部分能够分配所有权和访问策略。 每个工作区都是绑定到特定区域的容量的一部分,并单独计费。

在工作区中,你可以创建数据项,OneLake 中的所有数据都需通过数据项进行访问。 与 Office 在 OneDrive 中存储 Word、Excel 和 PowerPoint 文件的方式类似,Fabric 在 OneLake 中存储湖房、仓库和其他项目。 数据项可以为每个角色提供定制体验,例如湖屋中的 Spark 开发人员体验。

有关如何开始使用 OneLake 的详细信息,请参阅使用 OneLake 创建湖屋。

在每个级别打开

OneLake 在每个级别都打开。 OneLake 基于 Azure Data Lake Storage (ADLS) Gen2 构建,可以支持任何类型的文件(无论是结构化还是非结构化的)。 所有 Fabric 数据项(如数据仓库和湖屋)都将以 Delta Parquet 格式自动将其数据存储在 OneLake 中。 如果数据工程师使用 Spark 将数据加载到湖屋,然后 SQL 开发人员使用 T-SQL 在纯事务性数据仓库中加载数据,那么二者均在参与构建相同的数据湖。 OneLake 以 Delta Parquet 格式存储所有表格数据。

OneLake 支持相同的 ADLS Gen2 API 和 SDK,以便与现有的 ADLS Gen2 应用程序(包括 Azure Databricks)兼容。 在 OneLake 中处理数据时,可以将它视为整个组织的一个大型 ADLS 存储帐户。 每个工作区都将显示为该存储帐户中的一个容器,不同的数据项将显示为这些容器中的文件夹。

有关 API 和终结点的详细信息,请参阅 OneLake 访问和 API。 有关 OneLake 与 Azure 集成的示例,请参阅 Azure Synapse Analytics、Azure 存储资源管理器、Azure Databricks 和 Azure HDInsight 文章。

适用于 Windows 的 OneLake 文件资源管理器

OneLake 是用于数据的 OneDrive。 与使用 OneDrive 时一样,你可以使用适用于 Windows 的 OneLake 文件资源管理器从 Windows 轻松浏览 OneLake 数据。 你可以像在 Office 中一样浏览所有工作区和数据项,从而轻松上传、下载或修改文件。 OneLake 文件资源管理器简化了数据湖的使用过程,甚至非技术业务用户都可以轻松使用。

有关详细信息,请参阅 OneLake 文件资源管理器。

统一的数据副本

OneLake 旨在从单个数据副本中为你提供最大的价值,而无需移动或复制数据。 你不再需要复制数据,即可将数据与另一个引擎一起使用或打破孤岛,以便使用来自其他源的数据来分析数据。

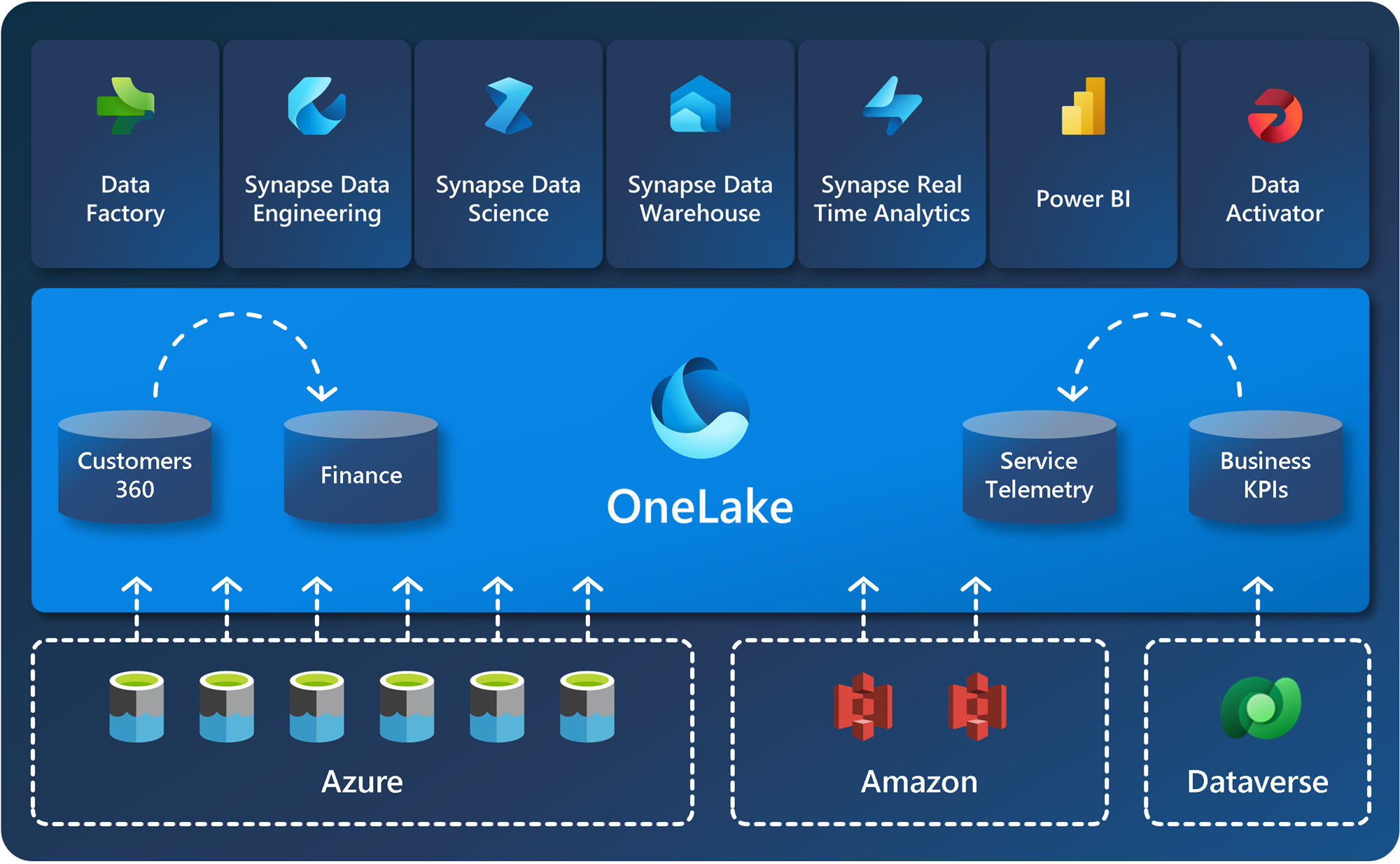

使用快捷方式可在不移动数据的情况下跨领域连接数据

借助快捷方式,组织可以轻松地在用户和应用程序之间共享数据,而无需不必要地移动和复制信息。 当团队在单独的工作区中独立工作时,快捷方式使你能够将不同业务组和域的数据合并到虚拟数据产品中,以满足用户的特定需求。

快捷方式是对存储在其他文件位置中的数据的引用。 这些文件位置可以位于同一工作区或跨不同工作区,可以位于 ADLS、S3 或 Dataverse 中的 OneLake 内或 OneLake 外部 - 很快将提供更多目标位置。 无论在哪个位置,快捷方式都能使文件和文件夹看起来像是存储在本地。

有关如何使用快捷方式的详细信息,请参阅 OneLake 快捷方式。

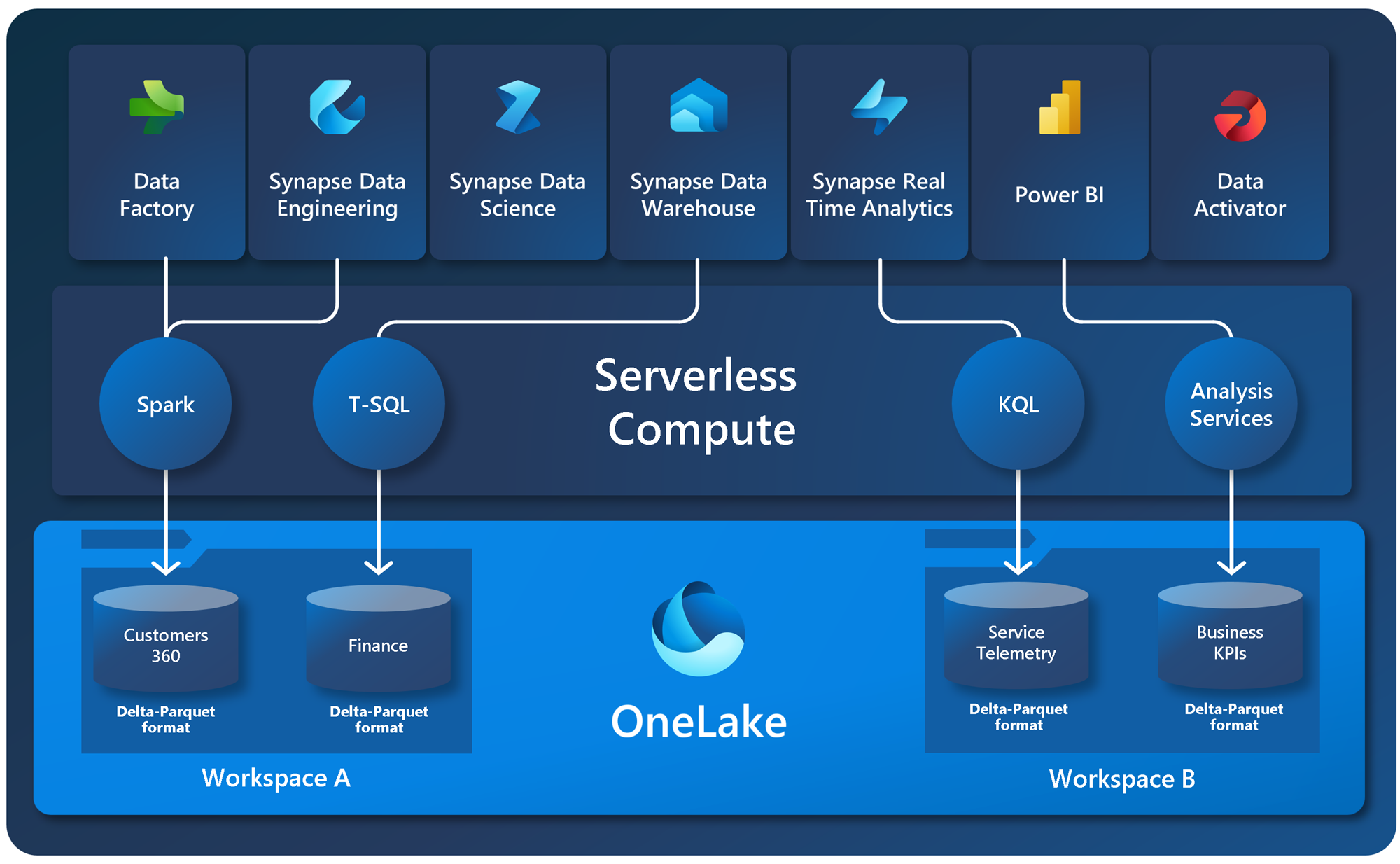

具有多个分析引擎的统一数据副本

尽管应用程序可能将存储和计算分离,但数据通常针对单个引擎进行优化,因此难以为多个应用程序重用相同的数据。 借助 Fabric,不同的分析引擎(T-SQL、Spark、Analysis Services 等)以开放 Delta Parquet 格式存储数据,从而允许跨多个引擎使用相同的数据。

不再需要复制数据,只需将其用于另一个引擎。 始终能够为尝试执行的作业选择最佳引擎。 例如,假设一个 SQL 工程师团队要构建一个纯事务性数据仓库。 他们可以使用 T-SQL 引擎和 T-SQL 的所有功能来创建表、转换数据并将数据加载到表。 如果数据科学家想要使用此数据,他们不再需要通过特殊的 Spark/SQL 驱动程序。 OneLake 以 Delta Parquet 格式存储所有数据。 数据科学家可以直接对数据使用 Spark 引擎及其开源库的全部功能。

企业用户可以在 Analysis Services 引擎中使用新的 Direct Lake 模式,直接基于 OneLake 生成 Power BI 报表。 Analysis Services 引擎可为 Power BI 语义模型提供支持,并且始终提供两种访问数据的模式:导入和直接查询。 Direct Lake 模式拥有完全不弱于导入模式的速度,但无需复制数据,兼具导入和直接查询的优点。 有关详细信息,请参阅 Direct Lake。

该示例示意图显示了如何使用 Spark 加载数据、使用 T-SQL 进行查询以及查看 Power BI 报表中的数据。

相关内容

反馈

即将发布:在整个 2024 年,我们将逐步淘汰作为内容反馈机制的“GitHub 问题”,并将其取代为新的反馈系统。 有关详细信息,请参阅:https://aka.ms/ContentUserFeedback。

提交和查看相关反馈