快速入門:使用 Azure 入口網站建立資料處理站

適用于:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

提示

試用 Microsoft Fabric 中的 Data Factory,這是適用于企業的單一分析解決方案。 Microsoft Fabric 涵蓋從資料移動到資料科學、即時分析、商業智慧和報告等所有專案。 瞭解如何 免費啟動新的試用版 !

本快速入門說明如何使用 Azure Data Factory Studio 或 Azure 入口網站 UI 來建立資料處理站。

注意

如果您不熟悉 Azure Data Factory,請參閱 Azure Data Factory 簡介,再嘗試本快速入門。

必要條件

Azure 訂用帳戶

如尚未擁有 Azure 訂用帳戶,請在開始之前先建立免費帳戶。

Azure 角色

若要瞭解建立資料處理站的 Azure 角色需求,請參閱 Azure 角色需求 。

建立資料處理站

Azure Data Factory Studio 中提供的快速建立體驗,可讓使用者在幾秒內建立資料處理站。 Azure 入口網站提供更進階的建立選項。

在 Azure Data Factory Studio 中快速建立

啟動 Microsoft Edge 或 Google Chrome 網頁瀏覽器。 目前只有 Microsoft Edge 和 Google Chrome 網頁瀏覽器才支援 Data Factory UI。

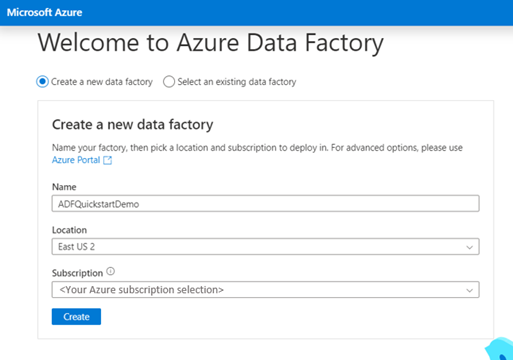

移至 Azure Data Factory 工作室,然後選擇 [建立新的資料處理站] 選項按鈕。

您可以使用預設值直接建立,或輸入唯一的名稱,並選擇建立新資料處理站時要使用的慣用位置和訂用帳戶。

建立之後,您可以直接輸入 Azure Data Factory Studio 的首頁。

在Azure 入口網站中建立進階

啟動 Microsoft Edge 或 Google Chrome 網頁瀏覽器。 目前只有 Microsoft Edge 和 Google Chrome 網頁瀏覽器才支援 Data Factory UI。

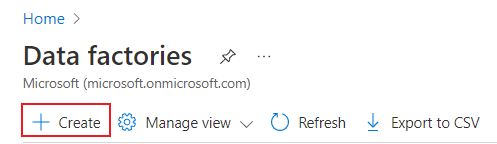

移至 [Azure 入口網站資料處理站] 頁面 。

登陸Azure 入口網站的資料處理站頁面之後,按一下 [ 建立 ]。

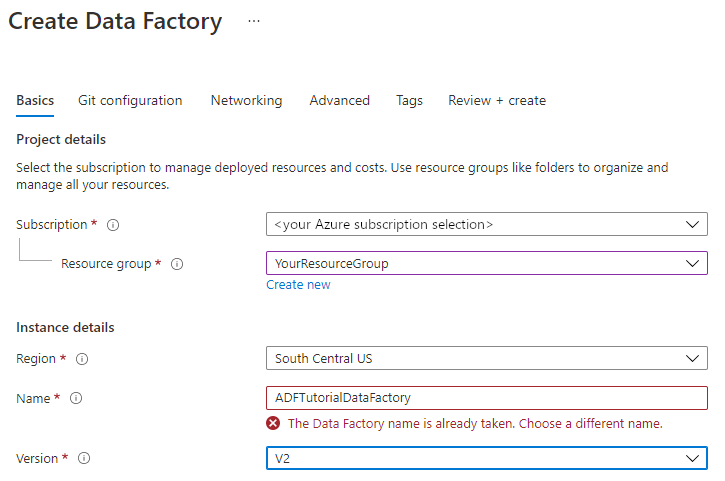

針對 資源群組 ,請採取下列步驟之一:

從下拉式清單中選取現有的資源群組。

選取 [ 新建 ],然後輸入新資源群組的名稱。

若要瞭解資源群組,請參閱 使用資源群組來管理您的 Azure 資源 。

針對 [ 區域 ],選取資料處理站的位置。

此清單只會顯示 Data Factory 支援的位置,以及 Azure Data Factory 中繼資料的儲存位置。 Data Factory 所使用的相關聯資料存放區(例如Azure 儲存體和 Azure SQL 資料庫)和計算(例如 Azure HDInsight)可以在其他區域中執行。

針對 [ 名稱 ],輸入 ADFTutorialDataFactory 。

Azure Data Factory 的名稱必須是 全域唯 一的。 如果您看到下列錯誤,請變更資料處理站的名稱(例如 < 您的名稱 > ADFTutorialDataFactory ),然後再試一次建立。 如需 Data Factory 成品的命名規則,請參閱 Data Factory - 命名規則 一文。

針對 [ 版本 ],選取 [V2 ]。

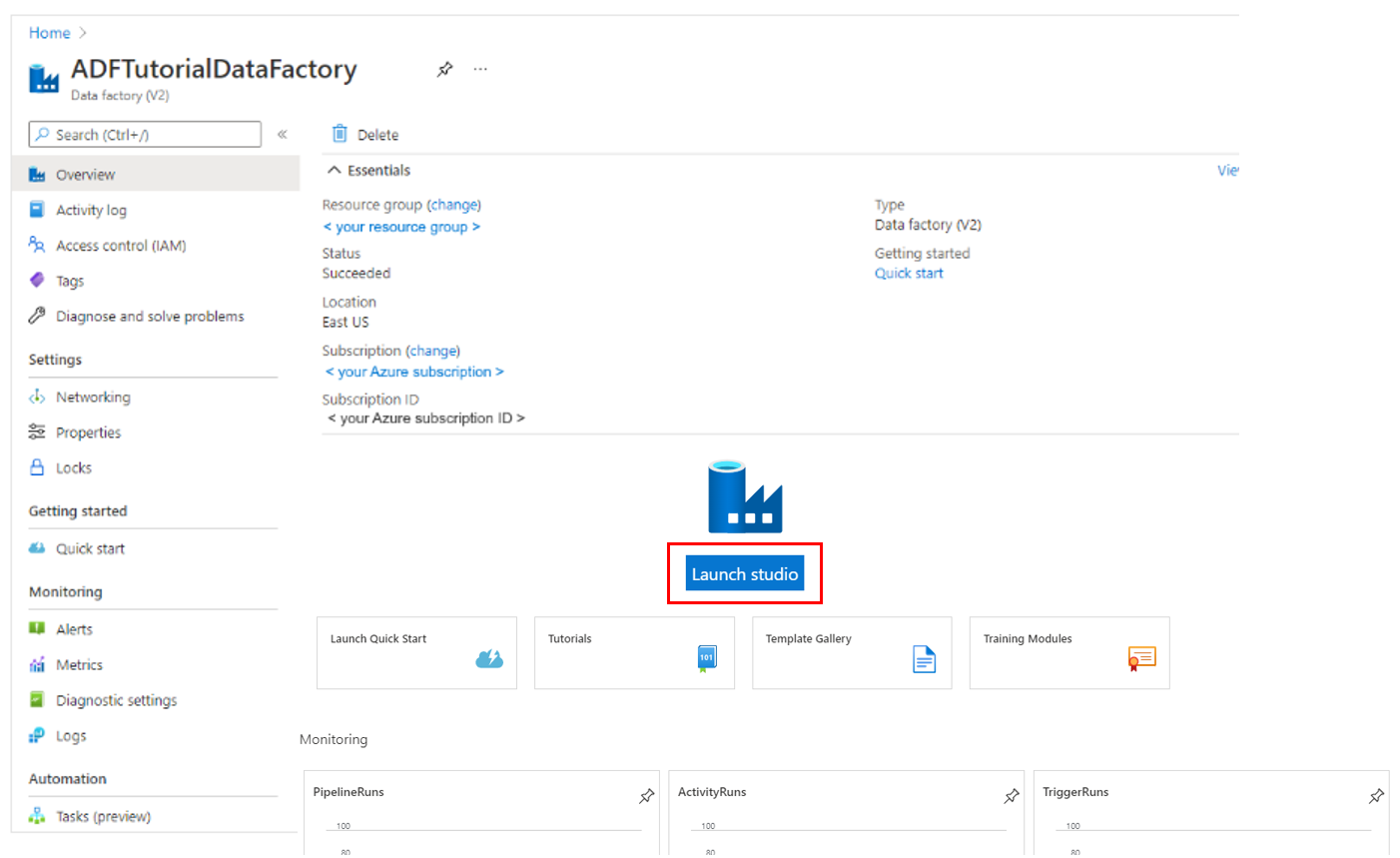

選取 [ 檢閱 + 建立 ],然後在驗證通過之後選取 [建立 ]。 建立完成後,選取 [移至資源 ] 以流覽至 Data Factory 頁面。

選取 [啟動 Studio ] 以開啟 Azure Data Factory Studio,以在不同的瀏覽器索引標籤上啟動 Azure Data Factory 使用者介面 (UI) 應用程式。

注意

如果您看到網頁瀏覽器卡在 「授權」,請清除 [ 封鎖協力廠商 Cookie 和網站資料 ] 核取方塊。 或保持選取狀態,建立 login.microsoftonline.com 的例外狀況,然後再次嘗試開啟應用程式。

相關內容

瞭解如何使用 Azure Data Factory,透過 Hello World - 如何複製資料 教學課程,將資料從某個位置複製到另一個位置。 精簡如何使用 Azure Data Factory 建立資料流程[data-flow-create.md]。