TDSP (Team Datová Věda Process) je agilní iterativní metodologie datových věd, kterou můžete použít k efektivnímu poskytování prediktivních analytických řešení a aplikací umělé inteligence. TDSP pomáhá zlepšit týmové spolupráce a učení tím, že navrhuje, jak týmové role spolupracují co nejlépe. TDSP zahrnuje osvědčené postupy a struktury od Microsoftu a dalších vedoucích pracovníků v oboru, které vašemu týmu pomůžou úspěšně implementovat iniciativy datových věd a plně si uvědomit výhody analytického programu.

Tento článek obsahuje přehled TDSP a jejích hlavních komponent. Obsahuje pokyny k implementaci TDSP pomocí nástrojů a infrastruktury Microsoftu. Podrobnější zdroje najdete v tomto článku.

Klíčové komponenty TDSP

TDSP má následující klíčové komponenty:

- Definice životního cyklu datových věd

- Standardizovaná struktura projektu

- Infrastruktura a zdroje doporučené pro projekty datových věd

- Nástroje a nástroje doporučené pro provádění projektu

Životní cyklus datových věd

TDSP poskytuje životní cyklus, který můžete použít ke strukturování vývoje projektů datových věd. Životní cyklus popisuje úplné kroky, které úspěšné projekty následují.

TDSP založený na úkolech můžete kombinovat s jinými životními cykly datových věd, jako je například standardní proces pro dolování dat (CRISP-DM), zjišťování znalostí v databázích (KDD) nebo jiný vlastní proces. Na vysoké úrovni mají tyto různé metodologie mnoho společného.

Tento životní cyklus byste měli použít, pokud máte projekt datových věd, který je součástí inteligentní aplikace. Inteligentní aplikace nasazují modely strojového učení nebo AI pro prediktivní analýzu. Tento proces můžete použít také pro průzkumné projekty datových věd a improvizované analytické projekty.

Životní cyklus TDSP se skládá z pěti hlavních fází, které váš tým provádí iterativním způsobem. Mezi tyto fáze patří:

Tady je vizuální znázornění životního cyklu TDSP:

Informace o cílech, úkolech a artefaktech dokumentace pro každou fázi najdete v tématu Životní cyklus procesu Datová Věda týmu.

Tyto úkoly a artefakty jsou přidružené k rolím projektu, například:

- Architekt řešení

- Vedoucí projektu.

- Datový inženýr.

- Odborník přes data.

- Vývojář aplikací.

- Vedoucí projektu

Následující diagram znázorňuje úkoly (modře) a artefakty (zeleně) přidružené ke každé fázi životního cyklu (na vodorovné ose) pro tyto role (na svislé ose).

Standardizovaná struktura projektu

Váš tým může použít infrastrukturu Azure k uspořádání prostředků datových věd.

Azure Machine Učení podporuje opensourcový MLflow. Pro řízení projektů datové vědy a AI doporučujeme používat MLflow. MLflow je navržený tak, aby spravil kompletní životní cyklus strojového učení. Trénuje a obsluhuje modely na různých platformách, takže můžete používat konzistentní sadu nástrojů bez ohledu na to, kde experimenty běží. MLflow můžete použít místně na počítači, ve vzdáleném cílovém výpočetním objektu, na virtuálním počítači nebo na počítači Učení výpočetní instanci.

MLflow se skládá z několika klíčových funkcí:

Sledování experimentů: Pomocí MLflow můžete sledovat experimenty, včetně parametrů, verzí kódu, metrik a výstupních souborů. Tato funkce vám pomůže efektivně porovnat různá spuštění a spravovat proces experimentování.

Kód balíčku: Nabízí standardizovaný formát pro balení kódu strojového učení, který zahrnuje závislosti a konfigurace. Tento balíček usnadňuje reprodukci spuštění a sdílení kódu s ostatními.

Správa modelů: MLflow poskytuje funkce pro správu a správu verzí modelů. Podporuje různé architektury strojového učení, takže můžete ukládat, verze a obsluhovat modely.

Obsluha a nasazení modelů: MLflow integruje možnosti obsluhy modelů a nasazení, takže můžete snadno nasazovat modely v různých prostředích.

Registrace modelů: Můžete spravovat životní cyklus modelu, včetně správy verzí, přechodů fází a poznámek. MLflow je užitečný pro udržování centralizovaného úložiště modelů v prostředí pro spolupráci.

Použijte rozhraní API a uživatelské rozhraní: V Azure je MLflow součástí rozhraní MACHINE Učení API verze 2, takže můžete pracovat se systémem prostřednictvím kódu programu. K interakci s uživatelským rozhraním můžete použít Azure Portal.

MLflow má za cíl zjednodušit a standardizovat proces vývoje strojového učení od experimentování po nasazení.

Strojové Učení se integruje s úložišti Git, takže můžete používat služby kompatibilní s Gitem: GitHub, GitLab, Bitbucket, Azure DevOps nebo jinou službu kompatibilní s Gitem. Kromě prostředků, které jsou již sledovány ve službě Machine Učení, může váš tým vyvíjet vlastní taxonomii ve službě kompatibilní s Gitem a ukládat další informace o projektu, například:

- Dokumentace

- Projekt, například sestava konečného projektu

- Datová sestava, například slovník dat nebo sestavy kvality dat

- Model, například sestavy modelů

- Kód

- Příprava dat

- Vývoj modelů

- Zprovoznění, včetně zabezpečení a dodržování předpisů

Infrastruktura a prostředky

TDSP poskytuje doporučení pro správu sdílených analýz a infrastruktury úložiště, jako jsou:

- Cloudové systémy souborů pro ukládání datových sad

- Databáze

- Clustery s velkými objemy dat, například SQL nebo Spark

- Služby strojového učení

Analytickou a datovou infrastrukturu úložiště můžete umístit do cloudu nebo místně, kde se ukládají nezpracované a zpracovávané datové sady. Tato infrastruktura umožňuje reprodukovatelnou analýzu. Brání také duplikaci, což může vést k nekonzistence a zbytečným nákladům na infrastrukturu. Infrastruktura obsahuje nástroje pro zřízení sdílených prostředků, jejich sledování a bezpečné připojení k těmto prostředkům každému členu týmu. Je také vhodné, aby členové projektu vytvářeli konzistentní výpočetní prostředí. Různé členy týmu pak můžou replikovat a ověřovat experimenty.

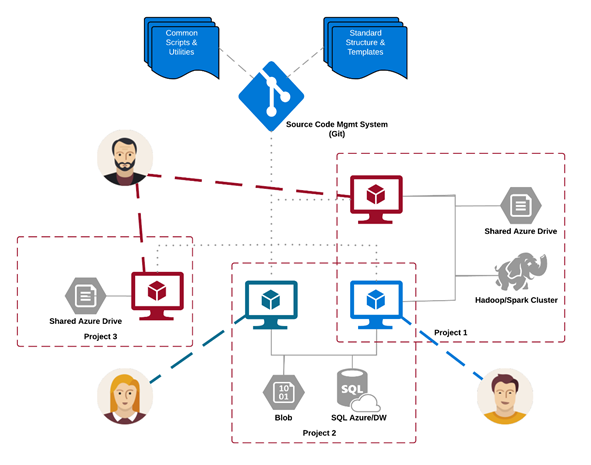

Tady je příklad týmu, který pracuje na několika projektech a sdílí různé komponenty infrastruktury cloudových analýz:

Nástroje

Ve většiněorganizacích Infrastruktura poskytuje nástroje pro implementaci TDSP a životního cyklu, které pomáhají snížit překážky a zvýšit konzistenci jejich přijetí.

Díky strojovému Učení můžou datoví vědci v rámci kanálu datové vědy nebo pracovního postupu použít opensourcové nástroje. V rámci strojového Učení Microsoft podporuje zodpovědné nástroje AI, které pomáhají dosáhnout zodpovědného standardu AI od Microsoftu.

Citace s hodnocením peer-reviewed

TDSP je dobře zavedená metodologie používaná napříč zapojeními Microsoftu, a proto byla zdokumentována a zkoumána v literaturě s hodnocením peer-review. Tyto citace poskytují příležitost prozkoumat funkce a aplikace TDSP. Seznam citací najdete na stránce s přehledem životního cyklu.