Générer des insights d’IA responsable dans l’interface utilisateur studio

Dans cet article, vous allez créer un tableau de bord et une carte de performance (préversion) d’IA responsable avec une expérience sans code dans l’interface utilisateur Azure Machine Learning studio.

Important

Cette fonctionnalité est actuellement disponible en préversion publique. Cette préversion est fournie sans contrat de niveau de service et n’est pas recommandée pour les charges de travail de production. Certaines fonctionnalités peuvent être limitées ou non prises en charge.

Pour plus d’informations, consultez Conditions d’Utilisation Supplémentaires relatives aux Évaluations Microsoft Azure.

Pour accéder à l’Assistant Génération de tableau de bord et générer un tableau de bord d’IA responsable, effectuez les étapes suivantes :

Inscrivez votre modèle dans Azure Machine Learning afin de pouvoir accéder à l’expérience sans code.

Dans le volet gauche d’Azure Machine Learning studio, sélectionnez l’onglet Modèles.

Sélectionnez le modèle enregistré pour lequel vous souhaitez créer des insights IA responsable, puis sélectionnez l’onglet Détails.

Sélectionnez Créer un tableau de bord IA responsable (préversion).

Pour connaître d’autres types de modèles pris en charge et limitations du tableau de bord d’IA responsable, consultez Scénarios pris en charge et limitations.

L’Assistant fournit une interface permettant d’entrer tous les paramètres nécessaires pour créer votre tableau de bord IA responsable sans avoir à toucher du code. L’expérience se déroule entièrement dans l’interface utilisateur Azure Machine Learning studio. Le studio présente un flux guidé et du texte d’instruction afin d’aider à contextualiser la variété de choix concernant les composants d’IA responsable avec lesquels vous souhaitez remplir votre tableau de bord.

L’Assistant est divisé en cinq sections :

- Jeux de données d’entraînement

- Jeu de données de test

- Tâche de modélisation

- Composants de tableau de bord

- Paramètres de composant

- Configuration de l’expérience

Sélectionner vos jeux de données

Dans les deux premières sections, vous sélectionnez le jeu de données d’entraînement et de test que vous avez utilisé quand vous avez entraîné votre modèle pour générer des insights de débogage de modèle. Pour des composants tels que l’analyse causale, qui ne nécessite pas de modèle, vous utilisez le jeu de données d’apprentissage pour effectuer l’apprentissage du modèle causal afin de générer les insights causales.

Notes

Seuls les formats de jeux de données tabulaires ML Table sont pris en charge.

Sélectionnez un jeu de données pour l’entraînement : dans la liste des jeux de données inscrits dans l’espace de travail Azure Machine Learning, sélectionnez le jeu de données que vous souhaitez utiliser pour générer des insights d’IA responsable pour des composants tels que des explications de modèle et une analyse des erreurs.

Sélectionnez un jeu de données pour les tests : dans la liste des jeux de données inscrits, sélectionnez le jeu de données que vous souhaitez utiliser pour remplir les visualisations de votre tableau de bord d’IA responsable.

Si le jeu de données d’entraînement ou de test que vous souhaitez utiliser n’est pas listé, sélectionnez Créer pour le charger.

Sélectionner votre tâche de modélisation

Après avoir sélectionné vos jeux de données, sélectionnez votre type de tâche de modélisation, comme illustré dans l’image suivante :

Sélectionner vos composants de tableau de bord

Le tableau de bord IA responsable offre deux profils pour les ensembles d’outils recommandés que vous pouvez générer :

Débogage de modèle : comprendre et déboguer les cohortes de données erronées dans votre modèle Machine Learning en utilisant l’analyse des erreurs, des exemples de simulation contrefactuelle et l’explicabilité du modèle.

Interventions réelles : Comprendre et déboguer les cohortes de données erronées dans votre modèle Machine Learning en utilisant l’analyse causale.

Notes

La classification multiclasse ne prend pas en charge le profil d’analyse d’interventions réelles.

- Sélectionnez le profil que vous souhaitez utiliser.

- Sélectionnez Suivant.

Configurer des paramètres pour les composants du tableau de bord

Après que vous avez sélectionné un profil, le volet de configuration Paramètres des composants pour le débogage de modèle pour les composants correspondants s’affiche.

Paramètres des composants pour le débogage de modèle :

Caractéristique cible (obligatoire) : spécifiez la caractéristique que votre modèle a appris à prédire.

Caractéristiques catégorielles : indiquez quelles caractéristique sont catégorielles afin de les afficher correctement en tant que valeurs catégorielles dans l’interface utilisateur du tableau de bord. Ce champ est préchargé pour vous en fonction des métadonnées de votre jeu de données.

Générer une arborescence d’erreurs et une carte thermique : activez ce bouton bascule afin de générer un composant d’analyse des erreurs pour votre tableau de bord IA responsable.

Caractéristiques de carte thermique d’erreur : sélectionnez jusqu’à deux caractéristiques pour pré-générer une carte thermique des erreurs.

Configuration avancée : spécifiez des paramètres supplémentaires, tels que Profondeur maximale de l’arborescence d’erreurs, Nombre de feuilles dans l’arborescence d’erreurs et Nombre minimal d’échantillons dans chaque nœud terminal.

Générer des exemples de simulation contrefactuelle : activez ce bouton bascule pour générer un composant de simulation contrefactuelle pour votre tableau de bord IA responsable.

Nombre de contrefactuels (obligatoire) : spécifiez le nombre d’exemples contrefactuels que vous souhaitez générer par point de données. Au moins 10 exemples doivent être générés pour permettre une vue sous forme de graphique à barres des caractéristiques qui ont été le plus perturbé en moyenne pour obtenir la prédiction souhaitée.

Plage de prédictions de valeurs (obligatoire) : spécifiez pour les scénarios de régression la plage dans laquelle vous souhaitez que les exemples contrefactuels aient des valeurs de prédiction. Pour les scénarios de classification binaire, la plage est automatiquement définie pour générer des contrefactuels pour la classe opposée de chaque point de données. Pour des scénarios de classification multiple, utilisez la liste déroulante pour spécifier la classe dans laquelle vous souhaitez que chaque point de données soit prédit.

Spécifier les caractéristiques à perturber : par défaut, toutes les caractéristiques seront perturbées. Toutefois, si vous souhaitez que seules des caractéristiques spécifiques soient perturbées, sélectionnez Spécifier les caractéristiques à perturber pour générer des explications contrefactuelles afin d’afficher un volet contenant une liste de caractéristiques à sélectionner.

Lorsque vous sélectionnez Spécifier les caractéristiques à perturber, vous pouvez spécifier la plage dans laquelle vous souhaitez autoriser les perturbations. Par exemple : pour la caractéristique YOE (Années d’expérience), spécifiez que les contrefactuels doivent avoir uniquement des valeurs de caractéristiques de 10 à 21, au lieu des valeurs par défaut de 5 à 21.

Générer des explications : activez ce bouton bascule pour générer un composant d’explication de modèle pour votre tableau de bord d’IA responsable. Aucune configuration n’est nécessaire, car un explicateur d’imitation de zone opaque par défaut sera utilisé pour générer les importances des caractéristiques.

Autrement, si vous sélectionnez le profil Interventions réelles, vous verrez l’écran suivant générer une analyse causale. Cela vous aidera à comprendre les effets de causalité des caractéristiques que vous souhaitez « traiter » sur un certain résultat que vous souhaitez optimiser.

Les paramètres des composants pour les interventions réelles utilisent une analyse causale. Effectuez les actions suivantes :

- Caractéristique cible (obligatoire) : choisissez le résultat pour lequel vous souhaitez calculer les effets causals.

- Caractéristiques de traitement (obligatoire) : choisissez une ou plusieurs caractéristiques que vous souhaitez changer (« traiter ») pour optimiser le résultat cible.

- Caractéristiques catégorielles : indiquez quelles caractéristique sont catégorielles afin de les afficher correctement en tant que valeurs catégorielles dans l’interface utilisateur du tableau de bord. Ce champ est préchargé pour vous en fonction des métadonnées de votre jeu de données.

- Paramètres avancés : spécifiez des paramètres supplémentaires pour votre analyse causale, comme des caractéristiques hétérogènes (caractéristiques supplémentaires pour comprendre la segmentation causale dans votre analyse en plus de vos caractéristiques de traitement) et le modèle causal à utiliser.

Configurer votre expérience

Pour finir, configurez votre expérience afin de lancer un travail pour générer votre tableau de bord d’IA responsable.

Dans le volet Configuration d’un travail d’entraînement ou d’une expérience, effectuez les étapes suivantes :

- Nom : donnez un nom unique à votre tableau de bord afin de pouvoir le différencier lorsque vous affichez la liste des tableaux de bord pour un modèle donné.

- Nom de l’expérience : sélectionnez une expérience existante dans laquelle exécuter le travail, ou créez une nouvelle expérience.

- Expérience existante : dans la liste déroulante, sélectionnez une expérience existante.

- Sélectionner le type de calcul : spécifiez le type de calcul que vous souhaitez utiliser pour exécuter votre travail.

- Sélectionnez le calcul : dans la liste déroulante, sélectionnez le calcul que vous souhaitez utiliser. S’il n’existe aucune ressource de calcul existante, sélectionnez le signe plus (+) pour créer une ressource de calcul, puis actualisez la liste.

- Description : ajoutez une description plus longue pour votre tableau de bord IA responsable.

- Étiquettes : ajoutez des étiquettes à ce tableau de bord d’IA responsable.

Une fois votre expérience configurée, sélectionnez Créer pour démarrer la génération de votre tableau de bord IA responsable. Vous serez redirigé vers la page d’expérience pour suivre la progression de votre travail avec un lien vers le tableau de bord d’IA responsable généré à partir de la page du travail, à l’issue de l’opération.

Pour savoir comment voir et utiliser votre tableau de bord d’IA responsable, consultez Utiliser le tableau de bord d’IA responsable dans Azure Machine Learning studio.

Comment générer une carte de performance d’IA responsable (préversion) ?

Quand vous avez créé un tableau de bord, vous pouvez utiliser une interface utilisateur sans code dans Azure Machine Learning studio pour personnaliser et générer une carte de performance d’IA responsable. Ceci vous permet de partager des insights clés pour un déploiement responsable de votre modèle (par exemple, l’impartialité et l’importance d’une caractéristique) avec des parties prenantes techniques et non techniques. Comme pour la création d’un tableau de bord, vous pouvez effectuer les étapes suivantes pour accéder à l’Assistant Génération de carte de performance :

- Accédez à l’onglet Modèles à partir de la barre de navigation gauche dans Azure Machine Learning studio.

- Sélectionnez le modèle inscrit pour lequel vous souhaitez créer une carte de performance et sélectionnez l’onglet IA responsable.

- Dans le panneau supérieur, sélectionnez Créer des insights d’intelligence artificielle responsable (préversion), puis Générer une carte de performance au format PDF.

L’Assistant vous permet de personnaliser votre carte de performance PDF sans programmation. L’expérience se déroule entièrement dans Azure Machine Learning studio : un flux guidé et des instructions textuelles contextualisent la variété de choix de l’interface utilisateur et vous aident à choisir les composants avec lesquels vous souhaitez remplir votre carte de performance. L’Assistant inclut sept étapes. Une huitième étape (évaluation de l’impartialité) est proposée uniquement pour les modèles avec des caractéristiques catégorielles :

- Résumé de la carte de performance PDF

- Performances du modèle

- Sélection de l’outil

- Analyse de données (précédemment appelée l’explorateur de données)

- Analyse causale

- Interprétabilité

- Configuration de l’expérience

- Évaluation de l’impartialité (uniquement en présence de caractéristiques catégorielles)

Configuration de votre carte de performance

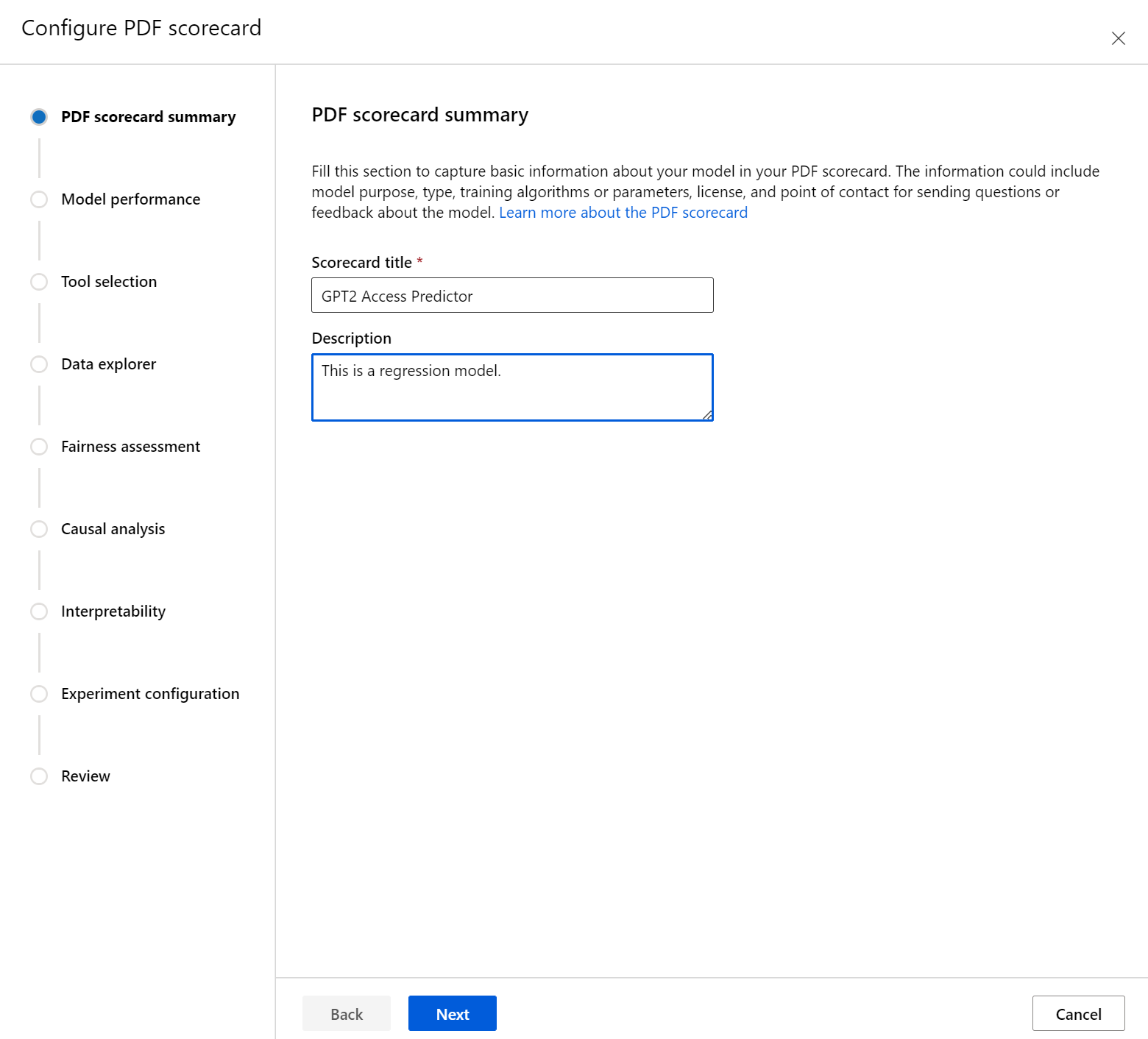

Tout d’abord, entrez un titre descriptif pour votre carte de performance. Si vous le souhaitez, vous pouvez également entrer une description des fonctionnalités du modèle, des données avec lesquelles il a été entraîné et évalué, du type d’architecture, etc.

La section Niveau de performance du modèle vous permet d’incorporer des métriques d’évaluation de modèle standard dans votre carte de performance et de définir les valeurs cibles souhaitées pour les métriques sélectionnées. Sélectionnez les métriques de performance souhaitées (jusqu’à trois) et les valeurs cibles à l’aide des listes déroulantes.

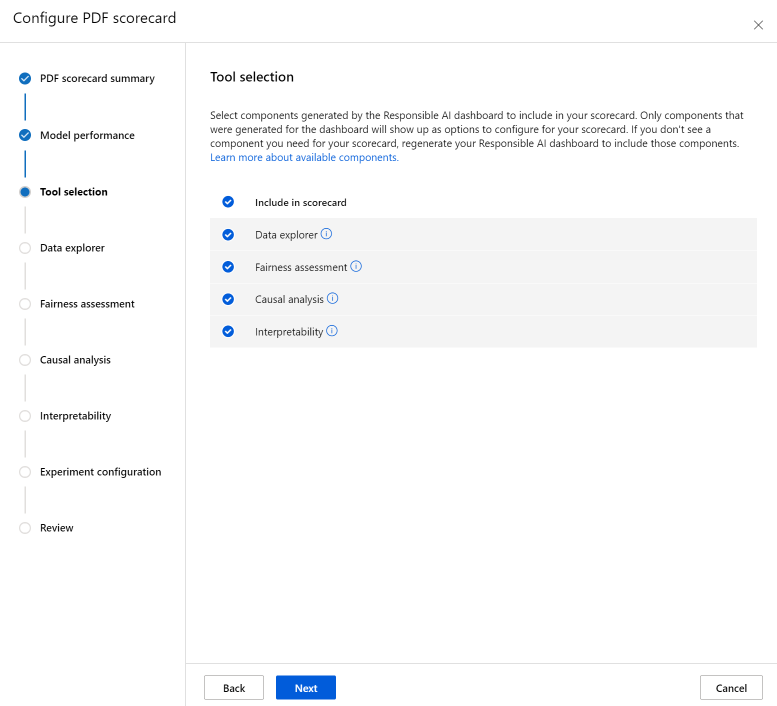

L’étape Sélection de l’outil vous permet de choisir les composants suivants que vous souhaitez inclure dans votre carte de performance. Cochez Inclure dans la carte de performance pour inclure tous les composants ou cochez/décochez chaque composant individuellement. Sélectionnez l’icône d’information (« i » dans un cercle) en regard des composants pour en savoir plus.

La section Analyse de données (précédemment appelée l’explorateur de données) permet d’effectuer une analyse de cohortes. Vous pouvez ainsi identifier les problèmes de surreprésentation et de sous-représentation, explorer la façon dont les données sont clusterisées dans le jeu de données et découvrir comment les prédictions de modèle impactent des cohortes de données spécifiques. Utilisez les cases à cocher dans la liste déroulante pour sélectionner les caractéristiques qui vous intéressent et ainsi identifier la performance de votre modèle vis-à-vis des cohortes sous-jacentes.

La section Évaluation de l’impartialité peut vous aider à évaluer les groupes de personnes qui peuvent être impactés négativement par les prédictions d’un modèle Machine Learning. Cette section comporte deux champs.

Caractéristiques sensibles : Identifiez un ou plusieurs attributs sensibles de votre choix (par exemple, l’âge ou le sexe) en hiérarchisant jusqu’à 20 sous-groupes à explorer et comparer.

Métrique d’assez-juste : Sélectionnez une métrique d’impartialité convenant à votre configuration (par exemple, différence de justesse ou rapport taux d’erreur), puis identifiez la ou les valeurs cibles souhaitées pour les métriques d’impartialité sélectionnées. La métrique d’impartialité sélectionnée (associée à la différence ou au rapport sélectionné avec le bouton bascule) capture la différence ou le rapport entre les valeurs extrêmes entre les sous-groupes. (max - min ou max/min).

Remarque

L’évaluation de l’impartialité n’est actuellement disponible que pour les attributs sensibles catégoriels tels que le sexe.

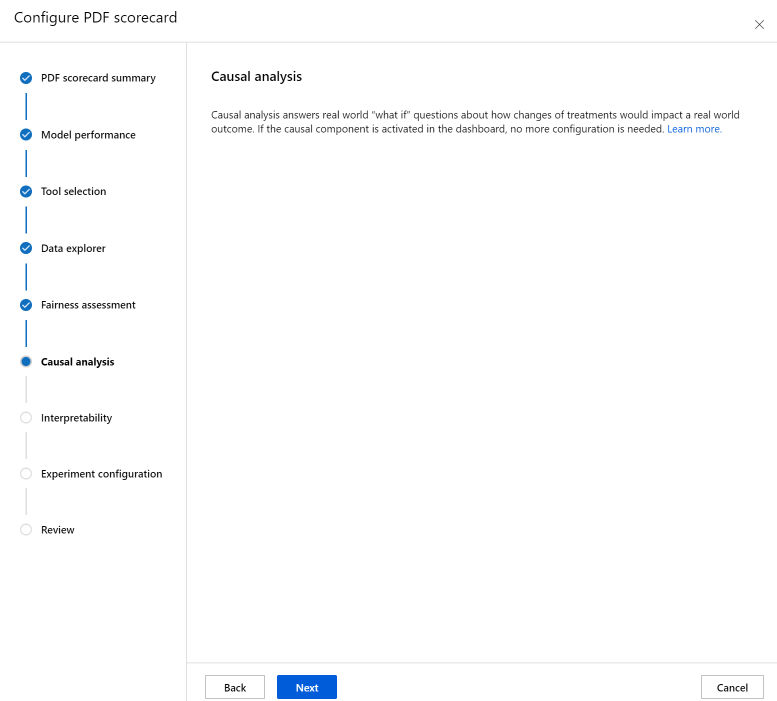

La section Analyse causale répond à des questions du monde réel du type « que se passerait-il si », c’est-à-dire comment des changements de traitements impacteraient un résultat dans le monde réel. Si le composant causal est activé dans le tableau de bord d’IA responsable pour lequel vous générez une carte de performance, aucune autre configuration n’est nécessaire.

La section Interprétabilité génère des descriptions compréhensibles par l’homme des prédictions effectuées par votre modèle Machine Learning. À l’aide des explications sur votre modèle, vous pouvez comprendre le raisonnement derrière les décisions qu’il prend. Sélectionnez le nombre (K) de caractéristiques que vous souhaitez voir, impactant le plus les prédictions globales de votre modèle. La valeur de K par défaut est 10.

Enfin, configurez votre expérience afin de lancer un travail pour générer votre carte de performance. Ces configurations sont identiques à celles de votre tableau de bord d’IA responsable.

Enfin, vérifiez vos configurations et sélectionnez Créer pour démarrer votre travail.

Après avoir démarré votre travail, vous serez redirigé vers la page d’expérience pour suivre sa progression. Pour savoir comment voir et utiliser votre carte de performance d’IA responsable, consultez Utiliser une carte de performance d’IA responsable (préversion).

Étapes suivantes

- Une fois votre tableau de bord IA responsable généré, découvrez comment y accéder et l’utiliser dans Azure Machine Learning studio.

- Apprenez-en davantage sur les concepts et les techniques du tableau de bord d’IA responsable.

- Découvrez comment collecter des données de manière responsable.

- Apprenez-en davantage sur la façon d’utiliser le tableau de bord IA responsable et la carte de performance pour déboguer des données et des modèles, et mieux éclairer la prise de décisions dans ce billet de blog de la communauté technique.

- Découvrez comment le tableau de bord IA responsable et la carte de performance ont été utilisés par le UK National Health Service (NHS) dans un témoignage client réel.

- Explorez les fonctionnalités du tableau de bord IA responsable via cette démonstration web interactive du Laboratoire d’IA.