Machine Learning - Évaluer

Important

Le support de Machine Learning Studio (classique) prend fin le 31 août 2024. Nous vous recommandons de passer à Azure Machine Learning avant cette date.

À partir du 1er décembre 2021, vous ne pourrez plus créer de nouvelles ressources Machine Learning Studio (classique). Jusqu’au 31 août 2024, vous pouvez continuer à utiliser les ressources Machine Learning Studio (classique) existantes.

- Consultez les informations sur le déplacement des projets de machine learning de ML Studio (classique) à Azure Machine Learning.

- En savoir plus sur Azure Machine Learning.

La documentation ML Studio (classique) est en cours de retrait et ne sera probablement plus mise à jour.

Cet article décrit les modules de Machine Learning Studio (classique) que vous pouvez utiliser pour évaluer un modèle Machine Learning. L’évaluation du modèle est effectuée une fois l’entraînement terminé, pour mesurer la précision des prédictions et évaluer l’ajustement du modèle.

Notes

S’applique à : Machine Learning Studio (classique) uniquement

Des modules par glisser-déposer similaires sont disponibles dans Concepteur Azure Machine Learning.

Cet article décrit également le processus global dans Machine Learning Studio (classique) pour la création de modèles, l’entraînement, l’évaluation et le scoring.

Créer et utiliser des modèles Machine Learning dans Machine Learning Studio (classique)

Le flux de travail classique pour Le Machine Learning inclut ces phases :

- Choisissez un algorithme approprié et définissez les options initiales.

- Entraîner le modèle à l’aide de données compatibles.

- Créez des prédictions à l’aide de nouvelles données basées sur les modèles du modèle.

- Évaluez le modèle pour déterminer si les prédictions sont précises, la quantité d’erreur et si le surfictage se produit.

Machine Learning Studio (classique) prend en charge une infrastructure flexible et personnalisable pour le Machine Learning. Chaque tâche de ce processus est effectuée par un type spécifique de module. Le module peut être modifié, ajouté ou supprimé sans interrompre le reste de votre expérience.

Utilisez les modules de cette catégorie pour évaluer un modèle existant. L’évaluation du modèle nécessite généralement un certain type de jeu de données de résultat. Si vous n’avez pas de jeu de données d’évaluation, vous pouvez générer des résultats en scoring. Vous pouvez également utiliser un jeu de données de test, ou un autre ensemble de données qui contient la « vérité de base » ou les résultats attendus connus.

En savoir plus sur l’évaluation du modèle

En général, lors de l’évaluation d’un modèle, vos options dépendent du type de modèle que vous évaluez et de la métrique que vous souhaitez utiliser. Ces rubriques répertorient certaines des métriques les plus fréquemment utilisées :

Machine Learning Studio (classique) fournit également une variété de visualisations, selon le type de modèle que vous utilisez et le nombre de classes que votre modèle prédit. Pour obtenir de l’aide sur la recherche de ces visualisations, consultez Afficher les métriques d’évaluation.

L’interprétation de ces statistiques nécessite souvent une meilleure compréhension de l’algorithme particulier sur lequel le modèle a été formé. Pour obtenir une bonne explication de la façon d’évaluer un modèle et comment interpréter les valeurs retournées pour chaque mesure, voir Comment évaluer les performances du modèle dans Machine Learning.

Liste des modules

La Machine Learning - Évaluer la catégorie inclut les modules suivants :

Modèle de validation croisée : valide les estimations de paramètres pour les modèles de classification ou de régression en partitionnant les données.

Utilisez le module Modèle de validation croisée si vous souhaitez tester la validité de votre jeu d’entraînement et du modèle. La validation croisée partitionne les données en plis, puis teste plusieurs modèles sur des combinaisons de plis.

Évaluer le modèle : évalue une classification ou un modèle de régression marqué à l’aide de métriques standard.

Dans la plupart des cas, vous allez utiliser le module Évaluer le modèle générique. Cela est particulièrement vrai si votre modèle est basé sur l’un des algorithmes de classification ou de régression pris en charge.

Évaluer le recommandeur : évalue la précision des prédictions de modèle de recommandation.

Pour les modèles de recommandation, utilisez le module Évaluer le recommandeur .

Tâches associées

- Pour les modèles de clustering, utilisez le module Affecter des données aux clusters . Ensuite, utilisez les visualisations de ce module pour afficher les résultats de l’évaluation.

- Vous pouvez créer des métriques d’évaluation personnalisées. Pour créer des métriques d’évaluation personnalisées, fournissez du code R dans le module Exécuter un script R ou du code Python dans le module Exécuter un script Python . Cette option est pratique si vous souhaitez utiliser des métriques publiées dans le cadre de bibliothèques open source ou si vous souhaitez concevoir votre propre métrique pour mesurer la précision du modèle.

Exemples

L’interprétation des résultats de l’évaluation du modèle Machine Learning est un art. Il nécessite de comprendre les résultats mathématiques, en plus des données et des problèmes métier. Nous vous recommandons de consulter ces articles pour obtenir une explication de l’interprétation des résultats dans différents scénarios :

- Choisissez des paramètres pour optimiser vos algorithmes dans Machine Learning

- Interpréter les résultats du modèle dans Machine Learning

- Évaluer les performances du modèle dans Machine Learning

Notes techniques

Cette section contient des détails, des conseils et des réponses aux questions fréquentes concernant l’implémentation.

Afficher les métriques d’évaluation

Découvrez où rechercher dans Machine Learning Studio (classique) pour rechercher les graphiques de métriques pour chaque type de modèle.

Modèles de classification à deux classes

La vue par défaut pour les modèles de classification binaire inclut un graphique ROC interactif et une table de valeurs pour les métriques principales.

Vous avez deux options pour afficher les modèles de classification binaire :

- Cliquez avec le bouton droit sur la sortie du module, puis sélectionnez Visualiser.

- Cliquez avec le bouton droit sur le module, sélectionnez Résultats de l’évaluation, puis visualisez.

Vous pouvez également utiliser le curseur pour modifier la valeur seuil de probabilité. Le seuil détermine si un résultat doit être accepté comme vrai ou non. Ensuite, vous pouvez voir comment ces valeurs changent.

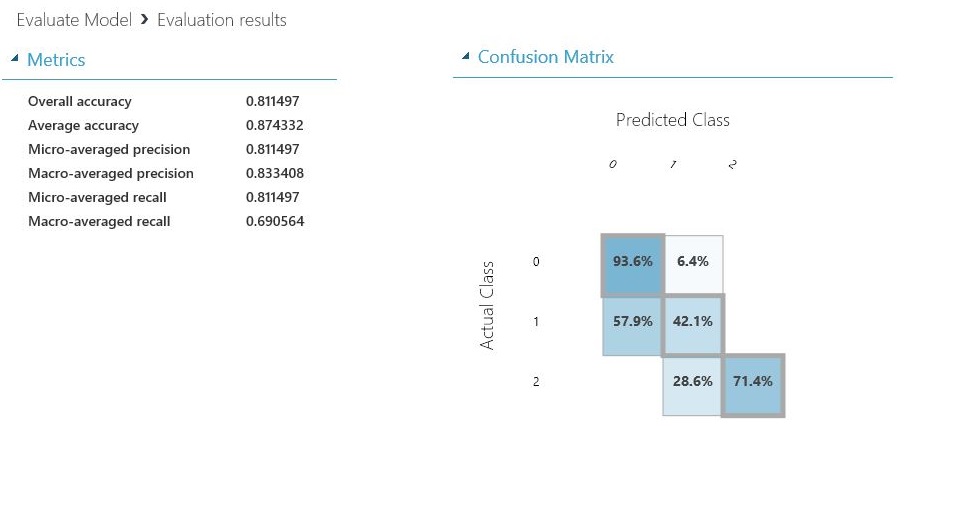

Modèles de classification multiclasse

L’affichage des métriques par défaut pour les modèles de classification multiclasse inclut une matrice de confusion pour toutes les classes et un ensemble de métriques pour le modèle dans son ensemble.

Vous avez deux options pour afficher les modèles de classification multiclasse :

- Cliquez avec le bouton droit sur la sortie du module, puis sélectionnez Visualiser.

- Cliquez avec le bouton droit sur le module, sélectionnez Résultats de l’évaluation, puis visualisez.

Pour plus de simplicité, voici les deux résultats, affichés côte à côte :

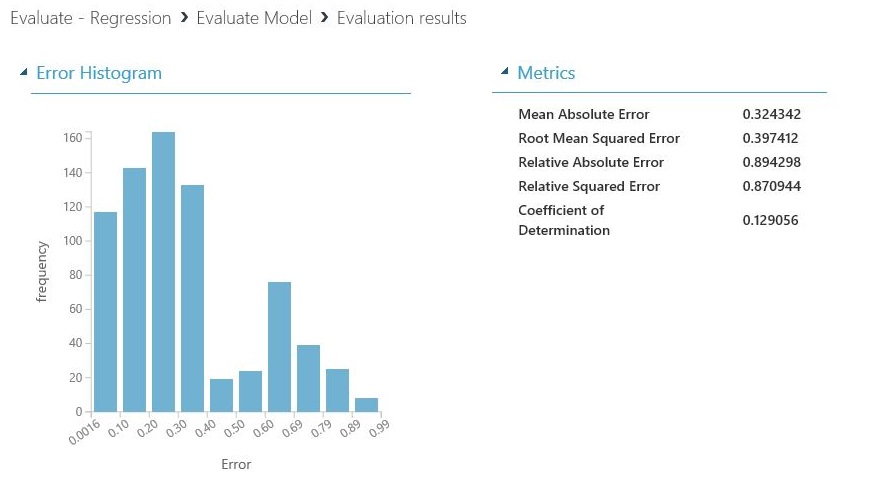

Modèles de régression

L’affichage des métriques pour les modèles de régression varie selon le type de modèle que vous avez créé. L’affichage des métriques est basé sur les interfaces d’algorithme sous-jacentes et sur le meilleur ajustement pour les métriques de modèle.

Vous avez deux options pour afficher les modèles de régression :

- Pour afficher les métriques de précision dans un tableau, cliquez avec le bouton droit sur la sortie du module Évaluer le modèle, puis sélectionnez Visualiser.

- Pour afficher un histogramme d’erreur avec les valeurs, cliquez avec le bouton droit sur le module, sélectionnez Résultats d’évaluation, puis sélectionnez Visualiser.

La vue Histogramme d’erreur peut vous aider à comprendre comment l’erreur est distribuée. Il est fourni pour les types de modèle suivants et inclut une table des métriques par défaut, telles que l’erreur carrée racine (RMSE).

Les modèles de régression suivants génèrent une table des métriques par défaut, ainsi que certaines métriques personnalisées :

- Bayesian Linear Regression

- Régression de forêt d’arbres décisionnels

- Régression quantile de forêt rapide

- Ordinal Regression

Astuces pour utiliser les données

Pour extraire les nombres sans copier et coller à partir de l’interface utilisateur Machine Learning Studio (classique), vous pouvez utiliser la nouvelle bibliothèque PowerShell pour Machine Learning. Vous pouvez obtenir des métadonnées et d’autres informations pour une expérience entière ou à partir de modules individuels.

Pour extraire des valeurs d’un module Évaluer un modèle, vous devez ajouter un commentaire unique au module pour faciliter l’identification. Utilisez ensuite l’applet de commande Download-AmlExperimentNodeOutput pour obtenir les métriques et leurs valeurs à partir de la visualisation au format JSON.

Pour plus d’informations, consultez Créer des modèles Machine Learning à l’aide de PowerShell.