Mi az a Databricks Csatlakozás?

Feljegyzés

Ez a cikk a Databricks Runtime 13.0-s és újabb verziókhoz készült Databricks Csatlakozás ismerteti.

A Databricks Csatlakozás örökölt verziójáról további információt a Databricks Runtime 12.2 LTS-hez készült Databricks Csatlakozás és alább talál.

- A cikk kihagyásához és a Pythonhoz készült Databricks Csatlakozás használatának megkezdéséhez tekintse meg a Pythonhoz készült Databricks Csatlakozás.

- A cikk kihagyásához és az R-hez készült Databricks Csatlakozás használatának megkezdéséhez tekintse meg az R-hez készült Databricks Csatlakozás.

- A cikk kihagyásához és a Scalához készült Databricks Csatlakozás használatának megkezdéséhez tekintse meg a Scala Databricks Csatlakozás című cikket.

Áttekintés

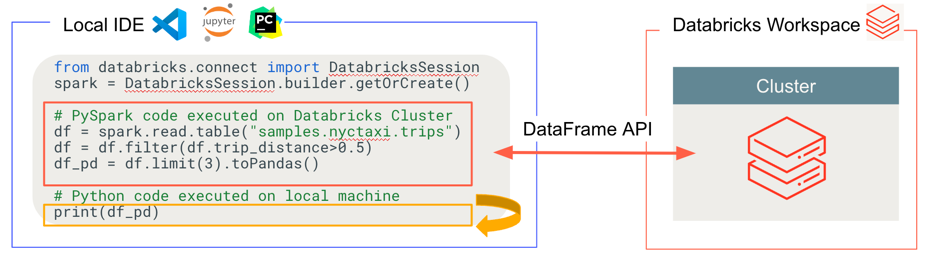

A Databricks Csatlakozás lehetővé teszi olyan népszerű azonosítók csatlakoztatását, mint a Visual Studio Code, a PyCharm, az RStudio Desktop, az IntelliJ IDEA, a notebook-kiszolgálók és más egyéni alkalmazások az Azure Databricks-fürtökhöz. Ez a cikk a Databricks Csatlakozás működését ismerteti.

A Databricks Csatlakozás a Databricks Runtime ügyfélkódtára. Lehetővé teszi kód írását Spark API-k használatával, és távolról futtathatja őket egy Azure Databricks-fürtön a helyi Spark-munkamenet helyett.

Ha például a DataFrame parancsot spark.read.format(...).load(...).groupBy(...).agg(...).show() a Databricks Csatlakozás használatával futtatja, a rendszer elküldi a parancs logikai ábrázolását az Azure Databricksben futó Spark-kiszolgálónak a távoli fürt végrehajtásához.

A Databricks Csatlakozás a következőt teheti:

Nagy méretű Spark-kódot futtathat bármely Python-, R- vagy Scala-alkalmazásból.

import pysparkA Pythonhoz,library(sparklyr)az R-hez vagyimport org.apache.sparka Scalához bárhol futtathatja a Spark-kódot közvetlenül az alkalmazásból anélkül, hogy ide beépülő modulokat kellene telepítenie, vagy Spark-beküldési szkripteket kellene használnia.Feljegyzés

A Databricks-Csatlakozás a Databricks Runtime 13.0-s és újabb verziója támogatja a Python-alkalmazások futtatását. Az R és a Scala csak a Databricks Csatlakozás a Databricks Runtime 13.3 LTS és újabb verziókban támogatott.

A kód hibakeresése és végrehajtása az IDE-ben akkor is, ha távoli fürttel dolgozik.

A kódtárak fejlesztésekor gyorsan iterál. A Databricks-Csatlakozás Python- vagy Scala-kódtár-függőségeinek módosítása után nem kell újraindítania a fürtöt, mert minden ügyfél-munkamenet el van különítve egymástól a fürtben.

Inaktív fürtök leállítása a munka elvesztése nélkül. Mivel az ügyfélalkalmazás leválasztva van a fürtről, a fürt újraindítása vagy frissítései nem érintik, ami általában a jegyzetfüzetben definiált összes változót, RDD-t és DataFrame-objektumot elveszíti.

A Databricks Runtime 13.3 LTS-hez és újabb verziókhoz a Databricks Csatlakozás már nyílt forráskódú Spark-Csatlakozás épül. A Spark Csatlakozás egy leválasztott ügyfél-kiszolgáló architektúrát vezet be az Apache Sparkhoz, amely lehetővé teszi a Spark-fürtökhöz való távoli kapcsolódást a DataFrame API használatával, és a feloldatlan logikai terveket protokollként. A Spark Csatlakozás alapuló "V2" architektúrával a Databricks Csatlakozás egyszerű és könnyen használható vékony ügyfél lesz. A Spark Csatlakozás mindenhol beágyazhatók az Azure Databrickshez való csatlakozáshoz: azonosítókban, jegyzetfüzetekben és alkalmazásokban, így az egyes felhasználók és partnerek egyaránt új (interaktív) felhasználói élményt hozhatnak létre a Databricks platform alapján. A Spark Csatlakozás a Spark Csatlakozás bemutatása című témakörben talál további információt.

A Databricks Csatlakozás határozza meg a kód futtatásának és hibakeresésének helyét az alábbi ábrán látható módon.

Kód futtatásához: Minden kód helyileg fut, míg a DataFrame-műveleteket tartalmazó összes kód a távoli Azure Databricks-munkaterület fürtjén fut, és a futtatási válaszok vissza lesznek küldve a helyi hívónak.

Hibakeresési kód esetén: Az összes kód helyileg van hibakereséssel, míg az összes Spark-kód továbbra is fut a fürtön a távoli Azure Databricks-munkaterületen. Az alapvető Spark-motorkódot nem lehet közvetlenül az ügyfélből hibakeresésre használni.

Következő lépések

- A Databricks Csatlakozás-megoldások Pythonnal való fejlesztésének megkezdéséhez kezdje a Pythonhoz készült Databricks Csatlakozás oktatóanyaggal.

- A Databricks Csatlakozás-megoldások R-vel való fejlesztésének megkezdéséhez kezdje a Databricks Csatlakozás R-oktatóanyaggal.

- A Databricks Csatlakozás-megoldások Scala-beli fejlesztésének megkezdéséhez kezdje a Databricks Csatlakozás scalai oktatóanyagával.