Usare Azure Data Factory per eseguire la migrazione dei dati dal data lake o dal data warehouse ad Azure

SI APPLICA A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Suggerimento

Provare Data Factory in Microsoft Fabric, una soluzione di analisi completa per le aziende. Microsoft Fabric copre tutti gli elementi, dallo spostamento dei dati all'analisi scientifica dei dati, all'analisi in tempo reale, alla business intelligence e alla creazione di report. Scopri come avviare gratuitamente una nuova versione di valutazione .

Se si vuole eseguire la migrazione del data lake o del data warehouse aziendale (EDW) a Microsoft Azure, è consigliabile usare Azure Data Factory. Azure Data Factory è particolarmente adatto agli scenari seguenti:

- Migrazione del carico di lavoro di Big Data da Amazon Simple Archiviazione Service (Amazon S3) o da Hadoop Distributed File System (HDFS) locale ad Azure

- Migrazione EDW da Oracle Exadata, Netezza, Teradata o Amazon Redshift ad Azure

Azure Data Factory può spostare petabyte (PB) di dati per la migrazione del data lake e decine di terabyte (TB) di dati per la migrazione del data warehouse.

Perché è possibile usare Azure Data Factory per la migrazione dei dati

- Azure Data Factory può aumentare facilmente la potenza di elaborazione per spostare i dati in modo serverless con prestazioni elevate, resilienza e scalabilità. E si paga solo per ciò che si usa. Si noti anche quanto segue:

- Azure Data Factory non presenta limitazioni sul volume di dati o sul numero di file.

- Azure Data Factory può usare completamente la larghezza di banda di rete e archiviazione per ottenere il volume massimo di velocità effettiva di spostamento dei dati nell'ambiente.

- Azure Data Factory usa un metodo con pagamento in base al consumo, in modo da pagare solo per il tempo effettivamente usato per eseguire la migrazione dei dati ad Azure.

- Azure Data Factory può eseguire un carico cronologico una tantum e carichi incrementali pianificati.

- Azure Data Factory usa il runtime di integrazione di Azure per spostare i dati tra endpoint data lake e warehouse accessibili pubblicamente. Può anche usare il runtime di integrazione self-hosted per lo spostamento dei dati per gli endpoint data lake e warehouse all'interno di Azure Rete virtuale (VNet) o dietro un firewall.

- Azure Data Factory offre sicurezza di livello aziendale: è possibile usare Windows Installer (MSI) o l'identità del servizio per l'integrazione da servizio a servizio protetta oppure usare Azure Key Vault per la gestione delle credenziali.

- Azure Data Factory offre un'esperienza di creazione senza codice e un dashboard di monitoraggio predefinito avanzato.

Migrazione dei dati online e offline

Azure Data Factory è uno strumento di migrazione dei dati online standard per trasferire i dati tramite una rete (Internet, ER o VPN). Mentre con la migrazione dei dati offline, gli utenti spediscono fisicamente i dispositivi di trasferimento dei dati dall'organizzazione a un data center di Azure.

Quando si sceglie tra un approccio di migrazione online e offline, è necessario tenere presenti tre considerazioni principali:

- Dimensioni dei dati di cui eseguire la migrazione

- Larghezza di banda di rete

- Finestra di migrazione

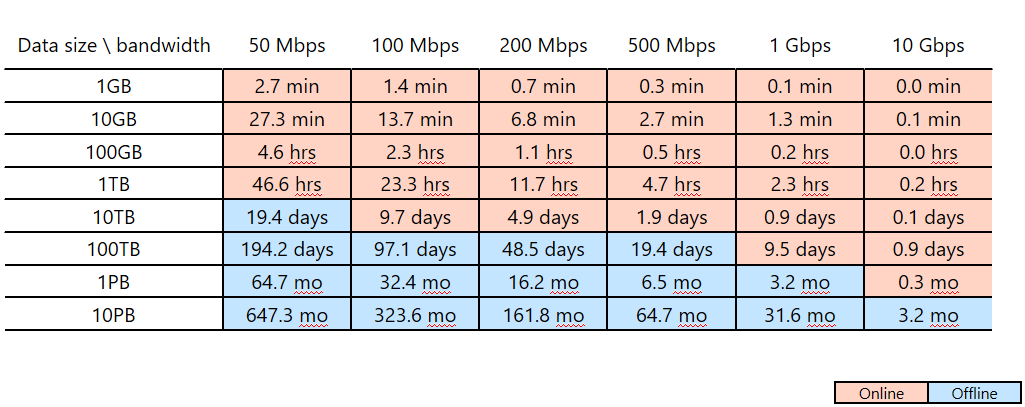

Si supponga, ad esempio, di voler usare Azure Data Factory per completare la migrazione dei dati entro due settimane (finestra di migrazione). Si noti la linea di taglio rosa/blu nella tabella seguente. La cella rosa più bassa per una determinata colonna mostra l'associazione di dimensioni dati/larghezza di banda di rete la cui finestra di migrazione è più vicina a ma meno di due settimane. Qualsiasi associazione di dimensioni/larghezza di banda in una cella blu ha una finestra di migrazione online di più di due settimane.

Questa tabella consente di determinare se è possibile soddisfare la finestra di migrazione prevista tramite la migrazione online (Azure Data Factory) in base alle dimensioni dei dati e alla larghezza di banda di rete disponibile. Se la finestra di migrazione online è superiore a due settimane, è consigliabile usare la migrazione offline.

Questa tabella consente di determinare se è possibile soddisfare la finestra di migrazione prevista tramite la migrazione online (Azure Data Factory) in base alle dimensioni dei dati e alla larghezza di banda di rete disponibile. Se la finestra di migrazione online è superiore a due settimane, è consigliabile usare la migrazione offline.

Nota

Usando la migrazione online, è possibile ottenere sia il caricamento dei dati cronologici che i feed incrementali end-to-end tramite un unico strumento. Tramite questo approccio, i dati possono essere mantenuti sincronizzati tra l'archivio esistente e il nuovo archivio durante l'intera finestra di migrazione. Ciò significa che è possibile ricompilare la logica ETL nel nuovo archivio con i dati aggiornati.