Caricare dati in Azure Data Lake Storage Gen2 con Azure Data Factory

SI APPLICA A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Suggerimento

Provare Data Factory in Microsoft Fabric, una soluzione di analisi completa per le aziende. Microsoft Fabric copre tutti gli elementi, dallo spostamento dei dati all'analisi scientifica dei dati, all'analisi in tempo reale, alla business intelligence e alla creazione di report. Scopri come avviare gratuitamente una nuova versione di valutazione .

Azure Data Lake Storage Gen2 è un set di funzionalità dedicate all'analisi dei Big Data e integrate in Archiviazione BLOB di Azure. Consente di interagire con i dati approfittando dei paradigmi sia del file system che dell'archiviazione di oggetti.

Azure Data Factory (ADF) è un servizio di integrazione dei dati completamente gestito basato sul cloud. È possibile usare il servizio per popolare il lake con i dati provenienti da un set completo di archivi dati locali e basati sul cloud e risparmiare tempo durante la compilazione di soluzioni di analisi. Per un elenco dettagliato di connettori supportati, vedere la tabella degli archivi dati supportati.

Azure Data Factory offre una soluzione di spostamento dei dati gestita e scale-out. ADF, grazie all'architettura scale-out, può inserire i dati a una velocità effettiva elevata. Per informazioni, vedere Prestazioni dell'attività di copia.

Questo articolo illustra come usare lo strumento Copia dati di Data Factory per caricare dati dal servizio Amazon Web Services S3 in Azure Data Lake Storage Gen2. È possibile seguire una procedura simile a quella usata per copiare dati da altri tipi di archivi dati.

Suggerimento

Per copiare dati da Azure Data Lake Storage Gen1 a Gen2, consultare questa procedura dettagliata specifica.

Prerequisiti

- Sottoscrizione di Azure: se non è disponibile una sottoscrizione di Azure, creare un account gratuito prima di iniziare.

- Archiviazione di Azure account con Data Lake Archiviazione Gen2 abilitato: se non si ha un account Archiviazione, creare un account.

- Account AWS con un bucket S3 contenente dati: questo articolo illustra come copiare i dati da Amazon S3. È possibile usare altri archivi dati seguendo una procedura simile.

Creare una data factory

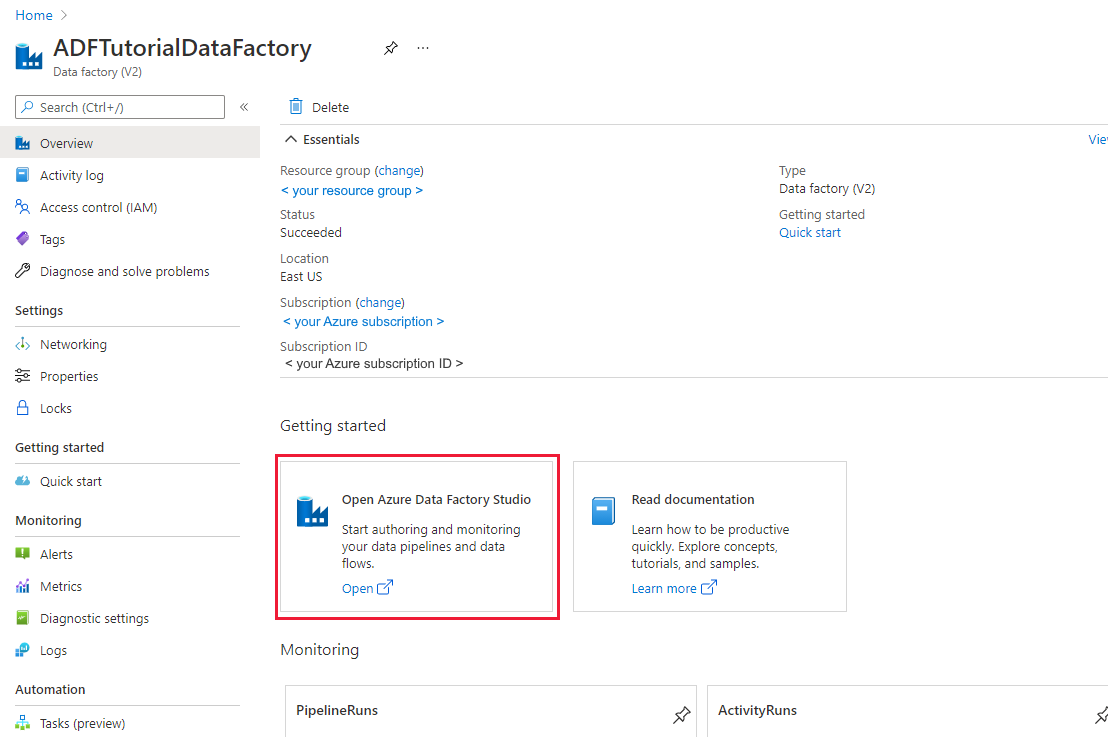

Se la data factory non è ancora stata creata, seguire la procedura descritta in Avvio rapido: Creare una data factory usando il portale di Azure e Azure Data Factory Studio per crearne uno. Dopo averlo creato, passare alla data factory nel portale di Azure.

Selezionare Apri nel riquadro Apri Azure Data Factory Studio per avviare l'applicazione Integrazione dei dati in una scheda separata.

Caricare i dati in Azure Data Lake Storage Gen2

Nella home page di Azure Data Factory selezionare il riquadro Inserimento per avviare lo strumento Copia dati.

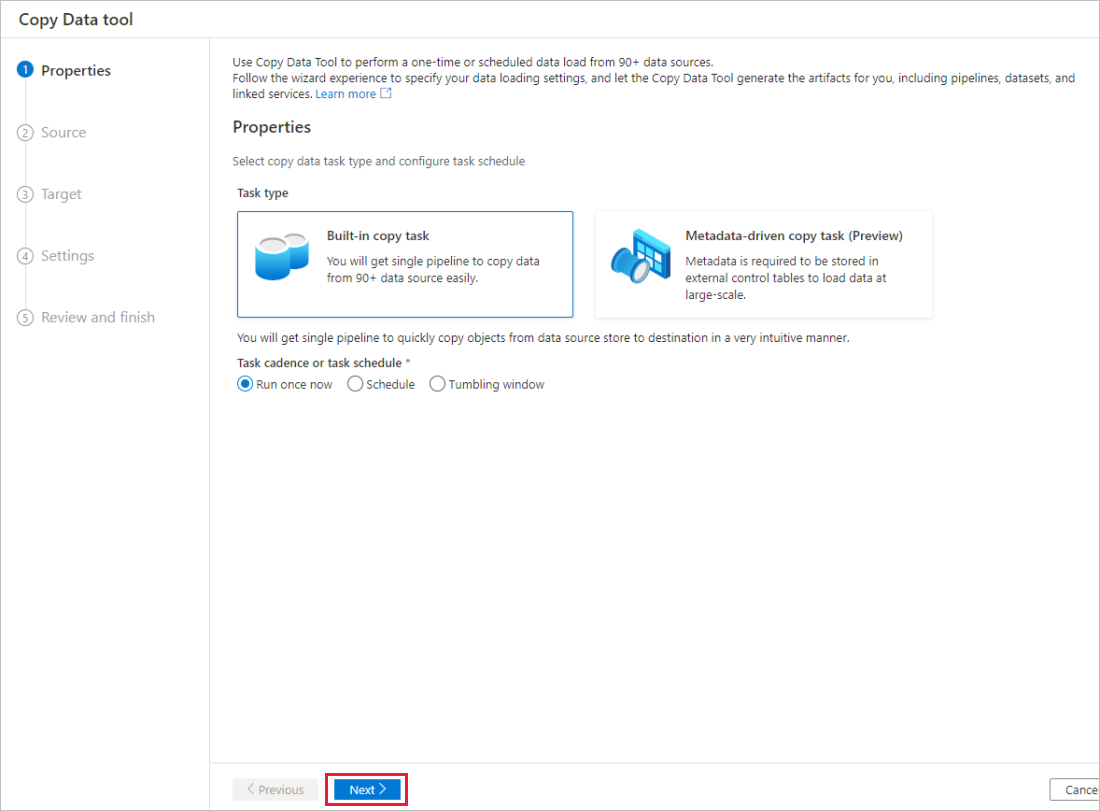

Nella pagina Proprietà scegliere Attività di copia predefinita in Tipo di attività e scegliere Esegui una volta ora in Frequenza attività o pianificazione attività, quindi selezionare Avanti.

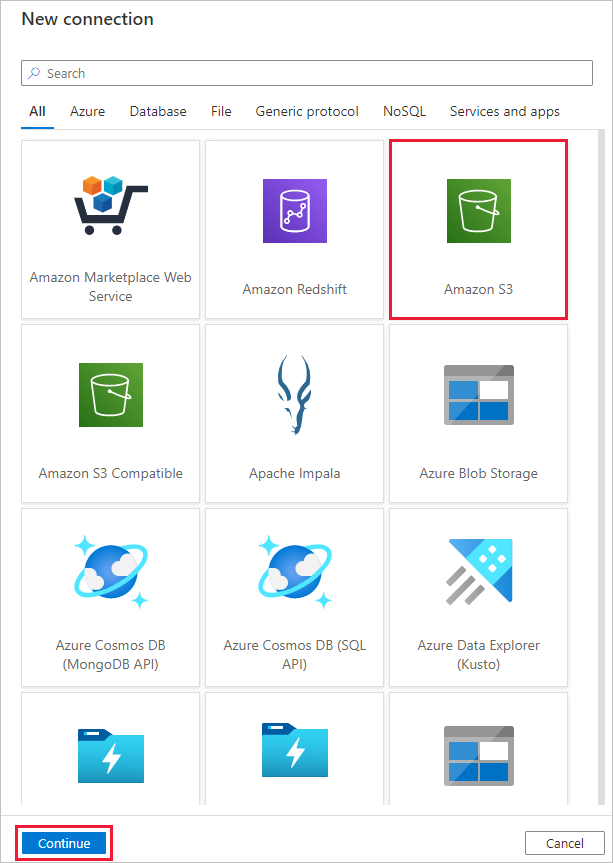

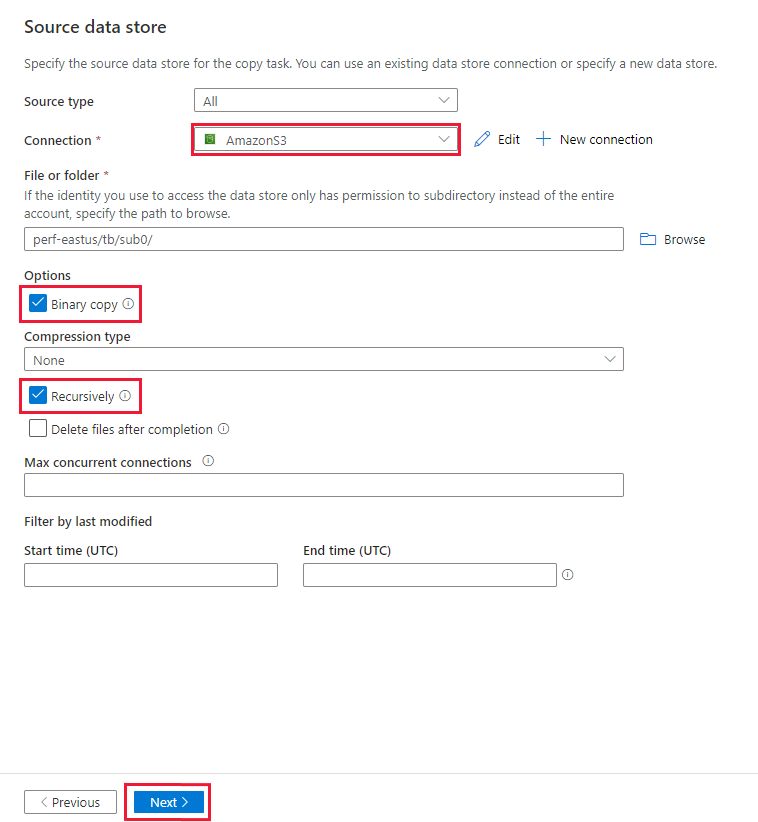

Nella pagina Archivio dati di origine completare la procedura seguente:

Selezionare + Nuova connessione. Selezionare Amazon S3 dalla raccolta di connettori e selezionare Continua.

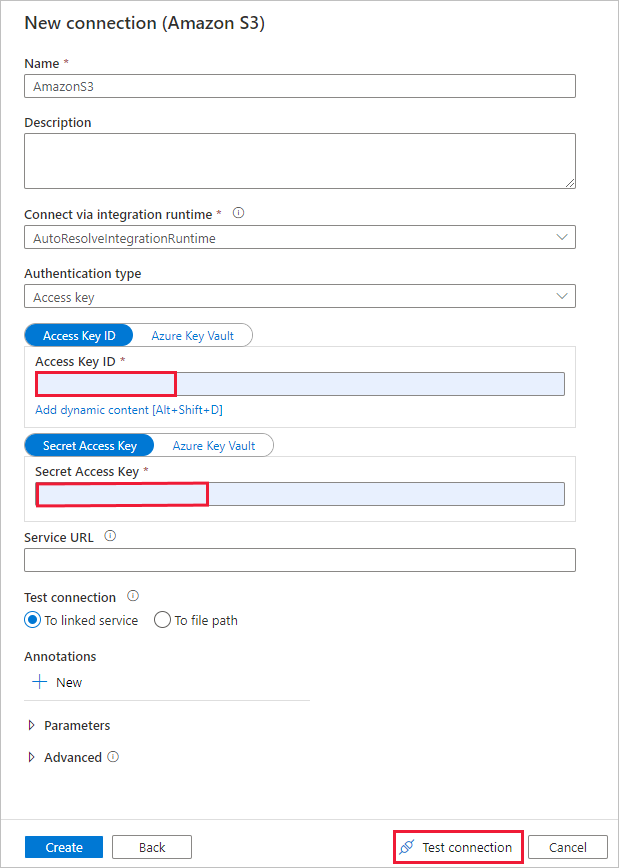

Nella pagina Nuova connessione (Amazon S3) seguire questa procedura:

- Specificare il valore ID della chiave di accesso.

- Specificare il valore Chiave di accesso segreta.

- Selezionare Test connessione per convalidare le impostazioni e quindi selezionare Crea.

Nella pagina Archivio dati di origine assicurarsi che la connessione Amazon S3 appena creata sia selezionata nel blocco Connessione ion.

Nella sezione File o cartella passare alla cartella e al file da copiare. Selezionare la cartella o il file e quindi selezionare OK.

Specificare il comportamento di copia controllando le opzioni Copia ricorsiva eBinaria . Selezionare Avanti.

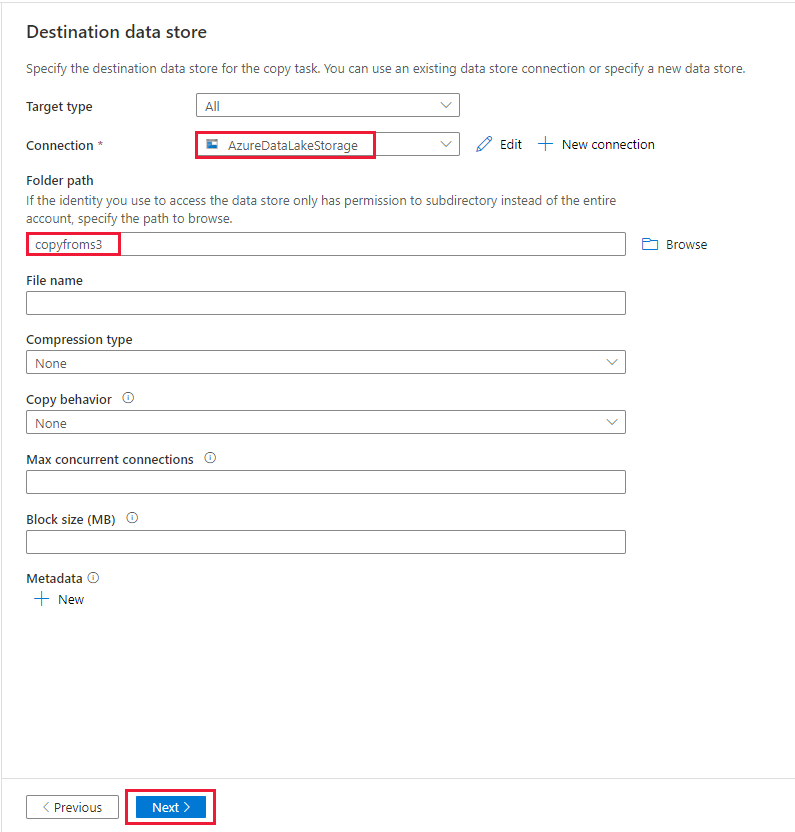

Nella pagina Archivio dati di destinazione completare la procedura seguente.

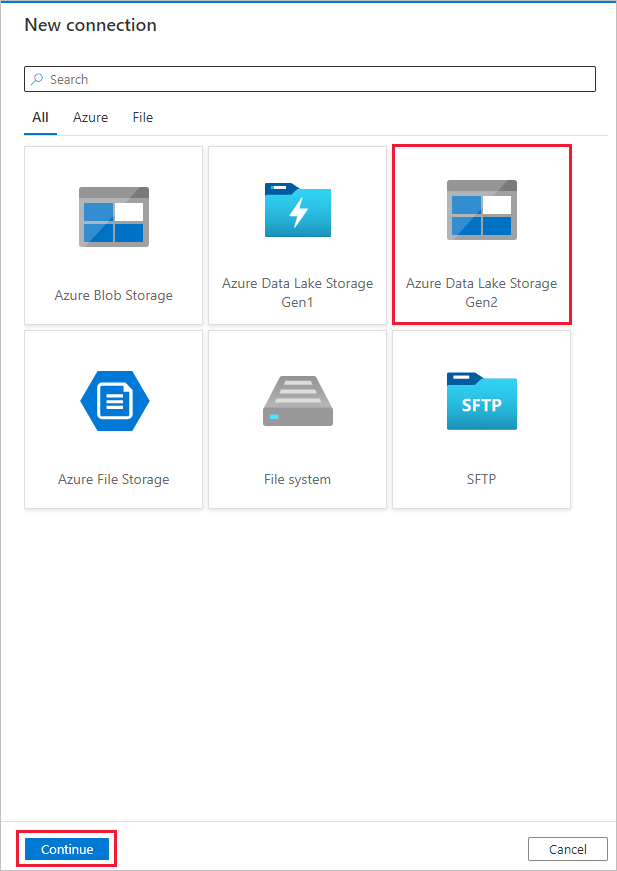

Selezionare + Nuova connessione, quindi selezionare Azure Data Lake Archiviazione Gen2 e selezionare Continua.

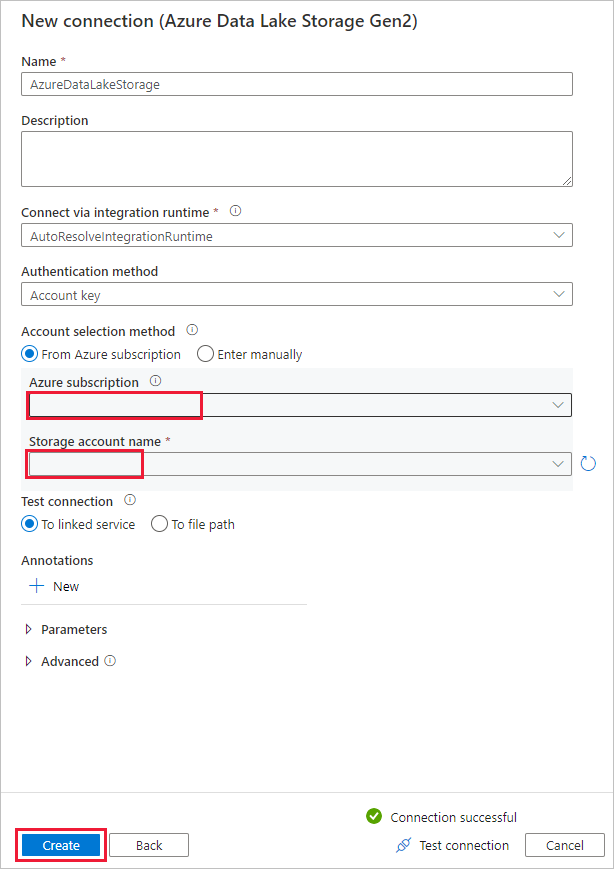

Nella pagina Nuova connessione (Azure Data Lake Archiviazione Gen2) selezionare l'account con supporto per Data Lake Archiviazione Gen2 dall'elenco a discesa "nome account Archiviazione" e selezionare Crea per creare la connessione.

Nella pagina Archivio dati di destinazione selezionare la connessione appena creata nel blocco Connessione ion. Quindi, in Percorso cartella immettere copyfroms3 come nome della cartella di output e selezionare Avanti. ADF creerà il file system e le sottocartelle ADLS Gen2 corrispondenti durante la copia, se non esiste.

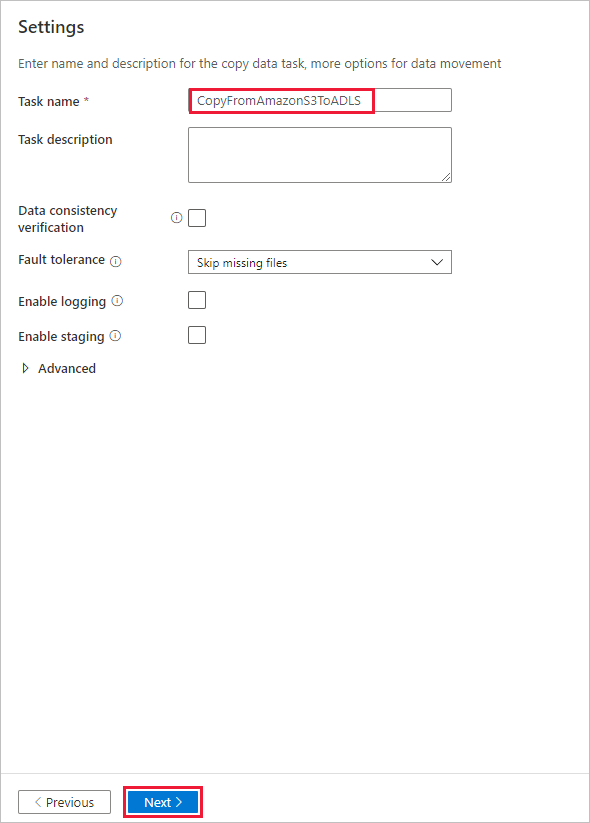

Nella pagina Impostazioni specificare CopyFromAmazonS3ToADLS per il campo Nome attività e selezionare Avanti per usare le impostazioni predefinite.

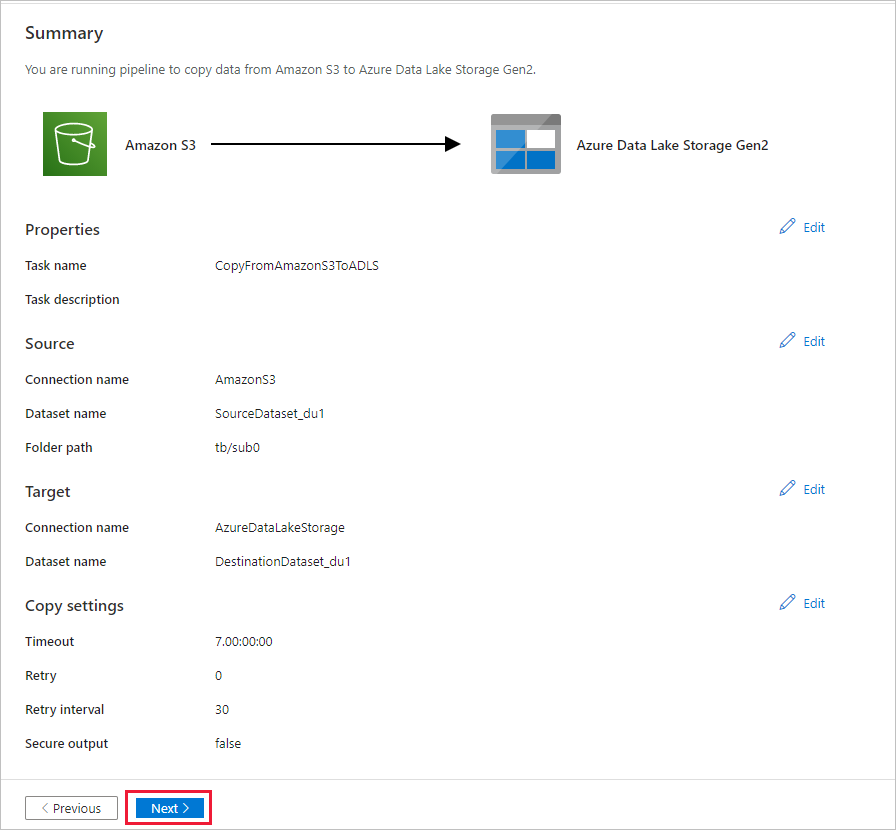

Nella pagina Riepilogo esaminare le impostazioni e selezionare Avanti.

Nella pagina Distribuzione selezionare Monitoraggio per monitorare la pipeline (attività).

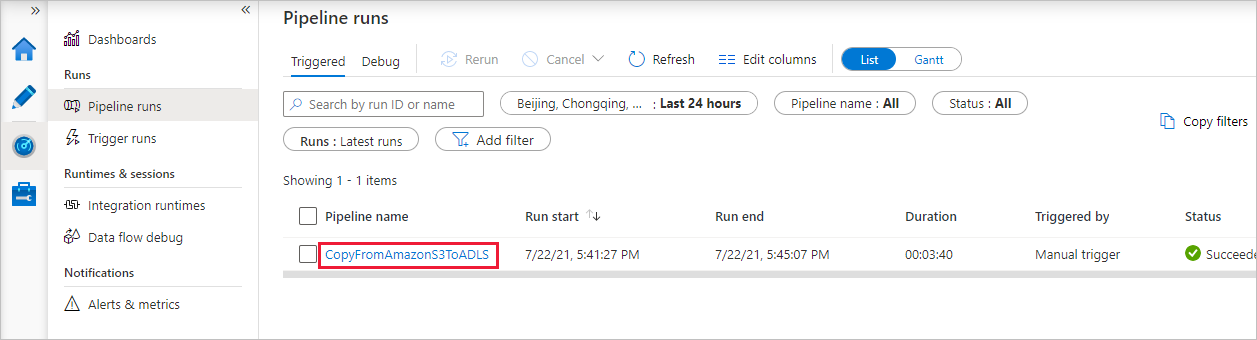

Al termine dell'esecuzione della pipeline, viene visualizzata un'esecuzione della pipeline attivata da un trigger manuale. È possibile usare i collegamenti nella colonna Nome pipeline per visualizzare i dettagli dell'attività ed eseguire di nuovo la pipeline.

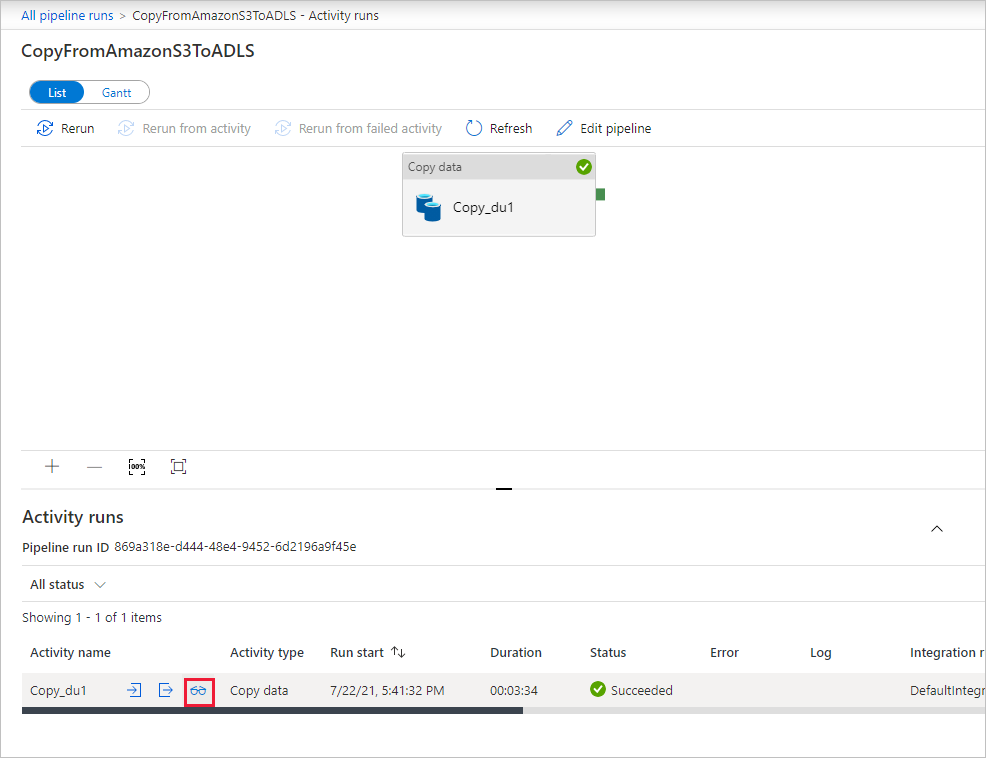

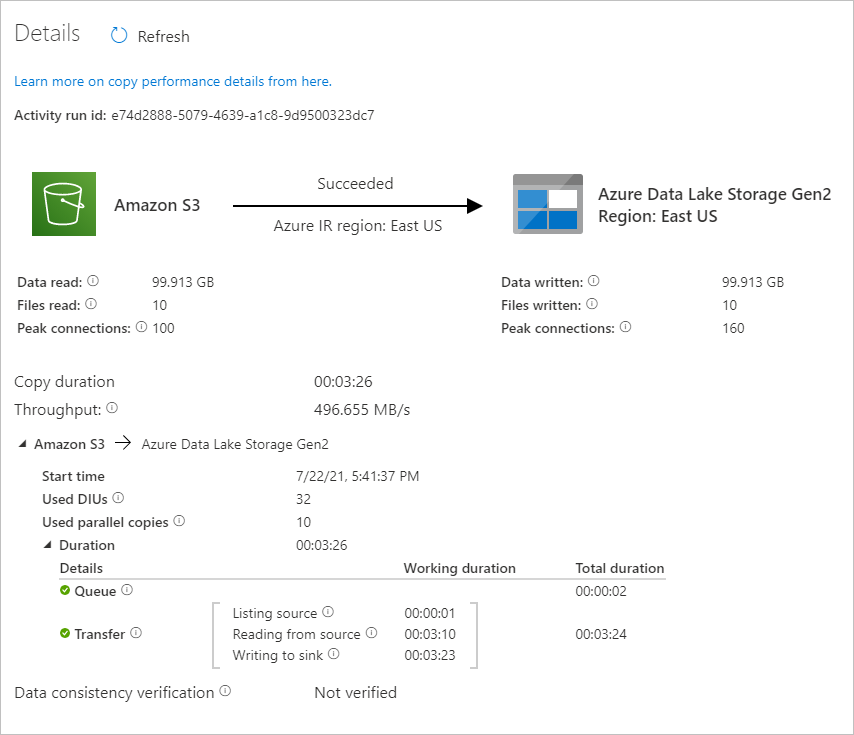

Per visualizzare le esecuzioni di attività associate all'esecuzione della pipeline, selezionare il collegamento CopyFromAmazonS3ToADLS nella colonna Nome pipeline. Per informazioni dettagliate sull'operazione di copia, selezionare il collegamento Dettagli (icona a forma di occhiali) nella colonna Nome attività. È possibile monitorare i dettagli, ad esempio il volume di dati copiati dall'origine al sink, la velocità effettiva dei dati, i passaggi di esecuzione con la durata corrispondente e la configurazione usata.

Per aggiornare la visualizzazione, selezionare Aggiorna. Selezionare Tutte le esecuzioni della pipeline nella parte superiore per tornare alla visualizzazione "Esecuzioni della pipeline".

Verificare che i dati vengano copiati nell'account Data Lake Storage Gen2.