データのコピー ツールを使用することにより、パーティション分割されたファイル名に基づく新しいファイルを増分コピーする

適用対象: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

ヒント

企業向けのオールインワン分析ソリューション、Microsoft Fabric の Data Factory をお試しください。 Microsoft Fabric は、データ移動からデータ サイエンス、リアルタイム分析、ビジネス インテリジェンス、レポートまで、あらゆるものをカバーしています。 無料で新しい試用版を開始する方法について説明します。

このチュートリアルでは、Azure Portal を使用してデータ ファクトリを作成します。 次に、時間でパーティション分割されたファイル名に基づく新しいファイルを Azure Blob Storage から Azure Blob Storage に増分コピーするパイプラインを、データのコピー ツールを使用して作成します。

Note

Azure Data Factory を初めて使用する場合は、「Azure Data Factory の概要」を参照してください。

このチュートリアルでは、以下の手順を実行します。

- データ ファクトリを作成します。

- データのコピー ツールを使用してパイプラインを作成します。

- パイプラインとアクティビティの実行を監視します。

前提条件

- Azure サブスクリプション:Azure サブスクリプションをお持ちでない場合は、開始する前に 無料アカウント を作成してください。

- Azure ストレージ アカウント: "ソース" および "シンク" データ ストアとして Blob ストレージを使用します。 Azure ストレージ アカウントがない場合は、「ストレージ アカウントの作成」の手順をご覧ください。

Blob ストレージに 2 つのコンテナーを作成する

次の手順を行って、チュートリアルで使用する Blob ストレージを準備します。

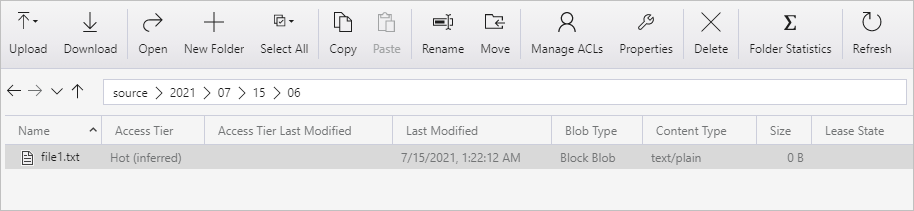

source という名前のコンテナーを作成します。 自分のコンテナー内に、2021/07/15/06 というフォルダー パスを作成します。 空のテキスト ファイルを作成し、file1.txt という名前を付けます。 自分のストレージ アカウントのフォルダー パス source/2021/07/15/06 に、file1.txt をアップロードします。 この作業は、Azure Storage Explorer をはじめとするさまざまなツールを使用して実行できます。

Note

フォルダー名は、UTC 時間に合わせて調整してください。 たとえば、現在の UTC 時刻が 2021 年 7 月 15 日午前 6 時 10 分である場合は、source/{Year}/{Month}/{Day}/{Hour}/ のルールに従って、source/2021/07/15/06/ というフォルダー パスを作成できます。

destination という名前のコンテナーを作成します。 この作業は、Azure Storage Explorer をはじめとするさまざまなツールを使用して実行できます。

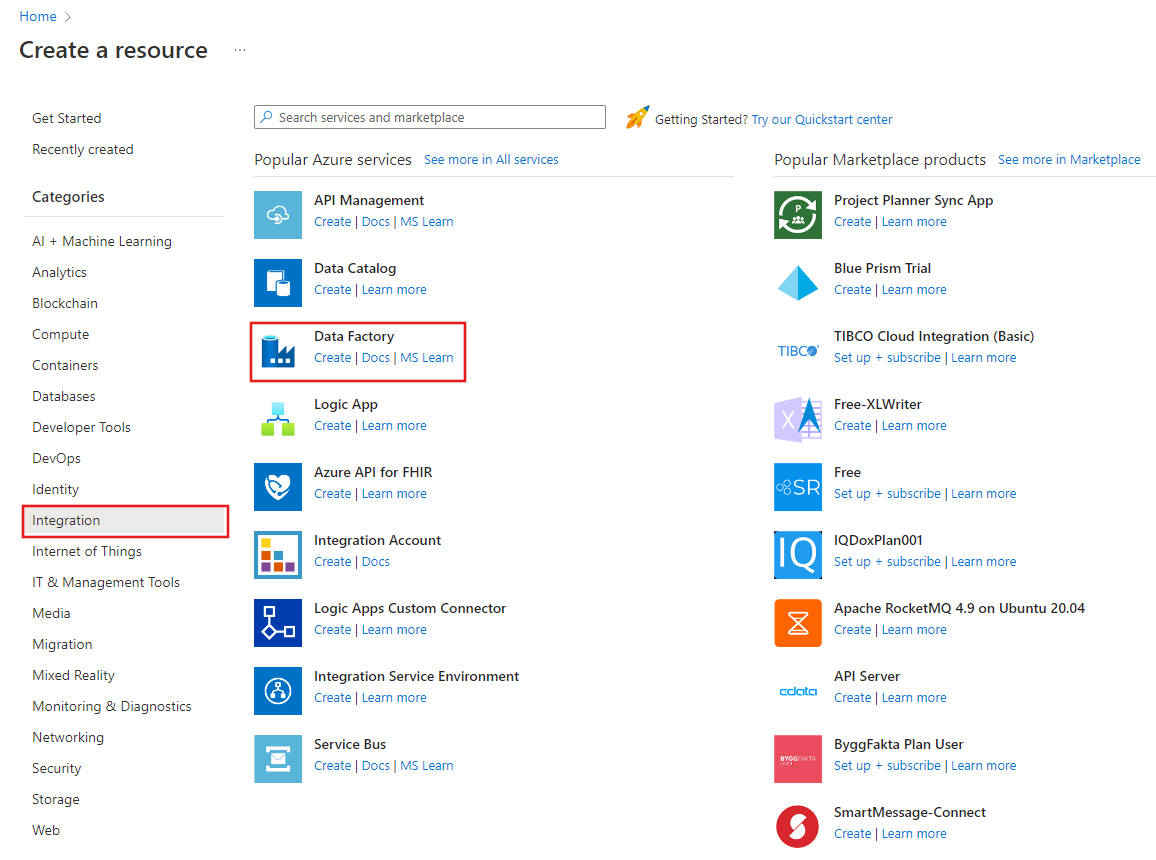

Data Factory の作成

左側のメニューで、 [リソースの作成]>[統合]>[Data Factory] を選択します。

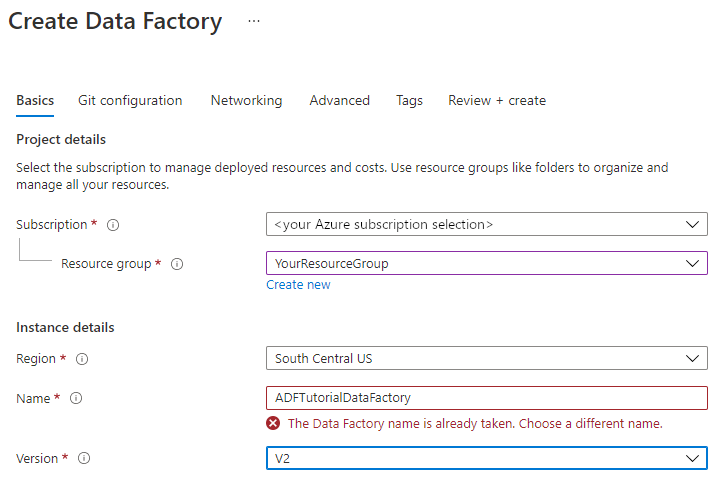

[新しいデータ ファクトリ] ページで、 [名前] に「ADFTutorialDataFactory」と入力します。

データ ファクトリの名前は "グローバルに一意" にする必要があります。 次のエラー メッセージが表示される場合があります。

データ ファクトリの名前の値に関するエラー メッセージが表示された場合は、別の名前を入力してください。 たとえば、yournameADFTutorialDataFactory という名前を使用します。 Data Factory アーティファクトの名前付け規則については、Data Factory の名前付け規則に関する記事をご覧ください。

新しいデータ ファクトリの作成先となる Azure サブスクリプションを選択します。

[リソース グループ] で、次の手順のいずれかを行います。

a. [Use existing (既存のものを使用)] を選択し、ドロップダウン リストから既存のリソース グループを選択します。

b. [新規作成] を選択し、リソース グループの名前を入力します。

リソース グループの詳細については、リソース グループを使用した Azure のリソースの管理に関するページを参照してください。

[バージョン] で、バージョンとして [V2] を選択します。

[場所] で、データ ファクトリの場所を選択します。 サポートされている場所のみがドロップダウン リストに表示されます。 データ ファクトリによって使用されるデータ ストア (Azure Storage、SQL Database など) やコンピューティング (Azure HDInsight など) は、他の場所やリージョンに存在していてもかまいません。

[作成] を選択します

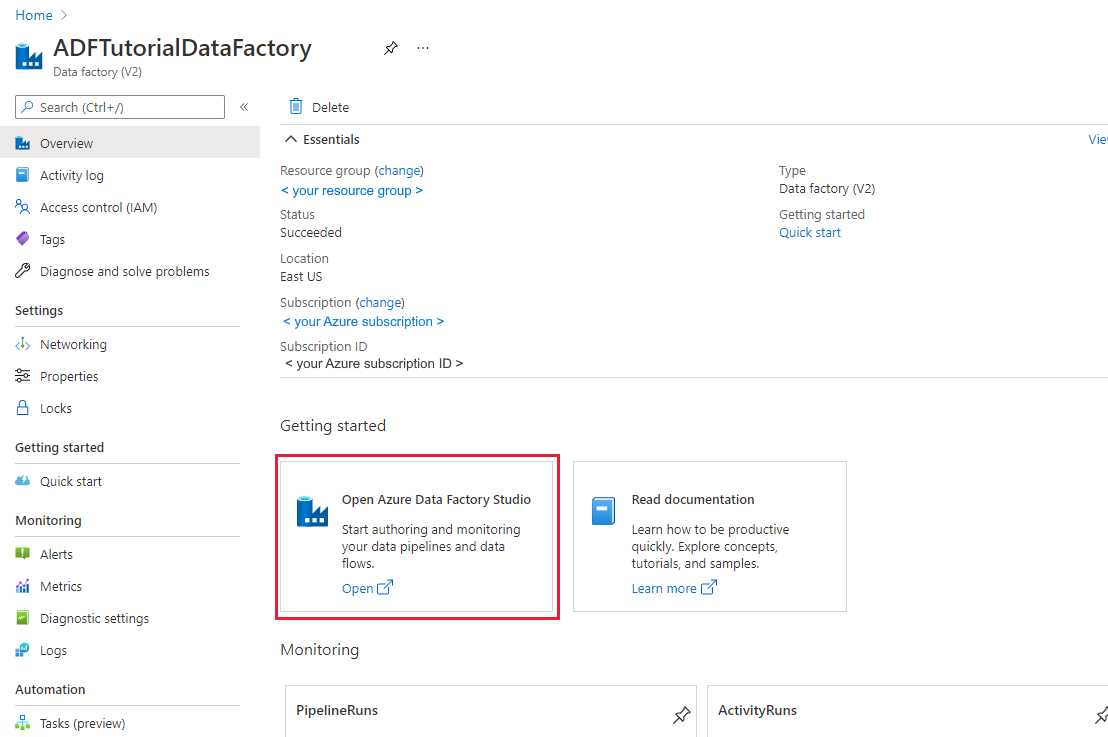

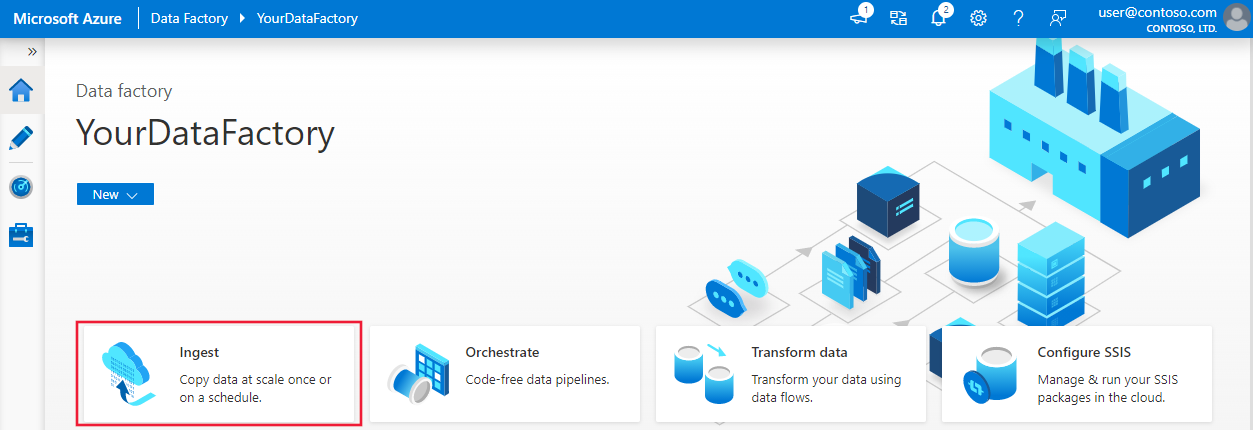

作成が完了すると、 [Data Factory] ホーム ページが表示されます。

別のタブで Azure Data Factory ユーザー インターフェイス (UI) を起動するには、 [Open Azure Data Factory Studio]\(Azure Data Factory Studio を開く\) タイルで [開く] を選択します。

データのコピー ツールを使用してパイプラインを作成する

Azure Data Factory のホーム ページで [取り込む] タイトルを選択して、データ コピー ツールを起動します。

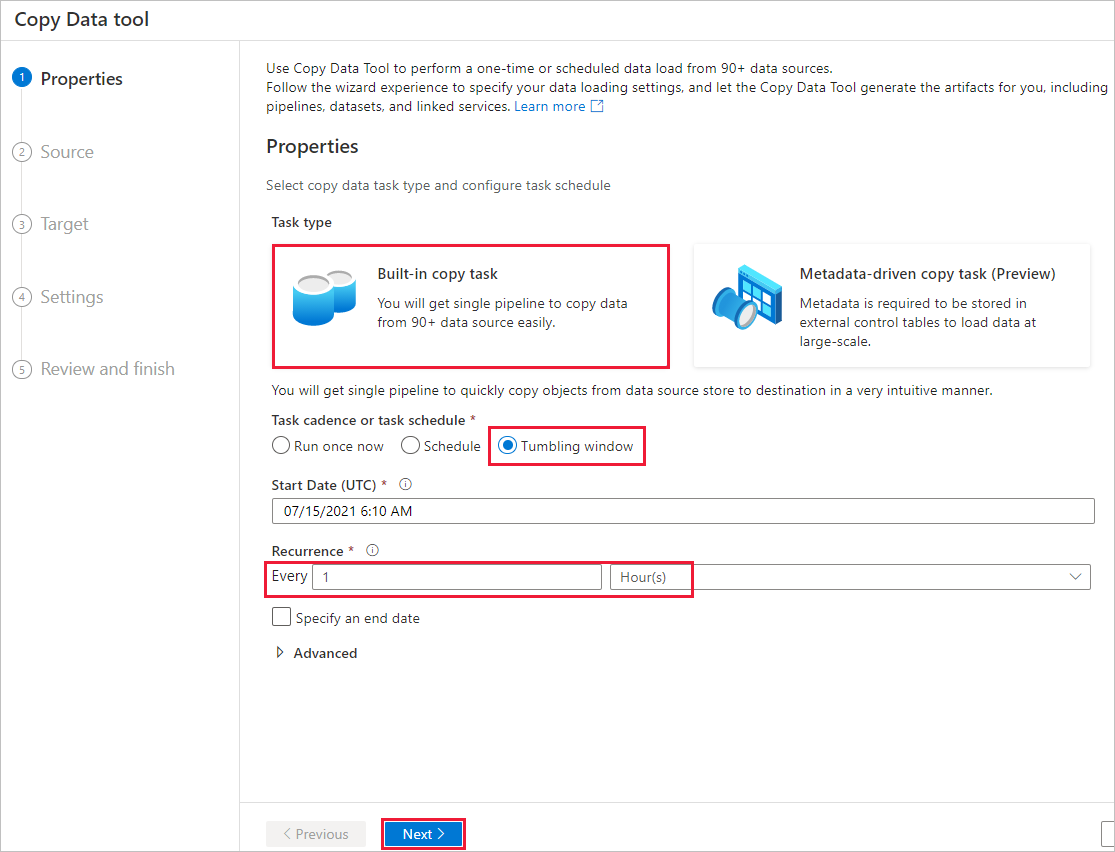

[プロパティ] ページで、次の手順を行います。

[タスクの種類] で [Built-in copy task]\(組み込みコピー タスク\) を選択します。

[Task cadence or task schedule]\(タスクの周期またはタスクのスケジュール\) で、 [Tumbling window]\(タンブリング ウィンドウ\) を選択します。

[Recurrence]\(繰り返し\) で、1 時間と指定します。

[次へ] を選択します。

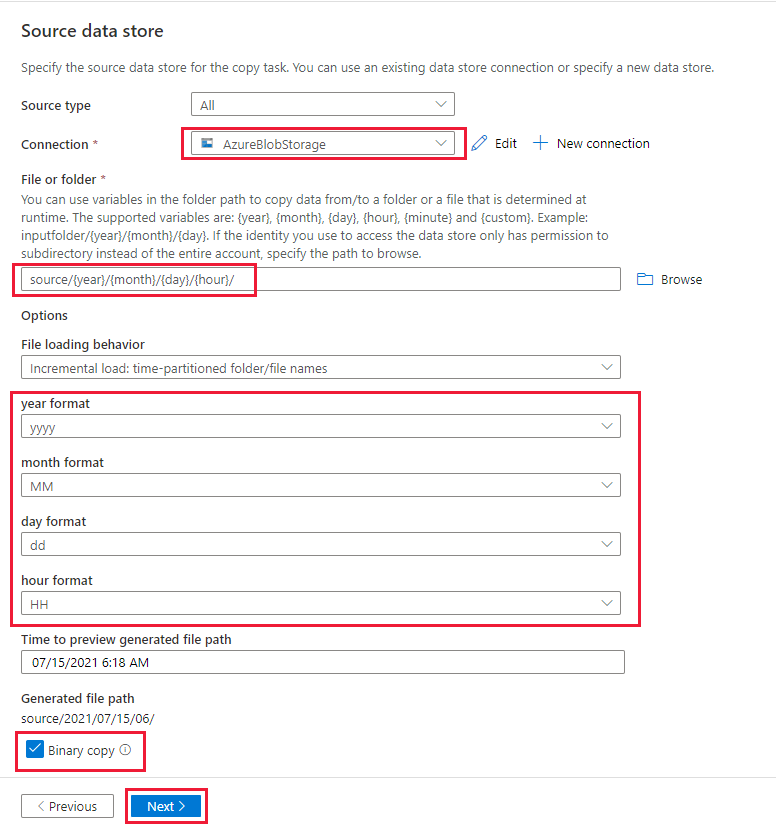

[ソース データ ストア] ページで、次の手順を実行します。

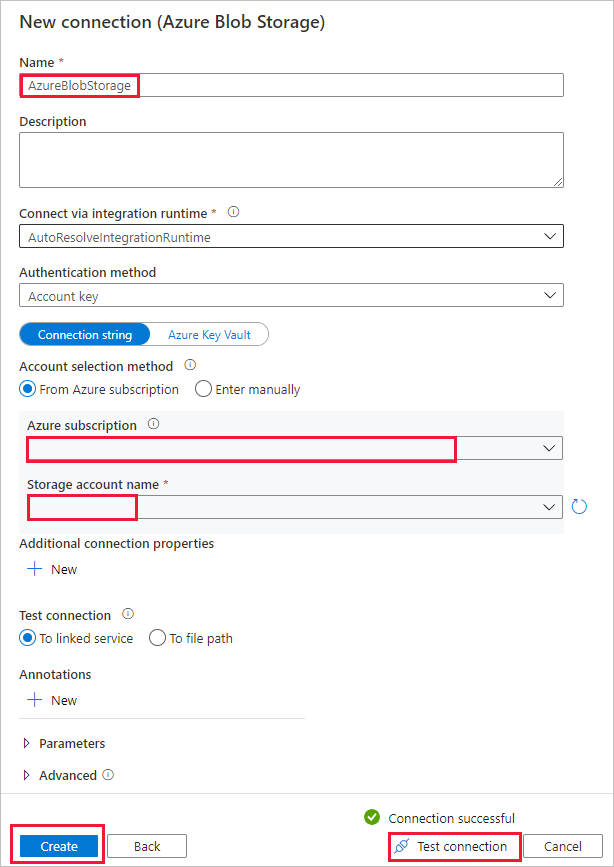

a. [+ 新しい接続] を選択して、接続を追加します。

b. ギャラリーから [Azure Blob Storage] を選択し、 [続行] を選択します。

c. [新しい接続 (Azure Blob Storage)] ページで、接続の名前を入力します。 Azure サブスクリプションを選択し、 [ストレージ アカウント名] 一覧からご利用のストレージ アカウントを選びます。 接続をテストし、 [作成] を選択します。

d. [ソース データ ストア] ページの [接続] セクションで、新しく作成した接続を選択します。

e. [ファイルまたはフォルダー] セクションで、source コンテナーを見つけて選択し、 [OK] を選択します。

f. [File loading behavior]\(ファイル読み込み動作\) で、 [Incremental load: time-partitioned folder/file names]\(段階的に読み込み: 時間でパーティション分割されたフォルダー/ファイル名\) を選択します。

g. 動的フォルダー パスを source/{year}/{month}/{day}/{hour}/ として入力し、次のスクリーンショットに示すように形式を変更します。

h. [Binary copy]\(バイナリ コピー\) をオンにして、[次へ] を選択します。

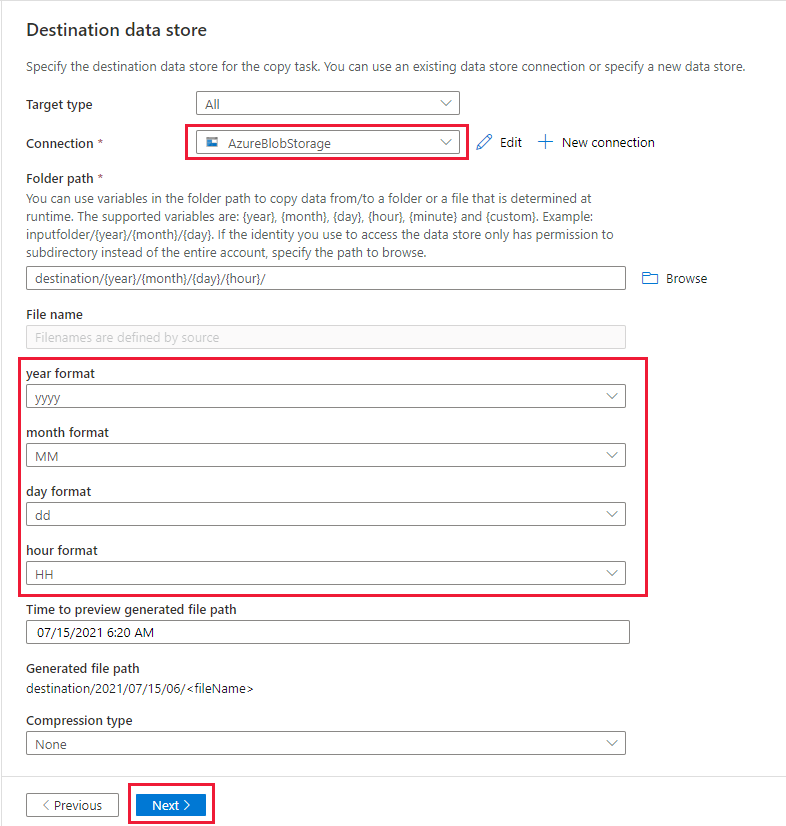

[コピー先データ ストア] ページで、次の手順を実行します。

データ ソース ストアと同じストレージ アカウントである AzureBlobStorage を選択します。

destination フォルダーを見つけて選択し、 [OK] を選択します。

動的フォルダー パスを destination/{year}/{month}/{day}/{hour}/ として入力し、次のスクリーンショットに示すように形式を変更します。

[次へ] を選択します。

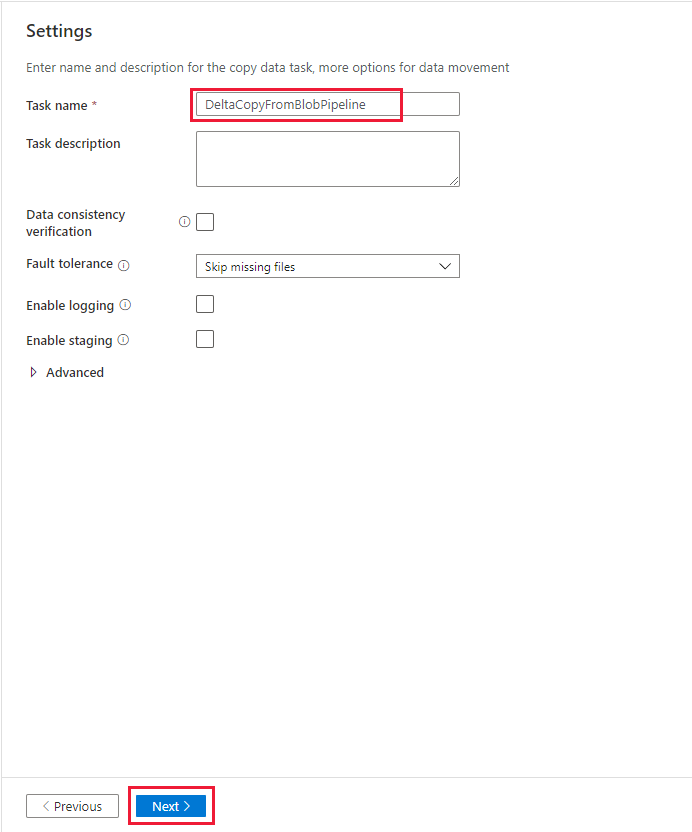

[設定] ページの [タスク名] に「DeltaCopyFromBlobPipeline」と入力し、 [次へ] を選択します。 指定したタスク名のパイプラインが Data Factory UI によって作成されます。

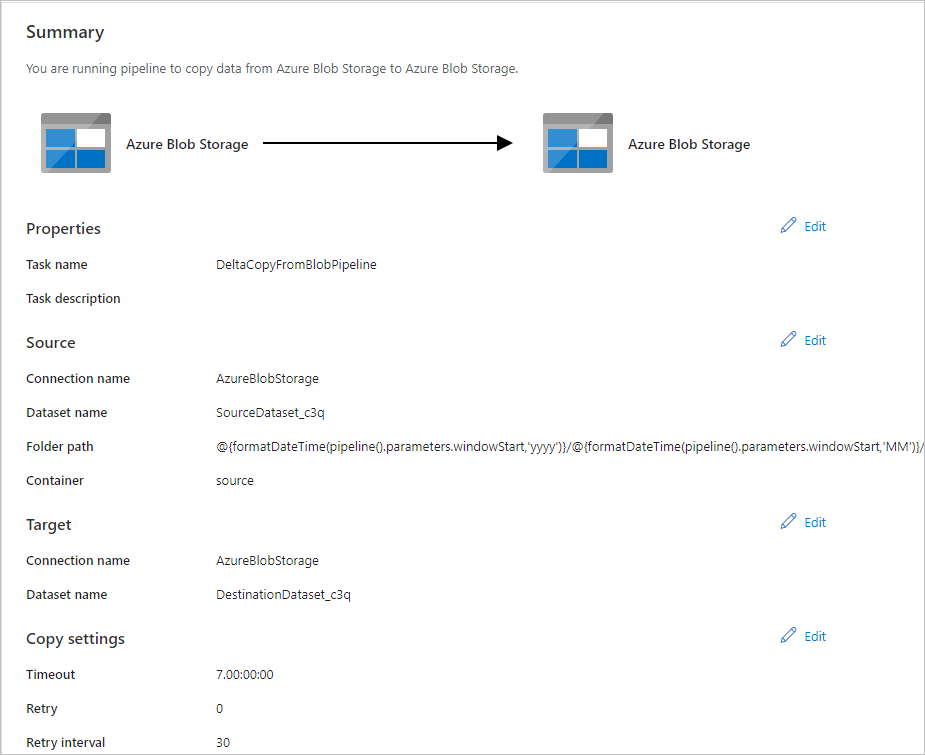

[サマリー] ページで設定を確認し、 [次へ] を選択します。

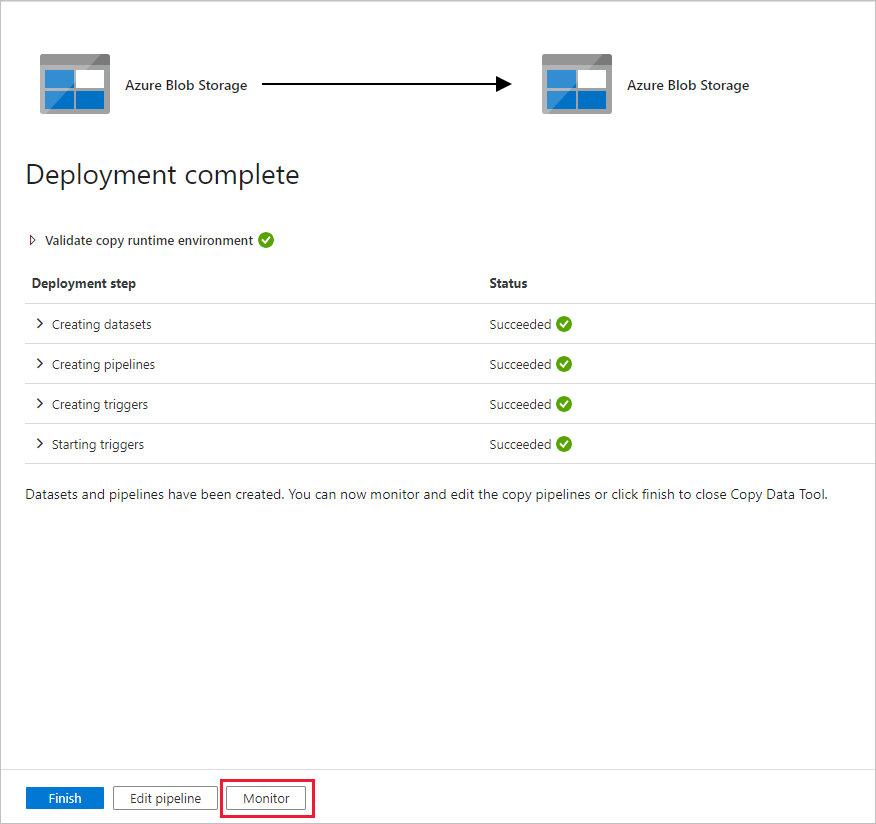

[Deployment]\(デプロイ\) ページで [監視] を選択してパイプライン (タスク) を監視します。

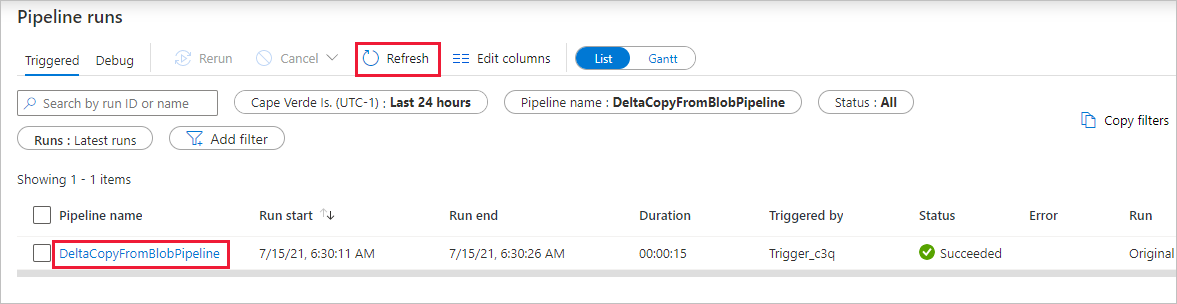

左側の [監視] タブが自動的に選択されたことがわかります。 パイプラインの実行が自動的にトリガーされるまで待機する必要があります (約 1 時間後)。 実行時に、パイプライン名のリンク DeltaCopyFromBlobPipeline を選択してアクティビティの実行の詳細を表示するか、パイプラインを再実行します。 [最新の情報に更新] を選択して、一覧を更新します。

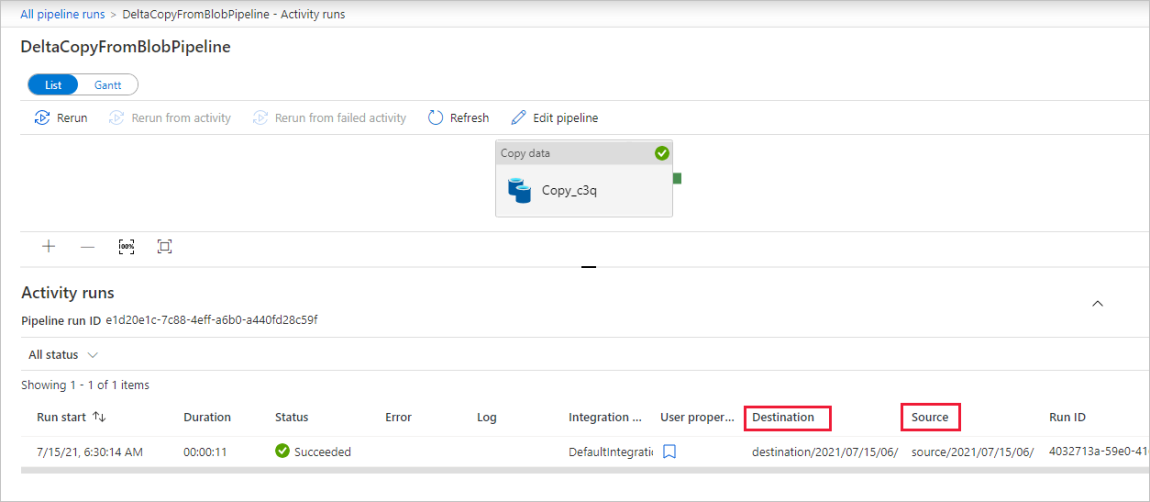

パイプライン内のアクティビティ (コピー アクティビティ) は 1 つだけなので、エントリは 1 つのみです。 [ソース] および [ターゲット] 列の列幅を (必要に応じて) 調整し、詳細が表示されるようにすると、ソース ファイル (file1.txt) が source/2021/07/15/06/ から、同じファイル名の destination/2021/07/15/06/ にコピーされていることがわかります。

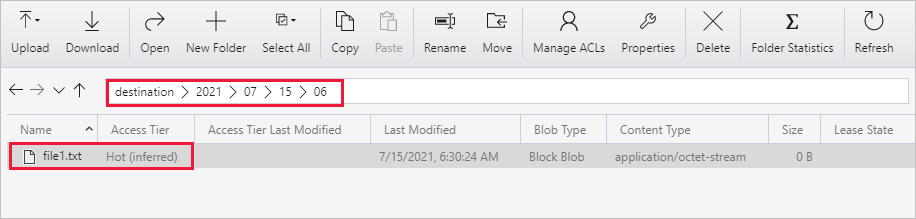

Azure Storage Explorer (https://storageexplorer.com/) を使用してファイルをスキャンしても、同じことを確認できます。

別の空のテキスト ファイルを作成し、file2.txt という新しい名前を付けます。 自分のストレージ アカウントのフォルダー パス source/2021/07/15/07 に、file2.txt ファイルをアップロードします。 この作業は、Azure Storage Explorer をはじめとするさまざまなツールを使用して実行できます。

注意

新しいフォルダー パスを作成する必要がないか注意してください。 フォルダー名は、UTC 時間に合わせて調整してください。 たとえば、現在の UTC 時刻が 2021 年 7 月 15 日午前 7 時 30 分の場合、 source/{Year}/{Month}/{Day}/{Hour}/ のルールに従って、source/2021/07/15/07/ というフォルダー パスを作成できます。

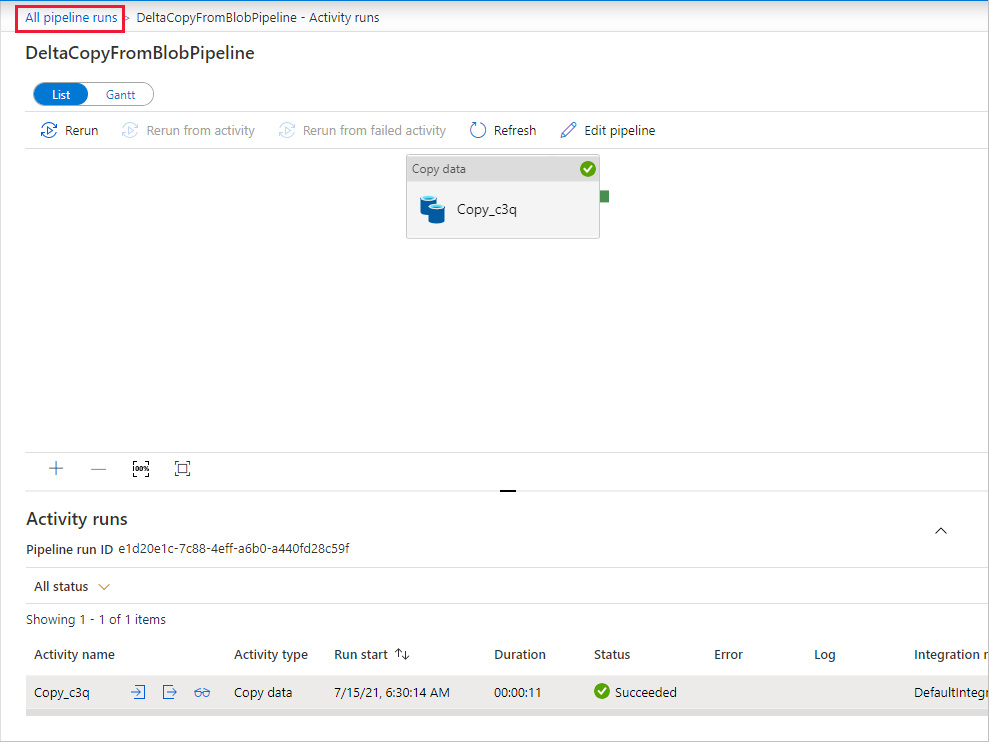

[パイプラインの実行] ビューに戻るには、 [All Pipelines Runs]\(すべてのパイプライン実行\) を選択し、さらに 1 時間後に同じパイプラインが再び自動的にトリガーされるまで待ちます。

2 つ目のパイプライン実行については、新しい DeltaCopyFromBlobPipeline を選択し、同じことを行って詳細を確認します。 ソース ファイル (file2.txt) が source/2021/07/15/07/ から、同じファイル名の destination/2021/07/15/07/ にコピーされたことがわかります。 Azure Storage Explorer (https://storageexplorer.com/) を使用して destination コンテナー内でファイルをスキャンしても、同じことを確認できます。

関連するコンテンツ

次のチュートリアルに進み、Azure 上の Spark クラスターを使ってデータを変換する方法について学習しましょう。