カスタム コンテナーを使用してモデルをオンライン エンドポイントにデプロイする

[アーティクル] 2024/10/23

20 人の共同作成者

フィードバック

この記事の内容

前提条件

ソース コードのダウンロード

環境変数を初期化する

TensorFlow モデルをダウンロードする

TF Serving イメージをローカル環境で実行して動作することをテストする

オンライン エンドポイントを Azure にデプロイする

関連するコンテンツ

さらに 3 個を表示

適用対象: Azure CLI ml extension v2 (現行) Python SDK azure-ai-ml v2 (現行)

カスタム コンテナーを使用して、Azure Machine Learning のオンライン エンドポイントにモデルをデプロイする方法について学びます。

カスタム コンテナーのデプロイでは、Azure Machine Learning によって使用される既定の Python Flask サーバー以外の Web サーバーを使用できます。 これらのデプロイのユーザーは、Azure Machine Learning の組み込みの監視、スケーリング、アラート、認証を引き続き利用できます。

次のテーブルに、TensorFlow Serving、TorchServe、Triton Inference Server、Plumber R パッケージ、Microsoft Azure Machine Learning Inference Minimal イメージなどのカスタム コンテナーを使用するさまざまなデプロイ例 を示します。

テーブルを展開する

この記事では、TensorFlow Serving を使用した TensorFlow (TF) モデルの提供に焦点を当てています。

Microsoft では、カスタム イメージが原因で発生した問題のトラブルシューティングを行うことができない場合があります。 問題が発生した場合は、問題がイメージに固有のものであるかどうかを確認するために、既定のイメージ、または Microsoft が提供するイメージのいずれかを使用するように求められることがあります。

この記事の手順に従う前に、次の前提条件が満たされていることをご確認ください。

このチュートリアルに従うには、GitHub からソース コードを複製してください。

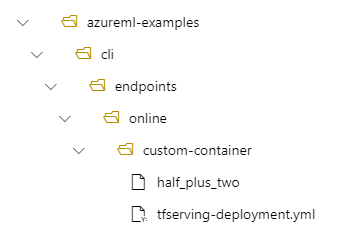

git clone https://github.com/Azure/azureml-examples --depth 1

cd azureml-examples/cli

git clone https://github.com/Azure/azureml-examples --depth 1

cd azureml-examples/cli

ノートブックの例 も参照してください。ただし、ノートブックの 3. Test locally セクションは azureml-examples/sdk ディレクトリの下で実行することを前提としていることにご注意ください。

環境変数を定義します。

BASE_PATH=endpoints/online/custom-container/tfserving/half-plus-two

AML_MODEL_NAME=tfserving-mounted

MODEL_NAME=half_plus_two

MODEL_BASE_PATH=/var/azureml-app/azureml-models/$AML_MODEL_NAME/1

入力を 2 で除算して結果に 2 を加算するモデルをダウンロードして解凍します。

wget https://aka.ms/half_plus_two-model -O $BASE_PATH/half_plus_two.tar.gz

tar -xvf $BASE_PATH/half_plus_two.tar.gz -C $BASE_PATH

TF Serving イメージをローカル環境で実行して動作することをテストする docker を使用して、テストのためにローカル環境でイメージを実行します。

docker run --rm -d -v $PWD/$BASE_PATH:$MODEL_BASE_PATH -p 8501:8501 \

-e MODEL_BASE_PATH=$MODEL_BASE_PATH -e MODEL_NAME=$MODEL_NAME \

--name="tfserving-test" docker.io/tensorflow/serving:latest

sleep 10

イメージに liveness とスコアリングの要求を送信できることを調べる 最初に、コンテナーが "アライブ" であること、つまりコンテナー内部のプロセスがまだ実行されていることを確認します。

curl -v http://localhost:8501/v1/models/$MODEL_NAME

次に、ラベル付けされていないデータに関する予測を取得できることを確認します。

curl --header "Content-Type: application/json" \

--request POST \

--data @$BASE_PATH/sample_request.json \

http://localhost:8501/v1/models/$MODEL_NAME:predict

ローカル環境でのテストが済んだので、イメージを停止します。

docker stop tfserving-test

オンライン エンドポイントを Azure にデプロイする 次に、オンライン エンドポイントを Azure にデプロイする

エンドポイントおよびデプロイ用の YAML ファイルを作成する YAML を使用してクラウド デプロイを構成できます。 この例で使用する YAML の例をご覧ください。

tfserving-endpoint.yml

$schema: https://azuremlsdk2.blob.core.windows.net/latest/managedOnlineEndpoint.schema.json

name: tfserving-endpoint

auth_mode: aml_token

tfserving-deployment.yml

$schema: https://azuremlschemas.azureedge.net/latest/managedOnlineDeployment.schema.json

name: tfserving-deployment

endpoint_name: tfserving-endpoint

model:

name: tfserving-mounted

version: {{MODEL_VERSION}}

path: ./half_plus_two

environment_variables:

MODEL_BASE_PATH: /var/azureml-app/azureml-models/tfserving-mounted/{{MODEL_VERSION}}

MODEL_NAME: half_plus_two

environment:

#name: tfserving

#version: 1

image: docker.io/tensorflow/serving:latest

inference_config:

liveness_route:

port: 8501

path: /v1/models/half_plus_two

readiness_route:

port: 8501

path: /v1/models/half_plus_two

scoring_route:

port: 8501

path: /v1/models/half_plus_two:predict

instance_type: Standard_DS3_v2

instance_count: 1

Azure Machine Learning ワークスペースに接続する お使いの Azure Machine Learning ワークスペースに接続し、ワークスペースの詳細を構成し、次のようにワークスペースへのハンドルを取得します。

必要なライブラリをインポートします。

# import required libraries

from azure.ai.ml import MLClient

from azure.ai.ml.entities import (

ManagedOnlineEndpoint,

ManagedOnlineDeployment,

Model,

Environment,

CodeConfiguration,

)

from azure.identity import DefaultAzureCredential

ワークスペースの詳細を構成し、ワークスペースへのハンドルを取得します。

# enter details of your Azure Machine Learning workspace

subscription_id = "<SUBSCRIPTION_ID>"

resource_group = "<RESOURCE_GROUP>"

workspace = "<AZUREML_WORKSPACE_NAME>"

# get a handle to the workspace

ml_client = MLClient(

DefaultAzureCredential(), subscription_id, resource_group, workspace

)

詳細については、Python SDK v2 を使用した、マネージド オンライン エンドポイントへの機械学習モデルのデプロイ に関するページを参照してください。

name : エンドポイントの名前。 Azure リージョンで一意である必要があります。 エンドポイント名は、大文字または小文字で始まり、'-' と英数字のみで構成されている必要があります。 名前付け規則の詳細については、「エンドポイントの制限 」を参照してください。auth_mode: キーベースの認証に key を使用します。 Azure Machine Learning のトークン ベースの認証に aml_token を使用します。 key には有効期限がありませんが、aml_token には有効期限があります。 認証の詳細については、オンライン エンドポイントの認証 に関する記事を参照してください。

必要に応じて、説明やタグをエンドポイントに追加できます。

# Creating a unique endpoint name with current datetime to avoid conflicts

import datetime

online_endpoint_name = "endpoint-" + datetime.datetime.now().strftime("%m%d%H%M%f")

# create an online endpoint

endpoint = ManagedOnlineEndpoint(

name=online_endpoint_name,

description="this is a sample online endpoint",

auth_mode="key",

tags={"foo": "bar"},

)

デプロイは、実際の推論を実行するモデルをホストするのに必要なリソースのセットです。 ManagedOnlineDeployment クラスを使用してエンドポイントのデプロイを作成します。

name - デプロイの名前。endpoint_name - デプロイの作成先となるエンドポイントの名前。model - デプロイに使用するモデル。 この値は、ワークスペース内の既存のバージョン管理された > モデルへの参照またはインライン モデルの仕様のいずれかになります。environment - デプロイに使用する環境。 この値は、ワークスペース内の既存のバージョン管理された環境への参照、またはインライン環境仕様のいずれかになります。code_configuration - ソース コードとスコアリング スクリプトの構成

path - モデルをスコアリングするためのソース コード ディレクトリへのパスscoring_script - ソース コード ディレクトリ内のスコアリング ファイルへの相対パス

instance_type - デプロイに使用する VM サイズ。 サポートされているサイズの一覧については、エンドポイント SKU の一覧 に関するページを参照してください。instance_count - デプロイに使用するインスタンスの数

# create a blue deployment

model = Model(name="tfserving-mounted", version="1", path="half_plus_two")

env = Environment(

image="docker.io/tensorflow/serving:latest",

inference_config={

"liveness_route": {"port": 8501, "path": "/v1/models/half_plus_two"},

"readiness_route": {"port": 8501, "path": "/v1/models/half_plus_two"},

"scoring_route": {"port": 8501, "path": "/v1/models/half_plus_two:predict"},

},

)

blue_deployment = ManagedOnlineDeployment(

name="blue",

endpoint_name=online_endpoint_name,

model=model,

environment=env,

environment_variables={

"MODEL_BASE_PATH": "/var/azureml-app/azureml-models/tfserving-mounted/1",

"MODEL_NAME": "half_plus_two",

},

instance_type="Standard_DS2_v2",

instance_count=1,

)

この YAML または Python パラメーターには、注意すべき重要な概念がいくつかあります。

基本イメージは、環境内のパラメーターとして指定され、この例では docker.io/tensorflow/serving:latest が使用されています。 コンテナーを調べると、このサーバーが ENTRYPOINT を使用してエントリ ポイント スクリプトを開始していることがわかります。これにより、MODEL_BASE_PATH や MODEL_NAME のような環境変数を受け取り、8501 のようなポートを公開します。 これらの詳細はすべて、この選択したサーバーの特定の情報です。 サーバーに関するこの理解に基づいて、デプロイを定義する方法を決定できます。 たとえば、デプロイ定義で MODEL_BASE_PATH と MODEL_NAME の環境変数を設定した場合、サーバー (この場合は TF Serving) はサーバーを開始するための値を受け取ります。 同様に、デプロイ定義でルートのポートを 8501 に設定すると、該当するルートへのユーザー要求が TF Serving サーバーに正しくルーティングされます。

この具体的な例は TF Serving のケースに基づいていますが、稼働状態を維持し、liveness、readiness、スコアリング ルートに関する要求に応答する任意のコンテナーを使用できることに注意してください。 他の例を参照して、コンテナーを作成するために dockerfile がどのように構成されているか (たとえば、ENTRYPOINT の代わりに CMD を使用しているなど) を確認できます。

推論構成は環境内のパラメーターであり、3 種類のルート (liveness、readiness、スコアリング ルート) のポートとパスを指定します。 マネージド オンライン エンドポイントを使用して独自のコンテナーを実行する場合は、推論構成が必要です。

readiness ルートと liveness ルート 選択した API サーバーによって、サーバーの状態を確認する方法が提供される場合があります。 指定できるルートには、liveness と readiness の 2 種類があります。 liveness ルートは、サーバーが実行されているかどうかを調べるために使用されます。 readiness ルートは、サーバーが作業を行う準備ができているかどうかを調べるために使用されます。 機械学習推論のコンテキストでは、サーバーはモデルを読み込む前に liveness 要求に対して 200 OK を応答でき、また、サーバーはモデルがメモリに読み込まれた後でのみ、readiness 要求に対して 200 OK を応答できます。

一般的な liveness および readiness probe の詳細については、Kubernetes のドキュメント を参照してください。

liveness および readiness ルートは、前の手順でコンテナーをローカルでテストするときに特定したように、選択した API サーバーによって決定されます。 この記事のデプロイ例では、TF Serving で liveness ルートだけが定義されているため、liveness と readiness の両方に同じパスを使用することに注意してください。 ルートを定義するさまざまなパターンについては、他の例を参照してください。

選択した API サーバーによって、作業するペイロードを受け取る方法が提供されます。 機械学習推論のコンテキストでは、サーバーは特定のルートを介して入力データを受信します。 API サーバーのこのルートは、前の手順でコンテナーをローカルでテストするときに特定し、作成するデプロイを定義するときに指定します。

デプロイが正常に作成されると、エンドポイントのscoring_uri パラメーターも更新されることに注意してください。これは az ml online-endpoint show -n <name> --query scoring_uri を使用して確認できます。

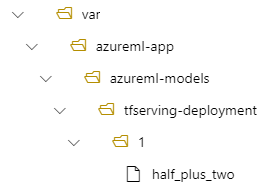

モデルをオンライン エンドポイントとしてデプロイすると、Azure Machine Learning によってモデルがエンドポイントに "マウント" されます。foo およびバージョン 1 で登録されたモデルは、デプロイされたコンテナーの内部の次のパスに配置されます: /var/azureml-app/azureml-models/foo/1

たとえば、ローカル コンピューター上にディレクトリ構造 /azureml-examples/cli/endpoints/online/custom-container があり、モデルの名前 がhalf_plus_two 場合は、次のようになります。

tfserving-deployment.yml には次のものが含まれます。

model:

name: tfserving-mounted

version: 1

path: ./half_plus_two

Model クラスには以下が含まれます。

model = Model(name="tfserving-mounted", version="1", path="half_plus_two")

その後、デプロイの /var/azureml-app/azureml-models/tfserving-deployment/1 の下にモデルが配置されます。

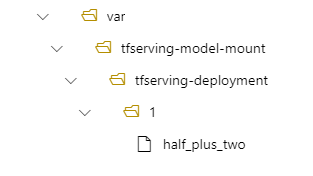

必要に応じて、model_mount_path を構成することもできます。 これにより、モデルがマウントされているパスを変更できます。

model_mount_path には、Linux (コンテナー イメージの OS) で有効な絶対パスを指定してください。

たとえば、以下のように tfserving-deployment.yml に model_mount_path パラメーターを含めることができます。

name: tfserving-deployment

endpoint_name: tfserving-endpoint

model:

name: tfserving-mounted

version: 1

path: ./half_plus_two

model_mount_path: /var/tfserving-model-mount

.....

たとえば、以下のように ManagedOnlineDeployment クラスに model_mount_path パラメーターを含めることができます。

blue_deployment = ManagedOnlineDeployment(

name="blue",

endpoint_name=online_endpoint_name,

model=model,

environment=env,

model_mount_path="/var/tfserving-model-mount",

...

)

その後、デプロイの /var/tfserving-model-mount/tfserving-deployment/1 にモデルが配置されます。 azureml-app/azureml-models ではなく、ご自分で指定したマウント パスの下に配置されます。

YAML の構築方法がわかったので、ご自分でエンドポイントを作成してください。

az ml online-endpoint create --name tfserving-endpoint -f endpoints/online/custom-container/tfserving-endpoint.yml

デプロイの作成には数分かかる場合があります。

az ml online-deployment create --name tfserving-deployment -f endpoints/online/custom-container/tfserving-deployment.yml --all-traffic

先ほど作成した MLClient を使用して、今度はワークスペースにエンドポイントを作成します。 このコマンドでは、エンドポイントの作成を開始し、エンドポイントの作成が続行されている間に確認応答を返します。

ml_client.begin_create_or_update(endpoint)

次を実行して作成およびデプロイします。

ml_client.begin_create_or_update(blue_deployment)

デプロイが完了したら、デプロイされたエンドポイントにスコアリング要求を行うことができるかどうかを確認します。

RESPONSE=$(az ml online-endpoint invoke -n $ENDPOINT_NAME --request-file $BASE_PATH/sample_request.json)

先ほど作成した MLClient を使用して、エンドポイントへのハンドルを取得します。 エンドポイントは、次のパラメーターを指定した invoke コマンドを使用して呼び出すことができます。

endpoint_name - エンドポイントの名前request_file - 要求データを含むファイルdeployment_name - エンドポイント内のテストする特定のデプロイの名前

JSON ファイルを使用してサンプル要求を送信します。 サンプル JSON はサンプル リポジトリ にあります。

# test the blue deployment with some sample data

ml_client.online_endpoints.invoke(

endpoint_name=online_endpoint_name,

deployment_name="blue",

request_file="sample-request.json",

)

エンドポイントで正常にスコアリングできたので、それを削除できます。

az ml online-endpoint delete --name tfserving-endpoint

ml_client.online_endpoints.begin_delete(name=online_endpoint_name)