컴퓨팅 구성 참조

이 문서에서는 컴퓨팅 UI 만들기에서 사용할 수 있는 모든 구성 설정을 설명합니다. 대부분의 사용자는 할당된 정책을 사용하여 컴퓨팅을 만들어 구성 가능한 설정을 제한합니다. UI에 특정 설정이 표시되지 않는 경우 선택한 정책에서 해당 설정을 구성할 수 없기 때문입니다.

이 문서에 설명된 구성 및 관리 도구는 다목적 컴퓨팅과 작업 컴퓨팅 모두에 적용됩니다. 작업 컴퓨팅 구성에 대한 자세한 고려 사항은 작업과 함께 Azure Databricks 컴퓨팅 사용을 참조 하세요.

정책

정책은 사용자가 컴퓨팅을 만들 때 사용할 수 있는 구성 옵션을 제한하는 데 사용되는 규칙 집합입니다. 사용자에게 무제한 클러스터 만들기 권한이 없는 경우 부여된 정책을 사용하여 컴퓨팅만 만들 수 있습니다.

정책에 따라 컴퓨팅을 만들려면 정책 드롭다운 메뉴에서 정책을 선택합니다.

기본적으로 모든 사용자는 개인 컴퓨팅 정책에 액세스할 수 있으므로 단일 컴퓨터 컴퓨팅 리소스를 만들 수 있습니다. Personal Compute 또는 추가 정책에 액세스해야 하는 경우 작업 영역 관리자에게 문의하세요.

단일 노드 또는 다중 노드 컴퓨팅

정책에 따라 단일 노드 컴퓨팅 또는 다중 노드 컴퓨팅을 만드는 중에서 선택할 수 있습니다.

단일 노드 컴퓨팅은 소량의 데이터 또는 단일 노드 기계 학습 라이브러리와 같은 분산되지 않은 워크로드를 사용하는 작업을 위한 것입니다. 다중 노드 컴퓨팅은 분산 워크로드가 있는 더 큰 작업에 사용해야 합니다.

단일 노드 속성

단일 노드 컴퓨팅에는 다음과 같은 속성이 있습니다.

- Spark를 로컬로 실행합니다.

- 드라이버는 작업자 노드가 없는 마스터 및 작업자 역할을 합니다.

- 컴퓨팅에서 논리 코어당 하나의 실행기 스레드를 생성하며 드라이버의 경우 코어 1개를 뺀 값입니다.

- 드라이버 로그에 모든

stderr및stdoutlog4j로그 출력을 저장합니다. - 다중 노드 컴퓨팅으로 변환할 수 없습니다.

단일 또는 다중 노드 선택

단일 또는 다중 노드 컴퓨팅 중에서 결정할 때 사용 사례를 고려합니다.

대규모 데이터 처리는 단일 노드 컴퓨팅에서 리소스를 소모합니다. 이러한 워크로드의 경우 Databricks는 다중 노드 컴퓨팅을 사용하는 것이 좋습니다.

단일 노드 컴퓨팅은 공유하도록 설계되지 않았습니다. 리소스 충돌을 방지하기 위해 Databricks는 컴퓨팅을 공유해야 하는 경우 다중 노드 컴퓨팅을 사용하는 것이 좋습니다.

다중 노드 컴퓨팅은 0명의 작업자로 확장할 수 없습니다. 대신 단일 노드 컴퓨팅을 사용합니다.

단일 노드 컴퓨팅은 프로세스 격리와 호환되지 않습니다.

GPU 예약은 단일 노드 컴퓨팅에서 사용하도록 설정되지 않습니다.

단일 노드 컴퓨팅에서 Spark는 UDT 열이 있는 Parquet 파일을 읽을 수 없습니다. 다음 오류 메시지가 표시됩니다.

The Spark driver has stopped unexpectedly and is restarting. Your notebook will be automatically reattached.이 문제를 해결하려면 네이티브 Parquet 판독기를 사용하지 않도록 설정합니다.

spark.conf.set("spark.databricks.io.parquet.nativeReader.enabled", False)

액세스 모드

액세스 모드는 컴퓨팅을 사용할 수 있는 사용자와 컴퓨팅을 통해 액세스할 수 있는 데이터를 결정하는 보안 기능입니다. Azure Databricks의 모든 컴퓨팅에는 액세스 모드가 있습니다.

Databricks는 모든 워크로드에 공유 액세스 모드를 사용하는 것이 좋습니다. 필요한 기능이 공유 액세스 모드에서 지원되지 않는 경우에만 단일 사용자 액세스 모드를 사용합니다.

| 액세스 모드 | 사용자에게 표시 | UC 지원 | 지원되는 언어 | 주의 |

|---|---|---|---|---|

| 단일 사용자 | 항상 | 예 | Python, SQL, Scala, R | 단일 사용자가 할당하고 사용할 수 있습니다. 일부 작업 영역에서 할당된 액세스 모드라고 합니다. |

| 공유 | 항상(프리미엄 플랜 필요) | 예 | Python(Databricks Runtime 11.3 LTS 이상), SQL, Scala(Databricks Runtime 13.3 LTS 이상을 사용하는 Unity 카탈로그 사용 컴퓨팅) | 사용자 간에 데이터 격리가 있는 여러 사용자가 사용할 수 있습니다. |

| 공유된 격리 없음 | 관리 관리자 설정 페이지에서 사용자 격리를 적용하여 이 액세스 모드를 숨길 수 있습니다. | 아니요 | Python, SQL, Scala, R | 격리 공유 없음 컴퓨팅에 대한 관련 계정 수준 설정이 있습니다. |

| 사용자 지정 | 숨김(모든 새 컴퓨팅의 경우) | 아니요 | Python, SQL, Scala, R | 이 옵션은 지정된 액세스 모드가 없는 기존 컴퓨팅이 있는 경우에만 표시됩니다. |

액세스 모드를 단일 사용자 또는 공유로 설정하여 Unity 카탈로그의 요구 사항을 충족하도록 기존 컴퓨팅을 업그레이드할 수 있습니다.

참고 항목

Databricks Runtime 13.3 LTS 이상에서는 모든 액세스 모드에서 init 스크립트 및 라이브러리가 지원됩니다. 요구 사항 및 지원은 다양합니다. Init 스크립트를 설치할 수 있는 위치 및 클러스터 범위 라이브러리를 참조하세요.

Databricks Runtime 버전

Databricks 런타임은 컴퓨팅에서 실행되는 핵심 구성 요소 집합입니다. Databricks 런타임 버전 드롭다운 메뉴를 사용하여 런타임을 선택합니다. 특정 Databricks 런타임 버전에 대한 자세한 내용은 Databricks 런타임 릴리스 정보 버전 및 호환성을 참조 하세요. 모든 버전에는 Apache Spark가 포함되었습니다. Databricks에서 권장하는 사항은 다음과 같습니다.

- 다목적 컴퓨팅의 경우 최신 버전을 사용하여 코드와 미리 로드된 패키지 간에 최신 최적화와 최신 호환성을 보장합니다.

- 작업 워크로드를 실행하는 작업 컴퓨팅의 경우 LTS(장기 지원) Databricks 런타임 버전을 사용하는 것이 좋습니다. LTS 버전을 사용하면 호환성 문제가 발생하지 않고 업그레이드 전에 워크로드를 철저히 테스트할 수 있습니다.

- 데이터 과학 및 기계 학습 사용 사례의 경우 Databricks Runtime ML 버전을 고려합니다.

Photon 가속 사용

Photon은 Databricks Runtime 9.1 LTS 이상을 실행하는 컴퓨팅에서 기본적으로 사용하도록 설정됩니다.

Photon 가속을 사용하거나 사용하지 않도록 설정하려면 Photon Acceleration 검사 사용 상자를 선택합니다. Photon에 대한 자세한 내용은 Photon이란?을 참조하세요.

작업자 및 드라이버 노드 형식

컴퓨팅은 하나의 드라이버 노드와 0개 이상의 작업자 노드로 구성됩니다. 기본적으로 드라이버 노드에서 작업자 노드와 동일한 인스턴스 유형을 사용하지만, 드라이버 및 작업자 노드에 대해 별도의 클라우드 공급자 인스턴스 유형을 선택할 수 있습니다. 다양한 인스턴스 유형 제품군은 메모리 집약적 또는 컴퓨팅 집약적 워크로드와 같은 다양한 사용 사례에 적합합니다.

작업자 또는 드라이버 노드로 사용할 풀을 선택할 수도 있습니다. Azure Databricks 풀이란?을 참조하세요.

작업자 유형

다중 노드 컴퓨팅에서 작업자 노드는 적절한 작동 컴퓨팅에 필요한 Spark 실행기 및 기타 서비스를 실행합니다. Spark를 사용하여 워크로드를 배포하면 모든 분산 처리가 작업자 노드에서 수행됩니다. Azure Databricks는 작업자 노드당 하나의 실행기를 실행합니다. 따라서 실행기와 작업자라는 용어는 Databricks 아키텍처의 컨텍스트에서 서로 교환적으로 사용됩니다.

팁

Spark 작업을 실행하려면 하나 이상의 작업자 노드가 필요합니다. 컴퓨팅에 작업자가 0인 경우 드라이버 노드에서 Spark가 아닌 명령을 실행할 수 있지만 Spark 명령은 실패합니다.

작업자 노드 IP 주소

Azure Databricks는 각각 두 개의 개인 IP 주소가 있는 작업자 노드를 시작합니다. 노드의 기본 개인 IP 주소는 Azure Databricks 내부 트래픽을 호스트합니다. 보조 개인 IP 주소는 클러스터 내 통신을 위해 Spark 컨테이너에서 사용됩니다. 이 모델을 사용하면 Azure Databricks가 동일한 작업 영역의 여러 컴퓨팅 간에 격리를 제공할 수 있습니다.

드라이버 형식

드라이버 노드는 컴퓨팅에 연결된 모든 Notebook의 상태 정보를 기본. 또한 드라이버 노드는 sparkContext를 기본, Notebook 또는 컴퓨팅의 라이브러리에서 실행하는 모든 명령을 해석하고, Spark 실행기와 조정되는 Apache Spark 마스터를 실행합니다.

드라이버 노드 유형의 기본값은 작업자 노드 유형과 동일합니다. Spark 작업자에서 많은 데이터를 수집하고(collect()) 이를 Notebook에서 분석하려는 경우 더 많은 메모리가 있는 더 큰 드라이버 노드 유형을 선택할 수 있습니다.

팁

드라이버 노드는 연결된 Notebook의 모든 상태 정보를 유지 관리하므로 드라이버 노드에서 사용하지 않는 Notebook을 분리해야 합니다.

GPU 인스턴스 유형

딥 러닝과 관련된 작업과 같이 고성능을 요구하는 계산적으로 어려운 작업의 경우 Azure Databricks는 GPU(그래픽 처리 장치)로 가속화된 컴퓨팅을 지원합니다. 자세한 내용은 GPU 사용 컴퓨팅을 참조 하세요.

Azure 기밀 컴퓨팅 VM

Azure 기밀 컴퓨팅 VM 유형은 클라우드 운영자를 포함하여 사용 중인 데이터에 대한 무단 액세스를 방지합니다. 이 VM 유형은 고도로 규제되는 산업 및 지역뿐만 아니라 클라우드에서 중요한 데이터가 있는 기업에 유용합니다. Azure의 기밀 컴퓨팅에 대한 자세한 내용은 Azure 기밀 컴퓨팅을 참조 하세요.

Azure 기밀 컴퓨팅 VM을 사용하여 워크로드를 실행하려면 작업자 및 드라이버 노드 드롭다운에서 DC 또는 EC 시리즈 VM 유형 중에서 선택합니다. Azure 기밀 VM 옵션을 참조하세요.

스폿 인스턴스

비용을 절약하기 위해 스폿 인스턴스 확인란을 선택하여 Azure 스폿 VM이라고도 하는 스폿 인스턴스를 사용하도록 선택할 수 있습니다.

첫 번째 인스턴스는 항상 주문형이고(드라이버 노드가 항상 주문형) 후속 인스턴스는 스폿 인스턴스가 됩니다.

사용 불가로 인해 인스턴스가 제거되면 Azure Databricks는 제거된 인스턴스를 대체하기 위해 새 스폿 인스턴스를 획득하려고 시도합니다. 스폿 인스턴스를 획득할 수 없는 경우 주문형 인스턴스가 배포되어 제거된 인스턴스를 대체합니다. 또한 새 노드가 기존 컴퓨팅에 추가되면 Azure Databricks는 해당 노드에 대한 스폿 인스턴스를 획득하려고 시도합니다.

자동 크기 조정 사용

자동 크기 조정 사용이 검사 경우 컴퓨팅에 대한 최소 및 최대 작업자 수를 제공할 수 있습니다. 그런 다음 Databricks는 작업을 실행하는 데 필요한 적절한 작업자 수를 선택합니다.

컴퓨팅에서 자동 크기 조정할 최소 및 최대 작업자 수를 설정하려면 작업자 유형 드롭다운 옆에 최소 작업자 및 최대 작업자 필드를 사용합니다.

자동 크기 조정을 사용하도록 설정하지 않으면 작업자 유형 드롭다운 옆에 작업자 필드에 고정된 수의 작업자 를 입력합니다.

참고 항목

컴퓨팅이 실행 중이면 컴퓨팅 세부 정보 페이지에 할당된 작업자 수가 표시됩니다. 할당된 작업자 수를 작업자 구성과 비교하고 필요에 따라 조정할 수 있습니다.

자동 크기 조정의 이점

자동 크기 조정을 사용하면 Azure Databricks에서 작업 특성을 고려하여 작업자를 동적으로 다시 할당합니다. 파이프라인의 특정 부분은 다른 부분보다 더 많은 계산을 요구할 수 있으며, Databricks는 이러한 작업 단계에서 추가 작업자를 자동으로 추가하고 더 이상 필요하지 않은 경우 제거합니다.

자동 크기 조정을 사용하면 워크로드와 일치하도록 컴퓨팅을 프로비전할 필요가 없으므로 높은 사용률을 쉽게 달성할 수 있습니다. 특히 이는 시간이 지남에 따라 요구 사항이 변경되는 워크로드(예: 하루 중 데이터 세트 검색)에 적용되지만 프로비전 요구 사항을 알 수 없는 짧은 일회성 워크로드에도 적용될 수 있습니다. 따라서 자동 크기 조정에서 제공하는 두 가지 이점은 다음과 같습니다.

- 워크로드는 일정한 크기의 언더 프로비저닝된 컴퓨팅에 비해 더 빠르게 실행될 수 있습니다.

- 자동 크기 조정은 정적으로 크기가 지정된 컴퓨팅에 비해 전체 비용을 줄일 수 있습니다.

컴퓨팅 및 워크로드의 일정한 크기에 따라 자동 크기 조정은 이러한 이점을 하나 또는 둘 다 동시에 제공합니다. 컴퓨팅 크기는 클라우드 공급자가 인스턴스를 종료할 때 선택한 최소 작업자 수보다 낮을 수 있습니다. 이 경우 Azure Databricks는 최소 작업자 수를 유지하기 위해 인스턴스를 다시 프로비전하려고 지속적으로 다시 시도합니다.

참고 항목

자동 크기 조정은 spark-submit 작업에 사용할 수 없습니다.

참고 항목

컴퓨팅 자동 크기 조정에는 구조적 스트리밍 워크로드에 대한 클러스터 크기를 축소하는 데 제한이 있습니다. Databricks는 스트리밍 워크로드에 대해 향상된 자동 크기 조정과 함께 Delta Live Tables를 사용하는 것이 좋습니다. 향상된 자동 크기 조정을 사용하여 Delta Live Tables 파이프라인의 클러스터 사용률 최적화를 참조 하세요.

자동 크기 조정 동작 방법

프리미엄 및 엔터프라이즈 가격 책정 계획의 작업 영역은 최적화된 자동 크기 조정을 사용합니다. 표준 가격 책정 계획의 작업 영역은 표준 자동 크기 조정을 사용합니다.

최적화된 자동 크기 조정에는 다음과 같은 특징이 있습니다.

- 최소에서 최대로 2단계로 스케일 업합니다

- 순서 섞기 파일 상태를 확인하여 컴퓨팅이 유휴 상태가 아니더라도 축소할 수 있습니다.

- 현재 노드의 백분율에 따라 스케일 다운합니다.

- 작업 컴퓨팅에서 지난 40초 동안 컴퓨팅의 사용량이 부족한 경우 축소합니다.

- 다목적 컴퓨팅에서 지난 150초 동안 컴퓨팅을 과소 사용하는 경우 스케일 다운됩니다.

- Spark 구성 속성은

spark.databricks.aggressiveWindowDownS컴퓨팅이 다운 스케일링 결정을 내리는 빈도를 초 단위로 지정합니다. 값을 늘리면 컴퓨팅이 더 느리게 축소됩니다. 최댓값은 600입니다.

표준 자동 크기 조정은 표준 계획 작업 영역에서 사용됩니다. 표준 자동 크기 조정에는 다음과 같은 특징이 있습니다.

- 8개의 노드를 추가하는 것으로 시작합니다. 그런 다음, 최대값에 도달하는 데 필요한 만큼의 단계를 수행하여 기하급수적으로 확장합니다.

- 노드의 90%가 10분 동안 사용 중이 아니고 컴퓨팅이 30초 이상 유휴 상태이면 축소됩니다.

- 하나의 노드부터 시작하여 기하급수적으로 스케일 다운합니다.

풀을 사용하여 자동 크기 조정

컴퓨팅을 풀에 연결하는 경우 다음을 고려합니다.

- 요청된 컴퓨팅 크기가 풀의 최소 유휴 인스턴스 수보다 작거나 같은 지 확인합니다 . 더 큰 경우 컴퓨팅 시작 시간은 풀을 사용하지 않는 컴퓨팅과 동일합니다.

- 최대 컴퓨팅 크기가 풀의 최대 용량보다 작거나 같은지 확인합니다. 더 큰 경우 컴퓨팅 생성이 실패합니다.

자동 크기 조정 예

자동 크기 조정을 위해 정적 컴퓨팅을 다시 구성하는 경우 Azure Databricks는 즉시 최소 및 최대 범위 내에서 컴퓨팅의 크기를 조정한 다음 자동 크기 조정을 시작합니다. 예를 들어 다음 표에서는 5~10개 노드 간에 자동 크기 조정하도록 컴퓨팅을 다시 구성하는 경우 특정 초기 크기로 컴퓨팅하는 방법을 보여 줍니다.

| 처음 크기 | 재구성 후 크기 |

|---|---|

| 6 | 6 |

| 12 | 10 |

| 3 | 5 |

로컬 스토리지 자동 크기 조정 사용

특정 작업에 필요한 디스크 공간을 예측하기 어려울 수 있는 경우가 많습니다. 생성 시 컴퓨팅에 연결할 관리 디스크의 기가바이트 수를 예측할 필요가 없도록 하기 위해 Azure Databricks는 모든 Azure Databricks 컴퓨팅에서 로컬 스토리지의 자동 크기 조정을 자동으로 사용하도록 설정합니다.

자동 크기 조정 로컬 스토리지를 사용하여 Azure Databricks는 컴퓨팅의 Spark 작업자에서 사용 가능한 사용 가능한 디스크 공간의 양을 모니터링합니다. 작업자가 디스크에서 너무 느리게 실행되기 시작하면 Databricks에서 디스크 공간이 부족하기 전에 새 관리 디스크를 작업자에 자동으로 연결합니다. 디스크는 가상 머신의 초기 로컬 저장소를 포함하여 가상 머신당 총 디스크 공간의 최대 5TB까지 연결됩니다.

가상 머신이 Azure로 반환되는 경우에만 가상 머신에 연결된 관리 디스크가 분리됩니다. 즉, 관리 디스크는 실행 중인 컴퓨팅의 일부인 경우 가상 머신에서 분리되지 않습니다. 관리 디스크 사용량을 축소하기 위해 Azure Databricks는 자동 크기 조정 컴퓨팅 또는 자동 종료로 구성된 컴퓨팅에서 이 기능을 사용하는 것이 좋습니다.

로컬 디스크 암호화

Important

이 기능은 공개 미리 보기 상태입니다.

컴퓨팅을 실행하는 데 사용하는 일부 인스턴스 유형에는 로컬로 연결된 디스크가 있을 수 있습니다. Azure Databricks는 순서 섞기 데이터 또는 임시 데이터를 이러한 로컬로 연결된 디스크에 저장할 수 있습니다. 컴퓨팅의 로컬 디스크에 일시적으로 저장된 데이터 순서 섞기를 포함하여 모든 스토리지 유형에 대해 미사용 데이터가 암호화되도록 하려면 로컬 디스크 암호화를 사용하도록 설정할 수 있습니다.

Important

로컬 볼륨에서 암호화된 데이터 읽기 및 쓰기의 성능 영향으로 인해 워크로드가 더 느리게 실행될 수 있습니다.

로컬 디스크 암호화를 사용하도록 설정하면 Azure Databricks는 각 컴퓨팅 노드에 고유하고 로컬 디스크에 저장된 모든 데이터를 암호화하는 데 사용되는 암호화 키를 로컬로 생성합니다. 키의 범위는 각 컴퓨팅 노드에 로컬이며 컴퓨팅 노드 자체와 함께 제거됩니다. 수명 동안 키는 암호화 및 암호 해독을 위해 메모리에 상주하며 암호화된 상태로 디스크에 저장됩니다.

로컬 디스크 암호화를 사용하도록 설정하려면 클러스터 API를 사용해야 합니다. 컴퓨팅을 만들거나 편집 enable_local_disk_encryption 하는 true동안 .

자동 종료

컴퓨팅에 대한 자동 종료를 설정할 수 있습니다. 컴퓨팅을 만드는 동안 몇 분 안에 비활성 기간을 지정하여 컴퓨팅을 종료합니다.

컴퓨팅에서 현재 시간과 마지막 명령 실행 간의 차이가 지정된 비활성 기간보다 큰 경우 Azure Databricks는 해당 컴퓨팅을 자동으로 종료합니다. 컴퓨팅 종료에 대한 자세한 내용은 컴퓨팅 종료를 참조 하세요.

태그

태그를 사용하면 조직의 다양한 그룹에서 사용하는 클라우드 리소스의 비용을 쉽게 모니터링할 수 있습니다. 컴퓨팅을 만들 때 태그를 키-값 쌍으로 지정하고, Azure Databricks는 이러한 태그를 VM 및 디스크 볼륨과 같은 클라우드 리소스와 DBU 사용 현황 보고서에 적용합니다.

풀에서 시작된 컴퓨팅의 경우 사용자 지정 태그는 DBU 사용 보고서에만 적용되며 클라우드 리소스에 전파되지 않습니다.

풀 및 컴퓨팅 태그 유형이 함께 작동하는 방법에 대한 자세한 내용은 태그를 사용하여 사용량 모니터링을 참조 하세요.

컴퓨팅에 태그를 추가하려면 다음을 수행합니다.

- 태그 섹션에서 각 사용자 지정 태그에 대한 키-값 쌍을 추가합니다.

- 추가를 클릭합니다.

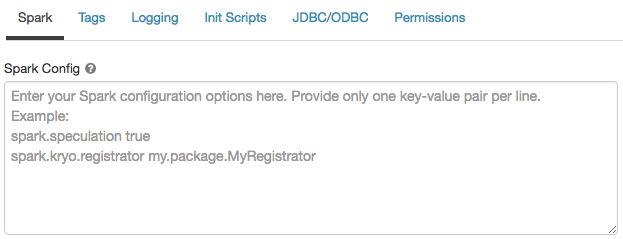

Spark 구성

Spark 작업을 미세 조정하려면 사용자 지정 Spark 구성 속성을 제공할 수 있습니다.

컴퓨팅 구성 페이지에서 고급 옵션 토글을 클릭합니다.

Spark 탭을 클릭합니다.

Spark 구성에서 구성 속성을 줄당 하나의 키-값 쌍으로 입력합니다.

클러스터 API를 사용하여 컴퓨팅을 구성할 때 클러스터 API 만들기 또는 업데이트 클러스터 API의 필드에 Spark 속성을 spark_conf 설정합니다.

컴퓨팅에 Spark 구성을 적용하기 위해 작업 영역 관리자는 컴퓨팅 정책을 사용할 수 있습니다.

비밀에서 Spark 구성 속성 검색

Databricks는 암호와 같은 중요한 정보를 일반 텍스트 대신 비밀로 저장하도록 권장합니다. Spark 구성에서 비밀을 참조하려면 다음 구문을 사용합니다.

spark.<property-name> {{secrets/<scope-name>/<secret-name>}}

예를 들어 다음과 같이 password라는 Spark 구성 속성을 secrets/acme_app/password에 저장된 비밀 값으로 설정합니다.

spark.password {{secrets/acme-app/password}}

자세한 내용은 Spark 구성 속성 또는 환경 변수에서 비밀을 참조하는 구문을 참조하세요.

컴퓨팅에 대한 SSH 액세스

보안상의 이유로 Azure Databricks에서 SSH 포트는 기본적으로 닫힙니다. Spark 클러스터에 대한 SSH 액세스를 사용하도록 설정하려면 드라이버 노드에 대한 SSH를 참조하세요.

참고 항목

작업 영역이 사용자 고유의 Azure 가상 네트워크에 배포되는 경우에만 SSH를 사용하도록 설정할 수 있습니다.

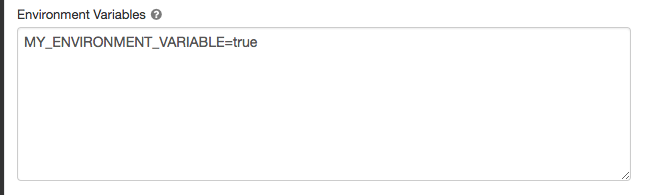

환경 변수

컴퓨팅에서 실행되는 init 스크립트에서 액세스할 수 있는 사용자 지정 환경 변수를 구성합니다 . Databricks는 또한 init 스크립트에서 사용할 수 있는 미리 정의된 환경 변수를 제공합니다. 이러한 미리 정의된 환경 변수는 재정의할 수 없습니다.

컴퓨팅 구성 페이지에서 고급 옵션 토글을 클릭합니다.

Spark 탭을 클릭합니다.

환경 변수 필드에서 환경 변수를 설정합니다.

클러스터 만들기 API 또는 업데이트 클러스터 API의 spark_env_vars필드를 사용하여 환경 변수를 설정할 수도 있습니다.

컴퓨팅 로그 배달

컴퓨팅을 만들 때 Spark 드라이버 노드, 작업자 노드 및 이벤트에 대한 로그를 배달할 위치를 지정할 수 있습니다. 로그는 5분마다 배달되고 선택한 대상에 매시간 보관됩니다. 컴퓨팅이 종료되면 Azure Databricks는 컴퓨팅이 종료될 때까지 생성된 모든 로그를 배달하도록 보장합니다.

로그의 대상은 컴퓨팅 cluster_id에 따라 달라집니다. 지정된 대상이 dbfs:/cluster-log-delivery면 컴퓨팅 로그가 0630-191345-leap375 .에 dbfs:/cluster-log-delivery/0630-191345-leap375전달됩니다.

로그 전달 위치를 구성하려면 다음을 수행합니다.

- 컴퓨팅 페이지에서 고급 옵션 토글을 클릭합니다.

- 로깅 탭을 클릭합니다.

- 대상 유형을 선택합니다.

- 컴퓨팅 로그 경로를 입력합니다.

참고 항목

이 기능은 REST API에서도 사용할 수 있습니다. 클러스터 API를 참조하세요.

피드백

출시 예정: 2024년 내내 콘텐츠에 대한 피드백 메커니즘으로 GitHub 문제를 단계적으로 폐지하고 이를 새로운 피드백 시스템으로 바꿀 예정입니다. 자세한 내용은 다음을 참조하세요. https://aka.ms/ContentUserFeedback

다음에 대한 사용자 의견 제출 및 보기