Model evalueren

Belangrijk

De ondersteuning voor Azure Machine Learning-studio (klassiek) eindigt op 31 augustus 2024. U wordt aangeraden om vóór die datum over te stappen naar Azure Machine Learning.

Vanaf 1 december 2021 kunt u geen nieuwe resources voor Azure Machine Learning-studio (klassiek) meer maken. Tot en met 31 augustus 2024 kunt u de bestaande resources van Azure Machine Learning-studio (klassiek) blijven gebruiken.

- Zie informatie over het verplaatsen van machine learning-projecten van ML Studio (klassiek) naar Azure Machine Learning.

- Meer informatie over Azure Machine Learning.

De documentatie van ML-studio (klassiek) wordt buiten gebruik gesteld en wordt in de toekomst mogelijk niet meer bijgewerkt.

Evalueert de resultaten van een classificatie- of regressiemodel met standaardgegevens

Categorie: Machine Learning / Evalueren

Notitie

Van toepassing op: alleen Machine Learning Studio (klassiek)

Vergelijkbare modules voor slepen en neerzetten zijn beschikbaar in Azure Machine Learning designer.

Moduleoverzicht

In dit artikel wordt beschreven hoe u de module Evaluate Model gebruikt in Machine Learning Studio (klassiek) om de nauwkeurigheid van een getraind model te meten. U geeft een gegevensset op die scores bevat die zijn gegenereerd op basis van een model en de module Evaluate Model berekent een set metrische metrische evaluatiegegevens die standaard zijn voor de industrie.

De metrische gegevens die door Evaluate Model worden geretourneerd, zijn afhankelijk van het type model dat u evalueert:

Voor aanbevelingsmodellen gebruikt u de module Evaluate Recommender .

Tip

Als u niet bekend bent met modelevaluatie, raden we deze voorbeelden aan in de Azure AI Gallery, die een model bouwen en vervolgens uitleggen hoe u de gerelateerde metrische gegevens gebruikt:

- Regressiemodellen vergelijken

- Binaire classificaties vergelijken

- Classificaties voor meerdere klassen vergelijken

We raden ook de videoserie van Dr. Stephen Elston aan als onderdeel van de machine learning-cursus van EdX.

Evaluate Model gebruiken

Er zijn drie manieren om de module Evaluate Model te gebruiken:

- Scores genereren op basis van uw trainingsgegevens en het model evalueren op basis van deze scores

- Scores genereren op het model, maar deze scores vergelijken met scores in een gereserveerde testset

- Scores vergelijken voor twee verschillende maar gerelateerde modellen, met behulp van dezelfde set gegevens

De trainingsgegevens gebruiken

Als u een model wilt evalueren, moet u een gegevensset verbinden die een set invoerkolommen en scores bevat. Als er geen andere gegevens beschikbaar zijn, kunt u de oorspronkelijke gegevensset gebruiken.

- Verbinding maken de scored-uitvoer van het scoremodel naar de invoer van Evaluate Model.

- Klik op De module Model evalueren en selecteer Uitvoeren geselecteerd om de evaluatiescores te genereren.

Testgegevens gebruiken

Een veelvoorkomend scenario in machine learning is het scheiden van uw oorspronkelijke gegevensset in trainings- en testgegevenssets, met behulp van de splitsmodule of de module Partitie en voorbeeld .

- Verbinding maken de uitvoer van de scoregegevensset van het scoremodel naar de invoer van Evaluate Model.

- Verbinding maken de uitvoer van de module Split Data met de testgegevens naar de rechterinvoer van Evaluate Model.

- Klik op De module Model evalueren en selecteer Uitvoeren geselecteerd om de evaluatiescores te genereren.

Scores van twee modellen vergelijken

U kunt ook een tweede set scores verbinden met Evaluate Model. De scores kunnen een gedeelde evaluatieset zijn met bekende resultaten of een set resultaten van een ander model voor dezelfde gegevens.

Deze functie is handig omdat u eenvoudig resultaten van twee verschillende modellen op dezelfde gegevens kunt vergelijken. Of u kunt scores uit twee verschillende uitvoeringen vergelijken met dezelfde gegevens met verschillende parameters.

- Verbinding maken de scored-uitvoer van het scoremodel naar de invoer van Evaluate Model.

- Verbinding maken de uitvoer van de module Score Model voor het tweede model naar de rechterinvoer van Evaluate Model.

- Klik met de rechtermuisknop op Evaluate Model en selecteer Uitvoeren geselecteerd om de evaluatiescores te genereren.

Resultaten

Nadat u Evaluate Model hebt uitgevoerd, klikt u met de rechtermuisknop op de module en selecteert u Evaluatieresultaten om de resultaten te bekijken. U kunt:

- Sla de resultaten op als een gegevensset, voor een eenvoudigere analyse met andere hulpprogramma's

- Een visualisatie genereren in de Studio-interface (klassiek)

Als u gegevenssets verbindt met beide invoer van Evaluate Model, bevatten de resultaten metrische gegevens voor beide gegevenssets of beide modellen. Het model of de gegevens die aan de linkerpoort zijn gekoppeld, worden eerst weergegeven in het rapport, gevolgd door de metrische gegevens voor de gegevensset of het model dat is gekoppeld aan de rechterpoort.

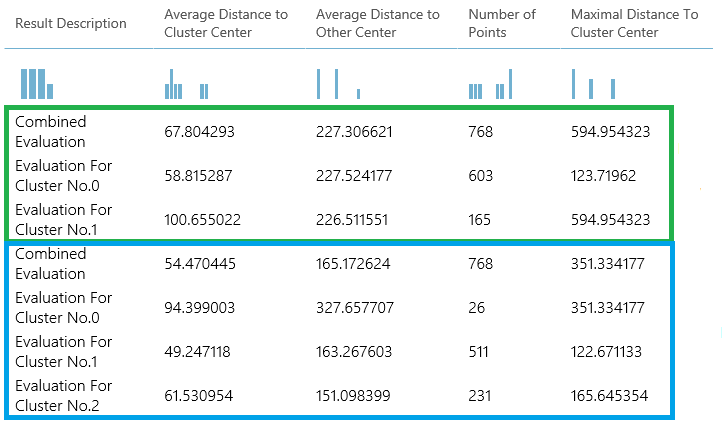

De volgende afbeelding vertegenwoordigt bijvoorbeeld een vergelijking van de resultaten van twee clusteringmodellen die zijn gebouwd op dezelfde gegevens, maar met verschillende parameters.

Omdat dit een clusteringmodel is, zijn de evaluatieresultaten anders dan als u scores van twee regressiemodellen hebt vergeleken of twee classificatiemodellen hebt vergeleken. De algemene presentatie is echter hetzelfde.

Metrische gegevens

In deze sectie worden de metrische gegevens beschreven die worden geretourneerd voor de specifieke typen modellen die worden ondersteund voor gebruik met Evaluate Model:

Metrische gegevens voor classificatiemodellen

De volgende metrische gegevens worden gerapporteerd bij het evalueren van classificatiemodellen. Als u modellen vergelijkt, worden deze gerangschikt op basis van de metrische gegevens die u selecteert voor evaluatie.

Nauwkeurigheid meet de goedheid van een classificatiemodel als het aandeel werkelijke resultaten in totaal.

Precisie is het aandeel werkelijke resultaten voor alle positieve resultaten.

Relevante overeenkomsten zijn de fractie van alle juiste resultaten die door het model worden geretourneerd.

F-score wordt berekend als het gewogen gemiddelde van precisie en relevante overeenkomsten tussen 0 en 1, waarbij de ideale F-scorewaarde 1 is.

AUC meet het gebied onder de curve met terecht-positieven op de y-as en fout-positieven op de x-as. Deze metrische waarde is handig omdat het één getal biedt waarmee u modellen van verschillende typen kunt vergelijken.

Gemiddeld logboekverlies is één score die wordt gebruikt om de boete voor verkeerde resultaten uit te drukken. Dit wordt berekend als het verschil tussen twee waarschijnlijkheidsverdelingen: de werkelijke verdeling en het verschil in het model.

Het verlies van trainingslogboeken is één score die het voordeel van de classificatie vertegenwoordigt ten opzichte van een willekeurige voorspelling. Het logboekverlies meet de onzekerheid van uw model door de waarschijnlijkheid te vergelijken met de bekende waarden (grondwaar) in de labels. U wilt het logboekverlies voor het model als geheel minimaliseren.

Metrische gegevens voor regressiemodellen

De metrische gegevens die worden geretourneerd voor regressiemodellen zijn over het algemeen ontworpen om de hoeveelheid fouten te schatten. Een model wordt beschouwd als geschikt voor de gegevens als het verschil tussen waargenomen en voorspelde waarden klein is. Als u echter het patroon van de residuen bekijkt (het verschil tussen een voorspeld punt en de bijbehorende werkelijke waarde) kunt u veel vertellen over mogelijke vooroordelen in het model.

De volgende metrische gegevens worden gerapporteerd voor het evalueren van regressiemodellen. Wanneer u modellen vergelijkt, worden deze gerangschikt op basis van de metrische gegevens die u selecteert voor evaluatie.

Negatieve logboekkans meet de verliesfunctie, een lagere score is beter. Houd er rekening mee dat deze metrische waarde alleen wordt berekend voor Bayesian Linear Regression en Decision Forest Regression; voor andere algoritmen is

Infinityde waarde voor niets.Gemiddelde absolute fout (MAE) meet hoe dicht de voorspellingen bij de werkelijke resultaten liggen; dus, een lagere score is beter.

De wortel van de gemiddelde kwadratische fout (RMSE) maakt één waarde die de fout in het model samenvat. Door het verschil te kwadraten, negeert de metrische waarde het verschil tussen overvoorspelling en ondervoorspelling.

Relatieve absolute fout (RAE) is het relatieve absolute verschil tussen verwachte en werkelijke waarden; relatief omdat het gemiddelde verschil wordt gedeeld door het rekenkundige gemiddelde.

De relatieve kwadratische fout (RSE) normaliseert op vergelijkbare wijze de totale kwadratische fout van de voorspelde waarden door de totale kwadratische fout van de werkelijke waarden te delen.

Mean Zero One Error (MZOE) geeft aan of de voorspelling juist is of niet. Met andere woorden:

ZeroOneLoss(x,y) = 1wanneerx!=y; anders0.De bepalingscoëfficiënt, ook wel R2 genoemd, vertegenwoordigt de voorspellende kracht van het model als een waarde tussen 0 en 1. Nul betekent dat het model willekeurig is (legt niets uit); 1 betekent dat er een perfecte pasvorm is. Wees echter voorzichtig bij het interpreteren van R2-waarden , omdat lage waarden volledig normaal kunnen zijn en hoge waarden kunnen worden vermoed.

Metrische gegevens voor clusteringmodellen

Omdat clusteringmodellen in veel opzichten aanzienlijk verschillen van classificatie- en regressiemodellen, retourneert Evaluate Model ook een andere set statistieken voor clusteringmodellen.

De statistieken die worden geretourneerd voor een clusteringmodel beschrijven hoeveel gegevenspunten aan elk cluster zijn toegewezen, de hoeveelheid scheiding tussen clusters en hoe nauw de gegevenspunten in elk cluster worden gegroepeerd.

De statistieken voor het clusteringmodel zijn gemiddeld over de hele gegevensset, met extra rijen met de statistieken per cluster.

In de volgende resultaten ziet u bijvoorbeeld een deel van de resultaten van een voorbeeldexperiment waarin de gegevens worden geclusterd in de gegevensset PIMA Indian Diabetes Binary Classification, die beschikbaar is in Machine Learning Studio (klassiek).

| Resultaatbeschrijving | Gemiddelde afstand tot clustercentrum | Gemiddelde afstand tot ander midden | Aantal punten | Maximale afstand tot clustercentrum |

|---|---|---|---|---|

| Gecombineerde evaluatie | 55.915068 | 169.897505 | 538 | 303.545166 |

| Evaluatie voor cluster no.0 | 0 | 1 | 570 | 0 |

| Evaluatie voor cluster nr.1 | 0 | 1 | 178 | 0 |

| Evaluatie voor cluster nr.2 | 0 | 1 | 178 | 0 |

In deze resultaten krijgt u de volgende informatie:

Met de module Sweep Clustering worden meerdere clusteringmodellen gemaakt, die worden vermeld in volgorde van nauwkeurigheid. Voor het gemak hebben we hier alleen het best gerangschikte model getoond. Modellen worden gemeten met behulp van alle mogelijke metrische gegevens, maar de modellen worden gerangschikt met behulp van de metrische gegevens die u hebt opgegeven. Als u de metrische waarde hebt gewijzigd, wordt een ander model mogelijk hoger gerangschikt.

De gecombineerde evaluatiescore boven aan elke sectie met resultaten bevat de gemiddelde scores voor de clusters die in dat specifieke model zijn gemaakt.

Dit meest gerangschikte model is opgetreden bij het maken van drie clusters; andere modellen kunnen twee clusters of vier clusters maken. Deze gecombineerde evaluatiescore helpt u daarom bij het vergelijken van modellen met verschillende clusters.

De scores in de kolom Gemiddelde afstand tot clustercentrum vertegenwoordigen de nabijheid van alle punten in een cluster tot het middelpunt van dat cluster.

De scores in de kolom, Gemiddelde afstand tot ander centrum, geven aan hoe dicht, gemiddeld, elk punt in het cluster de zwaartepunten van alle andere clusters is.

U kunt een van de vier metrische gegevens kiezen om deze afstand te meten, maar alle metingen moeten dezelfde metrische gegevens gebruiken.

In de kolom Aantal punten ziet u hoeveel gegevenspunten aan elk cluster zijn toegewezen, samen met het totale totale aantal gegevenspunten in een cluster.

Als het aantal gegevenspunten dat is toegewezen aan clusters kleiner is dan het totale aantal beschikbare gegevenspunten, betekent dit dat de gegevenspunten niet kunnen worden toegewezen aan een cluster.

De scores in de kolom Maximal Distance to Cluster Center vertegenwoordigen de som van de afstanden tussen elk punt en het middelpunt van het cluster van dat punt.

Als dit aantal hoog is, kan dit betekenen dat het cluster veel verspreid is. U moet deze statistiek samen met het gemiddelde afstand tot clustercentrum controleren om de verspreiding van het cluster te bepalen.

Voorbeelden

Zie deze voorbeeldexperimenten in de Azure AI Gallery voor voorbeelden van het genereren, visualiseren en interpreteren van metrische evaluatiegegevens. In deze experimenten wordt gedemonstreerd hoe u meerdere modellen bouwt en evalueert om te bepalen welk model het beste is.

Binaire classificaties vergelijken: hierin wordt uitgelegd hoe u de prestaties van verschillende classificaties vergelijkt die zijn gebouwd met dezelfde gegevens.

Vergelijking van classificaties met meerdere klassen: laat zien hoe u de nauwkeurigheid van verschillende classificatiemodellen vergelijkt die zijn gebouwd op de gegevensset voor letterherkenning.

Regressors vergelijken: begeleidt u bij het evalueren van verschillende regressiemodellen.

Schatting van de vraag: leer hoe u metrische evaluatiegegevens van meerdere modellen combineert.

Voorspelling van klantrelaties: laat zien hoe u meerdere gerelateerde modellen evalueert.

Verwachte invoer

| Naam | Type | Beschrijving |

|---|---|---|

| Scored gegevensset | Gegevenstabel | Scored gegevensset |

| Scored gegevensset om te vergelijken | Gegevenstabel | Scored gegevensset om te vergelijken (optioneel) |

Uitvoerwaarden

| Naam | Type | Beschrijving |

|---|---|---|

| Evaluatieresultaten | Gegevenstabel | Resultaat van gegevensevaluatie |

Uitzonderingen

| Uitzondering | Beschrijving |

|---|---|

| Fout 0003 | Uitzondering treedt op als een of meer invoerwaarden null of leeg zijn. |

| Fout 0013 | Uitzondering treedt op als doorgegeven aan moduleleerster ongeldig type heeft. |

| Fout 0020 | Uitzondering treedt op als het aantal kolommen in sommige gegevenssets dat aan de module is doorgegeven, te klein is. |

| Fout 0021 | Uitzondering treedt op als het aantal rijen in sommige gegevenssets dat aan de module is doorgegeven, te klein is. |

| Fout 0024 | Uitzondering treedt op als de gegevensset geen labelkolom bevat. |

| Fout 0025 | Uitzondering treedt op als de gegevensset geen scorekolom bevat. |

Zie ook

Model kruisvalideert

Aanbevelingsfunctie voor evaluatie

Evalueren

Score Model