Machine Learning - Evalueren

Belangrijk

De ondersteuning voor Azure Machine Learning-studio (klassiek) eindigt op 31 augustus 2024. U wordt aangeraden om vóór die datum over te stappen naar Azure Machine Learning.

Vanaf 1 december 2021 kunt u geen nieuwe resources voor Azure Machine Learning-studio (klassiek) meer maken. Tot en met 31 augustus 2024 kunt u de bestaande resources van Azure Machine Learning-studio (klassiek) blijven gebruiken.

- Zie informatie over het verplaatsen van machine learning-projecten van ML Studio (klassiek) naar Azure Machine Learning.

- Meer informatie over Azure Machine Learning.

De documentatie van ML-studio (klassiek) wordt buiten gebruik gesteld en wordt in de toekomst mogelijk niet meer bijgewerkt.

In dit artikel worden de modules in Machine Learning Studio (klassiek) beschreven die u kunt gebruiken om een machine learning-model te evalueren. Modelevaluatie wordt uitgevoerd nadat de training is voltooid, om de nauwkeurigheid van de voorspellingen te meten en het model passend te maken.

Notitie

Van toepassing op: alleen Machine Learning Studio (klassiek)

Vergelijkbare modules voor slepen en neerzetten zijn beschikbaar in Azure Machine Learning designer.

In dit artikel wordt ook het algehele proces in Machine Learning Studio (klassiek) beschreven voor het maken, trainen, evalueren en scoren van modellen.

Machine Learning-modellen maken en gebruiken in Machine Learning Studio (klassiek)

De typische werkstroom voor machine learning omvat deze fasen:

- Kies een geschikt algoritme en stel initiële opties in.

- Train het model met behulp van compatibele gegevens.

- Maak voorspellingen met behulp van nieuwe gegevens die zijn gebaseerd op de patronen in het model.

- Evalueer het model om te bepalen of de voorspellingen nauwkeurig zijn, de hoeveelheid fouten en of overfitting plaatsvindt.

Machine Learning Studio (klassiek) ondersteunt een flexibel, aanpasbaar framework voor machine learning. Elke taak in dit proces wordt uitgevoerd door een specifiek type module. De module kan worden gewijzigd, toegevoegd of verwijderd zonder de rest van het experiment te verbreken.

Gebruik de modules in deze categorie om een bestaand model te evalueren. Voor modelevaluatie is doorgaans een soort resultaatgegevensset vereist. Als u geen evaluatiegegevensset hebt, kunt u resultaten genereren door te scoren. U kunt ook een testgegevensset of een andere set gegevens gebruiken die 'grondwaar' of bekende verwachte resultaten bevat.

Meer informatie over modelevaluatie

Over het algemeen zijn uw opties bij het evalueren van een model afhankelijk van het type model dat u evalueert en de metrische gegevens die u wilt gebruiken. In deze onderwerpen worden enkele van de meest gebruikte metrische gegevens vermeld:

Machine Learning Studio (klassiek) biedt ook diverse visualisaties, afhankelijk van het type model dat u gebruikt en hoeveel klassen uw model voorspelt. Zie Metrische evaluatiegegevens weergeven voor hulp bij het vinden van deze visualisaties.

Het interpreteren van deze statistieken vereist vaak een beter begrip van het specifieke algoritme waarop het model is getraind. Zie Modelprestaties evalueren in Machine Learning voor een goede uitleg over hoe u een model evalueert en hoe u de waarden interpreteert die worden geretourneerd voor elke meting.

Lijst met modules

De categorie Machine Learning - Evalueren bevat de volgende modules:

Model kruisvalidatie: met kruisvalidatie worden parameterramingen voor classificatie- of regressiemodellen gevalideerd door de gegevens te partitioneren.

Gebruik de module Model kruisvalideren als u de geldigheid van uw trainingsset en het model wilt testen. Kruisvalidatie partitioneert de gegevens in vouwen en test vervolgens meerdere modellen op combinaties van vouwen.

Evaluate Model: Evalueert een scored classificatie- of regressiemodel met behulp van standaardmetrieken.

In de meeste gevallen gebruikt u de algemene module Evaluate Model . Dit geldt met name als uw model is gebaseerd op een van de ondersteunde classificatie- of regressiealgoritmen.

Evaluate Recommender: Evalueert de nauwkeurigheid van voorspellingen van het aanbevelingsmodel.

Voor aanbevelingsmodellen gebruikt u de module Evaluate Recommender .

Gerelateerde taken

- Gebruik voor clusteringmodellen de module Gegevens toewijzen aan clusters . Gebruik vervolgens de visualisaties in die module om evaluatieresultaten te bekijken.

- U kunt aangepaste metrische evaluatiegegevens maken. Als u aangepaste metrische evaluatiegegevens wilt maken, geeft u R-code op in de module Execute R Script of Python code in de module Execute Python Script. Deze optie is handig als u metrische gegevens wilt gebruiken die zijn gepubliceerd als onderdeel van opensource-bibliotheken of als u uw eigen metrische gegevens wilt ontwerpen voor het meten van modelnauwkeurigheid.

Voorbeelden

Het interpreteren van de resultaten van de evaluatie van machine learning-modellen is een kunst. Het vereist inzicht in de wiskundige resultaten, naast de gegevens en de zakelijke problemen. We raden u aan deze artikelen te bekijken voor een uitleg over het interpreteren van resultaten in verschillende scenario's:

- Kies parameters om uw algoritmen in Machine Learning te optimaliseren

- Modelresultaten interpreteren in Machine Learning

- Modelprestaties evalueren in Machine Learning

Technische opmerkingen

Deze sectie bevat implementatiedetails, tips en antwoorden op veelgestelde vragen.

Metrische evaluatiegegevens weergeven

Informatie over waar u in Machine Learning Studio (klassiek) kunt zoeken om de metrische grafieken voor elk modeltype te vinden.

Classificatiemodellen met twee klassen

De standaardweergave voor binaire classificatiemodellen bevat een interactief ROC-diagram en een tabel met waarden voor de belangrijkste metrische gegevens.

U hebt twee opties voor het weergeven van binaire classificatiemodellen:

- Klik met de rechtermuisknop op de module-uitvoer en selecteer Visualiseren.

- Klik met de rechtermuisknop op de module, selecteer Evaluatieresultaten en selecteer Visualiseren.

U kunt ook de schuifregelaar gebruiken om de waarschijnlijkheidsdrempelwaarde te wijzigen. De drempelwaarde bepaalt of een resultaat moet worden geaccepteerd als waar of niet. Vervolgens kunt u zien hoe deze waarden veranderen.

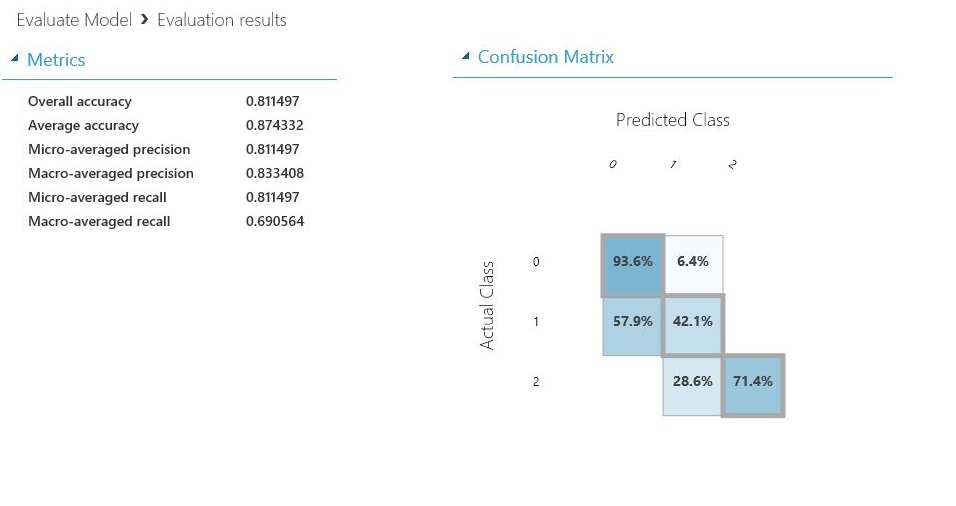

Classificatiemodellen met meerdere klassen

De standaardweergave voor metrische gegevens voor classificatiemodellen met meerdere klassen bevat een verwarringsmatrix voor alle klassen en een set metrische gegevens voor het model als geheel.

U hebt twee opties voor het weergeven van classificatiemodellen met meerdere klassen:

- Klik met de rechtermuisknop op de module-uitvoer en selecteer Visualiseren.

- Klik met de rechtermuisknop op de module, selecteer Evaluatieresultaten en selecteer Visualiseren.

Ter vereenvoudiging zijn dit de twee resultaten die naast elkaar worden weergegeven:

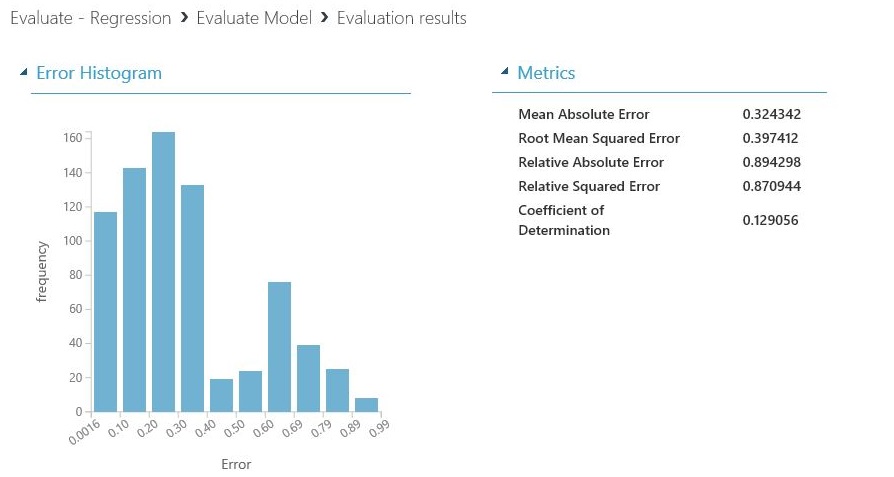

Regressiemodellen

De weergave metrische gegevens voor regressiemodellen is afhankelijk van het type model dat u hebt gemaakt. De weergave met metrische gegevens is gebaseerd op de onderliggende algoritmeinterfaces en is geschikt voor de metrische gegevens van het model.

U hebt twee opties voor het weergeven van regressiemodellen:

- Als u de metrische gegevens over nauwkeurigheid in een tabel wilt weergeven, klikt u met de rechtermuisknop op de uitvoer van de module Evaluate Model en selecteert u Visualiseren.

- Als u een fout histogram met de waarden wilt weergeven, klikt u met de rechtermuisknop op de module, selecteert u Evaluatieresultaten en selecteert u Visualiseren.

De weergave Fout histogram kan u helpen begrijpen hoe de fout wordt verdeeld. Deze is beschikbaar voor de volgende modeltypen en bevat een tabel met standaardgegevens, zoals een wortel van gemiddelde kwadratische fout (RMSE).

Met de volgende regressiemodellen wordt een tabel met standaardgegevens gegenereerd, samen met enkele aangepaste metrische gegevens:

- Bayesiaanse lineaire regressie

- Regressie beslissingsforest

- Regressie snelle forestkwantiel

- Ordinale regressie

Tips voor het werken met de gegevens

Als u de getallen wilt extraheren zonder de gebruikersinterface van Machine Learning Studio (klassiek) te kopiëren en plakken, kunt u de nieuwe PowerShell-bibliotheek voor Machine Learning gebruiken. U kunt metagegevens en andere informatie voor een heel experiment of uit afzonderlijke modules ophalen.

Als u waarden wilt extraheren uit een module Evaluate Model , moet u een unieke opmerking aan de module toevoegen om de identificatie te vereenvoudigen. Gebruik vervolgens de cmdlet Download-AmlExperimentNodeOutput om de metrische gegevens en de bijbehorende waarden op te halen uit de visualisatie in JSON-indeling.

Zie Machine Learning-modellen maken met Behulp van PowerShell voor meer informatie.