Sprzęt IT

W tej sekcji definiujemy sprzęt IT jako wszystko, co jest zainstalowane w stojaku (tzw. sprzęt montowany w stojaku). Ten sprzęt obejmuje zazwyczaj serwery, dedykowane macierze magazynowe, przełączniki i routery sieciowe, dystrybucję energii i urządzenia do zarządzania zdalnego. W szczególności odwołujemy się do stojaka z czterema słupkami wewnątrz obudowy w postaci szafki. Dodatkowe typy stojaków zostały opisane w dalszej części tego modułu.

Serwery

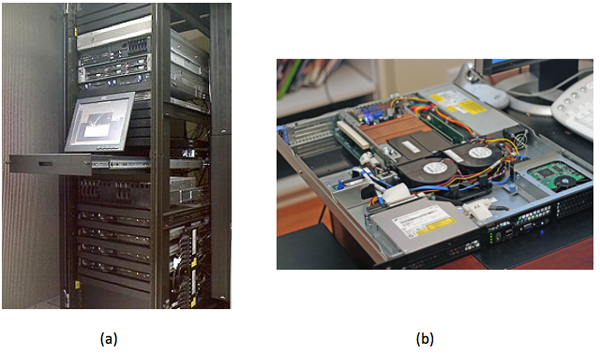

Serwer montowany w stojaku jest podobny do komputera w obudowie typu wieża, z wyjątkiem sytuacji, gdy ma on układ poziomy i pasuje do cieńszej, głębszej obudowy (zobacz rysunek 1). Wysokość jest mierzona w wielokrotnościach jednostek stojaków, gdzie 1U = 1,75 cala (4,45 cm). Serwer o rozmiarze 1U może mieć dużą gęstość procesora i pamięci RAM, ale pozostawia mało miejsca na karty rozszerzeń we/wy (zazwyczaj dwie). Serwer o rozmiarze 2U lub 3U może mieć sześć do ośmiu gniazd kart we/wy. Mniejsza obudowa musi również mieć mniejsze wentylatory i powoduje szum znacznie głośniejszy niż przeciętny komputer stacjonarny. (Jest to dopuszczalne, ponieważ większość serwerowni nie jest zajmowana przez ludzi). Systemy, które mają 4U, 5U lub większą obudowę, zwykle mają wyspecjalizowaną funkcję. Przykładem jest 80-rdzeniowy serwer firmy Intel, który ma gniazda CPU i pamięć RAM na zainstalowanych w pionie kartach rozszerzenia. Innym przykładem jest serwer akceleratora z czterema procesorami GPU. Trzeci przykład to obudowa serwerowa z 24, 36 lub 48 wewnętrznymi dyskami twardymi.

Rysunek 1. (a) Serwery zainstalowane w standardowym stojaku 19-calowym. b) Spojrzenie wewnątrz serwera montowanego w stojaku 1U. (Źródło)

Serwery instalowane w stojaku mają własne wentylatory, bloki zasilania (PSU), sieci i operacji we/wy, ale serwery blokowe współużytkują wszystkie te elementy w wielu węzłach w obrębie tej samej obudowy bloku (zwanej obudową blokową). Nie istnieje typowa, standardowa wersja bloków, dlatego bloki poszczególnych dostawców działają tylko z jego obudowami. Bloki to cienkie, poziome metalowe obudowy wsuwane z przodu obudowy blokowej i dołączane do płyty montażowej. Każdy blok ma własną płytę główną, procesor, pamięć RAM i dysk. Udostępniane jednostki PSU są zwykle bardziej wydajne niż dedykowane wersje montowane w stojaku, ponieważ mogą przyrostowo włączać lub wyłączać zasilanie, dostosowując pojemność jednostki PSU do zapotrzebowania związanego z ładunkiem. Na przykład zamiast 10 serwerów z 2 nadmiarowymi jednostkami PSU 750-W obudowa bloku może zasilać odpowiednik 10 serwerów z 4 jednostkami 2 500-W, w tym jedną nadmiarową. Bloki są gęstsze niż ich odpowiedniki montowane w poziomie, ich konserwacja jest łatwiejsza i wymagają mniejszej liczby kabli. Wadą jest wyższy koszt z góry, jeśli użytkownik potrzebuje tylko kilku serwerów, a ponadto jest on ograniczony tylko do określonego dostawcy.

Na koniec istnieje kilka serwerów, które wyglądają podobnie jak standardowy serwer montowany w stojaku, z tą różnicą, że mają dwie poziome płyty główne na 1U, a każda jest montowana na własnym zasobniku. Współużytkują one również zasilacz awaryjny PSU, ale w przeciwieństwie do bloków mają własne wentylatory i elementy we/wy. Istnieją różne odmiany tej konstrukcji, takie jak cztery węzły na 2U lub dwa węzły z wieloma procesorami GPU.

Czy wiesz, że?

Serwer montowany w stojaku 1-U jest czasami nazywany „pudełkiem na pizzę”.

W poniższym filmie wideo opisano różne czynniki formularzy serwera:

Ważną funkcją większości serwerów montowanych w stojaku jest możliwość wymiany podczas pracy. Składniki, takie jak jednostki PSU, wentylatory i dyski twarde, można usuwać i wymieniać, gdy serwer działa. Ta funkcja wydłuża czas pracy/zwiększa niezawodność małych i średnich wdrożeń. Wdrożenia aplikacji na dużą skalę wymagają wbudowania bardziej zaawansowanej odporności w warstwę oprogramowania. W tych systemach o dużej skali na potrzeby indywidualnych serwerów nie są używane składniki wymieniane podczas pracy ani nadmiarowe. W zamian awaria będzie występować na całym serwerze jako jednostce (i cały serwer będzie zastępowany).

Składniki elektryczne (na przykład kondensatory, regulatory napięcia) serwera są zwykle droższe i działają dłużej niż używane w systemach komputerowych, ponieważ serwery mają działać przez całą dobę przez wiele lat. Stacja robocza jest podobna do komputera klasy serwera, z podobnym procesorem, wysoką pojemnością pamięci RAM i dodaną niezawodnością. Różnica polega na tym, że stacja robocza znajduje się na biurku użytkownika, więc wymaga cichszych wentylatorów. Sytuację komplikuje fakt, że istnieją również stacje robocze montowane w stojaku. Te stacje robocze działają jak serwer, ale mają funkcję zdalnego przeglądania, więc użytkownik końcowy pracuje na zubożonym kliencie.

Nowsze serwery są teraz projektowane tak, aby działały w wyższej temperaturze otoczenia (do 95°F lub 35°C), co zmniejsza zapotrzebowanie na chłodzenie i w związku z tym obniża koszty operacyjne.

Na płycie głównej

Procesor i pamięć: Typowa płyta główna serwera ma więcej gniazd procesora CPU niż system klasyczny, a każde z tych gniazd może kontrolować więcej modułów DIMM (dwa wbudowane moduły pamięci). Inne podstawowe różnice między procesorami klasy serwerowej a klasą komputerów stacjonarnych (Intel Xeon a i3/i5/i7; AMD Opteron a FX/A/Phenom) to: więcej pamięci podręcznej, obsługa zarejestrowanych modułów DIMM i obsługa pamięć RAM z kodem korygującym błędy (ECC, error-correcting code).

Procesory klasy serwerowej mają również dedykowane obwody, które umożliwiają im komunikowanie się za pomocą dedykowanych kanałów na płycie głównej. W przypadku firmy Intel technologia ta nosi nazwę QuickPath Interconnect (QPI), a w przypadku firmy AMD — HyperTransport (HT). Są one zgodne z modelem niejednolitego dostępu do pamięci (NUMA), w którym procesy działające na innych procesorach (gniazdach) mogą uzyskiwać dostęp do dużych ilości pamięci RAM, przechodząc przez rozwiązanie QPI lub HT do pamięci RAM dołączonej do innego procesora. Łącząc wysoką gęstość, zarejestrowane moduły DIMM (16 GB lub 32 GB), więcej gniazd DIMM na serwer (9 lub 16) oraz wiele gniazd z możliwością połączenia wzajemnego podczas dołączania, jeden serwer może udostępniać pojedynczemu procesowi 512 GB, a nawet 1 TB pamięci RAM. (Jeśli masz wiele procesów z wieloma wątkami, uzyskasz większą wydajność, ale jest to temat innego kursu).

Zarządzanie dołączania: Mimo że wiele płyt głównych stacjonarnych ma teraz dołączanie sieci Gigabit Ethernet (GigE), ten trend rozpoczął się od serwerów i na nowoczesnych serwerach, znajdziesz od dwóch do czterech portów GigE. Inne urządzenia dołączane, które zawiera serwer, to port szeregowy służący do przekierowania konsoli i osadzony kontroler zarządzania, który umożliwia zdalne zarządzanie nawet wtedy, gdy system jest wyłączony (ale nadal jest podłączony) lub nie odpowiada (na przykład w przypadku awarii jądra). Wiele płyt głównych serwerów ma dołączane kontrolery dysków twardych, ale są one również popularne w postaci kart rozszerzania, które zostały omówione poniżej.

Karty rozszerzenia

PCI Express: często serwer wymaga dodatkowych urządzeń we/wy, w zależności od aplikacji przeznaczonych do uruchamiania na nim. Komputery i komputery mainframe charakteryzuje zawsze pewna rozszerzalność, a magistrale rozszerzeń zostały rozbudowane z ISA przez PCI i PCI-X do bieżącego standardu — PCI Express (PCIe). Największą różnicą między standardami PCI i PCIe jest to, że standard PCIe opiera się na szybkich połączeniach szeregowych między poszczególnymi punktami, a nie na rzeczywistej magistrali, do której dołączono wiele urządzeń. Każde z tych połączeń o dużej szybkości stanowi tor, a wiele torów działa równolegle. W związku z tym urządzenie PCIe x8 ma osiem torów o dużej szybkości. Każda generacja standardu PCIe od 1.0 do 3.0 efektywnie podwaja przepustowość poprzedniej generacji.

| Generacja standardu PCIe | x1 (MB/s) | x4 (GB/s) | x8 (GB/s) | x16 (GB/s) |

|---|---|---|---|---|

| 1.0 | 250 | 1 | 2 | 4 |

| 2.0 | 500 | 2 | 4 | 8 |

| 3.0 | 985 | 3,94 | 7,88 | 15,75 |

RAID: karty RAID (nadmiarowa macierz tanich dysków) umożliwiają wielu dyskom twardym działanie jako pojedyncza jednostka logiczna, ze zwiększoną wydajnością i nadmiarowością lub kombinacją obu tych dysków.

| Poziom RAID | Nazwisko | Zalety | Wady |

|---|---|---|---|

| 0 | Zwany rozkładaniem na poziomie bloku. | Większa wydajność. | Brak odporności na uszkodzenia, awaria pojedynczego dysku niszczy całą macierz. |

| 1 | Zwany dublowaniem, ponieważ dane są całkowicie replikowane. | Może wytrzymać awarię dysku. Oferuje szybszy odczyt (czasami). Ten poziom utrzymuje wydajność w przypadku awarii. | Połowa pojemności w porównaniu z dwoma niezależnymi dyskami. Ten poziom ma wolniejsze zapisy. |

| 10 | Nazywany RAID 1+0 lub 10 (dublowanie i rozkładanie). Łączy szybkość rozwiązania RAID 0 i nadmiarowość rozwiązania RAID 1. | Oferuje odporność na uszkodzenia. Ma zwiększoną wydajność. Ten poziom utrzymuje wydajność w przypadku awarii. | Połowa pojemności w porównaniu z dwoma niezależnymi macierzami RAID 0. |

| 5 | Rozkładanie na poziomie bloku z rozproszoną parzystością. | Ten poziom może wytrzymać awarię pojedynczego dysku i ma więcej pojemności niż macierze RAID 1, 10 i 6. | Wolniejsze zapisy niż rozwiązania RAID 0, 1 i 10, spadek wydajności w przypadku awarii i wolny proces ponownego kompilowania. |

| 6 | Rozkładanie na poziomie bloku z podwójnie rozproszoną parzystością. | Wytrzymuje awarie dwóch dysków i ma więcej pojemności niż macierze RAID 1 i 10 (z więcej niż czterema dyskami). | Wolniejsze zapisy niż rozwiązanie RAID 5, spadek wydajności w przypadku awarii i wolny proces ponownego kompilowania. |

Kontrolery RAID są wyposażone w różną liczbę portów (połączonych dysków), obsługują różne interfejsy (SATA, SAS), różnią się ilością wbudowanej pamięci podręcznej (na przykład 512 MB, 1 GB) i mają różne poziomy wydajności (przepływność MB/s, operacje we/wy na sekundę). Każdy z tych czynników może zmienić cenę adaptera (od kilkuset do ponad 1000 USD).

Karta magistrali hosta (HBA, host bus adapter) jest podobna do kontrolera RAID, z tą różnicą, że łączy się z magazynem zewnętrznym (omówionym w następnej sekcji), a sama karta zazwyczaj nie uwzględnia żadnych funkcji RAID. Karta będzie hermetyzować całą komunikację, dlatego urządzenie dysku zdalnego będzie w systemie operacyjnym wyglądać jak dysk lokalny i będzie można je ponownie uruchamiać.

Obsługa sieci: karty sieciowe Ethernet mogą zawierać karty pojedyncze lub wieloportowe z szybkością od 100 Mb/s (przestarzałe) do 1 Gb/s (typowe, niedrogie), 10 Gb/s (coraz bardziej powszechne, ale nadal drogie) lub 40 Gb/s (dostępne, ale nie są jeszcze powszechne).

Karta kanału hosta (HCA, host channel adapter) odnosi się do kart połączeń wzajemnych o dużej szybkości i małych opóźnieniach, takich jak InfiniBand. Są one zwykle używane w przypadku klastrów obliczeniowych o wysokiej wydajności (HPC).

Dostępne są również karty magazynu półprzewodnikowego, takie jak karty firmy Fusion-io. Zapewniają one znacznie wyższą wydajność niż kontrolery RAID, szczególnie w przypadku losowych operacji we/wy. Mają one bardzo wysokie koszty za gigabajt w porównaniu z dyskami twardymi, a nawet dyskami SSD (zapoznaj się z poniższą sekcją „Magazyn”).

Akceleratory: karty wideo, uruchomione na komputerach stacjonarnych, używają procesorów GPU do szybkiego renderowania 3D. Te procesory GPU mogą być również używane do obliczeń naukowych, dlatego znalazły się na rynkach serwerów HPC. Obecnie akceleratory z serii NVIDIA Tesla są dostępne w ponad 50 spośród 500 superkomputerów. Niedawno firma Intel wydała produkt akceleratora Xeon Phi, który jest oparty na architekturze Wiele zintegrowanych rdzeni (MIC) i jest podobny do wydajności produktu Tesla (>1 teraflop). Kosztuje on około 3000 USD, ale mogą zwiększyć wydajność z 2,5x do 10x (często) do 100x (nietypowo) dla aplikacji intensywnie korzystających z obliczeń matematycznych. Należy jednak pamiętać, że produkt ten nie mieści się w przeciętnej obudowie serwera ze względu na duży rozmiar karty i dodatkowe wymagania dotyczące zasilacza awaryjnego PSU.

Storage

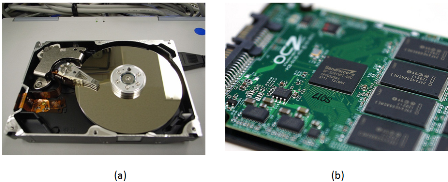

Gdy większość osób usłyszy wyraz „magazyn”, prawdopodobnie wyobrazi sobie dysk twardy (zobacz rysunek 2a). Wewnątrz dysku twardego obracające się talerze i głowica odczytu/zapisu wyglądają podobnie od dziesiątek lat. Elementy, które się zmieniły, to większa gęstość powierzchni, nowe techniki rejestrowania, szybsze interfejsy i ogólnie mniejszy pobór mocy. Dwa najbardziej typowe kształty dysków twardych to dyski 3,5 cala i 2,5 cala. Szybkości obrotów mogą się różnić, ale typowe wartości obr./min to 5400, 5900, 7200, 10 000 i 15 000. Im większa liczba obr./min, tym mniejsze opóźnienie między losowymi operacjami wyszukiwania.

Rysunek 2. (a) Wewnętrzny widok dysku twardego przedstawiający obracające się talerze i głowicę odczytu/zapisu. b) SSD z uwidocznionych obwodów. (Źródło)

Czy wiesz, że?

Maksymalna pojemność fizyczna dysku twardego zależy od elementu zwanego limitem superparamagnetycznym.

Dyski SSD (jak pokazano na rysunku 2b) stają się coraz tańsze, ale nadal mają znacznie wyższy koszt za gigabajt niż ich odpowiedniki mechaniczne. Dyski SSD są całkowicie elektroniczne; nie mają ruchomych części, co zapewnia krótszy czas wyszukiwania, wyższą wydajność i większą niezawodność. Dyski SSD mają ograniczoną liczbę zapisów, ale aby osiągnąć ten limit, użytkownik musiałby mieć przeprowadzać ciągły zapis na dysku 24 godziny dziennie przez kilka lat. Terminy SLC, MLC i TLC odnoszą się do liczby poziomów napięcia w każdej komórce: S jest dla pojedynczego (1), M jest dla wielu (2), a T jest dla potrójnego (3). Tym mniej poziomów, tym bardziej niezawodne jest (SLC > MLC > TLC). Im więcej poziomów, tym większa gęstość (TLC > MLC > SLC). Poziom SLC jest ogólnie zarezerwowany dla serwerów transakcyjnych o wysokiej przepływności. Poziom MLC to najbardziej typowy zamiennik dysków do komputerów stacjonarnych i laptopów, a także do serwerów, które potrzebują wyższej wydajności we/wy niż oferowana przez szybki dysk twardy (10 000 lub 15 000 obr./min). Poziom TLC pojawił się jako tańsza alternatywa dla poziom MLC, ale aby osiągnąć niższą cenę obniżono nieco jego wydajność i niezawodność.

Dyski twarde, które znajdują się w centrach danych, są niemal identyczne jak dyski, które znajdują się w komputerach stacjonarnych. Główną różnicą między korporacyjnym i zwykłym dyskiem SATA jest dodana ochrona przed wibracjami, która ma przedłużyć okres eksploatacji dysków montowanych w stojaku z wieloma innymi dyskami w tej samej obudowie. Ma on również dłuższe gwarancje — 5 lat zamiast 3.

SATA (Serial ATA) i SAS (Serial Attached SCSI) to dwa główne interfejsy dla wszystkich nowoczesnych dysków i większości dysków SSD. W przypadku serwerów interfejs SAS zapewnia możliwość komunikacji jednego dysku z dwoma kontrolerami dysków (w przypadku awarii jednego kontrolera). Interfejs SAS wymaga również niższego użycia procesora i zapewnia możliwość tworzenia połączeń łańcuchowych z dużą liczbą dysków za pośrednictwem ekspandera SAS. Większość kontrolerów RAID obsługujących interfejs SAS obsługuje również standard SATA, ale nie działa to w odwrotną stronę.

Bezpośrednio dołączony magazyn (DAS) odnosi się do obudowy montowanej w stojaku, która zawiera dodatkowe dyski, a także zasilacze awaryjne PSU i wentylatory, ale ma minimalną logikę kontroli. Wszystkie zadania są wykonywane przez kontroler (na serwerze), do którego są dołączane te jednostki. Typowe połączenie jest nawiązywane za pośrednictwem zewnętrznego kabla SAS (szeregowy o dużej szybkości, wieloprzewodowy i miedziany).

Sieć magazynowania (SAN) to kolekcja dysków twardych w obudowie, którą można połączyć z wieloma serwerami. Administrator systemu wydzieli macierz do jednostek LUN (numery jednostek logicznych magazynu), gdzie poszczególne jednostki LUN mogą być używane do różnych celów. Wiele serwerów nawiązuje połączenie z tą samą siecią SAN jednocześnie, ale w danym momencie tylko jeden serwer uzyskuje dostęp do danej jednostki LUN (chyba że zainstalowano oprogramowanie do skoordynowanego udostępniania, takie jak VMware). Serwery łączą się z siecią SAN za pośrednictwem sieci, zwykle protokołu Fibre Channel lub interfejsu iSCSI przez Ethernet (1 GB lub 10 GB). Każda jednostka LUN otrzymuje unikatową nazwę międzynarodową (WWN), która może być używana do dzielenia na strefy i maskowania, zapewniając bezpieczeństwo, ponieważ serwery mogą odczytywać tylko należące do nich jednostki LUN. Dostęp można także ograniczać według adresów IP i podsieci.

Większość komercyjnych produktów SAN obejmuje wiele jednostek w stojaku, a nawet wiele stojaków, i ma wiele nadmiarowych kontrolerów i ścieżek sieciowych, co przedłuża czas pracy. Sieci SAN mają wbudowane kontrolery RAID, dlatego awarie dysków są niewidoczne dla dołączonych serwerów. Produkty SAN różnią się znacznie od siebie i w zależności od funkcji, wydajności i pojemności mogą kosztować od 5000 USD do kilku milionów dolarów.

Magazyn dołączony do sieci (NAS) to urządzenie lub serwer, który udostępnia system plików wielu użytkownikom za pośrednictwem sieci. Każdy serwer z systemem Linux może stać się serwerem NAS, a na wielu dedykowanych urządzeniach NAS użytkowników system Linux działa w tle. Dwa najpopularniejsze protokoły używane przez magazyn NAS to CIFS (Common Internet File System, zwany również Server Message Block lub SMB) oraz NFS (sieciowy system plików). System CIFS wywodzi się z systemu Microsoft Windows i jest połączeniem na użytkownika, w którym system plików NFS jest używany głównie w systemie UNIX/Linux i jest połączeniem dla poszczególnych hosta.

Na koniec istnieje wiele rozproszonych równoległych systemów plików, które są zwykle używane w klastrach obliczeniowych i implementują schemat typu „wiele do wielu”. Zapewniają one znacznie wyższą łączną przepływność niż dowolna sieć SAN lub magazyn NAS oraz umożliwiają skalowanie pod względem wydajności i pojemności.

Wybór typu magazynu do użycia w dużym stopniu zależy od aplikacji, a większość organizacji będzie korzystać z powyższej kombinacji. Na przykład duża macierz magazynowa korzysta z równoległego rozproszonego systemu plików w wewnętrznej sieci zaplecza, ale prezentuje jednostki LUN w stylu sieci SAN i oferuje możliwości magazynu NAS dla innych klientów. Serwer plików systemu Windows będzie wyglądać jak urządzenie NAS podczas mapowania dysku sieciowego przez klienta, ale prawdopodobnie urządzenie magazynujące, na którym znajdują się pliki, znajduje się w sieci SAN poza programem Windows Server. Podczas nauki o udostępnianiu zasobów w późniejszym module niektóre z tych funkcji (migracja na żywo, odporność na uszkodzenia) będą wymagać urządzenia magazynującego SAN.

Sieć

Oprócz serwerów centrum danych zawiera cały sprzęt sieciowy, który służy do łączenia tych serwerów ze sobą i ze światem zewnętrznym.

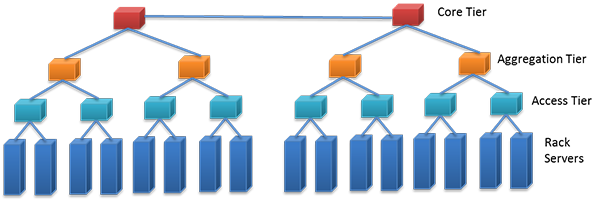

Jednym z popularnych projektów jest topologia wielowarstwowa (pokazana na rysunku 3), w której serwery łączą się bezpośrednio z przełącznikami. Te przełączniki łączą się z przełącznikami agregacji, które z kolei łączą się z pozostałą częścią sieci organizacji (taką jak przełączniki podstawowe) i ostatecznie z nadrzędnym usługodawcą internetowym.

Rysunek 3. Stos przełączników sieciowych zainstalowanych w stojaku. (Źródło)

Połączenie bogatsze (wyższa przepustowość) zazwyczaj łączy przełączniki warstwy dolnej i agregacji. Na przykład w przypadku portów 48x 1 GB łączących serwery stojaków i warstwę dostępu dostęp do warstwy agregacji może mieć następujące połączenia nadrzędne: 2 * 10 GB.

Określenie top of rack (TOR) odnosi się do konfiguracji, w której w każdym stojaku znajduje się najniższa warstwa przełączników sieciowych. Ta konstrukcja może obniżyć koszty i złożoność okablowania, ponieważ przewody są krótsze i mogą być miedziane, nawet przy szybkości 10 GB. Jest to szczególnie przydatne, jeśli większość ruchu sieciowego odbywa się do innych serwerów w tym samym stojaku. Na przykład implementacja Apache Hadoop może skorzystać z tej topologii, aby wybrać węzły do przechowywania danych (w stojaku i poza nim) oraz węzły, z których mają być pobierane dane (w stojaku). Jedna wada to ograniczona skalowalność. Przełączniki sieci Ethernet są blokowane, co oznacza, że jeśli wszystkie porty są zajęte w tym samym czasie, płyta montażowa nie może obsłużyć całego ruchu, dlatego niektóre żądania są odraczane. Ponadto dostępne łącza są zwykle mniejsze niż pełna przepustowość przełącznika sieci Ethernet. (Na przykład nie można mieć pasma 48 Gb/s na przełączniku 48x 1 GB). Jednak w większości rzeczywistych scenariuszy te pasma nigdy nie są nasycone, ponieważ nie każdy serwer korzysta z pełnej pojemności jednocześnie. Inną wadą jest wykorzystanie portów. Przełączniki mają określoną liczbę portów, zwykle 24 lub 48. Jeśli liczba serwerów należy do tego przedziału, w każdym stojaku będzie znajdować się kilka nigdy nieużywanych portów.

Określenie end of row (EOR) odnosi się do konfiguracji, która obejmuje rząd sąsiadujących lub przylegających stojaków, nazywanej czasami wnęką. Istnieje jeden dodatkowy stojak przeznaczony dla przełączników sieciowych, a wszystkie hosty w tym rzędzie (lub wnęce) są połączone z tym dedykowanym stojakiem. Kable są umieszczane nad stojakami w prowadnicach lub pod stojakami, pod podniesioną podłogą (więcej informacji na ten temat znajduje się w następnej sekcji). Przełączniki w tym dedykowanym stojaku mogą być większą obudową modularną (10U lub więcej), w której każdy moduł komunikuje się z innymi modułami za pomocą szybkiej płyty montażowej. Korzyść polega na tym, że wszystkie serwery w tym samym rzędzie (lub wnęce) mogą komunikować się ze sobą z tą samą szybkością (i z małymi opóźnieniami), dlatego liczba wąskich gardeł jest mniejsza. Wadą jest wyższy koszt płatny z góry i bardziej skomplikowane okablowanie (trudniejsze do debugowania w przypadku wystąpienia problemu). Przy takiej odległości łącza Gigabit mogą nadal być miedziane, ale dla wszystkich wartości wynoszących co najmniej 10 Gb/s wymagane są światłowody.

Ethernet to zdecydowanie najpopularniejszy typ sieci w centrach danych (i innych miejscach w organizacji). Chociaż wzrost popularności rozpoczął się w latach 80-tych od wartości 10 Mb/s, zarówno te produkty, jak i produkty 100 Mb/s są przestarzałe ze względu na niską cenę i wszechobecność produktów 1 Gb/s. Podstawowym czynnikiem wpływającym na popularność sieci Ethernet jest niski koszt i łatwość instalacji skrętki dwużyłowej. Najczęstszym typem okablowania Ethernet jest unshielded twisted pair (UTP) (patrz Rysunek 4a), który ma cztery pary cienkich (28 AWG) przewodów miedzianych i jest dostępny w różnych kategoriach: Kategoria 5 (Cat 5) jest dobra dla 10/100 Mb/s, Cat 5e i Cat 6 są dobre dla 1 Gb/s, a Cat 7 może przejść do 10 Gb/s. Każda generacja oferuje niewielkie zmiany projektowe w porównaniu z poprzednią, co pozwala na korzystanie z większej przepustowości i/lub dłuższych uruchomień. Alternatywnie ekranowana skrętka dwużyłowa (STP) ma dodatkową osłonę metalową na zewnątrz do użycia w środowiskach z zakłóceniami elektrycznymi (takimi jak fabryki lub w pobliżu linii wysokiego napięcia). Osłona zmniejsza zakłócenia, ale zazwyczaj nie jest wymagana w przypadku większości instalacji w stojaku.

Sieć Ethernet może być również przenoszona przez kabel światłowodowy (jak pokazano na rysunku 4b). Światłowody są jednokierunkowe, dlatego w kablach zobaczysz dwa sploty, jeden do wysyłania, a drugi do odbierania. Sygnały elektryczne są konwertowane na fotony, które pozostają wewnątrz światłowodu ze względu na różnice w indeksach refrakcji między rdzeniem (cienkim środkiem) i okładziną (grubszą warstwą zewnętrzną). Na okładzinie znajduje się warstwa materiału ognioodpornego. Kable światłowodowe są cieńsze i lżejsze niż kable miedziane, ale podczas ustalania kierunku kabla należy postępować ostrożnie, aby zachować minimalny promień zginania. W przeciwnym razie niektóre fotony wydostaną się, powodując straty. Światłowody w trybie wielomodowym są najczęściej używane wewnątrz centrów danych, ponieważ kable i nadajniki-odbiorniki są znacznie tańsze niż światłowody w trybie jednego włókna. Światłowody w trybie jednomodowym jest ogólnie zarezerwowana dla połączeń na dużych odległościach (100 m do 40 km). Karta Ethernet o wyższej szybkości 40 Gb/s ma w rzeczywistości 4 połączenia 10 Gb/s, które działają harmonijnie (podobnie jak tory PCIe); podobnie 100 Gb/s to 10 x 10 Gb/s (miedź, włókna) lub 4 x 25 Gb/s (tylko światłowody).

Rysunek 4: (a) Wycięcie nieskręconego kabla pary skręconej (UTP), pokazujące cztery pary kabli. b) Kabel sieciowy światłowodowy. Złącza LC w górnej części i złącza ST w dolnej części. (Źródło)

Fibre Channel (FC) to protokół przeznaczony do obsługi sieci SAN i zdalnych urządzeń magazynujących na poziomie bloku. Mimo że zwykle działa on na światłowodach, mogą być również używane kable miedziane. Można go również hermetyzować w sieci Ethernet w postaci protokołu FCoE (Fibre Channel over Ethernet), ale routing nie jest obsługiwany tak jak w przypadku interfejsu iSCSI. Protokół Fibre Channel HCA i generacje przełączników noszą nazwy związane ze swoją szybkością (w Gb/s) — nr GFC, w której nr to 1, 2, 4, 8, 10 lub 16. Najbardziej typowe rozwiązanie to teraz 8 GFC, które obsługuje połączenia 8 Gb/s (około 800 MB na sekundę w każdym kierunku).

iSCSIlub Internet SCSI (wymowa w języku angielskim: „scuzzy”) to protokół, który tworzy pakiety poleceń interfejsu SCSI (Small Computer Systems Interface, stary standard dysków twardych) do transportu za pośrednictwem sieci LAN lub WAN. Wiele sieci SAN obsługuje interfejs iSCSI, Jest on popularny, ponieważ można używać istniejącej sieci Ethernet zamiast wdrażania dedykowanej sieci FC.

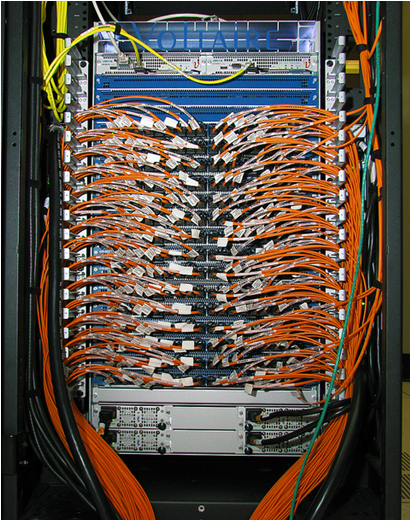

Standard InfiniBand (IB) był popularny w klastrach HPC przez prawie dekadę i zyskuje również aprobatę jako rozwiązanie do użycia w innych obszarach centrum danych. Główną zaletą standardu InfiniBand jest znacznie mniejsze kompleksowe opóźnienie w porównaniu do sieci Ethernet (1,7 mikrosekundy a 12,5 mikrosekundy dla 10 GigE w porównaniu z 30 do 100 mikrosekund dla GigE). Ponadto jest ono lepiej skalowanie przy użyciu liczby węzłów w klastrze. Innym kluczowym czynnikiem związanym z wydajnością standardu IB jest to, że przełączniki (pokazane na rysunku 5) nie są w pełni blokowane, co oznacza, że w obu kierunkach wszystkie porty są obsługiwane z pełną szybkością. Szybkości InfiniBand zostały podsumowane na poniższym wykresie:

| SDR | DDR | QDR | FDR-10 | FDR | EDR |

|---|---|---|---|---|---|

| 8 Gb/s | 16 Gb/s | 32 Gb/s | 40 Gb/s | 54,54 Gb/s | 100 Gb/s |

Sieci InfiniBand i Ethernet 40 Gb są również wdrażane jako sieć konwergentna lub wirtualna sieć szkieletowa, która wraz z wirtualizacją systemu operacyjnego pozwala na uruchamianie wielu adapterów wirtualnych (Ethernet, FC-HBA) za pośrednictwem mniejszej liczby linków o dużej szybkości. Połączenia można konfigurować dynamicznie za pomocą oprogramowania. Umożliwiają one korzystanie z mniejszej liczby kabli oraz łatwiejszą konserwację i zarządzanie.

Rysunek 5. Przełącznik InfiniBand. (Źródło)

Wybór technologii i topologii sieci do wdrożenia w centrum danych również zależy od aplikacji, ale zazwyczaj obejmuje wiele warstw z połączeniem w postaci światłowodu o dużej szybkości między warstwami. Miedziane okablowanie UTP jest powszechnie obsługiwane w stojaku i będzie nadal działać prawidłowo w przypadku sieci zarządzania o małej szybkości.