Copie e transforme dados no Amazon Simple Storage Service usando o Azure Data Factory ou o Azure Synapse Analytics

APLICA-SE A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Gorjeta

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange tudo, desde a movimentação de dados até ciência de dados, análises em tempo real, business intelligence e relatórios. Saiba como iniciar uma nova avaliação gratuitamente!

Este artigo descreve como usar a atividade de cópia para copiar dados do Amazon Simple Storage Service (Amazon S3) e usar o fluxo de dados para transformar dados no Amazon S3. Para saber mais, leia os artigos introdutórios do Azure Data Factory e do Synapse Analytics.

Gorjeta

Para saber mais sobre o cenário de migração de dados do Amazon S3 para o Armazenamento do Azure, consulte Migrar dados do Amazon S3 para o Armazenamento do Azure.

Capacidades suportadas

Esse conector do Amazon S3 é compatível com os seguintes recursos:

| Capacidades suportadas | IR |

|---|---|

| Atividade de cópia (fonte/-) | ① ② |

| Mapeando o fluxo de dados (origem/coletor) | ① |

| Atividade de Pesquisa | ① ② |

| Atividade GetMetadata | ① ② |

| Excluir atividade | ① ② |

(1) Tempo de execução de integração do Azure (2) Tempo de execução de integração auto-hospedado

Especificamente, esse conector do Amazon S3 oferece suporte à cópia de arquivos como estão ou à análise de arquivos com os formatos de arquivo e codecs de compactação suportados. Você também pode optar por preservar os metadados do arquivo durante a cópia. O conector usa o AWS Signature Versão 4 para autenticar solicitações no S3.

Gorjeta

Se você quiser copiar dados de qualquer provedor de armazenamento compatível com o S3, consulte Armazenamento compatível com Amazon S3.

Permissões obrigatórias

Para copiar dados do Amazon S3, verifique se você recebeu as seguintes permissões para operações de objeto do Amazon S3: s3:GetObject e s3:GetObjectVersion.

Se você usar a interface do usuário do Data Factory para criar, s3:ListAllMyBuckets serão necessárias permissões adicionais para s3:ListBucket/s3:GetBucketLocation operações como testar a conexão com o serviço vinculado e navegar a partir da raiz. Se não quiser conceder essas permissões, você pode escolher as opções "Testar conexão com o caminho do arquivo" ou "Procurar a partir do caminho especificado" na interface do usuário.

Para obter a lista completa de permissões do Amazon S3, consulte Especificação de permissões em uma política no site da AWS.

Introdução

Para executar a atividade Copiar com um pipeline, você pode usar uma das seguintes ferramentas ou SDKs:

- A ferramenta Copiar dados

- O portal do Azure

- O SDK do .NET

- O SDK do Python

- Azure PowerShell

- A API REST

- O modelo do Azure Resource Manager

Criar um serviço vinculado do Amazon Simple Storage Service (S3) usando a interface do usuário

Use as etapas a seguir para criar um serviço vinculado do Amazon S3 na interface do usuário do portal do Azure.

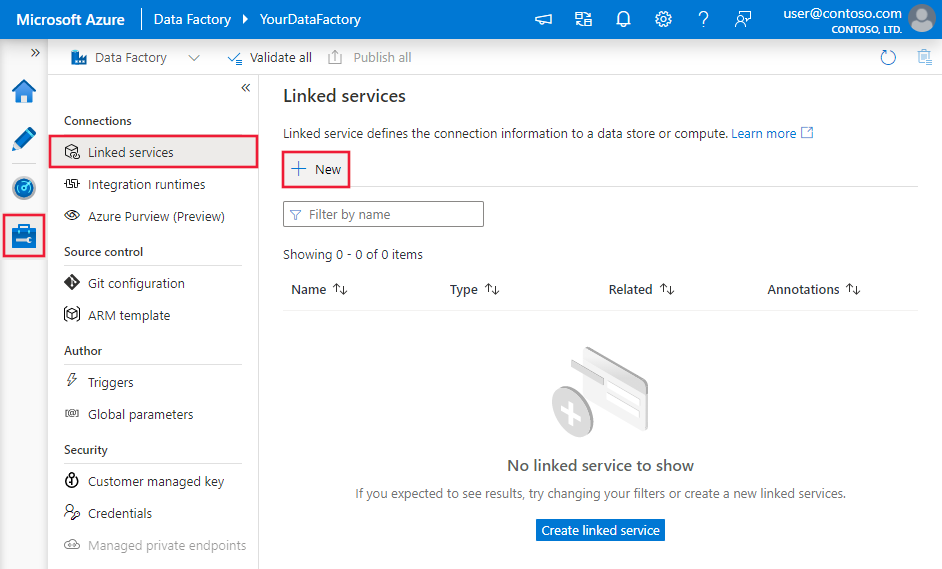

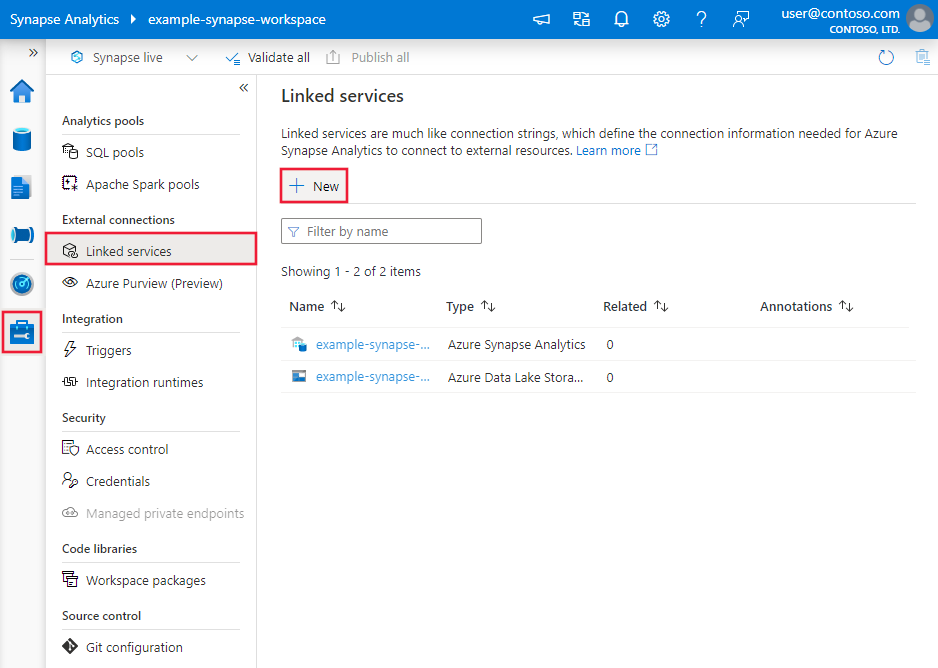

Navegue até a guia Gerenciar em seu espaço de trabalho do Azure Data Factory ou Synapse e selecione Serviços Vinculados e clique em Novo:

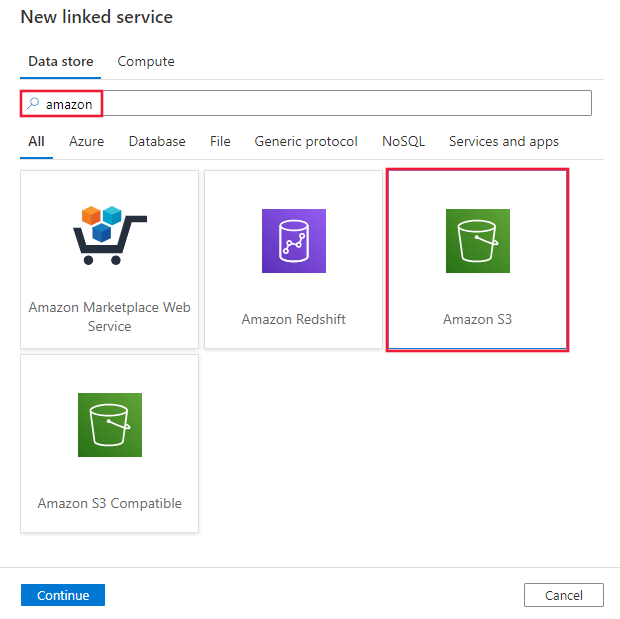

Pesquise por Amazon e selecione o conector do Amazon S3.

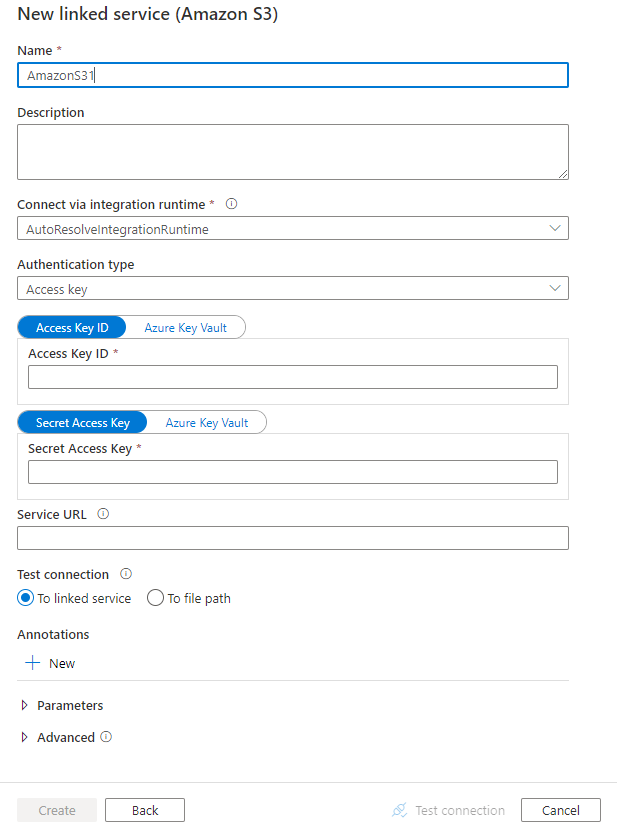

Configure os detalhes do serviço, teste a conexão e crie o novo serviço vinculado.

Detalhes de configuração do conector

As seções a seguir fornecem detalhes sobre as propriedades usadas para definir entidades do Data Factory específicas do Amazon S3.

Propriedades do serviço vinculado

As seguintes propriedades são compatíveis com um serviço vinculado do Amazon S3:

| Propriedade | Descrição | Necessário |

|---|---|---|

| tipo | A propriedade type deve ser definida como AmazonS3. | Sim |

| authenticationType | Especifique o tipo de autenticação usado para se conectar ao Amazon S3. Você pode optar por usar chaves de acesso para uma conta do AWS Identity and Access Management (IAM) ou credenciais de segurança temporárias. Os valores permitidos são: AccessKey (padrão) e TemporarySecurityCredentials. |

Não |

| accessKeyId | ID da chave de acesso secreta. | Sim |

| secretAccessKey | A própria chave de acesso secreta. Marque este campo como um SecureString para armazená-lo com segurança ou faça referência a um segredo armazenado no Cofre de Chaves do Azure. | Sim |

| sessionToken | Aplicável ao usar a autenticação de credenciais de segurança temporárias. Saiba como solicitar credenciais de segurança temporárias da AWS. Observação: a credencial temporária da AWS expira entre 15 minutos e 36 horas com base nas configurações. Verifique se sua credencial é válida quando a atividade é executada, especialmente para carga de trabalho operacionalizada - por exemplo, você pode atualizá-la periodicamente e armazená-la no Cofre da Chave do Azure. Marque este campo como um SecureString para armazená-lo com segurança ou faça referência a um segredo armazenado no Cofre de Chaves do Azure. |

Não |

| serviceUrl | Especifique o ponto de extremidade https://<service url>personalizado do S3 .Altere-o apenas se quiser experimentar um ponto de extremidade de serviço diferente ou se quiser alternar entre https e http. |

Não |

| ConecteVia | O tempo de execução de integração a ser usado para se conectar ao armazenamento de dados. Você pode usar o tempo de execução de integração do Azure ou o tempo de execução de integração auto-hospedado (se seu armazenamento de dados estiver em uma rede privada). Se essa propriedade não for especificada, o serviço usará o tempo de execução de integração padrão do Azure. | Não |

Exemplo: usando a autenticação de chave de acesso

{

"name": "AmazonS3LinkedService",

"properties": {

"type": "AmazonS3",

"typeProperties": {

"accessKeyId": "<access key id>",

"secretAccessKey": {

"type": "SecureString",

"value": "<secret access key>"

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Exemplo: usando autenticação de credencial de segurança temporária

{

"name": "AmazonS3LinkedService",

"properties": {

"type": "AmazonS3",

"typeProperties": {

"authenticationType": "TemporarySecurityCredentials",

"accessKeyId": "<access key id>",

"secretAccessKey": {

"type": "SecureString",

"value": "<secret access key>"

},

"sessionToken": {

"type": "SecureString",

"value": "<session token>"

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Propriedades do conjunto de dados

Para obter uma lista completa de seções e propriedades disponíveis para definir conjuntos de dados, consulte o artigo Conjuntos de dados.

O Azure Data Factory suporta os seguintes formatos de ficheiro. Consulte cada artigo para obter as configurações baseadas em formato.

- Formato Avro

- Formato binário

- Formato de texto delimitado

- Formato Excel

- Formato JSON

- Formato ORC

- Formato Parquet

- Formato XML

As seguintes propriedades são compatíveis com o Amazon S3 em configurações em um conjunto de dados baseado em location formato:

| Propriedade | Descrição | Necessário |

|---|---|---|

| tipo | A propriedade type em location um conjunto de dados deve ser definida como AmazonS3Location. |

Sim |

| Nome do bucket | O nome do bucket do S3. | Sim |

| folderPath | O caminho para a pasta sob o bucket fornecido. Se você quiser usar um curinga para filtrar a pasta, ignore essa configuração e especifique isso nas configurações da fonte de atividade. | Não |

| fileName | O nome do arquivo sob o bucket e o caminho da pasta fornecidos. Se você quiser usar um curinga para filtrar arquivos, ignore essa configuração e especifique isso nas configurações da fonte de atividade. | Não |

| versão | A versão do objeto S3, se o controle de versão do S3 estiver habilitado. Se não for especificado, a versão mais recente será buscada. | Não |

Exemplo:

{

"name": "DelimitedTextDataset",

"properties": {

"type": "DelimitedText",

"linkedServiceName": {

"referenceName": "<Amazon S3 linked service name>",

"type": "LinkedServiceReference"

},

"schema": [ < physical schema, optional, auto retrieved during authoring > ],

"typeProperties": {

"location": {

"type": "AmazonS3Location",

"bucketName": "bucketname",

"folderPath": "folder/subfolder"

},

"columnDelimiter": ",",

"quoteChar": "\"",

"firstRowAsHeader": true,

"compressionCodec": "gzip"

}

}

}

Propriedades da atividade Copy

Para obter uma lista completa de seções e propriedades disponíveis para definir atividades, consulte o artigo Pipelines . Esta seção fornece uma lista de propriedades suportadas pela fonte do Amazon S3.

Amazon S3 como tipo de origem

O Azure Data Factory suporta os seguintes formatos de ficheiro. Consulte cada artigo para obter as configurações baseadas em formato.

- Formato Avro

- Formato binário

- Formato de texto delimitado

- Formato Excel

- Formato JSON

- Formato ORC

- Formato Parquet

- Formato XML

As seguintes propriedades são compatíveis com o Amazon S3 em configurações em uma fonte de cópia baseada em storeSettings formato:

| Propriedade | Descrição | Necessário |

|---|---|---|

| tipo | A propriedade type under storeSettings deve ser definida como AmazonS3ReadSettings. |

Sim |

| Localize os ficheiros a copiar: | ||

| OPÇÃO 1: caminho estático |

Copie do bucket ou caminho de pasta/arquivo especificado no conjunto de dados. Se você quiser copiar todos os arquivos de um bucket ou pasta, especifique wildcardFileName adicionalmente como *. |

|

| OPÇÃO 2: Prefixo S3 - prefixo |

Prefixo para o nome da chave S3 sob o bucket fornecido configurado em um conjunto de dados para filtrar arquivos S3 de origem. As teclas S3 cujos nomes começam com bucket_in_dataset/this_prefix são selecionadas. Ele utiliza o filtro do lado do serviço do S3, que oferece melhor desempenho do que um filtro curinga.Quando você usa prefixo e opta por copiar para coletor baseado em arquivo com hierarquia de preservação, observe que o subcaminho após o último "/" no prefixo será preservado. Por exemplo, você tem origem bucket/folder/subfolder/file.txte configura o prefixo como folder/sub, então o caminho do arquivo preservado é subfolder/file.txt. |

Não |

| OPÇÃO 3: curinga - wildcardFolderPath |

O caminho da pasta com caracteres curinga sob o bucket fornecido configurado em um conjunto de dados para filtrar pastas de origem. Os curingas permitidos são: * (corresponde a zero ou mais caracteres) e ? (corresponde a zero ou caractere único). Use ^ para escapar se o nome da pasta tiver um curinga ou esse caractere de escape dentro. Veja mais exemplos em Exemplos de filtros de pastas e ficheiros. |

Não |

| OPÇÃO 3: curinga - wildcardFileName |

O nome do arquivo com caracteres curinga sob o bucket e o caminho da pasta fornecidos (ou caminho da pasta curinga) para filtrar os arquivos de origem. Os curingas permitidos são: * (corresponde a zero ou mais caracteres) e ? (corresponde a zero ou caractere único). Use ^ para escapar se o nome do arquivo tiver um curinga ou esse caractere de escape dentro. Veja mais exemplos em Exemplos de filtros de pastas e ficheiros. |

Sim |

| OPÇÃO 4: uma lista de ficheiros - fileListPath |

Indica para copiar um determinado conjunto de arquivos. Aponte para um arquivo de texto que inclua uma lista de arquivos que você deseja copiar, um arquivo por linha, que é o caminho relativo para o caminho configurado no conjunto de dados. Quando estiver usando essa opção, não especifique um nome de arquivo no conjunto de dados. Veja mais exemplos em Exemplos de lista de arquivos. |

Não |

| Configurações adicionais: | ||

| recursiva | Indica se os dados são lidos recursivamente das subpastas ou somente da pasta especificada. Observe que quando recursivo é definido como true e o coletor é um armazenamento baseado em arquivo, uma pasta ou subpasta vazia não é copiada ou criada no coletor. Os valores permitidos são true (padrão) e false. Esta propriedade não se aplica quando você configura fileListPatho . |

Não |

| deleteFilesAfterCompletion | Indica se os arquivos binários serão excluídos do armazenamento de origem depois de serem movidos com êxito para o repositório de destino. A exclusão do arquivo é por arquivo, portanto, quando a atividade de cópia falhar, você verá que alguns arquivos já foram copiados para o destino e excluídos da origem, enquanto outros ainda permanecem no armazenamento de origem. Esta propriedade só é válida no cenário de cópia de arquivos binários. O valor padrão: false. |

Não |

| modifiedDatetimeStart | Os arquivos são filtrados com base no atributo: última modificação. Os arquivos serão selecionados se o tempo da última modificação for maior ou igual a modifiedDatetimeStart e menor que modifiedDatetimeEnd. A hora é aplicada a um fuso horário UTC no formato "2018-12-01T05:00:00Z". As propriedades podem ser NULL, o que significa que nenhum filtro de atributo de arquivo será aplicado ao conjunto de dados. Quando modifiedDatetimeStart tiver um valor datetime, mas modifiedDatetimeEnd for NULL, os arquivos cujo último atributo modificado for maior ou igual ao valor datetime serão selecionados. Quando modifiedDatetimeEnd tiver um valor datetime, mas modifiedDatetimeStart for NULL, os arquivos cujo atributo da última modificação for menor que o valor datetime serão selecionados.Esta propriedade não se aplica quando você configura fileListPatho . |

Não |

| modifiedDatetimeEnd | Mesmo que acima. | Não |

| enablePartitionDiscovery | Para arquivos particionados, especifique se deseja analisar as partições do caminho do arquivo e adicioná-las como colunas de origem adicionais. Os valores permitidos são false (padrão) e true. |

Não |

| partitionRootPath | Quando a descoberta de partições estiver habilitada, especifique o caminho raiz absoluto para ler pastas particionadas como colunas de dados. Se não for especificado, por padrão, - Quando você usa o caminho do arquivo no conjunto de dados ou na lista de arquivos na origem, o caminho da raiz da partição é o caminho configurado no conjunto de dados. - Quando você usa o filtro de pasta curinga, o caminho da raiz da partição é o subcaminho antes do primeiro curinga. - Quando você usa prefixo, o caminho raiz da partição é sub-caminho antes do último "/". Por exemplo, supondo que você configure o caminho no conjunto de dados como "root/folder/year=2020/month=08/day=27": - Se você especificar o caminho raiz da partição como "root/folder/year=2020", a atividade de cópia gerará mais duas colunas e com o valor "08" e day "27", respectivamente, além das colunas month dentro dos arquivos.- Se o caminho raiz da partição não for especificado, nenhuma coluna extra será gerada. |

Não |

| maxConcurrentConnections | O limite superior de conexões simultâneas estabelecidas para o armazenamento de dados durante a execução da atividade. Especifique um valor somente quando quiser limitar conexões simultâneas. | Não |

Exemplo:

"activities":[

{

"name": "CopyFromAmazonS3",

"type": "Copy",

"inputs": [

{

"referenceName": "<Delimited text input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "DelimitedTextSource",

"formatSettings":{

"type": "DelimitedTextReadSettings",

"skipLineCount": 10

},

"storeSettings":{

"type": "AmazonS3ReadSettings",

"recursive": true,

"wildcardFolderPath": "myfolder*A",

"wildcardFileName": "*.csv"

}

},

"sink": {

"type": "<sink type>"

}

}

}

]

Exemplos de filtros de pastas e ficheiros

Esta seção descreve o comportamento resultante do caminho da pasta e do nome do arquivo com filtros curinga.

| balde | key | recursiva | Estrutura da pasta de origem e resultado do filtro (arquivos em negrito são recuperados) |

|---|---|---|---|

| balde | Folder*/* |

false | balde PastaA Ficheiro1.csv Arquivo2.json Subpasta1 Ficheiro3.csv Arquivo4.json Ficheiro5.csv OutraPastaB Ficheiro6.csv |

| balde | Folder*/* |

verdadeiro | balde PastaA Ficheiro1.csv Arquivo2.json Subpasta1 Ficheiro3.csv Arquivo4.json Ficheiro5.csv OutraPastaB Ficheiro6.csv |

| balde | Folder*/*.csv |

false | balde PastaA Ficheiro1.csv Arquivo2.json Subpasta1 Ficheiro3.csv Arquivo4.json Ficheiro5.csv OutraPastaB Ficheiro6.csv |

| balde | Folder*/*.csv |

verdadeiro | balde PastaA Ficheiro1.csv Arquivo2.json Subpasta1 Ficheiro3.csv Arquivo4.json Ficheiro5.csv OutraPastaB Ficheiro6.csv |

Exemplos de lista de ficheiros

Esta seção descreve o comportamento resultante do uso de um caminho de lista de arquivos em uma fonte de atividade Copiar.

Suponha que você tenha a seguinte estrutura de pasta de origem e deseja copiar os arquivos em negrito:

| Estrutura de origem da amostra | Conteúdo em FileListToCopy.txt | Configuração |

|---|---|---|

| balde PastaA Ficheiro1.csv Arquivo2.json Subpasta1 Ficheiro3.csv Arquivo4.json Ficheiro5.csv Metadados FileListToCopy.txt |

Ficheiro1.csv Subpasta1/Ficheiro3.csv Subpasta1/Ficheiro5.csv |

No conjunto de dados: - Balde: bucket- Caminho da pasta: FolderANa fonte da atividade Copiar: - Caminho da lista de arquivos: bucket/Metadata/FileListToCopy.txt O caminho da lista de arquivos aponta para um arquivo de texto no mesmo armazenamento de dados que inclui uma lista de arquivos que você deseja copiar, um arquivo por linha, com o caminho relativo para o caminho configurado no conjunto de dados. |

Preservar metadados durante a cópia

Ao copiar arquivos do Amazon S3 para o Azure Data Lake Storage Gen2 ou para o armazenamento de Blob do Azure, você pode optar por preservar os metadados do arquivo junto com os dados. Saiba mais em Preservar metadados.

Mapeando propriedades de fluxo de dados

Ao transformar dados em fluxos de dados de mapeamento, você pode ler arquivos do Amazon S3 nos seguintes formatos:

As configurações específicas do formato estão localizadas na documentação desse formato. Para obter mais informações, consulte Transformação de origem no mapeamento do fluxo de dados.

Transformação da fonte

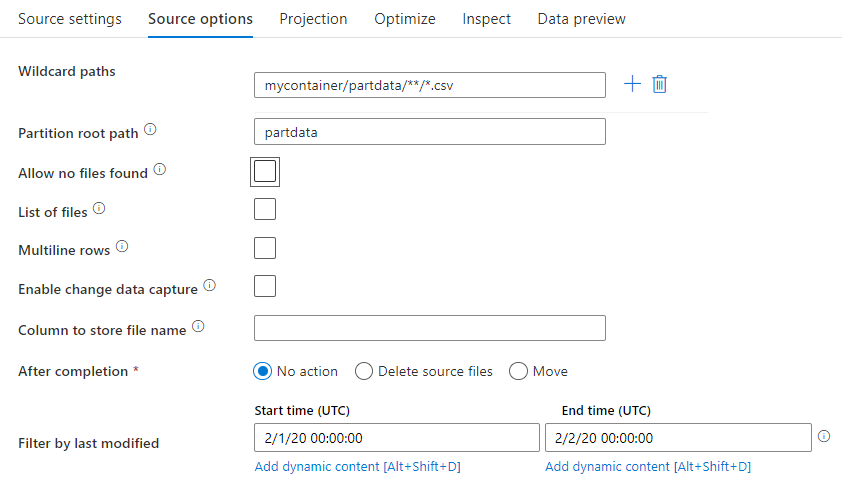

Na transformação de origem, você pode ler a partir de um contêiner, pasta ou arquivo individual no Amazon S3. Use a guia Opções de origem para gerenciar como os arquivos são lidos.

Caminhos curinga: o uso de um padrão curinga instruirá o serviço a percorrer cada pasta e arquivo correspondentes em uma única transformação de origem. Esta é uma maneira eficaz de processar vários arquivos dentro de um único fluxo. Adicione vários padrões de correspondência de curinga com o sinal de adição que aparece quando você passa o mouse sobre o padrão curinga existente.

No contêiner de origem, escolha uma série de arquivos que correspondam a um padrão. Somente um contêiner pode ser especificado no conjunto de dados. Portanto, o caminho curinga também deve incluir o caminho da pasta raiz.

Exemplos de curingas:

*Representa qualquer conjunto de caracteres.**Representa o aninhamento recursivo de diretórios.?Substitui um caractere.[]Corresponde a um ou mais caracteres entre parênteses./data/sales/**/*.csvObtém todos os arquivos .csv em /data/sales./data/sales/20??/**/Obtém todos os arquivos no século 20./data/sales/*/*/*.csvObtém arquivos .csv dois níveis em /data/sales./data/sales/2004/*/12/[XY]1?.csvObtém todos os arquivos .csv em dezembro de 2004, começando com X ou Y prefixados por um número de dois dígitos.

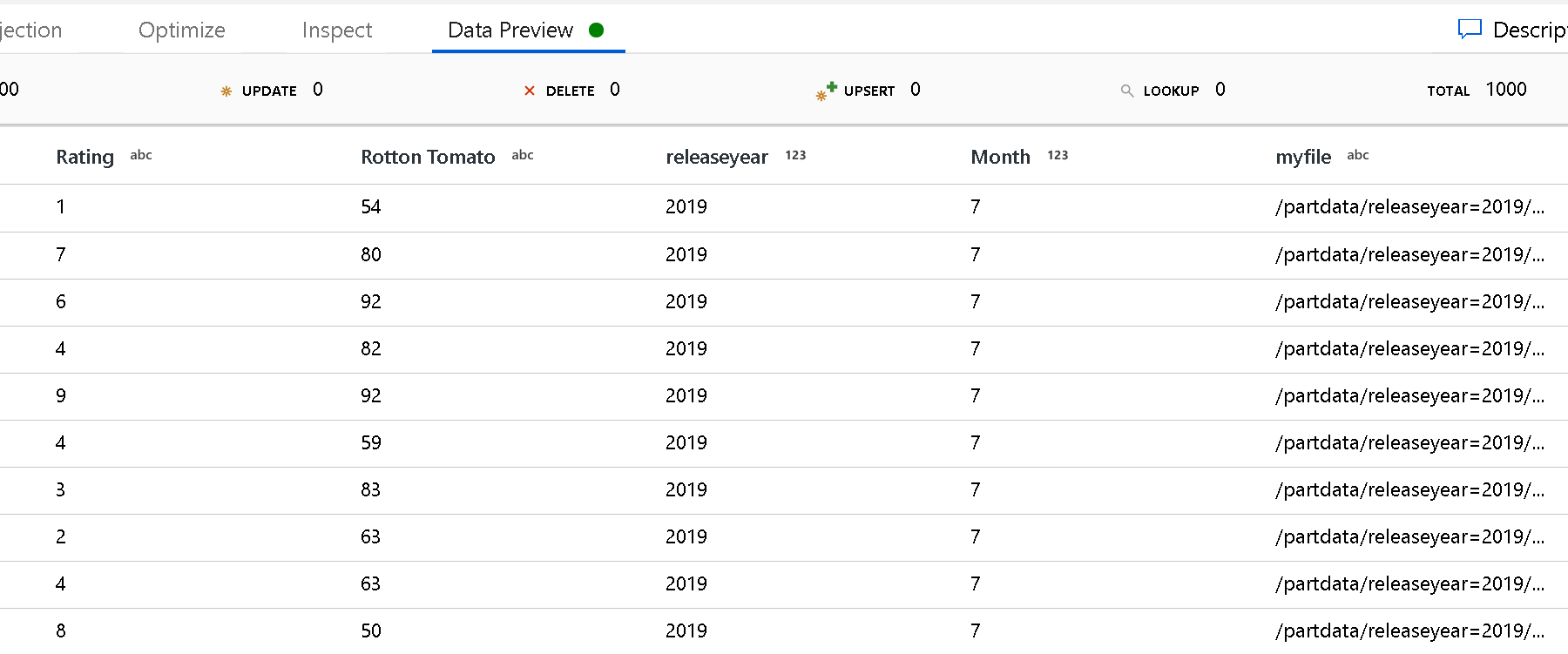

Caminho da raiz da partição: Se você tiver pastas particionadas em sua fonte de arquivos com um formato (por exemplo, year=2019), poderá atribuir o nível superior dessa árvore de pastas de partição a um key=value nome de coluna no fluxo de dados do seu fluxo de dados.

Primeiro, defina um curinga para incluir todos os caminhos que são as pastas particionadas mais os arquivos folha que você deseja ler.

Use a configuração Caminho raiz da partição para definir qual é o nível superior da estrutura de pastas. Quando visualizar o conteúdo dos seus dados através de uma pré-visualização de dados, verá que o serviço adicionará as partições resolvidas encontradas em cada um dos seus níveis de pasta.

Lista de ficheiros: Este é um conjunto de ficheiros. Crie um arquivo de texto que inclua uma lista de arquivos de caminho relativos a serem processados. Aponte para este ficheiro de texto.

Coluna para armazenar o nome do arquivo: armazene o nome do arquivo de origem em uma coluna em seus dados. Insira um novo nome de coluna aqui para armazenar a cadeia de caracteres de nome de arquivo.

Após a conclusão: escolha não fazer nada com o arquivo de origem depois que o fluxo de dados for executado, exclua o arquivo de origem ou mova o arquivo de origem. Os caminhos para a mudança são relativos.

Para mover os arquivos de origem para outro local pós-processamento, primeiro selecione "Mover" para a operação do arquivo. Em seguida, defina o diretório "from". Se você não estiver usando nenhum curinga para seu caminho, a configuração "de" será a mesma pasta que sua pasta de origem.

Se você tiver um caminho de origem com curinga, sua sintaxe terá esta aparência:

/data/sales/20??/**/*.csv

Você pode especificar "de" como:

/data/sales

E você pode especificar "para" como:

/backup/priorSales

Nesse caso, todos os arquivos que foram originados em /data/sales são movidos para /backup/priorSales.

Nota

As operações de arquivo são executadas somente quando você inicia o fluxo de dados de uma execução de pipeline (uma depuração de pipeline ou execução de execução) que usa a atividade Executar fluxo de dados em um pipeline. As operações de arquivo não são executadas no modo de depuração de fluxo de dados.

Filtrar por última modificação: você pode filtrar quais arquivos você processa especificando um intervalo de datas de quando eles foram modificados pela última vez. Todas as datas/hora estão em UTC.

Propriedades da atividade de pesquisa

Para saber detalhes sobre as propriedades, verifique Atividade de pesquisa.

Propriedades de atividade GetMetadata

Para saber detalhes sobre as propriedades, verifique a atividade GetMetadata.

Excluir propriedades de atividade

Para saber detalhes sobre as propriedades, marque Excluir atividade.

Modelos antigos

Nota

Os seguintes modelos ainda são suportados, assim como para compatibilidade com versões anteriores. Sugerimos que utilize o novo modelo mencionado anteriormente. A interface do usuário de criação mudou para gerar o novo modelo.

Modelo de conjunto de dados herdado

| Propriedade | Descrição | Necessário |

|---|---|---|

| tipo | A propriedade type do conjunto de dados deve ser definida como AmazonS3Object. | Sim |

| Nome do bucket | O nome do bucket do S3. O filtro curinga não é suportado. | Sim para a atividade Cópia ou Pesquisa, não para a atividade GetMetadata |

| key | O nome ou filtro curinga da chave de objeto do S3 sob o bucket especificado. Aplica-se somente quando a propriedade prefix não é especificada. O filtro curinga é suportado para a parte da pasta e a parte do nome do arquivo. Os curingas permitidos são: * (corresponde a zero ou mais caracteres) e ? (corresponde a zero ou caractere único).- Exemplo 1: "key": "rootfolder/subfolder/*.csv"- Exemplo 2: "key": "rootfolder/subfolder/???20180427.txt"Veja mais exemplos em Exemplos de filtros de pastas e ficheiros. Use ^ para escapar se sua pasta real ou nome de arquivo tiver um curinga ou esse caractere de escape dentro. |

Não |

| prefixo | Prefixo para a chave de objeto do S3. Os objetos cujas chaves começam com esse prefixo são selecionados. Aplica-se somente quando a propriedade da chave não é especificada. | Não |

| versão | A versão do objeto S3, se o controle de versão do S3 estiver habilitado. Se uma versão não for especificada, a versão mais recente será buscada. | Não |

| modifiedDatetimeStart | Os arquivos são filtrados com base no atributo: última modificação. Os arquivos serão selecionados se o tempo da última modificação for maior ou igual a modifiedDatetimeStart e menor que modifiedDatetimeEnd. A hora é aplicada ao fuso horário UTC no formato "2018-12-01T05:00:00Z". Lembre-se de que habilitar essa configuração afetará o desempenho geral da movimentação de dados quando você quiser filtrar grandes quantidades de arquivos. As propriedades podem ser NULL, o que significa que nenhum filtro de atributo de arquivo será aplicado ao conjunto de dados. Quando modifiedDatetimeStart tiver um valor datetime, mas modifiedDatetimeEnd for NULL, os arquivos cujo último atributo modificado for maior ou igual ao valor datetime serão selecionados. Quando modifiedDatetimeEnd tiver um valor datetime, mas modifiedDatetimeStart for NULL, os arquivos cujo atributo da última modificação for menor que o valor datetime serão selecionados. |

Não |

| modifiedDatetimeEnd | Os arquivos são filtrados com base no atributo: última modificação. Os arquivos serão selecionados se o tempo da última modificação for maior ou igual a modifiedDatetimeStart e menor que modifiedDatetimeEnd. A hora é aplicada ao fuso horário UTC no formato "2018-12-01T05:00:00Z". Lembre-se de que habilitar essa configuração afetará o desempenho geral da movimentação de dados quando você quiser filtrar grandes quantidades de arquivos. As propriedades podem ser NULL, o que significa que nenhum filtro de atributo de arquivo será aplicado ao conjunto de dados. Quando modifiedDatetimeStart tiver um valor datetime, mas modifiedDatetimeEnd for NULL, os arquivos cujo último atributo modificado for maior ou igual ao valor datetime serão selecionados. Quando modifiedDatetimeEnd tiver um valor datetime, mas modifiedDatetimeStart for NULL, os arquivos cujo atributo da última modificação for menor que o valor datetime serão selecionados. |

Não |

| format | Se você quiser copiar arquivos como está entre armazenamentos baseados em arquivo (cópia binária), ignore a seção de formato nas definições de conjunto de dados de entrada e saída. Se você quiser analisar ou gerar arquivos com um formato específico, os seguintes tipos de formato de arquivo são suportados: TextFormat, JsonFormat, AvroFormat, OrcFormat, ParquetFormat. Defina a propriedade type em format como um desses valores. Para obter mais informações, consulte as seções Formato texto, Formato JSON, Formato Avro, Formato Orc e Formato Parquet. |

Não (apenas para o cenário de cópia binária) |

| compressão | Especifique o tipo e o nível de compactação dos dados. Para obter mais informações, consulte Formatos de arquivo e codecs de compactação suportados. Os tipos suportados são GZip, Deflate, BZip2 e ZipDeflate. Os níveis suportados são Ótimos e Mais Rápidos. |

Não |

Gorjeta

Para copiar todos os arquivos em uma pasta, especifique bucketName para o bucket e prefixo para a parte da pasta.

Para copiar um único arquivo com um determinado nome, especifique bucketName para o bucket e a chave para a parte da pasta mais o nome do arquivo.

Para copiar um subconjunto de arquivos em uma pasta, especifique bucketName para o bucket e a chave para a parte da pasta mais o filtro curinga.

Exemplo: usando prefixo

{

"name": "AmazonS3Dataset",

"properties": {

"type": "AmazonS3Object",

"linkedServiceName": {

"referenceName": "<Amazon S3 linked service name>",

"type": "LinkedServiceReference"

},

"typeProperties": {

"bucketName": "testbucket",

"prefix": "testFolder/test",

"modifiedDatetimeStart": "2018-12-01T05:00:00Z",

"modifiedDatetimeEnd": "2018-12-01T06:00:00Z",

"format": {

"type": "TextFormat",

"columnDelimiter": ",",

"rowDelimiter": "\n"

},

"compression": {

"type": "GZip",

"level": "Optimal"

}

}

}

}

Exemplo: usando chave e versão (opcional)

{

"name": "AmazonS3Dataset",

"properties": {

"type": "AmazonS3",

"linkedServiceName": {

"referenceName": "<Amazon S3 linked service name>",

"type": "LinkedServiceReference"

},

"typeProperties": {

"bucketName": "testbucket",

"key": "testFolder/testfile.csv.gz",

"version": "XXXXXXXXXczm0CJajYkHf0_k6LhBmkcL",

"format": {

"type": "TextFormat",

"columnDelimiter": ",",

"rowDelimiter": "\n"

},

"compression": {

"type": "GZip",

"level": "Optimal"

}

}

}

}

Modelo de origem herdado para a atividade Copiar

| Propriedade | Descrição | Necessário |

|---|---|---|

| tipo | A propriedade type da fonte de atividade Copy deve ser definida como FileSystemSource. | Sim |

| recursiva | Indica se os dados são lidos recursivamente das subpastas ou somente da pasta especificada. Observe que quando recursivo é definido como true e o coletor é um armazenamento baseado em arquivo, uma pasta ou subpasta vazia não será copiada ou criada no coletor. Os valores permitidos são true (padrão) e false. |

Não |

| maxConcurrentConnections | O limite superior de conexões simultâneas estabelecidas para o armazenamento de dados durante a execução da atividade. Especifique um valor somente quando quiser limitar conexões simultâneas. | Não |

Exemplo:

"activities":[

{

"name": "CopyFromAmazonS3",

"type": "Copy",

"inputs": [

{

"referenceName": "<Amazon S3 input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "FileSystemSource",

"recursive": true

},

"sink": {

"type": "<sink type>"

}

}

}

]

Conteúdos relacionados

Para obter uma lista de armazenamentos de dados que a atividade Copiar suporta como fontes e coletores, consulte Armazenamentos de dados suportados.