Utilizar o Azure Data Lake Storage Gen1 para requisitos de macrodados

Nota

Azure Data Lake Storage Gen1 foi descontinuada. Veja o anúncio de descontinuação aqui. Data Lake Storage Gen1 recursos já não estão acessíveis. Se precisar de assistência especial, contacte-nos.

Existem quatro fases principais no processamento de macrodados:

- Ingerir grandes quantidades de dados num arquivo de dados, em tempo real ou em lotes

- Processar os dados

- Transferir os dados

- Visualizar os dados

Neste artigo, vamos analisar estas fases relativamente ao Azure Data Lake Storage Gen1 para compreender as opções e ferramentas disponíveis para satisfazer as suas necessidades de macrodados.

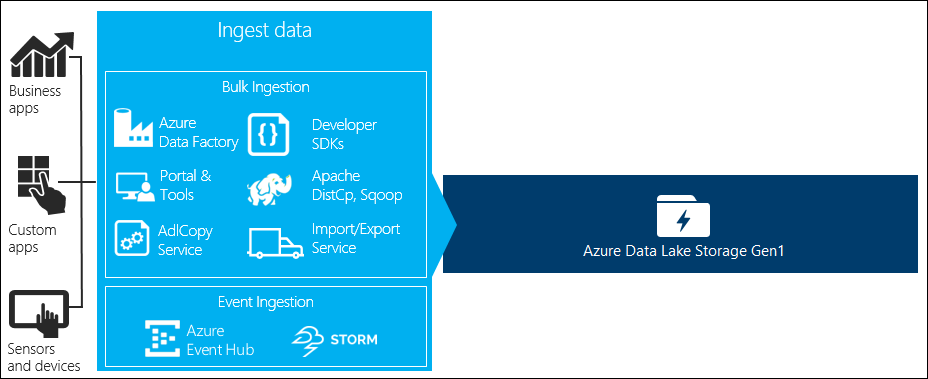

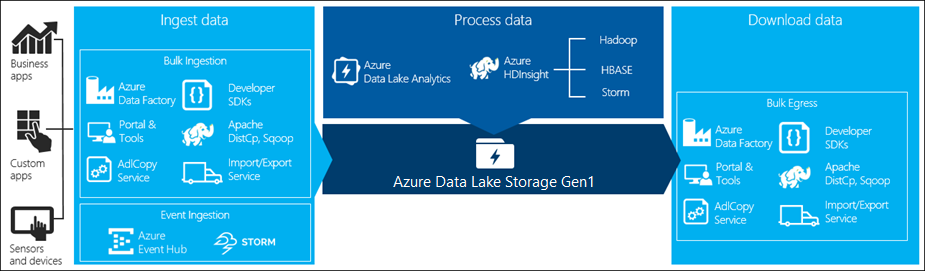

Ingerir dados em Data Lake Storage Gen1

Esta secção destaca as diferentes origens de dados e as diferentes formas pelas quais esses dados podem ser ingeridos numa conta Data Lake Storage Gen1.

Dados ad hoc

Isto representa conjuntos de dados mais pequenos que são utilizados para prototipar uma aplicação de macrodados. Existem diferentes formas de ingerir dados ad hoc consoante a origem dos dados.

| Origem de dados | Ingerir com |

|---|---|

| Computador local | |

| Azure Storage Blob |

Dados transmitidos em fluxo

Isto representa dados que podem ser gerados por várias origens, como aplicações, dispositivos, sensores, etc. Estes dados podem ser ingeridos em Data Lake Storage Gen1 por diversas ferramentas. Normalmente, estas ferramentas capturam e processam os dados numa base evento a evento em tempo real e, em seguida, escrevem os eventos em lotes em Data Lake Storage Gen1 para que possam ser processados.

Seguem-se as ferramentas que pode utilizar:

- Análise de Stream do Azure – os eventos ingeridos nos Hubs de Eventos podem ser escritos no Azure Data Lake Storage Gen1 com uma saída do Azure Data Lake Storage Gen1.

- EventProcessorHost – pode receber eventos dos Hubs de Eventos e, em seguida, escrevê-lo no Data Lake Storage Gen1 com o SDK .NET Data Lake Storage Gen1.

Dados relacionais

Também pode obter dados de bases de dados relacionais. Ao longo de um período de tempo, as bases de dados relacionais recolhem enormes quantidades de dados que podem fornecer informações importantes se forem processadas através de um pipeline de macrodados. Pode utilizar as seguintes ferramentas para mover esses dados para Data Lake Storage Gen1.

Dados de registo do servidor Web (carregar com aplicações personalizadas)

Este tipo de conjunto de dados é especificamente destacado porque a análise dos dados de registo do servidor Web é um caso de utilização comum para aplicações de macrodados e requer que grandes volumes de ficheiros de registo sejam carregados para Data Lake Storage Gen1. Pode utilizar qualquer uma das seguintes ferramentas para escrever os seus próprios scripts ou aplicações para carregar esses dados.

Para carregar dados de registo do servidor Web e também para carregar outros tipos de dados (por exemplo, dados de sentimentos sociais), é uma boa abordagem escrever os seus próprios scripts/aplicações personalizados porque lhe dá a flexibilidade de incluir o componente de carregamento de dados como parte da sua aplicação de macrodados maior. Em alguns casos, este código pode assumir a forma de um script ou de um utilitário de linha de comandos simples. Noutros casos, o código pode ser utilizado para integrar o processamento de macrodados numa aplicação ou solução empresarial.

Dados associados a clusters do Azure HDInsight

A maioria dos tipos de cluster do HDInsight (Hadoop, HBase, Storm) suporta Data Lake Storage Gen1 como um repositório de armazenamento de dados. Os clusters do HDInsight acedem a dados a partir de Blobs de Armazenamento do Azure (WASB). Para um melhor desempenho, pode copiar os dados do WASB para uma conta Data Lake Storage Gen1 associada ao cluster. Pode utilizar as seguintes ferramentas para copiar os dados.

Dados armazenados em clusters Do Hadoop iaaS ou no local

Grandes quantidades de dados podem ser armazenadas em clusters do Hadoop existentes, localmente em máquinas com HDFS. Os clusters do Hadoop podem estar numa implementação no local ou estar num cluster IaaS no Azure. Pode haver requisitos para copiar esses dados para Azure Data Lake Storage Gen1 para uma abordagem única ou de forma periódica. Existem várias opções que pode utilizar para o conseguir. Segue-se uma lista de alternativas e as trocas associadas.

| Abordagem | Detalhes | Vantagens | Considerações |

|---|---|---|---|

| Utilizar Azure Data Factory (ADF) para copiar dados diretamente de clusters do Hadoop para Azure Data Lake Storage Gen1 | O ADF suporta o HDFS como uma origem de dados | O ADF fornece suporte completo para o HDFS e a gestão e monitorização ponto a ponto de primeira classe | Requer que Gestão de Dados Gateway seja implementado no local ou no cluster IaaS |

| Exportar dados do Hadoop como ficheiros. Em seguida, copie os ficheiros para Azure Data Lake Storage Gen1 com o mecanismo adequado. | Pode copiar ficheiros para Azure Data Lake Storage Gen1 com:

|

Rápido para começar. Pode fazer carregamentos personalizados | Processo de vários passos que envolve várias tecnologias. A gestão e a monitorização tornar-se-ão um desafio ao longo do tempo, dada a natureza personalizada das ferramentas |

| Utilize o Distcp para copiar dados do Hadoop para o Armazenamento do Azure. Em seguida, copie os dados do Armazenamento do Azure para Data Lake Storage Gen1 com o mecanismo adequado. | Pode copiar dados do Armazenamento do Azure para Data Lake Storage Gen1 com: | Pode utilizar ferramentas open source. | Processo de vários passos que envolve várias tecnologias |

Conjuntos de dados realmente grandes

Para carregar conjuntos de dados que variam em vários terabytes, utilizar os métodos descritos acima pode, por vezes, ser lento e dispendioso. Nestes casos, pode utilizar as opções abaixo.

Utilizar o Azure ExpressRoute. O Azure ExpressRoute permite-lhe criar ligações privadas entre datacenters do Azure e infraestrutura no seu local. Isto fornece uma opção fiável para transferir grandes quantidades de dados. Para obter mais informações, veja Documentação do Azure ExpressRoute.

Carregamento "Offline" de dados. Se a utilização do Azure ExpressRoute não for viável por qualquer motivo, pode utilizar o serviço Importar/Exportar do Azure para enviar unidades de disco rígido com os seus dados para um datacenter do Azure. Os seus dados são carregados pela primeira vez para os Blobs de Armazenamento do Azure. Em seguida, pode utilizar Azure Data Factory ou a ferramenta AdlCopy para copiar dados dos Blobs de Armazenamento do Azure para Data Lake Storage Gen1.

Nota

Ao utilizar o serviço Importar/Exportar, os tamanhos de ficheiro nos discos que envia para o datacenter do Azure não devem ser superiores a 195 GB.

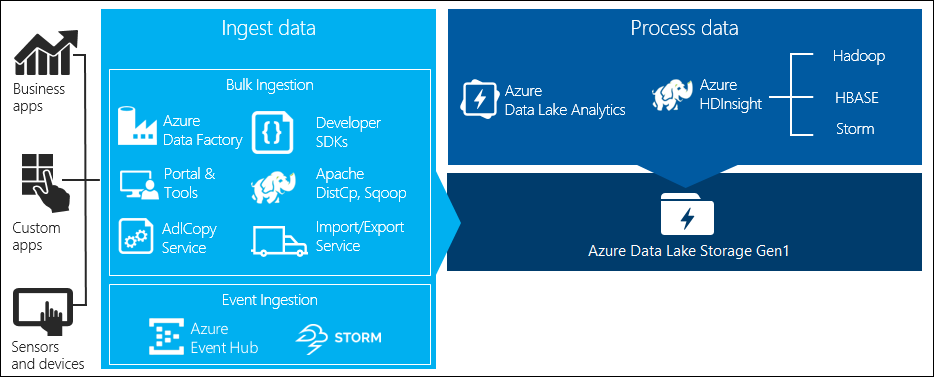

Processar dados armazenados no Data Lake Storage Gen1

Assim que os dados estiverem disponíveis no Data Lake Storage Gen1 pode executar análises sobre esses dados com as aplicações de macrodados suportadas. Atualmente, pode utilizar o Azure HDInsight e o Azure Data Lake Analytics para executar tarefas de análise de dados nos dados armazenados no Data Lake Storage Gen1.

Pode ver os seguintes exemplos.

- Criar um cluster do HDInsight com Data Lake Storage Gen1 como armazenamento

- Utilizar o Azure Data Lake Analytics com Data Lake Storage Gen1

Transferir dados do Data Lake Storage Gen1

Também poderá querer transferir ou mover dados do Azure Data Lake Storage Gen1 para cenários como:

- Mover dados para outros repositórios para interagir com os pipelines de processamento de dados existentes. Por exemplo, poderá querer mover dados de Data Lake Storage Gen1 para SQL do Azure Base de Dados ou SQL Server.

- Transfira dados para o seu computador local para processamento em ambientes IDE enquanto cria protótipos de aplicações.

Nesses casos, pode utilizar qualquer uma das seguintes opções:

Também pode utilizar os seguintes métodos para escrever o seu próprio script/aplicação para transferir dados de Data Lake Storage Gen1.

Visualizar dados no Data Lake Storage Gen1

Pode utilizar uma combinação de serviços para criar representações visuais de dados armazenados em Data Lake Storage Gen1.

- Pode começar por utilizar Azure Data Factory para mover dados do Data Lake Storage Gen1 para o Azure Synapse Analytics

- Depois disso, pode integrar o Power BI no Azure Synapse Analytics para criar representação visual dos dados.