Importar Dados

Importante

O suporte para o Estúdio de ML (clássico) terminará a 31 de agosto de 2024. Recomendamos a transição para o Azure Machine Learning até essa data.

A partir de 1 de dezembro de 2021, não poderá criar novos recursos do Estúdio de ML (clássico). Até 31 de agosto de 2024, pode continuar a utilizar os recursos existentes do Estúdio de ML (clássico).

- Consulte informações sobre projetos de machine learning em movimento de ML Studio (clássico) para Azure Machine Learning.

- Saiba mais sobre Azure Machine Learning.

A documentação do Estúdio de ML (clássico) está a ser descontinuada e poderá não ser atualizada no futuro.

Carrega dados de fontes externas na web; a partir de várias formas de armazenamento em nuvem em Azure, tais como tabelas, bolhas e bases de dados SQL; e de bases de dados SQL Server no local;

Categoria: Entrada e Saída de Dados

Nota

Aplica-se a: Machine Learning Studio (clássico) apenas

Módulos semelhantes de arrasto e queda estão disponíveis em Azure Machine Learning designer.

Visão geral do módulo

Este artigo descreve como usar o módulo de Dados de Importação em Machine Learning Studio (clássico), para carregar dados numa experiência de aprendizagem automática a partir de serviços de dados em nuvem existentes.

O módulo conta agora com um assistente para o ajudar a escolher uma opção de armazenamento e selecionar entre as subscrições e contas existentes para configurar rapidamente todas as opções. Precisa de editar uma ligação de dados existente? Sem problemas; o assistente carrega todos os detalhes de configuração anteriores para que não tenha de recomeçar do zero.

Depois de definir os dados que pretende e ligar à fonte, os Dados de Importação inferem o tipo de dados de cada coluna com base nos valores que contém e carregam os dados no seu espaço de trabalho Machine Learning Studio (clássico). A saída de Dados de Importação é um conjunto de dados que pode ser usado com qualquer experiência.

Importante

Atualmente, existem limitações nos tipos de contas de armazenamento que são suportadas. Para mais informações, consulte Notas Técnicas.

Se os dados de origem alterarem, pode atualizar o conjunto de dados e adicionar novos dados re-executando dados de importação. No entanto, se não quiser relê-lo a partir da fonte cada vez que executar a experiência, selecione a opção de resultados em cache para A VERDADEIRA. Quando esta opção é selecionada, o módulo verifica se a experiência já foi executada anteriormente utilizando a mesma fonte e as mesmas opções de entrada. Se for encontrada uma execução anterior, os dados na cache são utilizados, em vez de ressartar os dados da fonte.

Nota

Este módulo foi anteriormente nomeado Reader. Se usou previamente o módulo Reader numa experiência, é renomeado para Dados de Importação quando refrescar a experiência.

Origens de dados

O módulo De Dados de Importação suporta as seguintes fontes de dados. Clique nos links para obter instruções detalhadas e exemplos de utilização de cada fonte de dados.

Se não tem a certeza de como ou onde deve armazenar os seus dados, consulte este guia para cenários comuns de dados no processo de ciência de dados: Cenários para análises avançadas em Machine Learning.

| Origem de dados | Utilizar com |

|---|---|

| Web URL via HTTP | Obtenha dados que sejam hospedados num URL web que utiliza HTTP e que tenha sido fornecido nos formatos CSV, TSV, ARFF ou SvmLight |

| Consulta de Colmeia | Obtenha dados do armazenamento distribuído em Hadoop. Especifica os dados que pretende utilizando a linguagem HiveQL |

| Base de Dados SQL do Azure | Obtenha dados de Base de Dados SQL do Azure ou de SQL do Azure Data Warehouse |

| Tabela do Azure | Obtenha dados que são armazenados no serviço de mesa Azure |

| Importação de Armazenamento de Blobs do Azure | Obtenha dados que são armazenados no serviço de blob Azure |

| Fornecedores de Feed de Dados | Obtenha dados expostos como feed no formato OData |

| Importação de Bases de Dados SQL Server de Instalações | Obtenha dados de uma base de dados SQL Server no local usando o Microsoft Gestão de Dados Gateway |

| BD do Cosmos para o Azure | Obtenha dados armazenados em formato JSON em Azure Cosmos DB. |

Dica

Precisa de importar dados no formato JSON? Tanto R como Python suportam APIs DE REST, por isso utilize os módulos executar Python Script ou Executar scripts para analisar os seus dados e guardá-los como um conjunto de dados ML Azure.

Ou, use o SQL DB API para cosmosDB, que suporta várias lojas JSON, incluindo MongoDB, para ler os seus dados usando a opção Import from Azure Cosmos DB. Para mais informações, consulte Import from Azure Cosmos DB.

Como utilizar dados de importação

Adicione o módulo de Dados de Importação à sua experiência. Pode encontrar este módulo na categoria entrada e saída de dados em Studio (clássico).

Clique em Lançar O Assistente de Importação de Dados de Lançamento para configurar a fonte de dados utilizando um assistente.

O assistente obtém o nome e as credenciais da conta e ajuda-o a configurar outras opções. Se estiver a editar uma configuração existente, carrega primeiro os valores atuais.

Se não quiser utilizar o assistente, clique na fonte de Dados e escolha o tipo de armazenamento baseado na nuvem a que está a ler.

As definições adicionais dependem do tipo de armazenamento que escolher e se o armazenamento está ou não seguro. Pode ser necessário fornecer o nome da conta, tipo de ficheiro ou credenciais. Algumas fontes não requerem autenticação; para outros, pode precisar de saber o nome da conta, uma chave ou nome do recipiente.

Para mais detalhes, consulte a lista de fontes de Dados.

Selecione a opção De resultados em cache Utilização se pretender cache do conjunto de dados para reutilização em execuções sucessivas.

Assumindo que não houve outras alterações nos parâmetros do módulo, a experiência carrega os dados apenas na primeira vez que o módulo é executado, e depois utiliza uma versão em cache do conjunto de dados.

Desescolhe esta opção se precisar de recarregar os dados cada vez que executar a experiência.

Execute a experimentação.

Quando os Dados de Importação carregam os dados no Studio (clássico), infere o tipo de dados de cada coluna com base nos valores que contém, numéricos ou categóricos.

Se estiver presente um cabeçalho, o cabeçalho é utilizado para nomear as colunas do conjunto de dados de saída.

Se não existirem cabeçalhos de coluna existentes nos dados, novos nomes de colunas são gerados utilizando o formato col1, col2,... ,coln.

Resultados

Quando a importação estiver concluída, clique no conjunto de dados de saída e selecione Visualize para ver se os dados foram importados com sucesso.

Se quiser guardar os dados para reutilização, em vez de importar um novo conjunto de dados cada vez que a experiência é executada, clique com o botão direito na saída e selecione Guardar como Conjunto de Dados. Escolha um nome para o conjunto de dados. O conjunto de dados guardado preserva os dados no momento da poupança, e os dados não são atualizados quando a experiência é reecoda, mesmo que o conjunto de dados na experiência mude. Isto pode ser útil para tirar fotos de dados.

Após a importação dos dados, poderá necessitar de preparações adicionais para modelação e análise:

Gerar resumos estatísticos dos dados, utilizando Resumos dados ou Estatísticas Elementares do Cálculo.

Utilize metadados de edição para alterar nomes de colunas, para manusear uma coluna como um tipo de dados diferente, ou para indicar que algumas colunas são etiquetas ou funcionalidades.

Utilize colunas selecionadas no conjunto de dados para selecionar um subconjunto de colunas para transformar ou utilizar na modelação. As colunas transformadas ou removidas podem ser facilmente reunidas para o conjunto de dados original utilizando o módulo Add Columns ou o módulo 'Unir Dados '.

Utilize a partição e a amostra para dividir o conjunto de dados, efetuar a amostragem ou obter as linhas de cima n.

Utilizar Aplicar SQL Transformação para agregar dados, filtrar ou transformar usando declarações SQL.

Utilize estes módulos para limpar colunas de texto e gerar novas funcionalidades de texto:

- Pré-processar Texto

- Extrair Funcionalidades N-Grama a partir de Texto

- Reconhecimento de Entidades Nomeadas

- Execute Python Script, para implementar NLP personalizado com base em nltk.

Notas técnicas

Esta secção fornece uma lista de problemas conhecidos com o módulo de Dados de Importação , bem como algumas informações gerais de resolução de problemas não específicas de um tipo de origem.

Tipos de conta suportados

Frequentemente, a Azure lança novos serviços ou novos tipos de armazenamento; no entanto, existe tipicamente um atraso, enquanto o suporte para novos tipos de conta é implementado em Machine Learning Studio (clássico).

Atualmente, Machine Learning suporta todas as contas de armazenamento para fins gerais, com exceção das que utilizam o armazenamento redundante de zona (ZRS).

São suportadas as opções de armazenamento redundantes locais (LRS) e geo-redundantes.

As bolhas de bloco são suportadas, mas as bolhas de apêndice não são.

Perguntas e problemas comuns

Esta secção descreve algumas questões conhecidas, questões comuns e soluções alternativas.

Cabeçalhos devem ser linhas únicas

Se estiver a importar ficheiros CSV, esteja ciente de que Machine Learning permite uma única linha de cabeçalho. Não é possível inserir cabeçalhos multi-linhas.

Separadores personalizados apoiados na importação, mas não exportação

O módulo De Dados de Importação suporta a importação de dados que utilizam separadores de colunas alternativos, como o ponto e vírgula (;), que é frequentemente utilizado na Europa. Quando importar dados de ficheiros CSV em armazenamento externo, selecione o CSV com a opção de codificação e escolha uma codificação suportada.

No entanto, não é possível gerar separadores alternativos quando prepara dados para exportação utilizando o módulo Converte para CSV .

Má separação de colunas em dados de cordas que contenham vírgulas

Praticamente todos os caracteres que podem ser especificados como separadores de colunas (separadores, espaços, vírgulas, etc.) também podem ser encontrados aleatoriamente em campos de texto. Importar texto do CSV requer sempre cautela para evitar separar o texto em novas colunas desnecessárias. É um problema comum no processamento de texto que provavelmente encontrou e lidou de diferentes maneiras.

Os problemas também podem ocorrer quando se tenta exportar uma coluna de dados de cordas que contém vírgulas. Machine Learning não suporta qualquer manipulação especial ou tradução especial desses dados, tais como a colocação de cordas em aspas. Além disso, não é possível usar caracteres de fuga antes de uma vírgula para garantir que as vírgulas são tratadas como um personagem literal. Como consequência, novos campos são criados no ficheiro de saída para cada vírgula que é encontrada no campo de cordas.

Para evitar problemas de exportação, utilize o módulo de texto pré-processamento para remover caracteres de pontuação dos campos de cordas.

Também pode usar script R personalizado ou Python script para processar textos complexos e garantir que os dados podem ser importados ou exportados corretamente.

Codificação UTF-8 necessária

Machine Learning requer codificação UTF-8. Se os dados que está a importar utilizarem uma codificação diferente, ou forem exportados de uma fonte de dados que utiliza uma codificação padrão diferente, podem surgir vários problemas no texto.

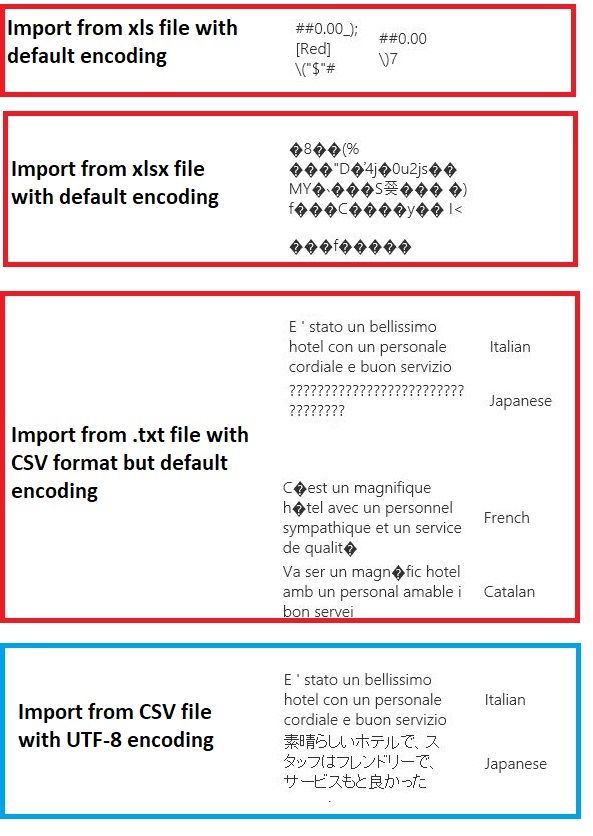

Por exemplo, a seguinte imagem contém o mesmo conjunto de dados multilanguage exportado a partir de Excel e depois importado para Machine Learning em quatro combinações diferentes de tipo de ficheiro e codificação.

O terceiro exemplo representa dados que foram perdidos durante a poupança de Excel no formato CSV, porque a codificação correta não foi especificada na altura. Portanto, se tiver problemas, certifique-se de verificar não apenas o ficheiro de que está a importar, mas se o ficheiro foi corretamente exportado da fonte.

Conjunto de dados não tem nomes de colunas

Se o conjunto de dados que está a importar não tiver nomes de colunas, certifique-se de especificar uma das opções "sem cabeçalho". Quando o faz, os Dados de Importação adicionam nomes de colunas predefinidos utilizando o formato Col1, Col2, etc. Mais tarde, utilize Metadados de Edição para corrigir os nomes das colunas.

Se estiver a exportar um conjunto de dados para um ficheiro CSV, utilize metadados de edição para adicionar nomes de colunas antes de o converter ou exportar.

Soluções alternativas para fontes de dados não apoiadas

Se precisar de obter dados de uma fonte que não está na lista, existem várias soluções alternativas que pode tentar:

Para fazer o upload de dados a partir de um ficheiro no seu computador, clique em Novo no Estúdio (clássico), selecione Dataset e, em seguida, selecione From Local File. Localize o ficheiro e especifique o formato (TSV, CSV, etc.). Para obter mais informações, consulte os dados de formação de importação em Studio (clássico).

Use R ou Python. Pode utilizar o módulo Executar R Script com um pacote R apropriado para obter dados de outras bases de dados em nuvem.

O módulo Executar Python Script também permite ler e converter dados de várias fontes. Veja estes exemplos de cientistas de dados da Microsoft na Galeria de Inteligência Cortana:

Carregue o ficheiro não-texto do armazenamento da bolha Azure

Obtenha dados de clusters AWS. Pode executar uma consulta contra um cluster genérico de Colmeia com webHCat ou ponto final HCatalog ativado. Ou publicar como uma página e ler a partir do URL web.

Obtenha dados de MongoDB. O utilitário de migração de dados para a Azure Cosmos DB suporta uma grande variedade de fontes e formatos. Para obter mais informações e exemplos, consulte Azure Cosmos DB: Ferramenta de migração de dados

Para mais ideias e soluções alternativas, consulte o fórum Machine Learning ou a Galeria Azure AI.

Parâmetros do módulo

Cada fonte de dados deve ser configurada utilizando diferentes opções. Esta tabela lista apenas as opções que são comuns a todas as fontes de dados.

| Name | Intervalo | Tipo | Predefinição | Description |

|---|---|---|---|---|

| Origem de dados | Lista | Fonte de dados ou pia | Serviço blob em Azure Armazenamento | A fonte de dados pode ser HTTP, HTTPS anónimo, um ficheiro no serviço Blob ou serviço de Tabela, uma base de dados SQL em Azure, uma SQL do Azure Data Warehouse, uma tabela Hive ou um ponto final OData. |

| Use resultados em cache | VERDADEIRO/FALSO | Booleano | FALSE | Se TRUE, o módulo verificará se a experiência foi executada anteriormente utilizando a mesma fonte e as mesmas opções de entrada, e se for encontrada uma execução anterior, os dados na cache são utilizados. Se FOREM FALSAs, ou se forem encontradas alterações, os dados serão recarregados a partir da fonte. |

Saídas

| Nome | Tipo | Description |

|---|---|---|

| Conjunto de dados de resultados | Tabela de Dados | Dataset com dados descarregados |

Exceções

| Exceção | Description |

|---|---|

| Erro 0027 | Uma exceção ocorre quando dois objetos têm que ter o mesmo tamanho, mas não são. |

| Erro 0003 | Uma exceção ocorre se uma ou mais entradas forem nulas ou vazias. |

| Erro 0029 | Uma exceção ocorre quando um URI inválido é passado. |

| Erro 0030 | uma exceção ocorre quando não é possível descarregar um ficheiro. |

| Erro 0002 | Ocorre uma exceção se um ou mais parâmetros não puderem ser analisados ou convertidos do tipo especificado para o tipo exigido pelo método-alvo. |

| Erro 0009 | Ocorre uma exceção se o nome da conta de armazenamento Azure ou o nome do recipiente forem especificados incorretamente. |

| Erro 0048 | Uma exceção ocorre quando não é possível abrir um ficheiro. |

| Erro 0015 | Uma exceção ocorre se a ligação da base de dados tiver falhado. |

| Erro 0046 | Uma exceção ocorre quando não é possível criar um diretório em caminho especificado. |

| Erro 0049 | Uma exceção ocorre quando não é possível analisar um ficheiro. |

Para obter uma lista de erros específicos dos módulos Studio (clássicos), consulte Machine Learning Códigos de Erro.

Para obter uma lista de exceções da API, consulte Machine Learning CÓDIGOs de Erro da API REST.

Ver também

Entrada e saída de dados

Conversões de formato de dados

Dados de Exportação

Lista de Módulos A-Z