Läsa in data i Azure Data Lake Storage Gen1 med hjälp av Azure Data Factory

GÄLLER FÖR: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dricks

Prova Data Factory i Microsoft Fabric, en allt-i-ett-analyslösning för företag. Microsoft Fabric omfattar allt från dataflytt till datavetenskap, realtidsanalys, business intelligence och rapportering. Lär dig hur du startar en ny utvärderingsversion kostnadsfritt!

Azure Data Lake Storage Gen1 (tidigare kallat Azure Data Lake Store) är en lagringsplats i företagsomfattande hyperskala för analysarbetsbelastningar med stordata. Med Data Lake Storage Gen1 kan du samla in data av valfri storlek, typ och inmatningshastighet. Data samlas in på en enda plats för driftsanalys och undersökande analys.

Azure Data Factory är en fullständigt hanterad molnbaserad dataintegreringstjänst. Du kan använda tjänsten för att fylla sjön med data från ditt befintliga system och spara tid när du skapar dina analyslösningar.

Azure Data Factory har följande fördelar när du läser in data i Data Lake Storage Gen1:

- Enkelt att konfigurera: En intuitiv 5-stegsguide utan skript.

- Stöd för omfattande datalager: Inbyggt stöd för en omfattande uppsättning lokala och molnbaserade datalager. En detaljerad lista finns i tabellen med datalager som stöds.

- Säker och kompatibel: Data överförs via HTTPS eller ExpressRoute. Den globala tjänstnärvaron säkerställer att dina data aldrig lämnar den geografiska gränsen.

- Höga prestanda: Upp till 1 GB/s datainläsningshastighet till Data Lake Storage Gen1. Mer information finns i aktiviteten Kopiera prestanda.

Den här artikeln visar hur du använder verktyget Data Factory Copy Data för att läsa in data från Amazon S3 till Data Lake Storage Gen1. Du kan följa liknande steg för att kopiera data från andra typer av datalager.

Kommentar

Mer information finns i Kopiera data till eller från Data Lake Storage Gen1 med hjälp av Azure Data Factory.

Förutsättningar

- Azure-prenumeration: Om du inte har en Azure-prenumeration skapar du ett kostnadsfritt konto innan du börjar.

- Data Lake Storage Gen1-konto: Om du inte har något Data Lake Storage Gen1-konto kan du läsa anvisningarna i Skapa ett Data Lake Storage Gen1-konto.

- Amazon S3: Den här artikeln visar hur du kopierar data från Amazon S3. Du kan använda andra datalager genom att följa liknande steg.

Skapa en datafabrik

Om du inte har skapat din datafabrik ännu följer du stegen i Snabbstart: Skapa en datafabrik med hjälp av Azure-portalen och Azure Data Factory Studio för att skapa en. När du har skapat den bläddrar du till datafabriken i Azure-portalen.

Välj Öppna på panelen Öppna Azure Data Factory Studio för att starta Dataintegration-programmet på en separat flik.

Läsa in data i Data Lake Storage Gen1

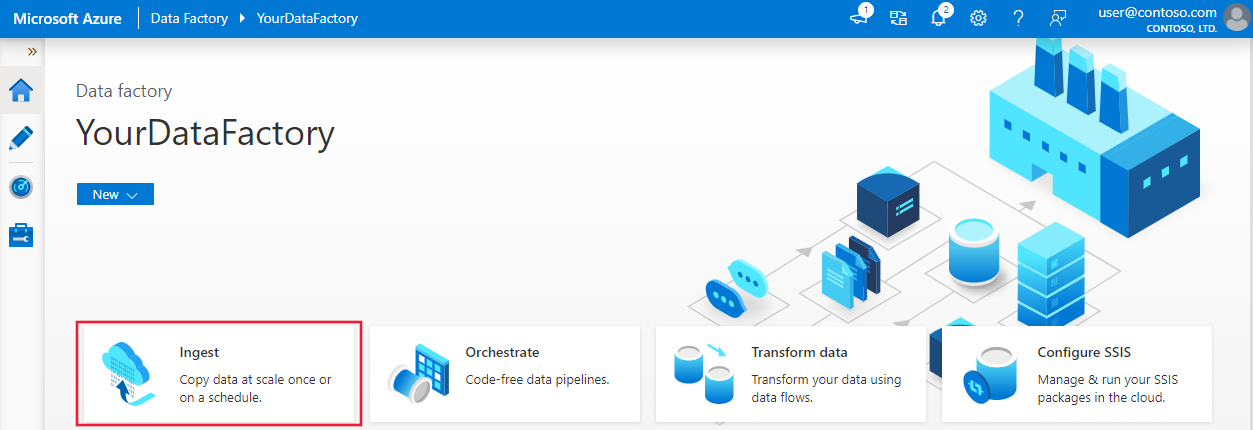

På startsidan väljer du panelen Mata in för att starta verktyget Kopiera data:

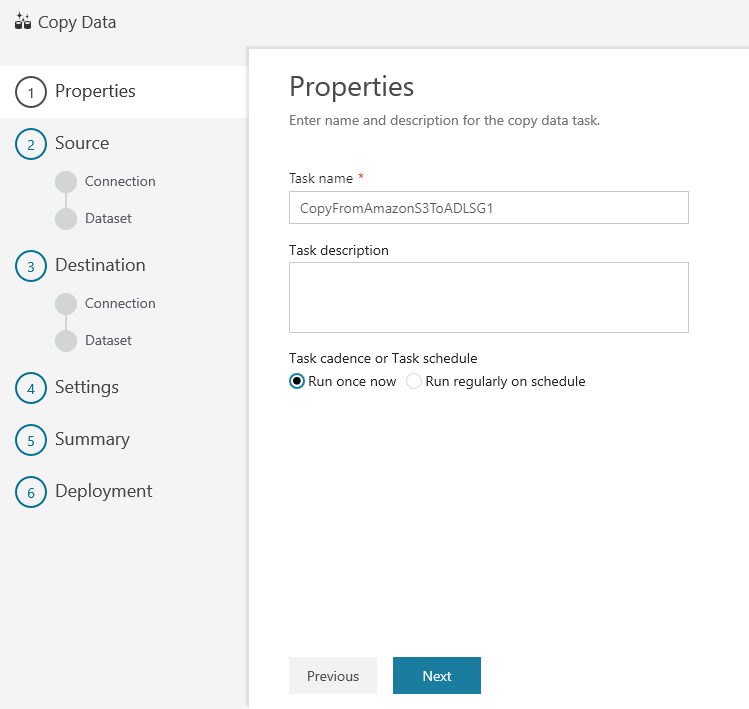

På sidan Egenskaper anger du CopyFromAmazonS3ToADLS för fältet Aktivitetsnamn och väljer Nästa:

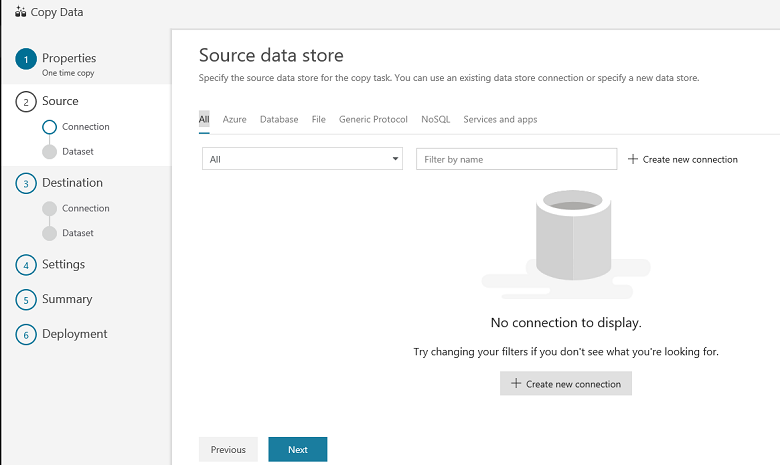

På sidan Källdatalager väljer du + Skapa ny anslutning:

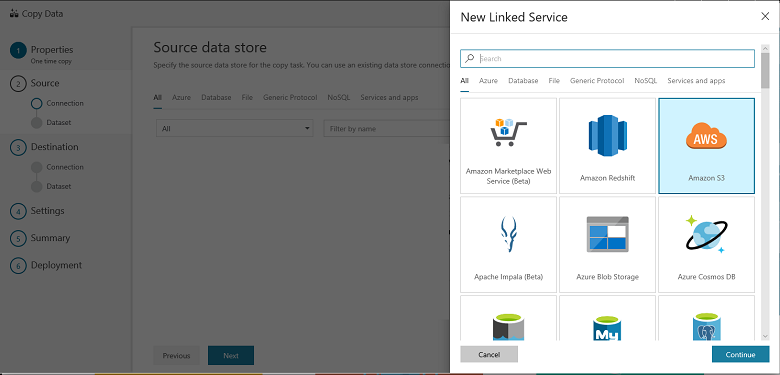

Välj Amazon S3 och välj Fortsätt

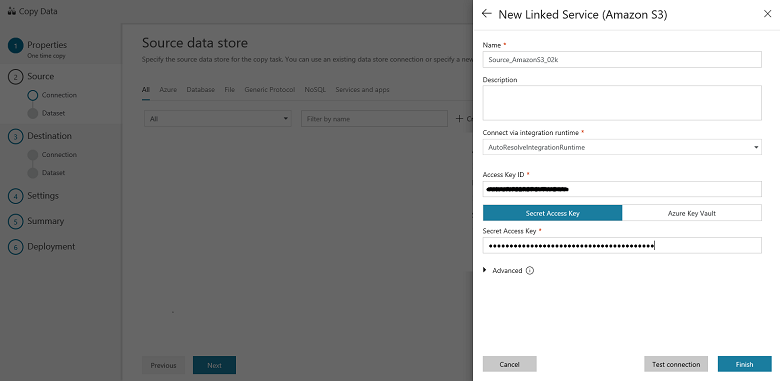

Gör följande på sidan Ange Amazon S3-anslutning:

Ange värdet för åtkomstnyckelns ID .

Ange värdet hemlig åtkomstnyckel.

Välj Slutför.

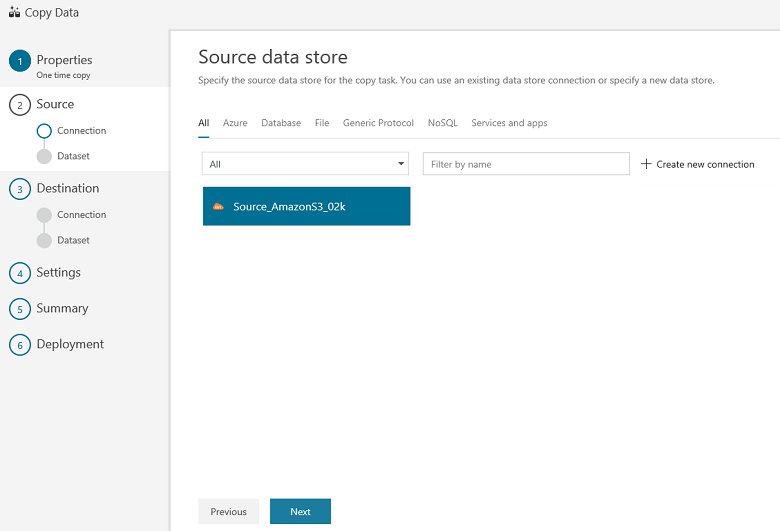

Du ser en ny anslutning. Välj Nästa.

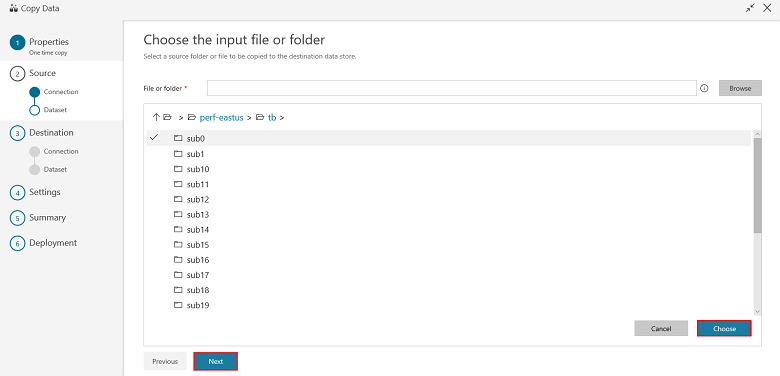

På sidan Välj indatafil eller mapp bläddrar du till den mapp och fil du vill kopiera över. Välj mappen/filen, välj Välj och välj sedan Nästa:

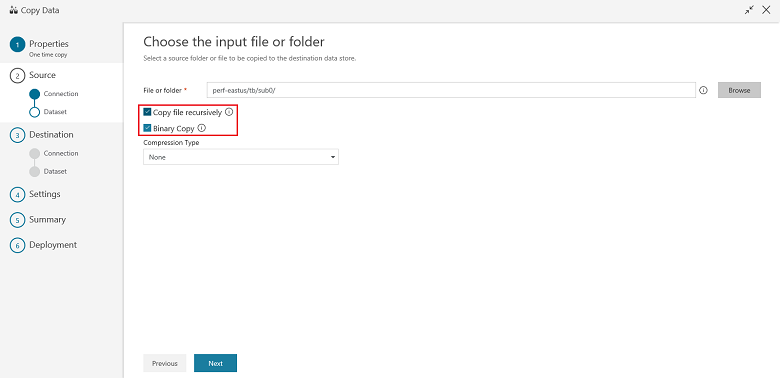

Välj kopieringsbeteendet genom att välja alternativen Kopiera filer rekursivt och Binär kopia (kopiera filer som de är). Välj Nästa:

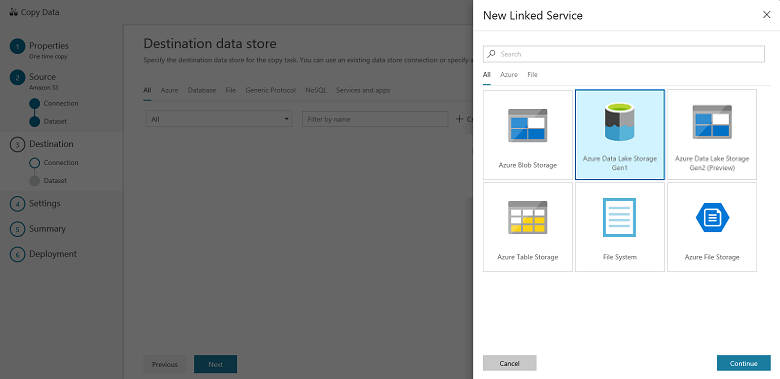

På sidan Måldatalager väljer du + Skapa ny anslutning och sedan Azure Data Lake Storage Gen1 och väljer Fortsätt:

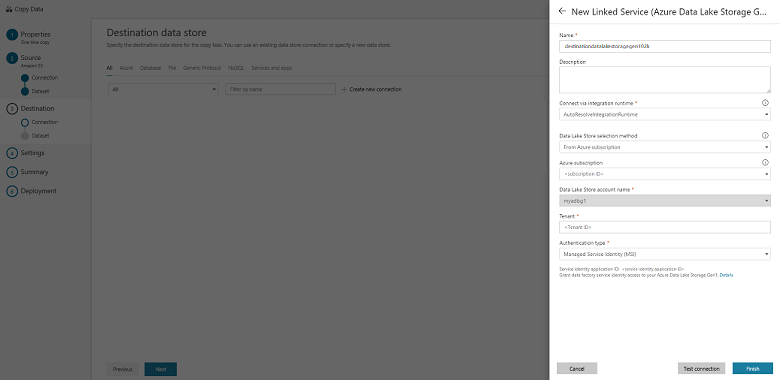

På sidan Ny länkad tjänst (Azure Data Lake Storage Gen1) gör du följande:

- Välj ditt Data Lake Storage Gen1-konto som Data Lake Store-kontonamn.

- Ange klientorganisationen och välj Slutför.

- Välj Nästa.

Viktigt!

I den här genomgången använder du en hanterad identitet för Azure-resurser för att autentisera ditt Data Lake Storage Gen1-konto. Se till att ge MSI rätt behörigheter i Data Lake Storage Gen1 genom att följa dessa instruktioner.

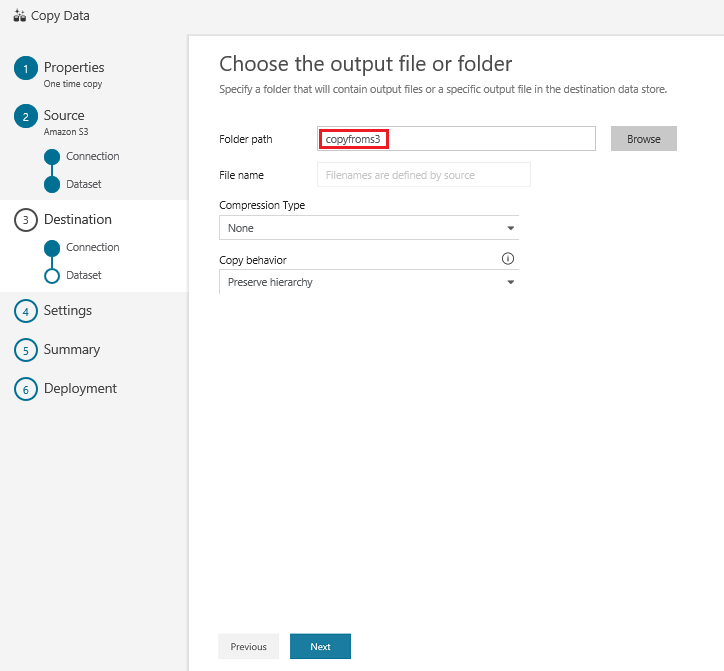

På sidan Välj utdatafil eller mapp anger du copyfroms3 som namn på utdatamappen och väljer Nästa:

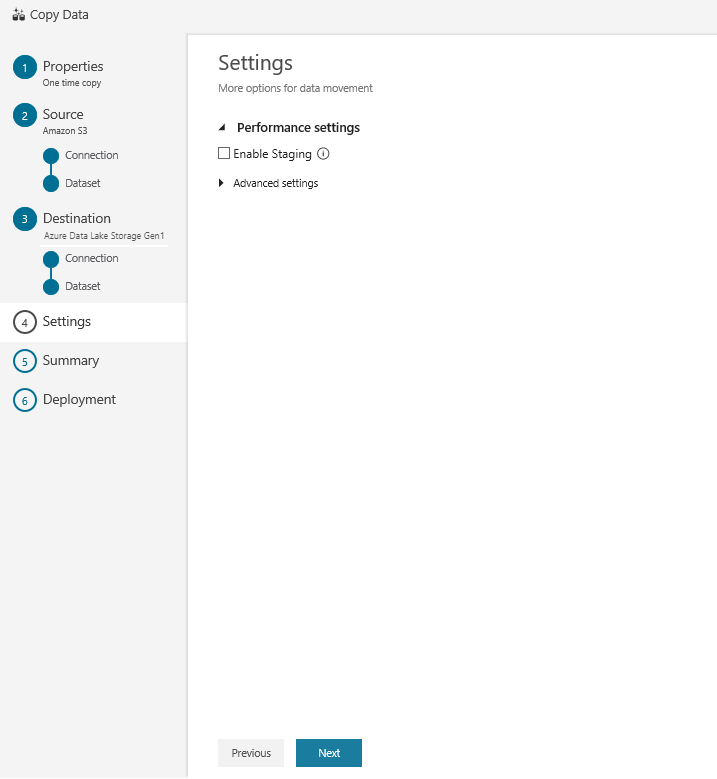

På sidan Inställningar väljer du Nästa:

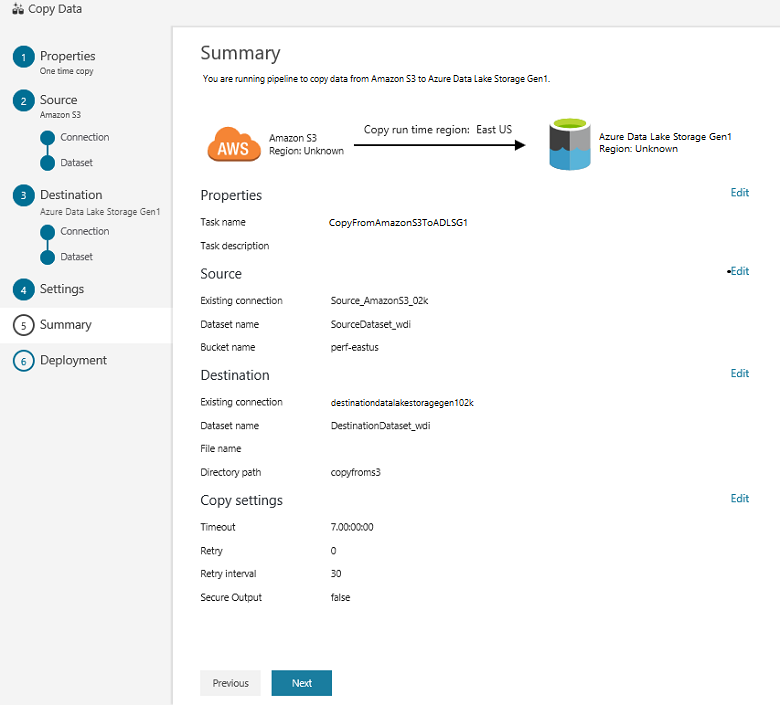

På sidan Sammanfattning granskar du inställningarna och väljer Nästa:

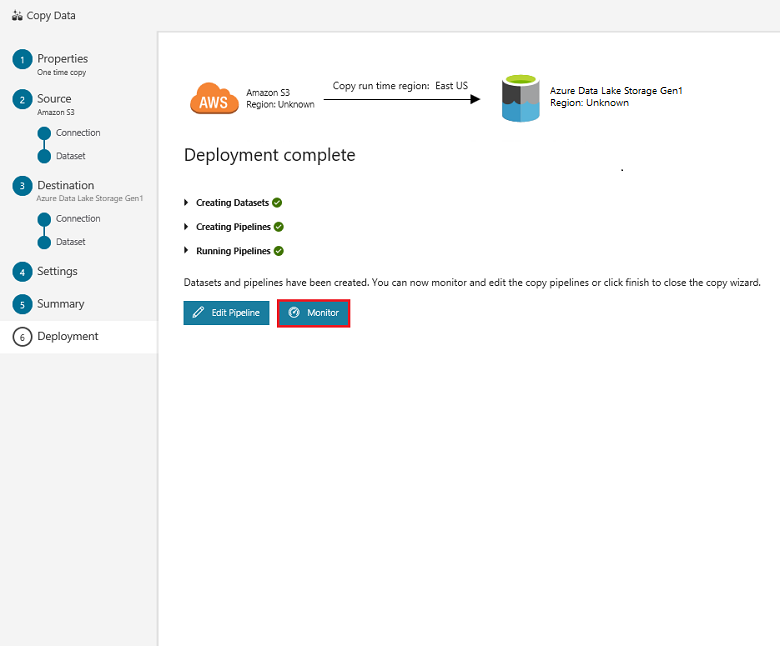

På sidan Distribution väljer du Övervaka för att övervaka pipelinen (uppgift):

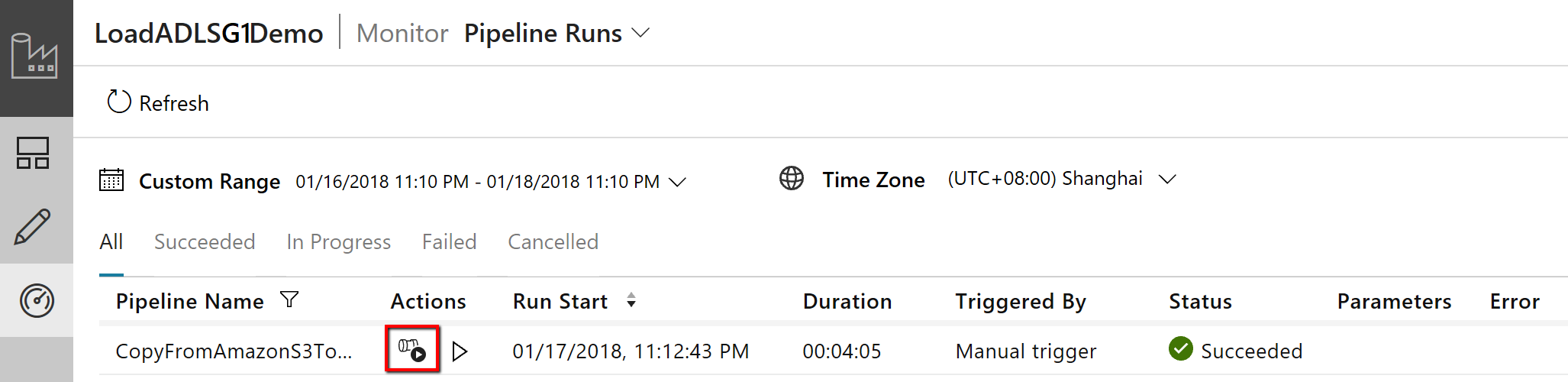

Observera att fliken Övervaka till vänster väljs automatiskt. Kolumnen Åtgärder innehåller länkar för att visa aktivitetskörningsinformation och köra pipelinen igen:

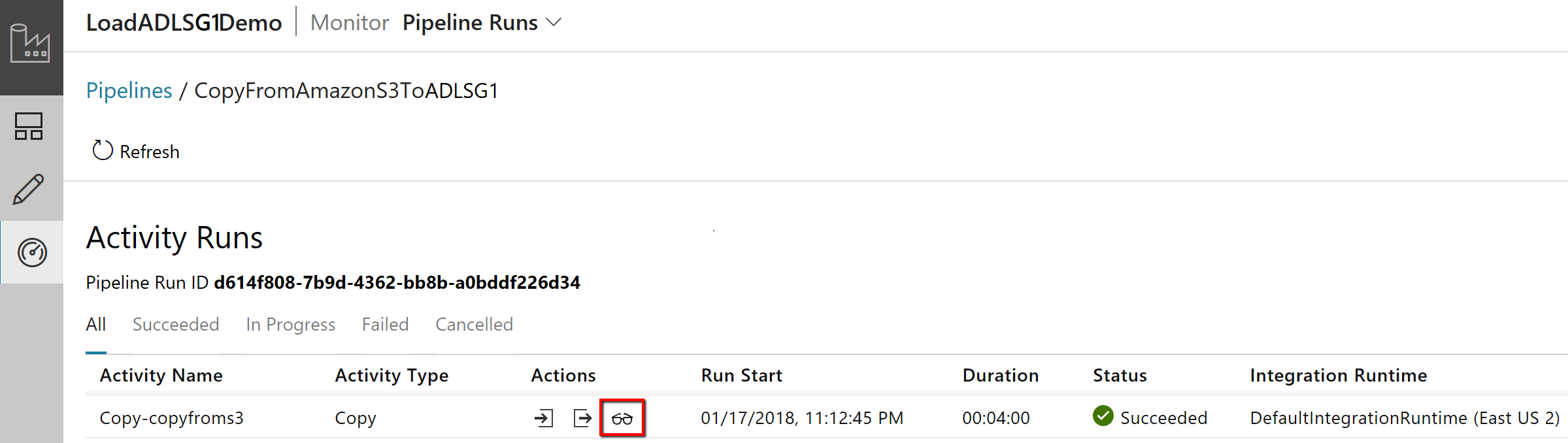

Om du vill visa aktivitetskörningar som är associerade med pipelinekörningen väljer du länken Visa aktivitetskörningar i kolumnen Åtgärder . Det finns bara en aktivitet (kopieringsaktiviteten) i pipelinen. Därför visas bara en post. Om du vill växla tillbaka till pipelinekörningsvyn väljer du länken Pipelines längst upp. Om du vill uppdatera listan väljer du Refresh (Uppdatera).

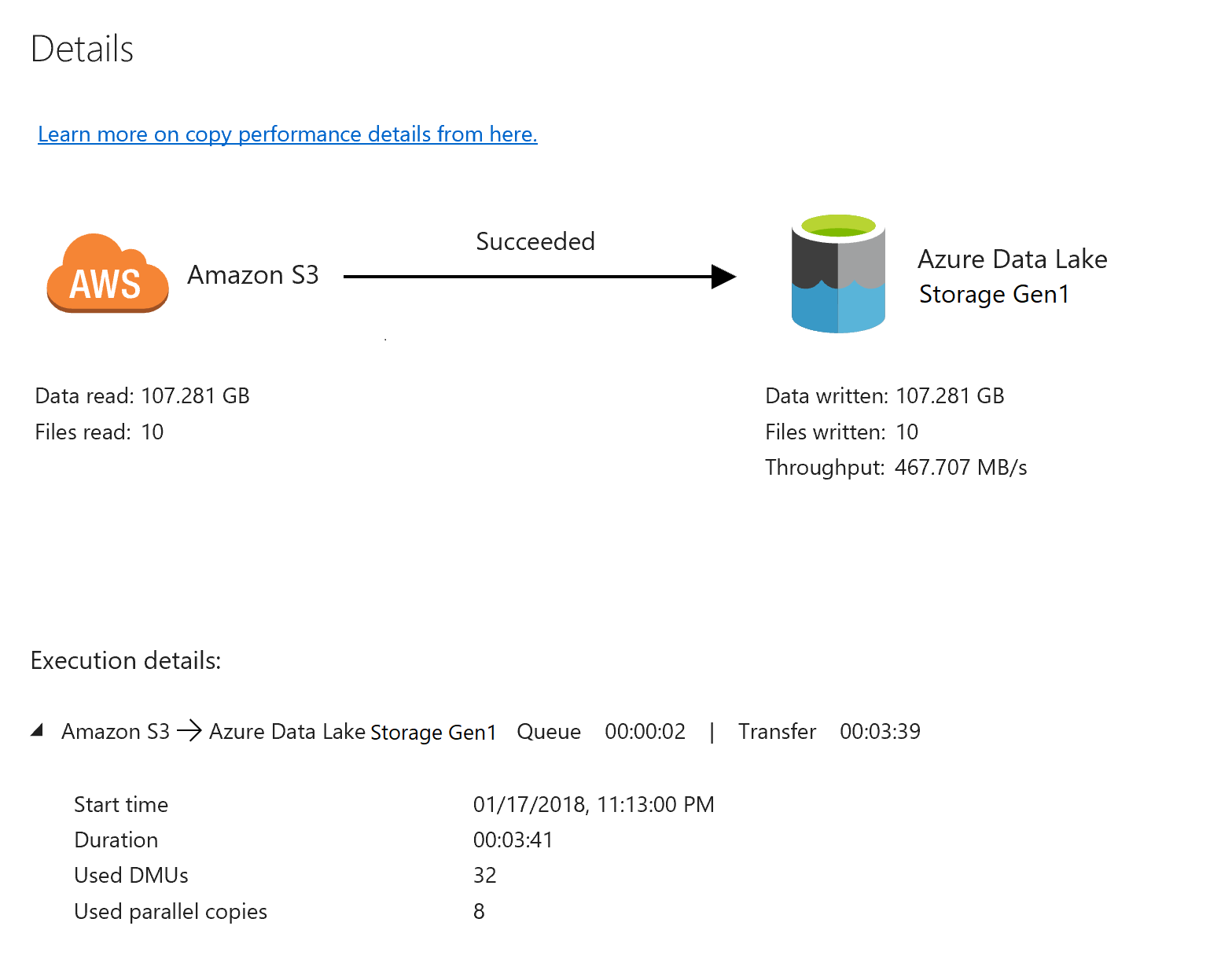

Om du vill övervaka körningsinformationen för varje kopieringsaktivitet väljer du länken Information under Åtgärder i aktivitetsövervakningsvyn. Du kan övervaka information som mängden data som kopieras från källan till mottagaren, dataflödet, körningsstegen med motsvarande varaktighet och använda konfigurationer:

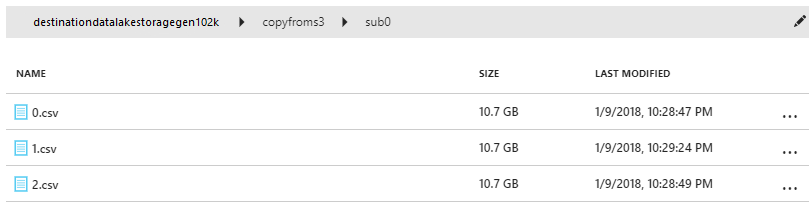

Kontrollera att data kopieras till ditt Data Lake Storage Gen1-konto:

Relaterat innehåll

Gå vidare till följande artikel om du vill veta mer om stöd för Data Lake Storage Gen1: