Kopiera inkrementellt nya filer baserat på tidspartitionerat filnamn med verktyget Kopiera data

GÄLLER FÖR: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dricks

Prova Data Factory i Microsoft Fabric, en allt-i-ett-analyslösning för företag. Microsoft Fabric omfattar allt från dataflytt till datavetenskap, realtidsanalys, business intelligence och rapportering. Lär dig hur du startar en ny utvärderingsversion kostnadsfritt!

I den här självstudien skapar du en datafabrik i Azure Portal. Sedan använder du verktyget Kopiera data för att skapa en pipeline som stegvis kopierar nya filer baserat på tidspartitionerat filnamn från Azure Blob Storage till Azure Blob Storage.

Kommentar

Om du inte har använt Azure Data Factory tidigare kan du läsa Introduktion till Azure Data Factory.

I den här självstudien får du göra följande:

- Skapa en datafabrik.

- Använd verktyget Kopiera data för att skapa en pipeline.

- Övervaka pipelinen och aktivitetskörningarna.

Förutsättningar

- Azure-prenumeration: Om du inte har någon Azure-prenumeration kan du skapa ett kostnadsfritt konto innan du börjar.

- Azure Storage-konto: Använd Blob Storage som käll- och mottagardatalager . Om du inte har något Azure-lagringskonto finns det anvisningar i Skapa ett lagringskonto.

Skapa två containrar i Blob Storage

Förbered bloblagringen för självstudien genom att utföra de här stegen.

Skapa en container med namnet source. Skapa en mappsökväg som 2021/07/15/06 i containern. Skapa en tom textfil och ge den namnet file1.txt. Ladda upp file1.txt till mappsökvägen source/2021/07/15/06 i ditt lagringskonto. Du kan använda olika verktyg för att utföra dessa uppgifter, exempelvis Azure Storage Explorer.

Kommentar

Justera mappnamnet med din UTC-tid. Om den aktuella UTC-tiden till exempel är 06:10 den 15 juli 2021 kan du skapa mappsökvägen som källa/2021/07/15/06/ av regeln för källan/{Year}/{Month}/{Day}/{Hour}/.

Skapa en container med namnet destination. Du kan använda olika verktyg för att utföra dessa uppgifter, exempelvis Azure Storage Explorer.

Skapa en datafabrik

Välj Skapa en resursintegreringsdatafabrik>> på den vänstra menyn:

I fönstret Ny datafabrik, under Namn anger du ADFTutorialDataFactory.

Namnet på datafabriken måste vara globalt unikt. Du kan få följande felmeddelande:

Ange ett annat namn för datafabriken om du får ett felmeddelande om namnvärdet. Använd till exempel namnet dittnamnADFTutorialDataFactory. Se artikeln Data Factory – namnregler för namnregler för Data Factory-artefakter.

Välj den Azure-prenumeration som du vill skapa den nya datafabriken i.

Gör något av följande för Resursgrupp:

a. Välj Använd befintlig och välj en befintlig resursgrupp i listrutan.

b. Välj Skapa ny och ange namnet på en resursgrupp.

Mer information om resursgrupper finns i Använda resursgrupper för att hantera Azure-resurser.

För version väljer du V2.

Under plats väljer du en plats för datafabriken. Endast platser som stöds visas i listrutan. Datalagren (t.ex. Azure Storage och SQL Database) och beräkningarna (t.ex. Azure HDInsight) som används i datafabriken kan finnas på andra platser och i andra regioner.

Välj Skapa.

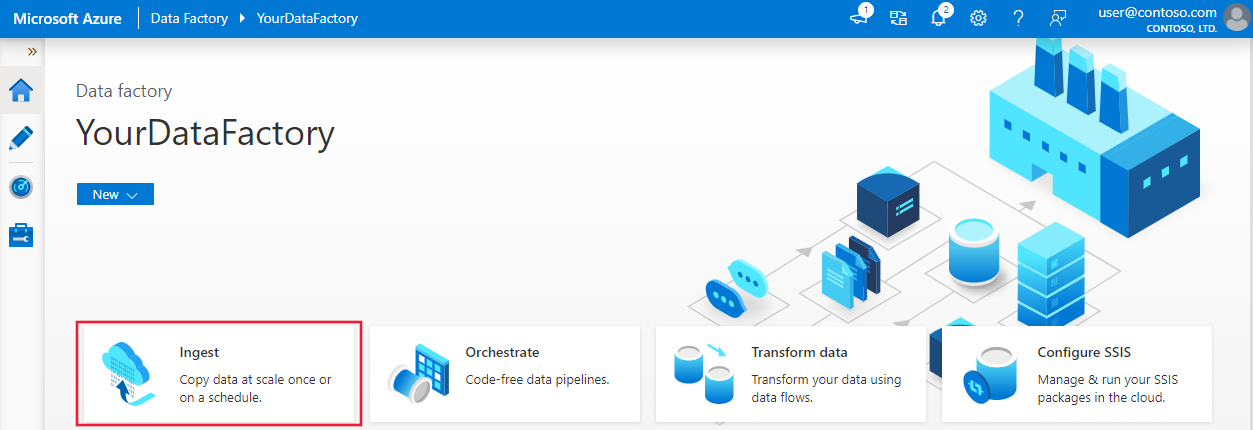

När den har skapats visas startsidan för Data Factory.

Om du vill starta Användargränssnittet för Azure Data Factory på en separat flik väljer du Öppna på panelen Öppna Azure Data Factory Studio.

Använd verktyget Kopiera data för att skapa en pipeline

På startsidan för Azure Data Factory väljer du inmatningsrubriken för att starta verktyget Kopiera data.

På sidan Egenskaper gör du följande:

Under Aktivitetstyp väljer du Inbyggd kopieringsaktivitet.

Under Aktivitetstakt eller aktivitetsschema väljer du Rullande fönster.

Under Upprepning anger du 1 timme.

Välj Nästa.

Gör följande på sidan Källdatalager:

a. Välj + Ny anslutning för att lägga till en anslutning.

b. Välj Azure Blob Storage i galleriet och välj sedan Fortsätt.

c. På sidan Ny anslutning (Azure Blob Storage) anger du ett namn för anslutningen. Välj din Azure-prenumeration och välj ditt lagringskonto i listan Lagringskontonamn . Testa anslutningen och välj sedan Skapa.

d. På sidan Källdatalager väljer du den nyligen skapade anslutningen i avsnittet Anslut ion.

e. I avsnittet Arkiv eller mapp bläddrar du till och väljer källcontainern och väljer sedan OK.

f. Under Beteende för filinläsning väljer du Inkrementell belastning: tidspartitionerade mapp-/filnamn.

g. Skriv sökvägen för den dynamiska mappen som källa/{år}/{månad}/{dag}/{timme}/, och ändra formatet enligt följande skärmbild.

h. Kontrollera Binär kopia och välj Nästa.

Slutför följande steg på sidan Måldatalager :

Välj AzureBlobStorage, som är samma lagringskonto som datakällans lagringsplats.

Bläddra och välj målmappen och välj sedan OK.

Skriv sökvägen för den dynamiska mappen som mål/{year}/{month}/{day}/{hour}/, och ändra formatet enligt följande skärmbild.

Välj Nästa.

På sidan Inställningar under Uppgiftsnamn anger du DeltaCopyFromBlobPipeline och väljer sedan Nästa. Med användargränssnittet för Data Factory skapas en pipeline med angivet aktivitetsnamn.

Granska inställningarna på sidan Sammanfattning och klicka på Nästa.

Välj Övervaka på sidan Distribution för att övervaka pipelinen (aktiviteten).

Observera att fliken Övervaka till vänster väljs automatiskt. Du behöver vänta på pipelinekörningen när den utlöses automatiskt (ungefär efter en timme). När den körs väljer du pipelinens namnlänk DeltaCopyFromBlobPipeline för att visa aktivitetskörningsinformation eller köra pipelinen igen. Om du vill uppdatera listan väljer du Refresh (Uppdatera).

Det finns bara en aktivitet (kopieringsaktiviteten) i pipelinen. Därför visas bara en post. Justera kolumnbredden för kolumnerna Källa och Mål (om det behövs) för att visa mer information. Du kan se att källfilen (file1.txt) har kopierats från källa/2021/07/15/06/ till mål/2021/07/15/06/ med samma filnamn.

Du kan också kontrollera samma sak med hjälp av Azure Storage Explorer (https://storageexplorer.com/) för att genomsöka filerna.

Skapa ytterligare en tom textfil med det nya namnet som file2.txt. Ladda upp filen file2.txt till mappsökvägen source/2021/07/15/07 i ditt lagringskonto. Du kan använda olika verktyg för att utföra dessa uppgifter, exempelvis Azure Storage Explorer.

Kommentar

Du kanske är medveten om att en ny mappsökväg måste skapas. Justera mappnamnet med din UTC-tid. Om den aktuella UTC-tiden till exempel är 07:30 den juli. 15. 2021 kan du skapa mappsökvägen som källa/2021/07/15/07/ enligt regeln {Year}/{Month}/{Day}/{Hour}/.

Om du vill gå tillbaka till vyn Pipelinekörningar väljer du Alla pipelines-körningar och väntar på att samma pipeline ska utlösas igen automatiskt efter ytterligare en timme.

Välj den nya DeltaCopyFromBlobPipeline-länken för den andra pipelinekörningen när den kommer och gör samma sak för att granska information. Källfilen (file2.txt) har kopierats från källa/2021/07/15/07/ till destination/2021/07/15/07/ med samma filnamn. Du kan också kontrollera samma sak med hjälp av Azure Storage Explorer (https://storageexplorer.com/) för att genomsöka filerna i målcontainern .

Relaterat innehåll

Fortsätt till följande självstudie och lär dig att transformera data med ett Spark-kluster på Azure:

Feedback

Kommer snart: Under hela 2024 kommer vi att fasa ut GitHub-problem som feedbackmekanism för innehåll och ersätta det med ett nytt feedbacksystem. Mer information finns i: https://aka.ms/ContentUserFeedback.

Skicka och visa feedback för