Özel konuşma modelinin doğruluğunu test etme

Bu makalede, metin modeline veya kendi özel modellerinize yönelik temel konuşmanın doğruluğunu nicel olarak ölçmeyi ve geliştirmeyi öğreneceksiniz. Doğruluğu test etmek için ses + insan etiketli transkript verileri gereklidir. 30 dakikadan 5 saate kadar temsili ses sağlamanız gerekir.

Önemli

Test sırasında sistem bir transkripsiyon gerçekleştirir. Fiyatlandırma hizmet teklifine ve abonelik düzeyine göre farklılık gösterdiği için bu durumu göz önünde bulundurmak önemlidir. En son ayrıntılar için her zaman resmi Azure AI hizmetleri fiyatlandırmasına bakın.

Test oluşturun

Bir test oluşturarak özel modelinizin doğruluğunu test edebilirsiniz. Test için ses dosyalarının bir koleksiyonu ve buna karşılık gelen transkripsiyonlar gerekir. Özel modelin doğruluğunu metin tabanlı modelle veya başka bir özel modelle konuşmayla karşılaştırabilirsiniz. Test sonuçlarını aldıktan sonra, konuşma tanıma sonuçlarına kıyasla hata oranı (WER) sözcüğünü değerlendirin.

Test oluşturmak için şu adımları izleyin:

Özel konuşma Projenizin adı> Test modelleri'ne tıklayın.>

Yeni test oluştur'u seçin.

Doğruluğu değerlendir'i>seçin.

Bir ses + insan etiketli transkripsiyon veri kümesi seçin ve ardından İleri'yi seçin. Kullanılabilir veri kümesi yoksa kurulumu iptal edin ve veri kümelerini karşıya yüklemek için Konuşma veri kümeleri menüsüne gidin.

Not

Modelinizde kullandığınızdan farklı bir akustik veri kümesi seçmek önemlidir. Bu yaklaşım, modelin performansı hakkında daha gerçekçi bir anlayış sağlayabilir.

Değerlendirilecek en fazla iki model seçin ve ardından İleri'yi seçin.

Test adını ve açıklamasını girin ve İleri'yi seçin.

Test ayrıntılarını gözden geçirin ve kaydet ve kapat'ı seçin.

Test oluşturmak için komutunu kullanın spx csr evaluation create . İstek parametrelerini aşağıdaki yönergelere göre oluşturun:

- parametresini

projectvar olan bir projenin kimliğine ayarlayın. Testi Speech Studio'da da görüntüleyebilmeniz için bu parametre önerilir. Kullanılabilir projeleri almak için komutunu çalıştırabilirsinizspx csr project list. - Gerekli

model1parametreyi test etmek istediğiniz modelin kimliğine ayarlayın. - Gerekli

model2parametreyi test etmek istediğiniz başka bir modelin kimliğine ayarlayın. İki modeli karşılaştırmak istemiyorsanız hem hem demodel1model2için aynı modeli kullanın. - Gerekli

datasetparametreyi test için kullanmak istediğiniz veri kümesinin kimliğine ayarlayın. - Parametresini

languageayarlayın, aksi takdirde Konuşma CLI'sı varsayılan olarak "en-US" değerini ayarlar. Bu parametre, veri kümesi içeriğinin yerel ayarı olmalıdır. Yerel ayar daha sonra değiştirilemez. Konuşma CLIlanguageparametresi, JSON isteğindeki ve yanıttaki özelliğine karşılık gelirlocale. - Gerekli

nameparametreyi ayarlayın. Bu parametre, Speech Studio'da görüntülenen addır. Konuşma CLInameparametresi, JSON isteğindeki ve yanıttaki özelliğine karşılık gelirdisplayName.

Aşağıda test oluşturan örnek bir Konuşma CLI komutu verilmişti:

spx csr evaluation create --api-version v3.1 --project 9f8c4cbb-f9a5-4ec1-8bb0-53cfa9221226 --dataset be378d9d-a9d7-4d4a-820a-e0432e8678c7 --model1 ff43e922-e3e6-4bf0-8473-55c08fd68048 --model2 1aae1070-7972-47e9-a977-87e3b05c457d --name "My Evaluation" --description "My Evaluation Description"

Aşağıdaki biçimde bir yanıt gövdesi almanız gerekir:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca",

"model1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/ff43e922-e3e6-4bf0-8473-55c08fd68048"

},

"model2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/1aae1070-7972-47e9-a977-87e3b05c457d"

},

"dataset": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/datasets/be378d9d-a9d7-4d4a-820a-e0432e8678c7"

},

"transcription2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/6eaf6a15-6076-466a-83d4-a30dba78ca63"

},

"transcription1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/0c5b1630-fadf-444d-827f-d6da9c0cf0c3"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/9f8c4cbb-f9a5-4ec1-8bb0-53cfa9221226"

},

"links": {

"files": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca/files"

},

"properties": {

"wordErrorRate2": -1.0,

"wordErrorRate1": -1.0,

"sentenceErrorRate2": -1.0,

"sentenceCount2": -1,

"wordCount2": -1,

"correctWordCount2": -1,

"wordSubstitutionCount2": -1,

"wordDeletionCount2": -1,

"wordInsertionCount2": -1,

"sentenceErrorRate1": -1.0,

"sentenceCount1": -1,

"wordCount1": -1,

"correctWordCount1": -1,

"wordSubstitutionCount1": -1,

"wordDeletionCount1": -1,

"wordInsertionCount1": -1

},

"lastActionDateTime": "2022-05-20T16:42:43Z",

"status": "NotStarted",

"createdDateTime": "2022-05-20T16:42:43Z",

"locale": "en-US",

"displayName": "My Evaluation",

"description": "My Evaluation Description"

}

Yanıt gövdesindeki en üst düzey self özellik, değerlendirmenin URI'dir. Proje ve test sonuçlarıyla ilgili ayrıntıları almak için bu URI'yi kullanın. Değerlendirmeyi güncelleştirmek veya silmek için de bu URI'yi kullanırsınız.

Değerlendirmelerle ilgili Konuşma CLI'sı yardımı için aşağıdaki komutu çalıştırın:

spx help csr evaluation

Test oluşturmak için Konuşmayı metne dönüştürme REST API'sinin Evaluations_Create işlemini kullanın. İstek gövdesini aşağıdaki yönergelere göre oluşturun:

projectözelliğini mevcut bir projenin URI'sine ayarlayın. Testi Speech Studio'da da görüntüleyebilmeniz için bu özellik önerilir. Kullanılabilir projeleri almak için Projects_List isteğinde bulunabilirsiniz.- özelliğini içinde

testingKindcustomPropertiesolarakEvaluationayarlayın. belirtmezsenizEvaluation, test bir kalite denetleme testi olarak değerlendirilir. ÖzelliğintestingKindolarak veya olarak ayarlanmasıEvaluationInspectionveya ayarlanmaması fark etmez, doğruluk puanlarına API aracılığıyla erişebilirsiniz, ancak Speech Studio'da erişemezsiniz. - Gerekli

model1özelliği test etmek istediğiniz modelin URI'sine ayarlayın. - Gerekli

model2özelliği test etmek istediğiniz başka bir modelin URI'sine ayarlayın. İki modeli karşılaştırmak istemiyorsanız hem hem demodel1model2için aynı modeli kullanın. - Gerekli

datasetözelliği test için kullanmak istediğiniz veri kümesinin URI'sine ayarlayın. - Gerekli

localeözelliği ayarlayın. Bu özellik, veri kümesi içeriğinin yerel ayarı olmalıdır. Yerel ayar daha sonra değiştirilemez. - Gerekli

displayNameözelliği ayarlayın. Bu özellik, Speech Studio'da görüntülenen addır.

Aşağıdaki örnekte gösterildiği gibi URI'yi kullanarak bir HTTP POST isteği oluşturun. değerini Konuşma kaynak anahtarınız ile değiştirin YourSubscriptionKey , değerini Konuşma kaynağı bölgenizle değiştirin YourServiceRegion ve istek gövdesi özelliklerini daha önce açıklandığı gibi ayarlayın.

curl -v -X POST -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey" -H "Content-Type: application/json" -d '{

"model1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/ff43e922-e3e6-4bf0-8473-55c08fd68048"

},

"model2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/1aae1070-7972-47e9-a977-87e3b05c457d"

},

"dataset": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/datasets/be378d9d-a9d7-4d4a-820a-e0432e8678c7"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/9f8c4cbb-f9a5-4ec1-8bb0-53cfa9221226"

},

"displayName": "My Evaluation",

"description": "My Evaluation Description",

"customProperties": {

"testingKind": "Evaluation"

},

"locale": "en-US"

}' "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations"

Aşağıdaki biçimde bir yanıt gövdesi almanız gerekir:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca",

"model1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/ff43e922-e3e6-4bf0-8473-55c08fd68048"

},

"model2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/1aae1070-7972-47e9-a977-87e3b05c457d"

},

"dataset": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/datasets/be378d9d-a9d7-4d4a-820a-e0432e8678c7"

},

"transcription2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/6eaf6a15-6076-466a-83d4-a30dba78ca63"

},

"transcription1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/0c5b1630-fadf-444d-827f-d6da9c0cf0c3"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/9f8c4cbb-f9a5-4ec1-8bb0-53cfa9221226"

},

"links": {

"files": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca/files"

},

"properties": {

"wordErrorRate2": -1.0,

"wordErrorRate1": -1.0,

"sentenceErrorRate2": -1.0,

"sentenceCount2": -1,

"wordCount2": -1,

"correctWordCount2": -1,

"wordSubstitutionCount2": -1,

"wordDeletionCount2": -1,

"wordInsertionCount2": -1,

"sentenceErrorRate1": -1.0,

"sentenceCount1": -1,

"wordCount1": -1,

"correctWordCount1": -1,

"wordSubstitutionCount1": -1,

"wordDeletionCount1": -1,

"wordInsertionCount1": -1

},

"lastActionDateTime": "2022-05-20T16:42:43Z",

"status": "NotStarted",

"createdDateTime": "2022-05-20T16:42:43Z",

"locale": "en-US",

"displayName": "My Evaluation",

"description": "My Evaluation Description",

"customProperties": {

"testingKind": "Evaluation"

}

}

Yanıt gövdesindeki en üst düzey self özellik, değerlendirmenin URI'dir. Değerlendirmenin projesi ve test sonuçlarıyla ilgili ayrıntıları almak için bu URI'yi kullanın. Değerlendirmeyi güncelleştirmek veya silmek için de bu URI'yi kullanırsınız.

Test sonuçlarını alma

Konuşma tanıma sonuçlarına kıyasla test sonuçlarını almanız ve hata oranı (WER) sözcüğünü değerlendirmeniz gerekir.

Test sonuçlarını almak için şu adımları izleyin:

- Speech Studio'da oturum açın.

- Özel konuşma Projenizin adı> Test modelleri'ne tıklayın.>

- Bağlantıyı test adına göre seçin.

- Test tamamlandıktan sonra, durumu Başarılı olarak ayarlandığında gösterildiği gibi, test edilen her model için WER numarasını içeren sonuçlar görmeniz gerekir.

Bu sayfada veri kümenizdeki tüm konuşmalar ve tanıma sonuçları, gönderilen veri kümesinden alınan transkripsiyon listelenir. Ekleme, silme ve değiştirme gibi çeşitli hata türlerini değiştirebilirsiniz. Sesi dinleyerek ve her sütundaki tanıma sonuçlarını karşılaştırarak, hangi modelin gereksinimlerinizi karşıladığına karar verebilir ve daha fazla eğitim ve geliştirmenin nerede gerekli olduğunu belirleyebilirsiniz.

Test sonuçlarını almak için komutunu kullanın spx csr evaluation status . İstek parametrelerini aşağıdaki yönergelere göre oluşturun:

- Gerekli

evaluationparametreyi, test sonuçlarını almak istediğiniz değerlendirmenin kimliğine ayarlayın.

Test sonuçlarını alan örnek bir Konuşma CLI komutu aşağıda verilmişti:

spx csr evaluation status --api-version v3.1 --evaluation 8bfe6b05-f093-4ab4-be7d-180374b751ca

Sözcük hata oranları ve diğer ayrıntılar yanıt gövdesinde döndürülür.

Aşağıdaki biçimde bir yanıt gövdesi almanız gerekir:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca",

"model1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/ff43e922-e3e6-4bf0-8473-55c08fd68048"

},

"model2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/1aae1070-7972-47e9-a977-87e3b05c457d"

},

"dataset": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/datasets/be378d9d-a9d7-4d4a-820a-e0432e8678c7"

},

"transcription2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/6eaf6a15-6076-466a-83d4-a30dba78ca63"

},

"transcription1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/0c5b1630-fadf-444d-827f-d6da9c0cf0c3"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/9f8c4cbb-f9a5-4ec1-8bb0-53cfa9221226"

},

"links": {

"files": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca/files"

},

"properties": {

"wordErrorRate2": 4.62,

"wordErrorRate1": 4.6,

"sentenceErrorRate2": 66.7,

"sentenceCount2": 3,

"wordCount2": 173,

"correctWordCount2": 166,

"wordSubstitutionCount2": 7,

"wordDeletionCount2": 0,

"wordInsertionCount2": 1,

"sentenceErrorRate1": 66.7,

"sentenceCount1": 3,

"wordCount1": 174,

"correctWordCount1": 166,

"wordSubstitutionCount1": 7,

"wordDeletionCount1": 1,

"wordInsertionCount1": 0

},

"lastActionDateTime": "2022-05-20T16:42:56Z",

"status": "Succeeded",

"createdDateTime": "2022-05-20T16:42:43Z",

"locale": "en-US",

"displayName": "My Evaluation",

"description": "My Evaluation Description",

"customProperties": {

"testingKind": "Evaluation"

}

}

Değerlendirmelerle ilgili Konuşma CLI'sı yardımı için aşağıdaki komutu çalıştırın:

spx help csr evaluation

Test sonuçlarını almak için konuşmayı metne dönüştürme REST API'sinin Evaluations_Get işlemini kullanarak başlayın.

Aşağıdaki örnekte gösterildiği gibi URI'yi kullanarak bir HTTP GET isteği oluşturun. değerini YourEvaluationId değerlendirme kimliğiniz ile değiştirin, değerini YourSubscriptionKey Konuşma kaynak anahtarınızla değiştirin ve yerine YourServiceRegion Konuşma kaynak bölgenizi yazın.

curl -v -X GET "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/YourEvaluationId" -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey"

Sözcük hata oranları ve diğer ayrıntılar yanıt gövdesinde döndürülür.

Aşağıdaki biçimde bir yanıt gövdesi almanız gerekir:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca",

"model1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/ff43e922-e3e6-4bf0-8473-55c08fd68048"

},

"model2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/1aae1070-7972-47e9-a977-87e3b05c457d"

},

"dataset": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/datasets/be378d9d-a9d7-4d4a-820a-e0432e8678c7"

},

"transcription2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/6eaf6a15-6076-466a-83d4-a30dba78ca63"

},

"transcription1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/0c5b1630-fadf-444d-827f-d6da9c0cf0c3"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/9f8c4cbb-f9a5-4ec1-8bb0-53cfa9221226"

},

"links": {

"files": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca/files"

},

"properties": {

"wordErrorRate2": 4.62,

"wordErrorRate1": 4.6,

"sentenceErrorRate2": 66.7,

"sentenceCount2": 3,

"wordCount2": 173,

"correctWordCount2": 166,

"wordSubstitutionCount2": 7,

"wordDeletionCount2": 0,

"wordInsertionCount2": 1,

"sentenceErrorRate1": 66.7,

"sentenceCount1": 3,

"wordCount1": 174,

"correctWordCount1": 166,

"wordSubstitutionCount1": 7,

"wordDeletionCount1": 1,

"wordInsertionCount1": 0

},

"lastActionDateTime": "2022-05-20T16:42:56Z",

"status": "Succeeded",

"createdDateTime": "2022-05-20T16:42:43Z",

"locale": "en-US",

"displayName": "My Evaluation",

"description": "My Evaluation Description",

"customProperties": {

"testingKind": "Evaluation"

}

}

Sözcük hata oranını değerlendirme (WER)

Model doğruluğunu ölçmek için endüstri standardı sözcük hata oranıdır (WER). WER, tanıma sırasında tanımlanan yanlış sözcük sayısını sayar ve toplamı insan etiketli transkriptte (N) sağlanan toplam sözcük sayısına böler.

Yanlış tanımlanmış sözcükler üç kategoriye ayrılır:

- Ekleme (I): Hipotez transkriptine yanlış eklenen sözcükler

- Silme (D): Hipotez transkriptinde algılanmayan sözcükler

- Değiştirme (S): Başvuru ve hipotez arasında değiştirilen sözcükler

Speech Studio'da bölüm 100 ile çarpılır ve yüzde olarak gösterilir. Konuşma CLI'sı ve REST API sonuçları 100 ile çarpılamaz.

$$ WER = {{I+D+S} N}\over\times 100 $$

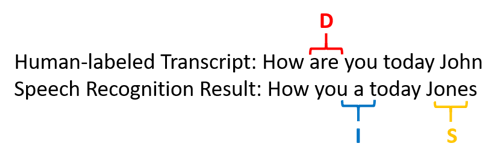

aşağıda, insan etiketli transkriptle karşılaştırıldığında yanlış tanımlanmış sözcükleri gösteren bir örnek verilmiştir:

Konuşma tanıma sonucu aşağıdaki gibi hatalı:

- Ekleme (I): "a" sözcüğü eklendi

- Silme (D): "are" sözcüğü silindi

- Değiştirme (S): "John" yerine "Jones" sözcüğünü yazın

Önceki örnekteki hata oranı sözcüğü %60'tır.

WER ölçümlerini yerel olarak çoğaltmak istiyorsanız NIST Puanlama Araç Seti'nden (SCTK) sclite aracını kullanabilirsiniz.

Hataları çözme ve WER'ı geliştirme

Uygulama, araç veya ürününüzle kullandığınız modelin kalitesini değerlendirmek için makine tanıma sonuçlarından WER hesaplamasını kullanabilirsiniz. % 5-10'lık bir WER iyi kalite olarak kabul edilir ve kullanıma hazırdır. %20'lik bir WER kabul edilebilir, ancak daha fazla eğitim almayı düşünebilirsiniz. %30 veya daha fazla WER düşük kaliteye işaret eder ve özelleştirme ve eğitim gerektirir.

Hataların nasıl dağıtıldığı önemlidir. Birçok silme hatasıyla karşılaşıldığında, bunun nedeni genellikle ses sinyalinin zayıf olmasıdır. Bu sorunu çözmek için ses verilerini kaynağa daha yakın bir şekilde toplamanız gerekir. Ekleme hataları, sesin gürültülü bir ortamda kaydedildiğini ve çapraz konuşmanın mevcut olabileceği ve tanıma sorunlarına neden olabileceği anlamına gelir. Değiştirme hataları genellikle etki alanına özgü terimlerin yetersiz bir örneği insan etiketli transkripsiyonlar veya ilgili metin olarak sağlandığında oluşur.

Tek tek dosyaları analiz ederek, hangi tür hataların mevcut olduğunu ve belirli bir dosyaya özgü hataları belirleyebilirsiniz. Dosya düzeyindeki sorunları anlamak, iyileştirmeleri hedeflemenize yardımcı olur.

Belirteç hata oranını değerlendirme (TER)

Sözcük hata oranının yanı sıra, kaliteyi son uçtan uca görüntüleme biçiminde değerlendirmek için Belirteç Hata Oranı'nın (TER) genişletilmiş ölçümlerini de kullanabilirsiniz. sözcük biçimine (That will cost $900. yerine that will cost nine hundred dollars) ek olarak, TER noktalama, büyük harfe çevirme ve ITN gibi görüntü biçimi yönlerini de dikkate alır. Konuşmayı metne dönüştürerek çıktı biçimlendirmesini görüntüleme hakkında daha fazla bilgi edinin.

TER, tanıma sırasında tanımlanan yanlış belirteç sayısını sayar ve toplamı insan etiketli transkriptte (N) sağlanan toplam belirteç sayısına böler.

$$ TER = {{I+D+S} N}\over\times 100 $$

TER hesaplama formülü WER'ye de benzer. Tek fark, TER'nin sözcük düzeyi yerine belirteç düzeyine göre hesaplanmış olmasıdır.

- Ekleme (I): Hipotez transkriptine yanlış eklenen belirteçler

- Silme (D): Hipotez transkriptinde algılanmayan belirteçler

- Değiştirme (S): Başvuru ve hipotez arasında değiştirilen belirteçler

Gerçek dünyada istenen iyileştirmeleri elde etmek için hem WER hem de TER sonuçlarını analiz edebilirsiniz.

Not

TER'yi ölçmek için ses + transkript testi verilerinin noktalama, büyük harfe çevirme ve ITN gibi görüntüleme biçimlendirmesine sahip transkriptler içerdiğinden emin olmanız gerekir.

Örnek senaryo sonuçları

Konuşma tanıma senaryoları ses kalitesine ve dile (sözlük ve konuşma stili) göre farklılık gösterir. Aşağıdaki tabloda dört yaygın senaryo incelendi:

| Senaryo | Ses kalitesi | Kelime | Konuşma stili |

|---|---|---|---|

| Çağrı merkezi | Düşük, 8 kHz, bir ses kanalında iki kişi olabilir, sıkıştırılabilir | Dar, etki alanına ve ürünlere özgü | Konuşma, gevşek yapılandırılmış |

| Cortana gibi sesli yardımcı veya sürüş penceresi | Yüksek, 16 kHz | Varlık ağırlıklı (şarkı adları, ürünler, konumlar) | Açıkça belirtilmiş sözcükler ve tümcecikler |

| Dikte (anlık ileti, notlar, arama) | Yüksek, 16 kHz | Çeşitli | Not alma |

| Video kapalı başlık | Çeşitli mikrofon kullanımı dahil olmak üzere çeşitli müzikler eklendi | Çeşitli, toplantılar, okunan konuşma, müzik şarkı sözleri | Okuma, hazırlama veya gevşek bir şekilde yapılandırılmış |

Farklı senaryolar farklı kalite sonuçları üretir. Aşağıdaki tabloda, WER'deki bu dört senaryonun içeriğinin oranı incelendi. Tabloda, her senaryoda en yaygın olan hata türleri gösterilmektedir. Ekleme, değiştirme ve silme hata oranları, modeli geliştirmek için ne tür veriler ekleneceğini belirlemenize yardımcı olur.

| Senaryo | Konuşma tanıma kalitesi | Ekleme hataları | Silme işlemi hataları | Değiştirme hataları |

|---|---|---|---|---|

| Çağrı merkezi | Orta (< %30 WER) |

Diğer kişilerin arka planda konuşmaları dışında düşük | Yüksek olabilir. Çağrı merkezleri gürültülü olabilir ve çakışan hoparlörler modeli karıştırabilir | Orta. Ürünler ve kişilerin adları bu hatalara neden olabilir |

| Sesli yardımcı | Yüksek (%10 WER olabilir < ) |

Düşük | Düşük | Orta, şarkı adları, ürün adları veya konumlar nedeniyle |

| Dikte | Yüksek (%10 WER olabilir < ) |

Düşük | Düşük | Yüksek |

| Video kapalı başlık | Video türüne bağlıdır (%50 WER olabilir < ) | Düşük | Müzik, gürültü, mikrofon kalitesi nedeniyle yüksek olabilir | Jargon bu hatalara neden olabilir |