Archivované poznámky k verzi

Shrnutí

Azure HDInsight je jednou z nejoblíbenějších služeb mezi podnikovými zákazníky pro opensourcové analýzy v Azure. Přihlaste se k odběru poznámek k verzi SLUŽBY HDInsight, kde najdete aktuální informace o HDInsightu a všech verzích HDInsight.

Pokud se chcete přihlásit k odběru, klikněte na tlačítko "kukátku" v banneru a podívejte se na vydané verze HDInsight.

Informace o vydání

Datum vydání: 15. února 2024

Tato verze platí pro verze HDInsight 4.x a 5.x. Verze HDInsight bude dostupná pro všechny oblasti za několik dní. Tato verze se vztahuje na číslo obrázku 2401250802. Jak zkontrolovat číslo image?

HDInsight používá postupy bezpečného nasazení, které zahrnují postupné nasazování oblastí. Může trvat až 10 pracovních dnů, než bude nová verze nebo nová verze dostupná ve všech oblastech.

Verze operačního systému

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Poznámka:

Ubuntu 18.04 je podporováno v rámci rozšířené údržby zabezpečení (ESM) týmu Azure Linuxu pro Azure HDInsight z července 2023.

Informace o konkrétních verzích úloh najdete v tématu

Nové funkce

- Podpora Apache Rangeru pro Spark SQL ve Sparku 3.3.0 (HDInsight verze 5.1) s balíčkem zabezpečení Enterprise Další informace najdete tady.

Opravené problémy

- Opravy zabezpečení z komponent Ambari a Oozie

Již brzy

Již brzy

- Vyřazení virtuálníchpočítačůch

- 31. srpna 2024 vyřadíme virtuální počítače Basic a Standard A-series. Před tímto datem je potřeba migrovat úlohy na virtuální počítače řady Av2, které poskytují více paměti na virtuální procesor a rychlejší úložiště na jednotkách SSD (Solid-State Drive).

- Abyste se vyhnuli přerušení služeb, migrujte úlohy z virtuálních počítačů Basic a Standard A-Series na virtuální počítače řady Av2 před 31. srpnem 2024.

Pokud máte další dotazy, obraťte se na podporu Azure.

Kdykoli se nás můžete zeptat na HDInsight ve službě Azure HDInsight – Microsoft Q&A

Nasloucháme: Zde můžete přidat další nápady a další témata a hlasovat pro ně – NÁVRHY HDInsight a sledovat nás o dalších aktualizacích v komunitě AzureHDInsight

Poznámka:

Doporučujeme zákazníkům používat nejnovější verze imagí HDInsight, protože přinášejí nejlepší open source aktualizace, aktualizace Azure a opravy zabezpečení. Další informace najdete v tématu Osvědčené postupy.

Další kroky

- Azure HDInsight: Nejčastější dotazy

- Konfigurace plánu oprav operačního systému pro clustery HDInsight se systémem Linux

- Předchozí zpráva k vydání verze

Azure HDInsight je jednou z nejoblíbenějších služeb mezi podnikovými zákazníky pro opensourcové analýzy v Azure. Pokud se chcete přihlásit k odběru poznámek k verzi, podívejte se na vydané verze v tomto úložišti GitHubu.

Datum vydání: 10. ledna 2024

Tato verze opravy hotfix se vztahuje na verze HDInsight 4.x a 5.x. Verze HDInsight bude dostupná pro všechny oblasti za několik dní. Tato verze se vztahuje na číslo obrázku 2401030422. Jak zkontrolovat číslo image?

HDInsight používá postupy bezpečného nasazení, které zahrnují postupné nasazování oblastí. Může trvat až 10 pracovních dnů, než bude nová verze nebo nová verze dostupná ve všech oblastech.

Verze operačního systému

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Poznámka:

Ubuntu 18.04 je podporováno v rámci rozšířené údržby zabezpečení (ESM) týmu Azure Linuxu pro Azure HDInsight z července 2023.

Informace o konkrétních verzích úloh najdete v tématu

Opravené problémy

- Opravy zabezpečení z komponent Ambari a Oozie

Již brzy

Již brzy

- Vyřazení virtuálníchpočítačůch

- 31. srpna 2024 vyřadíme virtuální počítače Basic a Standard A-series. Před tímto datem je potřeba migrovat úlohy na virtuální počítače řady Av2, které poskytují více paměti na virtuální procesor a rychlejší úložiště na jednotkách SSD (Solid-State Drive).

- Abyste se vyhnuli přerušení služeb, migrujte úlohy z virtuálních počítačů Basic a Standard A-Series na virtuální počítače řady Av2 před 31. srpnem 2024.

Pokud máte další dotazy, obraťte se na podporu Azure.

Kdykoli se nás můžete zeptat na HDInsight ve službě Azure HDInsight – Microsoft Q&A

Nasloucháme: Zde můžete přidat další nápady a další témata a hlasovat pro ně – NÁVRHY HDInsight a sledovat nás o dalších aktualizacích v komunitě AzureHDInsight

Poznámka:

Doporučujeme zákazníkům používat nejnovější verze imagí HDInsight, protože přinášejí nejlepší open source aktualizace, aktualizace Azure a opravy zabezpečení. Další informace najdete v tématu Osvědčené postupy.

Datum vydání: 26. října 2023

Tato verze platí pro verzi HDInsight 4.x a 5.x HDInsight, která bude dostupná pro všechny oblasti za několik dnů. Tato verze se vztahuje na číslo obrázku 2310140056. Jak zkontrolovat číslo image?

HDInsight používá postupy bezpečného nasazení, které zahrnují postupné nasazování oblastí. Může trvat až 10 pracovních dnů, než bude nová verze nebo nová verze dostupná ve všech oblastech.

Verze operačního systému

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Informace o konkrétních verzích úloh najdete v tématu

Co je nového

HDInsight oznamuje obecnou dostupnost SLUŽBY HDInsight 5.1 od 1. listopadu 2023. Tato verze přináší úplnou aktualizaci zásobníku do opensourcových komponent a integrací od Microsoftu.

- Nejnovější opensourcové verze – HDInsight 5.1 je k dispozici nejnovější stabilní opensourcová verze . Zákazníci můžou využívat všechny nejnovější opensourcové funkce, vylepšení výkonu Microsoftu a opravy chyb.

- Zabezpečení – Nejnovější verze mají nejnovější opravy zabezpečení, a to jak opravy opensourcového zabezpečení, tak vylepšení zabezpečení od Microsoftu.

- Nižší náklady na vlastnictví – Díky vylepšením výkonu můžou zákazníci snížit provozní náklady spolu s vylepšeným automatickým škálováním.

Oprávnění clusteru pro zabezpečené úložiště

- Zákazníci můžou zadat (během vytváření clusteru), jestli se má pro uzly clusteru HDInsight použít zabezpečený kanál pro připojení účtu úložiště.

Vytvoření clusteru HDInsight s vlastními virtuálními sítěmi

- Aby se zlepšil celkový stav zabezpečení clusterů HDInsight, musí clustery HDInsight pomocí vlastních virtuálních sítí zajistit, aby uživatel musel mít oprávnění k

Microsoft Network/virtualNetworks/subnets/join/actionprovádění operací vytváření. Zákazník může čelit selháním vytváření, pokud tato kontrola není povolená.

- Aby se zlepšil celkový stav zabezpečení clusterů HDInsight, musí clustery HDInsight pomocí vlastních virtuálních sítí zajistit, aby uživatel musel mít oprávnění k

Clustery ABFS jiného než ESP [Oprávnění clusteru pro čitelný soubor Word]

- Clustery ABFS mimo ESP omezují uživatele skupin bez Hadoopu spouštění příkazů Systému Hadoop pro operace úložiště. Tato změna zlepšuje stav zabezpečení clusteru.

Aktualizace v souladu s kvótou

- Teď můžete požádat o navýšení kvóty přímo ze stránky Moje kvóta a přímé volání rozhraní API je mnohem rychlejší. V případě selhání volání rozhraní API můžete vytvořit novou žádost o podporu pro navýšení kvóty.

Již brzy

Již brzy

Maximální délka názvu clusteru se změní na 45 z 59 znaků, aby se zlepšil stav zabezpečení clusterů. Tato změna se nasadí do všech oblastí, které se budou spouštět v nadcházející verzi.

Vyřazení virtuálníchpočítačůch

- 31. srpna 2024 vyřadíme virtuální počítače basicu a řady Standard A-series. Před tímto datem je potřeba migrovat úlohy na virtuální počítače řady Av2, které poskytují více paměti na virtuální procesor a rychlejší úložiště na jednotkách SSD (Solid-State Drive).

- Abyste se vyhnuli přerušení služeb, migrujte úlohy z virtuálních počítačů Basic a Standard A-Series na virtuální počítače řady Av2 před 31. srpnem 2024.

Pokud máte další dotazy, obraťte se na podporu Azure.

Kdykoli se nás můžete zeptat na HDInsight ve službě Azure HDInsight – Microsoft Q&A

Nasloucháme: Zde můžete přidat další nápady a další témata a hlasovat pro ně – NÁVRHY HDInsight a sledovat nás o dalších aktualizacích v komunitě AzureHDInsight

Poznámka:

Tato verze řeší následující CVE vydané msRC 12. září 2023. Akce je aktualizovat na nejnovější image 2308221128 nebo 2310140056. Zákazníkům se doporučuje, aby plánovali odpovídajícím způsobem.

| CVE | Závažnost | Název CVE | Poznámka |

|---|---|---|---|

| CVE-2023-38156 | Důležité | Ohrožení zabezpečení spočívající ve zvýšení oprávnění v Azure HDInsight Apache Ambari | Součástí image 2308221128 nebo 2310140056 |

| CVE-2023-36419 | Důležité | Ohrožení zabezpečení kvůli zvýšenému oprávnění plánovače pracovního postupu Azure HDInsight Apache Oozie | Použijte akci Skript na clusterech nebo proveďte aktualizaci na image 2310140056 |

Poznámka:

Doporučujeme zákazníkům používat nejnovější verze imagí HDInsight, protože přinášejí nejlepší open source aktualizace, aktualizace Azure a opravy zabezpečení. Další informace najdete v tématu Osvědčené postupy.

Datum vydání: 7. září 2023

Tato verze platí pro verzi HDInsight 4.x a 5.x HDInsight, která bude dostupná pro všechny oblasti za několik dnů. Tato verze se vztahuje na číslo image 2308221128. Jak zkontrolovat číslo image?

HDInsight používá postupy bezpečného nasazení, které zahrnují postupné nasazování oblastí. Může trvat až 10 pracovních dnů, než bude nová verze nebo nová verze dostupná ve všech oblastech.

Verze operačního systému

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Informace o konkrétních verzích úloh najdete v tématu

Důležité

Tato verze řeší následující CVE vydané msRC 12. září 2023. Akce je aktualizovat na nejnovější image 2308221128. Zákazníkům se doporučuje, aby plánovali odpovídajícím způsobem.

| CVE | Závažnost | Název CVE | Poznámka |

|---|---|---|---|

| CVE-2023-38156 | Důležité | Ohrožení zabezpečení spočívající ve zvýšení oprávnění v Azure HDInsight Apache Ambari | Obrázek zahrnutý v 2308221128 |

| CVE-2023-36419 | Důležité | Ohrožení zabezpečení kvůli zvýšenému oprávnění plánovače pracovního postupu Azure HDInsight Apache Oozie | Použití akce skriptů v clusterech |

Již brzy

- Maximální délka názvu clusteru se změní na 45 z 59 znaků, aby se zlepšil stav zabezpečení clusterů. Tato změna bude implementována do 30. září 2023.

- Oprávnění clusteru pro zabezpečené úložiště

- Zákazníci můžou zadat (během vytváření clusteru), jestli se má pro uzly clusteru HDInsight použít zabezpečený kanál pro kontaktování účtu úložiště.

- Aktualizace v souladu s kvótou

- Kvóty požadavků se zvyšují přímo ze stránky Moje kvóta, což bude přímé volání rozhraní API, což je rychlejší. Pokud volání APdI selže, zákazníci musí vytvořit novou žádost o podporu pro navýšení kvóty.

- Vytvoření clusteru HDInsight s vlastními virtuálními sítěmi

- Aby se zlepšil celkový stav zabezpečení clusterů HDInsight, musí clustery HDInsight pomocí vlastních virtuálních sítí zajistit, aby uživatel musel mít oprávnění k

Microsoft Network/virtualNetworks/subnets/join/actionprovádění operací vytváření. Zákazníci by museli odpovídajícím způsobem plánovat, protože tato změna by byla povinná kontrola, aby se zabránilo selháním vytváření clusterů před 30. zářím 2023.

- Aby se zlepšil celkový stav zabezpečení clusterů HDInsight, musí clustery HDInsight pomocí vlastních virtuálních sítí zajistit, aby uživatel musel mít oprávnění k

- Vyřazení virtuálníchpočítačůch

- 31. srpna 2024 vyřadíme virtuální počítače Basic a Standard A-series. Před tímto datem je potřeba migrovat úlohy na virtuální počítače řady Av2, které poskytují více paměti na virtuální procesor a rychlejší úložiště na jednotkách SSD (Solid-State Drive). Abyste se vyhnuli přerušení služeb, migrujte úlohy z virtuálních počítačů Basic a Standard A-Series na virtuální počítače řady Av2 před 31. srpnem 2024.

- Clustery ABFS jiného než ESP [Oprávnění clusteru pro čitelné aplikace Word]

- Plánte zavést změnu v clusterech ABFS mimo ESP, což omezuje uživatele skupin, kteří nejsou hadoopem, aby spouštěli příkazy Hadoopu pro operace úložiště. Touto změnou zlepšíte stav zabezpečení clusteru. Zákazníci musí naplánovat aktualizace před 30. zářím 2023.

Pokud máte další dotazy, obraťte se na podporu Azure.

Kdykoli se nás můžete zeptat na HDInsight ve službě Azure HDInsight – Microsoft Q&A

Zde můžete přidat další návrhy a nápady a další témata a hlasovat pro ně – komunita HDInsight (azure.com).

Poznámka:

Doporučujeme zákazníkům používat nejnovější verze imagí HDInsight, protože přinášejí nejlepší open source aktualizace, aktualizace Azure a opravy zabezpečení. Další informace najdete v tématu Osvědčené postupy.

Datum vydání: 25. července 2023

Tato verze platí pro verzi HDInsight 4.x a 5.x HDInsight, která bude dostupná pro všechny oblasti za několik dnů. Tato verze se vztahuje na číslo obrázku 2307201242. Jak zkontrolovat číslo image?

HDInsight používá postupy bezpečného nasazení, které zahrnují postupné nasazování oblastí. Může trvat až 10 pracovních dnů, než bude nová verze nebo nová verze dostupná ve všech oblastech.

Verze operačního systému

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Informace o konkrétních verzích úloh najdete v tématu

Co je nového

Co je nového

- Cluster ESP teď podporuje HDInsight 5.1.

- Upgradovaná verze Ranger 2.3.0 a Oozie 5.2.1 jsou nyní součástí HDInsight 5.1.

- Cluster Spark 3.3.1 (HDInsight 5.1) se dodává s clusterem Hive Warehouse Připojení or (HWC) 2.1, který spolupracuje s clusterem Interactive Query (HDInsight 5.1).

- Ubuntu 18.04 je podporováno v rámci ESM (Rozšířená údržba zabezpečení) týmem Azure Linux pro Azure HDInsight z července 2023.

Důležité

Tato verze řeší následující CVE vydané msRC 8. srpna 2023. Akce je aktualizovat na nejnovější image 2307201242. Zákazníkům se doporučuje, aby plánovali odpovídajícím způsobem.

| CVE | Závažnost | Název CVE |

|---|---|---|

| CVE-2023-35393 | Důležité | Ohrožení zabezpečení z hlediska falšování identity v Azure Apache Hivu |

| CVE-2023-35394 | Důležité | Ohrožení zabezpečení z hlediska falšování identity ve službě Azure HDInsight Jupyter Notebook |

| CVE-2023-36877 | Důležité | Ohrožení zabezpečení z hlediska falšování identity v Azure Apache Oozie |

| CVE-2023-36881 | Důležité | Ohrožení zabezpečení z hlediska falšování identity v Azure Apache Ambari |

| CVE-2023-38188 | Důležité | Ohrožení zabezpečení z hlediska falšování identity v Azure Apache Hadoop |

Již brzy

Již brzy

- Maximální délka názvu clusteru se změní na 45 z 59 znaků, aby se zlepšil stav zabezpečení clusterů. Zákazníci musí naplánovat aktualizace před 30. zářím 2023.

- Oprávnění clusteru pro zabezpečené úložiště

- Zákazníci můžou zadat (během vytváření clusteru), jestli se má pro uzly clusteru HDInsight použít zabezpečený kanál pro kontaktování účtu úložiště.

- Aktualizace v souladu s kvótou

- Kvóty požadavků se zvyšují přímo ze stránky Moje kvóta, což bude přímé volání rozhraní API, což je rychlejší. Pokud volání rozhraní API selže, zákazníci musí vytvořit novou žádost o podporu pro navýšení kvóty.

- Vytvoření clusteru HDInsight s vlastními virtuálními sítěmi

- Aby se zlepšil celkový stav zabezpečení clusterů HDInsight, musí clustery HDInsight pomocí vlastních virtuálních sítí zajistit, aby uživatel musel mít oprávnění k

Microsoft Network/virtualNetworks/subnets/join/actionprovádění operací vytváření. Zákazníci by museli odpovídajícím způsobem plánovat, protože tato změna by byla povinná kontrola, aby se zabránilo selháním vytváření clusterů před 30. zářím 2023.

- Aby se zlepšil celkový stav zabezpečení clusterů HDInsight, musí clustery HDInsight pomocí vlastních virtuálních sítí zajistit, aby uživatel musel mít oprávnění k

- Vyřazení virtuálníchpočítačůch

- 31. srpna 2024 vyřadíme virtuální počítače Basic a Standard A-series. Před tímto datem je potřeba migrovat úlohy na virtuální počítače řady Av2, které poskytují více paměti na virtuální procesor a rychlejší úložiště na jednotkách SSD (Solid-State Drive). Abyste se vyhnuli přerušení služeb, migrujte úlohy z virtuálních počítačů Basic a Standard A-series na virtuální počítače řady Av2 do 31. srpna 2024.

- Clustery ABFS jiného než ESP [Oprávnění clusteru pro čitelné aplikace Word]

- Plánte zavést změnu v clusterech ABFS mimo ESP, což omezuje uživatele skupin, kteří nejsou hadoopem, aby spouštěli příkazy Hadoopu pro operace úložiště. Touto změnou zlepšíte stav zabezpečení clusteru. Zákazníci musí naplánovat aktualizace před 30. zářím 2023.

Pokud máte další dotazy, obraťte se na podporu Azure.

Kdykoli se nás můžete zeptat na HDInsight ve službě Azure HDInsight – Microsoft Q&A

Můžete zde přidat další návrhy a nápady a další témata a hlasovat pro ně - HDInsight Community (azure.com) a sledovat nás o dalších aktualizacích na Twitteru

Poznámka:

Doporučujeme zákazníkům používat nejnovější verze imagí HDInsight, protože přinášejí nejlepší open source aktualizace, aktualizace Azure a opravy zabezpečení. Další informace najdete v tématu Osvědčené postupy.

Datum vydání: 8. května 2023

Tato verze se vztahuje na verzi HDInsight 4.x a 5.x HDInsight je dostupná pro všechny oblasti za několik dnů. Tato verze se vztahuje na číslo obrázku 2304280205. Jak zkontrolovat číslo image?

HDInsight používá postupy bezpečného nasazení, které zahrnují postupné nasazování oblastí. Může trvat až 10 pracovních dnů, než bude nová verze nebo nová verze dostupná ve všech oblastech.

Verze operačního systému

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Informace o konkrétních verzích úloh najdete v tématu

![]()

Aktualizace Azure HDInsight 5.1 pomocí

- Apache HBase 2.4.11

- Apache Phoenix 5.1.2

- Apache Hive 3.1.2

- Apache Spark 3.3.1

- Apache Tez 0.9.1

- Apache Zeppelin 0.10.1

- Apache Livy 0.5

- Apache Kafka 3.2.0

Poznámka:

- Všechny komponenty jsou integrovány s Hadoop 3.3.4 a ZK 3.6.3

- Všechny výše upgradované komponenty jsou nyní k dispozici v clusterech mimo ESP pro verzi Public Preview.

![]()

Vylepšené automatické škálování pro HDInsight

Azure HDInsight provedl významné vylepšení stability a latence automatického škálování. Mezi zásadní změny patří vylepšená smyčka zpětné vazby pro rozhodování o škálování, významné zlepšení latence škálování a podpora opětovného uvedení vyřazených uzlů do provozu, další informace o vylepšeních, o vlastních konfiguracích a migraci clusteru na vylepšené automatické škálování. Vylepšené možnosti automatického škálování jsou dostupné 17. května 2023 ve všech podporovaných oblastech.

Azure HDInsight ESP pro Apache Kafka 2.4.1 je teď obecně dostupný.

Azure HDInsight ESP pro Apache Kafka 2.4.1 je ve verzi Public Preview od dubna 2022. Po důležitá vylepšení oprav a stability CVE se teď azure HDInsight ESP Kafka 2.4.1 stává obecně dostupným a připraveným pro produkční úlohy, přečtěte si podrobnosti o konfiguraci a migraci.

Správa kvót pro HDInsight

HDInsight v současné době přiděluje kvótu zákaznickým předplatným na regionální úrovni. Jádra přidělená zákazníkům jsou obecná a nejsou klasifikována na úrovni rodiny virtuálních počítačů (například

Dv2,Ev3, atdEav4.).SLUŽBA HDInsight zavedla vylepšené zobrazení, které poskytuje podrobné a klasifikační kvóty pro virtuální počítače na úrovni rodiny. Tato funkce umožňuje zákazníkům zobrazit aktuální a zbývající kvóty pro oblast na úrovni rodiny virtuálních počítačů. Díky vylepšenému zobrazení mají zákazníci lepší viditelnost, pro plánování kvót a lepší uživatelské prostředí. Tato funkce je aktuálně dostupná ve službě HDInsight 4.x a 5.x pro oblast EUAP usa – východ. Další oblasti, které chcete sledovat později.

Další informace najdete v tématu Plánování kapacity clusteru ve službě Azure HDInsight | Microsoft Learn

![]()

- Střední Polsko

- Maximální délka názvu clusteru se změní na 45 z 59 znaků, aby se zlepšil stav zabezpečení clusterů.

- Oprávnění clusteru pro zabezpečené úložiště

- Zákazníci můžou zadat (během vytváření clusteru), jestli se má pro uzly clusteru HDInsight použít zabezpečený kanál pro kontaktování účtu úložiště.

- Aktualizace v souladu s kvótou

- Kvóty požadavků se zvyšují přímo ze stránky Moje kvóta, což je přímé volání rozhraní API, což je rychlejší. Pokud volání rozhraní API selže, zákazníci musí vytvořit novou žádost o podporu pro navýšení kvóty.

- Vytvoření clusteru HDInsight s vlastními virtuálními sítěmi

- Aby se zlepšil celkový stav zabezpečení clusterů HDInsight, musí clustery HDInsight pomocí vlastních virtuálních sítí zajistit, aby uživatel musel mít oprávnění k

Microsoft Network/virtualNetworks/subnets/join/actionprovádění operací vytváření. Zákazníci by museli odpovídajícím způsobem plánovat, protože by to byla povinná kontrola, aby se zabránilo selháním vytváření clusteru.

- Aby se zlepšil celkový stav zabezpečení clusterů HDInsight, musí clustery HDInsight pomocí vlastních virtuálních sítí zajistit, aby uživatel musel mít oprávnění k

- Vyřazení virtuálníchpočítačůch

- 31. srpna 2024 vyřadíme virtuální počítače Basic a Standard A-series. Před tímto datem je potřeba migrovat úlohy na virtuální počítače řady Av2, které poskytují více paměti na virtuální procesor a rychlejší úložiště na jednotkách SSD (Solid-State Drive). Abyste se vyhnuli přerušení služeb, migrujte úlohy z virtuálních počítačů Basic a Standard A-Series na virtuální počítače řady Av2 do 31. srpna 2024.

- Clustery ABFS bez ESP [Oprávnění clusteru pro svět čitelný]

- Plánte zavést změnu v clusterech ABFS mimo ESP, což omezuje uživatele skupin, kteří nejsou hadoopem, aby spouštěli příkazy Hadoopu pro operace úložiště. Touto změnou zlepšíte stav zabezpečení clusteru. Zákazníci musí naplánovat aktualizace.

Datum vydání: 28. února 2023

Tato verze platí pro HDInsight 4.0. a 5.0, 5.1. Verze HDInsight je dostupná pro všechny oblasti za několik dní. Tato verze se vztahuje na číslo obrázku 2302250400. Jak zkontrolovat číslo image?

HDInsight používá postupy bezpečného nasazení, které zahrnují postupné nasazování oblastí. Může trvat až 10 pracovních dnů, než bude nová verze nebo nová verze dostupná ve všech oblastech.

Verze operačního systému

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Informace o konkrétních verzích úloh najdete v tématu

Důležité

Společnost Microsoft vydala CVE-2023-23408, která je opravena v aktuální verzi a zákazníkům doporučujeme upgradovat clustery na nejnovější image.

![]()

HDInsight 5.1

Začali jsme zavádět novou verzi HDInsight 5.1. Všechny nové opensourcové verze přidané jako přírůstkové verze ve službě HDInsight 5.1.

Další informace najdete ve verzi HDInsight 5.1.0.

![]()

Upgrade Kafka 3.2.0 (Preview)

- Kafka 3.2.0 obsahuje několik důležitých nových funkcí a vylepšení.

- Upgrade zookeeperu na verzi 3.6.3

- Podpora Toky Kafka

- Silnější záruky doručování pro producenta Kafka povoleného ve výchozím nastavení.

log4j1.x nahrazeno znakemreload4j.- Odešlete nápovědu vedoucímu oddílu, aby se oddíl obnovil.

JoinGroupRequestaLeaveGroupRequestmáte důvod.- Přidání metrik počtu zprostředkovatelů8

- Vylepšení zrcadla

Maker2.

Upgrade HBase 2.4.11 (Preview)

- Tato verze obsahuje nové funkce, jako je přidání nových typů mechanismu ukládání do mezipaměti pro blokovou mezipaměť, možnost měnit

hbase:meta tablea zobrazithbase:metatabulku z webového uživatelského rozhraní HBase.

Upgrade Phoenix 5.1.2 (Preview)

- Phoenix verze byla v této verzi upgradována na verzi 5.1.2. Tento upgrade zahrnuje Phoenix Query Server. Proxy serveru Phoenix Query Server poskytuje standardní ovladač Phoenix JDBC a poskytuje zpětně kompatibilní wire protokol pro vyvolání ovladače JDBC.

Ambari CVEs

- Opravili jsme několik cves Ambari.

Poznámka:

ESP není v této verzi podporováno pro Kafka a HBase.

![]()

Ukončení podpory clusterů Azure HDInsight ve Sparku 2.4. 10. 2024 Další informace najdete v tématu Verze Sparku podporované ve službě Azure HDInsight.

Co bude dál

- Automatické škálování

- Automatické škálování s vylepšenou latencí a několika vylepšeními

- Omezení změny názvu clusteru

- Maximální délka názvu clusteru se změní na 45 z 59 ve veřejných verzích, Azure China a Azure Government.

- Oprávnění clusteru pro zabezpečené úložiště

- Zákazníci můžou zadat (během vytváření clusteru), jestli se má pro uzly clusteru HDInsight použít zabezpečený kanál pro kontaktování účtu úložiště.

- Clustery ABFS bez ESP [Oprávnění clusteru pro svět čitelný]

- Plánte zavést změnu v clusterech ABFS mimo ESP, což omezuje uživatele skupin, kteří nejsou hadoopem, aby spouštěli příkazy Hadoopu pro operace úložiště. Touto změnou zlepšíte stav zabezpečení clusteru. Zákazníci musí naplánovat aktualizace.

- Opensourcové upgrady

- Apache Spark 3.3.0 a Hadoop 3.3.4 jsou ve vývoji ve službě HDInsight 5.1 a zahrnují několik důležitých nových funkcí, výkonu a dalších vylepšení.

Poznámka:

Doporučujeme zákazníkům používat nejnovější verze imagí HDInsight, protože přinášejí nejlepší open source aktualizace, aktualizace Azure a opravy zabezpečení. Další informace najdete v tématu Osvědčené postupy.

Datum vydání: 12. prosince 2022

Tato verze platí pro HDInsight 4.0. Verze HDInsight 5.0 je dostupná pro všechny oblasti za několik dní.

HDInsight používá postupy bezpečného nasazení, které zahrnují postupné nasazování oblastí. Může trvat až 10 pracovních dnů, než bude nová verze nebo nová verze dostupná ve všech oblastech.

Verze operačního systému

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Informace o konkrétních verzích úloh najdete tady.

![]()

- Log Analytics – Zákazníci můžou povolit klasické monitorování, aby získali nejnovější verzi OMS 14.19. Pokud chcete odebrat staré verze, zakažte a povolte klasické monitorování.

- Automatické odhlášení uživatele Ambari z důvodu nečinnosti Další informace najdete tady.

- Spark – Nová a optimalizovaná verze Sparku 3.1.3 je součástí této verze. Otestovali jsme Apache Spark 3.1.2 (předchozí verze) a Apache Spark 3.1.3 (aktuální verze) pomocí srovnávacího testu TPC-DS. Test byl proveden pomocí skladové položky E8 V3 pro Apache Spark v úloze 1 TB. Apache Spark 3.1.3 (aktuální verze) překročil výkon Apache Sparku 3.1.2 (předchozí verze) o více než 40 % v celkovém modulu runtime dotazů pro dotazy TPC-DS pomocí stejných specifikací hardwaru. Tým Microsoft Sparku přidal optimalizace dostupné ve službě Azure Synapse se službou Azure HDInsight. Další informace najdete v tématu Zrychlení datových úloh s aktualizacemi výkonu Apache Sparku 3.1.2 ve službě Azure Synapse.

![]()

- Střední Katar

- Německo – sever

![]()

HDInsight se přesunul z Azul Zulu Java JDK 8, do

Adoptium Temurin JDK 8kterého podporuje vysoce kvalitní certifikované moduly runtime TCK a související technologie pro použití v ekosystému Java.Služba HDInsight se migrovala do

reload4jslužby . Změnylog4jplatí pro- Apache Hadoop

- Apache Zookeeper

- Apache Oozie

- Apache Ranger

- Apache Sqoop

- Apache Pig

- Apache Ambari

- Apache Kafka

- Apache Spark

- Apache Zeppelin

- Apache Livy

- Apache Rubix

- Apache Hive

- Apache Tez

- Apache HBase

- OMI

- Apache Pheonix

![]()

HDInsight pro implementaci protokolu TLS1.2 v budoucnu a starší verze se aktualizují na platformě. Pokud používáte jakékoli aplikace nad HDInsight a používají protokol TLS 1.0 a 1.1, upgradujte na protokol TLS 1.2, abyste se vyhnuli přerušení služeb.

Další informace najdete v tématu Povolení protokolu TLS (Transport Layer Security)

![]()

Ukončení podpory clusterů Azure HDInsight na Ubuntu 16.04 LTS od 30. listopadu 2022. HDInsight začne vydávat image clusteru pomocí Ubuntu 18.04 od 27. června 2021. Doporučujeme, aby naši zákazníci, kteří používají clustery s Ubuntu 16.04, znovu vytvořili clustery s nejnovějšími imagemi HDInsight do 30. listopadu 2022.

Další informace o kontrole verze clusteru Ubuntu najdete tady.

V terminálu spusťte příkaz "lsb_release -a".

Pokud je hodnota vlastnosti Description ve výstupu Ubuntu 16.04 LTS, tato aktualizace se vztahuje na cluster.

![]()

- Podpora Zóny dostupnosti výběru pro clustery Kafka a HBase (přístup k zápisu).

Opravy chyb open source

Opravy chyb Hivu

| Opravy chyb | Apache JIRA |

|---|---|

| HIVE-26127 | Chyba INSERT OVERWRITE – Soubor nebyl nalezen |

| HIVE-24957 | Nesprávné výsledky, pokud má poddotaz COALESCE v predikátu korelace |

| HIVE-24999 | HiveSubQueryRemoveRule generuje neplatný plán pro poddotaz IN s více korelacemi. |

| HIVE-24322 | Pokud je k dispozici přímé vložení, při čtení manifestu se musí zkontrolovat ID pokusu. |

| HIVE-23363 | Upgrade závislosti DataNucleus na verzi 5.2 |

| HIVE-26412 | Vytvoření rozhraní pro načtení dostupných slotů a přidání výchozího nastavení |

| HIVE-26173 | Upgrade derby na verzi 10.14.2.0 |

| HIVE-25920 | Náraz Xerce2 na 2.12.2. |

| HIVE-26300 | Upgrade verze vazby dat Jackson na verzi 2.12.6.1 nebo novější, abyste se vyhnuli CVE-2020-36518 |

Datum vydání: 10. 8. 2022

Tato verze platí pro HDInsight 4.0. Verze HDInsight je dostupná pro všechny oblasti za několik dní.

HDInsight používá postupy bezpečného nasazení, které zahrnují postupné nasazování oblastí. Může trvat až 10 pracovních dnů, než bude nová verze nebo nová verze dostupná ve všech oblastech.

![]()

Nová funkce

1. Připojení externích disků v clusterech HDI Hadoop/Spark

Cluster HDInsight se dodává s předdefinovaným místem na disku na základě skladové položky. Tento prostor nemusí být dostatečný ve velkých scénářích úloh.

Tato nová funkce umožňuje přidat do clusteru další disky, které se používají jako místní adresář správce uzlů. Během vytváření clusteru HIVE a Spark přidejte počet disků do pracovních uzlů, zatímco vybrané disky jsou součástí místních adresářů správce uzlů.

Poznámka:

Přidané disky jsou nakonfigurovány pouze pro místní adresáře správce uzlů.

Další informace najdete tady.

2. Selektivní analýza protokolování

Selektivní analýza protokolování je teď dostupná ve všech oblastech pro verzi Public Preview. Cluster můžete připojit k pracovnímu prostoru služby Log Analytics. Po povolení můžete zobrazit protokoly a metriky, jako jsou protokoly zabezpečení SLUŽBY HDInsight, Resource Manager Yarn, systémové metriky atd. Můžete monitorovat úlohy a zjistit, jak ovlivňují stabilitu clusteru. Selektivní protokolování umožňuje povolit nebo zakázat všechny tabulky nebo povolit selektivní tabulky v pracovním prostoru služby Log Analytics. Typ zdroje pro každou tabulku můžete upravit, protože v nové verzi Ženevy monitoruje jedna tabulka více zdrojů.

- Systém monitorování Ženevy používá mdsd (démon MDS), což je monitorovací agent a fluentd pro shromažďování protokolů pomocí sjednocené vrstvy protokolování.

- Selektivní protokolování používá akci skriptu k zakázání nebo povolení tabulek a jejich typů protokolů. Vzhledem k tomu, že neotevře žádné nové porty ani nezmění žádné existující nastavení zabezpečení, neexistují žádné změny zabezpečení.

- Akce skriptu se spouští paralelně na všech zadaných uzlech a mění konfigurační soubory pro zakázání nebo povolení tabulek a jejich typů protokolů.

Další informace najdete tady.

![]()

Pevný

Log Analytics

Služba Log Analytics integrovaná se službou Azure HDInsight s OMS verze 13 vyžaduje upgrade na OMS verze 14, aby bylo nutné použít nejnovější aktualizace zabezpečení. Zákazníci používající starší verzi clusteru s OMS verze 13 musí nainstalovat OMS verze 14, aby splnili požadavky na zabezpečení. (Jak zkontrolovat aktuální verzi a nainstalovat 14)

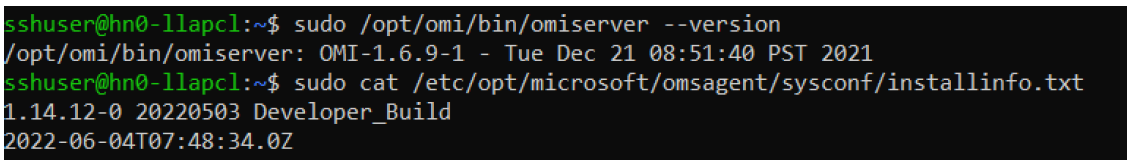

Jak zkontrolovat aktuální verzi OMS

- Přihlaste se ke clusteru pomocí SSH.

- V klientovi SSH spusťte následující příkaz.

sudo /opt/omi/bin/ominiserver/ --version

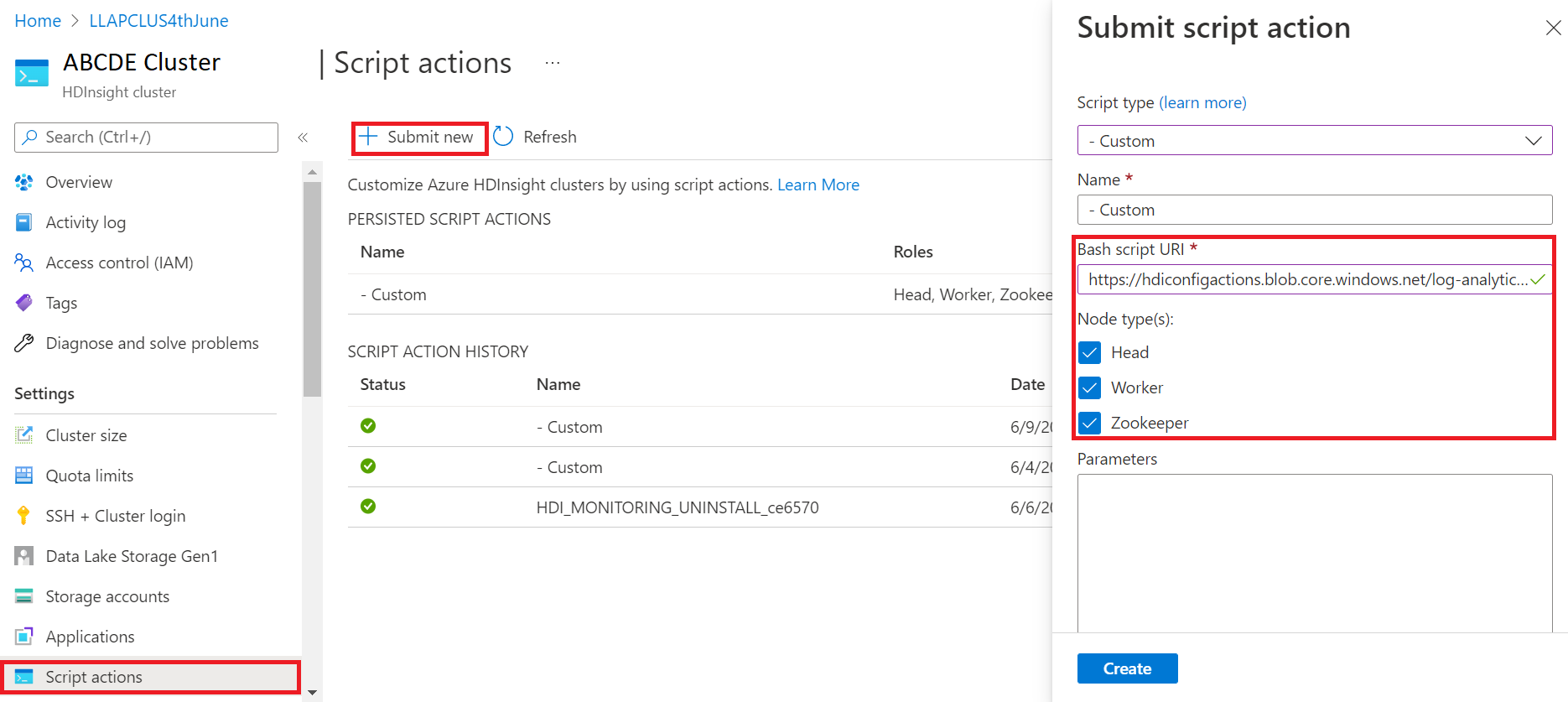

Postup upgradu verze OMS z verze 13 na 14

- Přihlaste se k portálu Azure Portal.

- Ve skupině prostředků vyberte prostředek clusteru HDInsight.

- Výběr akcí skriptu

- Na panelu akcí Odeslat skript zvolte jako vlastní typ skriptu.

- Vložte následující odkaz do pole Adresa URL skriptu Bash. https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- Výběr typů uzlů

- Vyberte příkaz Vytvořit.

Pomocí následujících kroků ověřte úspěšnou instalaci opravy:

Přihlaste se ke clusteru pomocí SSH.

V klientovi SSH spusťte následující příkaz.

sudo /opt/omi/bin/ominiserver/ --version

Další opravy chyb

- Rozhraní příkazového řádku protokolu Yarn se nepovedlo načíst protokoly, pokud je nějaká

TFilepoškozená nebo prázdná. - Vyřešili jsme chybu s neplatnými podrobnostmi o instančním objektu při získávání tokenu OAuth z Azure Active Directory.

- Vylepšili jsme spolehlivost vytváření clusterů při konfiguraci 100 nebo více pracovních uzlů.

Opravy chyb open source

Opravy chyb TEZ

| Opravy chyb | Apache JIRA |

|---|---|

| Chyba sestavení Tez: FileSaver.js nenalezena | TEZ-4411 |

Chybná výjimka FS v případech, kdy je sklad a scratchdir nachází se v jiné službě FS |

TEZ-4406 |

| TezUtils.createConfFromByteString v konfiguraci větší než 32 MB vyvolá com.google.protobuf.CodedInputStream výjimka | TEZ-4142 |

| TezUtils::createByteStringFromConf by měl místo DeflaterOutputStream používat snappy. | TEZ-4113 |

| Aktualizace závislosti protobuf na verzi 3.x | TEZ-4363 |

Opravy chyb Hivu

| Opravy chyb | Apache JIRA |

|---|---|

| Optimalizace výkonu v dělení ORC | HIVE-21457 |

| Vyhněte se čtení tabulky jako ACID, pokud název tabulky začíná na "delta", ale tabulka není transakční a strategie rozdělení BI se používá. | HIVE-22582 |

| Odebrání volání FS#exists z AcidUtils#getLogicalLength | HIVE-23533 |

| Vectorized OrcAcidRowBatchReader.computeOffset a optimalizace kbelíku | HIVE-17917 |

Známé problémy

HDInsight je kompatibilní s Apache HIVE 3.1.2. Vzhledem k chybě v této verzi se verze Hive zobrazí jako verze 3.1.0 v rozhraních Hive. Na funkčnost ale nemá žádný vliv.

Datum vydání: 10. 8. 2022

Tato verze platí pro HDInsight 4.0. Verze HDInsight je dostupná pro všechny oblasti za několik dní.

HDInsight používá postupy bezpečného nasazení, které zahrnují postupné nasazování oblastí. Může trvat až 10 pracovních dnů, než bude nová verze nebo nová verze dostupná ve všech oblastech.

![]()

Nová funkce

1. Připojení externích disků v clusterech HDI Hadoop/Spark

Cluster HDInsight se dodává s předdefinovaným místem na disku na základě skladové položky. Tento prostor nemusí být dostatečný ve velkých scénářích úloh.

Tato nová funkce umožňuje přidat do clusteru další disky, které se použijí jako místní adresář správce uzlů. Během vytváření clusteru HIVE a Spark přidejte počet disků do pracovních uzlů, zatímco vybrané disky jsou součástí místních adresářů správce uzlů.

Poznámka:

Přidané disky jsou nakonfigurovány pouze pro místní adresáře správce uzlů.

Další informace najdete tady.

2. Selektivní analýza protokolování

Selektivní analýza protokolování je teď dostupná ve všech oblastech pro verzi Public Preview. Cluster můžete připojit k pracovnímu prostoru služby Log Analytics. Po povolení můžete zobrazit protokoly a metriky, jako jsou protokoly zabezpečení SLUŽBY HDInsight, Resource Manager Yarn, systémové metriky atd. Můžete monitorovat úlohy a zjistit, jak ovlivňují stabilitu clusteru. Selektivní protokolování umožňuje povolit nebo zakázat všechny tabulky nebo povolit selektivní tabulky v pracovním prostoru služby Log Analytics. Typ zdroje pro každou tabulku můžete upravit, protože v nové verzi Ženevy monitoruje jedna tabulka více zdrojů.

- Systém monitorování Ženevy používá mdsd (démon MDS), což je monitorovací agent a fluentd pro shromažďování protokolů pomocí sjednocené vrstvy protokolování.

- Selektivní protokolování používá akci skriptu k zakázání nebo povolení tabulek a jejich typů protokolů. Vzhledem k tomu, že neotevře žádné nové porty ani nezmění žádné existující nastavení zabezpečení, neexistují žádné změny zabezpečení.

- Akce skriptu se spouští paralelně na všech zadaných uzlech a mění konfigurační soubory pro zakázání nebo povolení tabulek a jejich typů protokolů.

Další informace najdete tady.

![]()

Pevný

Log Analytics

Služba Log Analytics integrovaná se službou Azure HDInsight s OMS verze 13 vyžaduje upgrade na OMS verze 14, aby bylo nutné použít nejnovější aktualizace zabezpečení. Zákazníci používající starší verzi clusteru s OMS verze 13 musí nainstalovat OMS verze 14, aby splnili požadavky na zabezpečení. (Jak zkontrolovat aktuální verzi a nainstalovat 14)

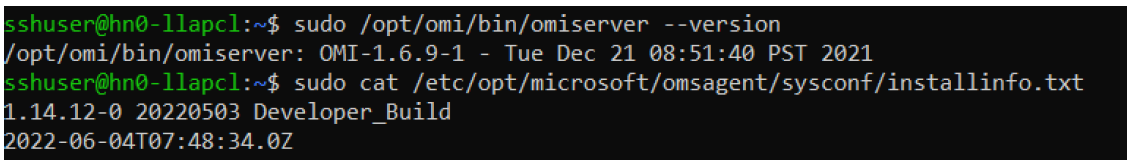

Jak zkontrolovat aktuální verzi OMS

- Přihlaste se ke clusteru pomocí SSH.

- V klientovi SSH spusťte následující příkaz.

sudo /opt/omi/bin/ominiserver/ --version

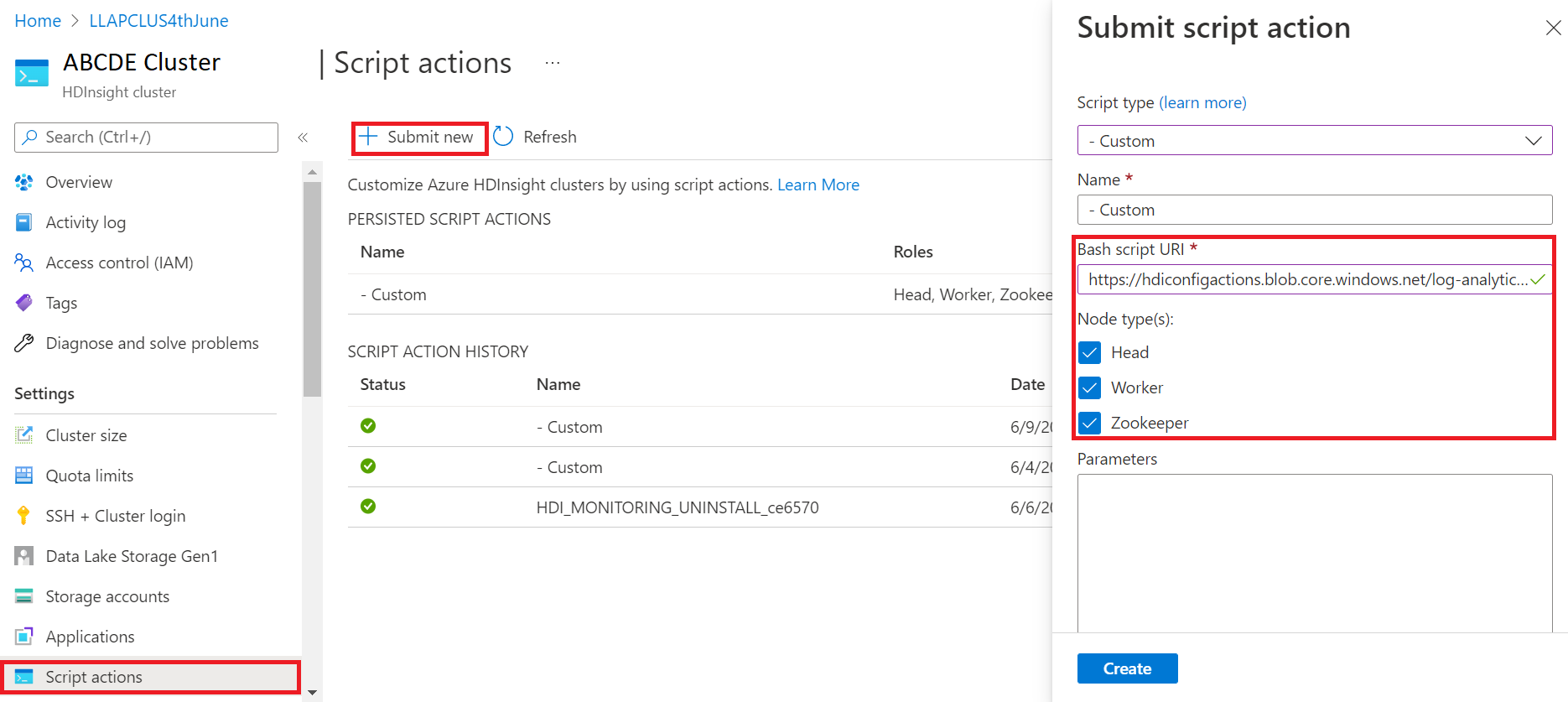

Postup upgradu verze OMS z verze 13 na 14

- Přihlaste se k portálu Azure Portal.

- Ve skupině prostředků vyberte prostředek clusteru HDInsight.

- Výběr akcí skriptu

- Na panelu akcí Odeslat skript zvolte jako vlastní typ skriptu.

- Vložte následující odkaz do pole Adresa URL skriptu Bash. https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- Výběr typů uzlů

- Vyberte příkaz Vytvořit.

Pomocí následujících kroků ověřte úspěšnou instalaci opravy:

Přihlaste se ke clusteru pomocí SSH.

V klientovi SSH spusťte následující příkaz.

sudo /opt/omi/bin/ominiserver/ --version

Další opravy chyb

- Rozhraní příkazového řádku protokolu Yarn se nepovedlo načíst protokoly, pokud je nějaká

TFilepoškozená nebo prázdná. - Vyřešili jsme chybu s neplatnými podrobnostmi o instančním objektu při získávání tokenu OAuth z Azure Active Directory.

- Vylepšili jsme spolehlivost vytváření clusterů při konfiguraci 100 nebo více pracovních uzlů.

Opravy chyb open source

Opravy chyb TEZ

| Opravy chyb | Apache JIRA |

|---|---|

| Chyba sestavení Tez: FileSaver.js nenalezena | TEZ-4411 |

Chybná výjimka FS v případech, kdy je sklad a scratchdir nachází se v jiné službě FS |

TEZ-4406 |

| TezUtils.createConfFromByteString v konfiguraci větší než 32 MB vyvolá com.google.protobuf.CodedInputStream výjimka | TEZ-4142 |

| TezUtils::createByteStringFromConf by měl místo DeflaterOutputStream používat snappy. | TEZ-4113 |

| Aktualizace závislosti protobuf na verzi 3.x | TEZ-4363 |

Opravy chyb Hivu

| Opravy chyb | Apache JIRA |

|---|---|

| Optimalizace výkonu v dělení ORC | HIVE-21457 |

| Vyhněte se čtení tabulky jako ACID, pokud název tabulky začíná na "delta", ale tabulka není transakční a strategie rozdělení BI se používá. | HIVE-22582 |

| Odebrání volání FS#exists z AcidUtils#getLogicalLength | HIVE-23533 |

| Vectorized OrcAcidRowBatchReader.computeOffset a optimalizace kbelíku | HIVE-17917 |

Známé problémy

HDInsight je kompatibilní s Apache HIVE 3.1.2. Vzhledem k chybě v této verzi se verze Hive zobrazí jako verze 3.1.0 v rozhraních Hive. Na funkčnost ale nemá žádný vliv.

Datum vydání: 3. 6. 2022

Tato verze platí pro HDInsight 4.0. Verze HDInsight je dostupná pro všechny oblasti za několik dní. Zde uvedené datum vydání označuje datum vydání první oblasti. Pokud se vám nezobrazují následující změny, počkejte, až bude vydaná verze aktivní ve vaší oblasti za několik dní.

Hlavní informace k vydání

Sklad Hive Připojení or (HWC) ve Sparku v3.1.2

Připojení or Hive Warehouse (HWC) umožňuje využívat jedinečné funkce Hive a Sparku k vytváření výkonných aplikací pro velké objemy dat. HWC je aktuálně podporován pouze pro Spark verze 2.4. Tato funkce přidává obchodní hodnotu povolením transakcí ACID v tabulkách Hive pomocí Sparku. Tato funkce je užitečná pro zákazníky, kteří ve svých datových aktivech používají Hive i Spark. Další informace najdete v tématu Apache Spark & Hive – Připojení or skladu Hive – Azure HDInsight | Microsoft Docs

Ambari

- Změny vylepšení škálování a zřizování

- Hive HDI je teď kompatibilní s operačním systémem verze 3.1.2

Verze HDI Hive 3.1 se upgraduje na OSS Hive 3.1.2. Tato verze obsahuje všechny opravy a funkce dostupné ve opensourcové verzi Hive 3.1.2.

Poznámka:

Spark

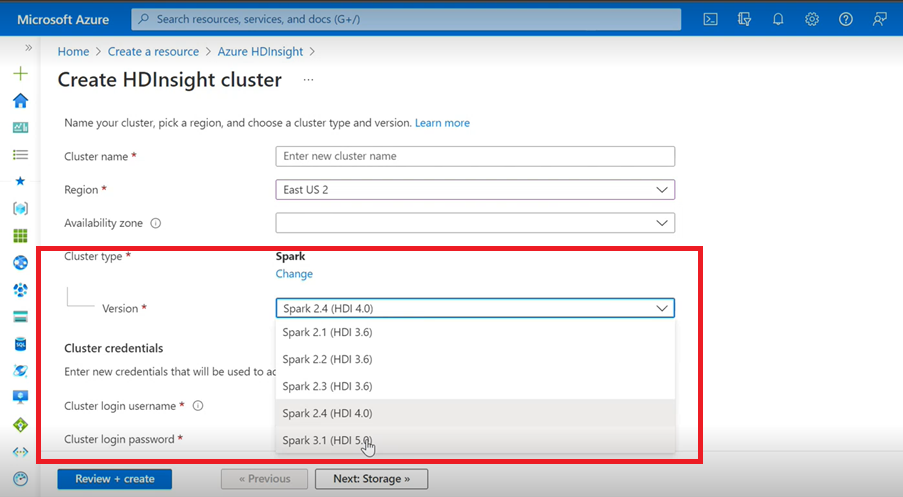

- Pokud k vytvoření clusteru Spark pro HDInsight používáte uživatelské rozhraní Azure, zobrazí se v rozevíracím seznamu jiná verze Spark 3.1. (HDI 5.0) spolu se staršími verzemi. Tato verze je přejmenovaná verze Sparku 3.1. (HDI 4.0). Jedná se pouze o změnu na úrovni uživatelského rozhraní, která nemá vliv na nic pro stávající uživatele a uživatele, kteří už šablonu ARM používají.

Poznámka:

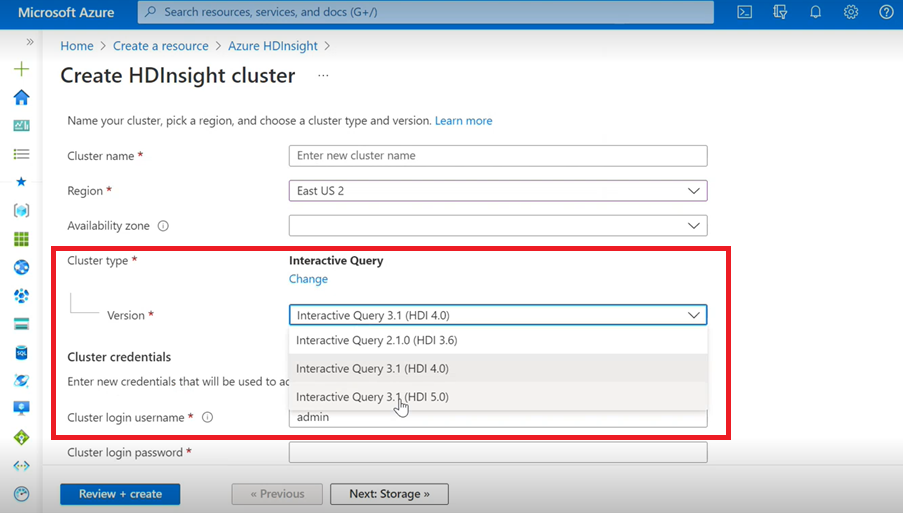

Interaktivní dotaz

- Pokud vytváříte interaktivní cluster dotazů, uvidíte z rozevíracího seznamu jinou verzi interaktivního dotazu 3.1 (HDI 5.0).

- Pokud budete používat verzi Spark 3.1 spolu s Hivem, která vyžaduje podporu ACID, musíte vybrat tuto verzi Interactive Query 3.1 (HDI 5.0).

Opravy chyb TEZ

| Opravy chyb | Apache JIRA |

|---|---|

| TezUtils.createConfFromByteString v konfiguraci větší než 32 MB vyvolá com.google.protobuf.CodedInputStream výjimka | TEZ-4142 |

| TezUtils createByteStringFromConf by měl místo DeflaterOutputStream používat snappy. | TEZ-4113 |

Opravy chyb HBase

| Opravy chyb | Apache JIRA |

|---|---|

TableSnapshotInputFormat by měl ke skenování použít ReadType.STREAM. HFiles |

HBASE-26273 |

| Přidání možnosti pro zakázání scanMetrics v TabulceSnapshotInputFormat | HBASE-26330 |

| Oprava pro ArrayIndexOutOfBoundsException při spuštění nástroje pro vyrovnávání | HBASE-22739 |

Opravy chyb Hivu

| Opravy chyb | Apache JIRA |

|---|---|

| NPE při vkládání dat s klauzulí "distribute by" s optimalizací řazení dynpart | HIVE-18284 |

| Příkaz MSCK REPAIR s filtrováním oddílů selže při odstraňování oddílů | HIVE-23851 |

| Při kapacitě =0 došlo k nesprávné výjimce<. | HIVE-25446 |

| Podpora paralelního načítání pro HastTables – rozhraní | HIVE-25583 |

| Zahrnout MultiDelimitSerDe ve výchozím nastavení HiveServer2 | HIVE-20619 |

| Odebrání glassfish.jersey a mssql-jdbc třídy z jdbc-standalone jar | HIVE-22134 |

| Výjimka nulového ukazatele při spuštění komprimace v tabulce MM | HIVE-21280 |

Dotaz Hive s velkou velikostí prostřednictvím knox selhání s chybou selhání zápisu přerušeného kanálu |

HIVE-22231 |

| Přidání možnosti nastavení uživatele vazby | HIVE-21009 |

| Implementace UDF pro interpretaci data a časového razítka pomocí interní reprezentace a hybridního kalendáře Gregorian-Julian | HIVE-22241 |

| Možnost Beeline zobrazit nebo nezobrazovat sestavu spuštění | HIVE-22204 |

| Tez: SplitGenerator se pokusí vyhledat soubory plánu, které neexistují pro Tez | HIVE-22169 |

Odebrání nákladného protokolování z mezipaměti LLAP hotpath |

HIVE-22168 |

| UDF: FunctionRegistry synchronizuje na org.apache.hadoop.hive.ql.udf.UDFType – třída | HIVE-22161 |

| Zabránění vytvoření přidávacího modulu směrování dotazů, pokud je vlastnost nastavená na false | HIVE-22115 |

| Odebrání synchronizace křížového dotazu pro dělenou val | HIVE-22106 |

| Přeskočení nastavení pomocného diru Hive během plánování | HIVE-21182 |

| Přeskočte vytváření pomocných dirů pro tez, pokud je rpc zapnutý | HIVE-21171 |

Přepnutí uživatelem definovaných funkcí Hivu pro použití Re2J modulu regulárních výrazů |

HIVE-19661 |

| Migrované clusterované tabulky pomocí bucketing_version 1 v Hive 3 používá pro vložení bucketing_version 2. | HIVE-22429 |

| Dělení na kontejnery: Kontejnery verze 1 nesprávně rozdělují data | HIVE-21167 |

| Přidání hlavičky licence ASF do nově přidaného souboru | HIVE-22498 |

| Vylepšení nástrojů schémat pro podporu mergeCatalog | HIVE-22498 |

| Hive s TEZ UNION ALL a UDTF vede ke ztrátě dat | HIVE-21915 |

| Rozdělení textových souborů i v případě, že existuje záhlaví nebo zápatí | HIVE-21924 |

| Funkce MultiDelimitSerDe vrátí nesprávné výsledky v posledním sloupci, pokud má načtený soubor více sloupců, než je v tabulkovém schématu. | HIVE-22360 |

| Externí klient LLAP – Potřeba snížit nároky llapBaseInputFormat#getSplits() | HIVE-22221 |

| Název sloupce s vyhrazeným klíčovým slovem se nepředloží, když se přepíše dotaz, včetně spojení v tabulce s maskou (Zoltan Matyus přes Zoltan Haindrich). | HIVE-22208 |

Zabránění vypnutí LLAP u AMReporter souvisejícího modulu RuntimeException |

HIVE-22113 |

| Ovladač stavové služby LLAP se může zaseknout s nesprávným ID aplikace Yarn | HIVE-21866 |

| OperationManager.queryIdOperation nevyčistí správně více ID dotazů | HIVE-22275 |

| Přenesení správce uzlů dolů blokuje restartování služby LLAP | HIVE-22219 |

| StackOverflowError při zahazování velkého počtu oddílů | HIVE-15956 |

| Kontrola přístupu se nezdařila, když se odebere dočasný adresář. | HIVE-22273 |

| Oprava chybných výsledků / výjimka ArrayOutOfBound v levých vnějších mapových spojeních v konkrétních podmínkách hranic | HIVE-22120 |

| Odebrání značky správy distribuce z pom.xml | HIVE-19667 |

| Doba analýzy může být vysoká, pokud existují hluboko vnořené poddotazy. | HIVE-21980 |

Pro ALTER TABLE není NASTAVEN TBLPROPERTIES ('EXTERNAL'='TRUE'); TBL_TYPE změny atributu, které se nezobrazují pro jiné než CAPS |

HIVE-20057 |

JDBC: Rozhraní Hive Připojení ion odstínů log4j |

HIVE-18874 |

Aktualizace adres URL úložiště ve poms větvi 3.1 |

HIVE-21786 |

DBInstall testy v hlavní větvi a větvi 3.1 byly přerušeny. |

HIVE-21758 |

| Načtení dat do kontejnerové tabulky ignoruje specifikace oddílů a načte data do výchozího oddílu. | HIVE-21564 |

| Dotazy s podmínkou spojení s časovým razítkem nebo časovým razítkem s literálem místního časového pásma vyvolá výjimku SemanticException | HIVE-21613 |

| Analýza výpočetních statistik pro sloupec, který ponechá přípravný dir v HDFS | HIVE-21342 |

| Nekompatibilní změna v výpočtu kbelíku Hive | HIVE-21376 |

| Poskytnutí náhradního autorizátoru, pokud se nepoužívá žádný jiný autorizaci | HIVE-20420 |

| Některé vyvolání alterPartitions vyvolá výjimku NumberFormatException: null | HIVE-18767 |

| HiveServer2: Předovězené předměty pro přenos http se v některých případech neuchovávají po celou dobu trvání komunikace http. | HIVE-20555 |

Datum vydání: 10. 3. 2022

Tato verze platí pro HDInsight 4.0. Verze HDInsight je dostupná pro všechny oblasti za několik dní. Zde uvedené datum vydání označuje datum vydání první oblasti. Pokud se vám nezobrazují následující změny, počkejte, až bude vydaná verze aktivní ve vaší oblasti za několik dní.

Verze operačního systému pro tuto verzi jsou:

- HDInsight 4.0: Ubuntu 18.04.5

Spark 3.1 je teď obecně dostupný

Spark 3.1 je teď obecně dostupný ve verzi HDInsight 4.0. Tato verze zahrnuje

- Adaptivní spouštění dotazů,

- Převod spojení sloučení řazení na všesměrové spojení hash,

- Optimalizátor Spark Catalyst,

- Dynamické vyřezávání oddílů

- Zákazníci budou moct vytvářet nové clustery Spark 3.1, a ne clustery Spark 3.0 (Preview).

Další informace najdete v tématu Apache Spark 3.1 , který je nyní obecně dostupný ve službě HDInsight – Microsoft Tech Community.

Úplný seznam vylepšení najdete v poznámkách k verzi Apache Spark 3.1.

Další informace o migraci najdete v průvodci migrací.

Kafka 2.4 je teď obecně dostupný

Kafka 2.4.1 je teď obecně dostupný. Další informace najdete v poznámkách k verzi Kafka 2.4.1. Mezi další funkce patří dostupnost MirrorMakeru 2, nová kategorie metrik AtMinIsr téma oddílu, vylepšený čas spuštění zprostředkovatele opožděný na vyžádání mmap indexových souborů, další metriky příjemců sledovat chování dotazování uživatelů.

Datový typ mapování v HWC se teď podporuje ve službě HDInsight 4.0.

Tato verze zahrnuje podporu datových typů map pro HWC 1.0 (Spark 2.4) Prostřednictvím aplikace spark-shell a všech ostatních klientů Spark, které HWC podporuje. Následující vylepšení jsou zahrnutá stejně jako jiné datové typy:

Uživatel může

- Vytvořte tabulku Hive s libovolnými sloupci obsahujícími datový typ Mapy, vložte do ní data a načtěte výsledky z ní.

- Vytvořte datový rámec Apache Sparku s mapovým typem a proveďte dávkové/streamové čtení a zápisy.

Nové oblasti

HDInsight nyní rozšířil svou geografickou přítomnost na dvě nové oblasti: Čína – východ 3 a Čína – sever 3.

Změny backportu operačního systému

Backporty OSS, které jsou součástí Hivu, včetně HWC 1.0 (Spark 2.4), které podporují datový typ Mapy.

Tady jsou backportované apache JIRA operačního systému pro tuto verzi:

| Ovlivněná funkce | Apache JIRA |

|---|---|

| Dotazy SQL s přímým úložištěm SQL s in/(NOT IN) by se měly rozdělit na základě maximálních parametrů povolených službou SQL DB. | HIVE-25659 |

Upgrade log4j verze 2.16.0 na verzi 2.17.0 |

HIVE-25825 |

Aktualizace Flatbuffer verze |

HIVE-22827 |

| Podpora datového typu Mapy nativně ve formátu Šipka | HIVE-25553 |

| Externí klient LLAP – Zpracování vnořených hodnot, pokud nadřazená struktura má hodnotu null | HIVE-25243 |

| Upgrade verze šipky na 0.11.0 | HIVE-23987 |

Oznámení o vyřazení

Škálovací sady virtuálních počítačů Azure ve službě HDInsight

HDInsight už nebude ke zřizování clusterů používat škálovací sady virtuálních počítačů Azure, neočekává se žádná zásadní změna. Stávající clustery HDInsight ve škálovacích sadách virtuálních počítačů nemají žádný vliv. Žádné nové clustery na nejnovějších imagích už nebudou používat škálovací sady virtuálních počítačů.

Škálování úloh Azure HDInsight HBase se teď bude podporovat jenom pomocí ručního škálování.

Od 1. března 2022 bude HDInsight podporovat pouze ruční škálování pro HBase, nemá žádný vliv na spuštěné clustery. Nové clustery HBase nebudou moct povolit automatické škálování na základě plánu. Další informace o ručním škálování clusteru HBase najdete v naší dokumentaci k ručnímu škálování clusterů Azure HDInsight.

Datum vydání: 27. 12. 2021

Tato verze platí pro HDInsight 4.0. Verze HDInsight je dostupná pro všechny oblasti za několik dní. Zde uvedené datum vydání označuje datum vydání první oblasti. Pokud se vám nezobrazují následující změny, počkejte, až bude vydaná verze aktivní ve vaší oblasti za několik dní.

Verze operačního systému pro tuto verzi jsou:

- HDInsight 4.0: Ubuntu 18.04.5 LTS

Image HDInsight 4.0 byla aktualizována, aby se zmírnit Log4j ohrožení zabezpečení, jak je popsáno v odpovědi Společnosti Microsoft na CVE-2021-44228 Apache Log4j 2.

Poznámka:

- Všechny clustery HDI 4.0 vytvořené po 27. prosince 2021 00:00 UTC se vytvoří s aktualizovanou verzí image, která snižuje

log4johrožení zabezpečení. Zákazníci proto tyto clustery nemusí opravovat nebo restartovat. - Pro nové clustery HDInsight 4.0 vytvořené mezi 16. prosincem 2021 v 01:15 UTC a 27. prosince 2021 00:00 UTC, HDInsight 3.6 nebo v připnutých předplatných po 16. prosinci 2021 se oprava automaticky použije během hodiny, ve které se cluster vytvoří, ale zákazníci musí restartovat uzly, aby se opravy dokončily (s výjimkou uzlů pro správu Kafka, které se automaticky restartují).

Datum vydání: 27. 7. 2021

Tato verze platí pro HDInsight 3.6 i HDInsight 4.0. Verze HDInsight je dostupná pro všechny oblasti za několik dní. Zde uvedené datum vydání označuje datum vydání první oblasti. Pokud se vám nezobrazují následující změny, počkejte, až bude verze v dané oblasti aktivní za několik dní.

Verze operačního systému pro tuto verzi jsou:

- HDInsight 3.6: Ubuntu 16.04.7 LTS

- HDInsight 4.0: Ubuntu 18.04.5 LTS

Nové funkce

Podpora služby Azure HDInsight pro omezenou veřejnou Připojení ivity je obecně dostupná 15. října 2021

Azure HDInsight teď podporuje omezené veřejné připojení ve všech oblastech. Níže jsou uvedeny některé z klíčových nejdůležitějších bodů této funkce:

- Schopnost obrátit poskytovatele prostředků na komunikaci clusteru tak, aby byla odchozí z clusteru na poskytovatele prostředků

- Podpora pro přenesení vlastních prostředků s podporou služby Private Link (například úložiště, SQL, trezor klíčů) pro cluster HDInsight pro přístup k prostředkům pouze přes privátní síť

- Nejsou zřízeny žádné veřejné IP adresy.

Pomocí této nové funkce můžete také přeskočit pravidla značek příchozí skupiny zabezpečení sítě (NSG) pro IP adresy pro správu SLUŽBY HDInsight. Další informace o omezení veřejného připojení

Podpora služby Azure HDInsight pro Azure Private Link je obecně dostupná 15. října 2021

K připojení ke clusterům HDInsight přes privátní propojení teď můžete použít privátní koncové body. Privátní propojení je možné použít ve scénářích mezi virtuálními sítěmi, ve kterých není partnerský vztah virtuálních sítí dostupný nebo povolený.

Azure Private Link umožňuje přístup ke službám Azure PaaS (například Azure Storage a SQL Database) a službám Hostovaným zákazníkem nebo partnerským službám Azure přes privátní koncový bod ve vaší virtuální síti.

Provoz mezi vaší virtuální sítí a službou prochází páteřní sítí Microsoftu. Vystavení služby veřejnému internetu už není nutné.

Další informace o povolení privátního propojení

Nové prostředí integrace služby Azure Monitor (Preview)

V této verzi bude nové prostředí integrace služby Azure Monitor ve verzi Preview v oblasti USA – východ a Západní Evropa. Další informace o novém prostředí služby Azure Monitor najdete tady.

Vyřazení z provozu

Verze HDInsight 3.6 je zastaralá od 1. října 2022.

Změny chování

HDInsight Interactive Query podporuje pouze automatické škálování založené na plánu.

Vzhledem k tomu, že scénáře zákazníků rostou vyspělejší a různorodější, zjistili jsme určitá omezení při automatickém škálování založeném na zatížení interaktivních dotazů (LLAP). Tato omezení jsou způsobená povahou dynamics dotazů LLAP, problémy s přesností budoucích předpovědí zatížení a problémy s redistribucí úloh plánovače LLAP. Vzhledem k těmto omezením můžou uživatelé v clusterech LLAP při povolení automatického škálování vidět pomalejší dotazy. Vliv na výkon může převažovat nad nákladové výhody automatického škálování.

Od července 2021 podporuje úloha Interactive Query v HDInsight pouze automatické škálování založené na plánu. U nových clusterů Interactive Query už nemůžete povolit automatické škálování založené na zatížení. Stávající spuštěné clustery můžou dál běžet se známými omezeními popsanými výše.

Microsoft doporučuje přejít na automatické škálování založené na plánu pro LLAP. Aktuální vzor využití clusteru můžete analyzovat prostřednictvím řídicího panelu Grafana Hive. Další informace najdete v tématu Automatické škálování clusterů Azure HDInsight.

Nadcházející změny

V nadcházejících verzích probíhají následující změny.

Odebere se integrovaná komponenta LLAP v clusteru ESP Spark.

Cluster HDInsight 4.0 ESP Spark má integrované komponenty LLAP spuštěné na obou hlavních uzlech. Komponenty LLAP v clusteru ESP Spark byly původně přidány pro HDInsight 3.6 ESP Spark, ale nemá žádný skutečný uživatelský případ pro HDInsight 4.0 ESP Spark. V příští vydané verzi naplánované v sep 2021 odebere HDInsight integrovanou komponentu LLAP z clusteru HDInsight 4.0 ESP Spark. Tato změna pomáhá přesměrovat úlohy hlavního uzlu a vyhnout se nejasnostem mezi typem clusteru ESP Spark a ESP Interactive Hive.

Nová oblast

- USA – západ 3

JioIndie – západ- Austrálie – střed

Změna verze komponenty

V této verzi byla změněna následující verze komponenty:

- Verze ORC od 1.5.1 do 1.5.9

Aktuální verze komponent pro HDInsight 4.0 a HDInsight 3.6 najdete v tomto dokumentu.

Back ported JIRA

Tady jsou back portované apache JIRA pro tuto verzi:

| Ovlivněná funkce | Apache JIRA |

|---|---|

| Datum a časové razítko | HIVE-25104 |

| HIVE-24074 | |

| HIVE-22840 | |

| HIVE-22589 | |

| HIVE-22405 | |

| HIVE-21729 | |

| HIVE-21291 | |

| HIVE-21290 | |

| UDF | HIVE-25268 |

| HIVE-25093 | |

| HIVE-22099 | |

| HIVE-24113 | |

| HIVE-22170 | |

| HIVE-22331 | |

| ORC | HIVE-21991 |

| HIVE-21815 | |

| HIVE-21862 | |

| Schéma tabulky | HIVE-20437 |

| HIVE-22941 | |

| HIVE-21784 | |

| HIVE-21714 | |

| HIVE-18702 | |

| HIVE-21799 | |

| HIVE-21296 | |

| Správa úloh | HIVE-24201 |

| Komprese | HIVE-24882 |

| HIVE-23058 | |

| HIVE-23046 | |

| Materializované zobrazení | HIVE-22566 |

Oprava cen pro virtuální počítače HDInsight Dv2

25. dubna 2021 byla opravena chyba s cenami pro Dv2 řadu virtuálních počítačů ve službě HDInsight. Chyba s cenami způsobila snížení poplatků na faktuře některých zákazníků před 25. dubnem a s opravou se ceny teď shodují s tím, co se inzerovalo na stránce s cenami SLUŽBY HDInsight, a cenovou kalkulačkou HDInsight. Chyba cen ovlivnila zákazníky v následujících oblastech, které používaly Dv2 virtuální počítače:

- Střední Kanada

- Kanada – východ

- Východní Asie

- Jižní Afrika – sever

- Southeast Asia

- Spojené arabské emiráty – střed

Od 25. dubna 2021 bude na vašem účtu opravená částka pro Dv2 virtuální počítače. Oznámení zákazníků se před změnou odeslala vlastníkům předplatného. K zobrazení správných nákladů na Dv2 virtuálních počítačích ve vaší oblasti můžete použít cenovou kalkulačku, stránku s cenami SLUŽBY HDInsight nebo okno Vytvořit cluster HDInsight na webu Azure Portal.

Od vás není potřeba žádná jiná akce. Oprava ceny bude platit pouze pro využití dne 25. dubna 2021 v zadaných oblastech, a ne na využití před tímto datem. Abyste měli jistotu, že máte nejvýkonnější a nákladově efektivní řešení, doporučujeme zkontrolovat ceny, VCPU a RAM pro vaše Dv2 clustery a porovnat Dv2 specifikace s Ev3 virtuálními počítači, abyste zjistili, jestli by vaše řešení mohlo těžit z využití některé z novějších řad virtuálních počítačů.

Datum vydání: 2. 6. 2021

Tato verze platí pro HDInsight 3.6 i HDInsight 4.0. Verze HDInsight je dostupná pro všechny oblasti za několik dní. Zde uvedené datum vydání označuje datum vydání první oblasti. Pokud se vám nezobrazují následující změny, počkejte, až bude verze v dané oblasti aktivní za několik dní.

Verze operačního systému pro tuto verzi jsou:

- HDInsight 3.6: Ubuntu 16.04.7 LTS

- HDInsight 4.0: Ubuntu 18.04.5 LTS

Nové funkce

Upgrade verze operačního systému

Jak je uvedeno v cyklu vydání Ubuntu, jádro Ubuntu 16.04 dosáhne konce životnosti (EOL) v dubnu 2021. V této verzi jsme začali zavádět novou image clusteru HDInsight 4.0 běžící na Ubuntu 18.04. Nově vytvořené clustery HDInsight 4.0 běží ve výchozím nastavení na Ubuntu 18.04 jednou k dispozici. Existující clustery na Ubuntu 16.04 běží stejně jako u plné podpory.

HDInsight 3.6 bude dál běžet na Ubuntu 16.04. Od 1. července 2021 se změní na základní podporu (ze standardní podpory). Další informace odatech Ubuntu 18.04 nebude podporováno pro HDInsight 3.6. Pokud chcete používat Ubuntu 18.04, budete muset své clustery migrovat do HDInsight 4.0.

Pokud chcete přesunout existující clustery HDInsight 4.0 do Ubuntu 18.04, musíte clustery odstranit a znovu vytvořit. Po zpřístupnění podpory Ubuntu 18.04 můžete clustery vytvořit nebo znovu vytvořit.

Po vytvoření nového clusteru můžete SSH do clusteru spustit a ověřit sudo lsb_release -a , že běží na Ubuntu 18.04. Před přechodem do produkčního prostředí doporučujeme nejprve otestovat své aplikace v testovacích předplatných.

Optimalizace škálování v clusterech s akcelerovanými zápisy HBase

HDInsight provedl některá vylepšení a optimalizace škálování pro clustery s podporou zrychleného zápisu HBase. Přečtěte si další informace o akcelerovaném zápisu HBase.

Vyřazení z provozu

V této verzi nedochází k žádnému vyřazení.

Změny chování

Zakázání Stardard_A5 velikosti virtuálního počítače jako hlavního uzlu pro HDInsight 4.0

Hlavní uzel clusteru HDInsight zodpovídá za inicializaci a správu clusteru. Standard_A5 velikost virtuálního počítače má problémy se spolehlivostí jako hlavní uzel pro HDInsight 4.0. Od této verze zákazníci nebudou moct vytvářet nové clustery s velikostí virtuálního počítače Standard_A5 jako hlavní uzel. Můžete použít další dva základní virtuální počítače, jako jsou E2_v3 nebo E2s_v3. Existující clustery se budou spouštět tak, jak jsou. Pro hlavní uzel se důrazně doporučuje čtyřjádrový virtuální počítač, který zajistí vysokou dostupnost a spolehlivost produkčních clusterů HDInsight.

Prostředek síťového rozhraní není viditelný pro clustery spuštěné ve škálovacích sadách virtuálních počítačů Azure

HDInsight se postupně migruje do škálovacích sad virtuálních počítačů Azure. Síťová rozhraní pro virtuální počítače už nejsou viditelná pro zákazníky pro clustery, které používají škálovací sady virtuálních počítačů Azure.

Nadcházející změny

V nadcházejících verzích budou probíhat následující změny.

HDInsight Interactive Query podporuje pouze automatické škálování založené na plánu.

Vzhledem k tomu, že scénáře zákazníků rostou vyspělejší a různorodější, zjistili jsme určitá omezení při automatickém škálování založeném na zatížení interaktivních dotazů (LLAP). Tato omezení jsou způsobená povahou dynamics dotazů LLAP, problémy s přesností budoucích předpovědí zatížení a problémy s redistribucí úloh plánovače LLAP. Vzhledem k těmto omezením můžou uživatelé v clusterech LLAP při povolení automatického škálování vidět pomalejší dotazy. Vliv na výkon může převažovat nad nákladové výhody automatického škálování.

Od července 2021 podporuje úloha Interactive Query v HDInsight pouze automatické škálování založené na plánu. U nových clusterů Interactive Query už nemůžete povolit automatické škálování. Stávající spuštěné clustery můžou dál běžet se známými omezeními popsanými výše.

Microsoft doporučuje přejít na automatické škálování založené na plánu pro LLAP. Aktuální vzor využití clusteru můžete analyzovat prostřednictvím řídicího panelu Grafana Hive. Další informace najdete v tématu Automatické škálování clusterů Azure HDInsight.

Pojmenování hostitele virtuálního počítače se změní 1. července 2021.

HDInsight teď ke zřízení clusteru používá virtuální počítače Azure. Služba se postupně migruje do škálovacích sad virtuálních počítačů Azure. Tato migrace změní formát názvu plně kvalifikovaného názvu domény hostitele clusteru a čísla v názvu hostitele nebudou v posloupnosti zaručená. Pokud chcete získat názvy plně kvalifikovaných názvů domén pro každý uzel, vyhledejte názvy hostitelů uzlů clusteru.

Přechod na škálovací sady virtuálních počítačů Azure

HDInsight teď ke zřízení clusteru používá virtuální počítače Azure. Služba bude postupně migrovat do škálovacích sad virtuálních počítačů Azure. Celý proces může trvat měsíce. Po migraci oblastí a předplatných se nově vytvořené clustery HDInsight budou spouštět ve škálovacích sadách virtuálních počítačů bez akcí zákazníka. Neočekává se žádná změna způsobující chybu.

Datum vydání: 24. 3. 2021

Nové funkce

Spark 3.0 Preview

HDInsight přidal podporu Sparku 3.0.0 do HDInsight 4.0 jako funkci Preview.

Kafka 2.4 Preview

HDInsight přidala podporu Kafka 2.4.1 do HDInsight 4.0 jako funkce Preview.

Eav4-series support

HDInsight přidal Eav4v této verzi podporu -series.

Přechod na škálovací sady virtuálních počítačů Azure

HDInsight teď ke zřízení clusteru používá virtuální počítače Azure. Služba se postupně migruje do škálovacích sad virtuálních počítačů Azure. Celý proces může trvat měsíce. Po migraci oblastí a předplatných se nově vytvořené clustery HDInsight budou spouštět ve škálovacích sadách virtuálních počítačů bez akcí zákazníka. Neočekává se žádná změna způsobující chybu.

Vyřazení z provozu

V této verzi nedochází k žádnému vyřazení.

Změny chování

Výchozí verze clusteru se změní na 4.0.

Výchozí verze clusteru HDInsight se změní z verze 3.6 na 4.0. Další informace o dostupných verzích najdete v tématu Dostupné verze. Přečtěte si další informace o novinkách ve službě HDInsight 4.0.

Výchozí velikosti virtuálních počítačů clusteru se změní na Ev3-series.

Výchozí velikosti virtuálních počítačů clusteru se mění z D-series na Ev3-series. Tato změna platí pro hlavní uzly a pracovní uzly. Pokud se chcete této změně vyhnout, které mají vliv na testované pracovní postupy, zadejte velikosti virtuálních počítačů, které chcete použít v šabloně ARM.

Prostředek síťového rozhraní není viditelný pro clustery spuštěné ve škálovacích sadách virtuálních počítačů Azure

HDInsight se postupně migruje do škálovacích sad virtuálních počítačů Azure. Síťová rozhraní pro virtuální počítače už nejsou viditelná pro zákazníky pro clustery, které používají škálovací sady virtuálních počítačů Azure.

Nadcházející změny

V nadcházejících verzích budou probíhat následující změny.

HDInsight Interactive Query podporuje pouze automatické škálování založené na plánu.

Vzhledem k tomu, že scénáře zákazníků rostou vyspělejší a různorodější, zjistili jsme určitá omezení při automatickém škálování založeném na zatížení interaktivních dotazů (LLAP). Tato omezení jsou způsobená povahou dynamics dotazů LLAP, problémy s přesností budoucích předpovědí zatížení a problémy s redistribucí úloh plánovače LLAP. Vzhledem k těmto omezením můžou uživatelé v clusterech LLAP při povolení automatického škálování vidět pomalejší dotazy. Dopad na výkon může převažovat nad nákladové výhody automatického škálování.

Od července 2021 podporuje úloha Interactive Query v HDInsight pouze automatické škálování založené na plánu. U nových clusterů Interactive Query už nemůžete povolit automatické škálování. Stávající spuštěné clustery můžou dál běžet se známými omezeními popsanými výše.

Microsoft doporučuje přejít na automatické škálování založené na plánu pro LLAP. Aktuální vzor využití clusteru můžete analyzovat prostřednictvím řídicího panelu Grafana Hive. Další informace najdete v tématu Automatické škálování clusterů Azure HDInsight.

Upgrade verze operačního systému

Clustery HDInsight aktuálně běží na Ubuntu 16.04 LTS. Jak je uvedeno v cyklu vydání Ubuntu, jádro Ubuntu 16.04 dosáhne konce životnosti (EOL) v dubnu 2021. V květnu 2021 začneme zavádět novou image clusteru HDInsight 4.0 běžící na Ubuntu 18.04. Nově vytvořené clustery HDInsight 4.0 poběží ve výchozím nastavení na Ubuntu 18.04. Existující clustery na Ubuntu 16.04 budou fungovat stejně jako v plné podpoře.

HDInsight 3.6 bude dál běžet na Ubuntu 16.04. Do 30. června 2021 skončí standardní podpora a od 1. července 2021 se změní na základní podporu. Další informace odatech Ubuntu 18.04 nebude podporováno pro HDInsight 3.6. Pokud chcete používat Ubuntu 18.04, budete muset své clustery migrovat do HDInsight 4.0.

Pokud chcete přesunout existující clustery do Ubuntu 18.04, musíte clustery odstranit a znovu vytvořit. Jakmile bude podpora Ubuntu 18.04 k dispozici, naplánujte vytvoření nebo opětovné vytvoření clusteru. Po zpřístupnění nové image ve všech oblastech pošleme další oznámení.

Důrazně doporučujeme předem otestovat akce skriptů a vlastní aplikace nasazené na hraničních uzlech na virtuálním počítači s Ubuntu 18.04. Virtuální počítač s Ubuntu Linuxem můžete vytvořit na 18.04-LTS a pak vytvořit a použít pár klíčů SSH (Secure Shell) na virtuálním počítači ke spuštění a otestování akcí skriptů a vlastních aplikací nasazených na hraničních uzlech.

Zakázání Stardard_A5 velikosti virtuálního počítače jako hlavního uzlu pro HDInsight 4.0

Hlavní uzel clusteru HDInsight zodpovídá za inicializaci a správu clusteru. Standard_A5 velikost virtuálního počítače má problémy se spolehlivostí jako hlavní uzel pro HDInsight 4.0. Od příští verze v květnu 2021 zákazníci nebudou moct vytvářet nové clustery s velikostí Standard_A5 virtuálních počítačů jako hlavní uzel. Můžete použít i další 2jádrový virtuální počítače, jako jsou E2_v3 nebo E2s_v3. Existující clustery se budou spouštět tak, jak jsou. Virtuální počítač se 4 jádry důrazně doporučuje pro hlavní uzel, aby se zajistila vysoká dostupnost a spolehlivost produkčních clusterů HDInsight.

Opravy chyb

HDInsight nadále vylepšuje spolehlivost a výkon clusteru.

Změna verze komponenty

Přidání podpory pro Spark 3.0.0 a Kafka 2.4.1 ve verzi Preview Aktuální verze komponent pro HDInsight 4.0 a HDInsight 3.6 najdete v tomto dokumentu.

Datum vydání: 2. 5. 2021

Tato verze platí pro HDInsight 3.6 i HDInsight 4.0. Verze HDInsight je dostupná pro všechny oblasti za několik dní. Zde uvedené datum vydání označuje datum vydání první oblasti. Pokud se vám nezobrazují následující změny, počkejte, až bude verze v dané oblasti aktivní za několik dní.

Nové funkce

Podpora řady Dav4

HDInsight v této verzi přidal podporu řady Dav4. Další informace o řady Dav4 najdete tady.

Obecná dostupnost proxy proxy serveru Kafka

Proxy server REST Kafka umožňuje interakci s clusterem Kafka prostřednictvím rozhraní REST API přes HTTPS. Proxy rest Kafka je od této verze obecně dostupné. Další informace o proxy serveru REST Kafka najdete tady.

Přechod na škálovací sady virtuálních počítačů Azure

HDInsight teď ke zřízení clusteru používá virtuální počítače Azure. Služba se postupně migruje do škálovacích sad virtuálních počítačů Azure. Celý proces může trvat měsíce. Po migraci oblastí a předplatných se nově vytvořené clustery HDInsight budou spouštět ve škálovacích sadách virtuálních počítačů bez akcí zákazníka. Neočekává se žádná změna způsobující chybu.

Vyřazení z provozu

Zakázané velikosti virtuálních počítačů

Od 9. ledna 2021 bude HDInsight blokovat všechny zákazníky, kteří vytvářejí clustery pomocí standand_A8, standand_A9, standand_A10 a velikosti virtuálních počítačů standand_A11. Existující clustery se budou spouštět tak, jak jsou. Zvažte přechod na HDInsight 4.0, abyste se vyhnuli potenciálnímu přerušení systému nebo podpory.

Změny chování

Výchozí velikost virtuálního počítače clusteru se změní na Ev3-series

Výchozí velikosti virtuálních počítačů clusteru se změní z D-series na Ev3-series. Tato změna platí pro hlavní uzly a pracovní uzly. Pokud se chcete této změně vyhnout, které mají vliv na testované pracovní postupy, zadejte velikosti virtuálních počítačů, které chcete použít v šabloně ARM.

Prostředek síťového rozhraní není viditelný pro clustery spuštěné ve škálovacích sadách virtuálních počítačů Azure

HDInsight se postupně migruje do škálovacích sad virtuálních počítačů Azure. Síťová rozhraní pro virtuální počítače už nejsou viditelná pro zákazníky pro clustery, které používají škálovací sady virtuálních počítačů Azure.

Nadcházející změny

V nadcházejících verzích budou probíhat následující změny.

Výchozí verze clusteru se změní na 4.0.

Od února 2021 se výchozí verze clusteru HDInsight změní z verze 3.6 na 4.0. Další informace o dostupných verzích najdete v tématu Dostupné verze. Přečtěte si další informace o novinkách ve službě HDInsight 4.0.

Upgrade verze operačního systému

HDInsight upgraduje verzi operačního systému z Ubuntu 16.04 na verzi 18.04. Upgrade bude dokončen před dubnem 2021.

Konec podpory HDInsight 3.6 30. června 2021

HdInsight 3.6 bude ukončena podpora. Od 30. června 2021 nemůžou zákazníci vytvářet nové clustery HDInsight 3.6. Existující clustery budou fungovat stejně jako bez podpory od Microsoftu. Zvažte přechod na HDInsight 4.0, abyste se vyhnuli potenciálnímu přerušení systému nebo podpory.

Změna verze komponenty

Žádná změna verze komponenty pro tuto verzi. Aktuální verze komponent pro HDInsight 4.0 a HDInsight 3.6 najdete v tomto dokumentu.

Datum vydání: 11.18.2020

Tato verze platí pro HDInsight 3.6 i HDInsight 4.0. Verze HDInsight je dostupná pro všechny oblasti za několik dní. Zde uvedené datum vydání označuje datum vydání první oblasti. Pokud se vám nezobrazují následující změny, počkejte, až bude verze v dané oblasti aktivní za několik dní.

Nové funkce

Automatická obměně klíčů pro šifrování neaktivních uložených klíčů spravovaných zákazníkem

Od této verze můžou zákazníci pro šifrování neaktivních uložených klíčů spravovaných zákazníkem používat adresy URL šifrovacích klíčů bez verze Azure KeyValut. HDInsight klíče automaticky otočí, jakmile vyprší jejich platnost nebo se nahradí novými verzemi. Další podrobnosti najdete tady.

Možnost výběru různých velikostí virtuálních počítačů Zookeeper pro Spark, Hadoop a ML Services

HDInsight dříve nepodporuje přizpůsobení velikosti uzlu Zookeeper pro typy clusterů Spark, Hadoop a ML Services. Ve výchozím nastavení se A2_v2/A2 velikosti virtuálních počítačů, které jsou poskytovány zdarma. V této verzi můžete vybrat velikost virtuálního počítače Zookeeper, která je nejvhodnější pro váš scénář. Uzly Zookeeper s jinou velikostí virtuálního počítače než A2_v2/A2 se budou účtovat. virtuální počítače A2_v2 a A2 se stále účtují zdarma.

Přechod na škálovací sady virtuálních počítačů Azure

HDInsight teď ke zřízení clusteru používá virtuální počítače Azure. Od této verze bude služba postupně migrovat do škálovacích sad virtuálních počítačů Azure. Celý proces může trvat měsíce. Po migraci oblastí a předplatných se nově vytvořené clustery HDInsight budou spouštět ve škálovacích sadách virtuálních počítačů bez akcí zákazníka. Neočekává se žádná změna způsobující chybu.

Vyřazení z provozu

Vyřazení clusteru HDInsight 3.6 ML Services

Typ clusteru HDInsight 3.6 ML Services bude ukončen do 31. prosince 2020. Zákazníci nebudou moct po 31. prosinci 2020 vytvářet nové clustery 3.6 ML Services. Existující clustery budou fungovat stejně jako bez podpory od Microsoftu. Tady zkontrolujte vypršení platnosti podpory pro verze HDInsight a typy clusterů.

Zakázané velikosti virtuálních počítačů

Od 16. listopadu 2020 zablokuje HDInsight novým zákazníkům vytváření clusterů pomocí standand_A8, standand_A9, standand_A10 a velikosti virtuálních počítačů standand_A11. Stávající zákazníci, kteří tyto velikosti virtuálních počítačů použili za poslední tři měsíce, nebudou ovlivněni. Od 9. ledna 2021 bude HDInsight blokovat všechny zákazníky, kteří vytvářejí clustery pomocí standand_A8, standand_A9, standand_A10 a velikosti virtuálních počítačů standand_A11. Existující clustery se budou spouštět tak, jak jsou. Zvažte přechod na HDInsight 4.0, abyste se vyhnuli potenciálnímu přerušení systému nebo podpory.

Změny chování

Přidání kontroly pravidel NSG před operací škálování

SLUŽBA HDInsight přidala skupiny zabezpečení sítě (NSG) a uživatelem definované trasy (UDR) při kontrole operace škálování. Stejné ověřování se provádí pro škálování clusteru kromě vytvoření clusteru. Toto ověřování pomáhá zabránit nepředvídatelným chybám. Pokud ověření neprojde, škálování selže. Další informace o tom, jak správně nakonfigurovat skupiny zabezpečení sítě a trasy definované uživatelem, najdete v tématu IP adresy pro správu služby HDInsight.

Změna verze komponenty

Žádná změna verze komponenty pro tuto verzi. Aktuální verze komponent pro HDInsight 4.0 a HDInsight 3.6 najdete v tomto dokumentu.

Datum vydání: 11.9.2020

Tato verze platí pro HDInsight 3.6 i HDInsight 4.0. Verze HDInsight je dostupná pro všechny oblasti za několik dní. Zde uvedené datum vydání označuje datum vydání první oblasti. Pokud se vám nezobrazují následující změny, počkejte, až bude verze v dané oblasti aktivní za několik dní.

Nové funkce

HdInsight Identity Broker (HIB) je teď obecně dostupný.

Služba HDInsight Identity Broker (HIB), která umožňuje ověřování OAuth pro clustery ESP, je teď v této verzi obecně dostupná. Clustery HIB vytvořené po této verzi budou mít nejnovější funkce HIB:

- Vysoká dostupnost

- Podpora vícefaktorového ověřování (MFA)

- Federovaní uživatelé se přihlašují bez synchronizace hodnot hash hesel do AAD-DS. Další informace najdete v dokumentaci HIB.

Přechod na škálovací sady virtuálních počítačů Azure

HDInsight teď ke zřízení clusteru používá virtuální počítače Azure. Od této verze bude služba postupně migrovat do škálovacích sad virtuálních počítačů Azure. Celý proces může trvat měsíce. Po migraci oblastí a předplatných se nově vytvořené clustery HDInsight budou spouštět ve škálovacích sadách virtuálních počítačů bez akcí zákazníka. Neočekává se žádná změna způsobující chybu.

Vyřazení z provozu

Vyřazení clusteru HDInsight 3.6 ML Services

Typ clusteru HDInsight 3.6 ML Services bude ukončen do 31. prosince 2020. Zákazníci nebudou po 31. prosinci 2020 vytvářet nové clustery 3.6 ML Services. Existující clustery budou fungovat stejně jako bez podpory od Microsoftu. Tady zkontrolujte vypršení platnosti podpory pro verze HDInsight a typy clusterů.

Zakázané velikosti virtuálních počítačů