Adatok migrálása az Amazon S3-ból az Azure Storage-ba az Azure Data Factory használatával

A következőkre vonatkozik: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tipp.

Próbálja ki a Data Factoryt a Microsoft Fabricben, amely egy teljes körű elemzési megoldás a nagyvállalatok számára. A Microsoft Fabric az adattovábbítástól az adatelemzésig, a valós idejű elemzésig, az üzleti intelligenciáig és a jelentéskészítésig mindent lefed. Ismerje meg, hogyan indíthat új próbaverziót ingyenesen!

Az Azure Data Factory egy hatékony, robusztus és költséghatékony mechanizmust biztosít az adatok nagy léptékű migrálásához az Amazon S3-ból az Azure Blob Storage-ba vagy az Azure Data Lake Storage Gen2-be. Ez a cikk az alábbi információkat tartalmazza az adatmérnökök és fejlesztők számára:

- Teljesítmény

- Másolási rugalmasság

- Network security

- Magas szintű megoldásarchitektúra

- Ajánlott megvalósítási eljárások

Teljesítmény

Az ADF kiszolgáló nélküli architektúrát kínál, amely lehetővé teszi a párhuzamosságot különböző szinteken, így a fejlesztők olyan folyamatokat hozhatnak létre, amelyek teljes mértékben kihasználják a hálózati sávszélességet és a tárolási IOPS-t, valamint a sávszélességet, hogy maximalizálják az adatáthelyezési átviteli sebességet a környezet számára.

Az ügyfelek sikeresen migráltak több száz millió fájlból álló petabájtnyi adatot az Amazon S3-ból az Azure Blob Storage-ba, 2 GBps-os és magasabb átviteli sebességgel.

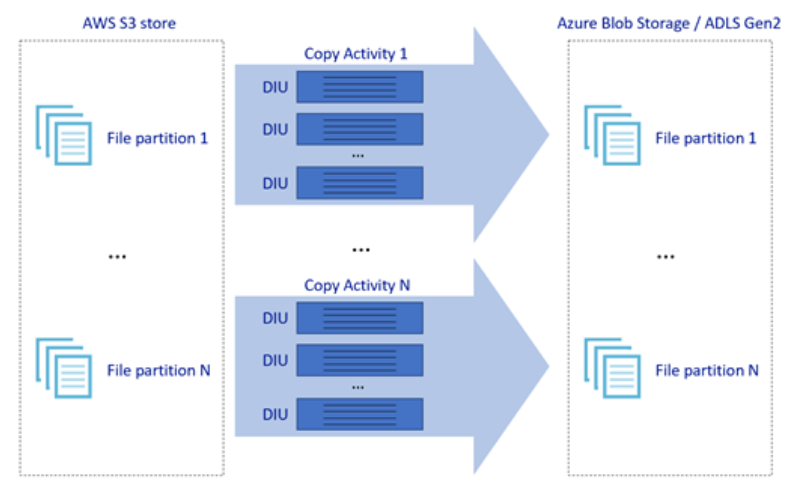

A fenti kép bemutatja, hogyan érhet el nagy adatátviteli sebességet a párhuzamosság különböző szintjein keresztül:

- Az egyetlen másolási tevékenység kihasználhatja a méretezhető számítási erőforrások előnyeit: az Azure Integration Runtime használatakor kiszolgáló nélküli módon legfeljebb 256 DIU-t adhat meg minden másolási tevékenységhez; a saját üzemeltetésű integrációs modul használatakor manuálisan skálázhatja fel a gépet, vagy horizontálisan felskálázhatja több gépre (legfeljebb négy csomópontra), és egyetlen másolási tevékenység minden csomóponton particionálhatja a fájlkészletét.

- Egy másolási tevékenység több szál használatával olvas és ír az adattárba.

- Az ADF-vezérlési folyamat több másolási tevékenységet is elindíthat párhuzamosan, például az Egyes hurkok esetében.

Rugalmasság

Az egyetlen másolási tevékenységen belül az ADF beépített újrapróbálkozási mechanizmussal rendelkezik, amely képes kezelni az adattárakban vagy az alapul szolgáló hálózaton előforduló átmeneti hibák bizonyos szintjét.

Ha bináris másolást végez az S3-ból a Blobba és az S3-ból az ADLS Gen2-be, az ADF automatikusan elvégzi az ellenőrzőpont-ellenőrzést. Ha egy másolási tevékenység futtatása meghiúsult vagy időtúllépés történt, egy későbbi újrapróbálkozáskor a másolás az elejétől kezdve az utolsó hibapontról folytatódik.

Network security

Az ADF alapértelmezés szerint https protokollon keresztül titkosított kapcsolattal továbbítja az adatokat az Amazon S3-ból az Azure Blob Storage-ba vagy az Azure Data Lake Storage Gen2-be. A HTTPS adattitkosítást biztosít az átvitel során, és megakadályozza a lehallgatást és a közbeékelt támadásokat.

Ha nem szeretné, hogy az adatok nyilvános interneten keresztül legyenek átadva, nagyobb biztonságot érhet el az adatok AWS Direct Csatlakozás és az Azure Express Route közötti privát társviszony-létesítési kapcsolaton keresztül történő átvitelével. Tekintse meg a megoldásarchitektúrát a következő szakaszban, amelyből megtudhatja, hogyan érhető el.

Megoldásarchitektúra

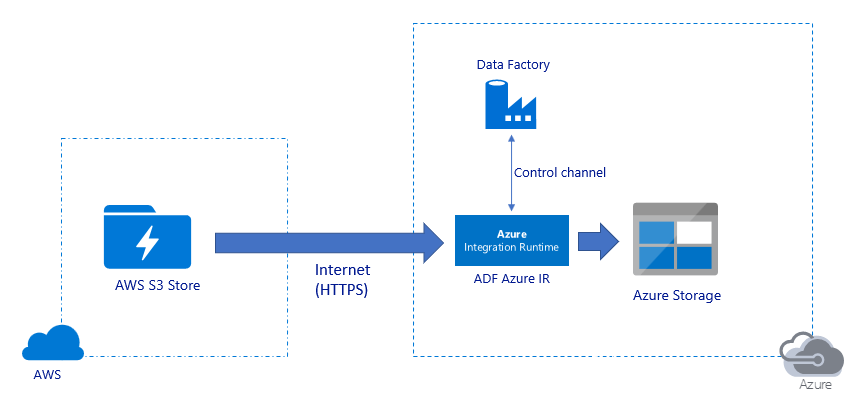

Adatok migrálása nyilvános interneten keresztül:

- Ebben az architektúrában az adatok biztonságos átvitele HTTPS használatával történik nyilvános interneten keresztül.

- A forrás Amazon S3 és a cél Azure Blob Storage vagy az Azure Data Lake Storage Gen2 egyaránt úgy van konfigurálva, hogy engedélyezze az összes hálózati IP-címről érkező forgalmat. Tekintse meg a lap későbbi részében hivatkozott második architektúrát, amelyből megtudhatja, hogyan korlátozhatja a hálózati hozzáférést adott IP-tartományra.

- A kiszolgáló nélküli módon egyszerűen felskálázhatja a lóerő mennyiségét, hogy teljes mértékben kihasználhassa a hálózati és tárolási sávszélességet, így a lehető legjobb átviteli sebességet érheti el a környezetében.

- Ezzel az architektúrával a kezdeti pillanatkép-migrálás és a deltaadat-migrálás is elérhető.

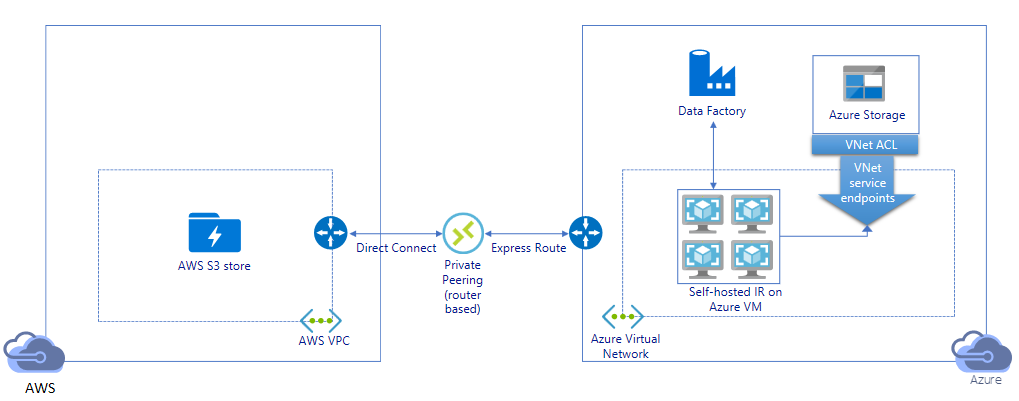

Adatok migrálása privát kapcsolaton keresztül:

- Ebben az architektúrában az adatmigrálás az AWS Direct Csatlakozás és az Azure Express Route közötti privát társviszony-létesítési kapcsolaton keresztül történik, így az adatok soha nem kerülnek át nyilvános interneten keresztül. Az AWS VPC és az Azure Virtual Network használatát igényli.

- Az architektúra eléréséhez telepítenie kell az ADF saját üzemeltetésű integrációs modulját egy Windows rendszerű virtuális gépre az Azure-beli virtuális hálózaton belül. A hálózat és a tároló IOPS-sávszélességének teljes kihasználása érdekében manuálisan skálázhatja fel a saját üzemeltetésű integrációs modul virtuális gépeit, vagy több virtuális gépre (akár négy csomópontra) is felskálázhatja a skálázást.

- Ezzel az architektúrával a kezdeti pillanatkép-adatmigrálás és a deltaadat-migrálás is elérhető.

Ajánlott megvalósítási eljárások

Hitelesítés és hitelesítő adatok kezelése

- Az Amazon S3-fiókban való hitelesítéshez az IAM-fiók hozzáférési kulcsát kell használnia.

- Az Azure Blob Storage-hoz való csatlakozáshoz több hitelesítési típus is támogatott. Az Azure-erőforrások felügyelt identitásainak használata erősen ajánlott: a Microsoft Entra ID-ban automatikusan felügyelt ADF-azonosításra épülve lehetővé teszi a folyamatok konfigurálását anélkül, hogy hitelesítő adatokat ad meg a társított szolgáltatás definíciójában. Másik lehetőségként hitelesítést végezhet az Azure Blob Storage-ban szolgáltatásnév, közös hozzáférésű jogosultságkód vagy tárfiókkulcs használatával.

- Több hitelesítési típus is támogatott az Azure Data Lake Storage Gen2-hez való csatlakozáshoz. Az Azure-erőforrások felügyelt identitásainak használata erősen ajánlott, bár a szolgáltatásnév vagy a tárfiókkulcs is használható.

- Ha nem felügyelt identitásokat használ az Azure-erőforrásokhoz, a hitelesítő adatok Azure Key Vaultban való tárolása erősen ajánlott, hogy az ADF-hez társított szolgáltatások módosítása nélkül egyszerűbbé tegye a kulcsok központi kezelését és elforgatását. Ez a CI/CD egyik ajánlott eljárása is.

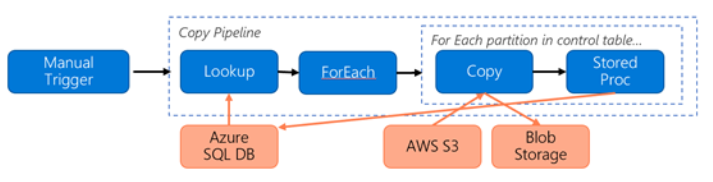

Kezdeti pillanatképadatok migrálása

Az adatpartíció különösen 100 TB-nál több adat áttelepítése esetén ajánlott. Az adatok particionálásához használja az "előtag" beállítást az Amazon S3 mappáinak és fájljainak név szerinti szűréséhez, majd minden ADF-másolási feladat egyszerre egy partíciót másolhat. A jobb átviteli sebesség érdekében egyszerre több ADF másolási feladatot is futtathat.

Ha bármelyik másolási feladat hálózati vagy adattárbeli átmeneti probléma miatt meghiúsul, újrafuttathatja a sikertelen másolási feladatot, hogy újra betöltse az adott partíciót az AWS S3-ból. A többi partíciót betöltő másolási feladatok nem lesznek hatással.

Delta-adatok migrálása

Az AWS S3-ból származó új vagy módosított fájlok azonosításának leghatékonyabb módja az időparticionált elnevezési konvenciók használata – ha az AWS S3-ban lévő adatok időszeletelési adatokkal vannak particionálva a fájl vagy mappa neve (például /yyyy/mm/dd/file.csv), akkor a folyamat könnyen azonosíthatja, hogy mely fájlokat/mappákat másolja növekményesen.

Ha az AWS S3-ban lévő adatok nincsenek idő particionálva, az ADF képes azonosítani az új vagy módosított fájlokat a LastModifiedDate alapján. Úgy működik, hogy az ADF az AWS S3 összes fájlját megvizsgálja, és csak az új és frissített fájlt másolja ki, amelynek utolsó módosított időbélyege nagyobb, mint egy bizonyos érték. Ha nagy számú fájl található az S3-ban, a kezdeti fájlvizsgálat hosszú időt vehet igénybe, függetlenül attól, hogy hány fájl felel meg a szűrőfeltételnek. Ebben az esetben javasoljuk, hogy először particionálja az adatokat ugyanazzal az előtag-beállítással a pillanatképek kezdeti áttelepítéséhez, hogy a fájlvizsgálat párhuzamosan történjen.

Saját üzemeltetésű integrációs futtatókörnyezetet igénylő forgatókönyvek esetén az Azure-beli virtuális gépen

Akár privát kapcsolaton keresztül migrálja az adatokat, akár egy adott IP-tartományt szeretne engedélyezni az Amazon S3 tűzfalon, telepítenie kell a saját üzemeltetésű integrációs modult az Azure Windows rendszerű virtuális gépen.

- Az egyes Azure-beli virtuális gépekhez javasolt konfiguráció Standard_D32s_v3 32 vCPU-val és 128 GB memóriával. Az adatmigrálás során folyamatosan monitorozhatja az integrációs modul virtuális gépének processzor- és memóriakihasználtságát, így ellenőrizheti, hogy tovább kell-e skáláznia a virtuális gépet a jobb teljesítmény érdekében, vagy leskálázhatja a virtuális gépet a költségek megtakarítása érdekében.

- A vertikális felskálázáshoz akár négy virtuálisgép-csomópontot is társíthat egyetlen saját üzemeltetésű integrációs modullal. A saját üzemeltetésű integrációs modulon futó egyetlen másolási feladat automatikusan particionálja a fájlkészletet, és az összes virtuálisgép-csomópont használatával párhuzamosan másolja a fájlokat. A magas rendelkezésre állás érdekében javasoljuk, hogy két virtuálisgép-csomóponttal kezdje, hogy elkerülje az adatmigrálás során előforduló egyetlen meghibásodási pontot.

Sebességkorlátozás

Ajánlott eljárásként végezzen egy teljesítmény-POC-t egy reprezentatív mintaadatkészlettel, hogy meg tudja határozni a megfelelő partícióméretet.

Kezdje egyetlen partícióval és egyetlen másolási tevékenységgel az alapértelmezett DIU-beállítással. Fokozatosan növelje a DIU-beállítást, amíg el nem éri a hálózat sávszélességkorlátját vagy az adattárak IOPS/sávszélességkorlátját, vagy elérte az egy másolási tevékenységhez engedélyezett maximális 256 DIU-t.

Ezután fokozatosan növelje az egyidejű másolási tevékenységek számát, amíg el nem éri a környezet korlátait.

Ha az ADF másolási tevékenysége által jelentett szabályozási hibák jelentkeznek, csökkentse az egyidejűséget vagy a DIU-beállítást az ADF-ben, vagy fontolja meg a hálózat és az adattárak sávszélesség-/IOPS-korlátainak növelését.

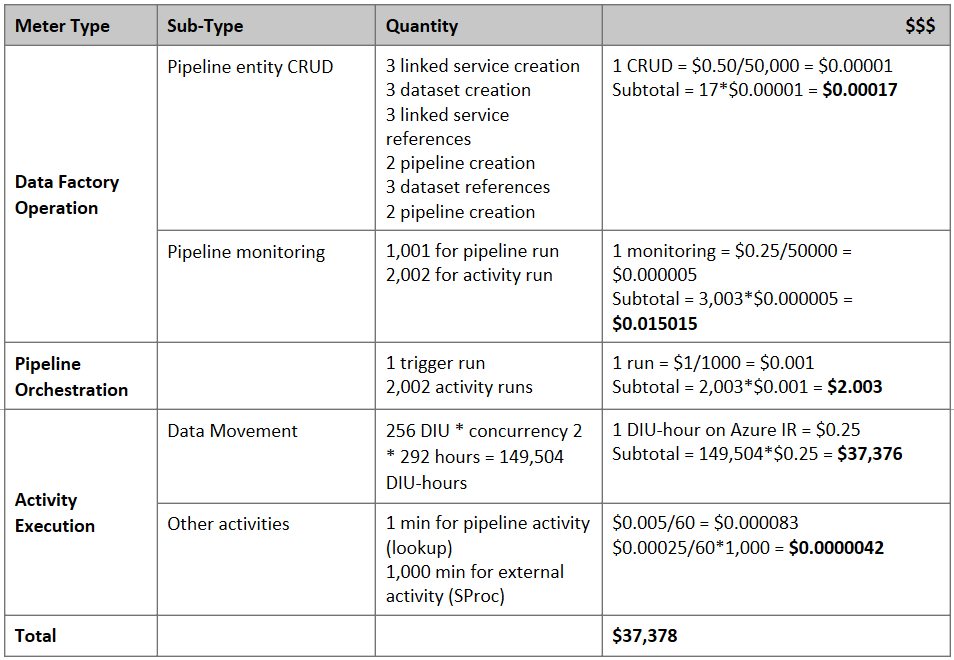

Ár becslése

Megjegyzés:

Ez egy hipotetikus díjszabási példa. A tényleges díjszabás a környezet tényleges átviteli sebességétől függ.

Fontolja meg az adatok S3-ból Azure Blob Storage-ba való migrálásához létrehozott alábbi folyamatot:

Tegyük fel a következőket:

- A teljes adatmennyiség 2 PB

- Adatok migrálása HTTPS-en keresztül az első megoldásarchitektúra használatával

- A 2 PB 1 KB partícióra van osztva, és minden másolat egy partíciót helyez át

- Minden másolat diu=256-tal van konfigurálva, és 1 GBps átviteli sebességet ér el

- A ForEach egyidejűsége 2, az összesített átviteli sebesség pedig 2 GBps

- A migrálás befejezése összesen 292 órát vesz igénybe

Íme a becsült ár a fenti feltételezések alapján:

További referenciák

- Amazon Simple Storage Service-összekötő

- Azure Blob Storage-összekötő

- Azure Data Lake Storage Gen2-összekötő

- Copy tevékenység teljesítmény finomhangolási útmutatója

- Saját üzemeltetésű integrációs modul létrehozása és konfigurálása

- Saját üzemeltetésű integrációs modul – HA és méretezhetőség

- Adatáthelyezési biztonsági szempontok

- Hitelesítő adatok tárolása az Azure Key Vaultban

- Fájl növekményes másolása az időparticionált fájlnév alapján

- Új és módosított fájlok másolása a LastModifiedDate alapján

- Az ADF díjszabási oldala

Sablon

Íme a sablon , amely az Amazon S3-ból az Azure Data Lake Storage Gen2-be több száz millió fájlból álló petabájtos adatok migrálását ismerteti.