Copiare dati da PostgreSQL usando Azure Data Factory o Synapse Analytics (legacy)

SI APPLICA A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Suggerimento

Provare Data Factory in Microsoft Fabric, una soluzione di analisi all-in-one per le aziende. Microsoft Fabric copre tutto, dallo spostamento dati al data science, all'analisi in tempo reale, alla business intelligence e alla creazione di report. Vedere le informazioni su come iniziare una nuova prova gratuita!

Questo articolo illustra come usare l'attività di copia nelle pipeline di Azure Data Factory e Synapse Analytics per copiare dati da un database PostgreSQL. Si basa sull'articolo di panoramica dell'attività di copia che presenta una panoramica generale sull'attività di copia.

Importante

Il nuovo connettore PostgreSQL offre un supporto postgreSQL nativo migliorato. Se si usa il connettore PostgreSQL legacy nella soluzione, aggiornare il connettore PostgreSQL prima del 31 ottobre 2024. Per informazioni dettagliate sulla differenza tra la versione legacy e quella più recente, vedere questa sezione .

Funzionalità supportate

Questo connettore PostgreSQL è supportato per le funzionalità seguenti:

| Funzionalità supportate | IR |

|---|---|

| attività Copy (source/-) | (1) (2) |

| Attività Lookup | (1) (2) |

(1) Runtime di integrazione di Azure (2) Runtime di integrazione self-hosted

Per un elenco degli archivi dati supportati come origini/sink dall'attività di copia, vedere la tabella relativa agli archivi dati supportati.

In particolare, questo connettore PostgreSQL supporta la versione 7.4 e le versioni successive di PostgreSQL.

Prerequisiti

Se l'archivio dati si trova all'interno di una rete locale, una rete virtuale di Azure o un cloud privato virtuale di Amazon, è necessario configurare un runtime di integrazione self-hosted per connettersi.

Se l'archivio dati è un servizio dati cloud gestito, è possibile usare Azure Integration Runtime. Se l'accesso è limitato agli indirizzi IP approvati nelle regole del firewall, è possibile aggiungere indirizzi IP del runtime di integrazione di Azure all'elenco elementi consentiti.

È anche possibile usare la funzionalità di runtime di integrazione della rete virtuale gestita in Azure Data Factory per accedere alla rete locale senza installare e configurare un runtime di integrazione self-hosted.

Per altre informazioni sui meccanismi di sicurezza di rete e sulle opzioni supportate da Data Factory, vedere strategie di accesso ai dati.

Il runtime di integrazione offre un driver PostgreSQL predefinito a partire dalla versione 3.7 e non è quindi necessario installare manualmente alcun driver.

Introduzione

Per eseguire l'attività di copia con una pipeline, è possibile usare uno degli strumenti o SDK seguenti:

- Strumento Copia dati

- Il portale di Azure

- .NET SDK

- The Python SDK

- Azure PowerShell

- The REST API

- Modello di Azure Resource Manager

Creare un servizio collegato a PostgreSQL usando l'interfaccia utente

Usare la procedura seguente per creare un servizio collegato a PostgreSQL nell'interfaccia utente di portale di Azure.

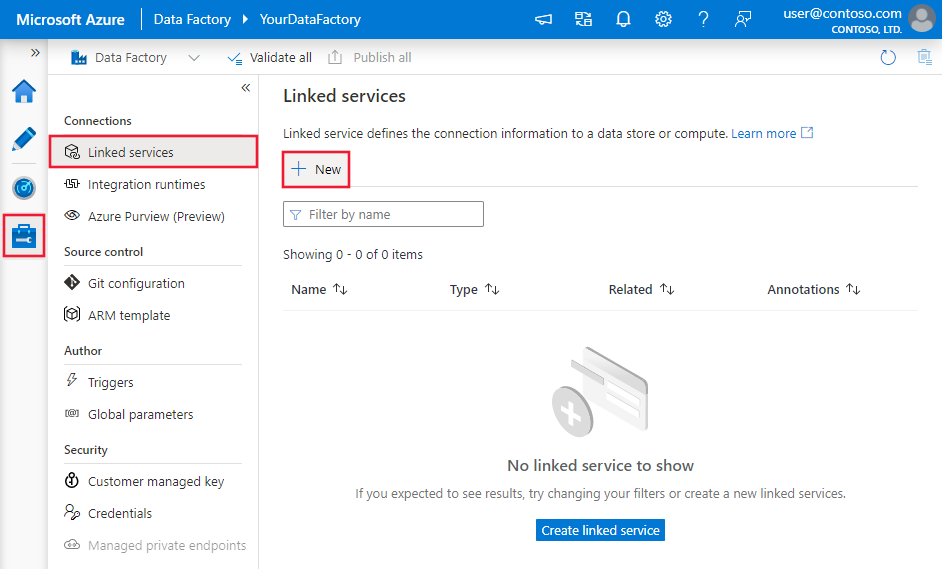

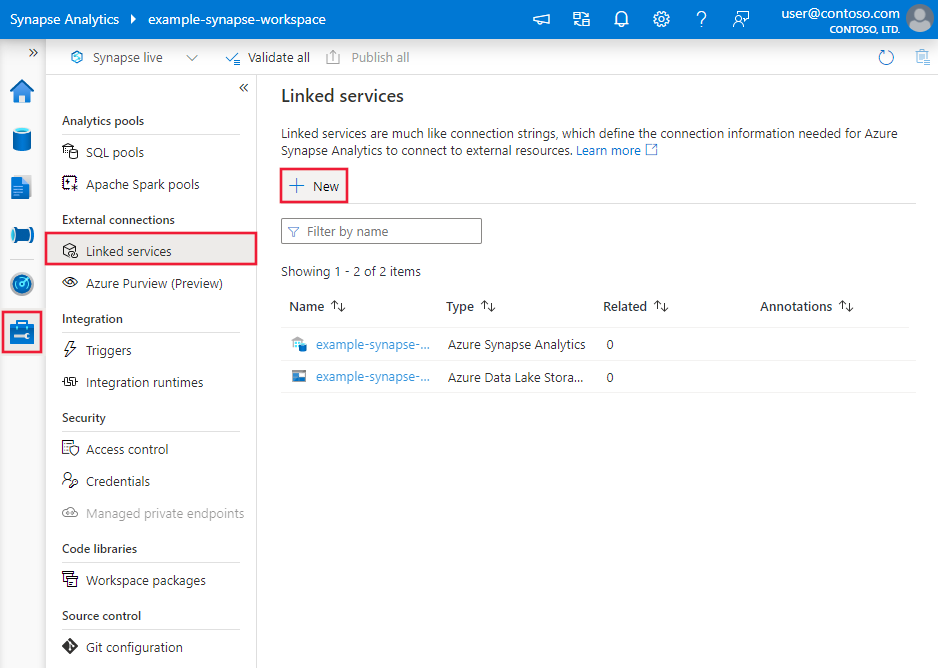

Passare alla scheda Gestisci nell'area di lavoro di Azure Data Factory o Synapse e selezionare Servizi collegati, quindi fare clic su Nuovo:

Cercare Postgre e selezionare il connettore PostgreSQL.

Configurare i dettagli del servizio, testare la connessione e creare il nuovo servizio collegato.

Dettagli di configurazione di Connessione or

Le sezioni seguenti riportano informazioni dettagliate sulle proprietà che vengono usate per definire entità di data factory specifiche per il connettore PostgreSQL.

Proprietà del servizio collegato

Per il servizio collegato di PostgreSQL sono supportate le proprietà seguenti:

| Proprietà | Descrizione | Richiesto |

|---|---|---|

| type | La proprietà type deve essere impostata su PostgreSql | Sì |

| connectionString | Stringa di connessione ODBC per la connessione al Database di Azure per PostgreSQL. È anche possibile inserire la password in Azure Key Vault ed eseguire lo spostamento forzato dei dati della configurazione password all'esterno della stringa di connessione. Vedere gli esempi seguenti e l'articolo Archiviare le credenziali in Azure Key Vault per altri dettagli. |

Sì |

| connectVia | Il runtime di integrazione da usare per la connessione all'archivio dati. Per altre informazioni, vedere la sezione Prerequisiti. Se non specificato, viene usato il runtime di integrazione di Azure predefinito. | No |

Una stringa di connessione tipica è Server=<server>;Database=<database>;Port=<port>;UID=<username>;Password=<Password>. Altre proprietà che è possibile impostare per il case:

| Proprietà | Descrizione | Opzioni | Richiesto |

|---|---|---|---|

| EncryptionMethod (EM) | Il metodo usato dal driver per crittografare i dati inviati tra il driver e il server di database. Ad esempio, EncryptionMethod=<0/1/6>; |

0 (Nessuna crittografia) (impostazione predefinita) / 1 (SSL) / 6 (RequestSSL) | No |

| ValidateServerCertificate (VSC) | Determina se il driver convalida il certificato inviato dal server di database quando è abilitata la crittografia SSL (metodo di crittografia = 1). Ad esempio, ValidateServerCertificate=<0/1>; |

0 (disabilitato) (impostazione predefinita) / 1 (abilitato) | No |

Nota

Per avere la verifica SSL completa tramite la connessione ODBC quando si usa il runtime di integrazione self-hosted, è necessario usare una connessione di tipo ODBC anziché il connettore PostgreSQL in modo esplicito e completare la configurazione seguente:

- Configurare il DSN in qualsiasi server SHIR.

- Inserire il certificato appropriato per PostgreSQL in C:\Windows\ServiceProfiles\DIAHostService\AppData\Roaming\postgresql\root.crt nei server SHIR. In questo caso, il driver ODBC cerca > il certificato SSL da verificare quando si connette al database.

- Nella connessione data factory usare una connessione di tipo ODBC, con il stringa di connessione che punta al DSN creato nei server SHIR.

Esempio:

{

"name": "PostgreSqlLinkedService",

"properties": {

"type": "PostgreSql",

"typeProperties": {

"connectionString": "Server=<server>;Database=<database>;Port=<port>;UID=<username>;Password=<Password>"

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Esempio: archiviare la password in Azure Key Vault

{

"name": "PostgreSqlLinkedService",

"properties": {

"type": "PostgreSql",

"typeProperties": {

"connectionString": "Server=<server>;Database=<database>;Port=<port>;UID=<username>;",

"password": {

"type": "AzureKeyVaultSecret",

"store": {

"referenceName": "<Azure Key Vault linked service name>",

"type": "LinkedServiceReference"

},

"secretName": "<secretName>"

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Il servizio collegato PostgreSQL con il payload seguente è ancora supportato senza modifiche, ma è consigliato l'uso del nuovo per il futuro.

Payload precedente:

{

"name": "PostgreSqlLinkedService",

"properties": {

"type": "PostgreSql",

"typeProperties": {

"server": "<server>",

"database": "<database>",

"username": "<username>",

"password": {

"type": "SecureString",

"value": "<password>"

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Proprietà del set di dati

Per un elenco completo delle sezioni e delle proprietà disponibili per la definizione di set di dati, vedere l'articolo sui set di dati. Questa sezione presenta un elenco delle proprietà supportate dal set di dati di PostgreSQL.

Per copiare dati da PostgreSQL, sono supportate le proprietà seguenti:

| Proprietà | Descrizione | Richiesto |

|---|---|---|

| type | La proprietà type del set di dati deve essere impostata su: PostgreSqlTable | Sì |

| schema | Nome dello schema. | No (se nell'origine dell'attività è specificato "query") |

| table | Nome della tabella. | No (se nell'origine dell'attività è specificato "query") |

| tableName | Nome della tabella con schema. Questa proprietà è supportata per garantire la compatibilità con le versioni precedenti. Per i nuovi carichi di lavoro, usare schema e table. |

No (se nell'origine dell'attività è specificato "query") |

Esempio

{

"name": "PostgreSQLDataset",

"properties":

{

"type": "PostgreSqlTable",

"typeProperties": {},

"schema": [],

"linkedServiceName": {

"referenceName": "<PostgreSQL linked service name>",

"type": "LinkedServiceReference"

}

}

}

Se si usa RelationalTable un set di dati tipizzato, è ancora supportato così come è, mentre si consiglia di usare quello nuovo in futuro.

Proprietà dell'attività di copia

Per un elenco completo delle sezioni e delle proprietà disponibili per la definizione delle attività, vedere l'articolo sulle pipeline. Questa sezione presenta un elenco delle proprietà supportate dall'origine PostgreSQL.

PostgreSQL come origine

Per copiare dati da PostgreSQL, nella sezione origine dell'attività di copia sono supportate le proprietà seguenti:

| Proprietà | Descrizione | Richiesto |

|---|---|---|

| type | La proprietà type dell'origine dell'attività di copia deve essere impostata su: PostgreSqlSource | Sì |

| query | Usare la query SQL personalizzata per leggere i dati. Ad esempio: "query": "SELECT * FROM \"MySchema\".\"MyTable\"". |

No (se nel set di dati è specificato "tableName") |

Nota

I nomi di schemi e tabelle fanno distinzione tra maiuscole e minuscole. Racchiudere i nomi tra "" (virgolette doppie) nella query.

Esempio:

"activities":[

{

"name": "CopyFromPostgreSQL",

"type": "Copy",

"inputs": [

{

"referenceName": "<PostgreSQL input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "PostgreSqlSource",

"query": "SELECT * FROM \"MySchema\".\"MyTable\""

},

"sink": {

"type": "<sink type>"

}

}

}

]

L'origine tipizzata RelationalSource è ancora supportata senza modifiche, ma è consigliato l'uso della nuova per il futuro.

Proprietà dell'attività Lookup

Per altre informazioni sulle proprietà, vedere Attività Lookup.

Contenuto correlato

Per un elenco degli archivi dati supportati come origini e sink dall'attività di copia, vedere archivi dati supportati.

Commenti e suggerimenti

Presto disponibile: Nel corso del 2024 verranno gradualmente disattivati i problemi di GitHub come meccanismo di feedback per il contenuto e ciò verrà sostituito con un nuovo sistema di feedback. Per altre informazioni, vedere https://aka.ms/ContentUserFeedback.

Invia e visualizza il feedback per