Copiare dati da Amazon RDS per SQL Server usando Azure Data Factory o Azure Synapse Analytics

Questo articolo illustra come usare l'attività di copia in Azure Data Factory e nelle pipeline di Azure Synapse per copiare dati da Amazon RDS per il database di SQL Server. Per altre informazioni, vedere l'articolo introduttivo per Azure Data Factory o Azure Synapse Analytics.

Funzionalità supportate

Questo connettore Amazon RDS per SQL Server è supportato per le funzionalità seguenti:

| Funzionalità supportate | IR |

|---|---|

| attività Copy (source/-) | (1) (2) |

| Attività Lookup | (1) (2) |

| Attività GetMetadata | (1) (2) |

| Attività stored procedure | (1) (2) |

(1) Runtime di integrazione di Azure (2) Runtime di integrazione self-hosted

Per un elenco degli archivi dati supportati come origini o sink dall'attività di copia, vedere la tabella relativa agli archivi dati supportati.

In particolare, questo connettore Amazon RDS per SQL Server supporta:

- SQL Server versione 2005 e successive.

- La copia dei dati tramite l'autenticazione di SQL o di Windows.

- Come origine, il recupero dei dati tramite una query SQL o una stored procedure. Per informazioni dettagliate, è anche possibile scegliere di eseguire la copia parallela da Amazon RDS per l'origine di SQL Server. Per informazioni dettagliate, vedere la sezione Copia parallela dal database SQL.

Sql Server Express Local DB non è supportato.

Prerequisiti

Se l'archivio dati si trova all'interno di una rete locale, una rete virtuale di Azure o un cloud privato virtuale di Amazon, è necessario configurare un runtime di integrazione self-hosted per connettersi.

Se l'archivio dati è un servizio dati cloud gestito, è possibile usare Azure Integration Runtime. Se l'accesso è limitato agli indirizzi IP approvati nelle regole del firewall, è possibile aggiungere indirizzi IP del runtime di integrazione di Azure all'elenco elementi consentiti.

È anche possibile usare la funzionalità di runtime di integrazione della rete virtuale gestita in Azure Data Factory per accedere alla rete locale senza installare e configurare un runtime di integrazione self-hosted.

Per altre informazioni sui meccanismi di sicurezza di rete e sulle opzioni supportate da Data Factory, vedere strategie di accesso ai dati.

Operazioni preliminari

Per eseguire l'attività di copia con una pipeline, è possibile usare uno degli strumenti o SDK seguenti:

- Strumento Copia dati

- Il portale di Azure

- .NET SDK

- The Python SDK

- Azure PowerShell

- The REST API

- Modello di Azure Resource Manager

Creare un servizio collegato Amazon RDS per SQL Server usando l'interfaccia utente

Usare la procedura seguente per creare un servizio collegato Amazon RDS per SQL Server nell'interfaccia utente di portale di Azure.

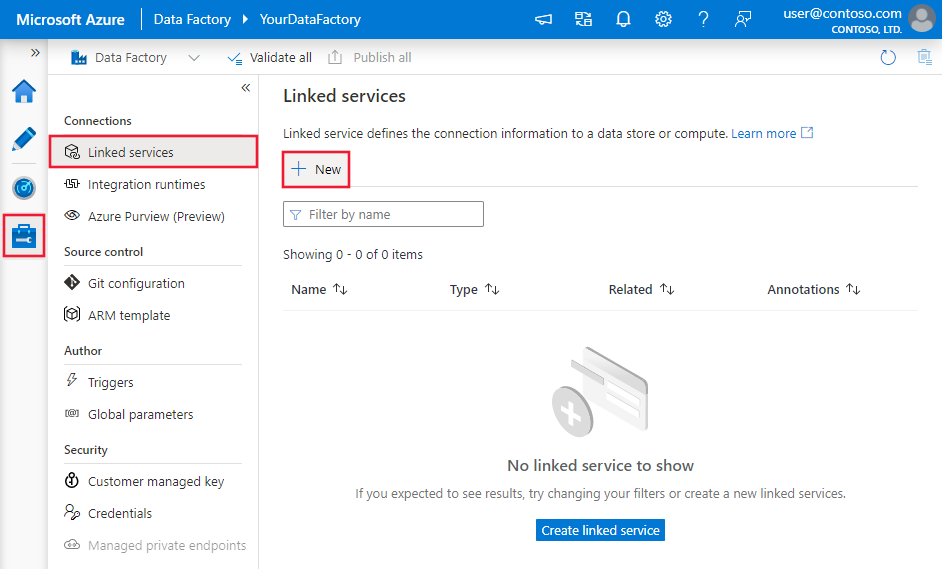

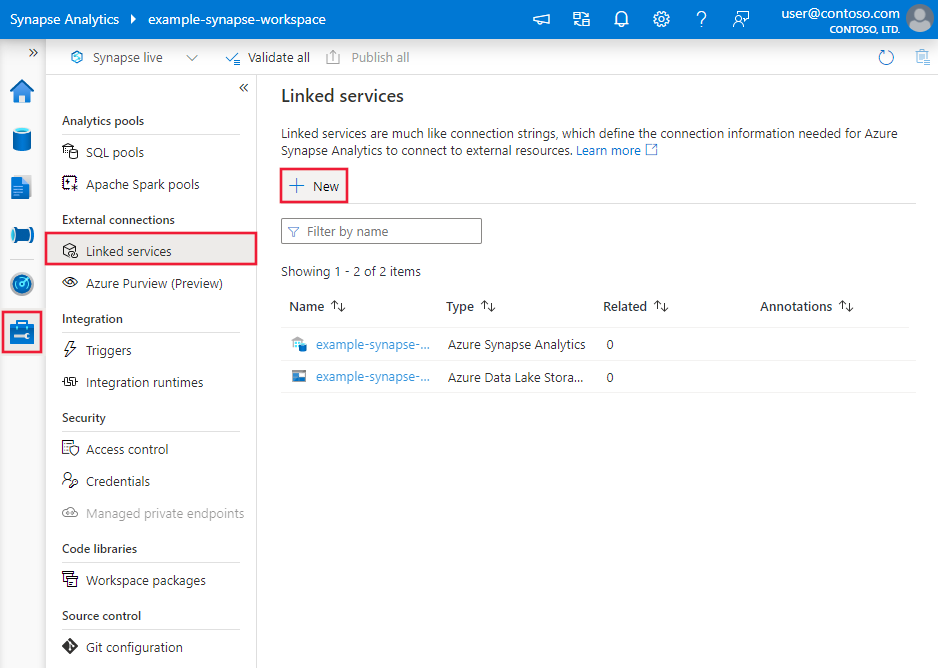

Passare alla scheda Gestisci nell'area di lavoro di Azure Data Factory o Synapse e selezionare Servizi collegati, quindi fare clic su Nuovo:

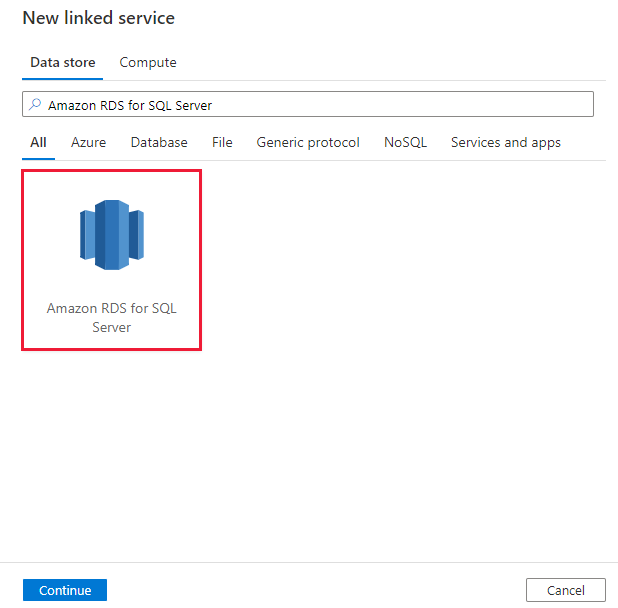

Cercare Amazon RDS per SQL Server e selezionare il connettore Amazon RDS per SQL Server.

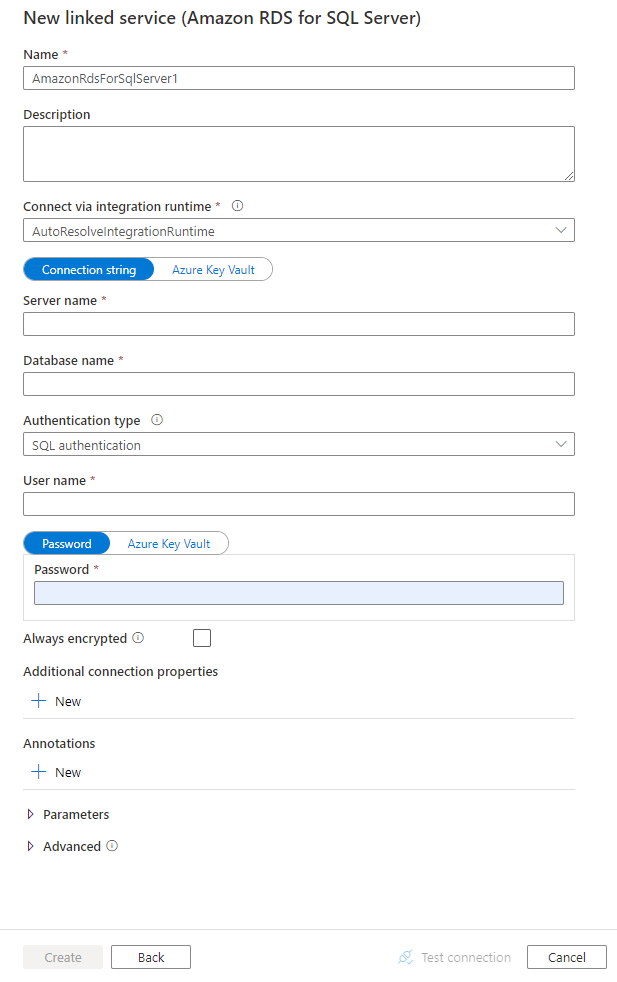

Configurare i dettagli del servizio, testare la connessione e creare il nuovo servizio collegato.

Dettagli di configurazione di Connessione or

Le sezioni seguenti forniscono informazioni dettagliate sulle proprietà usate per definire entità della pipeline di Data Factory e Synapse specifiche per il connettore di database Amazon RDS per SQL Server.

Proprietà del servizio collegato

Per il servizio collegato Amazon RDS per SQL Server sono supportate le proprietà seguenti:

| Proprietà | Descrizione | Richiesto |

|---|---|---|

| type | La proprietà type deve essere impostata su AmazonRdsForSqlServer. | Sì |

| connectionString | Specificare le informazioni connectionString necessarie per connettersi al database Amazon RDS per SQL Server usando l'autenticazione SQL o autenticazione di Windows. Vedere gli esempi seguenti. È anche possibile inserire una password in Azure Key Vault. Se si tratta dell'autenticazione SQL, estrarre la password configurazione dal stringa di connessione. Per altre informazioni, vedere l'esempio JSON che segue la tabella e Archiviare le credenziali in Azure Key Vault. |

Sì |

| userName | Specificare un nome utente se si usa autenticazione di Windows. Un esempio è domainname\username. | No |

| password | Specificare una password per l'account utente specificato per il nome utente. Contrassegnare questo campo come SecureString per archiviarlo in modo sicuro. In alternativa, fare riferimento a un segreto archiviato in Azure Key Vault. | No |

| alwaysEncrypted Impostazioni | Specificare le informazioni alwaysencryptedsettings necessarie per abilitare Always Encrypted per proteggere i dati sensibili archiviati in Amazon RDS per SQL Server usando l'identità gestita o l'entità servizio. Per altre informazioni, vedere l'esempio JSON che segue la tabella e la sezione Uso di Always Encrypted . Se non specificato, l'impostazione predefinita è sempre crittografata è disabilitata. | No |

| connectVia | Questo runtime di integrazione viene usato per connettersi all'archivio dati. Per altre informazioni, vedere la sezione Prerequisiti. Se non specificato, viene usato il runtime di integrazione di Azure predefinito. | No |

Nota

Amazon RDS per SQL Server Always Encrypted non è supportato nel flusso di dati.

Suggerimento

Se si verifica un errore con il codice di errore "UserErrorFailedTo Connessione ToSqlServer" e un messaggio simile a "Il limite di sessione per il database è XXX ed è stato raggiunto", aggiungere Pooling=false al stringa di connessione e riprovare.

Esempio 1: Usare l'autenticazione SQL

{

"name": "AmazonSqlLinkedService",

"properties": {

"type": "AmazonRdsForSqlServer",

"typeProperties": {

"connectionString": "Data Source=<servername>\\<instance name if using named instance>;Initial Catalog=<databasename>;Integrated Security=False;User ID=<username>;Password=<password>;"

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Esempio 2: Usare l'autenticazione SQL con una password in Azure Key Vault

{

"name": "AmazonSqlLinkedService",

"properties": {

"type": "AmazonRdsForSqlServer",

"typeProperties": {

"connectionString": "Data Source=<servername>\\<instance name if using named instance>;Initial Catalog=<databasename>;Integrated Security=False;User ID=<username>;",

"password": {

"type": "AzureKeyVaultSecret",

"store": {

"referenceName": "<Azure Key Vault linked service name>",

"type": "LinkedServiceReference"

},

"secretName": "<secretName>"

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Esempio 3: Usare autenticazione di Windows

{

"name": "AmazonSqlLinkedService",

"properties": {

"type": "AmazonRdsForSqlServer",

"typeProperties": {

"connectionString": "Data Source=<servername>\\<instance name if using named instance>;Initial Catalog=<databasename>;Integrated Security=True;",

"userName": "<domain\\username>",

"password": {

"type": "SecureString",

"value": "<password>"

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Esempio 4: Usare Always Encrypted

{

"name": "AmazonSqlLinkedService",

"properties": {

"type": "AmazonRdsForSqlServer",

"typeProperties": {

"connectionString": "Data Source=<servername>\\<instance name if using named instance>;Initial Catalog=<databasename>;Integrated Security=False;User ID=<username>;Password=<password>;"

},

"alwaysEncryptedSettings": {

"alwaysEncryptedAkvAuthType": "ServicePrincipal",

"servicePrincipalId": "<service principal id>",

"servicePrincipalKey": {

"type": "SecureString",

"value": "<service principal key>"

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Proprietà del set di dati

Per un elenco completo delle sezioni e delle proprietà disponibili per la definizione di set di dati, vedere l'articolo sui set di dati. Questa sezione fornisce un elenco delle proprietà supportate dal set di dati Amazon RDS per SQL Server.

Per copiare dati da un database Amazon RDS per SQL Server, sono supportate le proprietà seguenti:

| Proprietà | Descrizione | Richiesto |

|---|---|---|

| type | La proprietà type del set di dati deve essere impostata su AmazonRdsForSqlServerTable. | Sì |

| schema | Nome dello schema. | No |

| table | Nome della tabella/vista. | No |

| tableName | Nome della tabella/vista con schema. Questa proprietà è supportata per garantire la compatibilità con le versioni precedenti. Per i nuovi carichi di lavoro, usare schema e table. |

No |

Esempio

{

"name": "AmazonRdsForSQLServerDataset",

"properties":

{

"type": "AmazonRdsForSqlServerTable",

"linkedServiceName": {

"referenceName": "<Amazon RDS for SQL Server linked service name>",

"type": "LinkedServiceReference"

},

"schema": [ < physical schema, optional, retrievable during authoring > ],

"typeProperties": {

"schema": "<schema_name>",

"table": "<table_name>"

}

}

}

Proprietà dell'attività di copia

Per un elenco completo delle sezioni e delle proprietà disponibili per definire le attività, vedere l'articolo sulle pipeline. Questa sezione fornisce un elenco delle proprietà supportate dall'origine Amazon RDS per SQL Server.

Amazon RDS per SQL Server come origine

Suggerimento

Per caricare i dati da Amazon RDS per SQL Server in modo efficiente usando il partizionamento dei dati, vedere Copia parallela dal database SQL.

Per copiare dati da Amazon RDS per SQL Server, impostare il tipo di origine nell'attività di copia su AmazonRdsForSqlServerSource. Nella sezione source dell'attività di copia sono supportate le proprietà seguenti:

| Proprietà | Descrizione | Richiesto |

|---|---|---|

| type | La proprietà type dell'origine dell'attività di copia deve essere impostata su AmazonRdsForSqlServerSource. | Sì |

| sqlReaderQuery | Usare la query SQL personalizzata per leggere i dati. Un esempio è select * from MyTable. |

No |

| sqlReaderStoredProcedureName | Questa proprietà definisce il nome della stored procedure che legge i dati dalla tabella di origine. L'ultima istruzione SQL deve essere un'istruzione SELECT nella stored procedure. | No |

| storedProcedureParameters | Questi parametri sono relativi alla stored procedure. I valori consentiti sono coppie nome-valore. I nomi e le maiuscole/minuscole dei parametri devono corrispondere ai nomi e alla combinazione di maiuscole e minuscole dei parametri della stored procedure. |

No |

| isolationLevel | Specifica il comportamento di blocco della transazione per l'origine SQL. I valori consentiti sono: ReadCommitted, ReadUncommitted, RepeatableRead, Serializable, Snapshot. Se non specificato, viene utilizzato il livello di isolamento predefinito del database. Per altre informazioni dettagliate, vedere questo documento. | No |

| partitionOptions | Specifica le opzioni di partizionamento dei dati usate per caricare dati da Amazon RDS per SQL Server. I valori consentiti sono: Nessuno (impostazione predefinita), PhysicalPartitionsOfTable e DynamicRange. Quando un'opzione di partizione è abilitata ( ovvero , non None), il grado di parallelismo per caricare simultaneamente i dati da Amazon RDS per SQL Server è controllato dall'impostazione nell'attività parallelCopies di copia. |

No |

| partitionSettings | Specifica il gruppo di impostazioni per il partizionamento dei dati. Applicare quando l'opzione di partizione non Noneè . |

No |

In partitionSettings: |

||

| partitionColumnName | Specificare il nome della colonna di origine nel tipo integer o date/datetime (int, smallint, datebigint, smalldatetimedatetimedatetime2, o datetimeoffset) che verrà usato dal partizionamento dell'intervallo per la copia parallela. Se non specificato, l'indice o la chiave primaria della tabella vengono rilevati automaticamente e usati come colonna di partizione.Si applica quando l'opzione di partizione è DynamicRange. Se si usa una query per recuperare i dati di origine, associare ?DfDynamicRangePartitionCondition nella clausola WHERE. Per un esempio, vedere la sezione Copia parallela dal database SQL. |

No |

| partitionUpperBound | Valore massimo della colonna di partizione per la suddivisione dell'intervallo di partizioni. Questo valore viene usato per decidere lo stride della partizione, non per filtrare le righe nella tabella. Tutte le righe nella tabella o nel risultato della query verranno partizionate e copiate. Se non specificato, l'attività di copia rileva automaticamente il valore. Si applica quando l'opzione di partizione è DynamicRange. Per un esempio, vedere la sezione Copia parallela dal database SQL. |

No |

| partitionLowerBound | Valore minimo della colonna di partizione per la suddivisione dell'intervallo di partizioni. Questo valore viene usato per decidere lo stride della partizione, non per filtrare le righe nella tabella. Tutte le righe nella tabella o nel risultato della query verranno partizionate e copiate. Se non specificato, l'attività di copia rileva automaticamente il valore. Si applica quando l'opzione di partizione è DynamicRange. Per un esempio, vedere la sezione Copia parallela dal database SQL. |

No |

Tenere presente quanto segue:

- Se sqlReaderQuery viene specificato per AmazonRdsForSqlServerSource, l'attività di copia esegue questa query sull'origine Amazon RDS per SQL Server per ottenere i dati. In alternativa, è possibile specificare una stored procedure indicando i parametri sqlReaderStoredProcedureName e storedProcedureParameters, se la stored procedure accetta parametri.

- Quando si usa la stored procedure nell'origine per recuperare i dati, si noti se la stored procedure è progettata come restituzione di uno schema diverso quando viene passato un valore di parametro diverso, è possibile che si verifichi un errore o si verifichi un risultato imprevisto durante l'importazione dello schema dall'interfaccia utente o quando si copiano dati nel database SQL con la creazione automatica della tabella.

Esempio: Usare una query SQL

"activities":[

{

"name": "CopyFromAmazonRdsForSQLServer",

"type": "Copy",

"inputs": [

{

"referenceName": "<Amazon RDS for SQL Server input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "AmazonRdsForSqlServerSource",

"sqlReaderQuery": "SELECT * FROM MyTable"

},

"sink": {

"type": "<sink type>"

}

}

}

]

Esempio: Usare una stored procedure

"activities":[

{

"name": "CopyFromAmazonRdsForSQLServer",

"type": "Copy",

"inputs": [

{

"referenceName": "<Amazon RDS for SQL Server input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "AmazonRdsForSqlServerSource",

"sqlReaderStoredProcedureName": "CopyTestSrcStoredProcedureWithParameters",

"storedProcedureParameters": {

"stringData": { "value": "str3" },

"identifier": { "value": "$$Text.Format('{0:yyyy}', <datetime parameter>)", "type": "Int"}

}

},

"sink": {

"type": "<sink type>"

}

}

}

]

Definizione della stored procedure

CREATE PROCEDURE CopyTestSrcStoredProcedureWithParameters

(

@stringData varchar(20),

@identifier int

)

AS

SET NOCOUNT ON;

BEGIN

select *

from dbo.UnitTestSrcTable

where dbo.UnitTestSrcTable.stringData != stringData

and dbo.UnitTestSrcTable.identifier != identifier

END

GO

Copia parallela dal database SQL

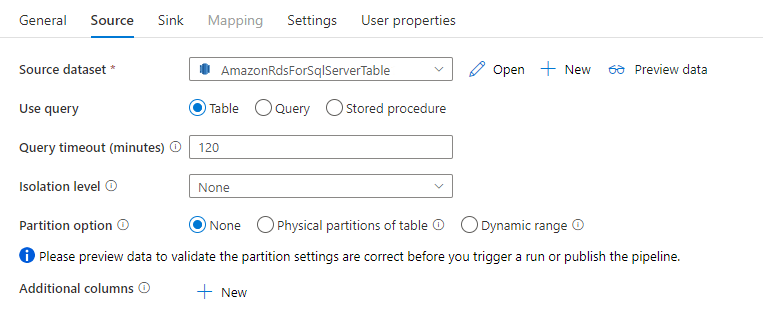

Il connettore Amazon RDS per SQL Server nell'attività di copia fornisce il partizionamento dei dati predefinito per copiare i dati in parallelo. È possibile trovare le opzioni di partizionamento dei dati nella scheda Origine dell'attività di copia.

Quando si abilita la copia partizionata, l'attività di copia esegue query parallele sull'origine Amazon RDS per SQL Server per caricare i dati in base alle partizioni. Il grado di parallelismo è controllato dall'impostazione parallelCopies sull'attività di copia. Ad esempio, se si imposta parallelCopies su quattro, il servizio genera e esegue simultaneamente quattro query in base all'opzione e alle impostazioni di partizione specificate e ogni query recupera una parte di dati da Amazon RDS per SQL Server.

È consigliabile abilitare la copia parallela con il partizionamento dei dati, in particolare quando si caricano grandi quantità di dati da Amazon RDS per SQL Server. Di seguito sono riportate le configurazioni consigliate per i diversi scenari: Quando si copiano dati in un archivio dati basato su file, è consigliabile scrivere in una cartella come più file (specificare solo il nome della cartella), nel qual caso le prestazioni sono migliori rispetto alla scrittura in un singolo file.

| Scenario | Impostazioni consigliate |

|---|---|

| Caricamento completo da tabelle di grandi dimensioni, con partizioni fisiche. | Opzione di partizione: partizioni fisiche della tabella. Durante l'esecuzione, il servizio rileva automaticamente le partizioni fisiche e copia i dati in base alle partizioni. Per verificare se la tabella contiene o meno una partizione fisica, è possibile fare riferimento a questa query. |

| Caricamento completo da una tabella di grandi dimensioni, senza partizioni fisiche, mentre con una colonna integer o datetime per il partizionamento dei dati. | Opzioni di partizione: partizione intervallo dinamico. Colonna di partizione (facoltativa): specificare la colonna usata per partizionare i dati. Se non specificato, viene utilizzata la colonna chiave primaria. Limite superiore della partizione e limite inferiore della partizione (facoltativo): specificare se si desidera determinare lo stride della partizione. Non si tratta di filtrare le righe nella tabella, tutte le righe della tabella verranno partizionate e copiate. Se non specificato, l'attività di copia rileva automaticamente i valori e può richiedere molto tempo a seconda dei valori MIN e MAX. È consigliabile specificare un limite superiore e un limite inferiore. Ad esempio, se la colonna di partizione "ID" ha valori compresi tra 1 e 100 e si imposta il limite inferiore su 20 e il limite superiore come 80, con copia parallela come 4, il servizio recupera i dati rispettivamente per 4 partizioni - ID nell'intervallo <=20, [21, 50], [51, 80]e >=81. |

| Caricare una grande quantità di dati usando una query personalizzata, senza partizioni fisiche, mentre con una colonna integer o date/datetime per il partizionamento dei dati. | Opzioni di partizione: partizione intervallo dinamico. Query: SELECT * FROM <TableName> WHERE ?DfDynamicRangePartitionCondition AND <your_additional_where_clause>.Colonna di partizione: specificare la colonna usata per partizionare i dati. Limite superiore della partizione e limite inferiore della partizione (facoltativo): specificare se si desidera determinare lo stride della partizione. Non si tratta di filtrare le righe nella tabella, tutte le righe nel risultato della query verranno partizionate e copiate. Se non specificato, l'attività di copia rileva automaticamente il valore. Ad esempio, se la colonna di partizione "ID" include valori compresi tra 1 e 100 e si imposta il limite inferiore su 20 e il limite superiore come 80, con copia parallela come 4, il servizio recupera i dati per 4 partizioni- ID nell'intervallo <=20, [21, 50], [51, 80], e >=81 rispettivamente. Di seguito sono riportate altre query di esempio per diversi scenari: 1. Eseguire una query sull'intera tabella: SELECT * FROM <TableName> WHERE ?DfDynamicRangePartitionCondition2. Eseguire una query da una tabella con la selezione di colonne e filtri aggiuntivi della clausola where: SELECT <column_list> FROM <TableName> WHERE ?DfDynamicRangePartitionCondition AND <your_additional_where_clause>3. Eseguire una query con sottoquery: SELECT <column_list> FROM (<your_sub_query>) AS T WHERE ?DfDynamicRangePartitionCondition AND <your_additional_where_clause>4. Eseguire una query con la partizione nella sottoquery: SELECT <column_list> FROM (SELECT <your_sub_query_column_list> FROM <TableName> WHERE ?DfDynamicRangePartitionCondition) AS T |

Procedure consigliate per caricare i dati con l'opzione di partizione:

- Scegliere una colonna distintiva come colonna di partizione (ad esempio chiave primaria o chiave univoca) per evitare l'asimmetria dei dati.

- Se la tabella include una partizione predefinita, usare l'opzione di partizione "Partizioni fisiche della tabella" per ottenere prestazioni migliori.

- Se si usa Azure Integration Runtime per copiare i dati, è possibile impostare unità di Integrazione dei dati (DIU) di dimensioni maggiori (>4) per usare più risorse di calcolo. Controllare gli scenari applicabili.

- "Grado di parallelismo di copia" controlla i numeri di partizione, impostando questo numero troppo grande a volte le prestazioni, è consigliabile impostare questo numero come (DIU o numero di nodi del runtime di integrazione self-hosted) * (da 2 a 4).

Esempio: caricamento completo da una tabella di grandi dimensioni con partizioni fisiche

"source": {

"type": "AmazonRdsForSqlServerSource",

"partitionOption": "PhysicalPartitionsOfTable"

}

Esempio: query con partizione a intervalli dinamici

"source": {

"type": "AmazonRdsForSqlServerSource",

"query": "SELECT * FROM <TableName> WHERE ?DfDynamicRangePartitionCondition AND <your_additional_where_clause>",

"partitionOption": "DynamicRange",

"partitionSettings": {

"partitionColumnName": "<partition_column_name>",

"partitionUpperBound": "<upper_value_of_partition_column (optional) to decide the partition stride, not as data filter>",

"partitionLowerBound": "<lower_value_of_partition_column (optional) to decide the partition stride, not as data filter>"

}

}

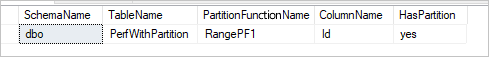

Query di esempio per controllare la partizione fisica

SELECT DISTINCT s.name AS SchemaName, t.name AS TableName, pf.name AS PartitionFunctionName, c.name AS ColumnName, iif(pf.name is null, 'no', 'yes') AS HasPartition

FROM sys.tables AS t

LEFT JOIN sys.objects AS o ON t.object_id = o.object_id

LEFT JOIN sys.schemas AS s ON o.schema_id = s.schema_id

LEFT JOIN sys.indexes AS i ON t.object_id = i.object_id

LEFT JOIN sys.index_columns AS ic ON ic.partition_ordinal > 0 AND ic.index_id = i.index_id AND ic.object_id = t.object_id

LEFT JOIN sys.columns AS c ON c.object_id = ic.object_id AND c.column_id = ic.column_id

LEFT JOIN sys.partition_schemes ps ON i.data_space_id = ps.data_space_id

LEFT JOIN sys.partition_functions pf ON pf.function_id = ps.function_id

WHERE s.name='[your schema]' AND t.name = '[your table name]'

Se la tabella ha una partizione fisica, viene visualizzato "HasPartition" come "sì" come illustrato di seguito.

Proprietà dell'attività Lookup

Per altre informazioni sulle proprietà, vedere Attività Lookup.

Proprietà dell'attività GetMetadata

Per altre informazioni sulle proprietà, vedere Attività GetMetadata

Uso di Always Encrypted

Quando si copiano dati da/in Amazon RDS per SQL Server con Always Encrypted, seguire questa procedura:

Archiviare la chiave master della colonna in un insieme di credenziali delle chiavi di Azure. Altre informazioni su come configurare Always Encrypted con Azure Key Vault

Assicurarsi di concedere l'accesso all'insieme di credenziali delle chiavi in cui è archiviata la chiave master della colonna . Per le autorizzazioni necessarie, vedere questo articolo .

Creare un servizio collegato per connettersi al database SQL e abilitare la funzione "Always Encrypted" usando l'identità gestita o l'entità servizio.

Risolvere i problemi di connessione

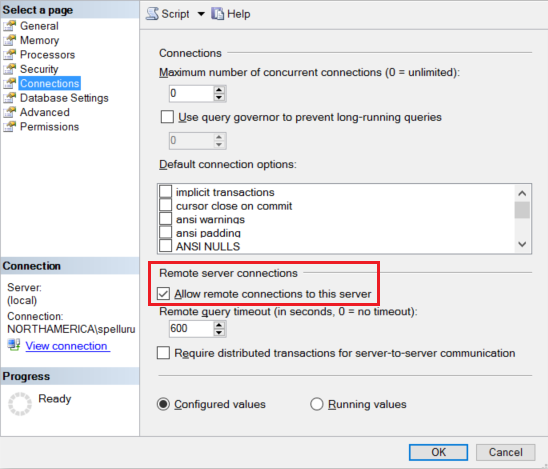

Configurare l'istanza di Amazon RDS per SQL Server per accettare connessioni remote. Avviare Amazon RDS per SQL Server Management Studio, fare clic con il pulsante destro del mouse sul server e scegliere Proprietà. Selezionare Connessione ions dall'elenco e selezionare la casella di controllo Consenti connessioni remote a questo server.

Per i passaggi dettagliati, vedere Configurare l'opzione di configurazione del server di accesso remoto.

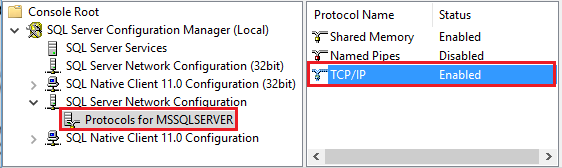

Avviare Amazon RDS per Gestione configurazione SQL Server. Espandere Amazon RDS per Configurazione di rete di SQL Server per l'istanza desiderata e selezionare Protocolli per MSSQL edizione Standard RVER. I protocolli vengono visualizzati nel riquadro destro. Abilitare TCP/IP facendo clic con il pulsante destro del mouse su TCP/IP e scegliendo Abilita.

Per altre informazioni e modi alternativi per abilitare il protocollo TCP/IP, vedere Abilitare o disabilitare un protocollo di rete del server.

Nella stessa finestra fare doppio clic su TCP/IP per avviare la finestra Proprietà TCP/IP.

Passare alla scheda Indirizzi IP. Scorrere verso il basso per visualizzare la sezione IPAll . Annotare la porta TCP. Il valore predefinito è 1433.

Creare una regola per Windows Firewall nel computer per consentire il traffico in ingresso attraverso questa porta.

Verificare la connessione: per connettersi ad Amazon RDS per SQL Server usando un nome completo, usare Amazon RDS per SQL Server Management Studio da un computer diverso. Un esempio è

"<machine>.<domain>.corp.<company>.com,1433".

Contenuto correlato

Per un elenco degli archivi dati supportati come origini e sink dall'attività di copia, vedere Archivi dati supportati.