Copiare dati da o verso Azure Data Lake Archiviazione Gen1 usando Azure Data Factory o Azure Synapse Analytics

SI APPLICA A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Suggerimento

Provare Data Factory in Microsoft Fabric, una soluzione di analisi completa per le aziende. Microsoft Fabric copre tutti gli elementi, dallo spostamento dei dati all'analisi scientifica dei dati, all'analisi in tempo reale, alla business intelligence e alla creazione di report. Scopri come avviare gratuitamente una nuova versione di valutazione .

Questo articolo illustra come copiare dati da e in Azure Data Lake Storage Gen1. Per altre informazioni, vedere l'articolo introduttivo per Azure Data Factory o Azure Synapse Analytics.

Funzionalità supportate

Questo connettore azure Data Lake Archiviazione Gen1 è supportato per le funzionalità seguenti:

| Funzionalità supportate | IR |

|---|---|

| Attività di copia (origine/sink) | ① ② |

| Flusso di dati di mapping (origine/sink) | ① |

| Attività Lookup | ① ② |

| Attività GetMetadata | ① ② |

| Attività Delete | ① ② |

(1) Runtime di integrazione di Azure (2) Runtime di integrazione self-hosted

In particolare, con il connettore è possibile eseguire queste operazioni:

- Copia di file tramite uno dei seguenti metodi di autenticazione, ovvero entità servizio o identità gestite per le risorse di Azure.

- Copia di file così come sono o analisi o generazione di file con i formati di file e i codec di compressione supportati.

- Mantenimento degli elenchi di controllo di accesso durante la copia in Azure Data Lake Storage Gen2.

Importante

Se si copiano dati tramite il runtime di integrazione self-hosted, configurare il firewall aziendale in modo da consentire il traffico in uscita verso <ADLS account name>.azuredatalakestore.net e login.microsoftonline.com/<tenant>/oauth2/token sulla porta 443. Quest'ultimo è il servizio token di sicurezza di Azure con cui deve comunicare il runtime di integrazione per ottenere il token di accesso.

Introduzione

Suggerimento

Per una procedura dettagliata su come usare il connettore Azure Data Lake Storage, vedere Caricare i dati in Azure Data Lake Storage.

Per eseguire l'attività di copia con una pipeline, è possibile usare uno degli strumenti o SDK seguenti:

- Strumento Copia dati

- Il portale di Azure

- .NET SDK

- The Python SDK

- Azure PowerShell

- The REST API

- Modello di Azure Resource Manager

Creare un servizio collegato ad Azure Data Lake Archiviazione Gen1 usando l'interfaccia utente

Usare la procedura seguente per creare un servizio collegato ad Azure Data Lake Archiviazione Gen1 nell'interfaccia utente di portale di Azure.

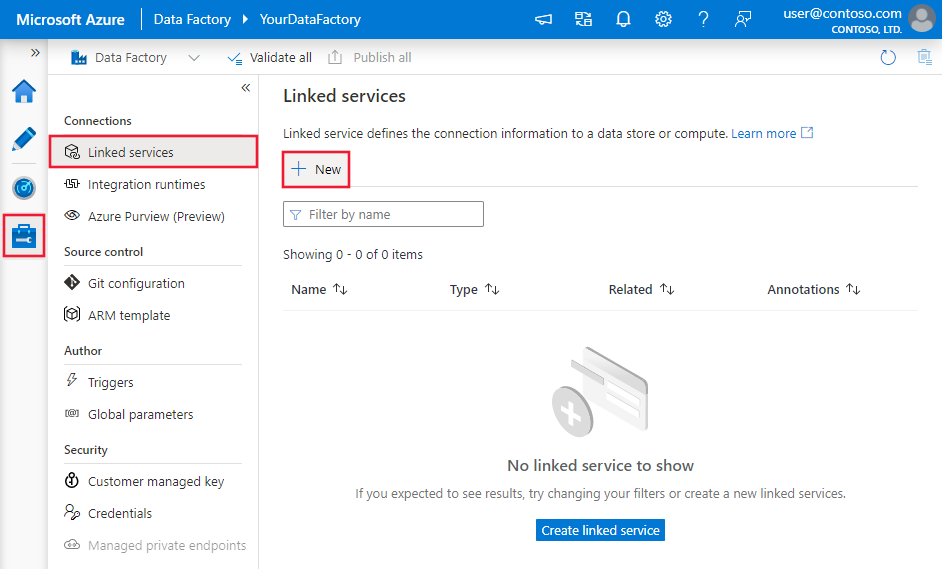

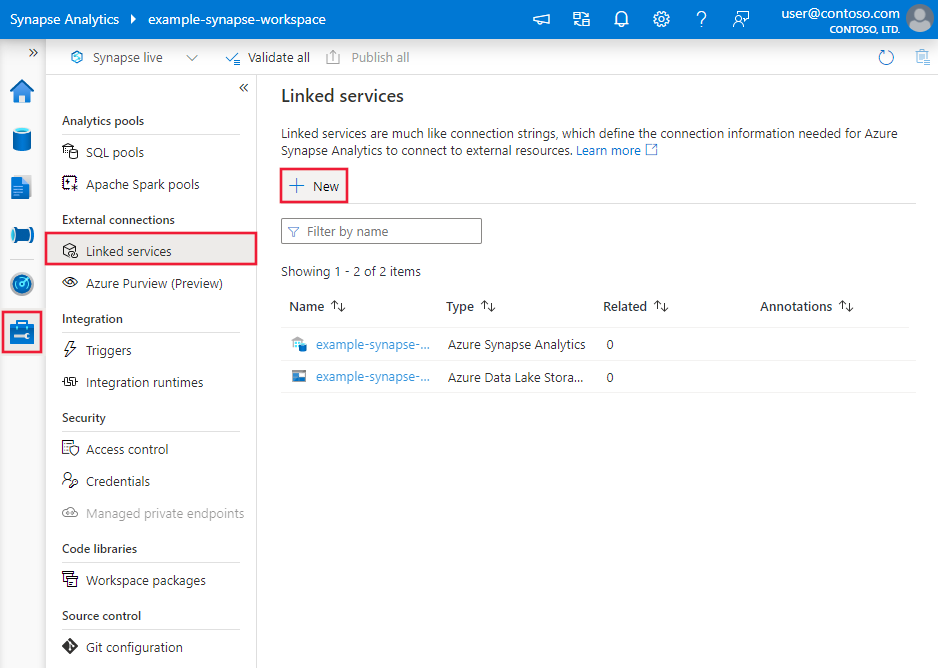

Passare alla scheda Gestisci nell'area di lavoro di Azure Data Factory o Synapse e selezionare Servizi collegati, quindi selezionare Nuovo:

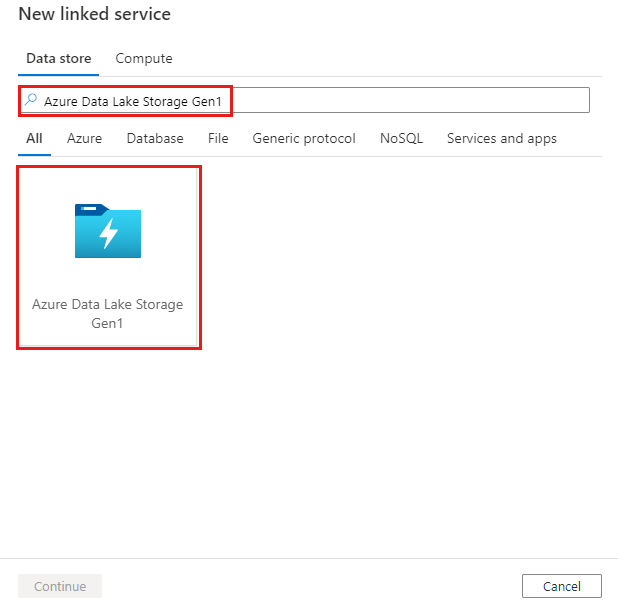

Cercare Azure Data Lake Archiviazione Gen1 e selezionare il connettore Azure Data Lake Archiviazione Gen1.

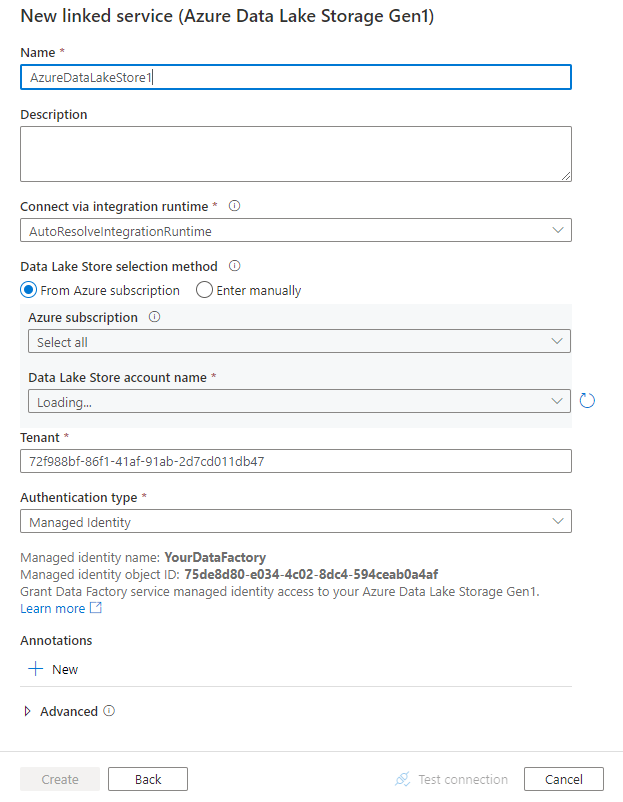

Configurare i dettagli del servizio, testare la connessione e creare il nuovo servizio collegato.

Dettagli di configurazione di Connessione or

Le sezioni seguenti forniscono informazioni sulle proprietà usate per definire entità specifiche di Azure Data Lake Store Gen1.

Proprietà del servizio collegato

Per il servizio collegato ad Azure Data Lake Store sono supportate le proprietà seguenti:

| Proprietà | Descrizione | Richiesto |

|---|---|---|

| Tipo | La proprietà type deve essere impostata su AzureDataLakeStore. |

Sì |

| dataLakeStoreUri | Informazioni sull'account Azure Data Lake Store. Queste informazioni accettano uno dei seguenti formati: https://[accountname].azuredatalakestore.net/webhdfs/v1 o adl://[accountname].azuredatalakestore.net/. |

Sì |

| subscriptionId | ID sottoscrizione di Azure a cui l'account Data Lake Store appartiene. | Richiesto per il sink |

| resourceGroupName | Nome del gruppo di risorse di Azure a cui l'account Data Lake Store appartiene. | Richiesto per il sink |

| connectVia | Runtime di integrazione da usare per la connessione all'archivio dati. È possibile usare Azure Integration Runtime o un runtime di integrazione self-hosted (se l'archivio dati si trova in una rete privata). Se questa proprietà non è specificata, come valore predefinito viene usato Azure Integration Runtime. | No |

Usare l'autenticazione basata su entità servizio

Per usare l'autenticazione basata sull'entità servizio, eseguire queste operazioni.

Registrare un'entità applicazione in Microsoft Entra ID e concedere l'accesso a Data Lake Store. Per la procedura dettaglia, vedere Autenticazione da servizio a servizio. Prendere nota dei valori seguenti che si usano per definire il servizio collegato:

- ID applicazione

- Chiave applicazione

- ID tenant

Concedere all'entità servizio l'autorizzazione appropriata. Per gli esempi di funzionamento dell'autorizzazione in Data Lake Storage Gen1, vedere Controllo di accesso in Azure Data Lake Storage Gen1.

- Come origine: in Accesso a Esplora dati>concedere almeno l'autorizzazione Esegui per TUTTE le cartelle upstream, inclusa la radice, insieme all'autorizzazione Lettura per i file da copiare. È possibile scegliere di aggiungere a Questa cartella e tutti gli elementi figlio come ricorsiva, e aggiungere come una voce di autorizzazione di accesso e una voce di autorizzazione predefinita. Non è presente alcun requisito per il controllo di accesso a livello di account (IAM).

- Come sink: in Accesso a Esplora dati>concedere almeno l'autorizzazione Esegui per TUTTE le cartelle upstream, inclusa la radice, insieme all'autorizzazione Di scrittura per la cartella sink. È possibile scegliere di aggiungere a Questa cartella e tutti gli elementi figlio come ricorsiva, e aggiungere come una voce di autorizzazione di accesso e una voce di autorizzazione predefinita.

Sono supportate le proprietà seguenti:

| Proprietà | Descrizione | Richiesto |

|---|---|---|

| servicePrincipalId | Specificare l'ID client dell'applicazione. | Sì |

| servicePrincipalKey | Specificare la chiave dell'applicazione. Contrassegnare questo campo come oggetto SecureString per archiviarlo in modo sicuro o fare riferimento a un segreto archiviato in Azure Key Vault. |

Sì |

| tenant | Specificare le informazioni sul tenant, ad esempio nome di dominio o ID tenant, in cui si trova l'applicazione. È possibile recuperarlo passando il cursore del mouse sull'angolo superiore destro del portale di Azure. | Sì |

| azureCloudType | Per l'autenticazione dell'entità servizio, specificare il tipo di ambiente cloud di Azure a cui è registrata l'applicazione Microsoft Entra. I valori consentiti sono AzurePublic, AzureChina, AzureUsGovernment e AzureGermany. Per impostazione predefinita, viene usato l'ambiente cloud del servizio. |

No |

Esempio:

{

"name": "AzureDataLakeStoreLinkedService",

"properties": {

"type": "AzureDataLakeStore",

"typeProperties": {

"dataLakeStoreUri": "https://<accountname>.azuredatalakestore.net/webhdfs/v1",

"servicePrincipalId": "<service principal id>",

"servicePrincipalKey": {

"type": "SecureString",

"value": "<service principal key>"

},

"tenant": "<tenant info, e.g. microsoft.onmicrosoft.com>",

"subscriptionId": "<subscription of ADLS>",

"resourceGroupName": "<resource group of ADLS>"

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Usare l'autenticazione dell'identità gestita assegnata dal sistema

Una data factory o un'area di lavoro di Synapse può essere associata a un'identità gestita assegnata dal sistema, che rappresenta il servizio per l'autenticazione. È possibile usare direttamente questa identità gestita assegnata dal sistema per l'autenticazione di Data Lake Store, analogamente all'uso della propria entità servizio. Consente a questa risorsa designata di accedere e copiare dati da o verso Data Lake Store.

Per usare l'autenticazione dell'identità gestita assegnata dal sistema, seguire questa procedura.

Recuperare le informazioni sull'identità gestita assegnata dal sistema copiando il valore di "ID applicazione identità del servizio" generato insieme all'area di lavoro factory o Synapse.

Concedere all'identità gestita assegnata dal sistema l'accesso a Data Lake Store. Per gli esempi di funzionamento dell'autorizzazione in Data Lake Storage Gen1, vedere Controllo di accesso in Azure Data Lake Storage Gen1.

- Come origine: in Accesso a Esplora dati>concedere almeno l'autorizzazione Esegui per TUTTE le cartelle upstream, inclusa la radice, insieme all'autorizzazione Lettura per i file da copiare. È possibile scegliere di aggiungere a Questa cartella e tutti gli elementi figlio come ricorsiva, e aggiungere come una voce di autorizzazione di accesso e una voce di autorizzazione predefinita. Non è presente alcun requisito per il controllo di accesso a livello di account (IAM).

- Come sink: in Accesso a Esplora dati>concedere almeno l'autorizzazione Esegui per TUTTE le cartelle upstream, inclusa la radice, insieme all'autorizzazione Di scrittura per la cartella sink. È possibile scegliere di aggiungere a Questa cartella e tutti gli elementi figlio come ricorsiva, e aggiungere come una voce di autorizzazione di accesso e una voce di autorizzazione predefinita.

Non è necessario specificare proprietà diverse dalle informazioni generali di Data Lake Store nel servizio collegato.

Esempio:

{

"name": "AzureDataLakeStoreLinkedService",

"properties": {

"type": "AzureDataLakeStore",

"typeProperties": {

"dataLakeStoreUri": "https://<accountname>.azuredatalakestore.net/webhdfs/v1",

"subscriptionId": "<subscription of ADLS>",

"resourceGroupName": "<resource group of ADLS>"

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Usare l'autenticazione dell'identità gestita assegnata dall'utente

Una data factory può essere assegnata con una o più identità gestite assegnate dall'utente. È possibile usare questa identità gestita assegnata dall'utente per l'autenticazione dell'archiviazione BLOB, che consente di accedere e copiare dati da o in Data Lake Store. Per altre informazioni sulle identità gestite per le risorse di Azure, vedere Identità gestite per le risorse di Azure

Per usare l'autenticazione dell'identità gestita assegnata dall'utente, seguire questa procedura:

Creare una o più identità gestite assegnate dall'utente e concedere l'accesso ad Azure Data Lake. Per gli esempi di funzionamento dell'autorizzazione in Data Lake Storage Gen1, vedere Controllo di accesso in Azure Data Lake Storage Gen1.

- Come origine: in Accesso a Esplora dati>concedere almeno l'autorizzazione Esegui per TUTTE le cartelle upstream, inclusa la radice, insieme all'autorizzazione Lettura per i file da copiare. È possibile scegliere di aggiungere a Questa cartella e tutti gli elementi figlio come ricorsiva, e aggiungere come una voce di autorizzazione di accesso e una voce di autorizzazione predefinita. Non è presente alcun requisito per il controllo di accesso a livello di account (IAM).

- Come sink: in Accesso a Esplora dati>concedere almeno l'autorizzazione Esegui per TUTTE le cartelle upstream, inclusa la radice, insieme all'autorizzazione Di scrittura per la cartella sink. È possibile scegliere di aggiungere a Questa cartella e tutti gli elementi figlio come ricorsiva, e aggiungere come una voce di autorizzazione di accesso e una voce di autorizzazione predefinita.

Assegnare una o più identità gestite assegnate dall'utente alla data factory e creare le credenziali per ogni identità gestita assegnata dall'utente.

La proprietà seguente è supportata:

| Proprietà | Descrizione | Richiesto |

|---|---|---|

| credentials | Specificare l'identità gestita assegnata dall'utente come oggetto credenziale. | Sì |

Esempio:

{

"name": "AzureDataLakeStoreLinkedService",

"properties": {

"type": "AzureDataLakeStore",

"typeProperties": {

"dataLakeStoreUri": "https://<accountname>.azuredatalakestore.net/webhdfs/v1",

"subscriptionId": "<subscription of ADLS>",

"resourceGroupName": "<resource group of ADLS>",

"credential": {

"referenceName": "credential1",

"type": "CredentialReference"

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Proprietà del set di dati

Per un elenco completo delle sezioni e delle proprietà disponibili per la definizione dei set di dati, vedere l'articolo Set di dati.

Azure Data Factory supporta i formati di file seguenti. Per impostazioni basate sui formati, fare riferimento ai singoli articoli.

- Formato Avro

- Formato binario

- Formato testo delimitato

- Formato Excel

- Formato JSON

- Formato ORC

- Formato Parquet

- Formato XML

Le proprietà seguenti sono supportate per Azure Data Lake Storage Gen1 nelle impostazioni location nel set di dati basato sul formato:

| Proprietà | Descrizione | Richiesto |

|---|---|---|

| Tipo | La proprietà type in location nel set di dati deve essere impostata su AzureDataLakeStoreLocation. |

Sì |

| folderPath | Il percorso di una cartella. Se si intende usare un carattere jolly per filtrare le cartelle, ignorare questa impostazione e specificarla nelle impostazioni dell'origine dell'attività. | No |

| fileName | Nome del file nel percorso cartella specificato. Se si intende usare un carattere jolly per filtrare i file, ignorare questa impostazione e specificarla nelle impostazioni dell'origine dell'attività. | No |

Esempio:

{

"name": "DelimitedTextDataset",

"properties": {

"type": "DelimitedText",

"linkedServiceName": {

"referenceName": "<ADLS Gen1 linked service name>",

"type": "LinkedServiceReference"

},

"schema": [ < physical schema, optional, auto retrieved during authoring > ],

"typeProperties": {

"location": {

"type": "AzureDataLakeStoreLocation",

"folderPath": "root/folder/subfolder"

},

"columnDelimiter": ",",

"quoteChar": "\"",

"firstRowAsHeader": true,

"compressionCodec": "gzip"

}

}

}

Proprietà dell'attività di copia

Per un elenco completo delle sezioni e delle proprietà disponibili per la definizione delle attività, vedere l'articolo sulle pipeline. Questa sezione presenta un elenco delle proprietà supportate dall'origine e dal sink di Azure Data Lake Store.

Azure Data Lake Store come origine

Azure Data Factory supporta i formati di file seguenti. Per impostazioni basate sui formati, fare riferimento ai singoli articoli.

- Formato Avro

- Formato binario

- Formato testo delimitato

- Formato Excel

- Formato JSON

- Formato ORC

- Formato Parquet

- Formato XML

Le proprietà seguenti sono supportate per Azure Data Lake Storage Gen1 nelle impostazioni storeSettings nell'origine della copia basata sul formato:

| Proprietà | Descrizione | Richiesto |

|---|---|---|

| Tipo | La proprietà type in storeSettings deve essere impostata su AzureDataLakeStoreReadSettings. |

Sì |

| Individuare i file da copiare: | ||

| OPZIONE 1: percorso statico |

Copia dal percorso di cartella/file specificato nel set di dati. Se si vogliono copiare tutti i file da una cartella, specificare anche wildcardFileName come *. |

|

| OPTION 2: intervallo di nomi - listAfter |

Recuperare le cartelle/i file il cui nome è dopo questo valore alfabeticamente (esclusivo). Usa il filtro lato servizio per ADLS Gen1, che offre prestazioni migliori rispetto a un filtro con caratteri jolly. Il servizio applica questo filtro al percorso definito nel set di dati e è supportato un solo livello di entità. Per altri esempi, vedere Esempi di filtro dell'intervallo di nomi. |

No |

| OPTION 2: intervallo di nomi - listBefore |

Recuperare le cartelle/i file il cui nome è prima di questo valore in ordine alfabetico (inclusivo). Usa il filtro lato servizio per ADLS Gen1, che offre prestazioni migliori rispetto a un filtro con caratteri jolly. Il servizio applica questo filtro al percorso definito nel set di dati e è supportato un solo livello di entità. Per altri esempi, vedere Esempi di filtro dell'intervallo di nomi. |

No |

| OPZIONE 3: carattere jolly - wildcardFolderPath |

Percorso della cartella con caratteri jolly per filtrare le cartelle di origine. I caratteri jolly consentiti sono: * (corrisponde a zero o più caratteri) e ? (corrisponde a zero caratteri o a un carattere singolo). Usare ^ come carattere di escape se il nome effettivo della cartella include caratteri jolly o questo carattere di escape. Vedere altri esempi in Esempi di filtro file e cartelle. |

No |

| OPZIONE 3: carattere jolly - wildcardFileName |

Nome file con caratteri jolly nel percorso folderPath/wildcardFolderPath specificato per filtrare i file di origine. I caratteri jolly consentiti sono: * (corrispondenza di zero o più caratteri) e ? (corrispondenza di zero caratteri o di un carattere singolo). Usare ^ per il carattere escape se il nome effettivo del file include caratteri jolly o escape. Vedere altri esempi in Esempi di filtro file e cartelle. |

Sì |

| OPZIONE 4: un elenco di file - fileListPath |

Indica di copiare un determinato set di file. Puntare a un file di testo che include un elenco di file da copiare, un file per riga, ovvero il percorso relativo al percorso configurato nel set di dati. Quando si usa questa opzione, non specificare il nome file nel set di dati. Per altri esempi, vedere Esempi di elenco di file. |

No |

| Impostazioni aggiuntive: | ||

| recursive | Indica se i dati vengono letti in modo ricorsivo dalle cartelle secondarie o solo dalla cartella specificata. Quando la proprietà recursive è impostata su true e il sink è un archivio basato su file, una cartella o una sottocartella vuota non viene copiata o creata nel sink. I valori consentiti sono true (predefinito) e false. Questa proprietà non è applicabile quando si configura fileListPath. |

No |

| deleteFilesAfterCompletion | Indica se i file binari verranno eliminati dall'archivio di origine dopo il corretto spostamento nell'archivio di destinazione. L'eliminazione del file è per file, quindi quando l'attività di copia ha esito negativo, si noterà che alcuni file sono già stati copiati nella destinazione ed eliminati dall'origine, mentre altri rimangono nell'archivio di origine. Questa proprietà è valida solo nello scenario di copia dei file binari. Valore predefinito: false. |

No |

| modifiedDatetimeStart | Filtro dei file in base all'attributo: Ultima modifica. I file vengono selezionati se l'ora dell'ultima modifica è maggiore o uguale a modifiedDatetimeStart e minore di modifiedDatetimeEnd. L'ora viene applicata con il fuso orario UTC e il formato "2018-12-01T05:00:00Z". Le proprietà possono essere NULL, a indicare che al set di dati non viene applicato alcun filtro di attributo di file. Quando modifiedDatetimeStart ha un valore datetime ma modifiedDatetimeEnd è NULL, significa che i file il cui ultimo attributo modificato è maggiore o uguale al valore datetime è selezionato. Quando modifiedDatetimeEnd ha un valore datetime ma modifiedDatetimeStart è NULL, significa che i file il cui ultimo attributo modificato è minore del valore datetime selezionato.Questa proprietà non è applicabile quando si configura fileListPath. |

No |

| modifiedDatetimeEnd | Come sopra. | No |

| enablePartitionDiscovery | Per i file partizionati, specificare se analizzare le partizioni dal percorso del file e aggiungerle come colonne di origine aggiuntive. I valori consentiti sono false (impostazione predefinita) e true. |

No |

| partitionRootPath | Quando l'individuazione delle partizioni è abilitata, specificare il percorso radice assoluto per leggere le cartelle partizionate come colonne di dati. Se non è specificato, per impostazione predefinita, - Quando si usa il percorso del file nel set di dati o nell'elenco di file nell'origine, il percorso radice della partizione è il percorso configurato nel set di dati. - Quando si usa il filtro delle cartelle con caratteri jolly, il percorso radice della partizione è il sottopercorso prima del primo carattere jolly. Si supponga, ad esempio, di configurare il percorso nel set di dati come "root/folder/year=2020/month=08/day=27": - Se si specifica il percorso radice della partizione come "root/folder/year=2020", l'attività di copia genera altre due colonne month e day con il valore "08" e "27" rispettivamente, oltre alle colonne all'interno dei file.- Se il percorso radice della partizione non è specificato, non viene generata alcuna colonna aggiuntiva. |

No |

| maxConcurrentConnections | Limite massimo di connessioni simultanee stabilite all'archivio dati durante l'esecuzione dell'attività. Specificare un valore solo quando si desidera limitare le connessioni simultanee. | No |

Esempio:

"activities":[

{

"name": "CopyFromADLSGen1",

"type": "Copy",

"inputs": [

{

"referenceName": "<Delimited text input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "DelimitedTextSource",

"formatSettings":{

"type": "DelimitedTextReadSettings",

"skipLineCount": 10

},

"storeSettings":{

"type": "AzureDataLakeStoreReadSettings",

"recursive": true,

"wildcardFolderPath": "myfolder*A",

"wildcardFileName": "*.csv"

}

},

"sink": {

"type": "<sink type>"

}

}

}

]

Azure Data Lake Store come sink

Azure Data Factory supporta i formati di file seguenti. Per impostazioni basate sui formati, fare riferimento ai singoli articoli.

Le proprietà seguenti sono supportate per Azure Data Lake Storage Gen1 nelle impostazioni storeSettings nel sink di copia basato sul formato:

| Proprietà | Descrizione | Richiesto |

|---|---|---|

| Tipo | La proprietà type in storeSettings deve essere impostata su AzureDataLakeStoreWriteSettings. |

Sì |

| copyBehavior | Definisce il comportamento di copia quando l'origine è costituita da file di un archivio dati basato su file. I valori consentiti sono i seguenti: - PreserveHierarchy (predefinito): mantiene la gerarchia dei file nella cartella di destinazione. Il percorso relativo del file di origine nella cartella di origine è identico al percorso relativo del file di destinazione nella cartella di destinazione. - FlattenHierarchy: tutti i file della cartella di origine si trovano nel primo livello della cartella di destinazione. I nomi dei file di destinazione vengono generati automaticamente. - MergeFiles: unisce tutti i file della cartella di origine in un solo file. Se si specifica il nome di file, il nome del file unito sarà il nome specificato. In caso contrario, verrà usato un nome di file generato automaticamente. |

No |

| expiryDateTime | Specifica il momento di scadenza dei file scritti. La scadenza viene applicata in orario UTC nel formato "2020-03-01T08:00:00Z". Per impostazione predefinita, è NULL, il che significa che i file scritti non sono mai scaduti. | No |

| maxConcurrentConnections | Limite massimo di connessioni simultanee stabilite all'archivio dati durante l'esecuzione dell'attività. Specificare un valore solo quando si desidera limitare le connessioni simultanee. | No |

Esempio:

"activities":[

{

"name": "CopyToADLSGen1",

"type": "Copy",

"inputs": [

{

"referenceName": "<input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<Parquet output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "<source type>"

},

"sink": {

"type": "ParquetSink",

"storeSettings":{

"type": "AzureDataLakeStoreWriteSettings",

"copyBehavior": "PreserveHierarchy"

}

}

}

}

]

Esempi di filtri per intervalli di nomi

In questa sezione viene descritto il comportamento risultante dei filtri dell'intervallo di nomi.

| Esempio di struttura di origine | Configurazione | Result |

|---|---|---|

| root a file.csv Ax file2.csv ax.csv b file3.csv bx.csv c file4.csv cx.csv |

Nel set di dati: - Percorso cartella: rootNell'origine dell'attività Copy: - Elenca dopo: a- Elencare prima: b |

Vengono quindi copiati i file seguenti: root Ax file2.csv ax.csv b file3.csv |

Esempi di filtro file e cartelle

Questa sezione descrive il comportamento risultante del percorso cartella e del nome del file con i filtri con caratteri jolly.

| folderPath | fileName | recursive | Struttura delle cartelle di origine e risultato del filtro (i file in grassetto sono stati recuperati) |

|---|---|---|---|

Folder* |

(vuoto, usare il valore predefinito) | falso | CartellaA File1.csv File2.json Sottocartella1 File3.csv File4.json File5.csv AltraCartellaB File6.csv |

Folder* |

(vuoto, usare il valore predefinito) | true | CartellaA File1.csv File2.json Sottocartella1 File3.csv File4.json File5.csv AltraCartellaB File6.csv |

Folder* |

*.csv |

falso | CartellaA File1.csv File2.json Sottocartella1 File3.csv File4.json File5.csv AltraCartellaB File6.csv |

Folder* |

*.csv |

true | CartellaA File1.csv File2.json Sottocartella1 File3.csv File4.json File5.csv AltraCartellaB File6.csv |

Esempi di elenco di file

Questa sezione descrive il comportamento risultante dall'uso del percorso di elenco file nell'origine dell'attività di copia.

Si supponga di disporre della struttura di cartelle di origine seguente e di voler copiare i file in grassetto:

| Esempio di struttura di origine | Contenuto in FileListToCopy.txt | Configurazione |

|---|---|---|

| root CartellaA File1.csv File2.json Sottocartella1 File3.csv File4.json File5.csv Metadati UFX FileListToCopy.txt |

File1.csv Sottocartella1/File3.csv Sottocartella1/File5.csv |

Nel set di dati: - Percorso cartella: root/FolderANell'origine dell'attività Copy: - Percorso elenco file: root/Metadata/FileListToCopy.txt Il percorso dell'elenco di file fa riferimento a un file di testo nello stesso archivio dati che include un elenco di file da copiare, un file per riga con il percorso relativo del percorso configurato nel set di dati. |

Esempi di comportamento dell'operazione di copia

Questa sezione descrive il comportamento risultante dell'operazione di copia per diverse combinazioni di valori recursive e copyBehavior.

| recursive | copyBehavior | Struttura della cartella di origine | Destinazione risultante |

|---|---|---|---|

| true | preserveHierarchy | Cartella1 File1 File2 Sottocartella1 File3 File4 File5 |

La Cartella1 di destinazione viene creata con la stessa struttura dell'origine: Cartella1 File1 File2 Sottocartella1 File3 File4 File5. |

| true | flattenHierarchy | Cartella1 File1 File2 Sottocartella1 File3 File4 File5 |

La cartella 1 di destinazione viene creata con la struttura seguente: Cartella1 Nome generato automaticamente per File1 Nome generato automaticamente per File2 Nome generato automaticamente per File3 Nome generato automaticamente per File4 Nome generato automaticamente per File5 |

| true | mergeFiles | Cartella1 File1 File2 Sottocartella1 File3 File4 File5 |

La cartella 1 di destinazione viene creata con la struttura seguente: Cartella1 Il contenuto di File1 + File2 + File3 + File4 + File 5 viene unito in un file con nome generato automaticamente. |

| falso | preserveHierarchy | Cartella1 File1 File2 Sottocartella1 File3 File4 File5 |

La Cartella1 di destinazione viene creata con la struttura seguente: Cartella1 File1 File2 La sottocartella1 con File3, File4 e File5 non viene considerata. |

| falso | flattenHierarchy | Cartella1 File1 File2 Sottocartella1 File3 File4 File5 |

La Cartella1 di destinazione viene creata con la struttura seguente: Cartella1 Nome generato automaticamente per File1 Nome generato automaticamente per File2 La sottocartella1 con File3, File4 e File5 non viene considerata. |

| falso | mergeFiles | Cartella1 File1 File2 Sottocartella1 File3 File4 File5 |

La Cartella1 di destinazione viene creata con la struttura seguente: Cartella1 Il contenuto di File1 + File2 viene unito in un file con nome generato automaticamente. Nome generato automaticamente per File1 La sottocartella1 con File3, File4 e File5 non viene considerata. |

Mantenere elenchi di controllo di accesso per Data Lake Storage Gen2

Suggerimento

Per copiare dati da Azure Data Lake Archiviazione Gen1 in Gen2 in generale, vedere Copiare dati da Azure Data Lake Archiviazione Gen1 a Gen2 per una procedura dettagliata e procedure consigliate.

Se si desidera replicare gli elenchi di controllo di accesso (ACL) insieme ai file di dati quando si esegue l'aggiornamento da Data Lake Storage Gen1 a Data Lake Storage Gen2, vedere Mantenere gli elenchi di controllo di accesso da Data Lake Storage Gen1.

Proprietà del flusso di dati per mapping

Quando si trasformano i dati nei flussi di dati di mapping, è possibile leggere e scrivere file da Azure Data Lake Archiviazione Gen1 nei formati seguenti:

Le impostazioni specifiche del formato si trovano nella documentazione per tale formato. Per altre informazioni, vedere Trasformazione dell'origine nel flusso di dati di mapping e Trasformazione Sink nel flusso di dati di mapping.

Trasformazione origine

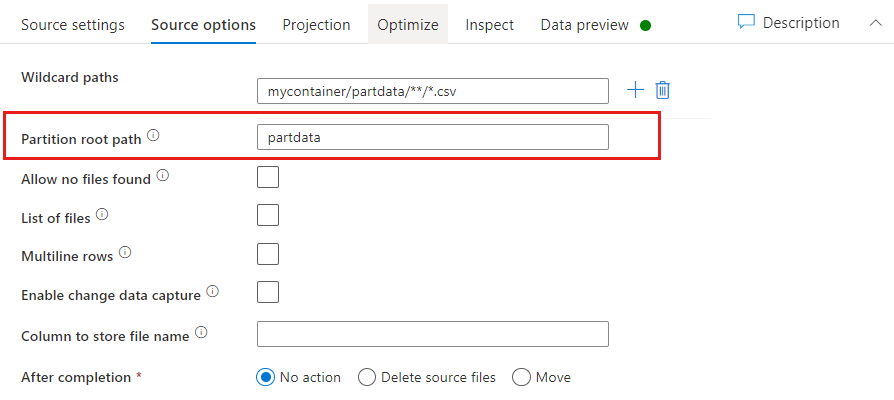

Nella trasformazione di origine è possibile leggere da un contenitore, una cartella o un singolo file in Azure Data Lake Archiviazione Gen1. La scheda Source options (Opzioni origine) consente di gestire la modalità di lettura dei file.

Percorso con caratteri jolly: l'uso di un criterio con caratteri jolly indicherà al servizio di scorrere ogni cartella e file corrispondente in una singola trasformazione Origine. Si tratta di un modo efficace per elaborare più file all'interno di un singolo flusso. Aggiungere più sequenze di corrispondenza con caratteri jolly con il segno + visualizzato quando si passa il mouse sulla sequenza con caratteri jolly esistente.

Nel contenitore di origine scegliere una serie di file che corrispondono a un criterio. Nel set di dati è possibile specificare solo il contenitore. Il percorso con caratteri jolly deve quindi includere anche il percorso della cartella a partire dalla cartella radice.

Esempi di caratteri jolly:

*Rappresenta qualsiasi set di caratteri**Rappresenta l'annidamento delle directory ricorsive?Sostituisce un carattere[]Trova la corrispondenza di uno o più caratteri nelle parentesi quadre/data/sales/**/*.csvOttiene tutti i dati CSV in /data/sales/data/sales/20??/**/Ottiene tutti i file in modo ricorsivo all'interno di tutte le cartelle 20xx corrispondenti/data/sales/*/*/*.csvOttiene i file CSV due livelli sotto /data/sales/data/sales/2004/12/[XY]1?.csvOttiene tutti i file CSV da dicembre 2004 a partire da X o Y, seguiti da 1 e da qualsiasi singolo carattere

Percorso radice partizione: se sono presenti cartelle partizionate nell'origine file con un key=value formato (ad esempio, year=2019), è possibile assegnare il livello superiore dell'albero delle cartelle di partizione a un nome di colonna nel flusso di dati del flusso di dati.

Impostare innanzitutto un carattere jolly per includere tutti i percorsi che rappresentano le cartelle partizionate, nonché i file foglia da leggere.

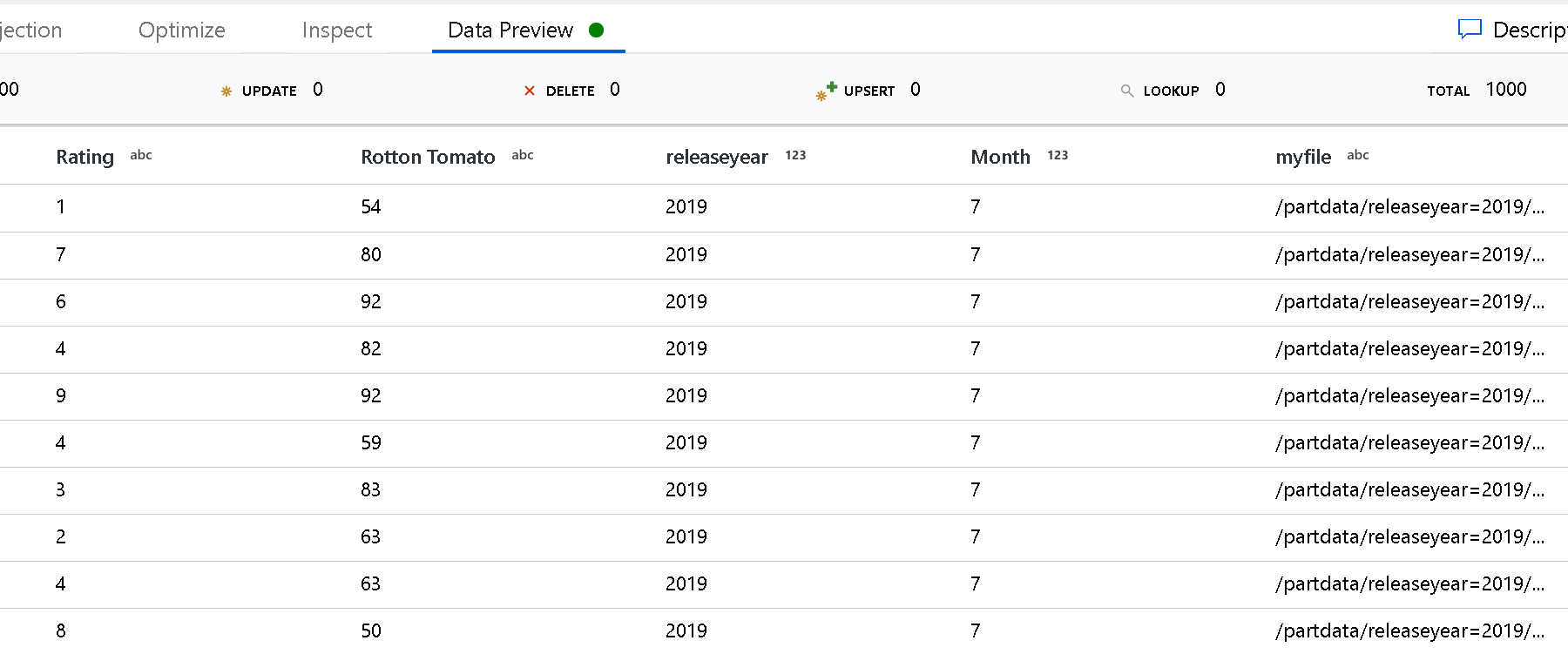

Usare l'impostazione Partition Root Path (Percorso radice partizione) per definire il livello superiore della struttura di cartelle. Quando si visualizza il contenuto dei dati tramite un'anteprima dei dati, si noterà che il servizio aggiunge le partizioni risolte trovate in ognuno dei livelli di cartella.

Elenco di file: set di file. Creare un file di testo che includa un elenco di file di percorsi relativi da elaborare. Puntare a questo file di testo.

Colonna per archiviare il nome del file: archiviare il nome del file di origine in una colonna nei dati. Immettere un nuovo nome di colonna per archiviare la stringa del nome file.

Al termine: scegliere di non eseguire alcuna operazione con il file di origine dopo l'esecuzione del flusso di dati, eliminare il file di origine o spostare il file di origine. I percorsi per lo spostamento sono relativi.

Per spostare i file di origine in un altro percorso dopo l'elaborazione, selezionare "Sposta" come operazione sul file. Impostare quindi la directory "da". Se non si usano caratteri jolly per il percorso, l'impostazione "from" è la stessa cartella della cartella di origine.

Se si dispone di un percorso di origine con caratteri jolly, la sintassi sarà simile alla seguente:

/data/sales/20??/**/*.csv

È possibile specificare "da" come

/data/sales

E "a" come

/backup/priorSales

In questo caso, tutti i file originati in/data/sales vengono spostati in /backup/priorSales.

Nota

Le operazioni sui file vengono eseguite solo quando si avvia il flusso di dati da un'esecuzione di pipeline (esecuzione del debug o esecuzione della pipeline) che usa l'attività di esecuzione del flusso di dati in una pipeline. Le operazioni sui file non vengono eseguite in modalità di debug del flusso di dati.

Filtro in base all'ultima modifica: è possibile filtrare i file elaborati specificando un intervallo di date di data dell'ultima modifica. Tutte le ore e le date sono in formato UTC.

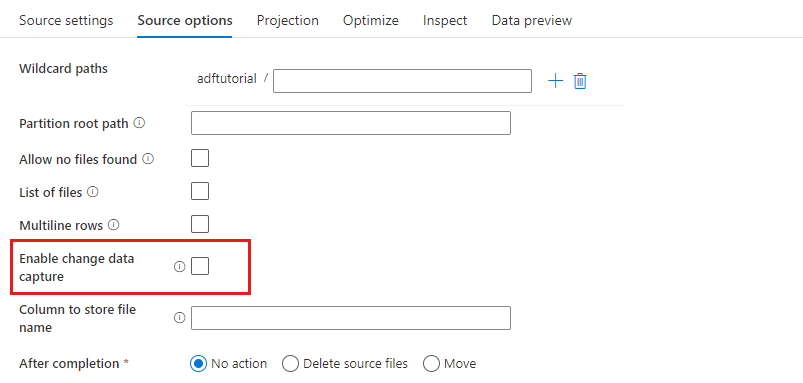

Abilitare Change Data Capture: se true, si otterranno file nuovi o modificati solo dall'ultima esecuzione. Il caricamento iniziale dei dati completi dello snapshot verrà sempre ottenuto nella prima esecuzione, seguito dall'acquisizione di file nuovi o modificati solo nelle esecuzioni successive. Per altri dettagli, vedere Change Data Capture.

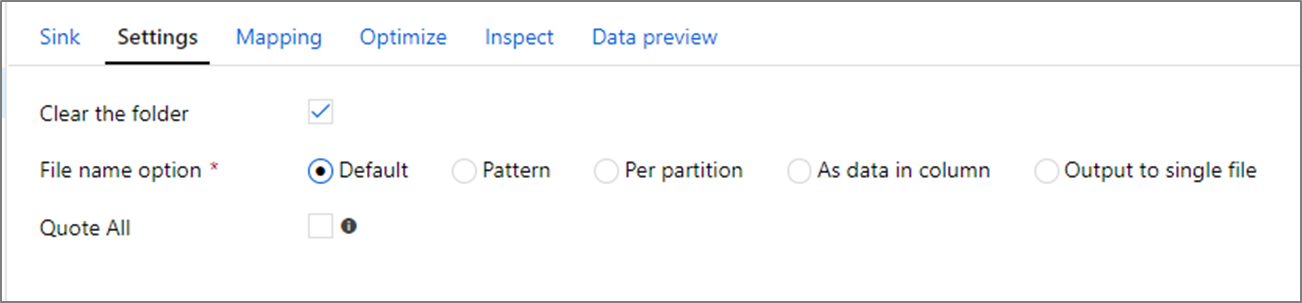

Proprietà sink

Nella trasformazione sink è possibile scrivere in un contenitore oppure in una cartella in Azure Data Lake Storage Gen1. La scheda Settings (Impostazioni) consente di gestire la modalità di scrittura dei file.

Cancella la cartella: determina se la cartella di destinazione viene cancellata prima della scrittura dei dati.

Opzione Nome file: determina la modalità di denominazione dei file di destinazione nella cartella di destinazione. Le opzioni di nomi di file sono indicate di seguito:

- Impostazione predefinita: consenti a Spark di denominare i file in base alle impostazioni predefinite part.

- Modello: immettere un modello che enumera i file di output per partizione. Ad esempio, loans[n].csv crea loans1.csv, loans2.csv e così via.

- Per partizione: immettere un nome di file per partizione.

- Come dati nella colonna: impostare il file di output sul valore di una colonna. Il percorso è relativo al contenitore del set di dati e non alla cartella di destinazione. Se nel set di dati è presente un percorso di cartella, viene sottoposto a override.

- Output in un singolo file: combinare i file di output partizionati in un singolo file denominato. Il percorso è relativo alla cartella del set di dati. Tenere presente che l'operazione di unione può avere esito negativo in base alle dimensioni del nodo. Questa opzione non è consigliata per set di dati di grandi dimensioni.

Virgolette tutte: determina se racchiudere tutti i valori tra virgolette

Proprietà dell'attività Lookup

Per altre informazioni sulle proprietà, vedere Attività Lookup.

Proprietà dell'attività GetMetadata

Per altre informazioni sulle proprietà, vedere Attività GetMetadata

Proprietà dell'attività Delete

Per altre informazioni sulle proprietà, vedere Attività Delete

Modalità legacy

Nota

I modelli seguenti sono ancora supportati così come sono per la compatibilità con le versioni precedenti. Si consiglia di usare il nuovo modello menzionato nelle sezioni precedenti in futuro e l'interfaccia utente di creazione è passata alla generazione del nuovo modello.

Modello di set di dati legacy

| Proprietà | Descrizione | Richiesto |

|---|---|---|

| Tipo | La proprietà type del set di dati deve essere impostata su AzureDataLakeStoreFile. | Sì |

| folderPath | Percorso della cartella in Data Lake Store. Se il valore non è specificato, punta alla radice. Il filtro con caratteri jolly è supportato. I caratteri jolly consentiti sono * (corrispondenza di zero o più caratteri) e ? (corrispondenza di zero caratteri o di un carattere singolo). Usare ^ per applicare una sequenza di escape se il nome effettivo della cartella include caratteri jolly o tale carattere di escape. Esempio: cartellaradice/sottocartella/. Vedere altri esempi in Esempi di filtro file e cartelle. |

No |

| fileName | Filtro con nome o carattere jolly per i file nell'elemento "folderPath" specificato. Se non si specifica alcun valore per questa proprietà, il set di dati punta a tutti i file nella cartella. Per un filtro, i caratteri jolly consentiti sono * (corrispondenza di zero o più caratteri) e ? (corrispondenza di zero caratteri o di un carattere singolo).- Esempio 1: "fileName": "*.csv"- Esempio 2: "fileName": "???20180427.txt"Usare ^ per applicare una sequenza di escape se il nome effettivo del file include caratteri jolly o tale carattere di escape.Quando fileName non viene specificato per un set di dati di output e preserveHierarchy non viene specificato nel sink dell'attività, l'attività di copia genera automaticamente il nome del file con il modello seguente: "Data.[ GUID ID esecuzione attività]. [GUID se FlattenHierarchy]. [formato se configurato]. [compressione se configurata]", ad esempio "Data.0a405f8a-93ff-4c6f-b3be-f69616f1df7a.txt.gz". Se si esegue la copia da un'origine in formato tabulare usando un nome di tabella anziché una query, il modello di nome è "[nome tabella].[formato].[compressione se configurata]", ad esempio "MiaTabella.csv". |

No |

| modifiedDatetimeStart | Filtro di file basato sull'ultima modifica dell'attributo. I file vengono selezionati se l'ora dell'ultima modifica è maggiore o uguale a modifiedDatetimeStart e minore di modifiedDatetimeEnd. L'ora viene applicata in base al fuso orario UTC nel formato "2018-12-01T05:00:00Z". Le prestazioni complessive dello spostamento dei dati sono interessate dall'abilitazione di questa impostazione quando si intende applicare un filtro a grandi quantità di file. Le proprietà possono essere NULL, a indicare che al set di dati non viene applicato alcun filtro di attributo di file. Quando modifiedDatetimeStart ha un valore datetime ma modifiedDatetimeEnd è NULL, vengono selezionati i file il cui ultimo attributo modificato è maggiore o uguale al valore datetime. Quando modifiedDatetimeEnd ha un valore datetime ma modifiedDatetimeStart è NULL vengono selezionati i file il cui ultimo attributo modificato è minore del valore datetime. |

No |

| modifiedDatetimeEnd | Filtro di file basato sull'ultima modifica dell'attributo. I file vengono selezionati se l'ora dell'ultima modifica è maggiore o uguale a modifiedDatetimeStart e minore di modifiedDatetimeEnd. L'ora viene applicata in base al fuso orario UTC nel formato "2018-12-01T05:00:00Z". Le prestazioni complessive dello spostamento dei dati sono interessate dall'abilitazione di questa impostazione quando si intende applicare un filtro a grandi quantità di file. Le proprietà possono essere NULL, a indicare che al set di dati non viene applicato alcun filtro di attributo di file. Quando modifiedDatetimeStart ha un valore datetime ma modifiedDatetimeEnd è NULL, vengono selezionati i file il cui ultimo attributo modificato è maggiore o uguale al valore datetime. Quando modifiedDatetimeEnd ha un valore datetime ma modifiedDatetimeStart è NULL vengono selezionati i file il cui ultimo attributo modificato è minore del valore datetime. |

No |

| format | Per copiare i file così come sono tra archivi basati su file (copia binaria), ignorare la sezione del formato nelle definizioni dei set di dati di input e di output. Se si vuole analizzare o generare file con un formato specifico, sono supportati i tipi di formato seguenti: TextFormat, JsonFormat, AvroFormat, OrcFormat e ParquetFormat. Impostare la proprietà type in format su uno di questi valori. Per altre informazioni, vedere le sezioni Formato testo, Formato JSON, Formato AVRO, Formato OCR e Formato Parquet. |

No (solo per uno scenario di copia binaria) |

| compressione | Specificare il tipo e il livello di compressione dei dati. Per altre informazioni, vedere l'articolo sui formati di file supportati e i codec di compressione. I tipi supportati sono GZip, Deflate, BZip2 e ZipDeflate. I livelli supportati sono Ottimale e Più veloce. |

No |

Suggerimento

Per copiare tutti i file in una cartella, specificare solo folderPath.

Per copiare un singolo file con un determinato nome, specificare folderPath con un percorso di cartella e fileName con un nome file.

Per copiare un subset di file in una cartella, specificare folderPath con un percorso di cartella e fileName con un filtro con caratteri jolly.

Esempio:

{

"name": "ADLSDataset",

"properties": {

"type": "AzureDataLakeStoreFile",

"linkedServiceName":{

"referenceName": "<ADLS linked service name>",

"type": "LinkedServiceReference"

},

"typeProperties": {

"folderPath": "datalake/myfolder/",

"fileName": "*",

"modifiedDatetimeStart": "2018-12-01T05:00:00Z",

"modifiedDatetimeEnd": "2018-12-01T06:00:00Z",

"format": {

"type": "TextFormat",

"columnDelimiter": ",",

"rowDelimiter": "\n"

},

"compression": {

"type": "GZip",

"level": "Optimal"

}

}

}

}

Modello di origine dell'attività di copia legacy

| Proprietà | Descrizione | Richiesto |

|---|---|---|

| Tipo | La proprietà type dell'origine dell'attività di copia deve essere impostato su AzureDataLakeStoreSource. |

Sì |

| recursive | Indica se i dati vengono letti in modo ricorsivo dalle cartelle secondarie o solo dalla cartella specificata. Quando recursive è impostata su true e il sink è un archivio basato su file, una cartella o una sottocartella vuota non viene copiata né creata nel sink. I valori consentiti sono true (predefinito) e false. |

No |

| maxConcurrentConnections | Limite massimo di connessioni simultanee stabilite all'archivio dati durante l'esecuzione dell'attività. Specificare un valore solo quando si desidera limitare le connessioni simultanee. | No |

Esempio:

"activities":[

{

"name": "CopyFromADLSGen1",

"type": "Copy",

"inputs": [

{

"referenceName": "<ADLS Gen1 input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "AzureDataLakeStoreSource",

"recursive": true

},

"sink": {

"type": "<sink type>"

}

}

}

]

Modello di sink dell'attività di copia legacy

| Proprietà | Descrizione | Richiesto |

|---|---|---|

| Tipo | La proprietà type del sink dell'attività di copia deve essere impostata su AzureDataLakeStoreSink. |

Sì |

| copyBehavior | Definisce il comportamento di copia quando l'origine è costituita da file di un archivio dati basato su file. I valori consentiti sono i seguenti: - PreserveHierarchy (predefinito): mantiene la gerarchia dei file nella cartella di destinazione. Il percorso relativo del file di origine nella cartella di origine è identico al percorso relativo del file di destinazione nella cartella di destinazione. - FlattenHierarchy: tutti i file della cartella di origine si trovano nel primo livello della cartella di destinazione. I nomi dei file di destinazione vengono generati automaticamente. - MergeFiles: unisce tutti i file della cartella di origine in un solo file. Se si specifica il nome di file, il nome del file unito sarà il nome specificato. In caso contrario, il nome del file viene generato automaticamente. |

No |

| maxConcurrentConnections | Limite massimo di connessioni simultanee stabilite all'archivio dati durante l'esecuzione dell'attività. Specificare un valore solo quando si desidera limitare le connessioni simultanee. | No |

Esempio:

"activities":[

{

"name": "CopyToADLSGen1",

"type": "Copy",

"inputs": [

{

"referenceName": "<input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<ADLS Gen1 output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "<source type>"

},

"sink": {

"type": "AzureDataLakeStoreSink",

"copyBehavior": "PreserveHierarchy"

}

}

}

]

Change Data Capture (anteprima)

Azure Data Factory può ottenere file nuovi o modificati solo da Azure Data Lake Archiviazione Gen1 abilitando Abilita Change Data Capture (anteprima) nella trasformazione origine del flusso di dati di mapping. Con questa opzione del connettore è possibile leggere solo file nuovi o aggiornati e applicare trasformazioni prima di caricare i dati trasformati in set di dati di destinazione desiderati.

Assicurarsi di mantenere invariato il nome della pipeline e dell'attività, in modo che il checkpoint possa sempre essere registrato dall'ultima esecuzione per ottenere modifiche da questa posizione. Se si modifica il nome della pipeline o il nome dell'attività, il checkpoint verrà reimpostato e si inizierà dall'inizio dell'esecuzione successiva.

Quando si esegue il debug della pipeline, l'opzione Abilita Change Data Capture (anteprima) funziona anche. Il checkpoint viene reimpostato quando si aggiorna il browser durante l'esecuzione del debug. Dopo aver soddisfatto il risultato dell'esecuzione del debug, è possibile pubblicare e attivare la pipeline. Inizierà sempre dall'inizio indipendentemente dal checkpoint precedente registrato dall'esecuzione di debug.

Nella sezione di monitoraggio è sempre possibile eseguire di nuovo una pipeline. Quando si esegue questa operazione, le modifiche vengono sempre ottenute dal record del checkpoint nell'esecuzione della pipeline selezionata.

Contenuto correlato

Per un elenco degli archivi dati supportati come origini e sink dall'attività di copia, vedere archivi dati supportati.