対話可能なオブジェクト

ボタンは長きにわたり、2D で抽象化された世界でイベントをトリガーするために使用される象徴でした。 3 次元の Mixed Reality の世界では、この抽象化の世界に閉じこもる必要はありません。 すべてのものが、イベントをトリガーする対話可能なオブジェクトになることができます。 対話可能なオブジェクトは、テーブルの上にあるコーヒー カップや空中の風船など、何でもかまいません。 ダイアログ UI などの特定の状況では、従来のボタンを引き続き使用します。 ボタンの視覚的な表現は、コンテキストによって異なります。

対話可能なオブジェクトの重要なプロパティ

視覚的な合図

視覚的な手掛かりとは、眼で受け取り、視覚認知中に視覚系によって処理される、光からの感覚的な手掛かりです。 視覚系は多くの種、特に人間にとって最も支配的であるため、視覚的な手掛かりは、世界がどのように認識されるかにおける大きな情報源です。

ホログラフィーのオブジェクトは Mixed Reality 内の実際の環境と混じり合うため、どのオブジェクトと対話できるかを理解するのが困難な場合があります。 エクスペリエンス内のすべての対話可能なオブジェクトについて、入力状態ごとに区別された視覚的な手掛かりを提供することが重要です。 これにより、エクスペリエンスのどの部分が対話可能であるかをユーザーが理解するのを助け、一貫性のある対話方式を使用することによって、ユーザーの信頼を得られるようになります。

遠くの対話式操作

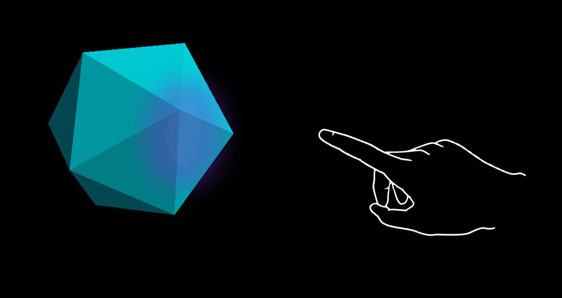

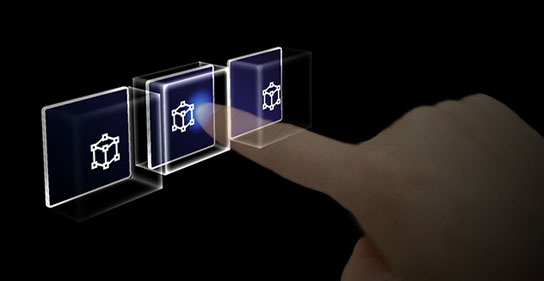

ユーザーが視線入力、ハンド レイ、およびモーション コントローラーの射線を使用して対話できるオブジェクトについては、次の 3 つの入力状態に対して異なる視覚的な手掛かりを使用することをお勧めします。

既定 (監視) 状態

オブジェクトの既定のアイドル状態。

カーソルはオブジェクト上にありません。 手は検出されていません。

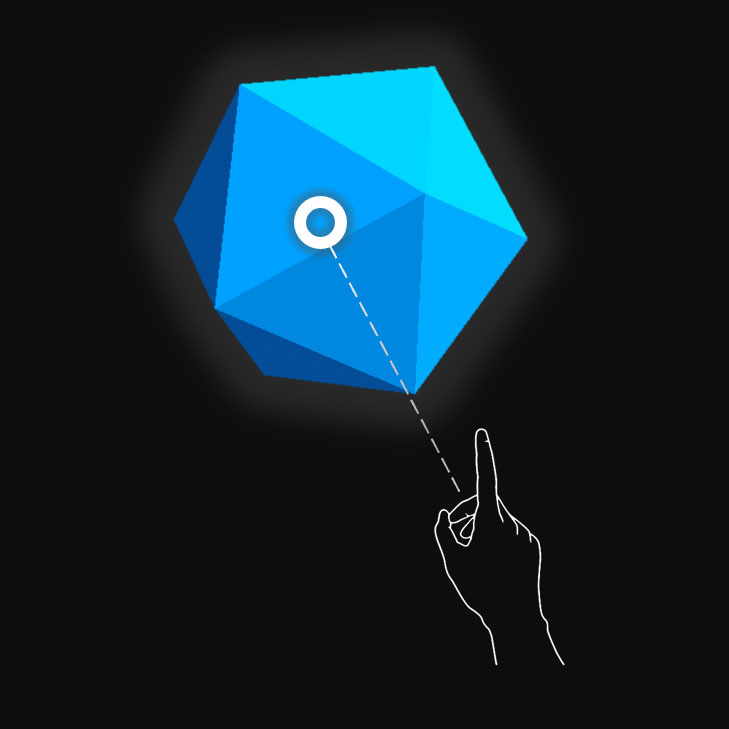

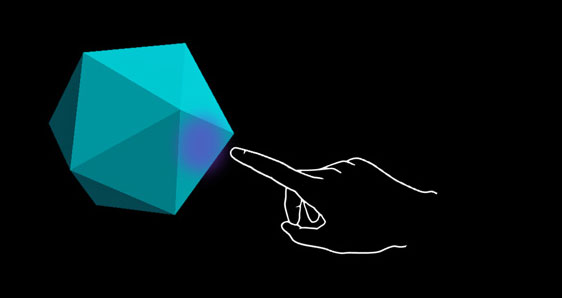

ターゲット (ホバー) 状態

オブジェクトが視線カーソル、指の近接、またはモーション コントローラーのポインターの対象になっている場合。

カーソルはオブジェクト上にあります。 手が検出され、準備が完了しています。

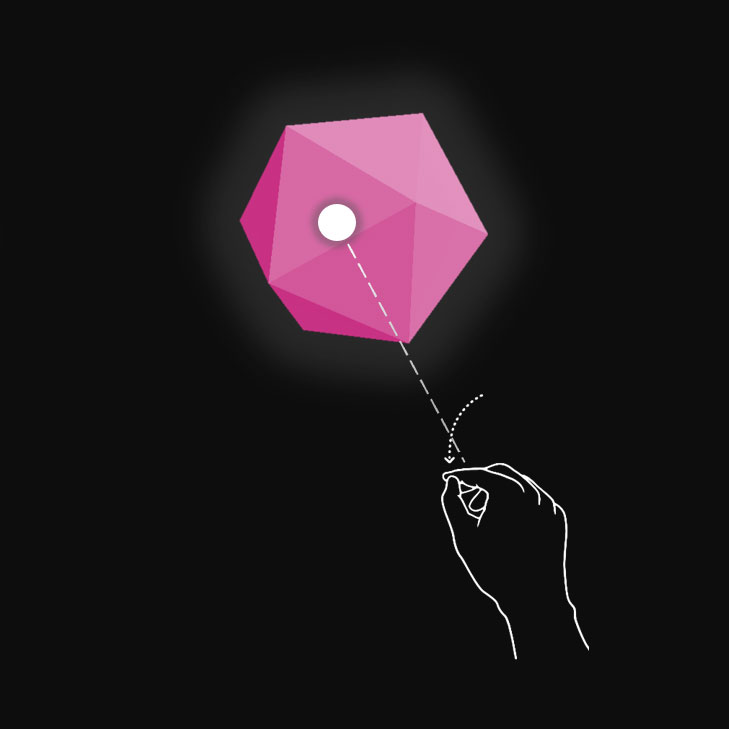

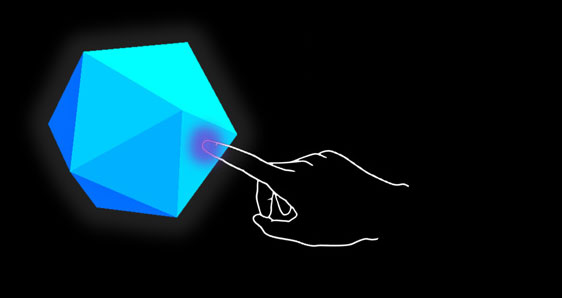

押された状態

オブジェクトがエアタップ ジェスチャ、指で押す動作、またはモーション コントローラーの選択ボタンによって押されたとき。

カーソルはオブジェクト上にあります。 手は検出され、エアタップされています。

強調表示や拡大/縮小などの手法を使用して、ユーザーの入力状態の視覚的な手掛かりを提供することができます。 Mixed Reality では、[スタート] メニューとアプリ バー ボタンを使用して、さまざまな入力状態を視覚化する例を見つけることができます。

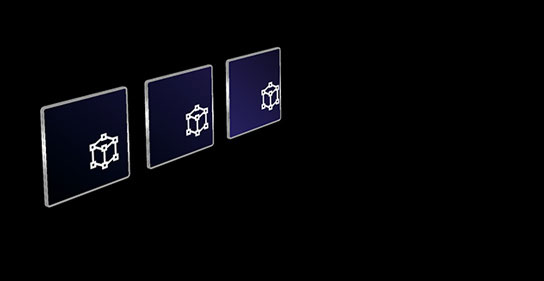

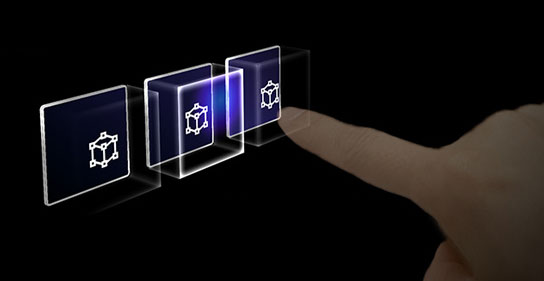

これらの状態がホログラフィー ボタンでどのように見えるかを示します。

既定 (監視) 状態

ターゲット (ホバー) 状態

押された状態

近くの対話式操作 (直接)

HoloLens 2 では、オブジェクトとの対話を可能にする、多関節ハンド トラッキング入力がサポートされています。 触覚によるフィードバックや完全な奥行きの認識がなければ、オブジェクトから手がどれだけ離れているか、またはそれに触っているかどうかを判断するのが困難な場合があります。 十分な視覚的な手掛かりを提供してオブジェクトの状態を伝え、特にそのオブジェクトに基づく手の状態を伝えることが重要です。

視覚的フィードバックを使用して、次の状態を伝えます。

- 既定 (監視): オブジェクトの既定のアイドル状態。

- ホバー: 手がホログラムの近くにある場合は、ビジュアルを変更して、手がホログラムをターゲットとしていることを伝えます。

- 距離と対話式操作ポイント: 手がホログラムに近づいたとき、投影された対話式操作の投影点と、オブジェクトから指までの距離を通知するフィードバック

- 接触の開始: ビジュアル (光、色) が変更され、接触が始まったことを通知します

- つかんだ状態: オブジェクトをつかむとビジュアル (光、色) が変更されます

- 接触の終了: 接触が終了するとビジュアル (光、色) が変更されます

ホバー (遠い)

手の近さに応じて強調表示されます。

ホバー (近い)

手までの距離に応じて強調表示のサイズが変化します。

タッチ/押す

視覚および音声でのフィードバック。

つかむ

視覚および音声でのフィードバック。

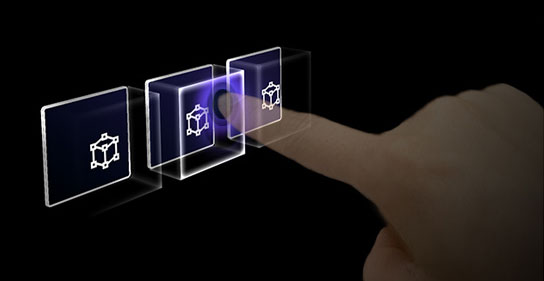

HoloLens 2 のボタンは、さまざまな入力の対話式操作状態がどのように視覚化されるかの例を示しています。

[Default]

ホバー

距離に基づく明るさの効果を示しています。

タッチ

波及効果を表示します。

ショートカット キー

前面プレートを移動します。

HoloLens 2 の "リング" の視覚的な手掛かり

HoloLens 2 には、ユーザーの奥行きの認識に役立つ視覚的な手掛かりがもう 1 つあります。 その指先の近くにリングが表示され、指先がオブジェクトに近づくにつれて小さくなります。 押された状態に達すると、そのリングは最終的に 1 つの点に収束します。 この視覚的アフォーダンスは、ユーザーが、オブジェクトからどれだけ離れているかを理解するのに役立ちます。

ビデオ ループ: 境界ボックスまでの近さに基づく視覚的なフィードバックの例

音声の手掛かり

直接ハンド対話では、適切な音声フィードバックによってユーザー エクスペリエンスが大幅に向上します。 音声フィードバックを使用して、次の手掛かりを通知します。

- 接触の開始: タッチが始まるときにサウンドを再生する

- 接触の終了: タッチの終了時にサウンドを再生する

- グラブの開始: グラブの開始時にサウンドを再生する

- グラブの終了: グラブの終了時にサウンドを再生する

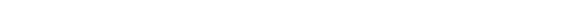

音声コマンド

対話可能なオブジェクトの場合は、代替の対話式操作オプションをサポートすることが重要です。 既定では、対話可能なすべてのオブジェクトの音声コマンドをサポートすることをお勧めします。 見つけやすさを高めるために、ホバー状態のときにツールヒントを提供することもできます。

画像: 音声コマンドのツールヒント

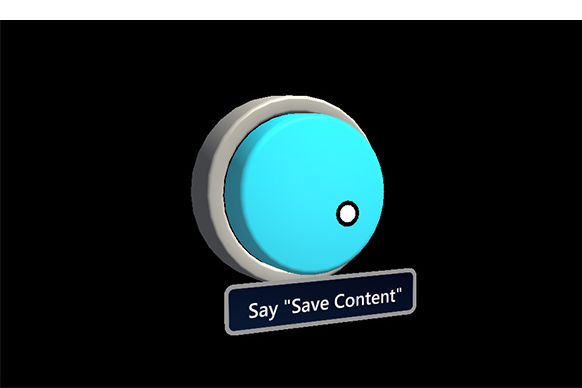

サイズ設定に関する推奨事項

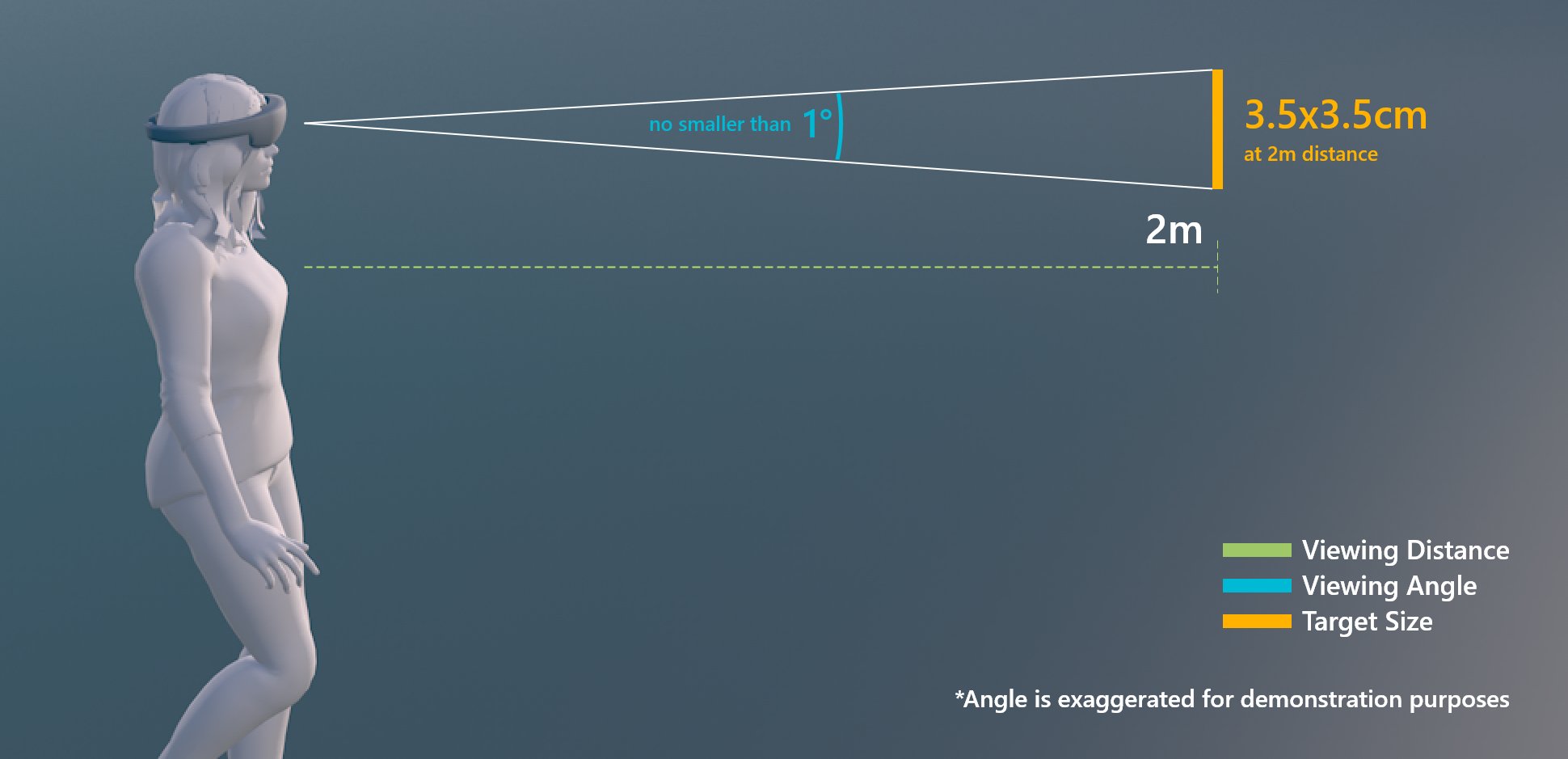

対話可能なすべてのオブジェクトに簡単に触れられるように、ユーザーからの距離に基づいて、対話可能なオブジェクトが最小サイズを確実に満たすようにすることをお勧めします。 視覚角度は、多くの場合、視覚円弧の角度で測定されます。視覚的な角度は、ユーザーの目と物体の間の距離に基づいており、一定のままですが、ユーザーからの距離が変化するとターゲットの物理的なサイズが変化する可能性があります。 ユーザーからの距離に基づいてオブジェクトの必要な物理サイズを決定するには、このようなビジュアル角度計算ツールを使用してみてください。

対話可能なコンテンツの最小サイズに関する推奨事項を次に示します。

直接ハンド対話のターゲット サイズ

| Distance | 表示角度 | サイズ |

|---|---|---|

| 45 cm | 2° 以上 | 1.6 x 1.6 cm |

直接ハンド対話のターゲット サイズ

ハンド レイまたは視線入力の対話式操作のターゲット サイズ

| Distance | 表示角度 | サイズ |

|---|---|---|

| 2 m | 1° 以上 | 3.5 x 3.5 cm |

ハンド レイまたは視線入力の対話式操作のターゲット サイズ

Unity 向け MRTK (Mixed Reality ツールキット) の対話可能なオブジェクト

MRTK では、Interactable というスクリプトを使用して、オブジェクトがさまざまな種類の入力の対話式操作状態に応答するようにすることができます。 これにより、色、サイズ、素材、シェーダーなどのオブジェクト プロパティを制御することで、視覚的な状態を定義できるさまざまなテーマがサポートされます。

MixedRealityToolkit の標準シェーダーには、視覚および音声の手掛かりを作成するのに役立つ近接光などのさまざまなオプションが用意されています。